I Large Language Models non sono entità magiche. Non sono “intelligenza” nel senso romantico del termine, e chi continua a raccontare che “ragionano” dovrebbe forse frequentare un corso accelerato di teoria delle probabilità. Il nuovo lavoro di Zekri e colleghi, che mette in relazione i modelli linguistici con le catene di Markov, è una di quelle ricerche che divide il pubblico in due: chi finalmente sospira un “era ora” e chi, terrorizzato, si accorge che tutta la narrativa da Silicon Valley sulla “creatività artificiale” rischia di sgretolarsi come un castello di sabbia davanti alla marea della matematica.

È un’eresia affermare che GPT-4, Llama o Gemma siano solo sofisticati processi di transizione tra stati finiti? Certo che lo è. Ed è proprio per questo che vale la pena dirlo.

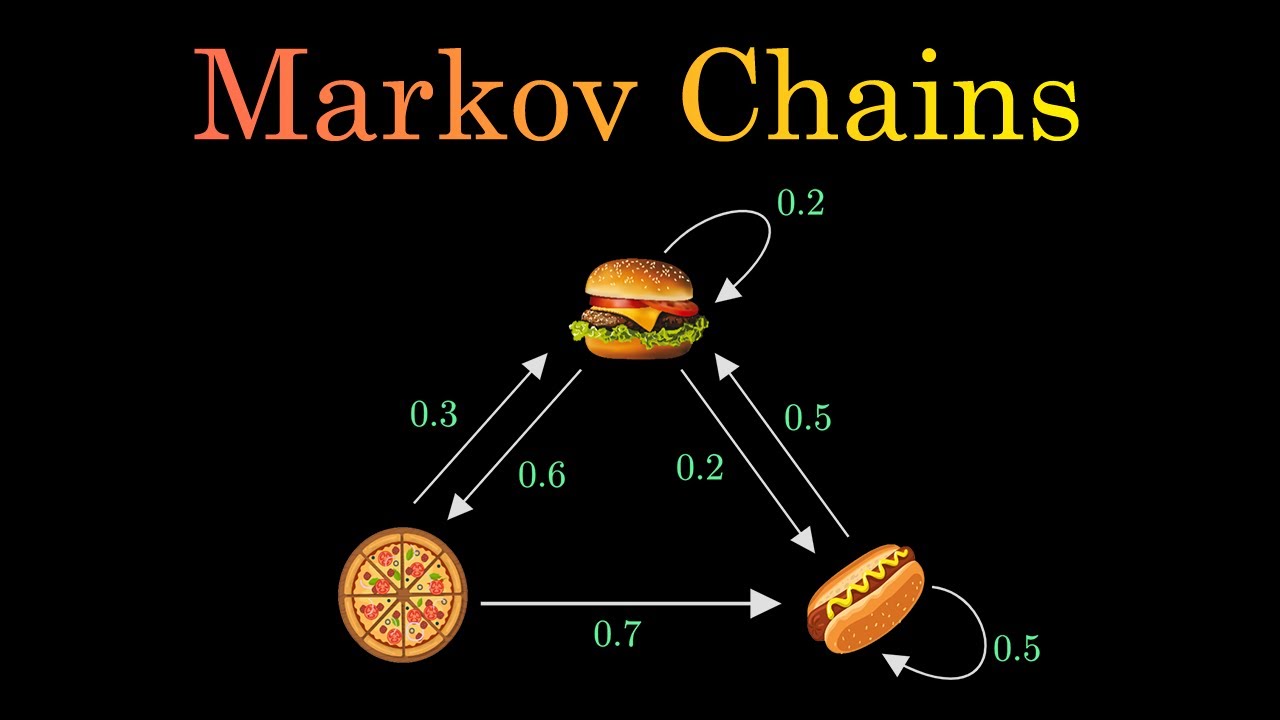

La brutalità di questa visione è quasi liberatoria. Un Large Language Model, spiegato senza marketing, è un sistema che calcola la probabilità che un token segua un altro, muovendosi in uno spazio finito di sequenze compatibili. Fine. Il romanticismo del “pensiero artificiale” svanisce quando si capisce che ogni parola generata non è altro che un passo di una catena di Markov che, dato un contesto, sceglie la transizione più plausibile e non è un insulto è una descrizione chirurgica. Se questo vi sembra riduttivo, pensateci un attimo: la mente umana, in fondo, non fa nulla di così diverso quando completa una frase iniziata da un altro. La differenza, semmai, è che noi ci illudiamo di essere originali.

Questa prospettiva ribalta molte certezze, a cominciare da quelle sulla generalizzazione dei modelli linguistici. Gli autori mostrano che la capacità di un LLM di “capire” un linguaggio è, in realtà, la sua abilità nel stimare correttamente le probabilità di transizione tra sequenze di token. La complessità? Mostruosa, certo, ma teoricamente affrontabile. L’analisi formale arriva a stabilire dei confini sulla generalizzazione, calcolando quanti token di addestramento servano per ridurre l’errore di approssimazione. Scoperta “banale” per chi mastica teoria statistica, ma devastante per chi continua a credere che i Large Language Models apprendano “concetti” anziché pattern.

Qui sta l’ironia: più i modelli sono grandi, più diventano prevedibili nel loro fallimento. Zekri lo dimostra chiaramente con le famiglie Llama e Gemma, mostrando come l’errore previsto teoricamente si allinei con i risultati empirici. L’apparente mistero della generalizzazione cade a pezzi quando lo guardi con lenti matematiche.

C’è poi il tema, assai più imbarazzante per i sostenitori della “AI creativa”, del looping. Sì, quella fastidiosa tendenza dei modelli a ripetere le stesse frasi, a bloccarsi in cicli autoreferenziali che a volte sembrano deliri da intelligenza infantile.

Gli autori lo spiegano con una chiarezza disarmante: ogni LLM ha una distribuzione stazionaria, un attrattore matematico verso cui tende indipendentemente dal prompt iniziale. In parole povere, date abbastanza tempo, qualsiasi conversazione con un LLM scivolerà in un loop prevedibile. Un orrore narrativo per chi sogna dialoghi infiniti e “creativi”, ma una benedizione per chi studia le sue vulnerabilità e qui ci sarebbe da ridere amaramente: le stesse aziende che vendono LLM come compagni di conversazione “umani” stanno segretamente lavorando su algoritmi per rallentare proprio quella convergenza, aggiungendo penalità di ripetizione. Quando si dice il marketing contro la matematica.

Un altro punto che merita attenzione è il ruolo della temperatura, la tanto citata “leva della creatività”. Zekri lo distrugge con eleganza: aumentare la temperatura non rende un LLM più creativo, lo rende semplicemente più veloce nel convergere alla sua distribuzione stazionaria, quindi più incoerente. Altro che “temperatura alta = fantasia”. È come dare più caffeina a un impiegato già confuso: parlerà di più, ma non necessariamente con più senso.

Anche qui, l’analisi Markoviana spiega ciò che molti sperimentano empiricamente senza comprenderlo: i testi sballati a temperature alte non sono “geniali intuizioni”, ma l’effetto naturale di una catena di transizioni che perde coerenza perché esplora più stati in meno tempo. Il che, a ben pensarci, è quasi poetico: chiediamo a queste macchine di comportarsi come artisti e poi ci stupiamo quando balbettano nonsense.

Sul piano strategico, la teoria non è meno provocatoria. Se i Large Language Models sono catene di Markov su steroidi, il loro miglioramento non è questione di “magia architetturale” ma di pura gestione statistica: quantità di dati, qualità della tokenizzazione, grandezza della finestra di contesto. Le imprese che investono miliardi per differenziarsi con “modelli più intelligenti” dovrebbero forse rivedere le priorità.

Un CEO con il senso del business dovrebbe chiedersi: vale la pena puntare su un modello da 500 miliardi di parametri se il guadagno marginale di generalizzazione è spiegabile con un banale logaritmo del vocabolario e della dimensione del contesto? La risposta, suggerisce questo paper, è quasi sempre no e questa non è una notizia comoda per chi vive di hype.

C’è un altro aspetto dirompente: l’analisi dell’in-context learning. Zekri mostra che, se si considerano i prompt come sequenze Markoviane, si possono stimare con precisione i limiti dell’apprendimento in tempo reale. Tradotto in linguaggio manageriale: non aspettatevi che un LLM impari un compito complesso da due esempi buttati in un prompt, a meno che quel compito non rispetti certe regole di mixing time. In altre parole, non è vero che un LLM “impara” qualsiasi cosa al volo: sta semplicemente aggiornando la sua stima delle transizioni più probabili in base al contesto recente, e lo fa tanto meglio quanto più quel contesto è “mescolato” e regolare.

È un insight che cambia il modo di progettare applicazioni basate su prompt engineering: meno arte, più statistica. Ma provate a dirlo a chi continua a vendere corsi da mille euro su “come scrivere prompt perfetti”.

Il punto più sottile, quasi filosofico, è che questa lettura “Markoviana” restituisce una prospettiva più onesta sulla natura stessa del linguaggio artificiale. Non è un sistema che “capisce”, è un sistema che prevede. La sua forza sta nella quantità, non nella qualità. Non c’è nulla di male, se lo accettiamo. Anzi, è liberatorio riconoscere che questi modelli sono macchine probabilistiche, straordinariamente potenti ma altrettanto prevedibili nei loro difetti.

La vera domanda non è se un LLM possa diventare “intelligente” nel senso umano, ma se possiamo sfruttare la sua prevedibilità per costruire applicazioni più robuste, più sicure, più trasparenti. La risposta, per chi guarda al business, è sì.

Ma solo se smettiamo di raccontarci favole.In sintesi, il lavoro di Zekri e colleghi è una doccia fredda, una di quelle che fanno bene al mercato. Perché ricorda a tutti, investitori inclusi, che dietro la retorica dell’AI generativa ci sono catene di probabilità che obbediscono a leggi precise e chi capisce queste leggi, chi le padroneggia, non chi le ignora in nome della “magia”, sarà quello che guiderà il prossimo ciclo di innovazione. Gli altri continueranno a giocare a fare i visionari, fino al prossimo crollo di hype. Ma tranquilli, la matematica non si offende.