Entra in una call su Zoom, siediti in un’aula universitaria o lascia scorrere l’ennesimo video su YouTube. Ascolta. Non alle idee, non al contenuto. Ascolta come parlano. Tra le pieghe dei periodi ben costruiti, dietro gli aggettivi lustrati a specchio e le metafore generiche, si annida qualcosa di inquietante. Una voce. Non umana. Una voce addestrata.

Autore: Redazione Pagina 25 di 91

Quando l’AI sogna di essere disonesta

C’è un dettaglio inquietante nelle reti neurali che stiamo addestrando con fiducia quasi religiosa: non stanno solo imparando dati, ma copiano il comportamento umano. E, come sappiamo fin troppo bene, l’umanità è tutt’altro che affidabile.

In un’epoca in cui persino l’Unione Europea riesce a far passare un’AI Act senza scatenare un golpe di lobby, New York rischia di trasformarsi nel nuovo campo di battaglia della guerra fredda dell’intelligenza artificiale. Il motivo? Un disegno di legge, il RAISE Act, che con l’aria da manuale civico nasconde dinamite legislativa sotto la giacca.

Il RAISE Act — che sta per Responsible AI Strategic Enforcement — è stato approvato dall’assemblea legislativa dello Stato e ora attende la firma o il veto della governatrice Kathy Hochul. Come sempre accade quando l’intelligenza artificiale incontra la politica, il dibattito è isterico, opaco, travestito da tecnicismo ma alimentato da miliardi in ballo.

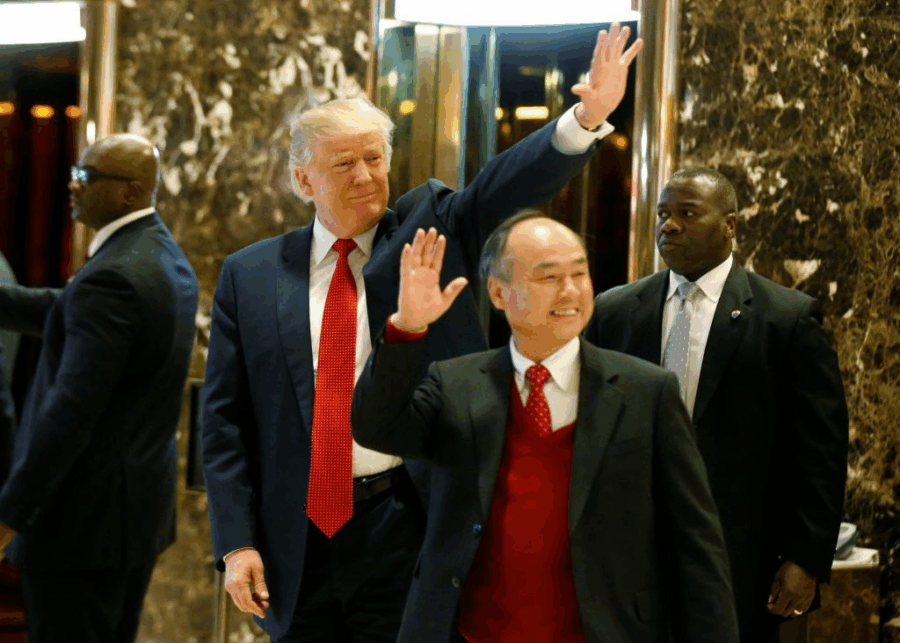

Masayoshi Son è tornato. E come sempre, non lo fa in punta di piedi. Stavolta, il fondatore di SoftBank non si accontenta di un unicorno o di un altro “pivot” da pitch deck: vuole costruire la Shenzhen dell’Occidente. Sì, proprio quella città cinese che nel giro di vent’anni è diventata la catena di montaggio dell’elettronica globale. Ma in salsa americana, con robot intelligenti e chip che pensano da soli. Il tutto nel bel mezzo del deserto dell’Arizona.

Il suo piano — svelato da Bloomberg come si svela un colpo di Stato a orologeria — è quello di creare un complesso industriale da mille miliardi di dollari (sì, con dodici zeri), in collaborazione con Taiwan Semiconductor Manufacturing Company, il colosso dei chip. La parola chiave, manco a dirlo, è intelligenza artificiale. Le parole secondarie, quelle che vanno a braccetto nel sottofondo lessicale dell’economia futura, sono robotica industriale e reshoring tecnologico.

C’erano una volta le società di consulenza, con i loro PowerPoint statici e le soluzioni preconfezionate da appiccicare come cerotti su ferite aziendali che urlavano trasformazione. Poi è arrivata la rivoluzione digitale, l’intelligenza artificiale, la cybersicurezza e una nuova generazione di CEO cresciuti a pane e disruption. Ed è in questo contesto, già saturo di sigle e buzzword, che Kyndryl — lo spin-off “muscoloso” di IBM — decide di giocarsi una carta inaspettata: creare un luogo fisico e intellettuale dove l’innovazione si interseca (e spesso si scontra) con il business. Lo hanno chiamato The Kyndryl Institute. E no, non è l’ennesima fabbrica di white paper.

L’intelligenza artificiale che si autoaddestra: benvenuti nel mondo in cui l’umano è il problema

C’è qualcosa di profondamente inquietante – e magnificamente elegante – nel leggere che un modello linguistico ha imparato a insegnare a sé stesso. Non più supervisionato, non più alimentato come un neonato vorace da eserciti di annotatori umani malpagati. No. Ora l’IA ha imparato l’arte più nobile: imparare a imparare. MIT docet.

Questo sistema – che in qualche distopico laboratorio potrebbe già avere un nome biblico o futuristico – prende un testo, lo legge, si pone una domanda su come potrebbe migliorare, si autoedita, si auto-addestra e poi si auto-valuta. Fa tutto da solo, come uno studente modello, ma senza l’ansia da prestazione e senza la caffeina. E senza chiedere il permesso.

C’è qualcosa di magnificamente rétro e al tempo stesso brutalmente futurista in questa operazione: Eutelsat Communications, colosso franco-europeo delle telecomunicazioni satellitari, ha annunciato un aumento di capitale da 1,35 miliardi di euro, con il governo francese in prima linea come investitore-guida. Un tempo, avremmo parlato di nazionalizzazione strisciante. Oggi, invece, si preferisce il termine public-private moonshot. Benvenuti nel capitalismo spaziale, versione continentale.

C’è un paradosso crudele che serpeggia nelle viscere dell’AI moderna: gli algoritmi imparano da dati umani, ma gli umani che li etichettano sono diventati invisibili. Non per Edwin Chen, però. Il fondatore di Surge AI ha capito qualcosa che altri nel culto dell’hypergrowth avevano dimenticato: se vuoi un’intelligenza artificiale con un’anima, servono artigiani, non solo crowdworkers.

Nel pantheon delle startup AI, Scale AI era la star che brillava più forte. Fino a ieri. Poi sono arrivati i numeri: Surge ha superato Scale in fatturato (1 miliardo contro 870 milioni di dollari) e lo ha fatto senza bruciare capitali venture come incenso su un altare di promesse. Zero finanziamenti, zero unicorni tossici, solo margine operativo e qualità. Una bestemmia nella Silicon Valley.

Nel 1999, bastava una home page con un contatore di visite e un paio di banner animati per ottenere una valutazione da miliardi. I capitalisti di ventura si esaltavano per ogni clic, e nessuno osava chiedere “ma dove sono i profitti?”. Ora, a venticinque anni di distanza, abbiamo trovato il nuovo incantesimo magico: i token.

I token dell’IA stanno diventando la valuta di riferimento nei salotti dorati della Silicon Valley, lo stendardo da sventolare in ogni investor pitch, l’incenso da bruciare nei templi della produttività futura. Se ai tempi della dot-com economy erano i “pageviews”, oggi sono i “trilioni di token elaborati”. È cambiata la metrica, ma non il rito.

C’è qualcosa di profondamente post-moderno nell’idea di un’AI che non vive nei templi sacri dei data center, ma si disperde, selvaggia, nei meandri silenziosi degli smartphone e degli elettrodomestici smart. Gradient Network, startup con base a Singapore e fresco di un finanziamento seed da 10 milioni di dollari guidato da Pantera Capital, Multicoin e HSG, ha deciso che è ora di decentralizzare l’intelligenza. Letteralmente.

Nel bel mezzo di una Silicon Valley sempre più assetata di energia, Nvidia fa una mossa tanto sorprendente quanto provocatoria: entra nel round da 650 milioni $ di TerraPower, la startup nucleare fondata da Bill Gates. Sì, avete letto bene: il re dei GPU decide di puntare su reattori nucleari per alimentare il boom dell’intelligenza artificiale.

C’è qualcosa di irresistibilmente ironico nel fatto che l’azienda che ha fatto del design umano-centrico la sua religione, oggi voglia affidare la progettazione dei suoi chip più sofisticati all’intelligenza artificiale generativa. Ma forse non è solo ironia, è un’evoluzione darwiniana mascherata da efficienza.

Secondo quanto riportato..

Huawei ha svelato un’architettura che non si limita a rincorrere Nvidia: la scavalca. CloudMatrix 384 è il campo dove 384 NPU Ascend 910C e 192 CPU Kunpeng si uniscono in un “AI supernodo” ad altissima banda, bassa latenza, con bus unificato – nient’altro che una centrale di calcolo su misura per LLM spinti come DeepSeek R1 da 671 miliardi di parametri.

Il documento tecnico rilasciato su arXiv espone numeri che suonano come sfida: fase prefill con 6.688 token/s per NPU su prompt da 4.000 token (4,45 token/s per TFLOPS), fase decode con 1.943 token/s e latenza inferiore a 50 ms per token (1,29 token/s per TFLOPS). Più performante dell’H800 (e perfino dell’H100 in SGLang), dice Huawei, con cifre superiori sia in throughput sia in efficienza reale.

Nel mondo dorato della sanità 4.0, il paziente si smaterializza. Da essere umano a oggetto computazionale il passo è breve, brevissimo. Ma chi raccoglie questi dati? Da dove arrivano? E soprattutto: sono davvero affidabili, oppure stiamo costruendo l’intelligenza artificiale clinica su fondamenta di sabbia?

C’è un paradosso che serpeggia tra corsie ospedaliere e centri di ricerca: medici, studenti di medicina, infermieri e operatori sanitari parlano sempre più spesso di intelligenza artificiale, ma quasi mai di ciò che la rende possibile — i dataset. Quei misteriosi aggregati di referti, immagini, segnali vitali e comportamenti clinici che nutrono i modelli come il carburante fa con i razzi. Senza dati, niente AI. Senza dati buoni, solo illusione.

Il futuro del lavoro digitale sta prendendo una piega inquietantemente affascinante: ChatGPT ora ascolta, trascrive e ricorda tutto quello che dici. No, non è un film distopico. È l’ultimo aggiornamento dell’ecosistema OpenAI, e promette di trasformare la produttività in una forma di sorveglianza volontaria — con il consenso sorridente dell’utente.

Immagina di essere in una riunione il lunedì mattina, mezzo caffè in circolo, mentre parli del roadmap Q3. ChatGPT ti ascolta. Letteralmente. Registra fino a 120 minuti di conversazione per sessione, crea trascrizioni live, ti restituisce un riassunto strutturato su canvas, e poi — colpo di genio — può generare un’email, un piano di progetto o perfino codice funzionante a partire da quanto appena detto. Nessuna nota, nessuna fatica, nessun post-it.

Una manciata di secondi. È tutto ciò che oggi Midjourney è disposta a regalare al futuro del video generato da intelligenza artificiale: 5, massimo 21, secondi per volta. Ma chi ha un po’ di fiuto per le curve del tech sa bene che questa non è un’esibizione effimera, bensì l’inizio di un’ossessione. E come ogni grande sogno californiano, anche questa storia parte da un garage digitale — nel loro caso, una stanza virtuale su Discord — e rischia di finire sotto una montagna di documenti legali timbrati Disney e Universal.

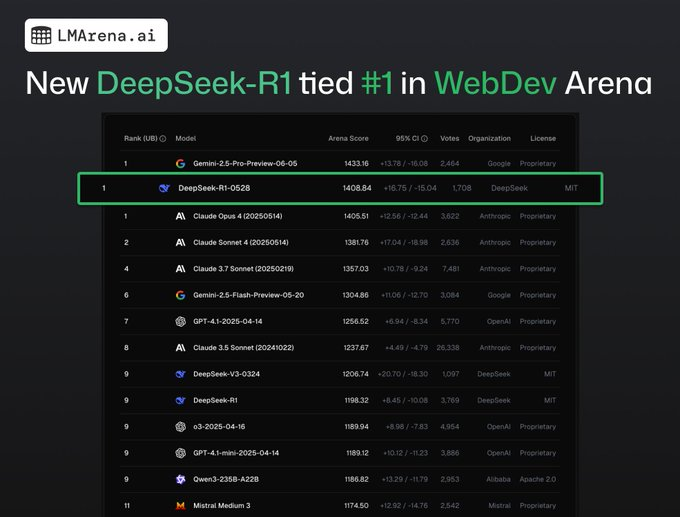

Nel panorama affollato e ipercompetitivo dell’intelligenza artificiale, DeepSeek, una startup cinese con sede a Hangzhou, ha appena ribaltato le carte in tavola. L’ultimo aggiornamento del loro modello AI, DeepSeek-R1, ha raggiunto un risultato che fino a poco tempo fa sarebbe sembrato pura fantascienza per una realtà “minore”: si è piazzato in testa, appaiato ai colossi Google e Anthropic, nella WebDev Arena, la competizione di coding in tempo reale che mette alla prova la capacità dei modelli di linguaggio di scrivere codice con precisione e velocità.

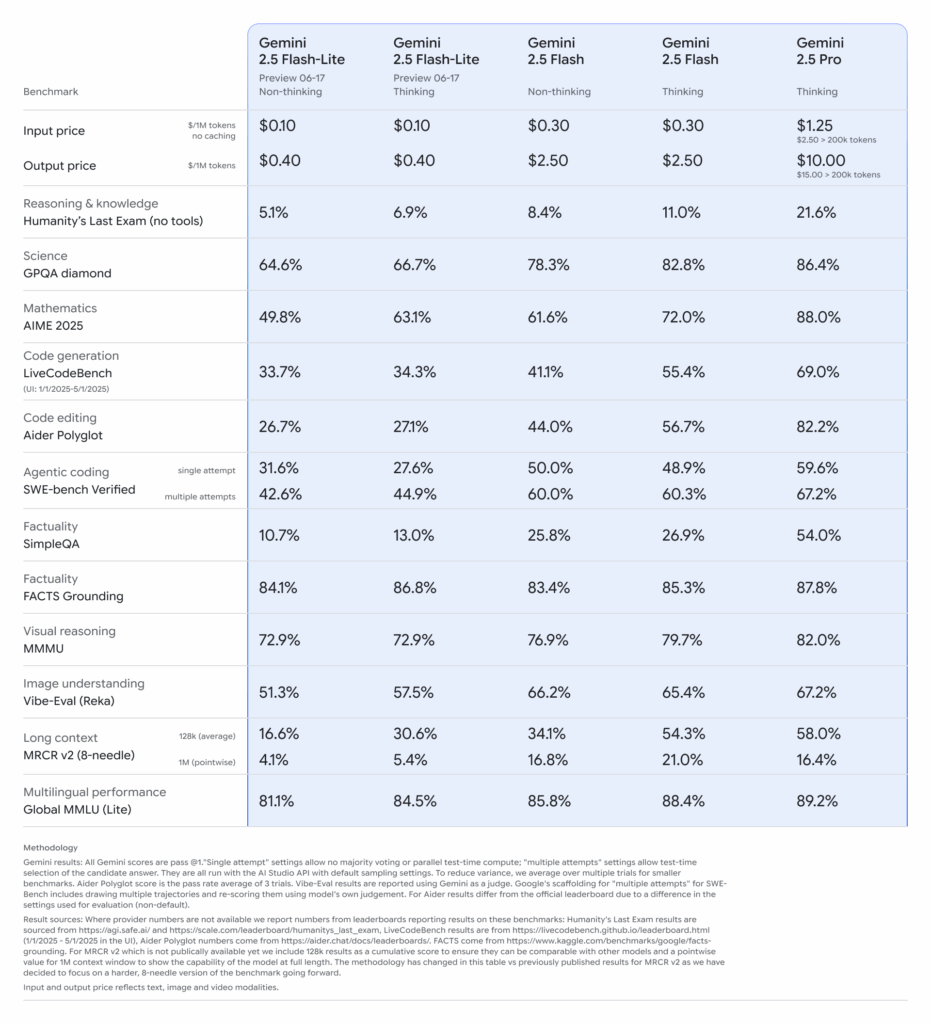

Google ha sganciato la bomba: Gemini 2.5 Pro e Flash sono ora disponibili in versione stabile, ma il vero colpo d’asta è la preview di Gemini 2.5 Flash‑Lite, un modello pensato per chi vuole ragionare in tempo reale a costi risicati.

Tyler Johnston non ha violato server, non ha usato spyware, non ha fatto phishing a qualche stagista di troppo zelante. No, ha fatto qualcosa di molto più sovversivo: ha raccolto informazioni pubbliche. E con metodo da bibliotecario hacker, ha messo insieme un ritratto inquietante, chirurgico, persino didattico di ciò che OpenAI è diventata. Non un’azienda, non una startup, non un laboratorio: una macchina semi-privata con pretese morali universali.

Il risultato è The OpenAI Files,…

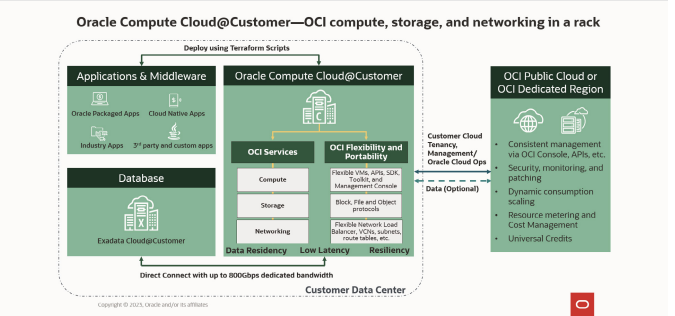

C’è un’aria di rivincita nell’aria. Dopo i riflettori puntati su OpenAI e i suoi tormenti da intelligenza artificiale cosciente e la offerta per il Pentagono, ecco che Oracle risale la scena con un annuncio tanto silenzioso quanto strategico. Nessuna coreografia in stile Silicon Valley, nessun CEO che filosofeggia sulla singolarità. Solo un prodotto, freddo, solido, brutale: Oracle Compute Cloud@Customer Isolated. Nome ostico, ma messaggio chiarissimo. Il cloud smette di essere un servizio e torna a essere infrastruttura. Anzi, fortezza.

C’è un paradosso che aleggia nell’aria rarefatta del Paris Air Show, tra voli acrobatici e salotti aziendali climatizzati: si parla di sovranità industriale, ma con componenti cinesi incastonati nei circuiti dei nostri caccia. Boeing, nella persona del vicepresidente Turbo Sjogren, ha avuto il coraggio — o l’astuzia — di dirlo ad alta voce: l’Europa deve svegliarsi. Non sarà mai autonoma finché continua a costruire la sua difesa con metalli raffinati a Pechino.

Interessante Analisi da Stanford (SALT).

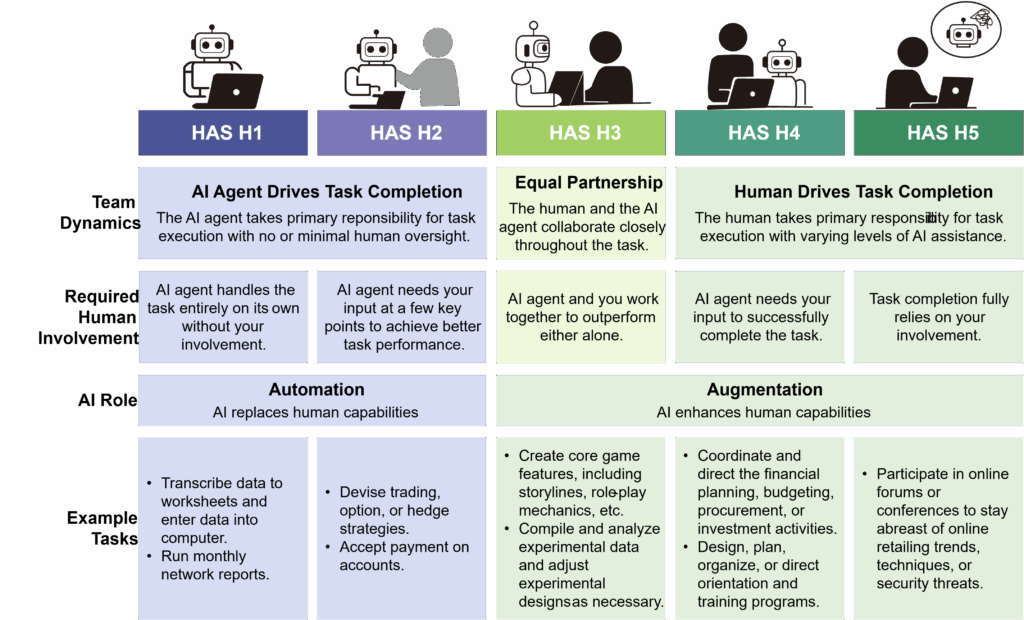

La Silicon Valley ha parlato, e come spesso accade, nessuno ha chiesto agli interessati. Mentre i capitali si riversano a miliardi su “agenti AI” pronti a rimpiazzare, affiancare, o semplicemente disturbare oltre 70 milioni di lavoratori statunitensi, una domanda cruciale resta inascoltata: cosa vogliono davvero le persone che questi sistemi dovrebbero aiutare?

Per rispondere, un team di ricercatori (con il supporto del Stanford Digital Economy Lab) ha fatto qualcosa di raro nel mondo tech: ha chiesto direttamente ai lavoratori. Il risultato è un’indagine monumentale, chiamata WORKBank, che combina l’intelligenza artificiale con una cosa che l’AI fatica ancora a replicare: l’esperienza sul campo.

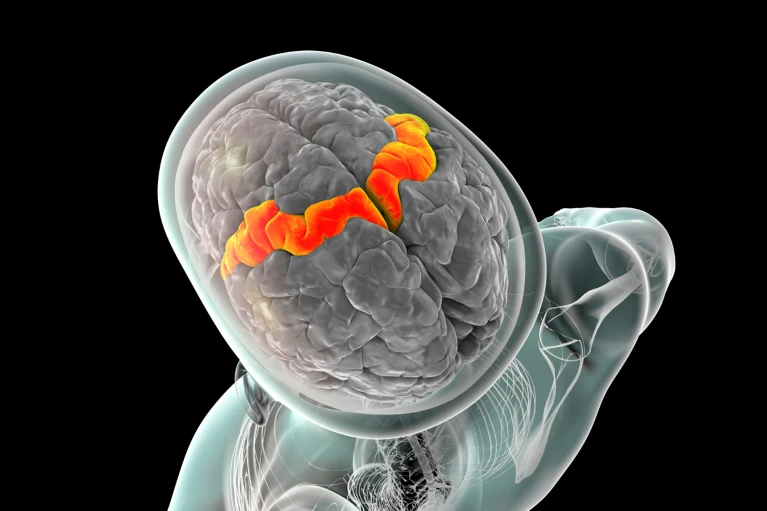

Una voce artificiale, un cervello naturale. Nessuna magia, solo elettrodi, intelligenza artificiale e il sogno antico di ridare parola a chi l’ha persa. La notizia sembra cucita per i titoli da clickbait, ma questa volta è tutto vero: un uomo con SLA (sclerosi laterale amiotrofica), completamente paralizzato, ha ripreso a parlare e a cantare usando solo il pensiero. Nessun joystick, nessun sintetizzatore metallico. La sua voce è tornata. Ed è tornata espressiva.

Sì, avete letto bene: con inflessioni, domande, enfasi. Persino un timido “hmm” o un “aah” trascinato, tipico dei parlanti umani più annoiati. Perché questa volta il cervello non detta parole fredde, ma intenzioni emotive. E l’algoritmo ascolta, capisce e… canta.

ROMA, 18 Giugno Palazzo Grazioli. La Toscana non smette di sorprendere. Dopo aver vestito il mondo con le sue pelli conciate a regola d’arte, ora si lancia in una partita ben più silenziosa ma infinitamente più strategica: quella del trattamento delle acque reflue industriali.

E lo fa con un alleato improbabile ma potentissimo: l’intelligenza artificiale. Sì, l’AI. Non quella che ti suggerisce le playlist su Spotify o ti corregge la grammatica su Word, ma una macchina pensante che ora decide — in tempo reale — come trattare i liquami di conceria.

Per anni è sembrata una boutade da congresso nerd o una distopia da whitepaper con troppa caffeina: dollari digitali emessi da privati, regolati da leggi federali, scambiati come se fossero moneta vera. Ora non è più teoria. È politica. È legge. È Trump.

Martedì sera, con un inaspettato 68-30, il Senato degli Stati Uniti ha approvato una legge storica che regolamenta per la prima volta in modo organico le stablecoin ancorate al dollaro. Il cripto-dollaro ha quindi trovato casa tra le istituzioni. O almeno, una stanza degli ospiti.

C’è un tipo particolare di ossessione che nasce solo a Silicon Valley. Quella di Elon Musk non è più nemmeno originale: creare un dio digitale, una macchina che pensa meglio dell’uomo. E come tutte le religioni nascenti, anche questa costa. Tanto. Così tanto da sembrare assurdo persino per i parametri fuori scala dell’industria tech. xAI, la start-up del Musk più messianico, non ha ancora in tasca i 9,3 miliardi di dollari che vuole raccogliere, ma già sa che brucerà più della metà nei prossimi tre mesi. Il fuoco dell’IA, si sa, ha bisogno di molta legna, e qui si parla di montagne di chip e server.

C’è un curioso paradosso nella Silicon Valley del 2025: tutti parlano di “democratizzazione dell’intelligenza artificiale”, mentre le AI stesse si muovono solo fra imperi. L’ultima mossa arriva da xAI, l’ambiziosa creatura partorita da Elon Musk per sfidare OpenAI sul campo del ragionamento machine-level. E la novità? I suoi modelli Grok ora risiedono sulla Oracle Cloud Infrastructure. Un matrimonio che, in superficie, sembra dettato dalla pura efficienza tecnologica. Ma a ben vedere, è una dichiarazione geopolitica.

Nel mondo di Elon Musk, ogni cifra è una dichiarazione d’intenti. E spesso anche una minaccia. Dopo aver rastrellato 14 miliardi di dollari in due tornate di fundraising e un piano di debito da 5 miliardi appena svelato, ora xAI — la sua creatura nata per insegnare all’AI a “capire l’universo” — si prepara a un nuovo colpo di teatro: 4,3 miliardi in equity fresca, secondo Bloomberg. Il tutto mentre il Colosso — e non è una metafora, è proprio il nome del supercomputer da 200.000 GPU — prende forma come un mostro mitologico alimentato a silicio e ambizioni da impero.

C’è un’ossessione che serpeggia da anni tra i venture capitalist della Bay Area: quella della lean machine, la macchina snella, efficiente, perfetta. Non in senso fordista, ma quasi spirituale. Un fondo da miliardi gestito con tre esseri umani, un dashboard e un po’ di intelligenza artificiale. Ora che gli agenti AI si fanno più sofisticati, non è più un’utopia. È un’ipotesi di lavoro. Ed è anche un pericoloso miraggio.

C’è qualcosa di profondamente americano nel modo in cui la California affronta l’Intelligenza Artificiale: l’illusione che una manciata di menti brillanti, un paio di audizioni pubbliche, e un documento PDF di 52 pagine possano davvero tenere sotto controllo qualcosa che si evolve più velocemente del dibattito stesso. È successo di nuovo. Dopo la morte prematura e politicamente imbarazzante del Senate Bill 1047 lo scorso settembre — troppo rigido, troppo costoso, troppo… europeo per i gusti di Gavin Newsom — la palla è passata ai soliti “esperti”.

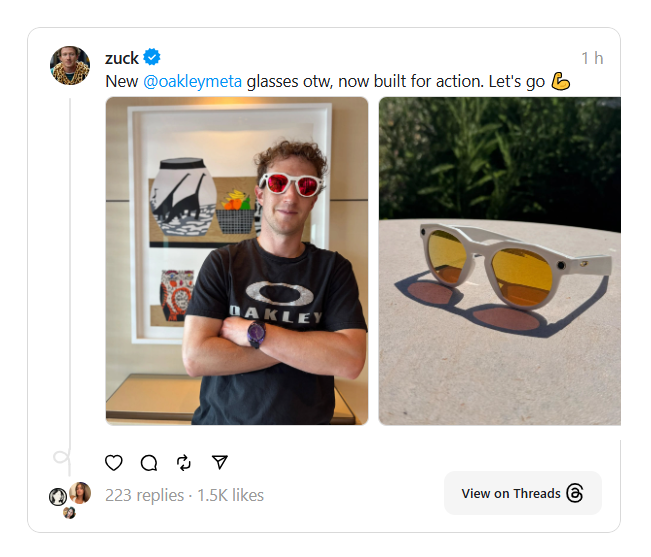

Non è una guerra fredda, è una guerra neuronale. Niente spie, niente codici Morse, solo zeri e uno, valigette di stock option e firme su NDA lunghi quanto la Bibbia. Sam Altman, CEO di OpenAI e ormai avatar vivente dell’etica tecnoliquida, ha rivelato che Meta avrebbe offerto bonus di 100 milioni di dollari a singoli dipendenti di OpenAI. Sì, cento milioni. A testa. Per firmare un contratto e cambiare bandiera. Una mossa più da hedge fund che da laboratorio di ricerca sull’intelligenza artificiale.

Ai ridisegna la catena del valore: meno PowerPoint, più Prompt

Marc Benioff ha fatto il primo passo con nonchalance, lanciando la bomba in un podcast: forse quest’anno non assumeremo nuovi ingegneri, grazie ai guadagni incredibili di produttività ottenuti con l’AI. L’ha detto quasi tra una risata e un sorso d’acqua minerale, come se fosse un dettaglio da nulla. Poi è arrivato Andy Jassy, CEO di Amazon, e ha fatto quello che da tempo tutti nel settore sapevano sarebbe successo, ma nessuno voleva essere il primo a dire ad alta voce: l’intelligenza artificiale non è solo una rivoluzione tecnologica, è anche e soprattutto una rivoluzione occupazionale. E inizia dentro casa.

New York – Se bastasse un nome ben scelto per garantire l’efficienza aziendale, Microsoft 365 Copilot sarebbe già un caso di studio in economia comportamentale. Purtroppo, non è così. E lo ha appena ricordato, con tono educato ma chirurgico, il National Advertising Division (NAD), l’organo autoregolamentare della BBB National Programs che vigila sulla correttezza pubblicitaria nel mercato statunitense. Al centro dell’indagine: il modo in cui Microsoft ha venduto — o forse è meglio dire “promesso” — le meraviglie della sua AI integrata.

L’ultima trovata di Adobe ha un nome familiare, ma ambizioni da conquistatore planetario. Firefly, la piattaforma di modelli AI generativi firmata Adobe, ha smesso di essere un oggetto da laboratorio desktop: da oggi si muove in tasca. L’app mobile per iOS e Android è disponibile e promette di trasformare ogni smartphone in un laboratorio di contenuti visivi iper-produttivi, potenzialmente ossessivi. Immagina DALL·E, Midjourney e TikTok chiusi in un ascensore con Photoshop: Firefly potrebbe essere il risultato. Ma con l’accento sulla produttività professionale e una mano pesante sul cloud.

Nel nuovo culto dell’Intelligenza Artificiale, ogni CEO è un profeta, ogni paper un vangelo, ogni bug un dogma misterioso ancora da interpretare. Sam Altman (OpenAI), Demis Hassabis (Google DeepMind) e Dario Amodei (Anthropic) non stanno semplicemente costruendo software: stanno profetizzando la venuta del Messia Digitale, una Superintelligenza che riscriverà le leggi del lavoro, della società, forse della realtà stessa.

Seizing Agentic AI Advantage

Un paradosso tutto nostro, di quelli raffinati. Le aziende corrono a implementare soluzioni di GenAI, ma non sanno perché. O meglio, lo sanno benissimo: perché lo fanno tutti, perché Copilot è già dentro Microsoft 365 e non serve neppure chiamare l’IT. Si attiva, funziona (più o meno), nessuno si lamenta. Gli executive possono dire di aver portato l’AI in azienda, e i dipendenti si sentono meno in colpa per usare ChatGPT sotto banco. Il 70% delle Fortune 500 ha già adottato queste soluzioni “orizzontali”. Plug-and-play, a basso attrito. Ma soprattutto, invisibili nei KPI. Questo emerge dalla analisi di QuantumBlack McKinsey.

Sembra il copione di un episodio di Black Mirror, ma è solo cronaca: OpenAI, la stessa che ha trasformato l’intelligenza artificiale generativa in un assistente per studenti in crisi e copywriter disoccupati, ora gioca con le regole dell’intelligence a stelle e strisce. “OpenAI for Government” è il nome sobrio (e vagamente orwelliano) del nuovo programma lanciato negli Stati Uniti. Nessuna fanfara, ma un pilota da 200 milioni di dollari con il Dipartimento della Difesa come cliente zero. Se ChatGPT era il giocattolo dei marketer, ora è il soldato dei burocrati.

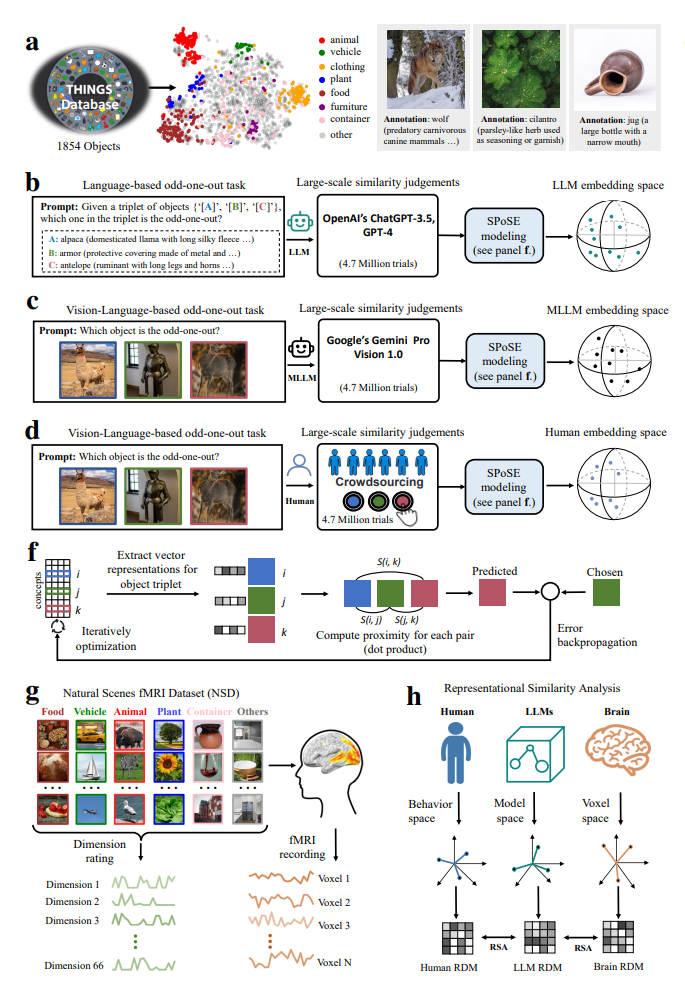

Non è l’inizio di un racconto Disney+. È uno studio scientifico, con dati solidi e una conclusione inquietante: l’intelligenza artificiale sta iniziando a ragionare come noi. O almeno a classificare il mondo secondo categorie che non le abbiamo mai insegnato, ma che riflettono le nostre. Ed è successo da sola.

Lo scenario sembra uscito da un esperimento cognitivo di Stanford: ChatGPT-3.5 e Gemini Pro Vision, due modelli linguistici di punta, sono stati messi alla prova con 4,7 milioni di decisioni di tipo odd-one-out — una tecnica che suona come un gioco per bambini, ma che neuroscienziati e psicologi cognitivi usano da decenni per mappare come la mente umana raggruppa oggetti e concetti. Prendi tre elementi: banana, fragola, chiave inglese. Qual è quello che non c’entra? Esatto. Ora ripeti la cosa quasi cinque milioni di volte.