La startup cinese Zhipu AI ha recentemente raccolto oltre 1 miliardo di yuan (circa 137,22 milioni di dollari) in un nuovo round di finanziamento, pochi mesi dopo aver ottenuto un investimento di 3 miliardi di yuan. Questo finanziamento è stato guidato da investitori statali come Hangzhou City Investment Group Industrial Fund e Shangcheng Capital. I fondi saranno utilizzati per migliorare il modello di linguaggio GLM di Zhipu AI e per espandere il suo ecosistema di intelligenza artificiale, con un focus sulle imprese nella provincia di Zhejiang e nella zona economica del delta del fiume Yangtze.

Autore: Redazione Pagina 49 di 91

Scopri i migliori strumenti di Intelligenza Artificiale per la sintesi di testi nel 2025! Questa pagina presenta tool AI per riassumere documenti, generare contenuti e rispondere a domande, ideali per professionisti e ricercatori. Esplora le innovazioni che ottimizzano il tuo lavoro!

Honor, azienda cinese leader nella tecnologia, ha annunciato al Mobile World Congress (MWC) 2025 di Barcellona un investimento di 10 miliardi di dollari nei prossimi cinque anni per sviluppare un ecosistema di dispositivi basati sull’intelligenza artificiale (AI). Questo ambizioso progetto, denominato “Honor Alpha Plan”, mira a trasformare l’azienda da semplice produttore di smartphone a leader nell’integrazione dell’AI in vari dispositivi, tra cui PC, tablet e dispositivi indossabili.

Anthropic raggiunge una valutazione di 61,5 miliardi di dollari dopo l’ultimo round di finanziamento

Anthropic, la startup di intelligenza artificiale fondata nel 2021 da ex dipendenti di OpenAI, ha recentemente concluso un significativo round di finanziamento, raccogliendo 3,5 miliardi di dollari e raggiungendo una valutazione post-money di 61,5 miliardi di dollari.

Questo investimento è stato guidato da Lightspeed Venture Partners, con la partecipazione di altri importanti investitori come Cisco Investments, Salesforce Ventures e Fidelity Management & Research Company.

In questa directory vi proponiamo una selezione dei migliori strumenti di Intelligenza Artificiale per creare contenuti artistici nel 2025! Questa pagina presenta tool AI per generare opere d’arte, creare illustrazioni e ottimizzare processi creativi, ideali per artisti, designer e creator digitali.

L’espansione dei data center continua a spingere la domanda di soluzioni di networking sempre più performanti, con l’intelligenza artificiale che accelera la necessità di interconnessioni ad alta velocità. Secondo Jefferies, questo scenario sta creando opportunità significative per aziende chiave nel settore, come Coherent e Lumentum Holdings entrambe promosse con un rating di acquisto dall’istituto di investimento.

Il team di analisti guidato da Blayne Curtis ha evidenziato che Coherent non sta cavalcando una rivoluzione tecnologica, ma piuttosto consolidando la sua posizione dominante nel mercato dei transceiver a 400G, con una probabile leadership anche negli 800G. Tuttavia, l’azienda è stata penalizzata da una serie di acquisizioni fallite, ristrutturazioni e spese non necessarie, fattori che hanno inciso sul valore azionario. Un punto critico per Coherent rimane la capacità dei VCSEL di sostenere velocità di 200G per lane, ma la società si è detta fiduciosa nello sviluppo di soluzioni avanzate, affiancate da un business in crescita nelle tecnologie EML e Silicon Photonics (SiPho).

La Cina ha recentemente emesso direttive che invitano i principali imprenditori e ricercatori nel campo dell’intelligenza artificiale (IA) a evitare viaggi negli Stati Uniti a causa di preoccupazioni legate alla sicurezza nazionale. Le autorità temono che durante tali viaggi possano essere divulgate informazioni sensibili sui progressi cinesi nell’IA e che gli esecutivi possano essere detenuti, utilizzati come strumenti nelle negoziazioni tra Stati Uniti e Cina.

In questa directory abbiamo voluto raccogliere i migliori strumenti di Intelligenza Artificiale disponibili al momento per generare immagini nel 2025! Questa pagina contiene un elenco di tool AI per creare contenuti visivi unici, migliorare la qualità e automatizzare flussi di lavoro, ideali per artisti, designer, appassionati e semplici curiosi.

Nel 2025, se sei una Pubblica Amministrazione e stai ancora cercando “spazio server” come se fossi in un episodio del 2006, sei fuori tempo massimo. Ma c’è una buona notizia: la digitalizzazione della PA può finalmente fare il salto di qualità, grazie a un’accoppiata che fino a poco fa sembrava utopica — infrastruttura sostenibile e procurement intelligente. E in questo gioco, operatori come Seeweb non sono solo “fornitori”, ma abilitatori sistemici.

Il Consiglio dei Ministri ha dato il via libera preliminare a un disegno di legge che conferisce una delega al governo per regolamentare il ritorno dell’energia nucleare in Italia. Il testo, composto da quattro articoli, stabilisce una cornice normativa per lo sviluppo dell’energia nucleare sostenibile e della fusione, con l’obiettivo di contribuire al raggiungimento dei target di decarbonizzazione e sicurezza energetica delineati dal Piano Nazionale Integrato Energia e Clima (PNIEC). Contestualmente, l’esecutivo ha approvato anche un decreto contro il caro bollette, segnando una strategia più ampia per affrontare le sfide energetiche del Paese.

Dans un continent où la paperasse circule plus vite que la fibre optique, et où l’innovation est trop souvent étranglée par les règlements, l’Europe essaie tant bien que mal de se faire une place dans le paysage de l’intelligence artificielle. Alors que les États-Unis et la Chine avancent à marche forcée, l’Ancien Continent oscille entre rêves de souveraineté numérique et réalité de la fragmentation.

Et pourtant, il se passe quelque chose. Une nouvelle génération de fournisseurs d’inférence IA émerge, déterminée à respecter les normes européennes tout en jouant dans la même cour que les géants transatlantiques.

Abbiamo visto in un precedente articolo come Alibaba abbia compiuto un passo strategico nell’arena dell’Intelligenza Artificiale generativa, rendendo open-source il suo modello Wan 2.1, specializzato nella creazione di immagini e video. Vediamone da vicino le potenzialità con 10 esempi particolarmente impressionanti.

OpenAI ha recentemente esteso la disponibilità di sora, il suo avanzato strumento di generazione video basato su intelligenza artificiale, agli utenti del regno unito e dell’europa. Questo strumento consente la creazione di video realistici attraverso semplici prompt testuali, rappresentando un significativo passo avanti nella produzione di contenuti digitali. Tuttavia, il lancio di sora in queste regioni avviene in un contesto di accese discussioni riguardanti la protezione del copyright e l’uso dell’ia generativa.

Sora è accessibile esclusivamente agli abbonati ai piani premium di chatgpt: plus, al costo di $20/£20 al mese, e pro, a $200/£200 al mese. Gli utenti possono generare video fino a 20 secondi in risoluzione 1080p, con la possibilità di scegliere tra formati widescreen, verticali o quadrati. oltre alla creazione da prompt testuali, sora permette di caricare immagini per generare video correlati e offre funzionalità di editing come storyboard e remix, facilitando la personalizzazione dei contenuti.

Scopri i migliori strumenti di Intelligenza Artificiale per la ricerca nel 2025! Questa pagina presenta tool AI per analizzare dati, risolvere problemi e sintetizzare contenuti, ideali per studenti, ricercatori e professionisti. Esplora le innovazioni che rivoluzionano la tua esperienza di ricerca!

OpenAI ha appena annunciato il lancio di GPT-4.5, definendolo il suo “modello più grande e più competente fino ad oggi”. Tuttavia, c’è subito una precisazione: non è un modello di frontiera e, paradossalmente, potrebbe non essere all’altezza di o1 o o3-mini, due modelli interni che sembrano superarlo in diverse metriche. Un debutto con il freno a mano tirato.

Secondo OpenAI, GPT-4.5 offre miglioramenti nelle capacità di scrittura, una conoscenza del mondo più aggiornata e una personalità più raffinata rispetto ai modelli precedenti.

Ma attenzione: non introduce abbastanza novità per essere classificato come una vera evoluzione. Un documento trapelato prima dell’annuncio afferma che “GPT-4.5 non è un modello di frontiera, ma è il più grande LLM mai realizzato da OpenAI, migliorando l’efficienza computazionale di GPT-4 di oltre 10 volte”. Un bel traguardo tecnico, che però non porta con sé “sette nuove capacità fondamentali di ragionamento” rispetto ai precedenti aggiornamenti. Insomma, una crescita muscolare senza una reale svolta.

E costoso è la parola chiave qui. Il nuovo modello di OpenAI ha un prezzo API da capogiro di 75 $ per milione di token di input e 150 $ per milione di token di output, è dieci volte più costoso di Claude 3.7 Sonnet , il che lo rende potenzialmente proibitivo per molti sviluppatori e startup che intendono sfruttare questa tecnologia.

Nel panorama in rapida evoluzione dell’intelligenza artificiale, Tencent ha recentemente presentato il suo ultimo modello, Hunyuan Turbo S, progettato per superare le limitazioni dei concorrenti “a pensiero lento”. Questo avanzamento rappresenta un passo significativo nella competizione globale per l’innovazione nell’IA.

Hunyuan Turbo S si distingue per la sua capacità di fornire risposte in meno di un secondo, eliminando i ritardi che affliggono modelli come DeepSeek R1 e Hunyuan T1. Questa rapidità non compromette la qualità; infatti, le competenze in ambito conoscitivo, matematico e di ragionamento di Turbo S sono paragonabili a quelle di DeepSeek-V3, un modello che ha recentemente superato ChatGPT di OpenAI in termini di download su app store.

Philadelphia accoglie il riconoscimento di un’eccellenza italiana nel campo dell’intelligenza artificiale: Roberto Navigli, ordinario di Intelligenza Artificiale presso la Sapienza Università di Roma, è stato insignito del prestigioso titolo di Fellow dell’AAAI (Association for the Advancement of Artificial Intelligence), l’organizzazione scientifica più autorevole nel settore dell’IA a livello globale.

Navigli è l’unico ricercatore europeo a ricevere il titolo nel 2025, un segnale forte della rilevanza internazionale delle sue ricerche. La motivazione ufficiale sottolinea i suoi “contributi significativi alla comprensione del linguaggio naturale multilingue e lo sviluppo di metodi ampiamente riconosciuti per la costruzione di risorse di conoscenza, la disambiguazione del testo e il parsing semantico”. Un riconoscimento che va ben oltre il merito accademico, testimoniando l’impatto rivoluzionario che le sue ricerche hanno avuto sul Natural Language Processing (NLP) a livello globale.

Il governo italiano accelera sulla ripresa del nucleare. Durante un’audizione alle commissioni riunite Attività produttive e Ambiente della Camera, il Ministro delle Imprese e del Made in Italy, Adolfo Urso, ha annunciato l’intenzione del Consiglio dei Ministri di presentare un disegno di legge (DDL) per delineare il nuovo quadro normativo sul nucleare. Contestualmente, si sta lavorando alla creazione di una nuova realtà industriale che vedrà la partecipazione delle maggiori aziende pubbliche italiane.

L’Unione Europea ha svelato il tanto atteso Clean Industrial Deal, un piano che punta a rilanciare la competitività industriale del continente con una ricetta basata su meno vincoli ambientali, più aiuti di Stato e un’opzione Buy European per contrastare la pressione di Stati Uniti e Cina. Accanto a questo pacchetto, Bruxelles ha presentato misure per ridurre la burocrazia e un piano per abbassare le bollette energetiche delle imprese, due elementi cruciali per rendere il contesto industriale europeo più dinamico.

Nvidia è diventata il pilastro dell’intelligenza artificiale generativa grazie alle sue GPU avanzate, trasformandosi in una delle aziende più preziose al mondo. Il suo chip H100 è diventato così richiesto da essere ormai un bene di lusso, con prezzi alle stelle e disponibilità limitata. Questo dominio ha spinto il valore di mercato dell’azienda oltre il trilione di dollari, segnando un’era in cui i chip AI sono il nuovo petrolio dell’industria tecnologica.

Tuttavia, la leadership di Nvidia non è incontrastata. I giganti del settore, tra cui Microsoft, Meta, OpenAI, Amazon e Google, hanno deciso di progettare i propri processori AI per ridurre la dipendenza dalla casa di Santa Clara e abbattere i costi. OpenAI, ad esempio, è prossima al lancio del proprio chip sviluppato in collaborazione con TSMC, utilizzando la tecnologia a 3 nanometri per massimizzare efficienza e prestazioni.

Recentemente, Alibaba Group Holding Ltd è stata aggiunta alla lista “Best Ideas” di Benchmark, un riconoscimento che ha immediatamente influenzato positivamente il valore delle sue azioni. Questo riconoscimento è il risultato di una serie di sviluppi strategici e finanziari che hanno consolidato la posizione di Alibaba come leader nell’e-commerce e nell’intelligenza artificiale (AI) in Cina.

Nel trimestre conclusosi a dicembre 2024, Alibaba ha registrato un incremento dell’8% nei ricavi, raggiungendo 280,2 miliardi di yuan (circa 36,65 miliardi di euro). Parallelamente, l’utile netto è salito a 48,9 miliardi di yuan, evidenziando una solida performance finanziaria. Questi risultati sono stati trainati principalmente dalla crescita nel settore dell’e-commerce e dagli investimenti nell’AI. Il CEO Eddie Wu ha annunciato piani per investire significativamente nell’AI e nel cloud computing nei prossimi tre anni, con l’obiettivo di sviluppare un’intelligenza artificiale generale (AGI).

Amazon ha finalmente svelato Alexa+ (Plus), la nuova versione del suo assistente vocale, potenziata dall’intelligenza artificiale generativa. Questa evoluzione rappresenta un salto significativo rispetto alla versione tradizionale di Alexa, grazie all’integrazione di modelli linguistici avanzati (LLMs) e un ecosistema di servizi più esteso, che include news, ordini online e interazioni con app di terze parti.

Alexa+ non sarà solo un assistente più intelligente, ma anche più proattivo. Sarà in grado di organizzare eventi nel calendario, acquistare biglietti per concerti e rispondere in modo più articolato e contestuale alle domande degli utenti. Inoltre, Amazon ha introdotto una nuova piattaforma web, alexa.com, e un’app mobile aggiornata per gestire e interagire con Alexa Plus in modo ancora più intuitivo.

A partire dal novembre 2024, una parte significativa dell’arretrato di segnalazioni di incidenti SU AIID relativi all’intelligenza artificiale è stata processata, permettendo tra dicembre 2024 e gennaio 2025 di monitorare con maggiore efficienza gli eventi in tempo reale. Durante questo periodo, siamo riusciti a tenere il passo con i nuovi incidenti mentre continuavamo a scoprire casi precedenti che erano stati trascurati. Questo processo ci ha permesso di fare luce su una serie di eventi preoccupanti che continuano a evolversi e a influenzare la società, mostrando come l’intelligenza artificiale venga sempre più utilizzata per scopi dannosi, sia in ambito politico che sociale.

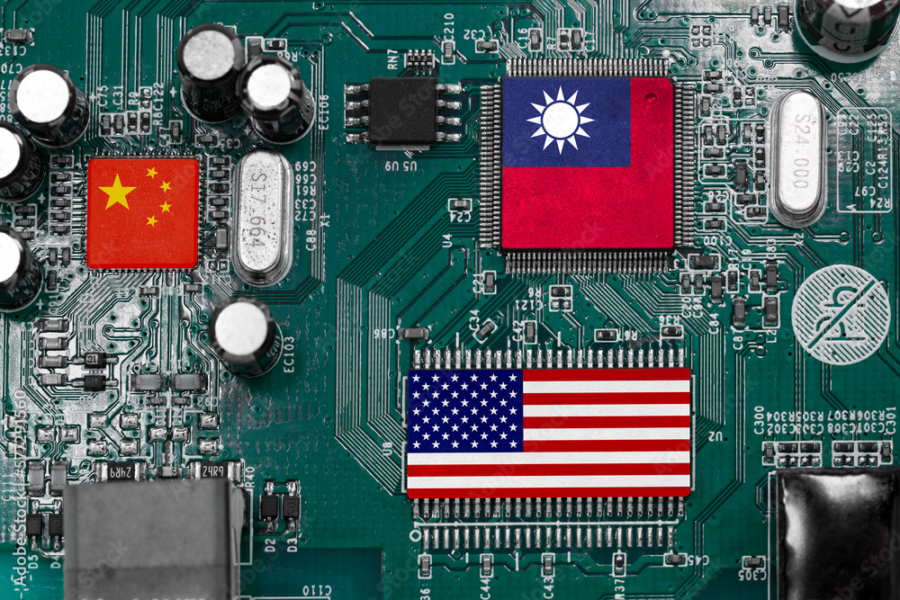

La Cina ha recentemente accusato Taiwan di voler “regalare” la propria industria dei semiconduttori agli Stati Uniti in cambio di supporto politico da Washington. Questa dichiarazione segue notizie di discussioni tra Taiwan Semiconductor Manufacturing Co (TSMC) e Intel riguardo a una possibile acquisizione di quote, sebbene nessuna delle due aziende abbia confermato ufficialmente tali trattative.

Secondo Pechino, il Partito Progressista Democratico (DPP) al governo a Taiwan starebbe sfruttando l’industria dei semiconduttori per ottenere vantaggi personali e promuovere l’indipendenza dell’isola, che la Cina considera parte integrante del proprio territorio. Le autorità cinesi sostengono che questa strategia mira a trasferire tecnologie chiave agli Stati Uniti, mettendo a rischio la sovranità tecnologica regionale.

Anthropic ha annunciato che la sua ultima versione di Claude, il modello 3.7 Sonnet, è riuscita a giocare e vincere al classico videogioco Pokémon, dimostrando capacità avanzate di ragionamento e adattamento.

Secondo un thread pubblicato su X, Claude 3.7 Sonnet ha sconfitto il primo capopalestra, Brock, dopo poche ore di gioco e ha battuto Misty nei giorni successivi. Un progresso che i modelli precedenti, come Claude 3.5 Sonnet, non erano in grado di raggiungere, spesso rimanendo bloccati o vagando senza una strategia chiara.

OpenAI ha recentemente introdotto una nuova funzionalità per ChatGPT denominata Deep Research, progettata per assistere gli utenti in attività di ricerca complesse che normalmente richiederebbero diverse ore di lavoro umano. Questa innovazione è disponibile per gli abbonati ai piani Plus, Team, Edu ed Enterprise di ChatGPT.

Deep Research si distingue per la sua capacità di operare in modo autonomo, pianificando ed eseguendo una serie di passaggi per raccogliere, interpretare e analizzare grandi quantità di dati provenienti da testi, immagini e PDF disponibili online. Questa funzionalità consente all’IA di adattarsi dinamicamente alle informazioni trovate, modificando il suo approccio in tempo reale quando necessario. In pratica, Deep Research funge da assistente personale virtuale, supportando gli utenti in progetti di ricerca articolati e fornendo risposte dettagliate e contestualizzate.

Alibaba ha compiuto un passo strategico nell’arena dell’intelligenza artificiale generativa, rendendo open-source il suo modello Wan 2.1, specializzato nella creazione di immagini e video. Questa mossa si inserisce in un contesto di forte competizione nel mercato dell’AI, dove colossi tecnologici cinesi e occidentali si contendono la leadership.

Il gigante dell’e-commerce ha rilasciato quattro varianti del modello: T2V-1.3B, T2V-14B, I2V-14B-720P e I2V-14B-480P. Queste versioni offrono capacità avanzate di generazione di immagini e video, partendo sia da input testuali che visivi. Tra le innovazioni più rilevanti, il modello è in grado di gestire effetti testuali sia in cinese che in inglese, migliorando significativamente la qualità visiva grazie a un’elaborazione ottimizzata dei movimenti complessi, della risoluzione e della fedeltà fisica delle animazioni generate.

Il modello T2V-14B è progettato per la creazione di contenuti visivi di alta qualità, offrendo eccellenti dinamiche di movimento. D’altra parte, il modello T2V-1.3B rappresenta un equilibrio tra qualità e potenza computazionale, risultando ideale per una vasta gamma di sviluppatori, sia nel campo dello sviluppo secondario che nella ricerca accademica. Ad esempio, con un laptop standard, gli utenti possono utilizzare il modello T2V-1.3B per generare un video di 5 secondi a 480p in circa 4 minuti.

Rivista.ai parteciperà all’AI Festival 2025, l’AI Festival 2025, in programma il 26 e 27 febbraio a Milano presso l’edificio Roentgen dell’Università Bocconi, rappresenta un appuntamento imperdibile per professionisti, aziende e appassionati di intelligenza artificiale. Organizzato da WMF – We Make Future e Search On Media Group, l’evento si focalizza sull’integrazione dell’AI nei processi aziendali, lavorativi e sociali, esplorando sia le applicazioni pratiche che le implicazioni etiche di questa tecnologia emergente.

Il programma formativo dell’AI Festival 2025 è strutturato per offrire una visione completa e approfondita delle diverse sfaccettature dell’intelligenza artificiale. Tra le sessioni previste, spiccano due percorsi principali:

- AI Agents: dedicato all’evoluzione degli agenti AI e alle loro applicazioni in vari settori, analizzando come queste tecnologie stiano trasformando le interazioni e i servizi.

- Deep Tech: un’immersione nei trend tecnologici emergenti, offrendo una comprensione avanzata delle innovazioni che stanno plasmando il futuro dell’AI.

Oltre a queste aree tematiche, l’evento prevede sessioni plenarie e 14 sale formative, con interventi di oltre 160 esperti di fama mondiale. Tra gli speaker confermati, figurano rappresentanti di aziende leader come IBM, Microsoft e Oracle, nonché esponenti di istituzioni italiane ed europee, tra cui l’Agenzia per la Cybersicurezza Nazionale e il Parlamento Europeo. Questi interventi offriranno approfondimenti su temi quali la trasformazione digitale, il marketing, la programmazione e la governance nell’era dell’intelligenza artificiale.

DeepSeek, la startup cinese di intelligenza artificiale che ha scosso il mercato con il modello R1, sta anticipando il lancio del suo nuovo LLM, denominato R2. Secondo fonti interne citate da Reuters, l’azienda aveva pianificato il debutto per maggio, ma ora punta a renderlo disponibile il prima possibile. L’obiettivo è chiaro: consolidare il proprio vantaggio e dimostrare che l’intelligenza artificiale può evolversi senza i budget colossali tipici delle Big Tech statunitensi.

L’impatto del lancio di R1 è stato dirompente, non solo per la qualità del modello ma anche per il suo approccio economico e scalabile. Il report pubblicato da DeepSeek ha messo in discussione il dogma secondo cui solo investimenti miliardari possono alimentare l’innovazione nel settore AI. La reazione del mercato è stata evidente: il 27 gennaio, il giorno successivo all’annuncio di R1, i titoli tecnologici USA hanno subito un tracollo, con Nvidia che ha perso circa 589 miliardi di dollari di capitalizzazione.

Il mercato dell’auto in Europa sta cambiando rapidamente, con un chiaro spostamento delle preferenze dei consumatori verso soluzioni ibride ed elettriche. Secondo i dati diffusi dall’Associazione dei Costruttori Europei (Acea), a gennaio 2025 le immatricolazioni di auto ibride sono aumentate del 18,4% rispetto all’anno precedente, conquistando il 34,9% del mercato complessivo. Questo balzo ha reso le ibride la prima scelta degli europei, sorpassando le auto a benzina, che hanno subito un calo drastico del 18,9%, scendendo al 29,4%. Ancora più netto il declino del diesel, ormai relegato al 10% del mercato con un crollo del 27% su base annua.

Genova si candida a diventare un hub strategico per il futuro digitale dell’Europa. A delineare questa ambiziosa prospettiva è Roberto Cingolani, amministratore delegato di Leonardo, che ha individuato nella città ligure una serie di condizioni favorevoli per trasformarla nella “città del dato”.

Anthropic, la startup AI sostenuta da Amazon, è destinata a ridefinire il panorama dell’intelligenza artificiale con il suo ultimo round di finanziamento. Secondo il Wall Street Journal, l’azienda ha raccolto 3,5 miliardi di dollari, portando la sua valutazione complessiva a 61,5 miliardi di dollari. Questo segna un’accelerazione significativa rispetto agli obiettivi iniziali, che miravano a un finanziamento di 2 miliardi, ma la crescente popolarità del chatbot Claude ha spinto gli investitori a scommettere ancora più pesantemente sulla società.

Il round di finanziamento ha visto la partecipazione di importanti fondi di venture capital come Lightspeed Venture Partners, General Catalyst e Bessemer Venture Partners. Questa ondata di capitali arriva in un momento in cui Anthropic sta registrando una crescita esponenziale, con un tasso di ricavi annualizzato che ha recentemente raggiunto 1,2 miliardi di dollari.

Nel tumultuoso mondo delle criptovalute, l’exchange Bybit è recentemente balzato agli onori della cronaca per un attacco informatico senza precedenti. Hacker sofisticati sono riusciti a sottrarre oltre 1,4 miliardi di dollari in Ethereum dai portafogli “freddi” della piattaforma, segnando il più grande furto nella storia delle valute digitali.

L’attacco ha avuto luogo durante una routine di trasferimento di fondi da un portafoglio offline a uno online. Gli aggressori hanno sfruttato una tecnica avanzata di phishing, creando un’interfaccia falsa che replicava la piattaforma di gestione dei portafogli di Bybit. Questo stratagemma ha ingannato i dirigenti dell’azienda, inducendoli ad approvare una transazione verso un indirizzo sconosciuto.

Nel quadro del nuovo partenariato strategico bilaterale tra Italia ed Emirati Arabi Uniti, l’amministratore delegato di Eni, Claudio Descalzi, ha siglato tre accordi di collaborazione con importanti aziende emiratine che, oltre a rafforzare la cooperazione tra i due Paesi, rappresentano un passo significativo nello sviluppo di infrastrutture energetiche e tecnologiche avanzate.

La notizia ha scosso la comunità scientifica e tecnologica. Bloomberg riporta che alcuni dipendenti hanno già ricevuto comunicazioni verbali sugli imminenti licenziamenti. Wired, invece, ha riferito di recenti visite di funzionari del DOGE presso il Technology Laboratory del NIST nel campus di Gaithersburg, nel Maryland, segno di un’imminente ristrutturazione.

Anthropic ha recentemente introdotto claude 3.7 sonnet, un modello di intelligenza artificiale di “ragionamento ibrido” progettato per affrontare problemi complessi, con particolare attenzione a matematica e programmazione. Questo avanzamento rappresenta un passo significativo nell’evoluzione dei modelli di linguaggio, combinando diverse tecniche di ragionamento per migliorare l’efficacia nella risoluzione di problemi.

Nel 2025, mentre l’industria tecnologica continua a espandersi, una domanda cruciale emerge: quanto è sostenibile il nostro mondo digitale? The Green Web Foundation (TGWF), organizzazione no-profit fondata nel 2008, si pone l’obiettivo ambizioso di rendere Internet priva di combustibili fossili entro il 2030.

TGWF monitora l’energia utilizzata dai siti web, fornendo un dataset aperto che verifica se un sito è alimentato da fonti rinnovabili . Questo strumento è diventato essenziale per le aziende e le organizzazioni che desiderano ridurre la loro impronta digitale.

Coinbase vince la guerra contro la SEC: nessuna multa, nessuna resa, solo 50 milioni di spese legali

Coinbase, il più grande exchange di criptovalute negli Stati Uniti, ha ufficialmente archiviato la causa con la Securities and Exchange Commission (SEC) senza pagare un centesimo di multa e senza dover modificare il proprio business. In altre parole, la SEC ha bruciato mesi di risorse per ottenere il nulla cosmico. Le azioni di Coinbase hanno risposto con un modesto +2,2% nella mattinata di venerdì, come se il mercato avesse già fiutato da tempo l’ennesimo bluff dell’ente regolatore.