Il CEO Tim Cook ha dichiarato a febbraio durante un’assemblea degli azionisti online :

“Entro la fine dell’anno – ha detto Cook – non vedo l’ora di condividere con voi i modi in cui apriremo nuovi orizzonti nell’intelligenza artificiale generativa, un’altra tecnologia che crediamo possa ridefinire il futuro”.

“Apple – ha proseguito – ha preso atto dell’incredibile potenziale rivoluzionario dell’intelligenza artificiale generativa e sta investendo in modo significativo in questo settore”.

ReALM è la nuova intelligenza artificiale di Apple che, a differenza di molte altre AI, può comprendere un contesto, inclusi i suoi elementi ambigui, senza che questi debbano essere necessariamente indicati e specificati dall’interlocutore. Questo le permette di cogliere sottotesti in modo più dettagliato, consentendo interazioni più naturali con gli utenti.

La risoluzione di questo problema è una parte importante della comprensione del linguaggio naturale, poiché consente agli utenti di utilizzare pronomi e altri riferimenti indiretti senza generare confusione nella macchina. Nella creazione degli assistenti digitali, lo sviluppo della capacità di comprensione delle anafore, applicato a segnali verbali e informazioni visive, ha rappresentato storicamente una sfida significativa.

Il sistema ReALM di Apple cerca di risolvere questo problema convertendo il complesso processo di risoluzione dei riferimenti in un puro problema di modellazione del linguaggio. In tal modo, può comprendere riferimenti a elementi visivi visualizzati su uno schermo e integrare in automatico questa comprensione. Questo rappresenta un passo avanti significativo nel campo dell’intelligenza artificiale.

La “risoluzione delle anafore” è un concetto chiave nel campo dell’intelligenza artificiale e del linguaggio naturale. Le anafore sono espressioni linguistiche che fanno riferimento a un elemento o a un concetto precedentemente menzionato nel discorso. Ad esempio, in una frase come “Mario ha preso il suo cappello. Lo indossa sempre”, “lo” è un’anafora che si riferisce a “il suo cappello”.

La sfida della risoluzione delle anafore consiste nel permettere a un sistema di intelligenza artificiale di capire a cosa si riferiscono queste espressioni anaforiche nel contesto del discorso. Questo è fondamentale per la comprensione del linguaggio naturale, poiché consente agli utenti di utilizzare pronomi e altri riferimenti indiretti senza generare confusione nella macchina.

Nel caso di Apple e del suo sistema ReALM, l’obiettivo è quello di convertire il complesso processo di risoluzione dei riferimenti in un puro problema di modellazione del linguaggio. In questo modo, ReALM può comprendere riferimenti a elementi visivi visualizzati su uno schermo e integrare automaticamente questa comprensione. Questo rappresenta un passo avanti significativo nel campo dell’intelligenza artificiale e della comprensione del linguaggio naturale.

Il più recente documento di ricerca di Apple del 29 Marzo suggerisce che diventera’ un gigante tecnologico quando sarà il “vincitore dell’AI” una volta risolto il problema dell’implementazione su dispositivo che può abilitare un “superciclo” dell’iPhone, hanno detto gli analisti di Evercore ISI. ( nient’altro che una transazione di massa dai vecchi modelli di iPhone a quelli più recenti)

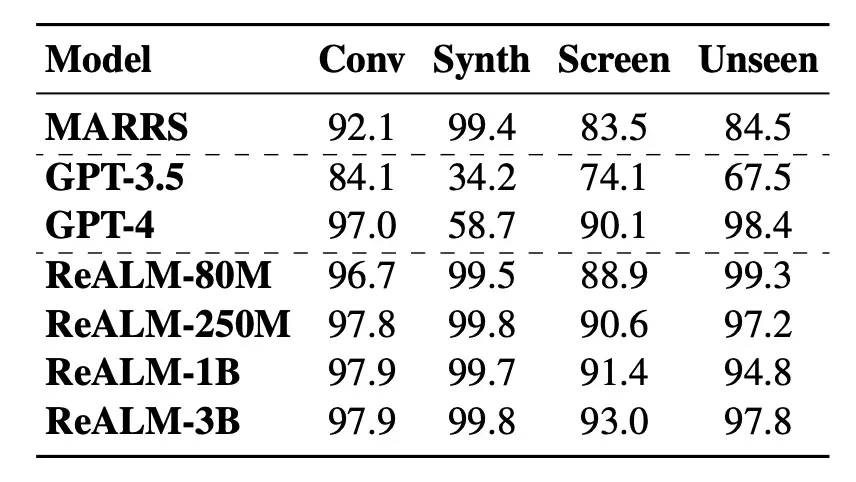

La ricerca, pubblicata lunedì, descrive il nuovo modello linguistico di Apple, noto come Reference Resolution As Language Modeling, o ReALM. I ricercatori hanno indicato che i modelli ReALM più piccoli presentavano prestazioni simili a quelle del GPT-4 di OpenAI, seppur con meno parametri. Ciò potrebbe consentire al nuovo modello di offrire l’AI al limite, o dispositivi come smartphone e PC, fornendo la stessa funzionalità dell’AI nei data center.

“L’innovazione chiave qui sembra essere intorno alla risoluzione dei riferimenti, che si riferisce a come l’AI (Multimodale) può comprendere i riferimenti ai dati visualizzati sullo schermo così come il contesto più conversazionale”, ha affermato l’analista di Evercore ISI Amit Daryanani. “

Apple semplifica il compito normalmente complesso della risoluzione dei riferimenti convertendo tutti i dati visualizzati sullo schermo in testo, che è molto più facile per un [grande modello linguistico] da analizzare rispetto alle immagini. Questa è la caratteristica chiave che consente ad Apple di offrire prestazioni elevate con un numero limitato di parametri.”

Offrendo strumenti di intelligenza artificiale su dispositivi consumer (e forse aumentando l’utilità di Siri), Apple potrebbe offrire agli sviluppatori una latenza inferiore, una migliore sicurezza e rendere più facile e meno costoso fare lavoro correlato all’AI, ha detto Daryanani.

“Pensiamo che la strategia di AI di Apple si concentrerà sull’incorporare l’inferenza su dispositivo per [grandi modelli linguistici] che alzeranno notevolmente l’esperienza utente non solo per l’iPhone ma anche per Mac/iPad”, ha spiegato Daryanani. “

Date la loro integrazione verticale e soprattutto il loro controllo sul proprio silicio, AAPL è meglio posizionata non solo per espandere il fossato che circonda l’ecosistema iOS ma anche potenzialmente guidare un ciclo di aggiornamento accelerato qualora l’implementazione finale venga considerata un cambiamento sufficientemente grande.”

Ha proseguito: “Il ciclo di aggiornamento probabilmente sarà guidato da aggiornamenti significativi all’hardware incluso un motore neurale o GPU potenzialmente migliorato. Inoltre, un aggiornamento sufficientemente significativo delle capacità potrebbe potenzialmente portare a un aumento nei [prezzi medi di vendita].”

Apple è pronta per dare il via alla sua conferenza annuale per sviluppatori il 10 giugno, dove molti si aspettano che la gigante tecnologica faccia una serie di annunci relativi all’AI.

Perchi volesse approfondire :

L’Intelligenza Artificiale (AI) multimodale si riferisce a sistemi di AI che possono processare, capire e/o generare output per più di un tipo di dati. Questo include la combinazione di diverse modalità di input e output, come immagini, testo, suono e video. L’obiettivo è migliorare la comprensione e le capacità di ragionamento dei sistemi di intelligenza artificiale.

Il documento di ricerca “MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training” discute la costruzione di modelli di linguaggio di grandi dimensioni multimodali efficienti (MLLMs). In particolare, studia l’importanza di vari componenti architettonici e scelte di dati. Attraverso ablazioni accurate e complete dell’encoder di immagini, del connettore linguaggio-visione e di varie scelte di dati di pre-addestramento, i ricercatori hanno identificato diverse lezioni di design cruciali.

Per esempio, dimostrano che per un pre-addestramento multimodale su larga scala, l’utilizzo di un mix attento di dati di didascalia di immagini, testo di immagini intercalate e dati solo di testo è fondamentale per ottenere risultati di riferimento pochi colpi allo stato dell’arte (SOTA state of the art), rispetto ad altri risultati di pre-addestramento pubblicati.

I modelli MM1, addestrati su dati visivi e linguistici, hanno dimostrato di eccellere in attività come la descrizione di immagini, la risposta a domande a partire da immagini e l’inferenza in linguaggio naturale. Grazie al pre-addestramento su larga scala, MM1 gode di proprietà interessanti come l’apprendimento migliorato nel contesto e il ragionamento multi-immagine, consentendo il prompting a catena di pensiero con pochi colpi.

Newsletter AI – non perderti le ultime novità sul mondo dell’Intelligenza Artificiale, i consigli sui tool da provare, i prompt e i corsi di formazione. Iscriviti alla newsletter settimanale e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!