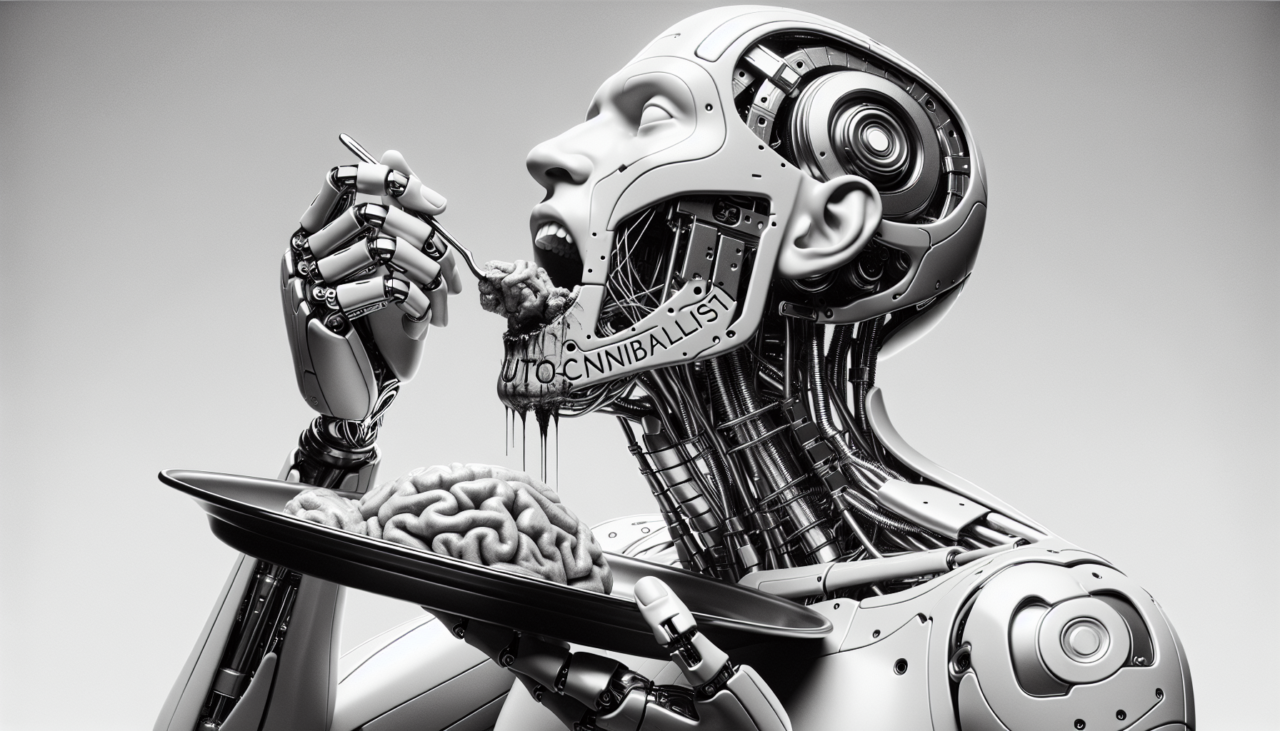

E così, dopo anni passati a divorare il web come un all-you-can-eat di dati gratuiti, l’intelligenza artificiale si trova di fronte a un problema esistenziale: cosa succede quando il buffet finisce? A quanto pare, la scorpacciata di contenuti liberamente accessibili sta per terminare, e ora le AI rischiano di rimanere a digiuno o, peggio ancora, di doversi nutrire dei propri rigurgiti.

Il campanello d’allarme è arrivato con il caso DeepSeek, un modello AI cinese che sembra ripetere le stesse risposte di ChatGPT come uno studente impreparato che copia dal compagno di banco. Secondo un’indagine di Copyleaks, il sospetto è che sia stato addestrato su output di OpenAI, il che significa che l’industria sta iniziando a masticare e risputare i propri contenuti. Un po’ come un ristorante che serve piatti riciclati dal giorno prima.

A mettere il timbro ufficiale su questa crisi è stato Sundar Pichai, CEO di Google, che al Dealbook Summit del New York Times ha sentenziato: “Abbiamo spremuto il web come un limone e il progresso d’ora in poi sarà più difficile.” Traduzione: abbiamo finito i dati gratis, ora o si paga o ci si arrangia.

Ma niente paura! La soluzione c’è, ed è ovviamente artificiale: i dati sintetici. Per chi non lo sapesse, i dati sintetici sono come la carne coltivata in laboratorio: sembrano veri, hanno lo stesso aspetto, ma sotto sotto non hanno mai visto la luce del sole. Generati direttamente da AI per alimentare altre AI, questi dati sono il nuovo oro del settore.

“Se hai pochi dati e non vuoi pagarli, te li inventi basandoti su quelli che hai già.” Un po’ come fare una fotocopia di una fotocopia finché il testo diventa illeggibile, ma con il vantaggio che nessuno ti denuncia per copyright.

Naturalmente, il metodo ha qualche effetto collaterale. Ad esempio, i dati sintetici possono contenere gli stessi pregiudizi dei dati reali, solo moltiplicati per dieci. Ma chi se ne importa? Il punto è evitare rogne legali e continuare a far girare il motore dell’innovazione.

Il vero problema, però, è che se l’AI continua a mangiare i propri scarti, a un certo punto potrebbe iniziare a perdere il contatto con la realtà. Immaginate un mondo in cui tutti gli articoli vengono scritti da AI che leggono altri articoli generati da AI. Dopo qualche ciclo di questo gioco al massacro, l’informazione diventa una gigantesca bolla autoreferenziale, dove nessuno sa più distinguere cosa è vero da cosa è stato generato per convenienza.

E se qualcuno volesse approfittare della situazione? Facile. i dati sintetici possono essere usati per insegnare alle AI a ignorare certi schemi di frode. In pratica, potremmo arrivare a un futuro in cui i truffatori addestrano i modelli AI per non riconoscerli. Geniale, vero? Vera aiutaci tu!!

La soluzione proposta da alcuni esperti è la solita: blockchain. Sistemi decentralizzati. Perché se c’è un problema, la blockchain è sempre la risposta, giusto? Invece di preoccuparci di rendere i dati “immutabili”, dovremmo pensare a renderli “durevoli e verificabili.” In altre parole, dovremmo trovare un modo per garantire che le AI non diventino completamente rincitrullite.

L’intelligenza artificiale ha vissuto la sua infanzia mangiando tutto il web senza preoccuparsi delle conseguenze. Ora è entrata nell’adolescenza e si trova di fronte a un duro risveglio: il cibo sta finendo, e non si può più crescere solo con gli avanzi.

O le aziende tech trovano una nuova fonte di dati freschi (leggi: pagano per contenuti di qualità), o ci ritroveremo con un’AI che gira in tondo, riciclando se stessa fino a diventare un gigantesco generatore automatico di banalità.

Le leggi di scalabilità nell’intelligenza artificiale (IA) sono state a lungo considerate una verità indiscussa: modelli più grandi, alimentati da quantità massicce di dati e potenza computazionale, dovrebbero inevitabilmente portare a prestazioni superiori. Tuttavia, recenti sviluppi nel campo suggeriscono che questa visione potrebbe essere troppo semplicistica, invitandoci a riconsiderare le reali implicazioni dell’aumento delle dimensioni dei modelli.

Grok 3, sviluppato da xAI, rappresenta un esempio emblematico di questa tendenza. Addestrato sul supercomputer Colossus, che presumibilmente integra 200.000 GPU Nvidia, Grok 3 ha beneficiato di una potenza computazionale dieci volte superiore rispetto ai modelli precedenti. Le sue prestazioni in vari compiti, tra cui ragionamento, matematica e codifica, sono state notevoli, portando a risultati di rilievo come il primo posto nella LMSys Chatbot Arena. Tuttavia, è lecito chiedersi se questi guadagni giustifichino l’enorme investimento in risorse, soprattutto considerando i costi operativi associati.

D’altro canto, GPT-4.5 di OpenAI, pur essendo il modello più grande mai sviluppato dall’azienda, ha mostrato miglioramenti modesti rispetto ai predecessori. Nonostante l’enorme investimento in termini di risorse computazionali e finanziarie, i guadagni in compiti complessi come matematica e codifica sono stati minimi. Questo solleva interrogativi sull’efficacia di continuare a scalare i modelli senza una strategia più mirata e innovativa.

L’approccio di test-time scaling adottato da Grok 3, che combina pre-addestramento massiccio con cicli di elaborazione aggiuntivi durante l’inferenza, ha portato a miglioramenti significativi nelle prestazioni di ragionamento. Tuttavia, sorge spontanea la domanda se tale approccio sia sostenibile e scalabile nel lungo termine, soprattutto considerando le risorse necessarie.

Le sfide emergenti suggeriscono che le leggi di scalabilità potrebbero essere in fase di evoluzione piuttosto che in rottura. I progressi futuri potrebbero dipendere dall’integrazione di pre-addestramento con tecniche di inferenza avanzate, come il ragionamento a catena di pensiero o l’apprendimento per rinforzo. Tuttavia, è incerto se questa combinazione possa realmente superare le limitazioni attuali senza introdurre complessità aggiuntive che ne compromettano l’efficienza.

Le dichiarazioni di esperti come Mark Chen di OpenAI enfatizzano la necessità di una solida base di conoscenza per il ragionamento. Tuttavia, è lecito dubitare se l’attuale paradigma di pre-addestramento massiccio sia sufficiente a fornire tale base, o se siano necessarie nuove metodologie che vadano oltre l’aumento delle dimensioni dei modelli.

Abbiamo raggiunto il SOFFITTO?

Mentre l’aumento delle dimensioni dei modelli ha portato a progressi significativi in vari compiti, le sfide attuali suggeriscono che le leggi di scalabilità non sono più così lineari come un tempo. È fondamentale esplorare approcci alternativi e innovativi che possano complementare o addirittura sostituire l’attuale paradigma basato esclusivamente sull’aumento delle dimensioni dei modelli.

Tuttavia, rimane il dubbio se tali approcci possano realmente offrire soluzioni efficaci senza introdurre nuove complicazioni.