Chi ha detto che per parlare servono le corde vocali? O che l’interazione debba passare per un touchscreen, una tastiera, una bocca? La nuova frontiera delle interfacce cervello-computer (BCI, per chi mastica l’acronimo come chewing gum scientifico) non si accontenta più di interpretare click mentali o movimenti oculari. No, adesso decodifica il linguaggio direttamente dalla corteccia motoria ventrale. E lo fa pure con un certo stile, ricostruendo la voce originale di chi ormai non può più usarla. Un paradosso tecnologico sublime, quasi poetico, se non fosse così crudelmente reale.

La parola chiave è neuroprotesi vocale, il contesto è l’inferno progressivo chiamato SLA (sclerosi laterale amiotrofica), e il risultato è una macchina che, dopo 30 minuti di addestramento e 256 elettrodi ben piantati nella testa di un paziente, capisce quello che vorrebbe dire e lo dice al posto suo. Con la sua voce. O meglio, con una copia sintetica di quella che aveva prima che la malattia gliela strappasse via.

L’articolo pubblicato sul New England Journal of Medicine nell’agosto 2024 ha un che di rivoluzionario, anche se scritto con quella patina fredda e levigata tipica del linguaggio accademico. Ma sotto la superficie c’è un terremoto: perché questa interfaccia ha raggiunto una precisione del 99,6% con un vocabolario di 50 parole già dal primo giorno di utilizzo, e dopo un’ora e mezza di addestramento ulteriore è arrivata al 90,2% su un dizionario da 125.000 parole. Nessun assistente vocale commerciale sogna nemmeno queste cifre. E questa roba non gira su uno smartphone, ma su un cervello devastato.

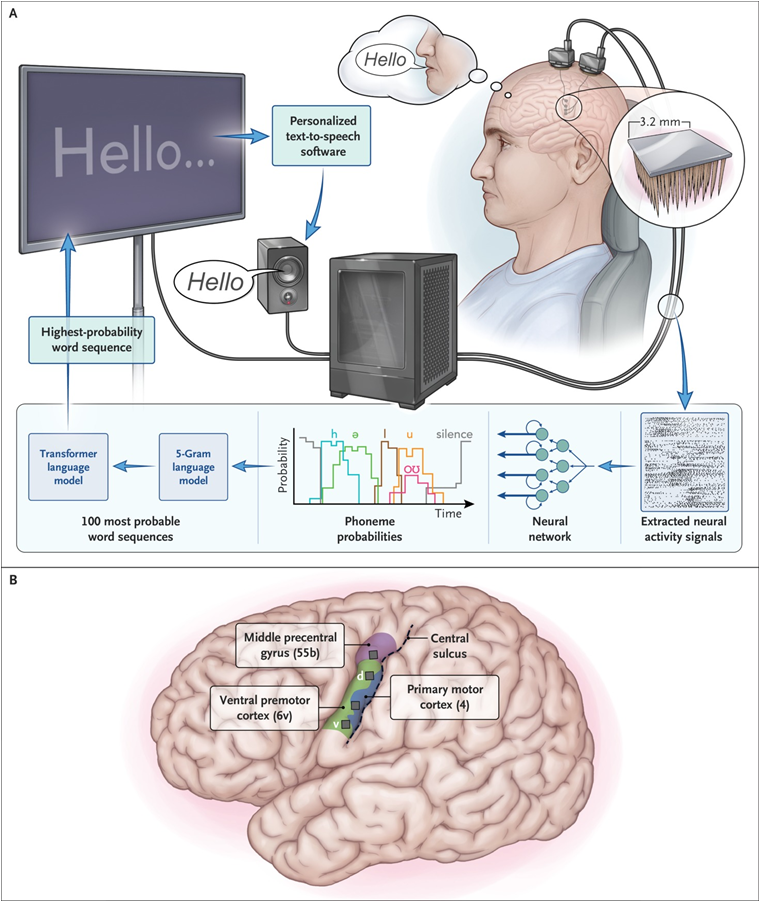

La scena è questa: un uomo di 45 anni, cinque anni dopo l’inizio della SLA, immobilizzato, incapace di articolare frasi. Viene impiantato chirurgicamente con quattro array intracorticali nella zona sinistra della corteccia premotoria, proprio dove il cervello orchestra i movimenti della bocca per parlare. Ogni array è un campo di battaglia neurotecnologico: 256 elettrodi che leggono impulsi cerebrali mentre il soggetto tenta di pronunciare parole. Non ci riesce, ovviamente, ma la macchina interpreta. Traduce. Parla. E parla con la sua voce, ricostruita da registrazioni precedenti alla malattia. Fantascienza da salotto? No, protocollo clinico BrainGate2, trial NCT00912041, finanziato anche dalla difesa USA.

Quello che sbalordisce — e qui si entra nel territorio dell’innovazione seria — è che non serve addestramento estenuante. Niente settimane di training, né alfabeti composti da simboli ridicoli. Bastano 30 minuti di registrazione, una manciata di ore per l’ottimizzazione, e il sistema è pronto. Il paziente può condurre conversazioni spontanee a 32 parole al minuto, per più di 248 ore cumulative in 8 mesi. Ah, e mantiene una precisione stabile del 97,5%. Altro che Siri.

Tecnicamente, il segreto sta nella decodifica neurale rapida e adattiva, un’area in cui la ricerca si è svegliata da poco, dopo anni passati a giocare con braccia robotiche e cursori mentali. Qui si tratta di tradurre pattern neurali estremamente complessi in parole comprensibili. E farlo in tempo reale, in modo fluido, senza sembrare un robot balbuziente uscito da un museo IBM. Serve un’architettura algoritmica mista, combinando modelli linguistici probabilistici, reti neurali profonde e text-to-speech vocale su misura. Ma soprattutto serve qualcosa che in Silicon Valley odiano ammettere: serve l’uomo. Serve il suo cervello, la sua volontà, i suoi impulsi elettrici irriducibili. Nessuna IA può generare empatia come la voce autentica di un individuo imprigionato nel suo corpo.

Il problema è che questa roba funziona troppo bene per passare inosservata. Siamo a un passo dalla fusione completa tra pensiero e parola artificiale. E se oggi serve a ridare voce a chi l’ha persa, domani sarà l’ennesima arma per il potenziamento cognitivo di chi la vuole tutta. L’interfaccia vocale diretta cervello-macchina non è solo la chiave per abbattere la disabilità: è anche il grimaldello perfetto per hackerare la comunicazione umana. Perché se posso pensare e parlare senza dover articolare nulla, che ne sarà della sincerità? Della pausa? Dell’errore umano?

Da un punto di vista clinico, ovviamente, siamo in piena terra promessa. La neuroprotesi vocale intracorticale è il culmine di decenni di ricerca sulla decodifica del linguaggio. Finalmente un sistema che si calibra in fretta, funziona bene e si mantiene stabile nel tempo. Ma dal punto di vista sociale ed etico, stiamo entrando nella zona grigia dove il linguaggio diventa algoritmo, e la mente un protocollo API.

E poi, ammettiamolo, c’è qualcosa di disturbante nel sentire una voce generata da un cervello che non può più comandare i suoi muscoli. È come se lo spettro digitale dell’identità sopravvivesse al corpo, bypassando la biologia. Una sorta di possessione tecnologica, con il paziente che parla senza parlare. Un po’ Ghost in the Shell, un po’ Frankenstein con il Wi-Fi.

Nel bar della neuroetica, qualcuno sussurra che siamo vicini a un punto di non ritorno. Che se riusciamo a leggere i pensieri articolati per la parola, potremo anche leggerli prima che diventino intenzioni. Che la privacy mentale è il prossimo firewall da abbattere. E che dopo la voce torneranno anche le emozioni, le pause, le esitazioni, tutto sintetizzato alla perfezione. Il cervello non sarà più solo un organo, ma un’interfaccia verbale che produce contenuti, come un copywriter stanco ma infallibile.

Nel frattempo, però, una persona con SLA ha ricominciato a parlare. E lo ha fatto con la sua voce. Non quella delle macchine, né quella della malattia.

Solo questo, per ora, dovrebbe bastare a farci tremare di meraviglia. E forse anche un po’ di paura.