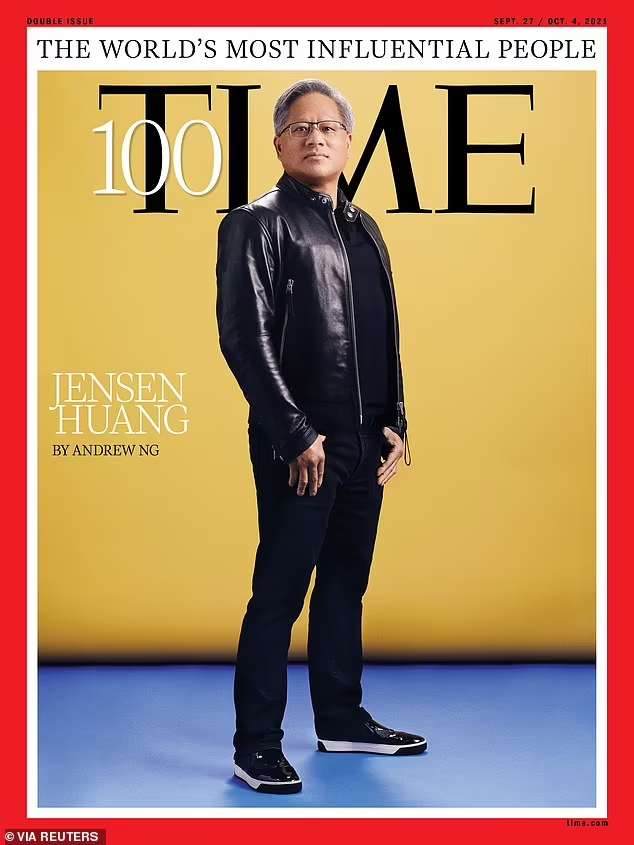

Jensen Huang, col suo look da rockstar della Silicon Valley e lo sguardo da profeta che vede l’infrastruttura del futuro, ha fatto una dichiarazione che, seppur elegantemente rivestita di “collaborazione”, puzza di resa strategica quanto basta: Nvidia apre le porte a chi prima stava fuori. NVLink Fusion, questa nuova trovata tecnologica annunciata con enfasi, è un cambio di paradigma. Ed è un cambio dettato dalla paura.

Sì, proprio dalla paura che quei “partner” come Amazon, Google e Microsoft che fino a ieri compravano GPU Nvidia come se fossero oro colato si stiano emancipando. Che stiano progettando, costruendo, ottimizzando propri chip AI. E non per hobby, ma per ridurre la dipendenza da un monopolista che per anni ha fatto il bello e il cattivo tempo.

NVLink Fusion permette di combinare i chip Nvidia con quelli di altri vendor. Prima? Non se ne parlava nemmeno. I sistemi DGX erano una chiesa a parte, con un solo Dio: CUDA. Tutto Nvidia, tutto chiuso, tutto integrato. Ma ora qualcosa è cambiato. O meglio: qualcuno. Alphabet ha i suoi TPU, Amazon ha Graviton e Trainium, Microsoft lavora da tempo a chip proprietari con ARM in salsa AI. E Nvidia non può più permettersi di chiudere i rubinetti e far finta che nulla stia succedendo.

Ironia della sorte, Jensen Huang che predicava l’era dei “software-defined data center” ora si trova costretto a fare il mediatore culturale tra il suo hardware e quello dei competitor. NVLink Fusion non è solo una feature, è una resa mascherata da innovazione. È la carta bianca offerta ai giganti del cloud per dire: “Restate con noi. Potete usare anche il vostro hardware. Ma almeno parte del motore deve essere Nvidia”.

La mossa è astuta. Perché tecnicamente NVLink Fusion permette una coesistenza efficiente, teoricamente “a basso attrito”, tra GPU Nvidia e chip alternativi. Ma sotto c’è un gioco ben più complesso. È una scommessa sulla sopravvivenza dell’ecosistema CUDA come standard di fatto, anche quando l’hardware non sarà più 100% Nvidia. In altre parole, è il tentativo di rendersi ineliminabili anche nei sistemi eterogenei del futuro. Una strategia in stile “embrace, extend, entangle”.

Nel frattempo, lo show continua: Huang ha annunciato che i nuovi chip GB300 arriveranno nel Q3. Un refresh degli attuali GB200, che già oggi dominano i data center AI delle big tech. Nessun dettaglio preciso, solo teaser: più performance, più banda, più efficienza. Tutto ovviamente progettato per accelerare LLM, inferenze sparse, training mastodontici. Ma la vera notizia non è il GB300. È il contesto.

Perché se nel 2023 la corsa all’AI sembrava una maratona con Nvidia al comando e tutti gli altri a rincorrere, oggi lo scenario è quello di un GP di Formula 1 con almeno quattro team che si stanno costruendo motori in casa. E Huang lo sa benissimo.

NVLink Fusion diventa così il collante artificiale tra un ecosistema in frantumi. Un modo per restare dentro i data center, anche quando i clienti decidono di farsi le cose da soli. È la versione moderna del “se non puoi batterli, almeno mettici un cavo ad alta velocità”.

E mentre tutti si concentrano sui benchmark e sulle slide con teraflops che crescono come i funghi, il vero messaggio è un altro: la centralità di Nvidia non è più un dogma. È una posizione negoziabile. È una piattaforma fra le tante, e ora ha bisogno di giocare di sponda con chi prima trattava come cliente captivo.

In mezzo a tutto questo, resta l’incognita su quanto le nuove architetture – GB300 compresi – sapranno mantenere la leadership rispetto ai chip personalizzati. Perché se i modelli linguistici continuano a crescere in modo esponenziale, i vincoli di efficienza e scalabilità diventeranno sempre più stringenti. E Nvidia, nonostante il vantaggio iniziale, non ha più il monopolio dell’innovazione. Solo quello delle abitudini.

Curiosità da bar, giusto per stemperare l’atmosfera: pare che in una cena a porte chiuse tra alcuni top executive del cloud, qualcuno abbia detto che “NVLink Fusion suona come la versione nerd del poliamore tecnologico”. Difficile dargli torto. Perché in fondo, dietro i protocolli di interconnessione e le interfacce PCIe, c’è un solo grande tema: libertà di scelta. E il fatto che Nvidia oggi debba concederla, è il segnale più forte che qualcosa si sta rompendo davvero.

Il futuro dell’AI non sarà solo un affare da GPU. Sarà un cocktail di architetture, di ecosistemi sovrapposti, di diplomazie forzate tra chi vuole scalare i modelli e chi vuole possedere l’intera supply chain. E in questo nuovo scenario, Nvidia non può più permettersi di essere un impero chiuso. Deve diventare, volente o nolente, una repubblica federale.