Il mondo dell’imaging RM sta entrando in una nuova era. Non si tratta di cambiare macchina, ma di cambiare cervello. Con l’arrivo di AI, stiamo passando da un’acquisizione “meccanica” delle immagini a una “intelligente”. Ma niente tecnicismi inutili. Questo articolo frutto dell’evento ECM gratuito organizzato a Viterbo Commissione Albo per TSRM con Rivista.AI patrocinato dal Dott. M.Gentile spiega in modo pratico e chiaro a chi lavora davvero sulla macchina i tecnici radiologi cosa cambia davvero con l’uso dell’intelligenza artificiale nei parametri principali della risonanza magnetica.

La matrice è come la griglia dei pixel di una foto. Più è alta, più l’immagine è dettagliata, ma più tempo ci vuole per acquisirla e più rumore si introduce. Con AI puoi permetterti di acquisire con matrici anche più basse, perché l’AI lavora sul segnale grezzo (non sull’immagine già fatta) e riesce a completare l’immagine in modo intelligente. Alla console vedi una qualità finale come se avessi usato una matrice maggiore, ma in metà tempo. Ma questo non ti impedisce di fare l’opposto anche… quindi di acquisire con una matrice alta a risoluzione elevatissima. Bisogna solo scegliere cosa preferiamo.

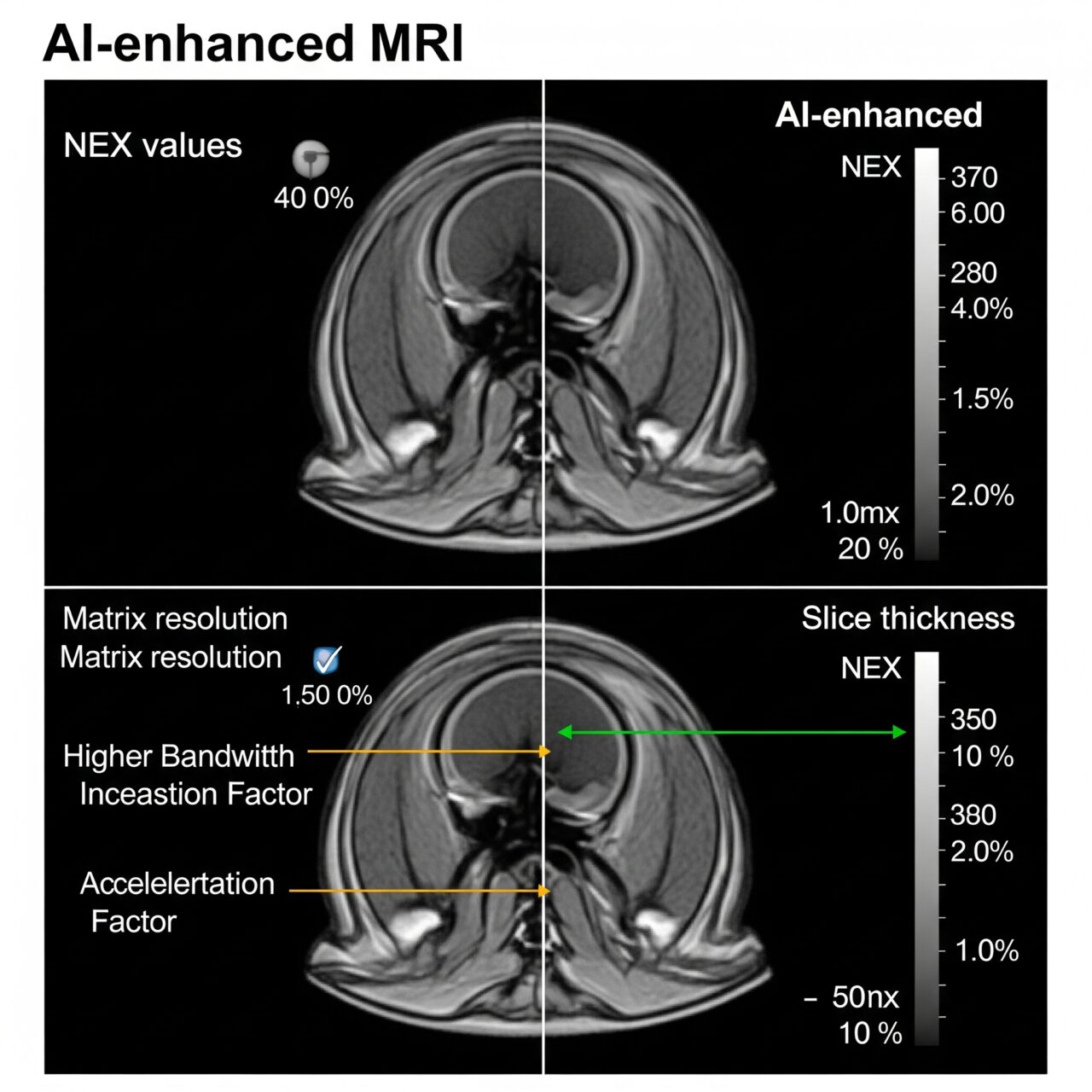

La bandwidth (larghezza di banda) regola quante frequenze usi per costruire l’immagine. In genere, maggiore bandwidth = meno artefatti da distorsione, ma più rumore. AI riesce a eliminare questo rumore in modo selettivo, mantenendo i dettagli importanti. Quindi puoi lavorare con bandwidth più alta senza sacrificare la qualità. Risultato: immagini più stabili anche in zone difficili (come collo e addome).

Il fattore di accelerazione è il trucco dell’imaging parallelo: usi più elementi per “saltare” righe del segnale e ridurre il tempo. Ma spesso le immagini diventano più “brutte” e piene di artefatti. L’AI sfrutta proprio la ridondanza tra gli elementi per ricostruire l’immagine come se non avessi saltato nulla. Questo significa che puoi accelerare molto di più e avere comunque immagini pulite. Puoi scansionare più pazienti, con meno richieste di ripetizione.

Il NEX (Number of Excitations) è il numero di volte in cui ripeti la stessa sequenza per “pulire” l’immagine dal rumore. Ma ogni ripetizione aumenta il tempo. Con AI, puoi usare anche un NEX basso (1 o meno se disponibile), perché l’AI elimina il rumore direttamente nella fase di ricostruzione. Così risparmi tempo e ottieni comunque un’immagine nitida e leggibile.

Lo spessore di slice incide sulla risoluzione delle immagini lungo l’asse verticale (z). Fette sottili = più dettaglio, ma meno segnale. Fette spesse = più segnale, ma meno precisione. AI permette di acquisire con slice leggermente più spesse (più segnale, meno tempo) e poi aumentare il dettaglio usando l’AI. In pratica, riesce a ricostruire “tra una fetta e l’altra” per creare immagini più omogenee e precise. Oppure possiamo acquisire con spessore ulteriormente ridotto e far diminuire il rumore all’AI!

Quello che serve sapere per davvero è che AI non è un filtro e non lavora sull’immagine già fatta. Lavora dentro il cuore del sistema, sulla materia grezza del segnale RM. Riconosce artefatti, rumore e distorsioni tipiche (come il famoso effetto “Gibbs ringing”) e le rielabora prima che diventino parte dell’immagine.

Per te, tecnico radiologo, questo si traduce in:

- meno ripetizioni

- meno tempo di acquisizione

- immagini più pulite e leggibili al primo colpo

- più pazienti gestiti in una giornata

- meno stress nei casi difficili (bambini, ansiosi, pazienti che si muovono)

Ora facciamo degli esempi:

1) Bandwidth: più larga, più rumore… ma più informazione per l’AI

Quando aumenti la bandwidth (larghezza di banda), ottieni un’acquisizione più veloce e con meno distorsioni geometriche (utile in aree come testa, orbite, collo). Il problema è che aumenti anche il rumore, perché la quantità di segnale per unità di tempo si riduce. Quindi, visivamente, l’immagine peggiora.

Ma l’AI, sfrutta proprio la maggior quantità di dati grezzi che arriva grazie alla banda larga per “ripulire” l’immagine. Non è un semplice filtro: va a prendere l’informazione di fondo e distingue tra ciò che è rumore e ciò che è reale. Così puoi avere immagini nitide, senza dover ridurre la bandwidth o aumentare il tempo.

2) Matrice: più pixel, più dettaglio… e più casino

Quando aumenti la matrice di acquisizione, cioè il numero di pixel che compongono l’immagine, ottieni una risoluzione spaziale migliore. Più dettaglio, più anatomia visibile.

Ma il prezzo da pagare è triplo: tempo di acquisizione più lungo, rumore aumentato, e rapporto segnale/rumore (SNR) che crolla.

E qui l’AI ti toglie le castagne dal fuoco: ti permette di acquisire con una matrice più bassa, quindi più veloce e con più segnale utile, e poi ricostruisce un’immagine “ad alta risoluzione” grazie a modelli addestrati su migliaia di esempi simili. Risultato: l’occhio del radiologo vede più dettaglio, ma tu hai acquisito meno.

3) Parallel imaging: accelerazione estrema, ma rumore molesto

Quando spingi l’imaging parallelo, puoi ridurre drasticamente il tempo di acquisizione. Fantastico per pazienti agitati o poco collaborativi.

Ma a ogni “spinta” in più, il rumore aumenta a dismisura e il rischio di artefatti sale. Questo perché stai “saltando” delle righe di k-space, e poi cercando di riempirle in modo matematico.

L’AI entra qui come salvatore: capisce dove stai perdendo informazione e riesce a completare le parti mancanti in modo coerente, sfruttando il contesto. Il modello ha visto milioni di pattern e può fare inferenze logiche e visive più sofisticate rispetto ai classici algoritmi di ricostruzione. In breve: puoi osare di più, perché hai una rete neurale che ti copre le spalle.

4) FOV: più piccolo, più dettaglio… ma anche più rumore

Ridurre il Field of View (FOV) significa “zoommare” su una zona, ottenendo migliore risoluzione spaziale. Lo fai ad esempio per esami focalizzati su articolazioni, piccoli organi, lesioni puntiformi.

Ma come in ogni zoom, più stringi il campo, meno segnale raccogli: quindi il rumore aumenta e il SNR si abbassa.

L’AI, anche qui, è l’asso nella manica: può eliminare il rumore e migliorare il contrasto mantenendo i dettagli, anche quando il FOV è ridotto. Ti permette di fare “close-up” diagnostici senza sacrificare la leggibilità.

Il mix perfetto in risonanza magnetica non esiste: si costruisce come un cocktail clinico, paziente per paziente

Domanda lecita, pragmatica, di quelle che fanno la differenza in sala RM: “Qual è il giusto mix di parametri per ottenere la miglior immagine possibile, nel minor tempo, col massimo dettaglio?”

La risposta secca sarebbe: dipende. Ma non ti lascio con un “dipende” da manuale. Qui parliamo di compromessi guidati dall’intelligenza (umana e artificiale), e di come scegliere bene ogni singolo parametro in funzione del contesto clinico, del paziente e delle risorse disponibili.

Da cosa dipende davvero il mix ottimale?

Il mix ideale di parametri RM dipende da una combinazione di fattori tecnici, clinici e umani. Te li traduco nella realtà operativa di tutti i giorni.

1. Tipo di distretto anatomico. La testa non è l’addome. Il rachide non è il ginocchio. Ogni zona ha le sue sensibilità e criticità. Per esempio:

- Cervello: serve alta risoluzione spaziale, poco rumore, tolleranza a movimenti minima → puoi spingere su matrice e ridurre il NEX grazie all’AI

- Addome: tempi brevi, rischio elevato di artefatti da movimento, distorsioni → bandwidth più alta e AI che rimuove il rumore

- Prostata o articolazioni: FOV ridotto, dettagli fini → FOV piccolo, slice sottili, AI per tenere alto l’SNR

2. Condizione del paziente. Un paziente che collabora bene ti permette sequenze più lunghe e parametri più “spinti”. Un paziente agitato, claustrofobico o in fase acuta ti costringe ad abbreviare.

Qui l’AI fa il miracolo: puoi ridurre il NEX, aumentare l’accelerazione e lei ricostruisce l’immagine come se avessi avuto tempo e pazienza.

3. Finalità clinica Stai cercando un piccolo nodulo? O devi semplicemente escludere patologia grossolana? Il livello di dettaglio richiesto ti cambia completamente l’assetto:

- Alta risoluzione richiesta → aumenti matrice, slice sottili, FOV più stretto, ma compensi con AI per evitare rumore

- Esame di controllo o follow-up rapido → acquisizione veloce, basso NEX, meno dettagli ma con AI per rendere comunque leggibile

4. Tempo disponibile e produttività del centro. Un centro ad alto volume (pazienti ogni 15-20 minuti) non può permettersi acquisizioni lunghe. Il mix ottimale qui diventa:

- Tempo minimo di acquisizione

- Elevata accelerazione

- AI attiva su tutte le sequenze per recuperare dettaglio e SNR

5. Tipo di macchina e software disponibile. Non tutte le macchine sono uguali. Se hai una macchina recente con AI attiva, puoi spingerti oltre. Se lavori con sistemi meno recenti, devi fare compromessi più classici (alza il NEX, abbassa la matrice, etc.).

La presenza dell’AI cambia radicalmente le tue scelte, perché ti permette di:

- usare bandwidth più alte (meno distorsione, tempo minore)

- acquisire con NEX 1 o meno

- spingere il parallel imaging oltre i limiti canonici

E quindi, come si imposta un “mix intelligente”?

Non esiste una ricetta universale, ma un buon tecnico RM oggi lavora così:

- imposta i parametri base in funzione dell’area anatomica e della domanda clinica

- valuta il rischio di movimento e decide quanto comprimere i tempi

- spinge su accelerazione e bandwidth dove può, confidando nell’AI per pulire l’immagine

- usa una matrice e FOV ottimali, ma non esasperati, per lasciare all’AI la rifinitura

- riduce il NEX il più possibile, soprattutto in pazienti difficili

Il vero trucco è capire dove puoi “barare” e dove devi restare conservativo. L’intelligenza artificiale non è un lasciapassare per immagini a casaccio: è uno strumento per massimizzare il potenziale dell’acquisizione, ma serve sempre la competenza umana per pilotare la macchina.

Se vuoi un’immagine mentale: il tecnico è il pilota. L’AI è il copilota che corregge la rotta e migliora l’efficienza. Ma se sbagli destinazione, ti ci porta comunque. Quindi il mix giusto sei tu a deciderlo. Solo che ora hai qualcuno che ti copre le spalle.

E il paziente, di solito, non si accorge di nulla. Ma il radiologo sì. E te lo farà notare.

La grande bugia? No. Ma l’AI può raccontarti una versione molto educata della verità

Domanda tagliente, onesta, e tremendamente attuale: “L’AI in risonanza magnetica potrebbe ricostruire cose che non ci sono?”

La risposta breve è sì, ma non come pensi. Non si tratta di inventare organi o tumori dal nulla come in una sceneggiatura di Black Mirror. Si tratta di interpretare, interpolare, e in certi casi stimare.

E quando l’intelligenza artificiale interpreta qualcosa che nel segnale grezzo non è ben definito, può effettivamente ricostruire un’immagine che sembra più precisa di quanto lo sia realmente.

Quindi, mettiamola così: l’AI può “migliorare” l’immagine al punto da dare l’illusione di un dettaglio reale, anche se quel dettaglio nel segnale originale è debole, borderline o addirittura assente. Non mente. Ma può “abbellire”. E questo abbellimento, in medicina, può diventare un problema.

Perché succede?

Il cuore del gioco è l’apprendimento basato su dati precedenti. AI è addestrata su migliaia di immagini reali. Questo gli dà una conoscenza statistica enorme di come “dovrebbe” apparire un fegato, un midollo, una cartilagine.

Quando il segnale è rumoroso, incompleto o sotto-campionato (cioè, mancano dati), l’AI ricostruisce basandosi su ciò che ha già visto.

Risultato? L’immagine sembra perfetta. Ma può essere una ricostruzione “verosimile”, non necessariamente vera al 100%.

Dove questo può diventare rischioso?

- Microlesioni: un piccolo nodulo epatico, una lesione corticale, un’erosione articolare iniziale. L’AI potrebbe:

- attenuarlo, se lo considera rumore

- amplificarlo, se lo interpreta come struttura coerente

- Pattern atipici: in caso di anatomie anomale, malformazioni, o tumori rari, l’AI potrebbe “normalizzare” l’immagine, appiattendo la variabilità invece che mostrarla

- Ricostruzione longitudinale: in esami di follow-up, se un dettaglio borderline è stato “interpretato” nella prima scansione, il confronto può essere falsato

Ma allora è pericolosa?

No. Ma è potente. E come tutte le tecnologie potenti, deve essere usata con testa.

Ecco la differenza sostanziale:

- La risonanza “classica” ti mostra ciò che il segnale grezzo ha acquisito, nel bene e nel male

- La risonanza “AI-based” ti mostra ciò che l’AI crede sia più probabile rispetto al segnale ricevuto

La qualità è spesso spettacolare, ma il prezzo è la fiducia nella rete neurale. È per questo che molti radiologi esperti oggi chiedono di vedere anche la versione “grezza” o non ricostruita in AI, per poter valutare se l’AI ha abbellito o effettivamente messo a fuoco.

In conclusione: sì, può farlo. Ma non per malizia. Perché glielo chiediamo noi.

La AI non si inventa cose. Ma può interpretare troppo. E in un mondo dove “vedere” è diagnosticare, questa sottile differenza tra realtà e probabilità va compresa, monitorata, e affiancata da giudizio clinico umano.

Il radiologo resta la mente. Il tecnico l’occhio. L’AI è solo una lente d’ingrandimento molto sofisticata. Ma se la lente ti mostra un dettaglio che non c’è… e tu lo prendi per vero… beh, allora la colpa non è della lente.

Come l’AI ha imparato a vedere meglio di noi: la storia di una macchina che ha iniziato a capire le immagini

Facciamola semplice, concreta, e senza mitologia da fantascienza. L’AI in risonanza magnetica non è magia, e nemmeno genialità artificiale. È statistica potente, mascherata da “intelligenza”. Ma dietro ogni immagine “perfetta” generata da AI, ci sono anni di evoluzione silenziosa, e miliardi di pixel studiati, confrontati, interpretati.

Ma quindi… come fa a migliorare un’immagine?

In parole povere: impara guardando milioni di esempi.

Una rete neurale convoluzionale (CNN) è come un bambino a cui fai vedere mille volte una mela. Dopo un po’, anche se la mela è un po’ marcia, sporca, sfocata, lui riesce comunque a dire: “È una mela”.

AI funziona esattamente così. È stata addestrata con decine di migliaia di immagini RM “perfette” (con buon segnale, senza rumore, con dettagli chiari). Poi le hanno “sporcate” apposta: hanno aggiunto rumore, distorsioni, tagliato porzioni di k-space, simulato accelerazioni estreme.

La rete ha imparato a confrontare l’immagine brutta con quella ideale e a capire come ripulirla, riempirla, ricostruirla.

Col tempo, ha imparato a farlo anche con immagini nuove, mai viste. Perché ha interiorizzato le regole statistiche dell’anatomia umana.

Come si è evoluta nel tempo?

- 2000-2010: le basi

Le prime tecniche erano filtri semplici, tipo “median filter” o “Gaussian blur”, buoni per togliere il rumore ma pessimi per mantenere i dettagli.

Nessuna intelligenza, solo matematica rigida. - 2010-2015: la rivoluzione dei Big Data

Grazie a internet, cloud e potenza di calcolo, sono arrivati i primi dataset enormi. Le reti neurali hanno cominciato a imparare, non solo eseguire istruzioni.

Ma in medicina erano ancora considerate “giocattoli da ricerca”. - 2015-2018: arriva il deep learning serio

Google, NVIDIA, Facebook cominciano a usare reti profonde (decine di strati) per riconoscere volti, parole, oggetti.

GE, Siemens e Philips si svegliano: “E se applicassimo questa roba alla risonanza magnetica?” - 2018-2020: addestramento intensivo

Nasce AIR™ Recon DL: una rete addestrata su immagini MR reali, usando piattaforme come Edison AI.

A differenza dei vecchi algoritmi, non lavora sull’immagine già finita (DICOM), ma sul segnale grezzo, dentro il cuore della macchina.

Questo gli permette di lavorare prima che le informazioni vengano perse nel processo di ricostruzione. - 2020-oggi: AI embedded

Oggi l’AI non è più un “optional”. È integrata nei software di acquisizione, lavora in tempo reale, ha parametri personalizzabili (puoi decidere quanto SNR vuoi), e impara anche dai tuoi esami.

In futuro sarà in grado di adattare i parametri in tempo reale, scegliendo da sola la matrice, il FOV, l’accelerazione, come un tecnico virtuale.

In sintesi: l’AI è diventata esperta guardando. Ma resta cieca se non c’è un umano che la guida.

La vera rivoluzione è che non hai più bisogno di acquisire tutto. Hai bisogno di acquisire abbastanza perché l’AI possa completare il resto in modo affidabile.

È passata da “software di supporto” a partner diagnostico invisibile.

E no, non è ancora perfetta. Ma si avvicina. E lo fa ogni volta che qualcuno le dà in pasto una nuova immagine.

Quindi se ti chiedi “come fa a sapere cosa c’è, anche quando il segnale è debole?”, la risposta è semplice:

Perché l’ha già visto migliaia di volte. Anche meglio di noi.

Questi esempi servono a dire una cosa molto semplice: prima dovevi scegliere tra qualità, velocità e segnale. Ora puoi avere tutto insieme.

L’AI non ti cambia il modo di acquisire. Ti cambia la libertà con cui puoi spingere ogni parametro al massimo, senza subire le conseguenze classiche.

E come ha detto Pascal Roux, radiologo a Parigi: “Non devo più scegliere tra qualità e velocità”.

Con AI, puoi avere entrambe. Non è una rivoluzione silenziosa. È già in atto. Sta a te decidere se guidarla.