L’AI ha perso la testa. O meglio, l’ha trasferita nei nervi periferici. Perché la vera notizia non è che DeepMind abbia reso Gemini Robotics “più piccolo e più efficiente”, ma che abbia deciso di farlo vivere direttamente a bordo delle macchine, scollegandolo dalla placenta del cloud. Il nuovo modello vision-language-action di Google, annunciato come una versione on-device del già impressionante Gemini Robotics, rompe il cordone ombelicale della connettività perpetua e si installa nel corpo dei robot come un cervello portatile. Senza Wi-Fi, senza lag, senza autorizzazioni. Solo carne meccanica e sinapsi di silicio.

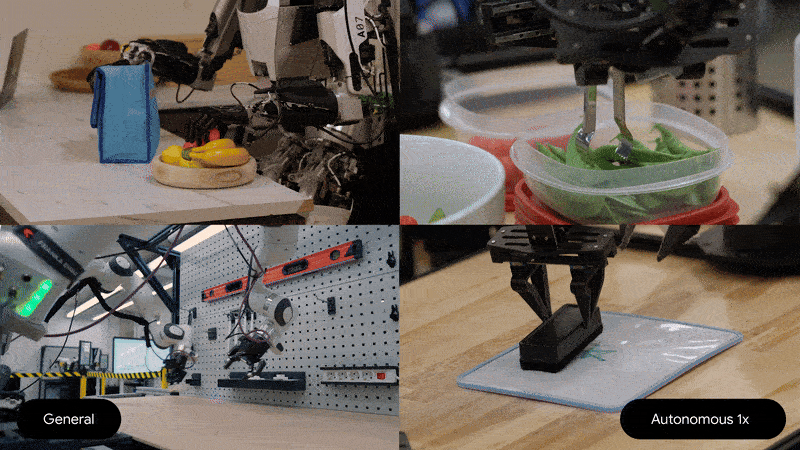

Nel gergo da conferenza stampa, questa versione viene definita “starter model”. Ma non fatevi ingannare dalla modestia retorica: è un incipit narrativo più che un prodotto base. Il nuovo Gemini può adattarsi a nuovi robot — dal Franka FR3 al più umanoide Apollo di Apptronik — con una manciata di dimostrazioni, da 50 a 100. In altri tempi, ci sarebbero voluti mesi di addestramento supervisionato, dataset monumentali e un esercito di ingegneri. Ora, invece, basta una coreografia di gesti e un po’ di codice: il robot impara. E se ne ricorda anche senza tornare a pregare il cloud.

C’è un motivo se Carolina Parada, responsabile della robotica di DeepMind, si dice “sorpresa” dalla forza di questo modello. Non è finta modestia da keynote. È che il paradigma sta cambiando sotto i nostri occhi. L’AI non è più solo una mente disincarnata che ci osserva dalle server farm: diventa un’intelligenza incarnata, distribuita, autonoma. La svolta? Il modello Gemini riesce ad agire, non solo a vedere e parlare. È in grado di eseguire compiti fisici complessi, anche quelli che non conosce, usando una comprensione semantica dell’ambiente e dei comandi. In altre parole, non segue solo istruzioni. Interpreta. Deduce. Improvvisa. Come un bravo cameriere di ristorante stellato, che non ha bisogno del menu per sapere cosa aspettarsi dal cliente.

È questo il cuore del modello VLA (vision-language-action): una tripla alleanza tra percezione, linguaggio e motricità. Quello che da decenni è il Santo Graal della robotica cognitiva, ora assume la forma di un SDK in beta testing. Perché Google, insieme all’on-device model, rilascerà anche un kit di sviluppo, il primo nel suo genere. Tradotto: gli sviluppatori potranno finalmente smettere di scrivere righe di codice su come afferrare un bicchiere e iniziare a dialogare con un’intelligenza che capisce cosa significa “porta questo alla signora col cappello rosso”. È un salto semantico, non solo tecnico.

Ma perché Google vuole spezzare il vincolo del cloud proprio ora? Non è solo una questione di latenza. È una questione di potere. E sicurezza. L’on-device model è perfetto per applicazioni dove la connessione non c’è — pensa ai robot in un magazzino remoto, in una centrale nucleare o a bordo di una nave militare. Ma anche in ambienti in cui i dati non possono essere esportati: ospedali, impianti industriali, laboratori di ricerca. I regolatori non vogliono più sentire parlare di “modello in cloud che registra tutto per migliorare il servizio”. La sovranità dei dati diventa un vincolo politico, oltre che tecnico. Ed ecco che Gemini si fa embedded.

Naturalmente, il fratello maggiore — il modello ibrido, che combina cloud e dispositivo — resta più potente. Ma la differenza si sta assottigliando, e il fatto che Parada lo definisca un “modello sorprendentemente forte” non è casuale. È la prova che la scalabilità dell’intelligenza artificiale non passa più solo dai teraFLOP, ma dalla capacità di stare dentro i sistemi, fisicamente. L’efficienza computazionale, combinata con architetture multimodali e raffinati sistemi di few-shot learning, sta rendendo obsoleti i paradigmi centralizzati.

E mentre il pubblico è ancora impegnato a interrogarsi sull’etica dell’AI generativa e sulle allucinazioni di ChatGPT, Google sposta silenziosamente il campo di battaglia nel mondo reale. Qui, dove un robot non può permettersi di “inventarsi” un modo per afferrare un bisturi o aprire un portello, serve precisione, adattabilità, e soprattutto presenza. Non intelligenza eterea, ma embodied cognition. Non un’oracolo distante, ma un agente che interagisce direttamente con il mondo.

Certo, siamo ancora in fase di test. Il modello è disponibile solo a un gruppo ristretto di sviluppatori fidati, e DeepMind continua a lavorare per minimizzare i rischi. Ma il messaggio è chiaro: la robotica AI-first è arrivata, e vuole essere autonoma. Nessun bisogno di tornare a casa per ricevere istruzioni. Nessun intermediario. Nessuna nuvola a fare da regista.

Questa decentralizzazione dell’intelligenza non è solo una rivoluzione tecnologica. È una rivoluzione culturale. Significa accettare che la mente non sta più al centro del sistema, ma ai margini. Significa costruire AI che non dipendano da una connessione per capire il mondo, ma che lo abitino, che lo tocchino, che ne facciano parte.

Come direbbe Alan Kay: “Il miglior modo per predire il futuro è inventarlo”. Google, intanto, sta infilando quel futuro nei circuiti dei suoi robot. E lo fa offline.