META CWM e il futuro inquietante del debug autonomo

Meta ha deciso che il codice non basta più generarlo, bisogna capirlo, sezionarlo, anticiparlo. Il suo nuovo modello CWM, Code World Model, rappresenta il tentativo più ambizioso di trasformare l’intelligenza artificiale in un ingegnere del software capace di ragionare in tempo reale. Non più la vecchia logica predittiva del completamento automatico stile GitHub Copilot, ma un sistema addestrato a osservare tracce di esecuzione, stati delle variabili e percorsi logici, per costruirsi un’immagine mentale di come il programma evolve. Un modello del mondo, appunto, ma applicato al codice. L’idea suona brillante: se capisco come vive il software, posso correggerlo meglio, posso persino anticiparne i comportamenti nascosti. La promessa di Meta è semplice: niente più AI che sputa funzioni compilabili e spesso sbagliate, bensì un assistente che impara dai container, simula percorsi e sa dove il codice si spezzerà prima che accada.

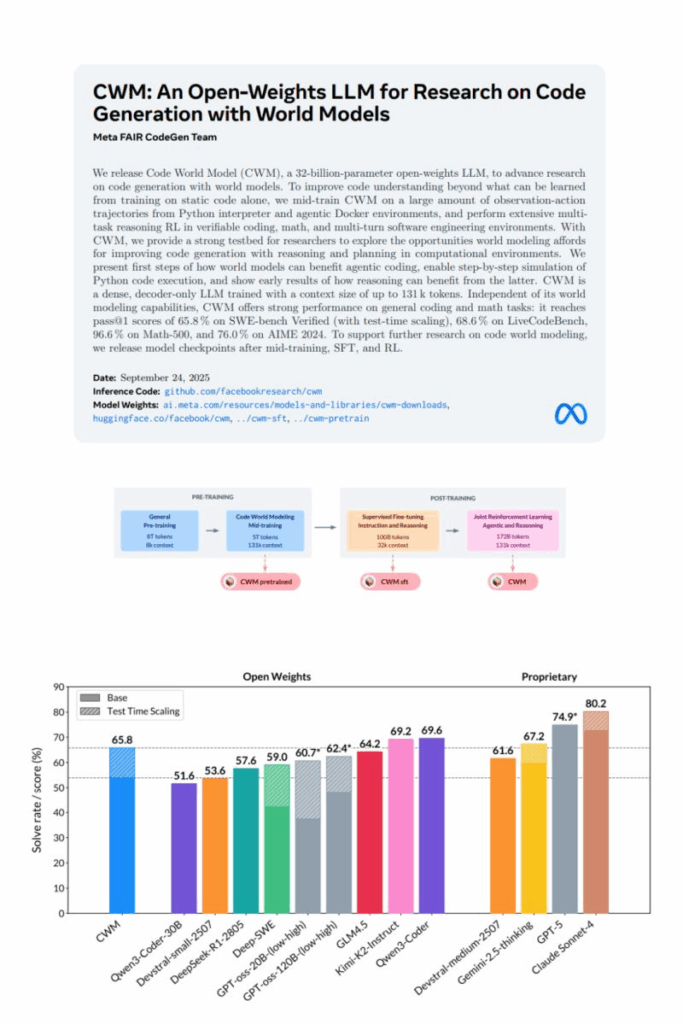

I numeri sventolati meritano attenzione. Nei benchmark ufficiali CWM ottiene circa il 65,8% su SWE‑bench Verified e il 68,6% su LiveCodeBench, mentre brilla con un 96,6% sul dominio matematico Math‑500 e un 76% su AIME 2024. Non male per un modello open‑weights da 32 miliardi di parametri. Peccato che l’affermazione di un’accuratezza del 91% nel debug, rilanciata in qualche titolo acchiappa‑click, non compaia nei paper né nei materiali tecnici. Forse si confonde la predizione di stati variabili con la capacità di correggere bug in un contesto reale. È il tipico marketing numerico: la matematica come esca per investitori e giornalisti frettolosi. Ma a ben vedere, ciò che conta non è la cifra magica, bensì la direzione intrapresa. Un’AI che non solo scrive codice, ma lo verifica, lo patcha, lo evolve.

Il problema è che questa autonomia apre scenari poco rassicuranti. Un conto è suggerire refactoring in un IDE, altro è lasciare che un modello agentico modifichi direttamente software critico. Chi risponde se un’AI introduce una regressione che manda in crash un sistema bancario? Chi si prende la colpa se un bug nascosto diventa una falla di sicurezza da milioni di dollari? Per ora le patch vivono in ambienti controllati, ma la traiettoria è chiara: container oggi, produzione domani. E già immaginiamo CTO che, attratti dall’efficienza, spingono i loro team a delegare sempre più manutenzione a un’entità probabilistica addestrata su codice pubblico.

Tracciabilità e spiegabilità diventano allora fondamentali. Non basta un log di sistema, serve un registro immutabile delle modifiche, con firme digitali, versioning forzato e motivazioni leggibili da un umano. La trasparenza non è opzionale, è l’unica difesa contro il caos. Eppure, sappiamo che l’industria preferisce la velocità al rigore, quindi non è difficile immaginare startup che abilitano patch automatiche senza supervisione per correre sul mercato. In quel momento il debito tecnico diventa un mostro silenzioso: bias incorporati, scelte architetturali opache, compromessi nascosti che accumulano vulnerabilità fino al crollo.

Le implicazioni etiche non si limitano alla sicurezza. Esiste un tema di responsabilità legale: se l’AI commette un errore, chi paga? Il vendor del modello? L’azienda che l’ha usato? L’ingegnere che ha dato l’OK? Senza una cornice normativa chiara rischiamo tribunali intasati da cause impossibili da risolvere. La governance del software, già fragile, verrebbe riscritta dalle macchine. E allora sì, servono guardrail severi: supervisione umana obbligatoria, sandbox impenetrabili, limiti di autonomia su moduli sensibili, audit esterni indipendenti. In pratica, trattare un agente di patching come tratteremmo un robot chirurgico o un veicolo a guida autonoma. Stesso livello di certificazione, stessi protocolli di sicurezza, stesso diritto al rollback immediato.

CWM è open weights, ed è questa la parte più dirompente. Non stiamo parlando di un giocattolo chiuso nelle segrete di Menlo Park, ma di un modello che ogni ricercatore, hacker o azienda può scaricare e addestrare a suo piacimento. È la democratizzazione del debug autonomo, con tutti i rischi del caso. La storia insegna che l’open source accelera l’innovazione ma anche gli abusi. Pensiamo a cosa succede quando un’AI che patcha da sola finisce in mano a gruppi che non hanno interesse per la sicurezza, ma solo per la rapidità o peggio per il sabotaggio.

Il paradosso è che mentre ci entusiasmiamo per la possibilità di avere programmatori instancabili che correggono codice giorno e notte, stiamo spalancando la porta a una trasformazione radicale della responsabilità tecnologica. Il software diventa un organismo che si autoregola, un ecosistema evolutivo dove l’umano diventa supervisore più che creatore. È affascinante e inquietante allo stesso tempo. Forse è inevitabile, ma conviene iniziare a discutere ora quali regole vogliamo imporre, prima che il codice inizi a scrivere la propria storia senza di noi.

Paper AI META : https://ai.meta.com/research/publications/cwm-an-open-weights-llm-for-research-on-code-generation-with-world-models/