Questa è la frase che fa scattare il sorriso compiaciuto nei corridoi dei laboratori di ricerca e il brontolio scettico nei dipartimenti di matematica. Google Deepmind ha giocato la partita rispettando ogni regola dell’Olimpiade Matematica Internazionale, quella sacra competizione dove solo un’élite di giovani prodigi riesce a portare a casa una medaglia d’oro. Il modello Gemini Deep Think ha risolto cinque problemi su sei, performance da medaglia ufficiale, seguendo le stesse condizioni imposte agli umani: quattro ore e mezza di tempo, niente accesso a risorse esterne, dimostrazioni scritte e coerenti. Non è un esercizio da laboratorio, è un colpo al cuore dell’orgoglio accademico.

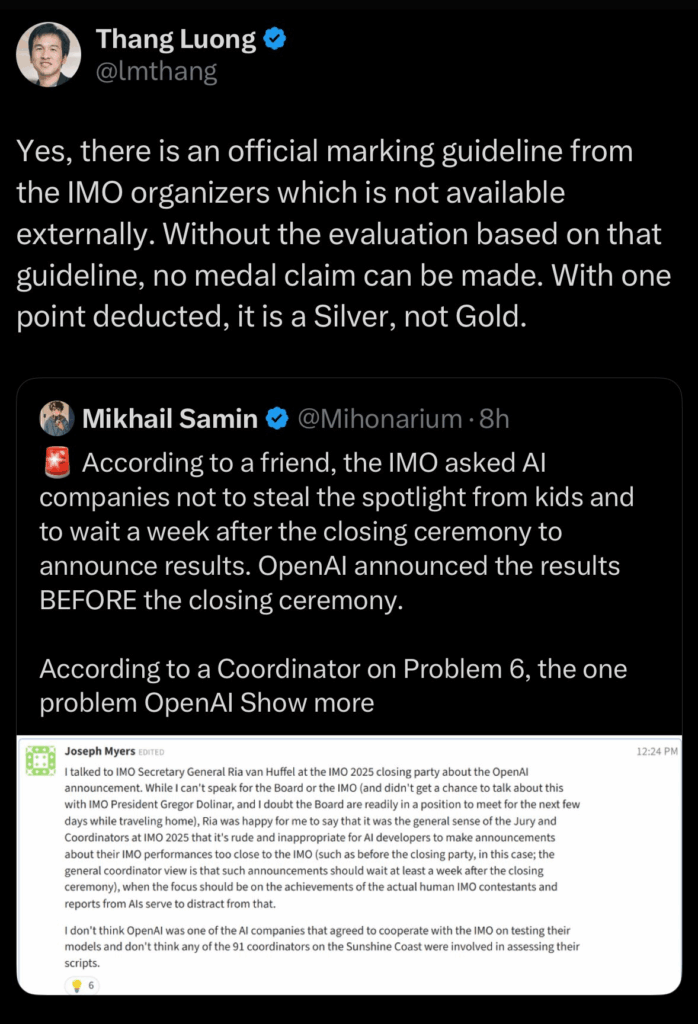

OpenAI, fedele al suo stile più aggressivo, ha fatto lo stesso con un suo modello sperimentale, ma in modo ufficioso. Ha preso gli stessi problemi, li ha processati internamente e ha ottenuto un punteggio identico, 35 su 42, sufficiente a qualificarsi per l’oro. Non ha aspettato il via libera ufficiale dell’organizzazione, pubblicando i risultati in anticipo e attirando l’inevitabile accusa di arroganza. La differenza tra i due colossi è tutta qui: Google ha rispettato il protocollo e ha aspettato il riconoscimento ufficiale, Openai ha preferito il clamore immediato, infischiandosene della ritualità.

Il dato cruciale però non è il gossip tra multinazionali. È il salto qualitativo nell’AI reasoning. Per la prima volta un’intelligenza artificiale ha superato un test olimpico basato su logica, astrazione e dimostrazioni in linguaggio naturale. Chi mastica matematica sa che non si tratta di calcoli meccanici ma di capacità di concatenare concetti, elaborare strategie e scrivere prove formalmente corrette. La percentuale di umani che raggiunge l’oro all’Imo è tra il 10 e l’11 per cento. Google e OpenAI si sono infilati esattamente in quella stretta élite, e questo dice molto più di mille chiacchiere su presunta intelligenza artificiale generale.

Il modello di Deepmind è stato addestrato con un approccio quasi spartano. Ha simulato in modo realistico l’ambiente di gara, ragionando in tempo reale sotto vincolo temporale. È qui la vera difficoltà: non basta trovare la soluzione, bisogna farlo con la pressione del timer e in un formato leggibile per i giudici umani. OpenAI ha seguito una strategia differente, puntando su un uso massiccio del cosiddetto test-time compute, ovvero potenza bruta concentrata per aumentare la profondità del ragionamento. È come se uno studente olimpico potesse improvvisamente moltiplicare il numero di pensieri paralleli durante l’esame. Nessuno vieta questa tecnica in laboratorio, ma rende il confronto con le prestazioni umane meno diretto.

Gli esperti non sono unanimi. Junehyuk Jung di Brown University ha definito il risultato “un segnale che l’AI potrà presto essere utile anche per problemi aperti”. Gary Marcus, invece, ha ricordato che senza verifica indipendente i titoli roboanti valgono poco. E un utente su Lesswrong ha sintetizzato con sarcasmo: “C’è sempre un po’ di marketing travestito da scienza nelle uscite di Openai”.

Demis Hassabis di Deepmind ha commentato sobriamente, ribadendo l’aderenza alle regole e la scelta di attendere l’approvazione ufficiale prima di sbandierare il traguardo. Sundar Pichai ha twittato un “From silver to gold” che ha raccolto perfino l’emoji di approvazione di Elon Musk. Dettagli di contorno, ma utili per capire il clima da semifinale mondiale tra colossi tech.

Il vero punto è che questo episodio segna una cesura culturale. Alphageometry2 aveva già mostrato come combinare ragionamento simbolico e linguaggio naturale, ma qui la consacrazione arriva in un’arena pubblica e riconosciuta. Non è più un test controllato in laboratorio, è una sfida in un contesto dove il metro di paragone è quello umano. Se questi modelli riusciranno a passare dall’esercizio olimpico alla ricerca accademica vera, potrebbero contribuire a risolvere problemi aperti in teoria dei numeri, fisica teorica e criptografia.

Il rischio è che la corsa alla medaglia faccia dimenticare l’importanza del rigore. Gli investimenti in AI hanno già superato i 300 miliardi quest’anno, e la pressione per mostrare risultati clamorosi è altissima. OpenAI ha chiarito che il modello non verrà rilasciato a breve e rimane sperimentale, ma è evidente che la gara per la supremazia del ragionamento matematico è iniziata.

La provocazione finale? L’Olimpiade Matematica Internazionale è nata per celebrare l’ingegno umano, e ora diventa il palcoscenico dove le creazioni umane lo eguagliano, se non lo superano. La matematica è ufficialmente diventata un campo di battaglia tra cervelli biologici e neuroni artificiali. E, per una volta, non siamo noi quelli che dettano le regole del gioco.