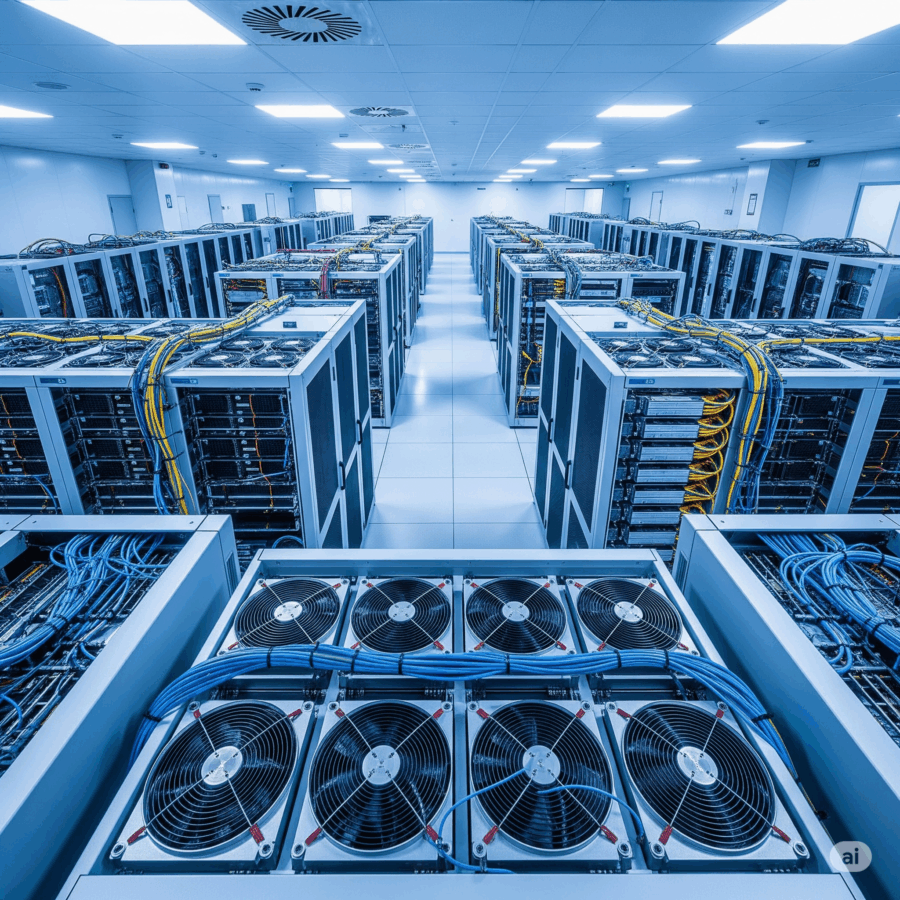

Nel teatrino sempre più surreale della comunicazione finanziaria, Oracle ha appena alzato il sipario su uno dei suoi momenti più strani, più affascinanti e, a modo suo, più geniali. Mentre i competitor si arrampicano sugli specchi per strappare qualche menzione in un blog di settore, Larry Ellison & co. decidono che un colossale accordo cloud da oltre 30 miliardi di dollari l’anno non meriti un comunicato stampa, né una fanfara condita da parole chiave ridondanti come “AI-native” o “cloud-first architecture”.

No, loro lo infilano di soppiatto in un documento per la SEC, intitolato con sobria precisione “Regulation FD Disclosure”, senza nemmeno la voglia di inventarsi un nome altisonante e per chi si chiedesse cosa significhi tutto ciò: vuol dire che Oracle ha deciso di fare la rockstar in giacca e cravatta, suonando heavy metal in una riunione del consiglio d’amministrazione.