Nel panorama tecnologico in continua evoluzione, molti si pongono la domanda: “Perché abbiamo ancora bisogno degli ingegneri se abbiamo l’intelligenza artificiale?” Una domanda legittima, considerando i rapidi progressi dell’IA e la sua applicazione in vari campi. Tuttavia, mentre l’IA ha fatto significativi progressi nell’assistenza alla scrittura di codice, lo sviluppo software va ben oltre il semplice scrivere righe di codice o generare script. Il ruolo degli ingegneri non si limita a produrre codice, ma implica anche la comprensione delle esigenze, la progettazione dell’architettura, l’ottimizzazione delle prestazioni e la garanzia che il software soddisfi gli obiettivi aziendali.

Tag: Coding

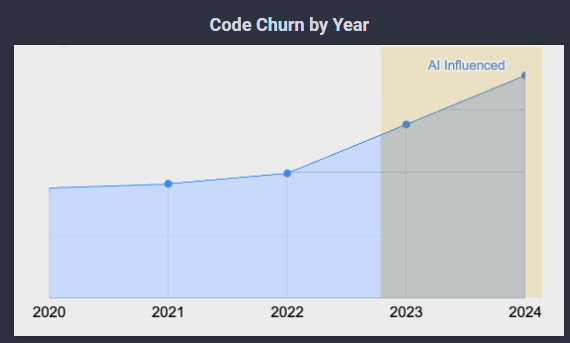

L’evoluzione degli assistenti di codifica sta segnando una fase cruciale nello sviluppo software, con l’intelligenza artificiale (IA) che gioca un ruolo sempre più significativo. Sundar Pichai, CEO di Google, ha annunciato che oltre il 25% del nuovo codice scritto all’interno dell’azienda è generato da algoritmi di intelligenza artificiale. Analogamente, Microsoft ha evidenziato come il suo assistente di codifica, GitHub Copilot, contribuisca a generare quasi la metà del codice all’interno dei file in cui è attivato. OpenAI, da parte sua, sta espandendo le capacità di generazione del codice dei suoi modelli, alimentando una competitività che si intensifica nel settore dell’IA.

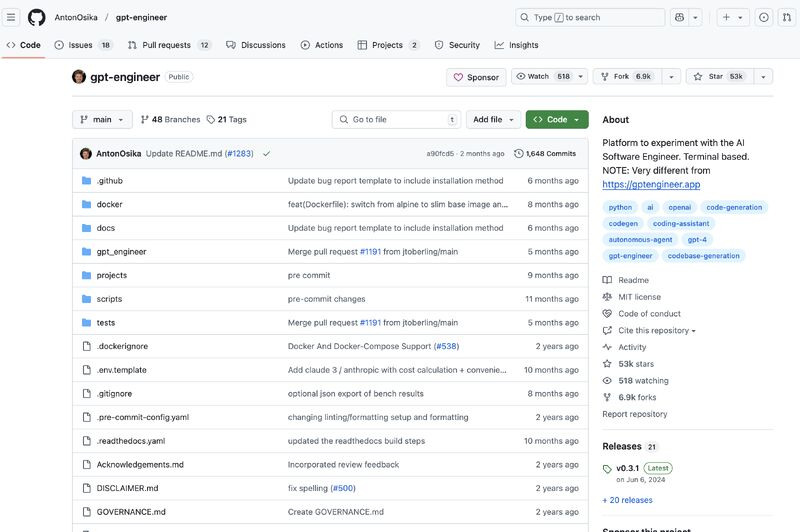

Anysphere, lo sviluppatore dell’assistente alla programmazione basato su AI, Cursor, sta attualmente attirando un notevole interesse da parte dei capitalisti di rischio, con offerte che valutano l’azienda a circa 2,5 miliardi di dollari e hanno ottenuto 8M$ da OpenAI. Questo segna una pietra miliare significativa per la startup, riflettendo la crescente fiducia degli investitori nelle tecnologie di intelligenza artificiale e machine learning, in particolare nel settore dello sviluppo software.