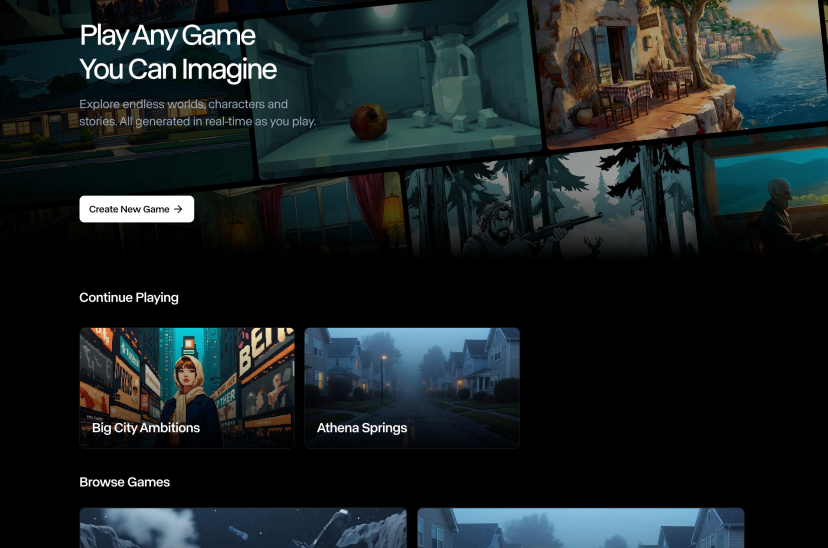

La Silicon Valley ha un nuovo giocattolo preferito: i videogiochi generati dall’intelligenza artificiale. Runway, la startup da 3 miliardi di dollari che ha già fatto tremare gli studios di Hollywood, ora punta dritta al cuore pulsante dell’industria videoludica. Ma non aspettatevi ancora mondi 3D fotorealistici o trame degne di The Last of Us. Per ora, l’esperienza è ridotta a una semplice interfaccia testuale con qualche immagine generata al volo. Sembra poco, ma è esattamente come è iniziata l’invasione AI nei set cinematografici: silenziosa, sottovalutata, e poi devastante.

Tag: runway

AMC Networks e Runway

L’intelligenza artificiale generativa non è più l’ospite invisibile nella stanza dei bottoni di Hollywood. Con la partnership tra AMC Networks e la startup Runway, la tecnologia non sta più bussando alla porta: ha buttato giù i muri, ha messo i piedi sul tavolo e ha iniziato a scrivere le sceneggiature. Previsualizzazioni generate da AI, campagne marketing senza un solo ciak, versioni alternative di film per fasce d’età modellate da algoritmi: questo non è il futuro della TV via cavo, è il presente, spudorato e inequivocabile.

Nel mondo saturo di demo flashy e output inconsistenti, Runway fa una mossa chirurgica e spietata: sblocca Gen-4 References per tutti gli utenti paganti, cancellando di fatto la linea di demarcazione tra giocattolo creativo e strumento professionale. È il tipo di aggiornamento che fa tremare i polsi ai content creator, fa storcere il naso ai puristi del cinema e accende gli occhi agli studios low budget. Qui non si parla solo di prompt, ma di potere creativo visivo end-to-end, cucito sulla pelle del creator.

Runway ha rilasciato lunedì il suo ultimo strumento di editing video, un passo deciso per consolidare la sua posizione in un mercato sempre più affollato e competitivo. La startup, valutata 4 miliardi di dollari secondo gli investitori che volevano finanziarla la scorsa estate, ha ora un obiettivo chiaro: sfidare OpenAI e il suo ambizioso progetto Sora.

Il nuovo modello, Gen-4, è un’evoluzione significativa rispetto ai suoi predecessori, con miglioramenti evidenti nella coerenza visiva tra clip diverse. Personaggi, ambientazioni e oggetti mantengono un aspetto uniforme grazie a un’immagine di riferimento fornita dall’utente, risolvendo una delle principali criticità dell’editing video basato su intelligenza artificiale.

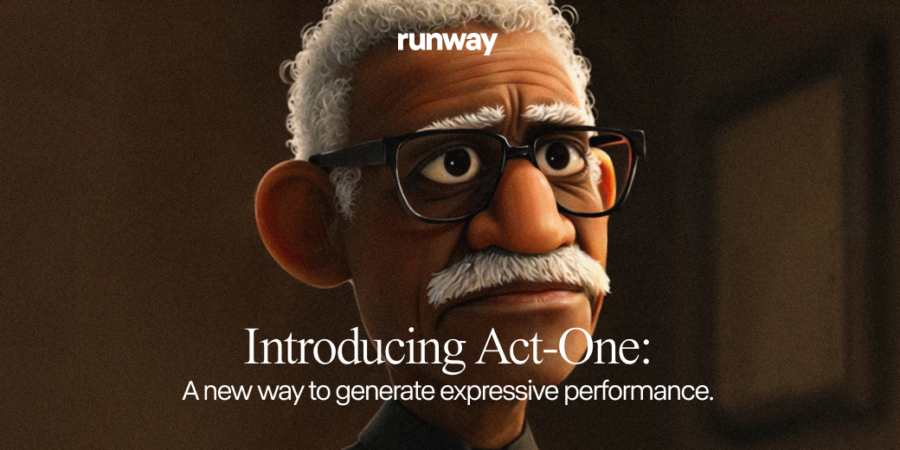

In un’epoca in cui l’innovazione tecnologica e la creatività artistica si intrecciano sempre di più, Runway è entusiasta di presentare Act-One, un avanzato strumento progettato per generare performance espressive di personaggi all’interno di Gen-3 Alpha. Questa nuova tecnologia promette di trasformare il modo in cui gli artisti possono animare i propri lavori, utilizzando video e audio come input per creare animazioni straordinarie.

Runway ha recentemente lanciato una nuova funzionalità che consente di generare video a partire da immagini statiche, utilizzando il suo modello Gen-3 Alpha. Questa innovazione, implementata solo poche ore fa, ha suscitato grande entusiasmo tra i creatori di contenuti e gli appassionati di tecnologia.

Il modello Gen-3 Alpha di Runway, disponibile al pubblico dal 1° luglio 2024, rappresenta un grande passo avanti nella generazione di video con intelligenza artificiale. Accessibile con un abbonamento a partire da $12 al mese, questo modello avanzato permette di creare video ad alta fedeltà, coerenti e controllabili tramite prompt di testo, immagine o video, diventando uno strumento prezioso per registi, creatori di contenuti e altri professionisti creativi.

Runway, l’azienda pionieristica di ricerca sull’intelligenza artificiale, ha annunciato il rilascio di Gen-3 Alpha, un nuovo modello trasformativo che rappresenta un importante passo avanti nella generazione di video ad alta fedeltà e controllabile. Questa ultima iterazione dei modelli di base di Runway segna un significativo progresso verso la costruzione di “Modelli Mondiali Generali” – sistemi di IA con una profonda e olistica comprensione del mondo visivo e della sua dinamica.

Sora è il nuovo generatore di text-to-video di OpenAI. Lo strumento, presentato giovedì scorso dall’azienda con sede a San Francisco, utilizza l’intelligenza artificiale generativa per creare istantaneamente brevi video basati su comandi scritti.

Sora non è il primo a lanciare questo tipo di tecnologia, dove sono già presenti realtà come Runway, Stable Video Diffusion, Pika e più recentemente Google con Lumiere. Tuttavia se andiamo ad analizzare i commenti dei vari esperti del settore rileviamo che sono tutti unanimi nel sottolineare l’alta qualità dei video realizzati finora e che l’introduzione di questa nuova App segni un passo avanti significativo sia per OpenAI che per il futuro della generazione di testo in video in generale.

Nel dettaglio Sora è un generatore di testo in video che crea video lunghi fino a 60 secondi in base a istruzioni scritte utilizzando l’Intelligenza Artificiale generativa. Il modello può anche generare video da un’immagine fissa esistente, tuttavia non è ancora disponibile per l’uso pubblico (OpenAI afferma che sta collaborando con politici e artisti prima di rilasciare ufficialmente lo strumento) e ci sono ancora molte cose che non sappiamo. Ma dall’annuncio di giovedì, la società ha condiviso una serie di esempi di video generati da Sora per mostrare cosa può fare e i risultati sembrano davvero impressionanti.

Contestualmente al rilascio, OpenAI ha dichiarato di essere consapevole che Sora potrebbe essere usata per produrre deepfake e disinformazione, specificando che l’azienda sta lavorando con i cosidetti “red teamer” esperti in aree come disinformazione, contenuti che incitano all’odio e pregiudizi, che testeranno il modello in modo contraddittorio, al fine di rilevare eventuali possibilità di rilevare contenuti fuorvianti. Immaginiamo quindi che non sarà possibile creare contenuti violenti o pornografici, né tantomeno riprodurre le fattezze di persone reali o lo stile di artisti famosi, come peraltro già succede per il suo generatore di immagini, Dall-E.

In ogni caso questo ulteriore passaggio evolutivo dell’AI generativa pone in capo a OpenAI una ulteriore responsabilità, non solo sul più vasto tema delle fake news che è possibile generare grazie a questi modelli ma anche dal punto di vista di eventuali problemi legati al diritto d’autore dei dati di addestramento per i quali OpenAI è già stata citata in giudizio da attori come il New York Times.