L’evoluzione delle tecnologie di intelligenza artificiale generativa ha catturato l’immaginazione del pubblico, offrendo strumenti che vanno dalla gestione delle attività lavorative alla stimolazione della creatività. Tali strumenti stanno rapidamente diventando parte integrante di prodotti utilizzati da milioni di persone nella vita quotidiana.

Tuttavia, con l’aumentare della popolarità di queste tecnologie, cresce il rischio di danni accidentali o intenzionali, come la diffusione di disinformazione e phishing, se i contenuti generati dall’IA non vengono correttamente identificati. Per affrontare questa sfida, Google Deepmind ha lanciato SynthID, un innovativo toolkit digitale per l’applicazione di watermark ai contenuti generati dall’IA.

Google Deepmind sta ampliando le capacità di SynthID per includere il watermarking di testi generati dall’IA nell’app Gemini e nell’esperienza web, nonché dei video generati da Veo, il nostro modello video generativo più avanzato.

SynthID per il testo

SynthID per il testo è progettato per integrarsi con la maggior parte dei modelli di generazione di testo basati sull’IA e per essere implementato su larga scala. Questo metodo innovativo incorpora un watermark impercettibile senza compromettere la qualità, l’accuratezza, la creatività o la velocità del processo di generazione del testo.

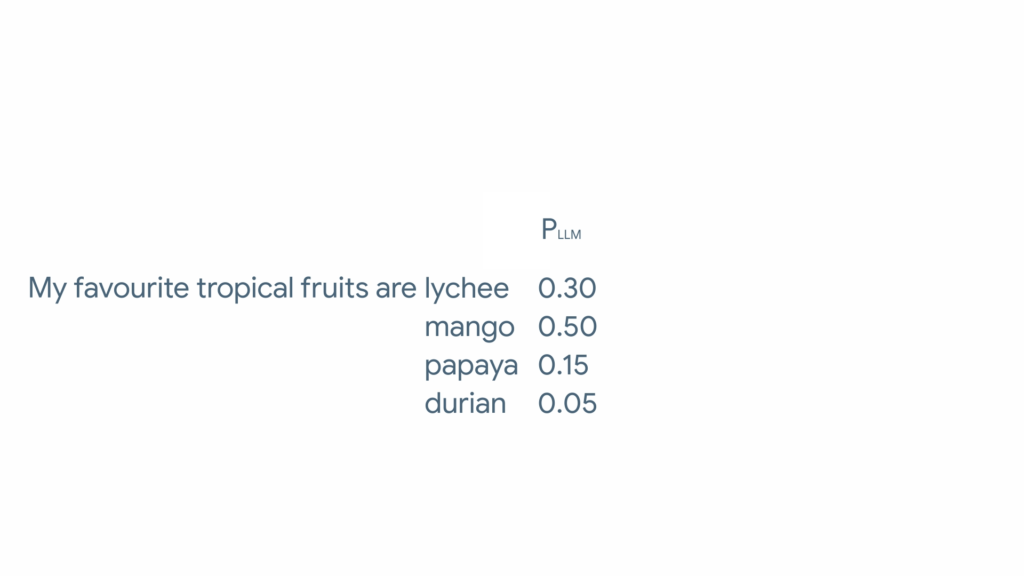

SynthID incorpora filigrane invisibili direttamente nel processo di generazione del testo, aggiungendo informazioni alla distribuzione dei token senza comprometterne qualità, accuratezza, creatività o velocità. SynthID funziona meglio con risposte lunghe generate da modelli linguistici, come saggi, sceneggiature o email. È efficace anche con alcune modifiche, come ritagliare testo o parafrasare leggermente. Tuttavia, la sua affidabilità diminuisce notevolmente quando il testo viene riscritto o tradotto.

La filigrana di SynthID è meno efficace con risposte a domande specifiche, dove c’è meno opportunità di regolare la distribuzione dei token senza influenzare l’accuratezza, come domande di fatti concreti. Strumenti di rilevamento AI attuali usano classificatori che spesso funzionano solo per compiti specifici, risultando meno flessibili e affidabili su diversi tipi di contenuti. Ciò può portare a etichettature errate, identificando erroneamente il testo come generato dall’intelligenza artificiale.

SynthID è efficace da solo, ma può essere combinato con altri metodi di rilevamento AI per una migliore copertura tra tipi di contenuti e piattaforme. Sebbene non impedisca direttamente ad attaccanti motivati come cybercriminali di causare danni, può rendere più difficile l’uso di contenuti AI per scopi dannosi.

SynthID per i video

Per quanto riguarda i video, Google Deepmind ha sviluppato una tecnica di watermarking ispirata al SynthID per le immagini. Questo metodo incorpora un watermark direttamente nei pixel di ogni frame video, rendendolo impercettibile all’occhio umano ma rilevabile per l’identificazione. A partire da oggi, tutti i video generati da Veo su VideoFX avranno il watermark di SynthID.

Funzionamento del watermarking per il testo

I modelli di linguaggio generano sequenze di testo in risposta a prompt specifici. SynthID inserisce watermark impercettibili direttamente nel processo di generazione del testo, modificando la distribuzione dei token senza compromettere la qualità o la creatività.

Benefici e limitazioni

SynthID per il watermarking del testo funziona meglio con risposte più lunghe e diverse, come saggi o script teatrali. Tuttavia, può risentire di trasformazioni estreme come la traduzione in un’altra lingua. È meno efficace con prompt basati su fatti.

Funzionamento del watermarking per i video

Il watermarking per i video si basa sulla tecnica di SynthID per le immagini, inserendo un watermark in ogni frame video. Questo aiuta a identificare se un video è stato generato da un’IA.

Portare SynthID all’ecosistema AI

SynthID per il watermarking del testo sarà presto reso open-source per consentire agli sviluppatori di integrare questa tecnologia nei propri modelli. Questo passo è parte del nostro impegno per prevenire il cattivo uso dei contenuti generati dall’IA e per garantire un ambiente digitale più sicuro per tutti.

Lascia un commento

Devi essere connesso per inviare un commento.