Nel panorama in rapida evoluzione dell’intelligenza artificiale, una nuova tecnica sta rivoluzionando il modo in cui i modelli vengono sviluppati, riducendo drasticamente i costi e democratizzando l’accesso a strumenti avanzati. Si tratta della “distillazione”, un processo che permette di trasferire le capacità di un modello AI di grandi dimensioni a uno più piccolo e leggero, mantenendo al contempo prestazioni elevate. Questa innovazione ha già sconvolto il settore, mettendo in discussione la supremazia di colossi come OpenAI, Microsoft e Meta, e favorendo l’ascesa di nuove realtà come la cinese DeepSeek.

La rivoluzione della distillazione: modelli più piccoli, costi ridotti

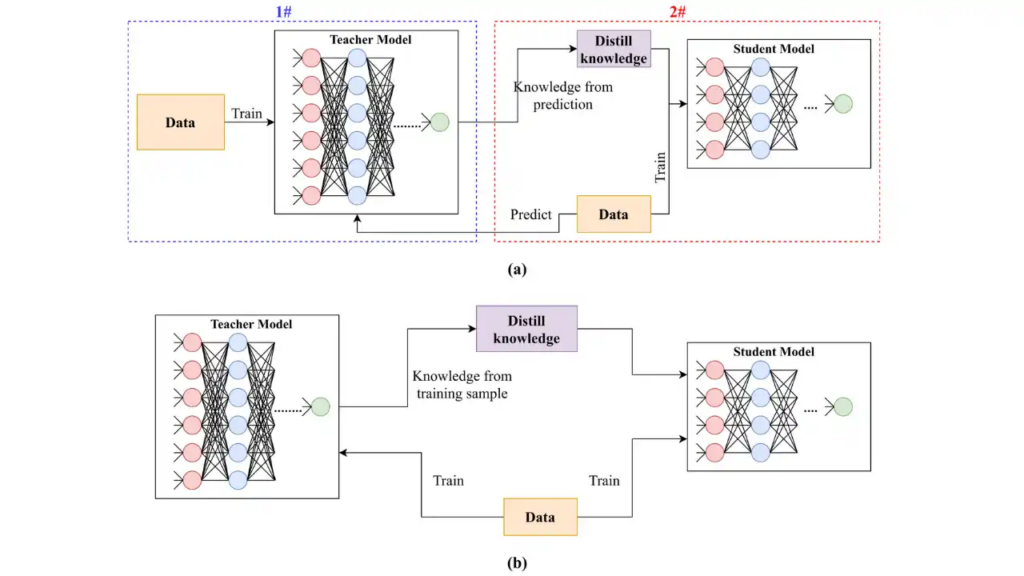

La distillazione consiste nel prendere un grande modello linguistico (definito “modello insegnante”) e utilizzarlo per generare dati che addestrano un modello più piccolo (“modello studente”). Questo permette di mantenere elevate capacità predittive, pur riducendo significativamente il fabbisogno computazionale e i costi di gestione.

L’adozione di questa tecnica ha guadagnato slancio quando DeepSeek ha dimostrato di poter distillare modelli open-source rilasciati da giganti come Meta e Alibaba, creando versioni più efficienti e accessibili. Questa mossa ha innescato un’ondata di preoccupazione a Wall Street, con ripercussioni sul valore azionario dei grandi player del settore.

I modelli di intelligenza artificiale di grandi dimensioni, come GPT-4 di OpenAI, Gemini di Google e Llama di Meta, richiedono enormi quantità di dati e potenza di calcolo per essere addestrati e mantenuti. Si stima che i costi di sviluppo di queste tecnologie si aggirino sui centinaia di milioni di dollari. La distillazione offre invece una soluzione alternativa: con un investimento molto inferiore, aziende e sviluppatori possono accedere a modelli potenti e integrabili direttamente su dispositivi come laptop e smartphone, senza la necessità di server costosi.

Deepseek e la minaccia alla leadership di OpenAI

Uno dei casi più emblematici dell’impatto della distillazione è quello di DeepSeek. Questa startup cinese ha dimostrato come sia possibile ridurre i costi computazionali senza sacrificare significativamente le capacità dei modelli, e lo ha fatto sfruttando tecnologie open-source rilasciate da concorrenti come Meta e Alibaba.

La vicenda ha allarmato OpenAI, che sospetta che DeepSeek abbia utilizzato la distillazione per addestrare il proprio modello su dati provenienti dalle sue piattaforme, una pratica che violerebbe i suoi termini di servizio. Per proteggersi, OpenAI ha rafforzato le misure di controllo, monitorando gli utenti e bloccando gli account sospetti di generare enormi quantità di dati per scopi di distillazione non autorizzata. Tuttavia, questa strategia è perlopiù reattiva, rendendo difficile una protezione totale.

Nonostante ciò, OpenAI e altri giganti del settore stanno cercando di trarre vantaggio dalla distillazione. Microsoft, ad esempio, ha utilizzato GPT-4 per distillare modelli più piccoli, come la famiglia Phi, dimostrando come questa tecnica possa essere un’arma a doppio taglio: da un lato, riduce i costi per gli utenti finali; dall’altro, mette sotto pressione il modello di business delle grandi aziende, che guadagnano meno dalla vendita di modelli distillati rispetto a quelli full-size.

Il dilemma della distillazione: efficienza vs. performance

Sebbene la distillazione sia un’opportunità per rendere più accessibili le capacità dell’AI, presenta anche delle limitazioni. La riduzione delle dimensioni di un modello comporta inevitabilmente una perdita di capacità generali: un modello distillato potrebbe eccellere in compiti specifici, come il riassunto di e-mail, ma non essere altrettanto versatile in altri ambiti.

Secondo Ahmed Awadallah di Microsoft Research, la distillazione rappresenta un compromesso: i modelli distillati possono essere estremamente efficienti per determinati scopi, ma difficilmente possono eguagliare la flessibilità e la potenza di un modello completo. Tuttavia, per la maggior parte delle aziende e degli sviluppatori, questi modelli più piccoli risultano più che sufficienti.

David Cox, vicepresidente della divisione AI di IBM Research, sottolinea che la maggior parte delle applicazioni aziendali non necessita di modelli giganteschi. I chatbot per il servizio clienti, le interfacce vocali e i sistemi di automazione possono funzionare perfettamente con versioni distillate, riducendo costi operativi e consumi energetici.

L’impatto sul mercato e il futuro dei modelli open

La distillazione rappresenta anche una vittoria per il movimento degli open models, ossia modelli AI resi disponibili pubblicamente per essere migliorati e adattati da sviluppatori indipendenti. Yann LeCun, capo scienziato AI di Meta, ha dichiarato che la sua azienda utilizzerà la distillazione per migliorare i propri prodotti, confermando l’impegno per un approccio aperto all’innovazione.

Questo solleva una questione cruciale per le aziende che investono miliardi di dollari nello sviluppo di modelli proprietari: ha senso continuare a investire enormi risorse in modelli avanzati, se poi possono essere rapidamente distillati e replicati da concorrenti più piccoli?

IBM evidenzia come l’AI stia diventando un settore estremamente competitivo e dinamico, dove il vantaggio del primo arrivato può svanire rapidamente. Un’azienda può spendere cifre astronomiche per creare un nuovo modello AI, solo per vedere la concorrenza raggiungerla in pochi mesi grazie alla distillazione.

L’equilibrio tra grandi modelli e versioni distillate

Nonostante le sfide poste dalla distillazione, OpenAI e altri colossi tecnologici ritengono che i grandi modelli manterranno un ruolo centrale. Per compiti complessi, ad alta intelligenza e con elevate necessità di precisione, le aziende saranno ancora disposte a pagare per avere accesso ai migliori modelli disponibili. Inoltre, le innovazioni sviluppate attraverso modelli di punta possono successivamente essere distillate per ottenere versioni più leggere e mirate.

L’AI sta entrando in una nuova fase, dove efficienza, accessibilità e sostenibilità economica stanno diventando fattori chiave. La distillazione potrebbe essere la tecnologia che ridefinisce il settore, spingendo i giganti dell’AI a trovare un nuovo equilibrio tra innovazione, protezione dei propri asset e apertura verso modelli più sostenibili e scalabili.