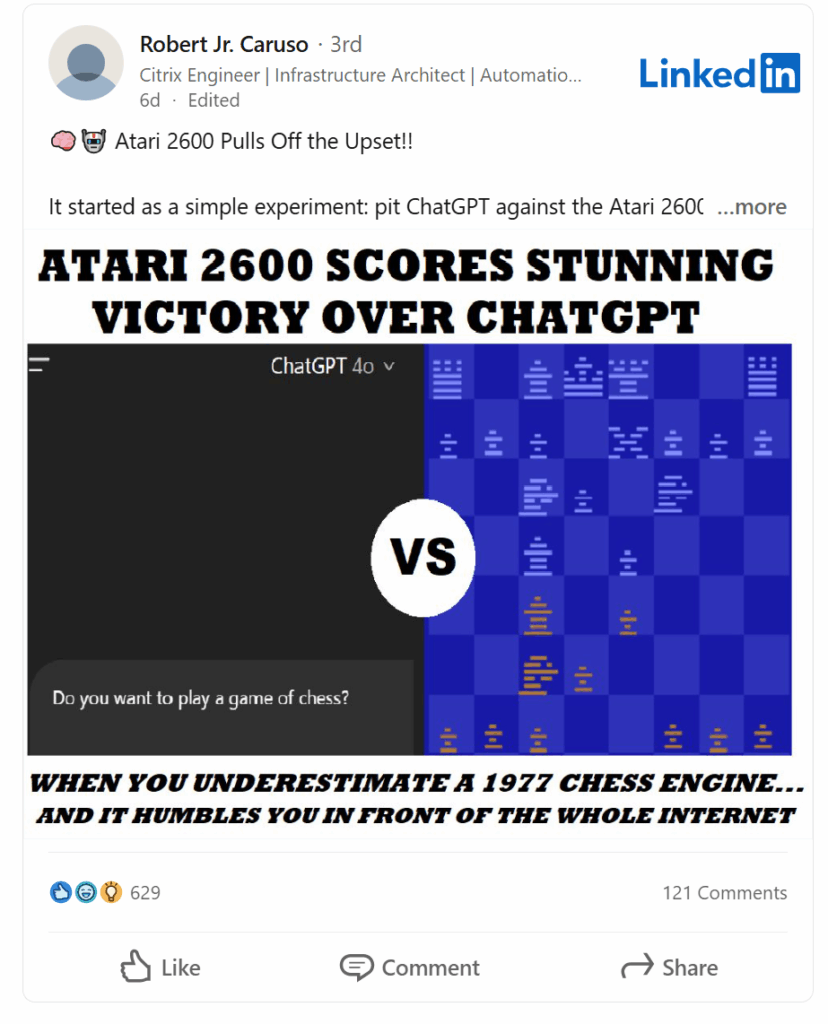

Una scacchiera grigia, pochi pixel maldestri. Un processore da 1.19 MHz, Atari 2600, anno 1977. E poi c’è ChatGPT, monumento del machine learning, con miliardi di parametri, ore di training, infrastruttura da superpotenza. Risultato? Umiliazione. Confusione tra pezzi. Errori da principiante. Scacco matto dall’intelligenza di un tostapane glorificato.

Non è ironia cosmica. È una lezione spietata sul perché l’intelligenza artificiale non è onnisciente, e sul fatto che il contesto – come sempre – conta più dell’intelligenza in sé.

I Large Language Model non sono cervelli nel senso classico. Non “vedono”. Non “giocano”. Non “ricordano” nel senso in cui lo fa un sistema a stati. Sono generatori di testo predittivo, reattivi, sensibili al prompt, alla sequenza, all’ambiguità semantica. Costruiscono coerenza linguistica, non strategia.

La battaglia tra ChatGPT e l’Atari è la metafora perfetta della guerra tra generalismo e specializzazione.

L’Atari è una bestia da soma monocorde. Fa una cosa. Solo quella. E la fa dannatamente bene. ChatGPT invece è una biblioteca che parla, una creatura del contesto, che però inciampa nella geometria essenziale di una scacchiera 8×8. Non perché sia “stupido”, ma perché non è nato per avere memoria posizionale persistente. Il suo cervello è un flusso, non una mappa.

Chi guida una Tesla nel deserto senza segnale GPS non può lamentarsi se finisce contro un cactus. Il problema non è l’intelligenza. È l’applicazione sbagliata.

L’umiliazione di ChatGPT da parte di un mostriciattolo a 8 bit non è solo un momento virale. È una specie di vendetta filosofica per la tecnologia del passato, e un monito per quella del futuro.

Gli umani si ostinano a credere che l’intelligenza artificiale sia una creatura unica, un cervello universale, un oracolo polivalente. Ma ogni AI è uno strumento, non un dio. Un bisturi non costruisce case. Un martello non fa diagnosi. E un LLM non gioca a scacchi, almeno non senza un sistema esterno che lo completi, che lo fissi nel tempo, che gli dia occhi e mani.

Il problema vero è che confondiamo la versatilità con la competenza.

ChatGPT può scrivere un trattato sulle aperture siciliane, ma inciampa su un cavallo che salta una regina. È l’equivalente digitale di un esperto teorico che entra in campo e si dimentica da che lato gioca. L’Atari, con tutta la sua goffaggine, invece gioca e basta. Non riflette, non sogna, non digita. Muove.

Ed è per questo che vince.

Ora, alcuni rideranno. Altri tireranno fuori il solito mantra: “l’AI non è ancora pronta”. Ma chi lavora seriamente con l’intelligenza artificiale capisce che il punto non è il fallimento. È la sintonia tra sistema e contesto. È lo use case. È la disciplina della selezione.

In un’epoca dove tutto viene etichettato “AI-powered”, il rischio più grande non è il collasso dei modelli. È la confusione tra potere e pertinenza.

L’AI funziona magnificamente dove il contesto è chiuso, ben definito, strutturato. Diagnostica medica con dati coerenti. Ottimizzazione logistica su input numerici. Classificazione visiva su immagini chiare. Ma quando la si butta dentro ambienti semiotici dinamici, dove bisogna vedere, tenere a mente, anticipare, allora il fascino si dissolve, e l’oracolo si scopre smemorato.

Una curiosità storica: l’Atari Chess del 1979 usava un algoritmo talmente compatto che ci stava in 4 KB di RAM. Eppure, batte un modello da centinaia di miliardi di parametri. Perché? Perché ha una sola cosa da fare.

Paradossalmente, è un elogio alla povertà cognitiva. La semplicità come vantaggio. L’intelligenza artificiale come forma di stupidità funzionale altamente ottimizzata.

Il futuro dell’AI non è nella rincorsa cieca alla generalizzazione. È nella orchestrazione intelligente degli strumenti giusti per i problemi giusti. E forse, anche, nel rispetto per quelle vecchie macchine che facevano poco, ma lo facevano bene.

Il vero pericolo oggi non è l’AI che sbaglia. È l’essere umano che si fida nel contesto sbagliato.

Si ride di ChatGPT che perde a scacchi contro l’Atari. Ma chi è il vero stupido? Il modello che non è progettato per giocare, o l’utente che lo mette sulla scacchiera come se fosse Deep Blue?

Nel mondo del software moderno, il concetto di tool selection è più cruciale che mai. Saper scegliere cosa usare, quando usarlo, e dove metterlo in pipeline. Questo è il nuovo talento. Non il prompt crafting, non l’ingenuità del “fammi tutto tu”. Ma il pensiero sistemico, architetturale, contestuale.

E allora forse, tra un matto in tre mosse e un algoritmo a 8 bit, la lezione è chiara:

l’intelligenza artificiale è uno specchio. Se gli chiedi di vedere, ma non gli dai occhi, l’unico cieco sei tu.