L’annuncio di Dreamer 4 da parte di Google DeepMind è la miccia che potrebbe accendere una nuova era per l’intelligenza artificiale agente. Un agente che non “impara giocando”, ma impara immaginando dentro il proprio modello del mondo senza mai interagire col mondo reale durante l’apprendimento e che ha già ottenuto il risultato simbolico di estrarre diamanti in Minecraft, consumando 100 volte meno dati rispetto a VPT di OpenAI. Questo non è un esperimento marginale: è una sfida lanciata al paradigma dominante del reinforcement learning.

Dreamer 4 è descritto nei termini di “Training Agents Inside of Scalable World Models” un paper da Danijar Hafner e collaboratori appena pubblicato su arXiv.

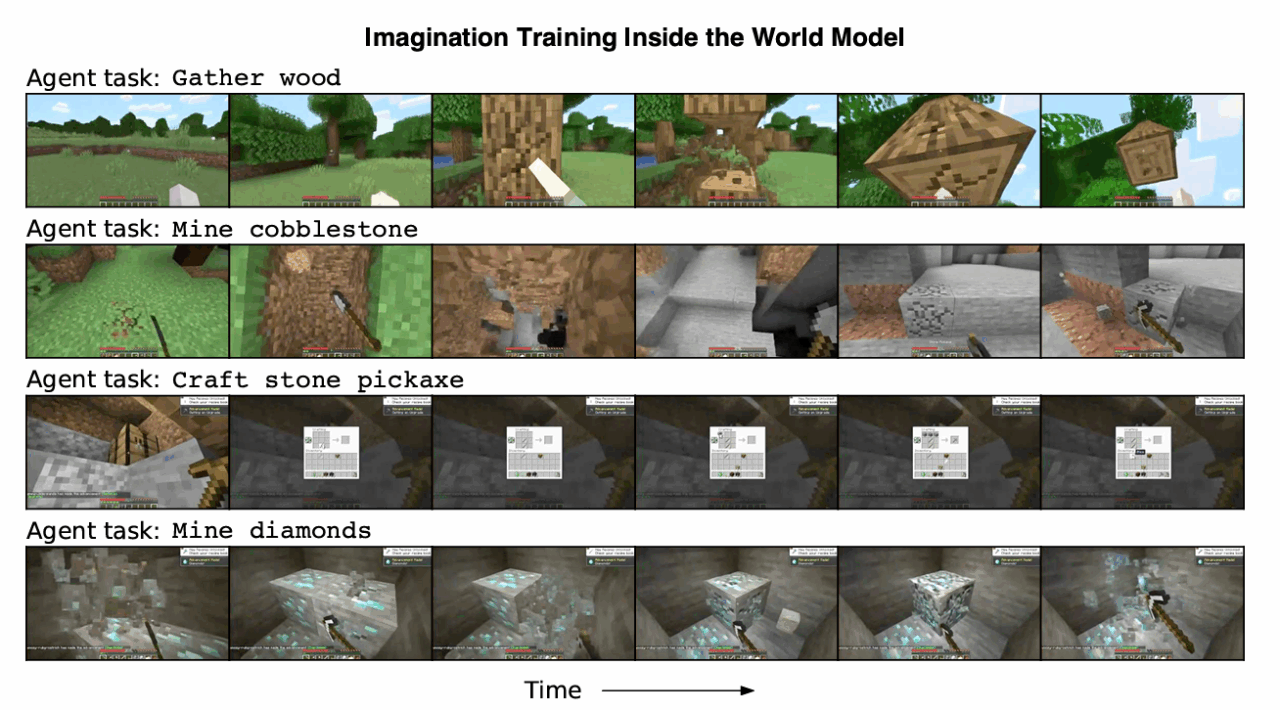

Nel documento si legge che Dreamer 4 simula in un modello interno, “immaginando” scenari alternativi, e utilizza quegli scenari simulati per addestrare una politica di azione (reinforcement learning interno).

Nel compito estremo del “diamond challenge” in Minecraft che richiede pianificazione su oltre 20.000 azioni da pixel raw Dreamer 4 è il primo agente che riesce a ottenere diamanti pur essendo stato addestrato esclusivamente da dati offline (video + combinazioni limitate di video + azioni).

I numeri:

Utilizza solo 2,5K ore (in totale) di video-gioco analoghi ai dataset usati da VPT di OpenAI, ma produce prestazioni superiori VPT invece aveva bisogno dell’ordine delle 270 K ore (o comunque un dataset molto più massiccio) per i risultati analoghi.

Converte 100 volte meno dati di azione-labeled rispetto a VPT per ottenere un’efficace policy. Funziona a circa 21 FPS su una singola GPU H100, permettendo “inferenza interattiva in real time” direttamente dal modello del mondo. E’ in grado di completare 14 su 16 attività testate (crafting, movimento, interazione, combattimento) all’interno del proprio modello simulato, battendo modelli precedenti come Lucid v1 e MineWorld.

Più in dettaglio: il segreto sta in due fasi chiare.

Prima, il modello di mondo apprende dalle sequenze video compresi video non etichettati con azioni una comprensione generica del mondo: come gli oggetti interagiscono, qual è la fisica implicita, la causalità visiva. Poi il policy learner (cioè la componente che sceglie le azioni) viene addestrato dentro quel modello (cioè “immaginando”) tramite RL su rollout simulati, non sul gioco reale.

Un meccanismo chiave introdotto è il shortcut forcing objective, che permette di generare con precisione fotogrammi simulati molto più velocemente, riducendo la necessità di passi intermedi di deduzione. Altri accorgimenti architetturali includono l’uso di transformer efficienti con attenzione spaziale/temporale, registri token e compressione latente causale con codice tokenizer che supporta decodifica frame-by-frame.

Perché tutto questo è rilevante per il futuro dell’IA? Perché Dreamer 4 sfida l’idea che serva un’enorme quantità di esplorazione online (cioè trial & error nel mondo reale o simulato costoso) per generare un agente competente. Se un modello del mondo affidabile può essere estratto da video “osservativi” + poche tracce azionabili, allora possiamo spostare il peso dell’apprendimento dall’interazione costosa al modelling predittivo. Ciò è cruciale per robotica, macchine autonome e domini dove sperimentare può essere pericoloso o proibitivo.

Vi sono però limiti evidenti: il tasso di successo di Dreamer 4 nel “diamond challenge” è ancora basso (ordine di pochi decimi di percentuale su molti run), l’inventario simulato può deragliare, la memoria a lungo termine è limitata, e alcune dinamiche complesse restano fuori portata del modello.

Alcune curiosità provocatorie: un essere umano che gioca dentro il modello simulato di Dreamer 4 riesce a completare 14/16 compiti, il che suggerisce che la simulazione è abbastanza realistica da non “frustrarci” nell’uso pratico.

La generalizzazione: il modello apprende condizionamento all’azione su un “dimensione” di Minecraft, ma quella conoscenza si trasferisce in dimensioni invisibili (Nether, End) con tassi di PSNR e SSIM elevati rispetto all’addestramento diretto.