C’è un momento preciso in cui la tecnologia smette di essere un semplice strumento e diventa un’estensione del nostro pensiero. Microsoft, con l’ultimo aggiornamento di Copilot Vision per Windows Insiders, ha appena varcato quella soglia. La narrazione ufficiale è elegante: un assistente intelligente che finalmente “vede” tutto ciò che c’è sullo schermo, non più limitato a due app contemporaneamente, ma capace di analizzare l’intero desktop o qualsiasi finestra di un browser o di un’app. La traduzione reale è meno poetica: stiamo iniziando a dare in pasto il nostro ambiente digitale completo a un’intelligenza artificiale che impara osservandoci. Sembra banale, ma non lo è affatto.

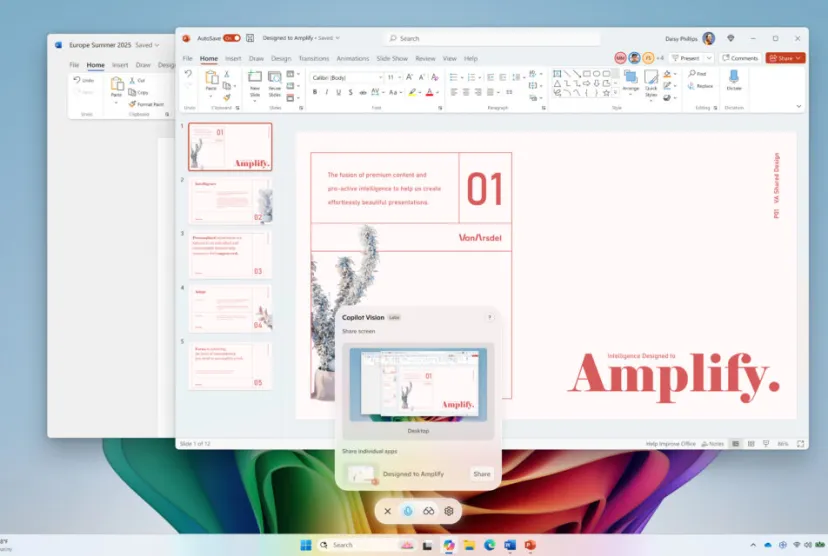

La differenza con il famigerato Recall è una sfumatura quasi psicologica. Recall fotografava automaticamente lo schermo a intervalli regolari, creando un archivio permanente di ricordi digitali, qualcosa che ha fatto tremare i polsi a chiunque abbia un minimo di consapevolezza su cosa significhi sicurezza dei dati. Copilot Vision, invece, è più “umano” nella sua invasività: si attiva manualmente, con un click sull’iconcina a forma di occhiali. Sembra quasi rassicurante, vero? Come se fosse uno screen sharing di una videochiamata, solo che dall’altra parte non c’è un collega annoiato, ma un motore di intelligenza artificiale pronto a sezionare ogni pixel del tuo schermo. “Aiutarti a migliorare il tuo progetto creativo, a ottimizzare il tuo curriculum, o a guidarti in un nuovo gioco”, promette Microsoft. E qui l’ironia è inevitabile: l’AI come life coach digitale, con la differenza che questo coach vede ogni tuo errore in tempo reale e lo ricorda meglio di te.

La vera forza, e insieme la vera minaccia, è la capacità di contestualizzare. La precedente versione di Copilot Vision era confinata a Edge e si limitava a collegare informazioni tra due app, un esperimento interessante ma ancora acerbo. Ora, invece, l’AI può “vedere” l’intero ecosistema, incrociare documenti, immagini, finestre di chat, fogli di calcolo e qualsiasi altro frammento di informazione che appare sul desktop. Per chi ragiona in termini di AI desktop analysis, questa è la svolta che mancava per trasformare il computer in un osservatore attivo, capace di correlazioni e deduzioni che noi umani non riusciamo a fare alla stessa velocità. Non è solo assistenza, è predizione: se Copilot Vision nota che stai scrivendo un’email con un tono eccessivamente aggressivo, potrebbe suggerirti un linguaggio più diplomatico; se stai modificando una foto, ti proporrà correzioni cromatiche in linea con i trend visuali del momento.

Non stiamo parlando di un semplice assistente vocale evoluto, ma di un analista costante che, con una freddezza da chirurgo, seziona il tuo comportamento digitale. Microsoft lo vende come un alleato creativo, ma l’effetto collaterale inevitabile è che ci abitueremo a lavorare sotto osservazione continua, accettando consigli “amichevoli” che progressivamente modelleranno il nostro stile di scrittura, di progettazione, di pensiero. Sembra un dettaglio, ma è un punto di non ritorno: chi ha il controllo del contesto visivo ha il controllo dell’interpretazione. E quando l’AI che interpreta è alimentata da un colosso come Microsoft, l’asimmetria di potere diventa gigantesca.

C’è anche un elemento curioso, quasi comico, che molti non colgono. Attivare Copilot Vision è un gesto volontario, certo, ma quanto a lungo rimarrà davvero così? Chi ha detto che la prossima versione non potrà suggerire, con il tono di un amico insistente, “Vuoi che ti aiuti meglio? Concedimi l’accesso all’intero desktop per qualche minuto in più”. È sempre la stessa dinamica di addestramento comportamentale che i social network hanno perfezionato negli ultimi dieci anni: prima ti offrono un vantaggio tangibile, poi ti fanno sentire inefficiente senza di loro. Alla fine, diventa naturale cliccare su quel maledetto simbolo degli occhiali.

Gli Windows Insiders lo sanno già: questa è solo la versione beta, l’inizio di un test su larga scala. Microsoft gioca una partita sottile, sperimentando la tolleranza psicologica degli utenti prima di spingere Copilot Vision nel mainstream. È la solita danza della gradualità: prima i nerd entusiasti, poi i professionisti curiosi, infine la massa, convinta che “se tutti lo usano, sarà sicuro”. È un copione già visto, eppure ci caschiamo sempre. Il vero colpo di genio è la narrazione orientata al miglioramento personale, il tocco da consulente motivazionale che rende quasi impossibile rifiutare.

Qualcuno potrebbe dire che siamo paranoici. Dopotutto, l’utente mantiene il controllo e può decidere cosa mostrare. Certo, ma è lo stesso tipo di controllo che abbiamo quando accettiamo i cookie su un sito: tecnicamente puoi rifiutarli, ma lo fai davvero? L’abitudine vince sempre sulla diffidenza. E quando la tecnologia funziona bene, l’abitudine si forma in fretta. Microsoft lo sa benissimo.

La verità, scomoda ma inevitabile, è che ci stiamo dirigendo verso un modello in cui l’AI non sarà più un semplice assistente, ma un osservatore costante che plasma la nostra interazione con il digitale. Copilot Vision è il primo vero passo verso un desktop che non solo reagisce, ma interpreta, valuta e, lentamente, condiziona. E il fatto che ci sembri comodo è la prova definitiva che siamo pronti a cedere pezzi della nostra autonomia in cambio di qualche consiglio brillante su come migliorare un curriculum. “Non preoccuparti, è solo un coach digitale”, ci diciamo sorridendo. Fino al giorno in cui non ci accorgeremo più di quando abbiamo iniziato a scrivere, pensare e persino decidere esattamente come lui ci suggerisce.