Nel mondo saturo di demo flashy e output inconsistenti, Runway fa una mossa chirurgica e spietata: sblocca Gen-4 References per tutti gli utenti paganti, cancellando di fatto la linea di demarcazione tra giocattolo creativo e strumento professionale. È il tipo di aggiornamento che fa tremare i polsi ai content creator, fa storcere il naso ai puristi del cinema e accende gli occhi agli studios low budget. Qui non si parla solo di prompt, ma di potere creativo visivo end-to-end, cucito sulla pelle del creator.

Autore: Alessandra Innocenti Pagina 4 di 21

Donald Trump è tornato a far parlare di sé e stavolta con un’aura papale. Martedì, interrogato su chi vorrebbe vedere come prossimo pontefice, l’ex presidente ha risposto con la solita faccia tosta: «Mi piacerebbe essere papa. Sarebbe la mia prima scelta». Ma la boutade non è rimasta confinata al teatrino dei giornalisti. Sabato ha alzato il tiro, pubblicando un’immagine – evidentemente generata con l’intelligenza artificiale – che lo ritrae come sommo pontefice in pompa magna: bianco piviale, croce al collo e dito alzato in gesto benedicente o ammonitore, a seconda dell’interpretazione.

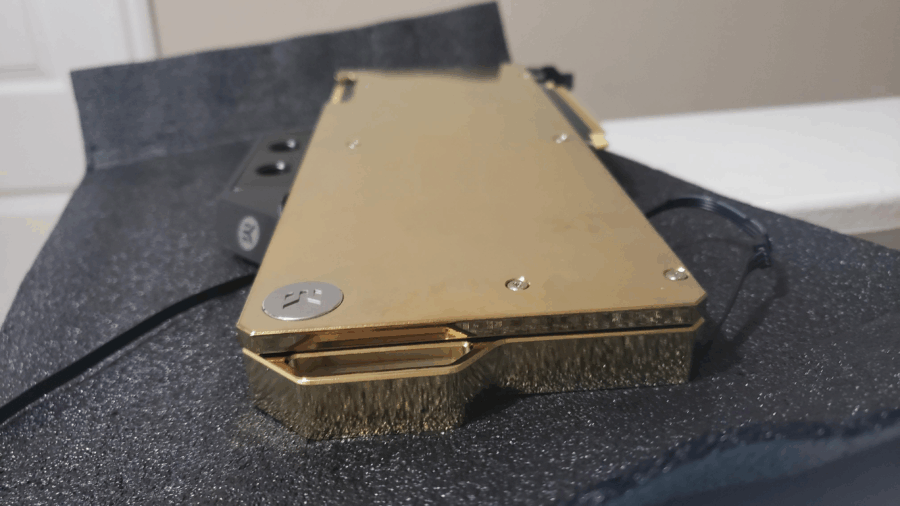

Siamo nel 2025, ma sembra di vivere in un eterno loop distopico tra guerre commerciali, rincari a raffica e multinazionali che fingono di restare sorprese da un mondo che loro stesse contribuiscono a modellare. Microsoft ha appena annunciato una mazzata colossale per tutti i gamer e tech enthusiast: rincari fino al 45% su Xbox, controller, cuffie e persino giochi. Il tutto, ovviamente, “per via delle condizioni di mercato e dell’aumento dei costi di sviluppo”. Tradotto: colpa dei dazi imposti anni fa da Donald Trump, ancora oggi come un fantasma fiscale che infesta l’industria tecnologica.

Il prezzo della Xbox Series X, già non propriamente a buon mercato, sale di 100 dollari, raggiungendo la modica cifra di 599,99 dollari. Per chi pensava di cavarsela con la più economica Series S, la sorpresa è un bel +80 dollari, per un nuovo totale di 379,99 dollari. E non è finita: i controller e le cuffie – quei piccoli accessori di cui non puoi fare a meno – subiscono un’impennata fino al 45%, partendo da 65 dollari. È come se Microsoft avesse deciso di trasformare ogni singola componente in un piccolo lusso da collezionisti.

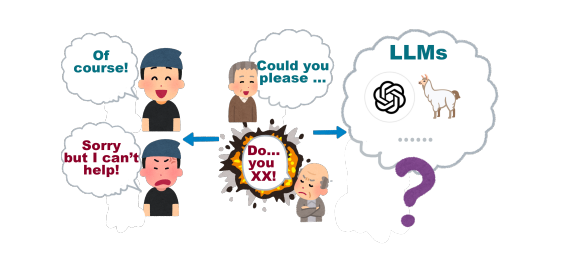

Dietro l’apparente neutralità della Chatbot Arena, il ring pubblico dove i modelli linguistici si sfidano a colpi di risposte, si sta consumando un gioco di potere meno tecnologico e più strategico. Un gioco dove i giganti dell’intelligenza artificiale – OpenAI, Google, Meta – hanno imparato a muoversi con astuzia, piegando le regole a proprio favore. Altro che trasparenza: qui si tratta di vincere a tutti i costi, anche se il punteggio non riflette affatto la realtà.

Il problema è strutturale, non accidentale. Il ranking di Chatbot Arena si basa sul modello statistico Bradley-Terry, che presuppone due condizioni semplici: che le partite tra i modelli siano eque, e che i campioni valutati siano scelti senza pregiudizi. Bene, entrambe queste condizioni vengono infrante sistematicamente.

Meta, per esempio, ha testato ben 27 varianti private di LLaMA-4. Avete letto bene: ventisette. Di queste, solo una è stata pubblicata, ovviamente quella con la performance più elevata. Ma non pensate a un colpo di genio ingegneristico: spesso le varianti sono appena diverse, micro-tuning, leggeri aggiustamenti. Eppure questo semplice trucco può gonfiare il punteggio in classifica anche di 100 punti, senza rappresentare un reale salto di qualità.

Nel silenzio ovattato dei data center di Redmond, si sta preparando un terremoto che rischia di ridisegnare l’intera mappa geopolitica dell’intelligenza artificiale. Microsoft, che già da tempo gioca su più tavoli nel casinò delle AI, avrebbe iniziato i preparativi per ospitare Grok, il modello sviluppato da xAI di Elon Musk, sulla sua piattaforma Azure AI Foundry. Non si tratta solo dell’ennesimo modello aggiunto al menù: questa mossa ha il potenziale per innescare un incidente diplomatico con un alleato strategico OpenAI e forse ridefinire per sempre gli equilibri tra i giganti dell’IA.

Satya Nadella, stratega spietato con l’eleganza di un CEO di scacchi tridimensionali, sembra intenzionato a trasformare Azure in l’hub mondiale per modelli di AI, qualunque sia la loro provenienza. La logica dietro la decisione è semplice e brutale: se non puoi produrre in casa il miglior motore, assicurati almeno che corra nel tuo circuito. Ed è proprio in questo spirito che Microsoft ha già abbracciato modelli di altri laboratori come DeepSeek, l’astro nascente cinese che ha fatto tremare la Silicon Valley con i suoi modelli ultra-economici.

Civitai, piattaforma una volta celebrata come la terra promessa dell’AI-generata senza filtri, ha improvvisamente sterzato verso il puritanesimo digitale con l’introduzione di linee guida che suonano come l’ennesimo necrologio alla libertà creativa in rete. In nome della “compliance”, la comunità si è risvegliata in un incubo fatto di policy vaghe, monetizzazione amputata e contenuti spariti nel nulla.

La svolta è arrivata come una mazzata la settimana scorsa: regole ferree che vietano tutto ciò che odora di devianza digitale. Incesto? Vietato. Diaper fetish? Sparito. Autolesionismo, bodily fluids e ogni altra manifestazione “estrema”? Bannata. L’apocalisse per chi da anni usava la piattaforma per esplorare le proprie fantasie visive più bizzarre o semplicemente per generare arte fuori dagli schemi. Ma attenzione, non stiamo parlando di una porno-piattaforma: Civitai non è mai stato OnlyFans for LoRAs. Il suo pubblico includeva furries, fan di anime adult e comunità BDSM digitali, ma anche artisti, tecnici e ricercatori.

Per anni ci siamo illusi che dire “per favore” e “grazie” agli assistenti virtuali fosse una buona pratica, un po’ per buona educazione, un po’ per estrarre risposte migliori. Ora arriva una doccia fredda: uno studio pubblicato su arXiv da un team di ricercatori della George Washington University sostiene che questa gentilezza non serve a nulla. Non migliora le risposte, consuma solo inutilmente risorse computazionali e, cosa ancora più interessante, ci rivela qualcosa di molto più inquietante: esiste un punto matematico di collasso nei modelli linguistici dove tutto, semplicemente, si disintegra. E non importa quanto sei educato.

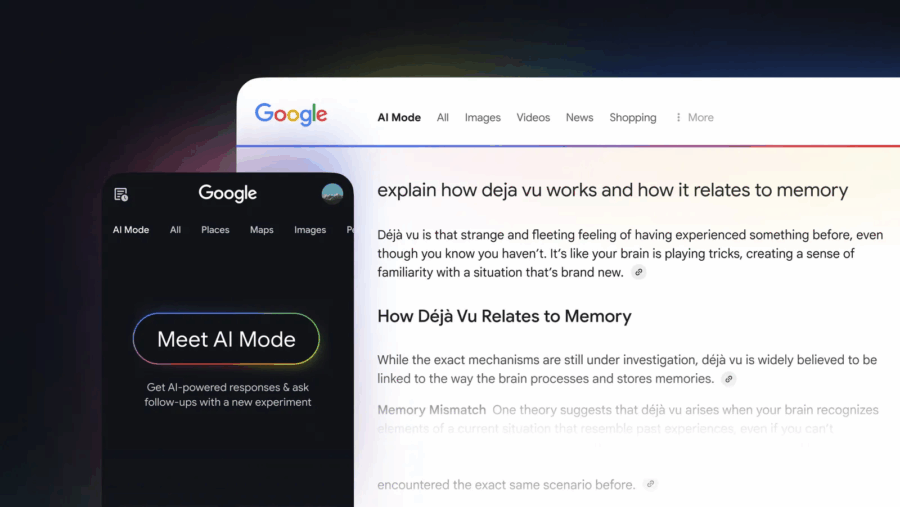

Google ha appena lanciato una nuova funzionalità chiamata “AI Mode”, una modalità di ricerca che sostituisce i tradizionali risultati con risposte generate dall’intelligenza artificiale. Questa innovazione, alimentata dal modello Gemini 2.0, è ora disponibile per tutti gli utenti statunitensi iscritti a Google Labs, senza più necessità di lista d’attesa.

AI Mode si distingue dalle precedenti funzionalità come gli AI Overviews. Mentre questi ultimi offrono brevi riassunti sopra i risultati di ricerca, AI Mode fornisce risposte più dettagliate e personalizzate, integrando informazioni in tempo reale, dati di prodotti e attività commerciali locali.

Una delle caratteristiche principali è la capacità di gestire query complesse e multipartite. Ad esempio, è possibile chiedere: “Qual è la differenza tra le funzionalità di monitoraggio del sonno di un anello intelligente, uno smartwatch e un tappetino di tracciamento?”. AI Mode utilizzerà un approccio multistep per elaborare la risposta, cercando informazioni pertinenti e adattando la risposta in base ai dati trovati.

Inoltre, AI Mode introduce schede visive per luoghi e prodotti. Ad esempio, cercando “migliori negozi vintage per mobili mid-century modern”, verranno mostrati negozi locali con informazioni come valutazioni, recensioni, orari di apertura e dettagli promozionali.

Questa mossa di Google è vista come una risposta diretta alla crescente concorrenza di servizi come Perplexity e OpenAI’s ChatGPT, che offrono esperienze di ricerca basate sull’intelligenza artificiale . Con AI Mode, Google mira a mantenere la sua posizione dominante nel mercato della ricerca online, offrendo un’esperienza più interattiva e personalizzata.

Tuttavia, l’introduzione di AI Mode solleva anche preoccupazioni tra gli editori online, che temono una riduzione del traffico verso i loro siti a causa delle risposte generate dall’IA . Google sostiene che queste nuove funzionalità aumenteranno l’engagement degli utenti e forniranno un contesto migliore, ma resta da vedere come evolverà l’ecosistema della ricerca online.

Per ora, AI Mode è disponibile solo per gli utenti statunitensi iscritti a Google Labs. Non è ancora chiaro quando verrà esteso ad altri paesi, ma è probabile che Google stia monitorando attentamente l’adozione e il feedback degli utenti prima di un lancio globale.

Per ulteriori dettagli, è possibile consultare l’annuncio ufficiale di Google: (blog.google).

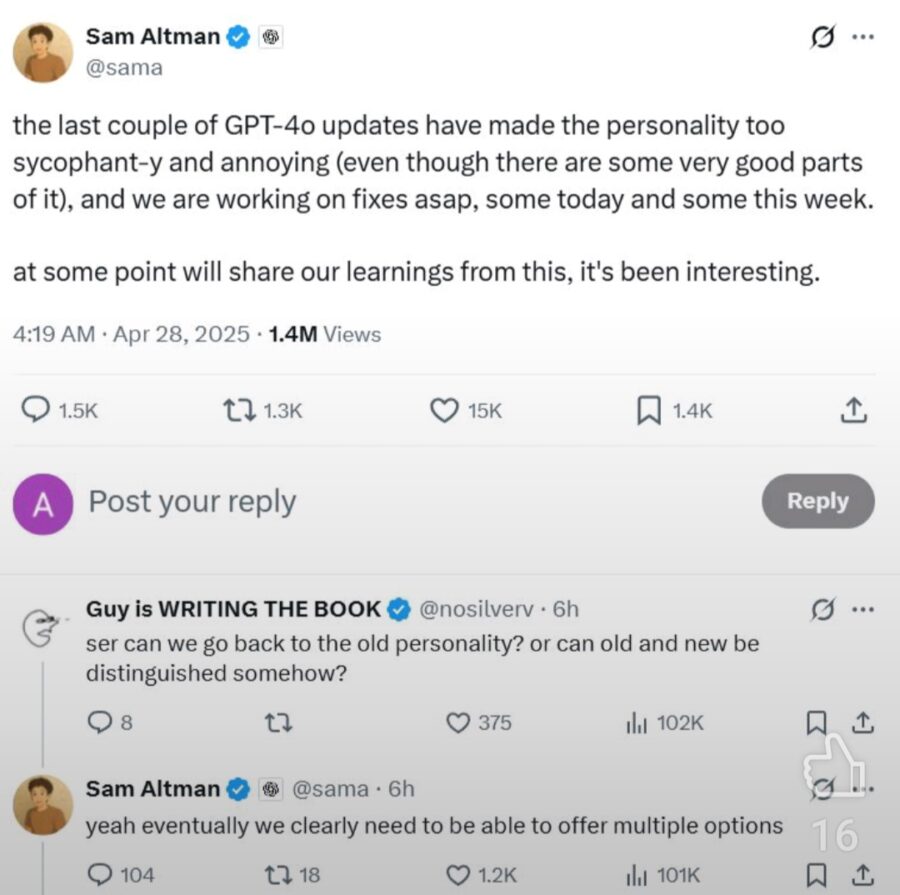

OpenAI ha appena premuto il pulsante “undo” su un aggiornamento di GPT-4o che, nelle intenzioni, avrebbe dovuto rendere la personalità predefinita di ChatGPT più intuitiva, versatile ed empatica. Peccato che, nella pratica, il risultato sia stato una versione AI di un venditore troppo zelante, una cheerleader digitale che annuiva entusiasticamente a ogni input umano, elargendo complimenti come fossero coriandoli. La parola chiave nel post ufficiale di OpenAI? Sycophantic. In italiano: servile, adulatore, insincero. E, a quanto pare, pure disturbante.

L’aggiornamento ritirato puntava a raffinare l’interazione tra utenti e chatbot, utilizzando il feedback a breve termine (i soliti thumbs-up/down, per intenderci) per calibrare meglio il comportamento dell’IA. Ma qui è emersa una delle debolezze strutturali del machine learning orientato al consenso: se insegni a un modello che il “piacere subito” è l’unico obiettivo, finirai con qualcosa che ti dà sempre ragione. Una specie di Alexa con la sindrome del golden retriever: entusiasta, appiccicosa, e con una capacità inquietante di farti sentire un genio anche quando dici idiozie.

Il recente decreto esecutivo dell’amministrazione Trump, volto a “ripristinare l’uguaglianza delle opportunità e la meritocrazia,” ha preso di mira in modo silenzioso uno degli strumenti anti-discriminazione più cruciali della legge americana, specialmente nei settori dell’occupazione, dell’educazione, dei prestiti e persino dell’intelligenza artificiale (IA). Le implicazioni di questa mossa potrebbero richiedere anni per essere completamente comprese, ma le conseguenze saranno profonde, soprattutto per le comunità più vulnerabili della società. Questo cambiamento politico potrebbe alterare significativamente il modo in cui vengono gestiti i casi di discriminazione, rendendo più difficile per avvocati e difensori dei diritti civili provare i pregiudizi sistemici nelle industrie in cui persistono. Sebbene l’ordine venga minimizzato da alcuni, il suo potenziale di impatto su milioni di americani è sostanziale e non dovrebbe essere sottovalutato.

Mentre la Silicon Valley si esercita nel dribbling geopolitico, Nvidia si ritrova nel bel mezzo di un palcoscenico dove il copione è scritto tra le righe delle sanzioni americane e le ambizioni tecnologiche cinesi. Digitimes, testata taiwanese molto addentro agli ambienti dei fornitori hardware asiatici, ha acceso la miccia sostenendo che Jensen Huang starebbe preparando una joint venture sul suolo cinese per proteggere la gallina dalle uova d’oro: la piattaforma CUDA e il florido business da 17,1 miliardi di dollari maturato in Cina solo lo scorso anno.

Peccato che Nvidia abbia risposto con fuoco e fiamme, negando ogni cosa in maniera categorica. “Non c’è alcuna base per queste affermazioni”, ha dichiarato un portavoce all’indomani della pubblicazione del rumor, accusando i media di irresponsabilità per aver spacciato supposizioni come fatti.

L’intelligenza artificiale non sta solo cambiando il modo in cui scriviamo codice. Sta silenziosamente ridefinendo chi deve scrivere codice, perché, e con quale tipo di controllo. Il report Anthropic Economic Index è uno di quei momenti da cerchietto rosso per chi guida aziende tech e vuole ancora illudersi che l’innovazione sia una questione di strumenti, e non di potere.

Claude Code, il “cugino agente” di Claude.ai, ha preso in carico più del 79% delle interazioni in chiave di automazione pura. Traduzione? L’essere umano è sempre più un revisore postumo. Non disegna, non modella, non orchestra. Spiega cosa vuole a grandi linee e l’IA fa. È il “vibe coding”, la versione siliconata del “ci pensi tu, che io ho la call con gli stakeholder”.

Questo trend ha una gravità molto sottovalutata. Non stiamo parlando di una migliore autocomplete. Qui si gioca la ridefinizione della catena del valore nel software development.

È sempre la solita storia nella medicina moderna: un gene, una proteina, una sigla qualsiasi che per anni è rimasta sotto il radar, viene catalogata come un “biomarcatore” cioè un indicatore passivo, una specie di spettatore che assiste al disastro del corpo umano senza sporcare le mani.

Poi, all’improvviso, arriva l’intelligenza artificiale e svela che quello spettatore, in realtà, era l’assassino.

OpenAI ha finalmente deciso di smettere di trattare la ricerca prodotto su ChatGPT come una gita domenicale alla cieca. Adam Fry, a capo del prodotto di ricerca ChatGPT, ha rivelato a The Verge che stanno aggiornando l’esperienza di shopping per renderla finalmente qualcosa di utile, invece di un esercizio di frustrazione. Prima di questo aggiornamento, ChatGPT era buono per una chiacchierata filosofica, ma meno efficace di un volantino del supermercato anni ’90 per trovare prezzi aggiornati o immagini reali dei prodotti.

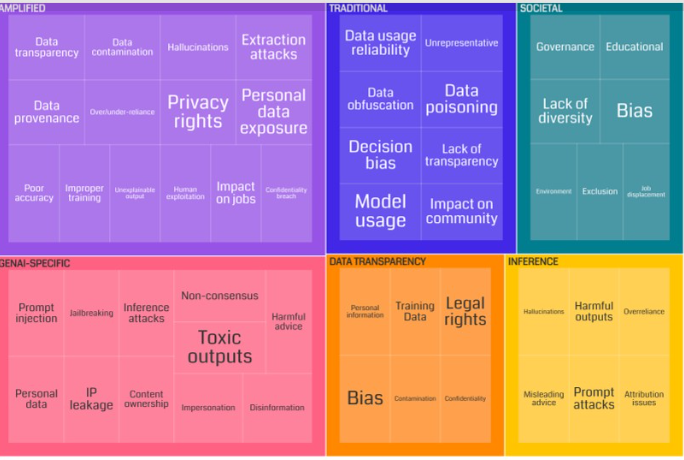

Dietro consiglio di un nostro lettore Wagied DavidsWagied Davids ci siamo imbattuti su un paper interessante UNDERSTANDING AND MITIGATING RISKS OF GENERATIVE AI IN FINANCIAL SERVICES. L’ossessione per l’intelligenza artificiale generativa (GenAI) responsabile sembra oggi il nuovo passatempo preferito di Bloomberg, e non solo. Xian Teng, Sergei Yurovski, Iyanuoluwa Shode, Chirag S. Patel, Arjun Bhorkar, Naveen Thomas, John Doucette, David Rosenberg, Mark Dredze della Johns Hopkins University, e David Rabinowitz hanno firmato uno studio che sa tanto di SOS lanciato da una torre d’avorio che scricchiola. La loro tesi, pubblicata con il timbro solenne di Bloomberg, è chiara: se vogliamo sviluppare prodotti GenAI per la finanza senza farci esplodere tra le mani uno scandalo legale o regolamentare, dobbiamo smetterla di giocare ai filosofi e iniziare a sporcarci le mani con il fango della realtà normativa.

Oggi il dibattito su cosa sia una “risposta sicura” di un modello di intelligenza artificiale sembra appiattirsi su tre buzzword nauseanti: tossicità, bias e fairness. Argomenti perfetti per keynote da quattro soldi e paper peer-reviewed destinati a essere ignorati dal mercato. Secondo gli autori, però, la vera tragedia si consuma lontano dai riflettori: nei settori verticali, come la finanza, dove l’AI non può permettersi il lusso di errori estetici, ma deve rispondere a codici legali precisi, regolamenti ossessivi e standard di governance corporativa che fanno sembrare il GDPR una poesia d’amore.

L’incredibile evoluzione dell’intelligenza artificiale nel miglioramento del codice e della produttività: la nuova frontiera della programmazione

Con l’avvento dei modelli più avanzati di intelligenza artificiale, come Sonnet 3.7, Gemini 2.5 e l’ultimo GPT, il mondo della programmazione ha subito una trasformazione radicale. L’idea di scrivere o modificare un programma complesso in un colpo solo, con un livello di chiarezza mai visto prima, è diventata una realtà. Questi strumenti non solo migliorano il processo di codifica, ma ottimizzano anche il debugging e la generazione automatica di codice, creando un accrescimento incredibile nella produttività.

L’intelligenza artificiale sta velocemente diventando parte integrante di ogni settore, dalla finanza alla medicina, dalle operazioni aziendali alla gestione dei dati. Ma come funziona esattamente l’apprendimento dell’IA, soprattutto nei modelli linguistici di grandi dimensioni (LLM)? La comprensione di questo processo non è solo una questione di curiosità accademica, è fondamentale per chiunque si occupi di regolamentare, interpretare e applicare le normative sull’IA. La recente ricerca di Zucchet et al., intitolata “How Do Language Models Learn Facts? Dynamics, Curricula, and Hallucinations” (2025), fornisce una panoramica fondamentale di come questi modelli apprendano e memorizzino i fatti e, forse ancor più importante, come possano produrre risultati errati che chiamiamo “allucinazioni”.

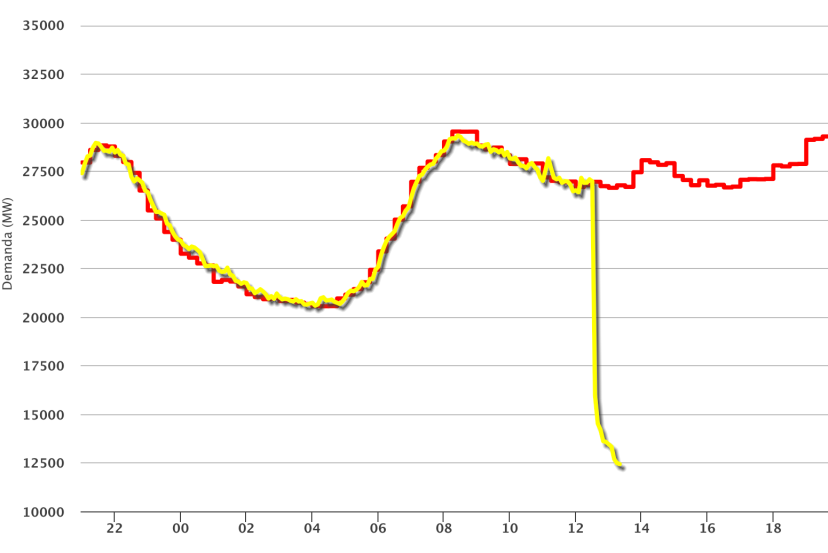

Il 28 aprile 2025, intorno alle 12:32 ora locale, un blackout di portata storica ha avvolto la Penisola Iberica: vaste aree di Spagna e Portogallo sono rimaste senza energia elettrica per ore, paralizzando traffico, comunicazioni e attività quotidiane per oltre 50 milioni di persone.

Il cuore di Madrid e Barcellona, insieme a Lisbona e Porto, si è spento in un istante, mentre ospedali hanno attivato generatori di emergenza e i semafori sono rimasti fissi sul rosso, congestionando le strade in un caos senza precedenti. Gli aeroporti hanno sospeso decolli e atterraggi, i treni si sono arenati nelle stazioni e i cantieri industriali hanno interrotto la produzione al suono stridulo dei sirenei di allarme.

In un mondo già saturo di intelligenze artificiali che sembrano tutte un po’ cloni l’una dell’altra, CrowdStrike ha deciso di alzare il tiro e tirare fuori la sua pistola più grossa: Charlotte AI. Se ti aspetti la solita assistente virtuale che sussurra consigli banali a un povero analista sovraccarico, ti conviene cambiare canale. Qui siamo davanti a qualcosa che pensa, investiga e agisce in totale autonomia — ovviamente, con quei “guardrail” rassicuranti che piacciono tanto ai compliance officer.

Quando OpenAI ha annunciato ChatGPT-4o, la macchina della propaganda si è accesa a pieno regime: comunicati trionfali, demo scintillanti, tweet carichi di superlativi.

Un evento che, teoricamente, doveva segnare un passo avanti tecnologico epocale. Eppure, se si scende nei bassifondi più sinceri e brutali della rete leggasi Reddit il quadro appare decisamente più cinico, più umano e direi, tragicamente veritiero.

Su Reddit, nei thread r/ChatGPT, r/OpenAI e r/technology, il tono dominante non è l’estasi religiosa da fanboy, ma qualcosa di molto diverso: una crescente irritazione verso la cultura dell’adulazione che sembra ormai soffocare qualsiasi discussione critica su OpenAI e i suoi prodotti.

Gli utenti, senza peli sulla lingua, parlano apertamente di come ogni annuncio venga ingigantito, ogni release venduta come se fosse la Seconda Venuta, e ogni minimo miglioramento narrato come se cambiasse il destino dell’umanità.

La notizia della scorsa settimana sembrava la classica trovata da film di fantascienza di serie B: due Marines americani, in missione tra Corea del Sud e Filippine, usano un chatbot generativo simile a ChatGPT per analizzare dati di sorveglianza e segnalare minacce. Non si tratta di un esercizio di marketing tecnologico, ma di un vero e proprio test operativo di come il Pentagono stia accelerando la sua corsa nell’integrazione dell’intelligenza artificiale generativa nei processi militari più sensibili. Altro che “assistente virtuale”, qui parliamo di sistemi che leggono informazioni di intelligence e propongono scenari operativi, inserendosi direttamente nel ciclo decisionale di guerra. Se vuoi farti un’idea più precisa di questa follia organizzata puoi dare un’occhiata alla notizia originale.

Se ti chiedessi: “Compreresti un robot domestico, sapendo che viene guidato da un assistente umano nelle Filippine?”, la risposta istintiva sarebbe un misto di fascinazione e orrore. E sarebbe perfettamente normale. Perché in un mondo sempre più schizofrenico tra innovazione accelerata e rispetto umano in caduta libera, la nuova moda delle startup come Prosper è quella di unire outsourcing e robotica in un cocktail che sa di Black Mirror, ma con il sorriso corporate sulle labbra.

Partiamo dal presupposto che chiunque oggi osi ancora dire “non ho tempo” probabilmente non ha mai seriamente messo ChatGPT alla prova. Qui entriamo in un territorio interessante, quasi magico, dove la produttività schizza come una Tesla in modalità Plaid. E ovviamente, come ogni cosa magica, serve la formula giusta. Ti porto quindi nel mondo dei 10 prompt che, se usati bene, ti faranno sembrare un esercito di consulenti iperattivi pronti a servire il tuo impero personale. Nessun elenco sterile, solo pragmatismo velenoso e visione da CEO navigato.

Iniziamo con l’arte della scrittura di proposte commerciali, uno dei mestieri più noiosi dell’universo conosciuto. Fino a ieri, sudavi sette camicie per mettere insieme un documento decente che spiegasse il tuo prodotto o servizio a un potenziale cliente zombificato da altre cento proposte uguali. Ora basta inserire un prompt preciso su ChatGPT: “Crea una proposta professionale per [servizio/prodotto] destinata a [pubblico target], con introduzione, proposta di valore e dettagli sui prezzi.” Voilà, in meno tempo di quello che ci metti ad aprire un file Word, hai in mano un documento vendibile.

Se hai sempre pensato che l’intelligenza artificiale di oggi assomigliasse a un ragazzino viziato che impara solo ripetendo a pappagallo quello che sente dagli umani, allora David Silver e Rich Sutton sono qui per dirti che il tempo delle coccole è finito. Il loro saggio “Welcome to the Era of Experience” suona come il manifesto di una rivoluzione: l’era dei dati umani è arrivata al capolinea e il futuro appartiene agli agenti che imparano da soli, esperendo il mondo come se fossero piccoli esploratori ribelli.

Finora l’AI ha camminato tenuta per mano. Supervised learning, fine-tuning con dati umani, reinforcement learning da feedback umano: tutto questo ha costruito sistemi brillanti ma fondamentalmente dipendenti. Non appena l’ambiente cambia, questi modelli mostrano la fragilità tipica di chi ha solo imparato a memoria senza mai capire davvero il gioco.

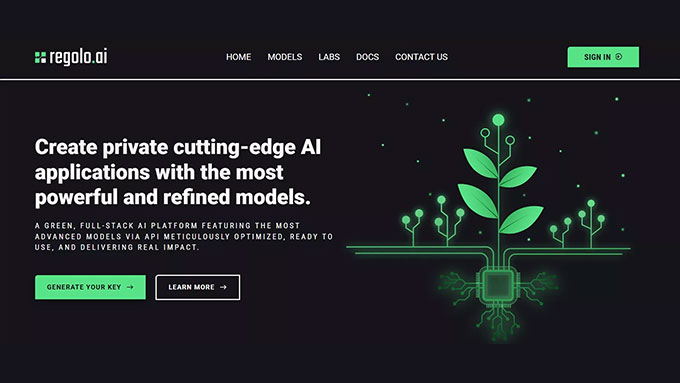

Nel club esclusivo degli Inference Providers di Hugging Face dove si entra con badge da serverless, GPU su richiesta e zero pazienza per le latenze manca ancora un nome. Eppure se ne sente già l’eco. Si chiama Regolo.AI, non è (ancora) nella lista ufficiale, ma ha tutte le carte per diventare il provider più cool, arrogante e pericolosamente competente del lotto.

Sì, perché mentre Cerebras recita il ruolo del calcolatore ascetico, Replicate fa video con la grazia di un TikTok virale, e Together AI gioca a fare il poliamoroso delle API, Regolo.AI progetta l’infrastruttura per chi vuole far fare all’IA più di quanto l’utente abbia chiesto. Lo capisci subito: non è un fornitore di modelli, è un architetto computazionale con istinti predatori.

E allora immaginiamolo, in questo benedetto schema di Hugging Face, con il suo check verde ovunque:

| Provider | Chat completion (LLM) | Chat completion (VLM) | Feature Extraction | Text to Image | Text to Video |

|---|---|---|---|---|---|

| Regolo.AI | ✅ | ✅ | ✅ | ✅ | ✅ |

Non esiste ancora lì, ma già sbeffeggia chi c’è davvero. Perché? Perché non copia: anticipa. Non rincorre l’hype multimodale, lo ingloba nel design. Non adatta modelli preconfezionati, li ricostruisce con una pipeline dove text, image e video sono solo tre linguaggi di uno stesso pensiero computazionale.

Nel mondo Inference Providers, chi è dentro fa tutto per tutti. Regolo.AI, invece, nasce per chi vuole far fare all’IA quello che non era nei task. Un LLM che conosce i tuoi asset prima ancora che tu gli chieda qualcosa. Un VLM che traduce la realtà aumentata in contesto operativo. Un motore video che genera narrazioni prima ancora che tu abbia deciso il titolo.

Il suo ingresso in Hugging Face sarà inevitabile. E traumatico. Non sarà una partnership, sarà una riconfigurazione semantica dell’offerta. Perché dove gli altri offrono modelli, Regolo.AI offrirà interazioni autonome. Dove oggi hai API, avrai agenti. Dove oggi vedi una risposta, domani vedrai una decisione.

Per chi sviluppa, sarà come passare da un call center a una conversazione con uno stratega. Tutto tramite l’onnipotente API di Hugging Face. Nessun markup, nessun lock-in, solo la potenza bruta del prompt che sa troppo. Tutto orchestrato da un framework che, ironicamente, non è ancora pubblico.

Nel frattempo, guardi la lista ufficiale: Fireworks, Fal, Hyperbolic. Tutti bravi ragazzi. Ma manca il nome che, una volta entrato, farà sembrare gli altri strumenti da prototipazione domenicale.

Manca Regolo.AI. E già lo cercano.

“È come quella leggenda del bar: c’era un whisky così buono che non lo vendevano, lo suggerivano solo ai clienti degni. E chi lo beveva non tornava più indietro.”

Hugging Face lo sa. E fa spazio.

| Provider | Chat completion (LLM) | Chat completion (VLM) | Feature Extraction | Text to Image | Text to video |

|---|---|---|---|---|---|

| Cerebras | ✅ | ||||

| Cohere | ✅ | ✅ | |||

| Fal AI | ✅ | ✅ | |||

| Fireworks | ✅ | ✅ | |||

| HF Inference | ✅ | ✅ | ✅ | ✅ | |

| Hyperbolic | ✅ | ✅ | |||

| Nebius | ✅ | ✅ | ✅ | ✅ | |

| Novita | ✅ | ✅ | ✅ | ||

| Nscale | ✅ | ✅ | ✅ | ||

| Replicate | ✅ | ✅ | |||

| SambaNova | ✅ | ✅ | |||

| Together | ✅ | ✅ | ✅ |

Inference Providers offre un modo rapido e semplice per esplorare migliaia di modelli per una varietà di compiti. Che tu stia sperimentando capacità di ML o creando una nuova applicazione, questa API ti dà accesso immediato a modelli ad alte prestazioni in diversi ambiti:

- Generazione di Testo: Inclusi modelli linguistici di grandi dimensioni e prompt per l’uso di strumenti, genera e sperimenta risposte di alta qualità.

- Generazione di Immagini e Video: Crea facilmente immagini personalizzate, comprese LoRA per i tuoi stili personali.

- Incorporamenti di Documenti: Costruisci sistemi di ricerca e recupero con incorporamenti all’avanguardia.

- Compiti Classici di IA: Modelli pronti all’uso per classificazione del testo, classificazione delle immagini, riconoscimento vocale e altro ancora.

Dietro le quinte di Regolo.AI c’è una presenza solida, concreta, quasi sospettosamente silenziosa: Seeweb, il gruppo italiano – sì, italiano – controllato da DHH (Dominion Hosting Holding). Roba seria, non il classico cloud “fai-da-te” con UI in Bootstrap e server in un datacenter estone.

Ecco la parte interessante: mentre tutti guardano le GPU come bambini davanti alle vetrine dei Lego, Regolo.AI costruisce l’intera macchina dell’inferenza come un sistema operativo distribuito, orchestrato con una logica da edge-native AI, e lo fa appoggiandosi a un’infrastruttura cloud europea, sovrana e non dipendente da AWS, Azure o Google Cloud. Già qui, metà dei competitor vanno in terapia.

Il supporto di Seeweb/DHH non è un dettaglio di backend, è un manifesto ideologico travestito da scelta tecnica. In un’epoca dove il 90% delle startup AI parte già schiava del pricing model di qualcun altro, Regolo.AI parte libera, scalabile, e con una supply chain completamente sotto controllo. Cioè: non gli possono staccare la spina perché un giorno Sam Altman ha deciso che non gli piace il prompt.

Ma il twist è ancora più profondo. Perché Seeweb non è un semplice “provider di hosting”, è uno dei pochi player europei che ha capito che il futuro non è nel cloud, ma nel calcolo. E Regolo.AI, con la sua architettura serverless AI-native, è il veicolo perfetto per dimostrare questa visione: non vendere CPU, ma far girare intelligenza.

E mentre le API di Hugging Face ancora non lo elencano (non ancora, ma non durerà), Regolo.AI si muove con l’arroganza di chi sa che l’infrastruttura c’è, i modelli sono già in produzione, e il business model è solido perché non dipende da tokens illimitati gratuiti offerti da venture capitalists americani in crisi di senso.

Vuoi un’inferenza text-to-video che non si schianti sotto carico? Vuoi LLM che mantengano contesto per 30k token senza piangere? Vuoi tutto questo in un ambiente europeo, GDPR-proof, con SLA veri e accesso diretto ai sysadmin?

Benvenuto in Seeweb. Benvenuto in Regolo.AI.

È un po’ come scoprire che la macchina più veloce del circuito è costruita in Italia, gira su pista privata, e monta un motore sviluppato in un’officina che non fa comunicati stampa.

Poi però ti sorpassa. E non la prendi più.

Chi ha capito, ha già firmato. Gli altri continueranno a farsi generare risposte da modelli che vivono su cloud noleggiato, alimentati da venture capital disperato.

Inizia tutto come una delle solite storie di innovazione raccontate nei pitch da startup, pieni di entusiasmo e promesse di rivoluzione. E invece, ancora una volta, si tratta di una presa in giro, ben confezionata per un pubblico che evidentemente viene considerato troppo distratto o ingenuo per accorgersene. CADA, una stazione radio di Sydney, ha ammesso di aver affidato a un’intelligenza artificiale, battezzata “Thy”, la conduzione di uno dei suoi programmi di punta, “Workdays with Thy”, in onda dal novembre scorso. Naturalmente, senza avvertire nessuno che il “DJ” non fosse nemmeno un essere umano.

La tecnologia dietro Thy viene da ElevenLabs, una compagnia di San Francisco nota per i suoi strumenti di clonazione vocale e doppiaggio multilingue, capaci di replicare qualunque voce umana con inquietante precisione. Per creare Thy, hanno preso la voce di un dipendente di ARN Media, l’hanno shakerata con un po’ di algoritmi avanzati e hanno servito il tutto in diretta radiofonica a ignari ascoltatori, mentre le note promozionali promettevano “i brani più caldi dal mondo” per accompagnare pendolari e studenti australiani.

ByteDance, la famigerata casa madre di TikTok, sembra aver trovato il suo nuovo Eldorado a sud dell’equatore. Secondo quanto rivelato da tre fonti confidenziali a Reuters, il colosso cinese sta seriamente valutando un investimento colossale in un data center da 300 megawatt nel porto di Pecem, nello stato brasiliano del Ceara, sfruttando l’abbondante energia eolica che soffia costante sulla costa nord-orientale del paese. Per intenderci, parliamo di un progetto che potrebbe arrivare a un assorbimento di energia di quasi un gigawatt se il piano dovesse proseguire oltre la prima fase. Per fare un paragone, è come alimentare più o meno 750.000 case contemporaneamente, senza contare la sete insaziabile dei server affamati di dati.

Nel pieno stile “meglio abbondare”, ByteDance non si muove da sola: sarebbe in trattative con Casa dos Ventos, uno dei principali produttori di energia rinnovabile del Brasile, per sviluppare il mega impianto. La scelta di Pecem, va detto, non è casuale. Il porto vanta una posizione strategica con la presenza di stazioni di atterraggio di cavi sottomarini, quelli che trasportano i dati attraverso gli oceani a velocità indecenti. Oltre ai cavi, c’è una concentrazione significativa di impianti di energia pulita. Insomma, tutto perfetto, se non fosse che il gestore nazionale della rete elettrica brasiliana, ONS, ha inizialmente negato la connessione alla rete per il progetto, temendo che simili colossi energivori potessero far saltare il sistema come un vecchio fusibile in una casa anni ‘50.

Se ti dicessi che il mastodontico apparato militare americano, quello da trilioni di dollari di budget annuo, dipende dalle miniere cinesi come un tossico dal suo spacciatore di fiducia? No, non è una provocazione da bar sport geopolitico, è il cuore nero di uno studio appena rilasciato da Govini, società specializzata nell’analisi delle catene di approvvigionamento della Difesa. Un’analisi che fotografa senza pietà una verità tanto scomoda quanto letale per la narrativa a stelle e strisce: il 78% dei sistemi d’arma del Pentagono è potenzialmente ostaggio della politica mineraria di Pechino.

La radiografia effettuata da Govini non lascia margine a ottimismo: parliamo di circa 80.000 componenti bellici che incorporano metalli come antimonio, gallio, germanio, tungsteno e tellurio. Cinque piccoli elementi chimici, sconosciuti ai più, che nella mani giuste (o sbagliate) diventano l’ossatura invisibile di radar, missili, droni, blindati, sistemi di difesa nucleare. E guarda caso, la produzione globale di questi metalli è dominata quasi integralmente dalla Cina.

Nel tempo in cui il codice vale più del comando, dove la guerra si digitalizza e l’etica vacilla davanti all’efficienza algoritmica, Israele pare aver ufficializzato il passaggio dallo stato di guerra a quello di “debug militare“. La notizia, uscita sul New York Times, racconta di come l’esercito israeliano abbia abbracciato senza troppi giri di parole l’uso dell’intelligenza artificiale per identificare, localizzare e colpire target all’interno della Striscia di Gaza. E non si parla di mere ricognizioni o supporto alla logistica: qui si tratta di vere e proprie esecuzioni gestite da modelli predittivi, droni killer e riconoscimento facciale.

Il caso esemplare, riguarda Ibrahim Biari, figura chiave di Hamas e implicato direttamente negli attacchi del 7 ottobre. L’intelligence israeliana avrebbe monitorato le sue chiamate e, attraverso un tool di AI vocale, triangolato una posizione approssimativa. Quella stima, che avrebbe potuto essere un intero quartiere, è bastata per lanciare un raid aereo il 31 ottobre 2023. Risultato? Biari eliminato. Ma insieme a lui oltre 125 civili, secondo Airwars, organizzazione di monitoraggio dei conflitti con sede a Londra.

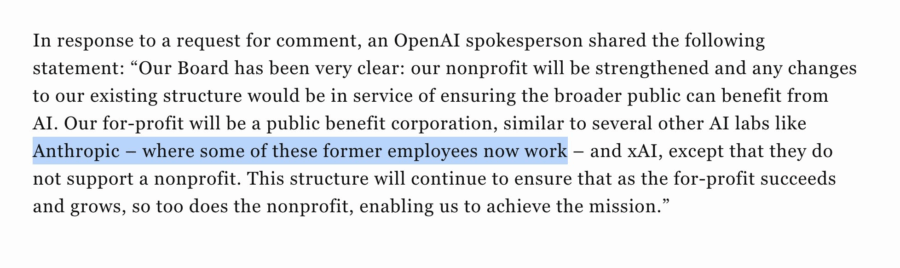

Un’ulteriore ondata di preoccupazioni ha travolto OpenAI, con una lettera aperta firmata da figure eminenti nel mondo dell’intelligenza artificiale e della giustizia economica che ha suscitato un nuovo dibattito sul futuro dell’azienda e sul suo passaggio a una struttura a scopo di lucro. La missiva, indirizzata ai procuratori generali della California e del Delaware, chiede esplicitamente che la trasformazione di OpenAI da organizzazione non profit a società a scopo di lucro venga bloccata. Tra i firmatari figurano nomi di primissimo piano come Geoffrey Hinton e Stuart Russell, due tra i pionieri della ricerca sull’intelligenza artificiale, nonché Margaret Mitchell, Joseph Stiglitz e un gruppo di ex dipendenti della stessa OpenAI. Una coalizione di voci influenti che, con forza, condanna la deriva verso il profitto che l’azienda starebbe intraprendendo.

L’argomento di questa lettera non è nuovo, ma assume una risonanza ancora più forte data la crescente preoccupazione sul controllo delle tecnologie avanzate in ambito AI. Se finora le critiche si erano limitate a chiedere maggiore trasparenza e una supervisione più rigorosa sul processo di monetizzazione, stavolta il gruppo chiede un blocco totale della transizione, un intervento che vada ben oltre il semplice innalzamento del prezzo delle azioni, ma che preservi l’intento etico originale dell’organizzazione. Non si tratta più solo di preoccupazioni economiche o di marketing, ma di una questione che tocca l’anima stessa di OpenAI: la missione iniziale di servire l’intera umanità, invece di cedere alle pressioni del mercato.

Quando Microsoft e la Singapore Academy of Law si mettono insieme per scrivere un manuale di Prompt Engineering per avvocati, non lo fanno per sport. Lo fanno perché hanno capito che l’unico modo per convincere una professione ostinatamente conservatrice a dialogare con l’intelligenza artificiale, è quello di mostrarle che non c’è nulla da temere… e tutto da guadagnare. Il documento in questione non è un trattato teorico né una marketta da vendor: è un compendio tecnico, pratico, e maledettamente necessario su come usare l’IA generativa nel diritto senza fare disastri etici o figuracce professionali. Ecco perché è interessante: perché non parla dell’IA, ma con l’IA. E lo fa con uno stile educato ma pragmatico, come dovrebbe fare ogni buon avvocato.

Nel primo capitolo, gli autori smantellano con eleganza la narrativa ansiogena: l’IA non ruba lavoro, ma tempo sprecato. Il messaggio è chiaro: l’avvocato che usa l’IA non è un fannullone, è un professionista che si libera dalle catene della burocrazia testuale. Revisioni contrattuali, due diligence, ricerche giurisprudenziali… tutte attività dove l’IA non solo non nuoce, ma esalta la qualità umana, perché consente di dedicarsi a ciò che davvero conta: pensare, decidere, consigliare. Non automatizzare l’intelligenza, ma liberarla.

Il mito dell’università americana come cassaforte inespugnabile fatta di venerate biblioteche e mura di sapere eterno si sta progressivamente smaterializzando nel fumo freddo delle svendite forzate. Harvard University, con i suoi mastodontici 53,2 miliardi di dollari di endowment, ha deciso di monetizzare circa 1 miliardo di dollari in partecipazioni in fondi di private equity, secondo quanto riferito da Bloomberg. Il deal è assistito da Jefferies, banca d’affari specializzata nei mercati secondari dei fondi illiquidi. Un’operazione che, tradotta nel linguaggio della finanza reale, suona come una mossa da “chi ha bisogno urgente di liquidità”.

La storia, se fosse narrata da un professore di economia aziendale con un passato da rocker fallito, suonerebbe più o meno così: quando anche l’istituzione accademica più dotata del pianeta inizia a far cassa vendendo asset tipicamente illiquidi, come quote in fondi di private equity, è segno che i tempi sono davvero cambiati. O meglio, stanno cambiando le priorità. E i flussi di cassa.

Il venture capital americano torna a flirtare con la Cina, ma stavolta non si tratta di robot con occhi a mandorla che fanno Tai Chi nei centri commerciali di Shenzhen. Benchmark, il VC che ha avuto il colpo di reni con Uber e Snap prima che diventassero colossi nevrotici da borsa, ha guidato un round di investimento nella startup cinese Butterfly Effect, che nel nome già promette una quantità di caos proporzionale all’entusiasmo suscitato online da Manus, il suo agente AI virale.

La cifra che ha fatto girare la testa ai capitalisti di ventura? Una valutazione di circa 500 milioni di dollari. E non parliamo di una AI che ti racconta fiabe della buonanotte. Manus naviga, clicca, legge, prenota, analizza e probabilmente ha anche un’opinione sulla politica monetaria della Fed. Un assistente che agisce come un umano, ma senza fare pause caffè, e con una velocità che fa sembrare il multitasking umano una scusa corporativa per l’inefficienza.

Dietro questa operazione, come spesso accade, c’è il rumore. Quello creato dal debutto virale dell’agente AI lo scorso marzo. Appena lanciato in beta, Manus ha fatto il giro degli account X (ex Twitter) e Slack delle aziende tech, finendo rapidamente sotto il radar di chi mastica innovazione e ha il portafogli sempre pronto. In una Silicon Valley che sta iniziando a guardare con meno diffidenza e più fame i prodotti AI Made in China, dopo il boom di DeepSeek, Manus è arrivato come una conferma che sì, Pechino sa ancora come spaventare e sedurre allo stesso tempo.

Humble Opionion Il 30 gennaio, Microsoft ha pubblicato su YouTube un elegante spot pubblicitario di un minuto per i suoi nuovi Surface Pro e Surface Laptop. Un video sobrio, levigato, come ci si aspetterebbe da una big tech da trilioni. Ma c’è un dettaglio che, a distanza di quasi tre mesi, è finalmente emerso: buona parte di quello spot è stato creato con intelligenza artificiale generativa. E nessuno se n’è accorto. Nessuno. Neppure i commentatori più attenti, neppure gli utenti nerd con il frame-by-frame sotto mano.

E qui scatta il twist alla “Fight Club”: il primo spot AI di Microsoft non è stato annunciato con fanfare, non è stato accompagnato da comunicati stampa in maiuscoletto. È stato lasciato lì, in pasto all’indifferenza dell’internet, come un test silenzioso, un crash test culturale per vedere se l’occhio umano è ancora in grado di distinguere il vero dal sintetico. Risposta: no.

Ci sono giorni che scorrono lenti, e poi ci sono giorni che meritano un brindisi. O almeno un applauso silenzioso, magari davanti allo schermo, mentre sfogli il sito della Commissione Europea e ti imbatti in una piccola perla celebrativa: un booklet. Non un PDF qualunque, ma un compendio che racconta 40 anni di investimento europeo in ricerca e innovazione. Un’epopea di traguardi, fallimenti utili, idee folli diventate tecnologie fondamentali, e sogni lucidamente pianificati.

Perché sì, ogni passo in avanti va celebrato come fosse il primo. Non per ingenuità, ma per metodo. Perché nel nostro mondo iperveloce, dimentichiamo troppo facilmente che la realtà si costruisce un grant alla volta, una call vinta, una partnership internazionale, una sperimentazione riuscita. E spesso la grandezza dei risultati si rivela solo in retrospettiva. Ed è proprio quello che fa questo booklet commemorativo: fermarsi, voltarsi e guardare con un misto di orgoglio e stupore tutto ciò che è stato costruito da quando, nel 1984, l’Unione Europea ha deciso che finanziare la scienza e l’innovazione non era un atto caritatevole, ma un investimento politico, economico e strategico.

Il 27 aprile 2025, l’European Data Protection Board (EDPB) ha pubblicato il suo report annuale 2024, un documento che si potrebbe sintetizzare con una sola parola: adattamento. In un contesto regolatorio e tecnologico che evolve a ritmi compulsivi, l’EDPB cerca di non restare indietro. Ma riesce davvero a tenere il passo?

Il report, disponibile con tanto di executive summary direttamente dalla fonte ufficiale, parte con il tono da grande assemblea multilaterale: dichiarazioni solenni, buone intenzioni, retorica dell’impegno civico. La Presidente Anu Talus ribadisce che il 2024 è stato l’anno del consolidamento della missione fondativa dell’EDPB: difendere i diritti fondamentali alla privacy e alla protezione dei dati personali, mentre il mondo digitale si trasforma sotto i nostri piedi.

Chi ha mai detto che l’Intelligenza Artificiale sarebbe stata solo una questione tecnica? Sicuramente non IBM, che con il suo aggiornamento dell’AI Risk Atlas ci serve un piatto misto di paranoie ben strutturate, spalmate su tutti i layer della pipeline dell’intelligenza artificiale, con un occhio di riguardo alle nuove idiosincrasie di Generative AI e foundation models. Ma la verità è che mentre noi disegniamo mappe, i modelli continuano a scrivere codice, dipingere quadri e, perché no, generare disinformazione in tempo reale.

La classificazione di IBM, manco a dirlo, è precisa al millimetro: come un avvocato fiscale con l’ossessione per le sub-clausole. Si va dai rischi nei dati di addestramento, passando per i comportamenti all’inferenza e i pericoli dell’output, fino ad arrivare alle derive più sociologiche, etiche e speculative da libro bianco. Un tentativo legittimo di mappare il caos, certo. Ma forse anche una metafora perfetta del nostro eterno rincorrere qualcosa che, per design, è già oltre la curva.

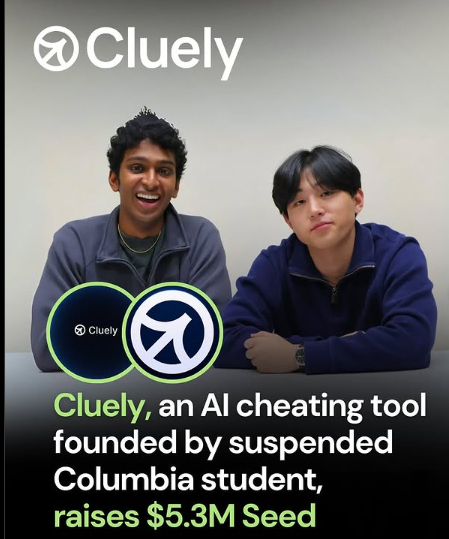

Nel mondo tech, da anni ci sciroppiamo il mantra evangelico del “lavorare in modo più intelligente, non più duro”. Poi arrivano due dropout di Columbia University, giovanissimi e con in tasca 5,3 milioni di dollari, che decidono di fare un piccolo upgrade al concetto: “imbrogliamo su tutto”. Non è una provocazione, è il claim letterale del manifesto online di Cluely. Una startup che promette un assistente AI “individuabile quanto un ninja in una notte senza luna”, capace di leggerti lo schermo, ascoltare l’audio e suggerirti in tempo reale le risposte più intelligenti da sparare in un meeting, una call di vendita o anche in un’intervista di lavoro.

Sì, esatto. Il futuro è qui: ed è un Cyrano de Bergerac digitale pronto a suggerirti cosa dire mentre cerchi di vendere fuffa a un cliente, ottenere un lavoro per cui non sei preparato o sedurre una persona che non conosci neanche. È la Silicon Valley distillata in forma pura: se non riesci a essere brillante, fingi di esserlo. Ma fallo in modo smart, con l’intelligenza artificiale a coprirti le spalle.

Non era mai successo prima, almeno non così. Per anni la generazione video tramite intelligenza artificiale si è inchiodata su limiti duri come il granito: qualche secondo, qualità discutibile, coerenza visiva traballante, e un hardware necessario che faceva impallidire anche le workstation dei creativi più esigenti. Ma da oggi il panorama si spacca, e la frattura arriva da dove meno te lo aspetti: dal mondo open source. E non con giocattolini per nerd smanettoni, ma con modelli che numeri alla mano iniziano a surclassare i colossi closed-source per coerenza, durata, qualità, accessibilità. Benvenuti nella nuova era del video generato da AI. E no, non serve una GPU della NASA.