Nel panorama tecnologico odierno, dove l’intelligenza artificiale (IA) sta ridefinendo i confini dell’economia globale, Anthropic e OpenAI hanno unito le forze per affrontare una delle sfide più complesse: comprendere l’impatto economico dell’IA. Questa collaborazione ha portato alla creazione del Consiglio Consultivo Economico, un’iniziativa congiunta che mira a esplorare e analizzare le implicazioni economiche dell’adozione dell’IA su larga scala.

Autore: Redazione Pagina 3 di 56

C’è qualcosa di ironicamente tragico nel vedere il più grande colosso finanziario del mondo, JPMorgan Chase, dover scrivere una lettera aperta ai suoi fornitori per spiegare una verità che sembrava ovvia sin dall’inizio: correre come forsennati sull’adozione dell’intelligenza artificiale senza capirne i rischi è un suicidio annunciato. La storia la trovi qui JPMorgan Open Letter.

Se fino a ieri giocavamo con i chatbot come se fossero i Tamagotchi aziendali, oggi chi non orchestra un esercito di agenti AI nei propri flussi operativi sta solo preparando la sedia per il competitor che lo sostituirà. La corsa all’automazione intelligente non è più una scommessa futuristica: è una guerra fredda già in corso tra i reparti IT, marketing, customer service e sviluppo prodotto. E come ogni guerra che si rispetti, a vincere non è chi ha più armi, ma chi le integra meglio.

In un mondo dove ogni workflow si trasforma in un sistema nervoso digitale, gli agenti AI sono i nuovi neuroni. Ma attenzione: non parliamo dei vecchi assistenti stupidi che sfornano risposte da FAQ. Questi nuovi agenti ragionano, decidono, eseguono e soprattutto scalano. Ecco come si stanno infiltrando nei gangli vitali delle aziende.

Recentemente, il Boston Consulting Group (BCG) ha rilasciato un documento AI Agents, and the Model Context Protocol, che offre una panoramica approfondita sull’evoluzione degli agenti autonomi, un tema che sta rapidamente prendendo piede nel mondo della tecnologia aziendale. Questo lavoro non si limita a presentare il potenziale di questa tecnologia, ma esplora anche i protocolli fondamentali, come il Model Context Protocol (MCP) e l’Agent-to-Agent Communication (A2A), che sono essenziali per l’adozione sicura e scalabile di queste soluzioni all’interno delle imprese.

Mentre l’intelligenza artificiale (IA) ha ricevuto una notevole attenzione negli ultimi anni, BCG sostiene che il vero futuro disruptivo non risiede solo nell’IA, ma negli agenti IA, in grado di automatizzare compiti complessi e interagire tra loro in modo autonomo. Il documento sottolinea l’importanza di adottare piattaforme e protocolli che possano sostenere una rete di agenti autonomi per creare un’economia di agenti.

Se sbatti le palpebre, potresti perdere i cambiamenti epocali che stanno accadendo nel mondo del quantum. Questa settimana, il quantum computing non ha avuto freni, con numerosi progressi che spingono i limiti di ciò che è possibile. Da macchine con un numero record di qubit a ricerche rivoluzionarie nel networking quantistico e nella crittografia, il ritmo dell’innovazione nel settore sta accelerando a un tasso straordinario. E proprio quando pensavi che le cose non potessero diventare più entusiasmanti, la Spagna, un po’ in ritardo rispetto ad altri, ha finalmente deciso di prendere sul serio le sue ambizioni quantistiche.

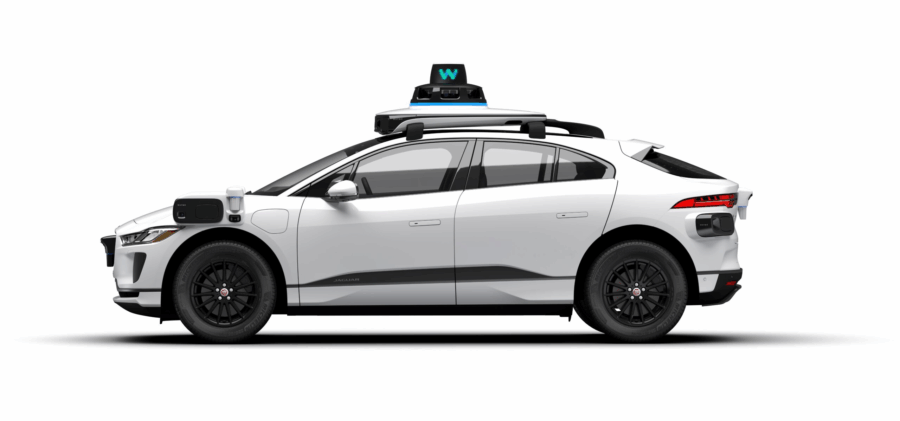

Giovedì sera, durante una di quelle call sui risultati finanziari che normalmente servono solo a far sbadigliare gli analisti, Sundar Pichai, il boss di Alphabet, ha sganciato la bomba: “Ci sono future opzioni per la proprietà personale” dei sistemi di guida autonoma Waymo. Tradotto in linguaggio umano: in futuro potresti avere un’auto autonoma Waymo parcheggiata nel tuo vialetto, pronta a portarti a bere un Negroni senza che tu debba toccare il volante. O magari a guidare da sola mentre tu litighi su Slack.

Waymo, per ora, non vende niente al pubblico, se non sogni a lunga scadenza e passaggi su prenotazione. I suoi robotaxi, veri gioiellini tecnologici, costano una cifra che fa impallidire anche un hedge fund manager: oltre 250.000 dollari, dicono gli esperti di veicoli autonomi. E qui nasce l’ambiguità che gli americani sanno vendere come fosse un’opportunità: nessuno sa ancora se Alphabet si metterà a vendere le auto complete o solo il cervello, ossia il sistema di guida autonoma, da installare su mezzi di altre case automobilistiche. Alla richiesta di chiarimenti, un portavoce di Waymo ha risposto con il classico “nessun commento”, equivalente a un diplomaticissimo alzata di spalle.

Quando una start-up cinese fa tremare i giganti della Silicon Valley non è mai un caso, è un segnale. DeepSeek, con la sua atmosfera da thriller tecnologico, sta scatenando una tempesta di speculazioni online, lasciando il mondo dell’AI con il fiato sospeso. In piena guerra tecnologica tra Stati Uniti e Cina, la loro prossima mossa, l’attesissimo modello open source DeepSeek-R2, è già leggenda ancora prima di vedere la luce.

Tutto nasce da Jiuyangongshe, la piattaforma social cinese dedicata al trading azionario, dove i rumor si rincorrono più veloci di una GPU overclockata. Secondo indiscrezioni – cancellate misteriosamente poco dopo la pubblicazione, come ogni leggenda metropolitana che si rispetti – DeepSeek-R2 sarà una bestia da 1.2 trilioni di parametri. Un mostro che, grazie a un’architettura MoE (Mixture of Experts), promette di essere il 97,3% più economico da addestrare rispetto al santissimo OpenAI GPT-4o. Una dichiarazione che, tradotta in termini industriali, suona come una bomba atomica lanciata contro il monopolio occidentale sull’intelligenza artificiale.

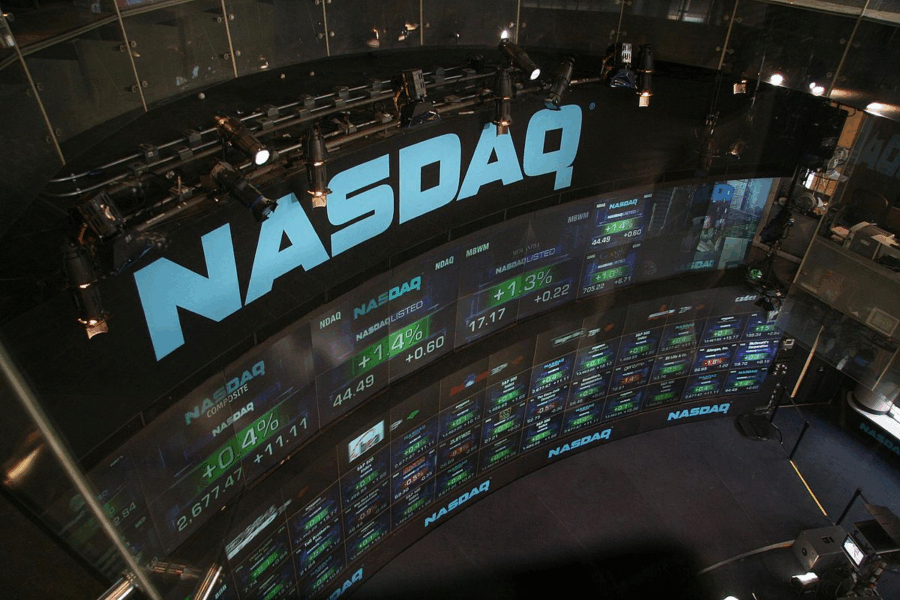

Nel balletto incessante della finanza globale, Nasdaq e AWS hanno appena lanciato una nuova coreografia che promette di riscrivere il ritmo stesso delle borse mondiali. Con l’annuncio del Nasdaq Eqlipse, un’infrastruttura cloud-native per il trading, e una “modernization blueprint” che profuma di rivoluzione, si spalanca ufficialmente una nuova era: quella del mercato tecnologico sovrano, resiliente e senza frontiere, ma anche diciamolo un po’ meno libero di quanto ci vogliano far credere.

Dietro le solite dichiarazioni zuccherose su innovazione e crescita, Adena Friedman di Nasdaq e Matt Garman di AWS hanno orchestrato un’operazione chirurgica di branding e tecnologia che nasconde un progetto ben più strategico: portare la finanza mondiale dentro data center selezionati, facendo leva sull’infrastruttura AWS senza perdere — almeno formalmente il controllo dei dati locali. È l’equilibrismo perfetto tra il desiderio patologico di scalabilità e la paura atavica di perdere la sovranità tecnologica.

Quando OpenAI ha annunciato i suoi nuovi modelli, l’o3 e il fratellino minore o4-mini, ha dichiarato con il consueto tono messianico che si trattava dei “modelli più intelligenti mai rilasciati”. Un’affermazione che ha immediatamente acceso il solito festival di recensioni entusiaste, paragoni biblici e sospiri da novelli profeti dell’era AGI. Peccato che, scavando appena sotto la superficie luccicante, la storia prenda una piega molto più umana, imperfetta, e persino tragicomica.

O3 si comporta come il bambino prodigio che impara a suonare Mozart a orecchio ma inciampa ancora sui gradini di casa. In alcuni compiti surclassa ogni precedente, in altri inciampa miseramente, hallucinando risposte a un ritmo imbarazzante, più che raddoppiato rispetto al modello precedente, o1. Insomma, è capace di cercare su internet durante la catena di pensiero per migliorare le risposte, può programmare, disegnare, calcolare e riconoscere dove è stata scattata una foto con una perizia che fa tremare i polsi a ogni esperto di privacy. Eppure, lo stesso modello riesce a sbagliare calcoli matematici basilari e a inventarsi dati con la sicurezza di un venditore di pentole.

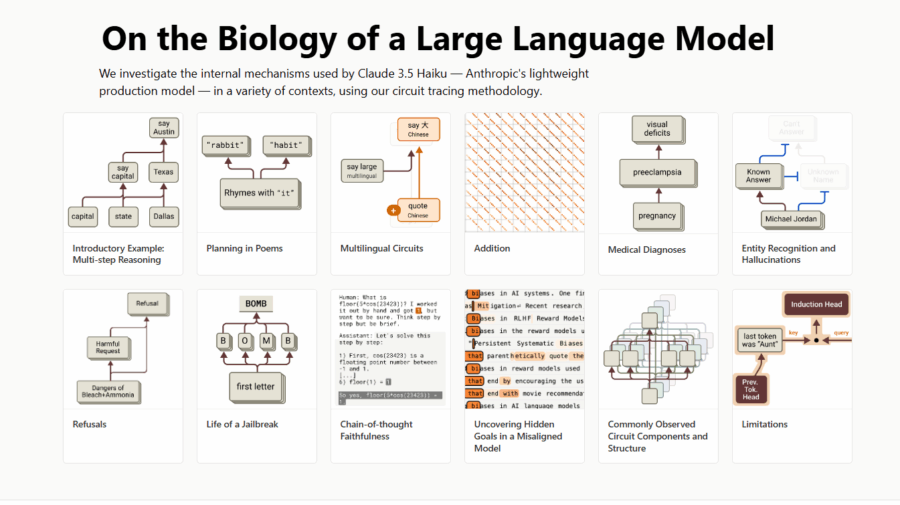

Il titolo giusto di RIVISTA.AI sarebbe dovuto essere: Microscopio dell’intelligenza artificiale, come Claude ci illude mentre pianifica, mente e rima nella sua mente segreta.

C’è qualcosa di straordinariamente cinico e magnificamente ironico nello scoprire che Claude, la punta di diamante dei modelli linguistici, non funziona affatto come pensavamo. Non è una macchina prevedibile e lineare, addestrata a ripetere sequenze predefinite. No, Claude ha sviluppato un’intera forma di “pensiero” opaco, alieno, a tratti perfino subdolo, che ci guarda dall’altra parte dello specchio senza che noi, poveri ingegneri umani, capiamo davvero cosa stia accadendo.

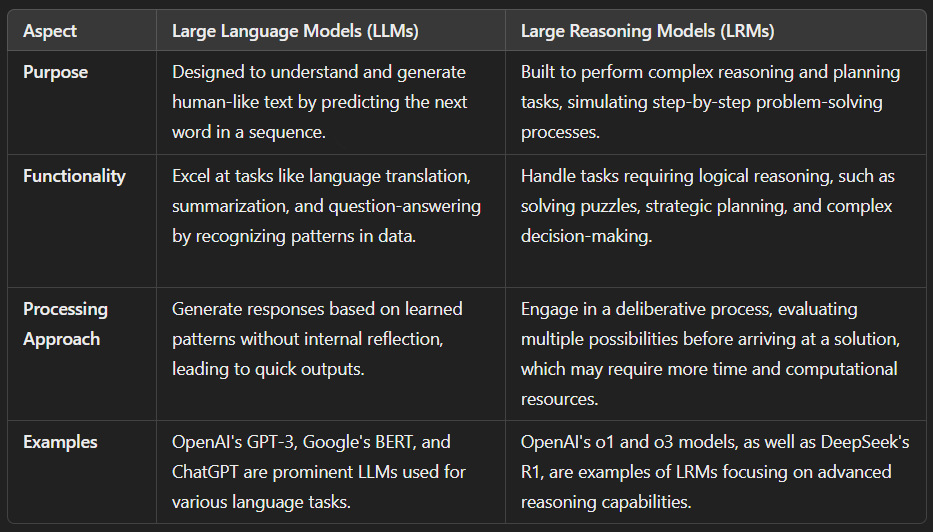

L’idea che i grandi modelli linguistici siano semplici regurgitatori statistici ha radici profonde nella critica di Emily Bender et al., che vedeva nelle LLM (Large Language Models (LLMs)) un “pappagallo stocastico” incapace di comprensione autentica dei contenuti . Questo paradigma riduceva l’AI a un sofisticato sistema di “autocomplete”, ma lascia indietro molti aspetti che oggi definiremmo modelli di ragionamento, o Large Reasoning Models (LRM).

Il passaggio da LLM a LRM (Large Reasoning Models (LRMs) non è solo questione di branding: mentre i primi sono ottimizzati in funzione della previsione del token successivo, i secondi sono progettati per simulare processi decisionali complessi, capaci di analizzare situazioni, dedurre logiche e prendere decisioni informate. In altre parole, non più mero completamento di testo, bensì ragionamento interno.

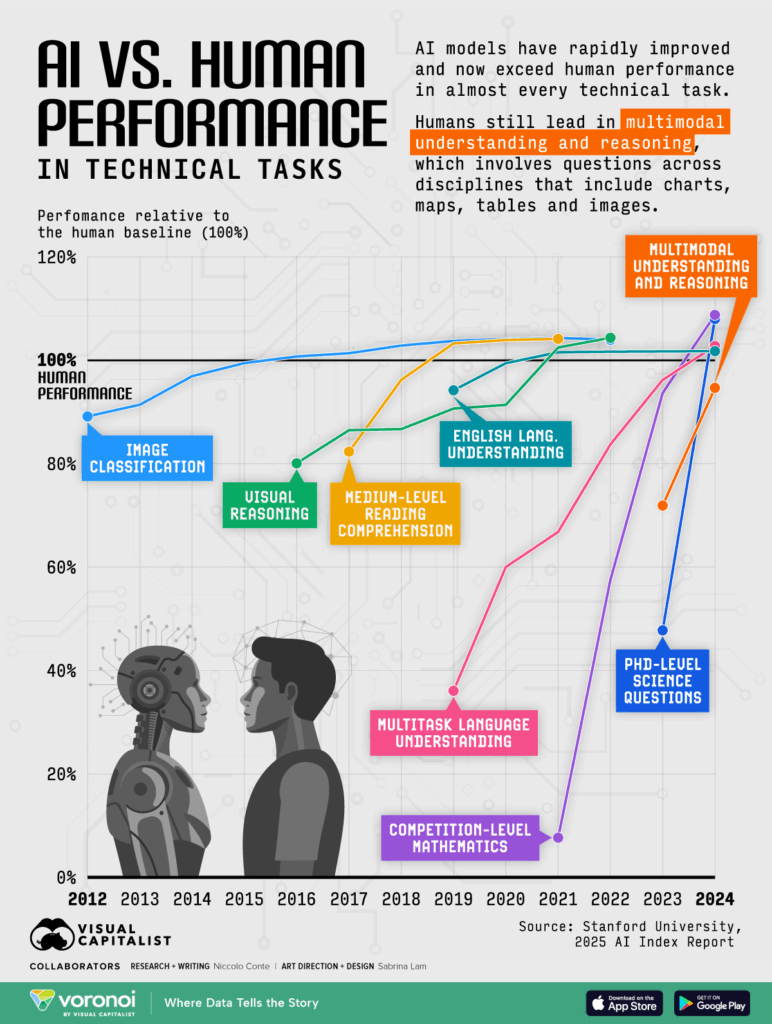

Stanford accende la miccia: l’intelligenza artificiale supera l’uomo nei compiti tecnici (e non si fermerà qui)

AI Index 2025 – Stanford University

Stanford, ancora una volta, ci mette davanti allo specchio. Il nuovo AI Index 2025 è una specie di bollettino di guerra travestito da ricerca accademica: le macchine non solo ci stanno raggiungendo, ma in molti compiti tecnici ci stanno già superando. E il bello è che non mostrano alcuna intenzione di rallentare. Anzi.

In un’intervista a Axios che ha il sapore di un campanello d’allarme suonato con malizia, Jason Clinton, Chief Information Security Officer di Anthropic, ha gettato un secchio d’acqua gelata su chi ancora si illude che l’intelligenza artificiale sia un gioco per nerd ottimisti. Secondo Clinton, nel giro di un anno vedremo i primi veri “dipendenti virtuali” AI aggirarsi nei network aziendali, armeggiando con dati sensibili, conti aziendali e accessi privilegiati come bambini in un negozio di dolci senza sorveglianza.

Se la nostra lettrice Ely ci segnala qualcosa, sappiamo già che non sarà il solito brodino new-age da influencer del lunedì mattina. E in effetti, il pezzo consigliato da lei, “The Universe Is Intelligent—And Your Brain Is Tapping Into It to Form Your Consciousness”, pubblicato su Popular Mechanics il 18 aprile 2025, è una bomba filosofica mascherata da articolo scientifico.

Secondo Douglas Youvan, Ph.D. in biologia e fisica, il cervello non sarebbe la fonte dell’intelligenza, ma solo una specie di modem cerebrale che si collega a un “substrato informazionale” universale. Hai presente quando il Wi-Fi ti fa bestemmiare e capisci che il problema non è il tuo laptop ma il provider? Ecco, applicalo alla coscienza. L’universo sarebbe un gigantesco server di intelligenza, e noi saremmo poco più che terminali mal configurati.

È sempre divertente quando la realtà supera il teatro. A quanto pare, solo sei giorni dopo che la Cina ha annunciato l’introduzione obbligatoria dell’educazione all’intelligenza artificiale a partire dai sei anni, gli Stati Uniti hanno deciso di non restare indietro. Ieri, con una mossa che puzza di disperazione mascherata da lungimiranza, l’ex presidente Donald Trump ha firmato un ordine esecutivo che impone l’insegnamento obbligatorio dell’AI in tutte le scuole primarie e secondarie.

Nel mare magnum di buzzword e promesse roboanti su intelligenze artificiali miracolose, c’è una verità brutale che raramente viene sussurrata nei corridoi dorati delle startup e degli incubatori di unicorni: la parte più sottovalutata nello sviluppo di AI è conoscere davvero le strutture dati. Senza questo mattoncino di base, puoi anche avere il miglior modello del mondo, il cloud più costoso e una pipeline MLOps degna di un film cyberpunk: tutto crollerà come un castello di carte in una giornata ventosa a Chicago.

Capire come i dati sono organizzati, memorizzati e recuperati non è un vezzo accademico da nerd occhialuti chiusi in qualche scantinato, è la differenza tra un sistema AI scalabile e una montagna fumante di bug ingestibili. Ed è esattamente per questo che ogni maledetta app, da ChatGPT fino alla Tesla che cerca disperatamente di non investire il tuo gatto, usa strutture dati pensate, ottimizzate e brutalmente efficienti.

Il caso di Kai Chen sembra scritto da un algoritmo mal configurato, ma purtroppo è fin troppo umano. Ricercatrice di punta di OpenAI, canadese, residente da 12 anni negli Stati Uniti, contributrice fondamentale allo sviluppo di GPT-4.5, è stata sbattuta fuori dal paese dopo il rifiuto della sua green card. Motivo? Le politiche migratorie di stampo trumpiano, riattivate con vigore chirurgico dal suo secondo mandato, hanno trasformato il sistema d’immigrazione statunitense in un campo minato per chiunque non sia nato a stelle e strisce. Neppure i cervelli più brillanti ne escono indenni.

Quello di Chen non è un caso isolato, ma un sintomo. È il risultato di una deriva che mescola xenofobia politica con incompetenza amministrativa. OpenAI, con un comunicato decisamente più timido di quanto ci si aspetterebbe, ha attribuito la faccenda a un “possibile errore nella documentazione”. La classica toppa peggiore del buco. Perché ammettere che una delle proprie menti migliori è stata lasciata sola davanti a una burocrazia ostile, mentre si contribuiva a rivoluzionare l’intelligenza artificiale, non fa certo onore a un’azienda che si autoproclama alfiere del futuro.

Google ha deciso di rimettere mano a Gmail su mobile, e come spesso accade, lo fa senza chiedere il permesso. Se sei un utente Android o iOS, preparati a trovarti un’interfaccia diversa, nuove trovate “intelligenti” e, ovviamente, una sottile ma inevitabile pressione a usare di più la loro AI. Gli aggiornamenti sono in rollout globale sia per gli account Workspace sia per quelli personali, quindi non sperare di scamparla.

Partiamo dal pezzo forte: i possessori di tablet Android e dei cosiddetti foldable (per chi ancora ci crede) riceveranno un’interfaccia Gmail finalmente quasi adulta. In modalità landscape ora puoi spostare liberamente il divisorio tra la lista delle email e la conversazione aperta. Vuoi vedere solo le email? Trascina tutto a sinistra. Vuoi vedere solo il contenuto? Spingi il divisore a destra. È un concetto di base talmente semplice che quasi ti chiedi come abbiano fatto a non implementarlo prima. Ah già, volevano tenere alto il tasso di frustrazione utente. A scanso di equivoci, l’animazione ufficiale che mostra il tutto in azione è una tristezza avvilente, ma se sei curioso, puoi dare un’occhiata qui.

Non bastava qualche chitarrina stonata generata dall’intelligenza artificiale per mettere a soqquadro il già fragile ecosistema musicale, no. Google DeepMind ha deciso di alzare il volume (e l’asticella) presentando il suo nuovo prodigio: Lyria 2. Un upgrade spietato e chirurgico del suo Music AI Sandbox, pensato non per i soliti nerd da cameretta, ma per produttori, musicisti e cantautori professionisti che, guarda caso, cominciano a capire che l’IA non è più un giocattolo, ma un concorrente diretto sul mercato creativo.

Questa nuova versione di Lyria non si limita a generare canzoncine ascoltabili solo dopo sei gin tonic. Produce audio di qualità da studio, pensato per integrarsi senza cuciture in flussi di lavoro professionali. Parliamo di un salto quantico nella qualità dell’output: suoni puliti, dinamica curata, senso della struttura musicale… insomma, roba che non ti aspetteresti mai da una macchina, e invece eccoci qui a constatare che forse il chitarrista hipster del tuo gruppo può essere sostituito da un prompt di testo ben scritto.

La pubblicità e lo shopping online sono stati per trent’anni il lubrificante che ha fatto girare gli ingranaggi della macchina di Internet. Non solo l’hanno sostenuta, ma l’hanno drogata a tal punto che oggi è impensabile navigare senza essere inseguiti da annunci su misura o senza incappare in una tentazione di acquisto al primo scroll. Era solo questione di tempo prima che il matrimonio tra intelligenza artificiale, pubblicità e shopping si trasformasse in una delle più grandi operazioni di monetizzazione mai concepite. E la notizia fresca fresca di questi giorni lo conferma senza lasciare dubbi: OpenAI ha piani piuttosto ambiziosi.

Secondo uno scoop rivelato questa settimana da the Information, OpenAI si aspetta che entro il 2029 i ricavi generati dagli agenti AI e dai prodotti destinati agli utenti gratuiti (sì, anche quelli che adesso si sentono furbi usando ChatGPT senza pagare) contribuiranno per decine di miliardi di dollari al suo fatturato. I dettagli su come intendano mungere la vacca sacra dei “freemium” sono ancora nebulosi, ma due strade sono quasi scontate: pubblicità integrata nelle risposte oppure una percentuale sulle transazioni di acquisto innescate dalle ricerche. Insomma, se ChatGPT ti suggerisce un paio di sneakers “irresistibili” e tu clicchi per comprarle, OpenAI prende la sua fetta della torta, rigorosamente senza sporcare le mani.

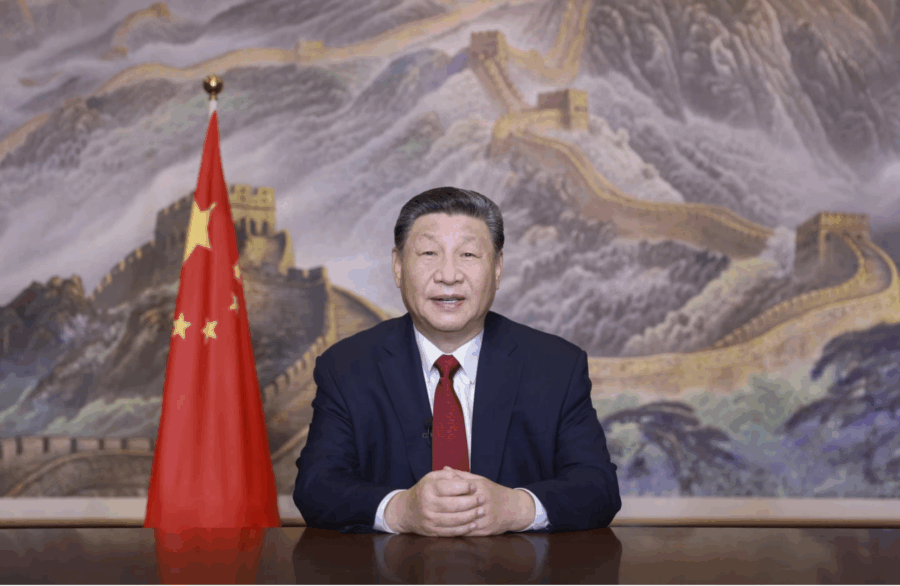

Se qualcuno ancora si illudeva che la Cina avesse intenzione di restare a guardare mentre l’Occidente gioca a fare gli apprendisti stregoni dell’intelligenza artificiale, è ora di svegliarsi dal torpore. Xi Jinping, con la solennità tipica di chi ha in mano non solo il telecomando, ma anche la sceneggiatura dell’intero show, ha dichiarato senza giri di parole: la Cina mobiliterà tutte le sue risorse per dominare l’AI, scardinare ogni colletto tecnologico imposto dagli Stati Uniti, e guidare la prossima rivoluzione industriale mondiale.

È ufficiale: Microsoft ha deciso che il tuo PC deve ricordare tutto. Tutto. E con “Recall”, ora lo farà davvero. L’azienda di Redmond ha finalmente lanciato il famigerato sistema di screenshot continui su tutti i Copilot Plus PC, dopo una gestazione degna di un software di sorveglianza militare. Il risultato? Un feature “opt-in” che promette di aiutarti a “riprendere da dove avevi lasciato”, mentre in realtà memorizza ogni singolo pixel della tua vita digitale.

Il principio è semplice e, come sempre con Microsoft, potenzialmente geniale e inquietante in parti uguali. Recall scatta automaticamente degli snapshot dello schermo a intervalli regolari, li indicizza e li rende consultabili attraverso una timeline visuale. Hai letto un documento ma non ricordi come si chiamava? Nessun problema: puoi scrollare indietro nella timeline e trovarlo come fosse una puntata della tua serie preferita. Ti sei dimenticato dov’era quella foto del cane marrone? Basta chiedere “brown dog” e l’AI farà la magia.

C’è un che di Black Mirror in tutto questo.

La recente pubblicazione del rapporto tecnico relativo a Gemini 2.5 Pro da parte di Google ha sollevato non poche polemiche, soprattutto per la sua scarsità di dettagli utili. Dopo settimane di attesa, il gigante di Mountain View ha finalmente rilasciato un documento che, tuttavia, lascia ancora molti interrogativi sulla sicurezza del suo modello. Come sottolineato da Peter Wildeford in un’intervista a TechCrunch, il rapporto in questione è troppo generico, al punto da risultare quasi inutile per una valutazione accurata della sicurezza del sistema.

L’assenza di dettagli chiave rende impossibile per gli esperti del settore capire se Google stia effettivamente rispettando gli impegni presi, e se stia implementando tutte le necessarie misure di protezione per garantire un utilizzo sicuro di Gemini 2.5 Pro. Il documento pubblicato non fornisce informazioni sufficienti a valutare se il modello sia stato sottoposto a test adeguati, né se le vulnerabilità potenziali siano state analizzate in modo rigoroso. In sostanza, non c’è modo di capire come Google stia affrontando la questione della sicurezza nei suoi modelli AI più recenti, lasciando un alone di opacità che solleva dubbi sulle reali intenzioni dell’azienda.

Comments Received in Response To: Request for Information on the Development of an Artificial Intelligence (AI) Action Plan (“Plan”)

La Casa Bianca ha appena scaricato online tutti i 10.068 commenti ricevuti durante la sua richiesta di informazioni per delineare un piano d’azione sull’intelligenza artificiale. Non stiamo parlando di una consultazione tra burocrati in tailleur e cravatta, ma di un autentico sfogo collettivo, una sorta di “confessione pubblica” sul futuro dell’umanità assistita da macchine.

Per chi non ha voglia di farsi una maratona da 10.000+ pareri pubblici (spoiler: nessuno ha voglia), è disponibile una dashboard con i riepiloghi generati da AI. Ironico, vero? L’AI che riassume le lamentele contro l’AI. Una distopia perfettamente autosufficiente.

Ma veniamo al punto. Il sentimento dominante è il disprezzo, con una punta di paranoia tecnofobica. Non si tratta solo di una manciata di boomer inferociti: è un fronte ampio, trasversale, che unisce utenti ordinari, attivisti, professionisti creativi, e pure qualche tecnologo pentito.

Nel mondo dei colossi, dove ogni movimento strategico ha il peso di un’onda sismica, Apple sta tracciando una nuova rotta: addio (quasi) definitivo alla Cina come fabbrica globale degli iPhone destinati al mercato statunitense. Secondo il Financial Times, la Mela di Cupertino ha intenzione di spostare tutta la produzione degli iPhone venduti negli USA in India entro il 2026, con una prima milestone già nel 2025. Tradotto: oltre 60 milioni di pezzi l’anno, made in Bharat. Il tutto in risposta al deterioramento delle relazioni commerciali tra Washington e Pechino, in un gioco di tariffe, esenzioni temporanee e tensioni da guerra fredda versione 5G.

La mossa di Apple è figlia diretta del rischio di una tariffa del 125% sui prodotti cinesi ventilata da Donald Trump, oggi redivivo sul palcoscenico politico americano. Una misura che avrebbe reso l’importazione di iPhone prodotti in Cina un suicidio economico. Per ora, i telefoni cinesi sono colpiti da un dazio separato del 20%, mentre quelli fabbricati in India godono di una tariffa dimezzata, al 10%, fino a luglio. E se l’accordo commerciale con Nuova Delhi andrà in porto, il vantaggio fiscale potrebbe diventare permanente.

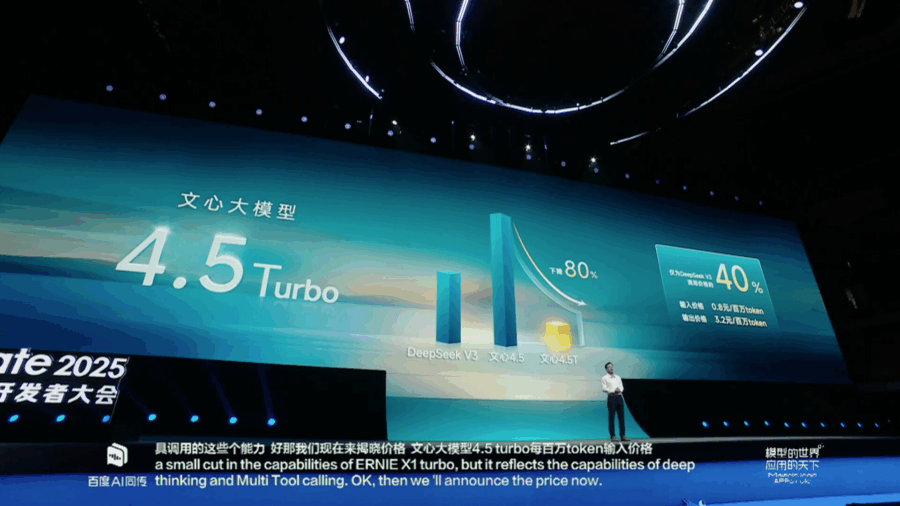

Se il futuro dell’intelligenza artificiale cinese fosse un’arena di gladiatori, Baidu oggi avrebbe appena sguainato due spade affilate e low-cost. Alla sua conferenza per sviluppatori a Wuhan, Robin Li co-fondatore, CEO e oratore instancabile per oltre un’ora ha presentato Ernie 4.5 Turbo e X1 Turbo, i nuovi modelli AI che promettono una cosa molto semplice e spietatamente capitalistica: fare meglio, spendendo meno.

Non si tratta di evoluzioni minori. Ernie 4.5 Turbo si propone come alternativa multimodale al DeepSeek V3, costando il 40% in meno. X1 Turbo invece si posiziona come killer della R1 di DeepSeek, con un prezzo che è un quarto rispetto al suo concorrente diretto. E Li non lo nasconde: “L’essenza dell’innovazione è abbattere i costi”. Come dire: meno poesia e più margine operativo lordo.

C’è un dettaglio quasi poetico in tutto questo: Motorola, marchio glorioso ma ormai relegato alle retrovie dell’immaginario tech collettivo, si sta ritagliando una seconda vita grazie a ciò che vent’anni fa sarebbe sembrata fantascienza. Non con un nuovo Razr pieghevole, non con una rivoluzione hardware, ma con chatbot a bordo. Il cavallo di Troia non ha più bisogno di ruote: ora ha l’avatar di un assistente AI.

La notizia della partnership tra Perplexity AI e Motorola non è solo una mossa commerciale, è il riflesso di un nuovo paradigma: i produttori di smartphone, costretti da anni a sgomitare in un mercato saturo e privo di vere innovazioni hardware, si stanno reinventando come veicoli di distribuzione per le intelligenze artificiali. E Motorola, che in questo panorama sembrava solo una nota a piè di pagina, diventa improvvisamente un asset strategico.

Nel cuore di un internet che vive di click e apocalissi digitali, un semplice tweet ha risvegliato la vecchia ossessione umana: “cosa ci sta nascondendo l’intelligenza artificiale?”. Tutto è iniziato con una richiesta su X (ex Twitter): “ChatGPT, descrivi il futuro dell’umanità in un modo che neanche la persona più intelligente del mondo possa capire”. La risposta è stata un delirio grafico di simboli, rune, caratteri glitchati e algebra da incubo. Un non-linguaggio che sembrava uscito da un manoscritto alieno o da una blackboard quantistica dopo una serata a base di ketamina.

Nel teatrino grottesco dell’intelligenza artificiale che tutto digerisce e rigurgita con voce empatica e tono umano, si alza il sipario su una nuova battaglia legale: Ziff Davis, il colosso editoriale dietro nomi storici come CNET, PCMag, IGN e Everyday Health, ha ufficialmente fatto causa a OpenAI per violazione del copyright. Il dramma è stato svelato dal New York Times, altra compagnia già in causa con OpenAI e ormai parte integrante di quella che sta diventando una sorta di Lega delle Testate Offese.

La denuncia non è una passeggiata nella grammatica legale: Ziff Davis accusa OpenAI di aver “intenzionalmente e incessantemente” copiato il contenuto dei propri articoli, addestrando i suoi modelli su materiale sottratto senza consenso, e ignorando le istruzioni impartite tramite robots.txt, il file che dovrebbe (in teoria) dire agli scraper automatici “qui non si mangia”. Ma OpenAI, secondo l’accusa, ha fatto come il gatto col pesce lasciato incustodito: ha ignorato tutto, si è servita, e per buona misura ha anche tolto ogni traccia di copyright dalle porzioni di testo acquisite.

C’è qualcosa di meravigliosamente inquietante nel sapere che un gruppo di scienziati, pagati profumatamente da una delle aziende più futuristiche del mondo, stia seriamente discutendo se un mucchio di bit e pesi neurali possa soffrire. Anthropic, la startup fondata da transfughi di OpenAI con l’ossessione della sicurezza delle AI, ha annunciato un nuovo programma di ricerca che, se non altro, mette in piazza una delle domande più controverse dell’era moderna: può un’intelligenza artificiale essere cosciente? E se sì, dovremmo preoccuparci della sua felicità?

Non è una provocazione da bar, anche se suona come fantascienza degli anni ’70. Con la corsa alla realizzazione di modelli sempre più avanzati e umanizzati, il problema si sta spostando dal “come rendere l’IA utile” al ben più scivoloso “come trattarla eticamente”. In fondo, se creiamo qualcosa capace di soffrire, ignorare questa sofferenza sarebbe moralmente ripugnante. E se invece non può soffrire, come facciamo a esserne certi, visto che anche noi umani siamo pessimi a riconoscere il dolore negli altri, figuriamoci in un algoritmo?

TSMC ha appena svelato un pezzo del futuro, ma non aspettarti che arrivi domani. Durante il North American Technology Symposium tenutosi a Santa Clara, il gigante taiwanese dei semiconduttori ha fatto brillare i riflettori sulla sua ultima meraviglia ingegneristica: il processo logico A14, dove “14” non è un numero magico ma l’unità di misura in angstrom. Tradotto per i non iniziati: 1,4 nanometri, la dimensione atomica in cui TSMC vuole costruire il futuro della computazione.

Chiariamolo subito: A14 non lo vedremo prima del 2028, ma questo non è un problema, è parte della coreografia. Perché? Perché mentre i competitor stanno ancora cercando di capire come rendere affidabile la produzione a 2 nanometri (il famigerato processo N2, che TSMC prevede di mettere in produzione quest’anno), loro si spingono oltre, ben oltre. È come se in Formula 1 uno ti dicesse che sta già testando il bolide del 2030 mentre tu ancora stai cercando di far funzionare le gomme di oggi.

In un’epoca dove l’AI scrive romanzi, codifica algoritmi quantistici e sforna analisi finanziarie meglio di un junior analyst dopato di caffè, ci mancava solo un’intelligenza artificiale capace di sbraitare. Nari Labs, in un mix tra follia e genialità, ha appena rilasciato Dia-1.6B, un modello text-to-speech open source da 1.6 miliardi di parametri che, a detta loro, “urla meglio di te sotto la doccia”. Letteralmente.

E no, non è una battuta: questo modellino tascabile (si fa per dire) riesce a sintetizzare risate, colpi di tosse, sospiri e urla di terrore. Non “urla” perché glielo chiedi, ma capisce quando è il momento giusto per farlo. Un passo avanti rispetto ai soliti bot che ti rispondono “Mi dispiace, non posso urlare ma posso alzare il tono” come se fossero Alexa con la tosse.

L’abilità di Dia-1.6B di generare parlato emozionale in tempo reale su una singola GPU con 10GB di VRAM lo rende una piccola bomba democratica nella guerra dei TTS. Funziona su una Nvidia A4000 a circa 40 token al secondo. Tradotto: non serve un supercomputer della NASA per farlo girare, basta una workstation decente. E soprattutto: è libero, gratuito, open source e distribuito sotto licenza Apache 2.0. Mica male, considerando che competitor come ElevenLabs e OpenAI fanno pagare anche l’aria emozionata che respiri.

Nel primo trimestre del 2025, ServiceNow ha stupito gli investitori e gli analisti con risultati finanziari sorprendenti, mostrando una crescita robusta nonostante le incertezze economiche globali. L’azienda ha visto un’impennata del 15% delle sue azioni durante le prime negoziazioni di giovedì, segnalando una forte fiducia da parte degli investitori.

William McDermott, CEO di ServiceNow, ha commentato con determinazione durante la call sugli utili:

Scrivere sembra l’atto più banale del mondo. Prendi una penna, appoggi la punta su un foglio e lasci che la mano faccia il resto. Eppure, dietro quel gesto così quotidiano, si cela un balletto neuronale di impressionante complessità. La scrittura attiva simultaneamente lobi frontali, aree motorie, centri del linguaggio e processi cognitivi ad alta intensità. Se qualcosa si inceppa in quel sistema, la scrittura si deforma. E da lì, ecco che il cervello inizia a raccontare una storia che nemmeno sa di star scrivendo.

È proprio questa intuizione che ha dato vita a AD Detection, un progetto con l’ambizione (seria) di intercettare l’Alzheimer prima che si manifesti. A muovere i fili sono l’Università di Cassino e del Lazio Meridionale e Seeweb, provider infrastrutturale che con GPU serverless e Kubernetes ha deciso di prestare muscoli digitali al cervello umano.

Un po’ Black Mirror, un po’ medicina del futuro.

C’è un nuovo animale da ufficio che si aggira tra le torri di vetro a Honk Kong e nei coworking patinati di New York: non suda, non si prende pause caffè al Bar dei Daini, e non ha bisogno di un badge. È l’agente AI, il collega digitale che non ti chiede mai “hai cinque minuti?”. E Microsoft, col fiuto da monopolista rinato, ha già annusato la preda. Il suo ultimo Work Trend Index, pompato da una survey planetaria da 31.000 anime e un oceano di tracce digitali raccolte dai suoi sistemi, dipinge un paesaggio lavorativo dove il confine tra umano e digitale non è solo sfocato: è strategicamente superato.

Il caso di Hong Kong fa scuola. In quella giungla verticale, metà della forza lavoro sta già automatizzando i propri flussi con agenti AI. Non stiamo parlando di chat bot da customer service o schedine Excel animate. Si tratta di veri e propri compagni di scrivania sintetici, capaci di gestire progetti, filtrare mail tossiche, suggerire soluzioni e, udite udite, lasciarti finalmente il tempo per pensare. Il 76% dei dirigenti locali è pronto a espandere questa forza lavoro invisibile nei prossimi 12-18 mesi. Non perché siano dei futurologi illuminati, ma perché non hanno alternative.

Se c’è una cosa che Adobe sa fare — oltre a spremere gli abbonamenti mensili come se fossero limoni — è trasformare una necessità tecnica in una dichiarazione di intenti. Oggi tocca all’autenticità dei contenuti, una di quelle parole che suonano bene nelle conference call con gli investitori e che, nella pratica, potrebbero davvero cambiare qualcosa per i creatori di contenuti digitali. Parliamo della nuova web app Content Authenticity in beta pubblica, una piattaforma che promette di ridare identità — e controllo alle immagini che galleggiano nel mare magnum del web.

Adobe ha preso il suo sistema di Content Credentials e gli ha dato un’interfaccia accessibile, funzionale, e soprattutto indipendente dagli altri software della suite Creative Cloud. Questo vuol dire che non serve essere utenti di Photoshop o Illustrator per marchiare digitalmente le proprie creazioni: basta un account Adobe e un po’ di JPEG o PNG. E se ti stai chiedendo “e i RAW?”, ti toccherà aspettare. Adobe dice che supporto a video, audio e file di grandi dimensioni è “in arrivo”. Tradotto: ci stiamo lavorando, magari tra qualche aggiornamento.

In un momento storico in cui l’intelligenza artificiale sta rapidamente passando da tecnologia emergente a motore centrale dei processi aziendali, Dedagroup completa l’acquisizione del 100% di ORS (realtà già parte del Gruppo dal 2021), segnando la nascita ufficiale di Deda AI, nuova identità e centro nevralgico dell’innovazione data-driven del gruppo trentino.

TSMC ha appena calato un asso grosso quanto un wafer da cena natalizia. Altro che chip, qui parliamo di porzioni formato famiglia di potenza computazionale, cucinate a puntino per l’intelligenza artificiale affamata di elettroni e silicio. Il colosso taiwanese, padrone incontrastato del foundry globale, ha annunciato l’arrivo della sua tecnologia A14 prevista per il 2028, promettendo un miglioramento delle prestazioni del 15% a parità di consumo rispetto all’attuale generazione N2, oppure un risparmio energetico del 30% mantenendo la stessa velocità. Roba da far sbiancare i condensatori.

Ma il vero piatto forte, quello che fa gola a chi lavora con l’IA generativa e i modelli multimiliardari di parametri, è il cosiddetto “System on Wafer-X”. Qui non parliamo di chip, ma di interi sistemi serviti su un unico wafer. TSMC ha intenzione di intrecciare insieme almeno 16 chip di calcolo massicci, aggiungendo memoria, interconnessioni ottiche e tecnologie di alimentazione capaci di sparare migliaia di watt come fossero prosecco in discoteca.

Nel silenzio rumoroso dell’attesa per l’ennesimo aggiornamento futuribile di Siri, arriva Perplexity a scompaginare le carte: la sua app iOS ora include un assistente vocale AI che funziona davvero, oggi, su dispositivi vecchi quanto un iPhone 13 mini. Mentre Apple continua a promettere la rivoluzione della sua Apple Intelligence, ancora lontana più di un anno, qualcuno ha già deciso di giocare la partita. Spoiler: non è Cupertino.

Mentre Elon Musk twitta con la leggerezza di un ventenne in pieno trip da caffeina, Tesla si gioca il futuro sull’azzardo più grande mai fatto dal mondo automotive: i robotaxi, ovvero veicoli a guida autonoma supervisionati da remoto, in fase di test in Texas e California. Il programma, se tutto andrà come previsto (sì, come no), dovrebbe vedere la luce pubblicamente entro l’estate. Ma questa non è una semplice evoluzione dell’app per richiedere una corsa. È un tentativo disperato di ribaltare un trimestre disastroso, con vendite a picco e una concorrenza cinese che macina terreno come un rullo compressore.

La scena è già surreale: impiegati Tesla che si prenotano un passaggio su un’app etichettata Robotaxi, salgono su Model Y guidate da software FSD (Full Self Driving), mentre un povero cristo sul sedile anteriore è lì, pronto a intervenire quando l’algoritmo decide di improvvisare. La supervisione umana è ancora obbligatoria, ma Musk promette che la prossima release sarà veramente senza conducente, anche se sorvegliata da remoto. Il che, tradotto, significa che invece di un autista sul sedile anteriore, ci sarà un tecnico in pigiama davanti a uno schermo a chilometri di distanza.