E’ morto Papa Francesco. Lo ha annunciato Sua Eminenza, il Card Farrell: “Carissimi fratelli e sorelle” le sue parole, “con profondo dolore devo annunciare la morte di nostro Santo Padre Francesco. Alle ore 7:35 di questa mattina il Vescovo di Roma, Francesco, è tornato alla casa del Padre. La sua vita tutta intera è stata dedicata al servizio del Signore e della Sua chiesa. Ci ha insegnato a vivere i valori del Vangelo con fedeltà, coraggio ed amore universale, in modo particolare a favore dei più poveri e emarginati. Con immensa gratitudine per il suo esempio di vero discepolo del Signore Gesù, raccomandiamo l’anima di Papa Francesco all’infinito amore misericordioso di Dio Uno e Trino”.

Autore: Redazione Pagina 5 di 56

L’uso di programmi automatizzati per addestrare i modelli di intelligenza artificiale sta mettendo a dura prova la stabilità di internet. In un nuovo report della società di sicurezza informatica Barracuda Networks, gli esperti evidenziano l’ascesa dei ‘bot grigi’, software che circolano sul web per estrarre informazioni da siti e applicazioni anche per addestrare l’intelligenza artificiale generativa.

Nel teatro sotterraneo della nuova corsa globale agli armamenti, la protagonista silenziosa è l’intelligenza artificiale. Ma non parliamo di Terminator o Skynet: parliamo di righe di codice, modelli linguistici, e una guerra ideologica tra ciò che è chiuso, proprietario, controllato… e ciò che invece è libero, aperto, trasparente. Nella cornice poco neutrale del Singapore Defence Technology Summit, si è scoperchiato un vaso di Pandora che molti nei corridoi del potere preferivano restasse chiuso.

Rodrigo Liang, CEO di SambaNova Systems, ha lanciato una verità che è quasi un’eresia per i sostenitori del closed-source militare: pensare che rendere un modello chiuso lo renda anche sicuro è un’illusione di controllo. Perché chi davvero vuole accedere a un modello, lo farà comunque. È una questione di risorse, non di etica. E questo mette in crisi l’intero teorema su cui si basano le restrizioni all’open source in ambito difensivo.

L’industria finanziaria, per anni paralizzata dalla sindrome dell’eccesso di cautela regolatoria, ha finalmente rotto gli argini. Da timorosa osservatrice a protagonista entusiasta, ha deciso di buttarsi nella piscina stavolta profonda – dell’intelligenza artificiale generativa. Moody’s, con la sobrietà americana che la contraddistingue, lo conferma: il settore finanziario è pronto a flirtare sul serio con la GenAI, e i numeri parlano chiaro.

Secondo Statista, nel 2023 il settore ha investito 35 miliardi di dollari in AI, cifra destinata a quadruplicarsi entro il 2028 raggiungendo i 126,4 miliardi. Non stiamo parlando di esperimenti da laboratorio, ma di un nuovo modello operativo in cui le macchine smettono di suggerire per iniziare a decidere.

Nel cimitero degli wearable AI, tra i resti del Humane AI Pin e il semi-congelato Rabbit R1, spunta un oggetto dalle dimensioni di un dollaro d’argento che non ha la minima intenzione di farsi notare per lo scintillio del marketing, ma per la sostanza. Si chiama OmiGPT, e la sua promessa è tanto modesta quanto potenzialmente devastante: un assistente ChatGPT al polso (o al collo) per meno di un centinaio di dollari.

Sì, hai letto bene. Mentre le Big Tech giocano alla “fantascienza per ricchi” con gadget da 699 dollari in su, una startup di San Francisco ha scelto la via spartana, realista e brutalmente ingegneristica. Dietro a questa creatura hi-tech c’è Nik Shevchenko, che non vuole venderti un sogno, ma qualcosa che userebbe lui stesso, se non altro per non doversi più portare appresso uno smartphone anche solo per salvare una conversazione.

La ministra dell’Università e della Ricerca, Anna Maria Bernini, e il ministro della Scienza e della Tecnologia della Repubblica dell’India, Jitendra Singh, hanno firmato un Memorandum of Understanding per rafforzare la cooperazione bilaterale nel campo della ricerca scientifica e tecnologica tra i due Paesi.

Nel silenzio rotto solo dal suono dei tasti e dai grafici di produttività, un nuovo paradigma si consolida nel cuore pulsante della corporate economy globale: l’intelligenza artificiale non è più una tecnologia da laboratorio, è una manodopera da trincea. E soprattutto, è una manodopera che non sciopera, non chiede ferie, non si ammala e non organizza sindacati. Da PayPal a EY, passando per Meta, Pinterest e l’intera Silicon Valley, si assiste a una mutazione darwiniana dove il lavoratore umano è una specie in via d’estinzione, rimpiazzata da algoritmi affamati di dati e GPU a 5 cifre.

Se c’è un settore dove l’Europa ha storicamente arrancato — tra proclami vaghi e mille “strategia comuni” mai implementate — è proprio la cybersicurezza. Troppa frammentazione, troppe gelosie nazionali, troppi piani che si fermavano alla slide. Ma nel 2023 qualcosa è cambiato. E stavolta non si tratta solo di un fondo da annunciare a Davos.

Parliamo di 27 Centri Nazionali di Coordinamento per la Cybersicurezza, uno per ogni Stato Membro UE. Non centri “di facciata” piazzati in qualche capoluogo per dare una carezza alla politica locale, ma strutture operative, tecniche, integrate in una rete continentale che punta a un obiettivo tanto ambizioso quanto necessario: la difesa digitale coordinata e distribuita.

Il Digital Europe Programme, come lo chiama Bruxelles in uno slancio di creatività anglofona, è l’ennesima colata di miliardi che l’Unione Europea decide di investire per scrollarsi di dosso l’etichetta di vecchia zia lenta della trasformazione digitale. È stato pensato per rendere l’Europa meno dipendente dai cugini americani (Big Tech) e meno vulnerabile alle grinfie digitali di chi, come la Russia, ha capito prima e meglio come si combattono le guerre anche nei cavi di rete.

Parliamo di un pacchetto da oltre 8,1 miliardi di euro, già stanziati all’interno del bilancio pluriennale 2021-2027. Roba seria, in teoria. In pratica, stiamo cercando di correre dietro a un treno che è già passato. Il programma si concentra su cinque aree strategiche: supercalcolo, intelligenza artificiale, cybersicurezza, competenze digitali avanzate e diffusione massiva delle tecnologie digitali, anche e soprattutto tra le PMI e le pubbliche amministrazioni. Esattamente quei settori dove l’Europa ha sempre balbettato tra mille progetti pilota e piani strategici con acronimi inquietanti.

Key Figures. / The DIGITAL Dashboard / Programme in a Nutshell

Nel nuovo rapporto di OpenAI, emerge un quadro chiarissimo e, per certi versi, disturbante per chi ancora si ostina a trattare l’IA come un giocattolino futuristico da laboratorio R&D. Sette aziende leader hanno fatto il salto quantico, adottando l’intelligenza artificiale come leva strategica e non come orpello da PowerPoint. E non parliamo di storytelling da conferenza, ma di risultati misurabili, concreti, da bilancio trimestrale. Quello che le accomuna? Nessuna si è limitata all’hype. Hanno trattato l’IA con la stessa serietà con cui un CFO tratta il debito a lungo termine.

Morgan Stanley ha aperto le danze mostrando che il rigore paga. Ha scelto di partire da valutazioni serrate, modello per modello, caso d’uso per caso d’uso. Niente romanticismi tecnofili: ciò che funziona resta, ciò che non performa si taglia. Questo approccio chirurgico ha permesso alla banca d’investimento di usare l’IA come moltiplicatore della conoscenza interna, in modo affidabile e scalabile. Tradotto: meno tempo perso tra documenti, più risposte in tempo reale, e soprattutto meno consulenze esterne. In un mondo in cui il valore dell’informazione si misura in millisecondi, questo non è un miglioramento, è un’arma.

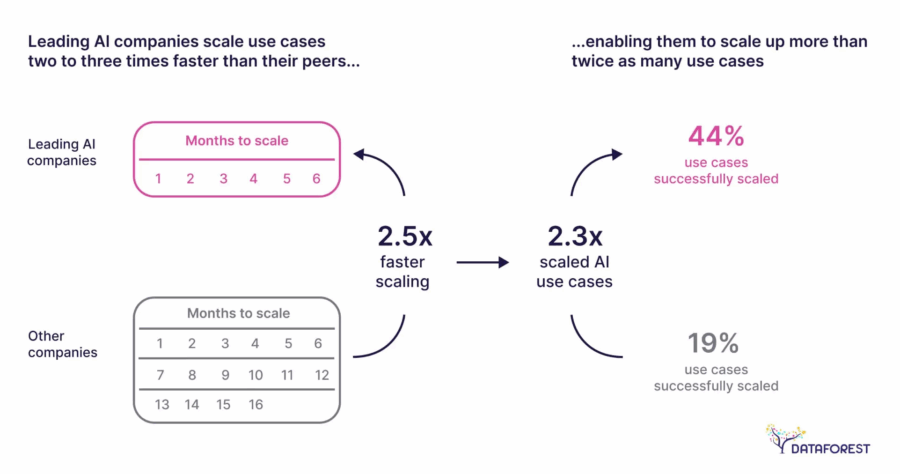

Oggi l’adozione dell’intelligenza artificiale non è più una questione di “se” ma di “come”. Ecco il punto: il vero grattacapo per le aziende non è tanto capire se usare l’AI, ma individuare quei casi d’uso in grado di generare valore reale, concreto, misurabile. Il resto è vetrina per board meeting e slide da consulenti con troppo tempo libero.

Viviamo un’epoca in cui ogni impresa, dal colosso industriale alla startup con il pitch (elevator) in tasca, proclama di “integrare soluzioni di AI”. Peccato che dietro il buzzword o le bullshits si nascondano spesso progetti pilota che restano confinati in sandbox accademici o POC eterni che non scalano mai. Perché? Perché manca strategia, leadership, capacità di distinguere l’automazione utile dal fumo algoritmico.

AML, KYC e KYB compliance

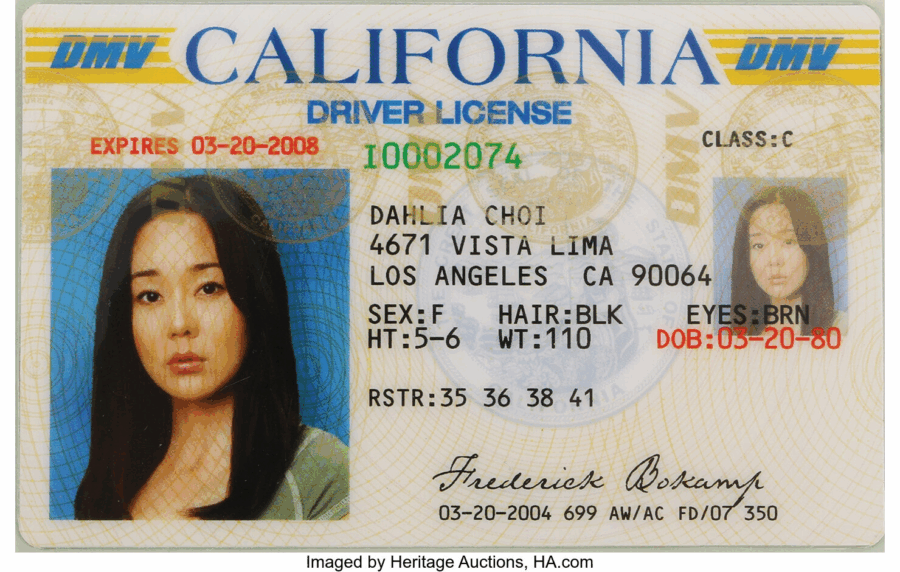

OpenAI ha annunciato che d’ora in poi le organizzazioni che vogliono accedere ai suoi modelli più avanzati dovranno passare per un processo di verifica d’identità. Non si parla di una banale registrazione con email aziendale: si entra nel regno del riconoscimento facciale e del documento ufficiale rilasciato dal governo. Sì, quello con la foto brutta.

Perché? Perché OpenAI, come ogni buon colosso tecnologico che ha finalmente capito che i giocattoli che ha messo al mondo possono essere usati non solo per creare poesie d’amore per gatti, ma anche per scenari meno Disney, ha deciso di mettere le mani avanti. O, meglio, di mettere un bel tornello all’ingresso.

Nel mondo dell’intelligenza artificiale, dove la corsa all’hype è più serrata di quella alle misure di sicurezza, OpenAI ha recentemente aggiornato il suo Preparedness Framework. Un’iniziativa che, almeno sulla carta, dovrebbe garantire che i rischi legati allo sviluppo e alla distribuzione dei loro modelli rimangano sotto un livello accettabile. Ma come ogni comunicato ben confezionato, anche questo odora più di mossa PR che di reale strategia di contenimento.

OpenAI ora utilizza cinque criteri per decidere quando una capacità dell’AI debba essere trattata con anticipo. Un sistema di valutazione che pare uscito da un manuale di risk management aziendale: se una capacità può causare danni seri, se questi sono misurabili, peggiori rispetto al passato, rapidi e irreversibili, allora finisce sotto la lente. In teoria sembra sensato. Nella pratica, è una formula che lascia tutto all’interpretazione: chi decide cosa è “plausibile”? Chi misura il “significativamente peggiore”? Un framework che si presta troppo facilmente alla flessibilità narrativa del momento.

Mentre l’Occidente si distrae con il teatrino della politica interna e i mercati annaspano tra trimestrali tiepide e annunci fumosi sull’IA, Goldman Sachs decide di mandare in trasferta i suoi analisti più svegli per vedere con i propri occhi cosa sta bollendo nella pentola asiatica. Il risultato? Un vero schiaffo morale a Silicon Valley e Washington D.C.: la Cina è avanti. Di brutto. E non solo in un settore, ma in un ecosistema industriale che copre tutto, dai chip fotonici agli eVTOL, passando per robotaxi, server AI, e smartphone dal design impietosamente competitivo.

Il Private Tech Tour 2025 di Goldman è una sorta di via crucis high-tech da Shanghai a Shenzhen, con tappa a Guangzhou, durante il quale i cervelloni della banca d’investimento incontrano 19 aziende selezionate in otto settori critici. Ma la vera notizia non è l’elenco – peraltro interessante – delle società visitate. La notizia è che Goldman torna con un messaggio chiaro: l’Asia, e in particolare la Cina, non sta più inseguendo. Sta guidando. E non ha intenzione di aspettare che l’Occidente si svegli.

Il mondo della tecnologia sta vivendo un’evoluzione profonda e, forse, inevitabile. C’è un movimento crescente che spinge verso la re-distribuzione dei fondi e delle risorse, dove la ricerca di base, quella che ha storicamente permesso alla scienza di progredire, è progressivamente messa da parte a favore di tecnologie più pratiche e già pronte per il mercato. Questo non è semplicemente un cambiamento nei paradigmi di sviluppo, ma un vero e proprio spostamento verso una mentalità più orientata al profitto, con implicazioni che potrebbero essere, se non dannose, almeno molto rischiose per la ricerca stessa.

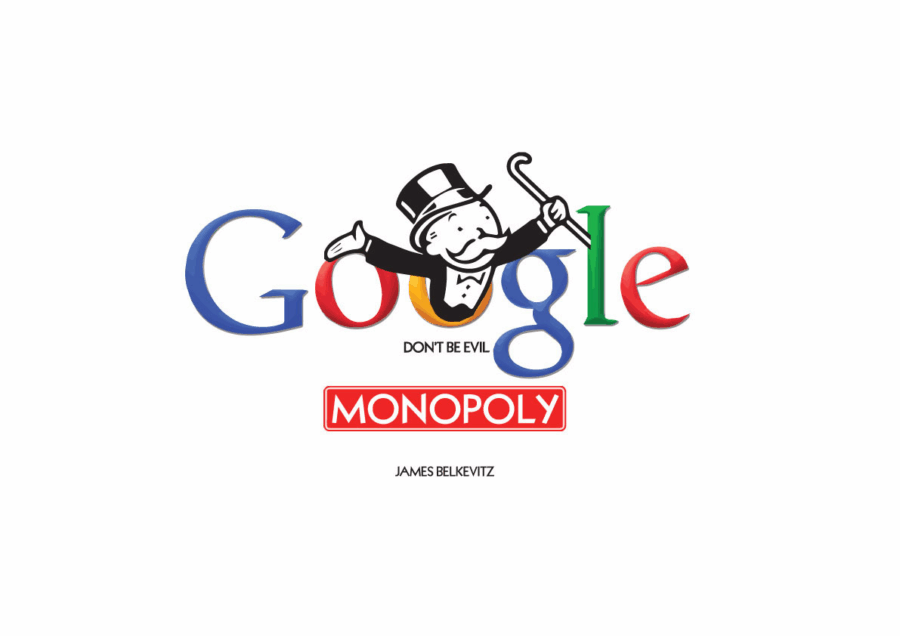

Lo abbiamo visto con i colossi tecnologici come Google e Meta, i quali, una volta pionieri nella promozione della ricerca accademica, sembrano ora adottare una politica più conservativa e commerciale. Google DeepMind, ad esempio, ha fatto passi indietro rispetto alla tradizione di apertura e condivisione della conoscenza.

Negli ultimi anni, i ricercatori di DeepMind hanno sempre più esitato a pubblicare i loro risultati, per evitare di offrire vantaggi competitivi ai rivali nel settore della IA. La concorrenza è feroce, e, piuttosto che puntare a contribuire al bene pubblico, l’azienda sembra preferire strategicamente la protezione del suo vantaggio tecnologico. Questo movimento non è isolato, e si riflette anche nel modo in cui Meta ha recentemente ridotto la priorità per la ricerca fondamentale nell’ambito dell’intelligenza artificiale, come evidenziato dal declino della sua iniziativa FAIR (Fundamental AI Research). Le risorse, che in passato erano destinate all’esplorazione teorica e a progetti di ricerca di lungo termine, sono ora indirizzate verso la creazione di strumenti generativi di intelligenza artificiale che rispondono alle esigenze immediate del mercato.

Seeweb,Nel circo globale dell’intelligenza artificiale, dove le major tech americane si combattono a colpi di modelli chiusi, GPU affamate e NDA degne della CIA, ogni tanto spunta qualcuno che osa dire: “Ehi, e se facessimo le cose in modo aperto, sostenibile e soprattutto, europeo?”. Ecco, quel qualcuno si chiama Seeweb, e la risposta si chiama Regolo.ai.

Il 14 aprile 2025, senza troppa fanfara da palcoscenico ma con parecchia sostanza, Seeweb ha lanciato ufficialmente Regolo.ai: una piattaforma di inference AI pensata per sviluppatori veri, non per guru da keynote. Niente slogan vuoti, ma un’infrastruttura AI full-stack, pronta all’uso, basata su API leggere e modelli performanti. Il tutto cucinato in casa da un team che non ha bisogno di comprare hype a Wall Street, perché gioca in casa nel gruppo DHH, già quotato e ben radicato nell’ecosistema digitale europeo.

Qui non si parla di un altro “tool per la productivity” o di un “assistente AI personale” con nomi da astronave. Regolo.ai è una ferramenta digitale per sviluppatori: ti dà accesso a tutto il ciclo di vita del modello, dall’addestramento all’inferenza, senza dover perdere mesi a configurare GPU o a capire se il tuo provider americano ti sta leggendo i log.

McKinsey, lancia una provocazione che dovrebbe far saltare dalla sedia chiunque occupi una stanza con più di tre monitor: la domanda fondamentale non è se usare l’intelligenza artificiale, ma quanto velocemente sei capace di riscrivere la tua azienda per sopravvivere nel nuovo ordine algoritmico. Sì, perché l’ondata degli AI agents non è solo un’ulteriore moda tecnologica, ma un terremoto operativo e strategico che sta riscrivendo le regole del gioco. E non c’è tempo per i nostalgici.

Qui non si parla di chatbot simpatici o assistenti digitali che rispondono alle email. Stiamo entrando in un’era dove gli agenti AI diventano dirigenti silenziosi, capaci di prendere decisioni, ottimizzare processi, negoziare contratti e, soprattutto, agire in autonomia. La trasformazione non è incrementale. È strutturale. Quindi la vera domanda è: la tua azienda ha il fegato, il codice e la cultura per tenere il passo?

La narrazione dell’onnipotente Google che domina il web inizia a sgretolarsi a colpi di sentenze. Un tribunale federale della Virginia ha inferto un colpo chirurgico al cuore dell’impero pubblicitario di Mountain View, stabilendo che la compagnia ha violato la legge antitrust “acquisendo e mantenendo volontariamente un potere monopolistico” nel settore delle tecnologie pubblicitarie. Non si tratta di una semplice multa o di una reprimenda retorica: è l’inizio di una potenziale disgregazione strutturale del modello di business che ha reso Google il gigante che conosciamo oggi.

La notizia ha il sapore del déjà vu, ma stavolta i numeri sono spietati: dal 25 aprile, i prezzi su Temu e Shein aumentano. Non di qualche spicciolo, ma con una mossa che sa tanto di riposizionamento forzato sul mercato americano, guidato più da Washington che da logiche di business. Il colpo arriva con la delicatezza di un bulldozer: il ritorno del “tariff man” Donald Trump che, ancora in piena campagna elettorale, ha rispolverato il suo armamentario preferito per riequilibrare (a modo suo) la bilancia commerciale con la Cina.

Questa volta l’affondo è chirurgico. Un dazio del 145% sui beni provenienti dalla Cina, fine della cosiddetta “de minimis rule” che consentiva l’ingresso duty-free negli USA per pacchi sotto gli 800 dollari. Una regola che, per anni, ha permesso a Temu e Shein di inondare il mercato statunitense con milioni di pacchi al giorno, facendo leva su logistica iperottimizzata, pricing aggressivo e un uso chirurgico degli influencer per agguantare Gen Z e Millennial.

Quando un colosso come Intel comincia a smettere di respirare innovazione e inizia a respirare burocrazia, è solo questione di tempo prima che qualcuno decida di tagliare via la carne morta. Ed ecco che Lip-Bu Tan, fresco di nomina a CEO, non perde tempo: prende in mano la scure e comincia a “piattire” l’organigramma come un vecchio ingegnere stanco delle chiacchiere in sala riunioni.

Nel giro di poche settimane dalla sua nomina, Tan ha mandato segnali forti. E non stiamo parlando di generici “intenti strategici” alla Harvard Business Review, ma di movimenti concreti. Via le strutture a cipolla, dentro un nuovo assetto in cui i pesi massimi del silicio gruppi storici come quello dei chip per data center, AI e personal computing risponderanno direttamente a lui. Un ritorno all’essenza: meno PowerPoint, più ingegneria.

L’ultimo giocattolo annunciato da xAI – il progetto di Elon Musk, ovvero la sua personale crociata contro OpenAI, Google e tutto ciò che odora di AI mainstream – è l’introduzione della “memoria” su Grok, il suo chatbot integrato nell’ecosistema X (ex Twitter). Niente di nuovo sotto il sole, direbbe chiunque mastichi almeno superficialmente il mondo dei modelli linguistici. La memoria nei chatbot non è una novità, è una feature ormai standard: ChatGPT l’ha integrata già da tempo, Gemini lo stesso. Quello che cambia è il contesto: il solito Musk-style, dove ogni beta diventa evento, ogni update una rivoluzione annunciata, e ogni “coming soon” una campagna marketing camuffata da nota di rilascio.

Google si trova nuovamente al centro delle polemiche per la gestione della trasparenza e della sicurezza dei suoi modelli di intelligenza artificiale, in particolare Gemini 2.5 Pro e la nuova variante Flash. Nonostante le promesse di innovazione e affidabilità, l’azienda è stata criticata per la scarsa chiarezza nei report di sicurezza e per le pratiche di valutazione discutibili.

Il report di sicurezza di Gemini 2.5 Pro è stato definito “scarno” da TechCrunch, sollevando dubbi sulla reale affidabilità del modello. La mancanza di dettagli specifici e l’assenza di una documentazione approfondita hanno alimentato le preoccupazioni sulla trasparenza delle pratiche di Google. Inoltre, l’azienda non ha ancora pubblicato un report per il modello Gemini 2.5 Flash, annunciando che sarà disponibile “presto”, ma senza fornire una data precisa.

Mentre il mondo continua a chiedersi se abbiamo davvero bisogno di un altro assistente vocale, Motorola decide di fare all-in sull’intelligenza artificiale con il prossimo Razr, previsto per il 24 aprile. Non sarà solo un altro pieghevole nostalgico, ma una piattaforma sperimentale per una nuova battaglia tra colossi: Gemini vs Perplexity. E a quanto pare, Motorola non intende restare neutrale.

La notizia arriva da Bloomberg, che conferma una partnership tra Motorola e Perplexity. L’assistente vocale AI sviluppato da quest’ultima non sarà solo una comparsa. Avrà il suo posto a bordo del Razr accanto a Gemini, ma con una UI personalizzata e una spinta di marketing che lascia intuire dove Motorola voglia veramente portare i suoi utenti. Il teaser pubblicato sui social, dove il Razr si trasforma nella parola “AI”, non è solo estetica: è una dichiarazione di intenti.

Nel perpetuo teatro della guerra per l’egemonia dell’intelligenza artificiale, Elon Musk ha appena piazzato un nuovo pezzo sulla scacchiera. Si chiama Grok Studio e rappresenta la versione xAI di un campo da gioco creativo e tecnico, qualcosa a metà tra un Google Docs potenziato, un IDE collaborativo e un’interfaccia AI generativa per chi pensa che l’interfaccia utente perfetta debba assomigliare a un canvas condiviso con HAL 9000.

Lanciato il 16 aprile, Grok Studio entra in diretta competizione con le esperienze “canvas-based” di ChatGPT e Claude, ribaltando il tavolo con qualche mossa ben calibrata sul piano dell’usabilità. A differenza dell’approccio quasi minimalista adottato da Anthropic con Artifacts, o la verticalizzazione funzionale di OpenAI con ChatGPT Canvas, xAI punta tutto su un’interazione immersiva, potenziata, dove l’AI non è solo assistente ma partner operativo — e anche un po’ intrusivo, se vogliamo.

Jensen Huang non è un CEO qualsiasi. È un fondatore con il carisma di un rockstar e la strategia di un generale in guerra. La sua visita a sorpresa a Pechino non è solo un gesto diplomatico: è una mossa tattica in una partita a scacchi globale dove la tecnologia è il nuovo petrolio. Un giorno prima, gli Stati Uniti avevano imposto nuove restrizioni sull’esportazione dei chip H20 di Nvidia verso la Cina, con una perdita stimata di 5,5 miliardi di dollari. Il giorno dopo, Huang era già a cena con i cinesi, come se nulla fosse. O meglio, come se tutto fosse in gioco.

La visita, orchestrata con la discrezione che si riserva agli incontri tra rivali con interessi comuni, è avvenuta su invito della China Council for the Promotion of International Trade, un organo statale che ormai gioca il ruolo di ambasciatore ombra tra Pechino e le grandi corporate americane. Huang si è incontrato con il presidente Ren Hongbin, promettendo che Nvidia “non risparmierà sforzi” per ottimizzare i suoi prodotti secondo i vincoli normativi, e che “servirà in modo incrollabile” il mercato cinese. Tradotto dal linguaggio diplomatico: Nvidia farà tutto il necessario per non perdere la Cina, anche a costo di disegnare chip su misura per un Paese sotto embargo.

Mentre i giganti del tech si azzuffano a colpi di algoritmi e hardware sempre più “intelligente”, Huawei ha deciso di rifarsi il trucco o meglio, il titanio e rilanciare sul mercato i suoi occhiali intelligenti di seconda generazione. La nuova versione, battezzata con modestia Huawei Smart Glasses 2 Titanium, promette di fare di più, meglio e con più stile… almeno a detta loro. Prezzo? 2.299 yuan, che al cambio sono circa 315 dollari. Per un paio di occhiali che fanno tutto tranne che servirti il caffè (per ora).

Huawei cerca così di piazzarsi meglio in una giungla affollata di occhiali “smart” dove il vero collante è l’intelligenza artificiale generativa, la stessa che muove ChatGPT. Da Baidu a ByteDance, da Xiaomi ad Alibaba, tutti vogliono un pezzo della torta. E il profumo è quello tipico dei mercati emergenti con margini ancora tutti da scrivere: più di 1,5 miliardi di occhiali (tra da vista e da sole) venduti ogni anno rappresentano un bacino potenziale enorme per l’iniezione di intelligenza artificiale nel quotidiano.

L’uovo di Pasqua più interessante quest’anno non contiene cioccolato, ma neuroni sintetici, directory iper-curate e un discreto profumo di intelligenza artificiale. Il merito? Va dato al grande Fabrizio Degni, che ha aggiornato la sua già leggendaria lista delle risorse online dove l’AI non è solo una sigla ma una realtà pulsante di strumenti, tips, trick e comunità pronte a tutto, tranne che a dormire.

E siccome la Pasqua è il tempo della resurrezione, anche questa lista risorge, aggiornata e arricchita, pronta a servire chi vuole davvero capire dove sta andando il mondo senza dover passare per LinkedIn o peggio, i soliti espertoni da Bar dei Daini.

Nel silenzio in cui solitamente le Big Tech rilasciano aggiornamenti camuffati da “note tecniche”, OpenAI ha fatto qualcosa di diverso: ha pubblicato una guida ufficiale, gratuita e maledettamente utile per domare GPT-4.1. E no, non è la solita lista di buone intenzioni da community manager, ma un compendio pragmatico per chi con l’AI non ci gioca, ma la piega al proprio volere per lavorare meglio, più velocemente e con risultati da CEO.

Siamo finalmente arrivati al punto in cui l’AI non ha più bisogno di essere “magica”, ma precisa, documentata e controllabile. Il che, per chi ha un minimo di esperienza, significa solo una cosa: scalabilità vera. Ma vediamo perché questa guida è un evento epocale sotto il profilo tecnico-strategico e perché ogni CTO con un neurone attivo dovrebbe stamparsela e impararla meglio del manuale della Tesla.

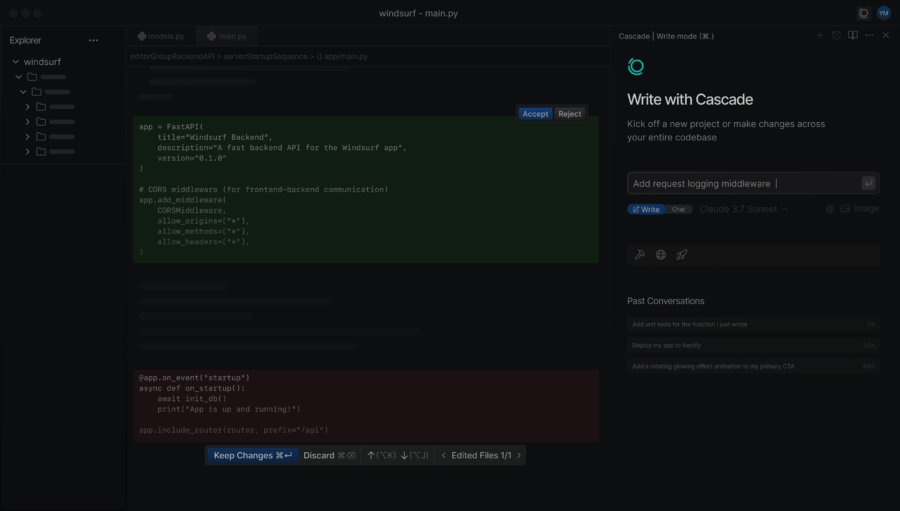

OpenAI sta valutando l’acquisizione di Windsurf, l’IDE “agentico” sviluppato da Codeium, per una cifra che si aggira intorno ai 3 miliardi di dollari . Se l’accordo dovesse concretizzarsi, rappresenterebbe la più grande acquisizione nella storia di OpenAI.

Windsurf si distingue per la sua capacità di combinare le funzionalità di un copilota AI con quelle di un agente autonomo. Questo approccio consente agli sviluppatori di collaborare con l’intelligenza artificiale in modo più fluido e intuitivo, migliorando la produttività e riducendo gli errori .

Tra le caratteristiche principali di Windsurf troviamo la funzione “Cascade”, che permette una comprensione profonda del codice e suggerimenti contestuali in tempo reale. Inoltre, l’IDE supporta l’editing multi-file e l’esecuzione di comandi intelligenti, facilitando la gestione di progetti complessi.

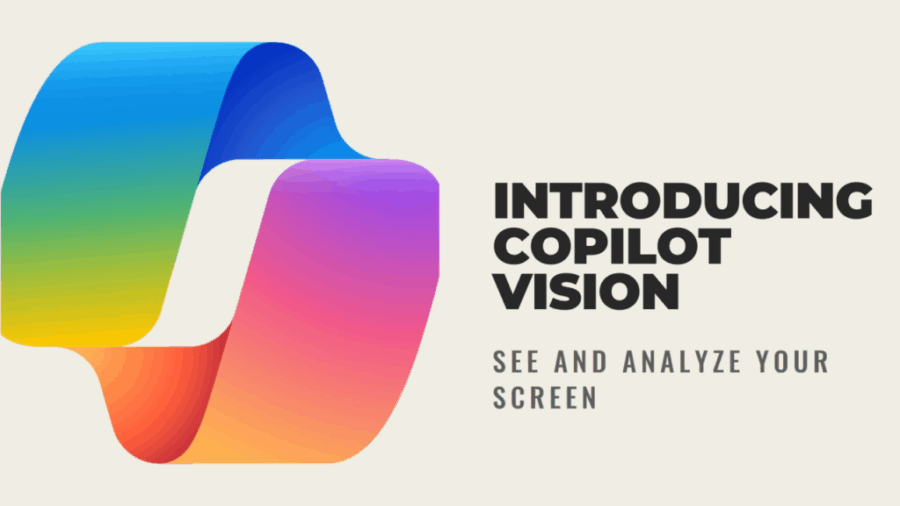

C’è una nuova voce nell’aria letteralmente – ed è quella di Copilot Vision, il nuovo giocattolo AI che Microsoft ha deciso di mettere a disposizione gratuitamente per chi usa il browser Edge. Il CEO della divisione AI di Microsoft, Mustafa Suleyman, l’ha annunciato su Bluesky con tono entusiasta, ma il sottotesto è chiaro: Microsoft vuole che lasciamo che il suo assistente virtuale veda tutto quello che vediamo noi.

Sì, hai letto bene: una volta attivato, Vision è in grado di “vedere” ciò che è sul tuo schermo e rispondere in tempo reale con suggerimenti, assistenza contestuale e commenti a voce. Un’esperienza “talk-based”, come la definiscono a Redmond, dove tu parli all’aria e aspetti che il tuo browser risponda. Cose da 2025, ma con un retrogusto da episodio distopico di Black Mirror.

Quando anche i giganti cambiano idea, di solito c’è un odore nell’aria: quello della competizione che comincia a bruciare sul collo. Google aveva promesso che Gemini Live, la sua feature AI con super-poteri visivi, sarebbe rimasta un’esclusiva per chi sborsava l’abbonamento Gemini Advanced. Ma oggi, con una mossa che sa più di ritirata strategica che di generosità improvvisa, ha deciso di renderla disponibile gratuitamente a tutti gli utenti Android attraverso l’app Gemini.

Nel grande show dell’intelligenza artificiale, OpenAI cala due assi: o3 e o4-mini, i nuovi modelli di ragionamento destinati a cambiare il gioco o almeno a riscriverne le regole con un tratto più sottile, più veloce e, sorprendentemente, visivo. Non siamo più nel campo dell’elaborazione del linguaggio, siamo nella frontiera in cui un modello guarda, osserva, riflette e agisce. E sì, ragiona con immagini.

Partiamo dal pezzo forte, o3, che OpenAI presenta come il suo modello “di ragionamento più potente”. Cosa significa? Che l’era del semplice completamento predittivo delle frasi è finita. Qui si parla di catene logiche complesse, inferenze tra testi e immagini, collegamenti dinamici tra fonti, strumenti e rappresentazioni visuali. Lo definiscono “reasoning model” ma sotto il cofano è una macchina epistemologica. E se suona esagerato, basta vedere cosa fa: integra immagini direttamente nella catena di pensiero, analizza schizzi, whiteboard, zooma su dettagli e ruota immagini per inferire concetti. Come se un architetto, uno scienziato e un designer si fossero fusi in un’unica entità che dialoga in tempo reale con te.

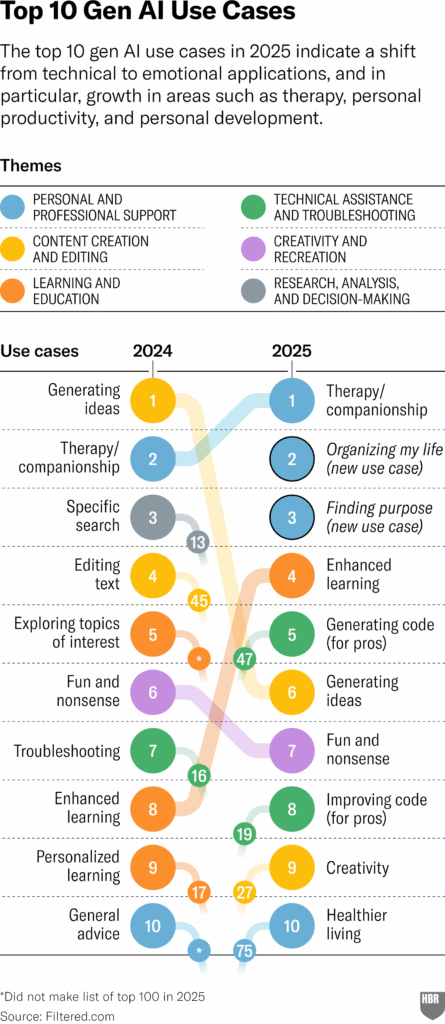

Nel 2025, l’Intelligenza Artificiale Generativa ha finalmente fatto coming out. No, non è diventata più intelligente. È diventata più… umana. E se nel 2024 l’ossessione era “come sfruttarla per costruire la prossima startup da un miliardo”, oggi il mood è un altro: come cavolo sopravvivere al casino della vita moderna.

Se pensavi di tirare avanti fino alla pensione facendo quello che hai sempre fatto, ho brutte notizie per te: il futuro del lavoro ha già fatto irruzione nel presente. Secondo il Future of Jobs Report 2025 del World Economic Forum, il 59% della forza lavoro globale dovrà essere riqualificata entro il 2030. Non “potrebbe” o “sarebbe bene”: dovrà. Tradotto: più della metà dei lavoratori oggi non ha le competenze che serviranno domani. Ma la parte davvero tragica? Non tutti avranno accesso a questa riqualificazione. E no, non ci sarà nessun sindacato, bonus statale o HR compassionevole che potrà salvarti se ti trovi dalla parte sbagliata di questa rivoluzione.

La causa? L’Intelligenza Artificiale. Sì, quella parola che ormai viene buttata in ogni frase come il prezzemolo nelle cucine di Masterchef. Ma stavolta non è una moda. L’AI non è solo una tecnologia. È una forza trasformativa alla pari della macchina a vapore della Rivoluzione Industriale. E chi dorme ora, finirà rottamato domani, come le cabine telefoniche o i middle manager inefficienti.

Non è una doccia fredda. È una glaciazione. Nvidia, il colosso americano dei chip AI, si ritrova improvvisamente a fare i conti con un colpo basso da Washington che rischia di cancellare quasi il 10% del suo fatturato globale. Un licensing obbligatorio per esportare gli H20 in Cina – chip già “castrati” per evitare restrizioni precedenti – suona più come una mossa geopolitica che una protezione tecnica. Risultato? ByteDance, Tencent e Alibaba – tutti affamati di potenza di calcolo – ora dovranno fare i conti con un futuro in cui Nvidia scompare dagli scaffali, e l’unica alternativa realistica è il “fai da te” made in China.

Nvidia si è già vista tagliare fuori in passato, ma con l’H20 aveva trovato un compromesso: un chip “legalmente accettabile”, depotenziato ma ancora abbastanza potente da servire gli LLM cinesi. Ora però il sipario cala di nuovo. Si parla di un impatto da 5,5 miliardi di dollari. Roba da convocare il consiglio d’amministrazione con whiskey e calmanti. E mentre Nvidia si lecca le ferite, le Big Tech cinesi non si piangono addosso: stanno correndo. Non per scelta, ma per necessità.

Microsoft non poteva restare a guardare mentre OpenAI e Anthropic si facevano i propri maggiordomi digitali personali. Così questa settimana ha sganciato il suo colpo: una nuova funzione per Copilot Studio chiamata, in perfetto stile Silicon Valley, “computer use”. Tradotto: l’intelligenza artificiale di Redmond ora può usare il tuo computer come farebbe un umano. Ma senza sindacati, pause caffè o click sbagliati dovuti alla noia.

In pratica, Copilot Studio potrà cliccare bottoni, scrivere nei campi di testo, aprire menu a tendina e — cosa ben più interessante — interagire con applicazioni desktop e siti web anche quando non esistono API ufficiali. L’AI impara dall’interfaccia utente visiva. Se un umano può farlo guardando lo schermo, l’agente AI può farlo anche meglio. O almeno ci prova.

Martedì, Nvidia ha acceso l’allarme rosso nei mercati dichiarando un colpo da 5,5 miliardi di dollari sulle sue finanze, un’anticipazione tutt’altro che digeribile per Wall Street. Il motivo? Le nuove, ennesime, restrizioni imposte dal governo degli Stati Uniti sulla vendita di chip per l’intelligenza artificiale e altre attrezzature hi-tech verso la Cina. Un déjà vu geopolitico che si trasforma, ancora una volta, in un bagno di sangue finanziario.

Il titolo Nvidia ha perso subito quota, lasciando sul terreno un secco 6% nelle contrattazioni after-hours. Non è una flessione qualsiasi: è un termometro emotivo, un segnale di panico sotto la superficie dorata del Nasdaq. Il gigante dei semiconduttori ha spiegato che l’onere è legato a inventario, impegni di acquisto e riserve associate ai chip H2O, quei gioiellini di silicio creati su misura per i clienti cinesi. Insomma: una Ferrari costruita per un mercato che ora rischia di finire sotto embargo. Non il massimo del timing.

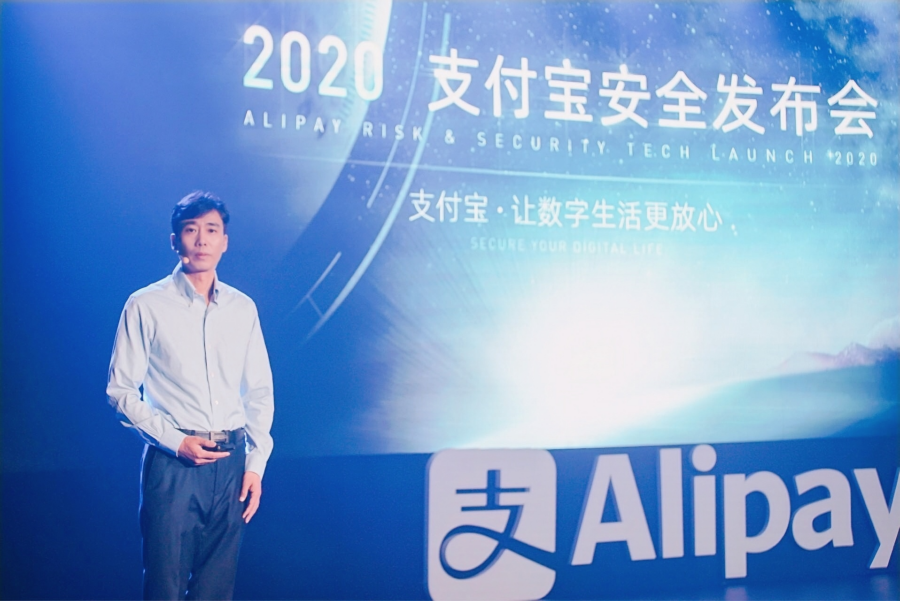

Mentre l’Occidente ancora dibatte sulla privacy dei dati sanitari e sull’etica dell’intelligenza artificiale applicata alla medicina, Ant Group la fintech figlia prediletta del colosso Alibaba ha già messo online cento dottori virtuali. O meglio: cento agenti AI, addestrati direttamente dai team di celebri medici cinesi e pronti a rispondere 24 ore su 24 tramite l’app Alipay. Non si tratta di chatbot generici: ognuno di questi agenti è modellato su un luminare in carne ed ossa, e promette “consigli autorevoli e credibili” con il tocco freddo ma immediato del silicio.

Sì, la sanità in Cina sta diventando un prodotto plug-and-play, un servizio embedded nell’ecosistema digitale di una super app. Il cittadino non deve più neppure uscire da Alipay originariamente un’app di pagamento per ottenere diagnosi, consulenze, analisi di referti caricati via smartphone e perfino prenotazioni per visite in presenza. Il cerchio è chiuso, l’utente è fidelizzato, il medico è virtuale.

Nel cuore di Pechino, sotto i riflettori di una presentazione aziendale con toni più da show business che da tech conference, Kuaishou ha lanciato Kling AI 2.0, definendolo – senza mezzi termini – “il modello di generazione video più potente al mondo”. Lo ha detto con tono trionfale Gai Kun, vicepresidente senior dell’azienda, mentre tutto il resto dell’industria dell’IA video globale stava probabilmente trattenendo il respiro, cercando di capire se fosse una sparata di marketing o la verità nuda e cruda.

Nel frattempo, numeri alla mano, Kling sta già scrivendo le sue regole. Oltre 22 milioni di utenti nel mondo, 168 milioni di video generati, più di 344 milioni di immagini sputate fuori da un’intelligenza artificiale che si nutre di prompt come un influencer si nutre di like. Sì, numeri da piattaforma mainstream, non da progetto sperimentale.

Nel teatrino sempre più affollato e teatrale dell’intelligenza artificiale, Anthropic si prepara a salire di tono letteralmente con l’introduzione imminente di una “voice mode” per il suo chatbot Claude. Secondo quanto riportato da Bloomberg, la nuova funzionalità vocale dovrebbe debuttare già questo mese, segnando un passo audace (e atteso) per avvicinarsi alla già consolidata esperienza conversazionale di ChatGPT, che integra da tempo un’interfaccia vocale sofisticata.

Per ora, il sipario si apre su tre voci in inglese, battezzate con poetica intenzione: Airy, Mellow e Buttery. Già dai nomi si intuisce la volontà di costruire un’esperienza sonora non solo funzionale, ma sensorialmente curata, in un tentativo di umanizzazione dell’interazione con l’AI. Per chi mastica branding, non è un dettaglio: non si tratta solo di “parlare”, ma di come si parla all’utente.