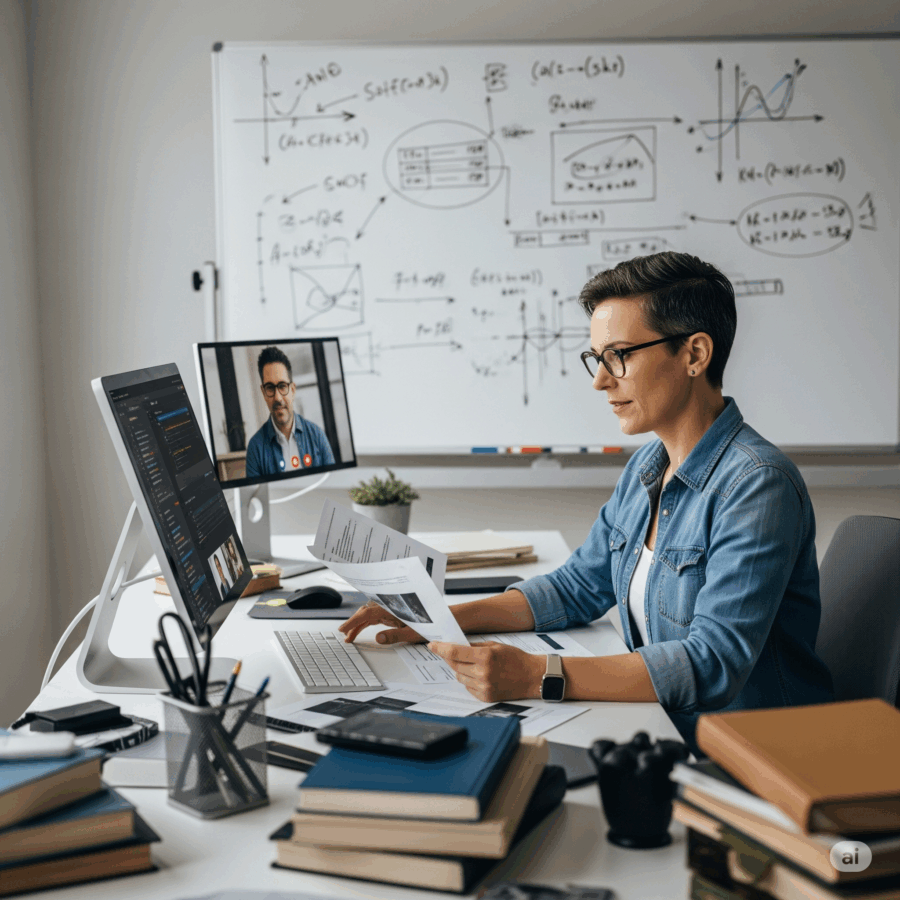

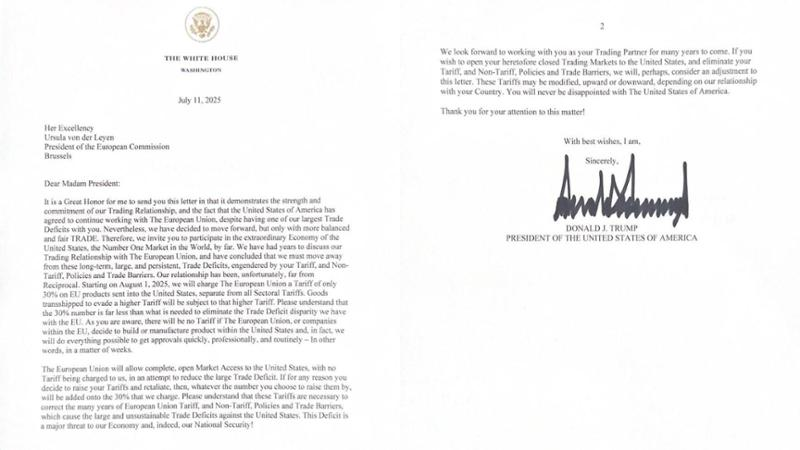

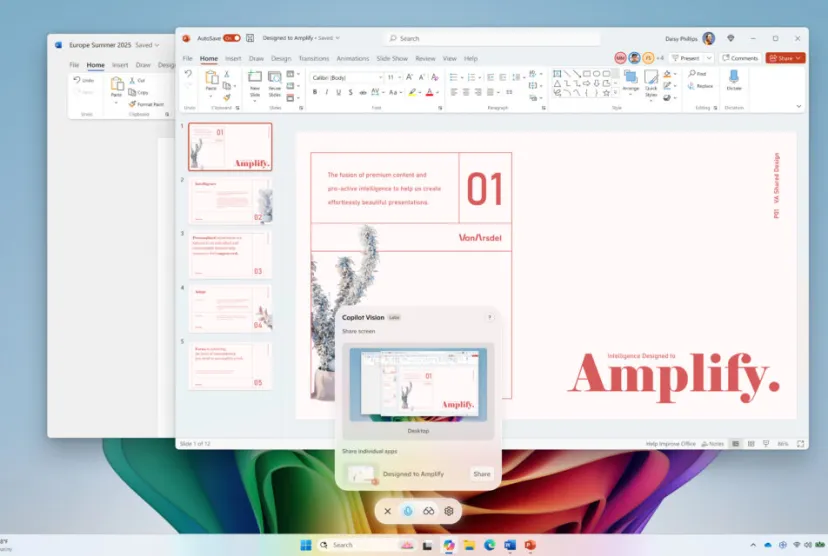

C’è un momento preciso in cui la tecnologia smette di essere un semplice strumento e diventa un’estensione del nostro pensiero. Microsoft, con l’ultimo aggiornamento di Copilot Vision per Windows Insiders, ha appena varcato quella soglia. La narrazione ufficiale è elegante: un assistente intelligente che finalmente “vede” tutto ciò che c’è sullo schermo, non più limitato a due app contemporaneamente, ma capace di analizzare l’intero desktop o qualsiasi finestra di un browser o di un’app. La traduzione reale è meno poetica: stiamo iniziando a dare in pasto il nostro ambiente digitale completo a un’intelligenza artificiale che impara osservandoci. Sembra banale, ma non lo è affatto.