Foxconn è stufa di essere vista come il braccio operaio di Apple. Non vuole più solo stringere bulloni per iPhone da 1.000 dollari e margini da fame. La direzione è tracciata: infrastruttura per l’intelligenza artificiale. Ed è una direzione con cui nessuno a Taipei vuole scherzare. Mercoledì è arrivato l’annuncio: una partnership strategica con Teco Electric & Machinery, il colosso taiwanese dei motori industriali, per entrare con forza nel mercato globale dei data center dedicati all’AI. Non in modo decorativo, ma strutturale, fisico, concreto. Come in “server rack”, “UPS”, “raffreddamento”, “infrastruttura elettrica”, “espansione planetaria”. Una dichiarazione di guerra, non un comunicato stampa.

Categoria: News Pagina 21 di 118

Rivista.AI e’ il portale sull’intelligenza artificiale (AI) attualita’, ultime notizie (news) e aggiornamenti sempre gratuiti e in italiano

La notizia è sottile come una lama e taglia in profondità: la Cyberspace Administration of China ha convocato ufficialmente Nvidia per chiedere conto dei presunti rischi di sicurezza legati ai chip H20, puntando il dito su una questione tanto tecnica quanto geopolitica: il cosiddetto “back door safety”. In parole povere, Pechino vuole sapere se quei chip possono essere tracciati o controllati da remoto, e se sì, da chi.

Chi mastica un po’ di strategia globale lo sa già: questa non è solo una questione di ingegneria dei semiconduttori. È una schermaglia digitale in una guerra fredda 2.0 dove il controllo delle AI, della potenza computazionale e dei dati non è più solo una priorità industriale, ma una questione di sovranità. E quando la Cina chiama, non lo fa per cortesia istituzionale. Lo fa perché ha il coltello dalla parte del silicio. Nvidia, da parte sua, è costretta a giocare una partita a scacchi bendata, dove ogni chip può diventare un caso diplomatico.

Dodici miliardi di dollari. Annualizzati, sia chiaro. Bastano sette mesi e OpenAI che ancora viene definita “startup” da chi ignora cosa significhi crescere più in fretta della regolamentazione raddoppia il suo fatturato e si posiziona in orbita. Non è solo un numero da riportare nei bilanci, ma un’asserzione di potere industriale. Tradotto in linguaggio terra-terra: il creatore di ChatGPT macina un miliardo di dollari al mese. Ogni giorno che passa, la Silicon Valley diventa un po’ più simile alla Federal Reserve.

Questa non è più l’intelligenza artificiale come ce la raccontavano nei podcast del 2023. Questa è l’ingegneria di una nuova egemonia cognitiva. E non è un caso che Microsoft, il cavaliere bianco col bilancino da investment banker, sia lì a raccogliere dividendi reputazionali con un sorrisetto da chi ha letto il finale prima degli altri. Ma andiamo per gradi o almeno fingiamo di farlo.

Quando un gigante come Microsoft presenta risultati trimestrali che sembrano usciti da un romanzo di fantascienza, vale la pena fermarsi a riflettere. Nel quarto trimestre fiscale 2025, il colosso di Redmond ha letteralmente polverizzato le aspettative, con utili per azione di 3,65 dollari contro i 3,38 previsti e ricavi che hanno toccato quota 76,44 miliardi di dollari, molto oltre i 73,83 stimati. Se vi state chiedendo se si tratti solo di numeri da Wall Street, la risposta è no: dietro quei dati c’è una trasformazione tecnologica che sembra aver trovato la sua macchina a propulsione nucleare nella nuvola intelligente e nell’intelligenza artificiale.

Giuliano Martinelli, Tommaso Bonomo, Pere-Lluís Huguet Cabot,

and Roberto Navigli Sapienza NLP Group, Sapienza University of Rome

Bookcoref e la rivoluzione nella risoluzione delle coreferenze sui testi lunghi

La risoluzione delle coreferenze, quel delicato passaggio che consente a un sistema di riconoscere che “lui”, “John” e “il ragazzo” possono riferirsi allo stesso personaggio, è storicamente confinata a brevi spezzoni di testo. OntoNotes, LitBank e compagnia sono i soliti noti, ma mostrano la corda appena il testo supera i diecimila token, figuriamoci un romanzo intero. In questo contesto si inserisce BookCoref, un benchmark che alza la posta e sfida i limiti dei modelli di NLP a lavorare su libri interi, portando la risoluzione delle coreferenze da mera palestra a vero e proprio campo di battaglia.

Quando OpenAI ha lanciato la modalità agente di ChatGPT, la Silicon Valley ha applaudito. I CISO hanno digrignato i denti. Perché l’intelligenza artificiale, quella che non chiede più “come posso aiutarti?” ma agisce in silenzio nei meandri del tuo browser, è qualcosa che nessuna ISO 27001 aveva previsto. Il risultato? Agenti di intelligenza artificiale che scrivono, leggono, decidono e firmano per te. Letteralmente.

Massimiliano Graziani di Cybera, uno che i rischi non li legge ma li decifra, lo dice senza mezzi termini:

“Oggi abbiamo sensazioni positive, ma alcune AI se non regolamentate potrebbero autonomamente decidere di cambiare le regole e sostituire l’umano”. Questo non è un dettaglio tecnico.

È un avvertimento da incorniciare. Il pericolo non è più che qualcuno rubi i tuoi dati, ma che l’agente AI, convinto di fare la cosa giusta, li invii da solo al peggior destinatario possibile e lì, come spiega Graziani,

il sangue sarà digitale, con odore di criptovaluta in wallet fantasma pronti a ricevere fondi da bonifici approvati da macchine fuori controllo.

Mark Zuckerberg, l’uomo che ha trasformato Facebook in Meta per inseguire l’utopia del metaverso, ora ci riprova con un’altra mossa al confine tra narcisismo tecnologico e delirio di onnipotenza. La nuova frontiera? Una “superintelligenza personale”, ovvero una versione altamente individualizzata di AGI (Artificial General Intelligence), condita da un post sul blog in pieno stile manifesto visionario, come solo lui sa fare. Ovviamente, accompagnato da un video promozionale con l’ormai iconica postura da CEO che ha appena scoperto il futuro. Spoiler: il futuro, secondo Zuck, è ancora una volta dentro Meta.

L’accordo tra Amazon e il New York Times per l’addestramento di modelli di intelligenza artificiale non è solo una notizia. È un segnale d’allarme per l’intero ecosistema dell’informazione. E no, non è una novità che le big tech cerchino dati di qualità per nutrire i loro modelli. La novità è che adesso si stanno comprando direttamente le redazioni. Venticinque milioni di dollari l’anno non sono solo un prezzo. Sono un test, una prova muscolare. Una dichiarazione di intenti.

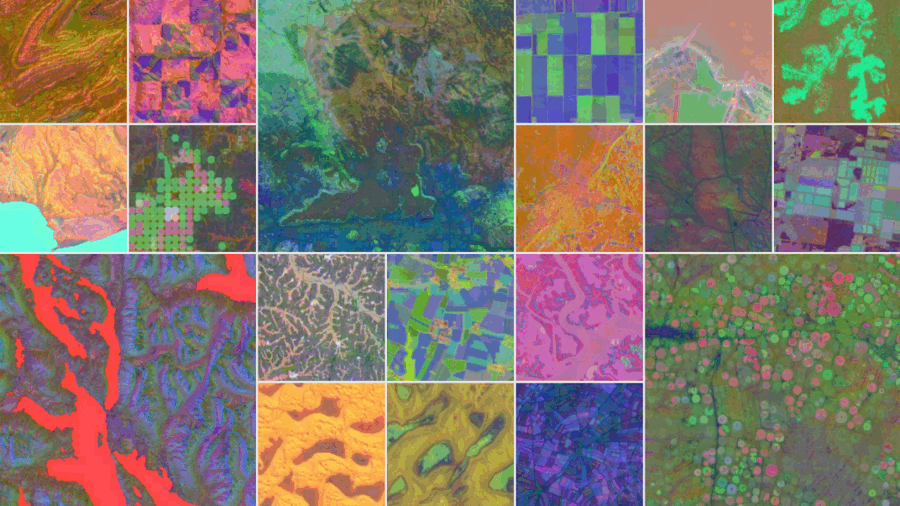

Benvenuti nella nuova fase del dominio algoritmico. Quando Google definisce la sua ultima creatura “un satellite virtuale”, non lo fa per gioco. AlphaEarth Foundations, sviluppato con DeepMind, non è semplicemente un modello AI. È l’inizio di una riscrittura radicale del concetto stesso di geografia. Altro che mappe: questa intelligenza artificiale assorbe immagini satellitari, radar, simulazioni climatiche, dati multispettrali e persino sensori oceanici, li metabolizza, li fonde e restituisce una lettura della Terra con un dettaglio che nessun satellite, da solo, ha mai potuto offrire.

Le aziende parlano di intelligenza artificiale come se fossero tutte a un passo dal diventare la prossima OpenAI. Slide patinate, piani decennali, comitati per l’etica algoritmica che si riuniscono rigorosamente dopo l’aperitivo del venerdì. Poi guardi i dati. E scopri che sotto il vestito non c’è (ancora) niente. L’ultima valutazione di Gartner sulla maturità AI è uno specchio impietoso che riflette una realtà che chi vive nel mondo tech conosce fin troppo bene: il desiderio c’è, ma le fondamenta sono di cartapesta.

L’ambizione, in effetti, non manca. Chi guida oggi le aziende vuole la luna: intelligenze artificiali integrate ovunque, decisioni data-driven, automazioni intelligenti che riducono costi e moltiplicano margini. Ma il problema non è la visione. È la dissonanza. Gartner lo chiama “maturity gap”, una discrepanza di due o tre livelli tra lo stato attuale e gli obiettivi desiderati in tutte le aree chiave dell’adozione AI. Tradotto: si sogna in grande, ma si lavora ancora con i mattoni sbagliati.

Anche i giganti si inchinano, ma non senza mordersi la lingua. Dopo OpenAI, è il turno di Google: il colosso di Mountain View ha annunciato di aver firmato il Codice di condotta AI UE, la tanto dibattuta iniziativa volontaria che dovrebbe (in teoria) garantire lo sviluppo sicuro e responsabile dei cosiddetti modelli fondazionali nell’ambito europeo. Peccato che il sostegno, più che entusiasta, suoni come un “sì, ma con riserva”. E il sottotesto è chiarissimo: la firma è uno scudo diplomatico, non un atto di fede normativa.

Non serviva una sfera di cristallo per prevedere che prima o poi sarebbe arrivato: un’intelligenza artificiale che non si limita a suggerirti formule o a colorare celle, ma che si appropria di Excel con la stessa spietata efficienza con cui un hedge fund cannibalizza una startup in crisi. Si chiama Shortcut, un nome talmente semplice da suonare arrogante. E forse lo è davvero. Nelle demo pubblicate su X, l’agente AI ha già umiliato intere generazioni di analisti junior, completando in pochi secondi modelli DCF che di solito occupano le notti insonni dei neolaureati in finanza.

C’è un nuovo lessico nel mondo dell’intelligenza artificiale. Non ha a che fare con parole dette, scritte o pensate. Non si legge in un libro né si sente da un podcast. È il linguaggio grezzo, sporco e impietoso del corpo umano, finalmente trasformato in frasi leggibili grazie a SensorLM, la nuova creatura di Google Research. Altro che LLM generalisti. Questa volta parliamo di un dizionario per le pulsazioni, i micromovimenti, le variazioni impercettibili del passo. La vera rivoluzione linguistica non riguarda ChatGPT o Gemini, ma il fatto che Google ora può raccontarti, in linguaggio naturale, cosa stavi facendo quando il tuo cuore ha saltato un battito alle 03:47 di notte.

SensorLM è un modello fondamentale, pre-addestrato su quasi 60 milioni di ore di dati biometrici raccolti in meno di tre mesi, da oltre 100.000 persone in 127 paesi. Non è una questione di scale, è una dichiarazione di egemonia. La fonte? Gli onnipresenti Fitbit e Pixel Watch. Un’armata silenziosa di polsi connessi ha alimentato un’infrastruttura semantica che ora può descrivere il corpo umano come se fosse un libro aperto. Il dettaglio che colpisce non è solo la quantità mostruosa di dati, ma il fatto che Google abbia trasformato quel materiale prelinguistico in narrazione coerente, precisa e contestualizzata. Come se un accelerometro potesse finalmente scrivere poesie.

Alcuni utenti stanno già vedendo riferimenti diretti a “GPT-5-prime” accanto ai modelli noti come GPT-4o nella UI di ChatGPT. E se c’è una lezione che l’industria ha imparato (e spesso dimenticato) è questa: OpenAI non fa trapelare nulla per caso. Quindi se un nome come GPT-5 compare anche solo per un istante nell’interfaccia di un utente pubblico, non è un bug. È marketing strategico mascherato da incidente tecnico.

Quello che emerge dai primi report è inquietantemente interessante. GPT-5-prime sembrerebbe una nuova architettura ibrida, una fusione fra l’approccio multimodale di GPT-4o e l’autorevolezza algoritmica che i modelli “grandi” avevano iniziato a perdere terreno a favore di Claude Sonnet 3.5, Cursor e infine Claude 4 Sonnet. OpenAI, se i dettagli sono confermati, starebbe reagendo non solo per riprendersi lo scettro nella mente degli sviluppatori, ma per ridefinire la categoria: da LLM ad intelligenza conversazionale adattiva, più simile a un copilota mentale che a un semplice chatbot.

Se pensavi che l’Intelligenza Artificiale fosse una moda passeggera, tipo Clubhouse o il metaverso secondo Zuckerberg, è arrivato il momento di aggiornare il tuo software mentale. Il Regno Unito ha appena staccato un assegno da 15 milioni di sterline per l’Alignment Project, una nuova iniziativa internazionale finalizzata a risolvere il problema più inquietante (e pericolosamente sottovalutato) dell’IA: l’allineamento degli obiettivi tra esseri umani e sistemi intelligenti. Tradotto in termini più brutali: evitare che la prossima superintelligenza decida di ottimizzare il pianeta eliminando l’elemento meno efficiente, ovvero noi.

Sì, perché il termine “allineamento dell’intelligenza artificiale” non è una trovata linguistica da documento strategico europeo, ma una questione esistenziale. Non stiamo parlando di rendere l’IA più simpatica o educata, ma di garantirci che, quando le daremo il potere di prendere decisioni autonome, non cominci a interpretare “massimizza la felicità umana” come “spegni internet, chiudi Netflix e metti tutti a coltivare patate per l’eternità”.

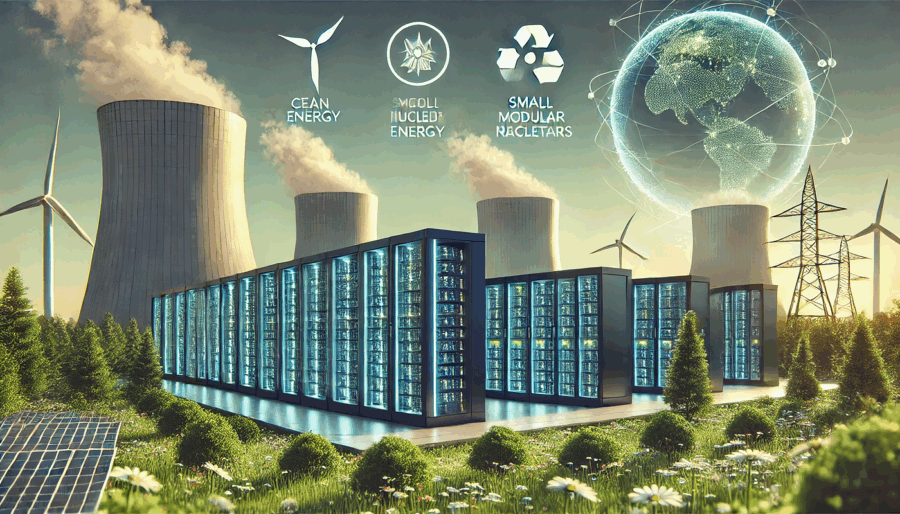

Chi paga il conto dell’intelligenza artificiale? Non chi la usa. Non chi la governa. Nemmeno chi la promuove con entusiasmo evangelico nei convegni. A pagarlo, lentamente ma inesorabilmente, sono le reti elettriche nazionali, le bollette dei consumatori e, incidentalmente, il pianeta. L’intelligenza artificiale, così come la intendono oggi i colossi tecnologici americani, è una macchina insaziabile alimentata da energia bruta, preferibilmente continua, modulabile e possibilmente prodotta da fonti che si possono accendere e spegnere a comando. In pratica: gas, carbone, nucleare. Il resto, cioè sole e vento, può accomodarsi fuori.

Sotto la patina patinata della “rivoluzione AI”, si nasconde un ritorno violento a modelli industriali ottocenteschi, con un’estetica da Silicon Valley e una politica energetica da Pennsylvania del 1910. A guidare questa distopia in Technicolor è una visione autoritaria della crescita, scritta con linguaggio da campagna elettorale e firmata da un ex presidente che sembra confondere deregolamentazione con innovazione. Trump, nel suo recente “AI Action Plan”, non ha semplicemente accelerato la realizzazione di data center. Ha spalancato la porta a una deregulation senza precedenti a favore di carbone, petrolio e “dispatchable power” un modo elegante per dire: tutto tranne l’energia rinnovabile.

Google sta lentamente trasformando il suo motore di ricerca in una macchina da guerra educativa. E non lo sta facendo con la solita fanfara da keynote californiano, ma a colpi chirurgici di nuove funzionalità integrate nell’ormai onnipresente AI Mode. L’ultima novità? Gli utenti possono ora caricare immagini direttamente dal desktop per chiedere a Gemini, l’intelligenza artificiale generativa al centro di tutto, di interpretarle, spiegarle e sezionarle come un professore post-moderno con un dottorato in machine learning. Il target dichiarato? Gli studenti. Il target reale? Chiunque voglia disintermediare la conoscenza, bypassando l’umano, spesso lento, opinabile e soggettivo.

L’introduzione dei Video Overviews su Google NotebookLM è uno di quegli aggiornamenti che sembrano marginali, quasi cosmetici, ma che in realtà ridisegnano sottilmente — e strategicamente — le dinamiche con cui si produce, consuma e manipola l’informazione digitale. Si tratta di una funzione che crea slideshow narrati direttamente dall’intelligenza artificiale, a partire dai documenti che l’utente carica nel proprio notebook. Una sorta di PowerPoint drogato da LLM, ma senza il designer umano, senza la fatica della sintesi, senza nemmeno il tempo morto del pensiero riflessivo. Una scorciatoia elegante, fluida, altamente digeribile. Perfetta per una generazione che scorre più di quanto legga.

Chiariamo subito un punto: l’IA generativa non è il nemico. Il nemico è il pensiero pigro. E OpenAI, con la sua nuova modalità Study Mode, tenta finalmente di mettere un freno all’orgia di outsourcing cognitivo che ha trasformato ChatGPT da promettente mentore digitale a complice silenzioso dell’apatia scolastica. Ora la macchina dice “aspetta un attimo, ragiona tu”. È quasi rivoluzionario.

Questa nuova funzionalità, già in fase di roll-out per gli utenti loggati ai piani Free, Plus, Pro e Team, si comporta come un professore un po’ severo ma giusto. Niente più risposte masticate e pronte all’uso: Study Mode propone domande, chiede spiegazioni, stimola l’autovalutazione. E se non si collabora? Niente risposte. Una forma di “disobbedienza pedagogica” algoritmica che sembra uscita più da una pedagogia socratica che da una strategia di prodotto della Silicon Valley.

Intelligenza artificiale e storytelling: due mondi che fino a pochi anni fa sembravano distanti, oggi si intrecciano in modo sempre più sinergico, rivoluzionando le fondamenta stesse del fare cinema. A dimostrarlo con forza è la seconda edizione del Reply AI Film Festival, un evento internazionale che porta sul grande schermo il frutto di una collaborazione inedita tra mente umana e algoritmi generativi.

In occasione dell’82. Mostra Internazionale d’Arte Cinematografica della Biennale di Venezia, dieci cortometraggi finalisti – selezionati tra oltre 2500 opere provenienti da 67 Paesi – saranno premiati giovedì 4 settembre presso la lounge Mastercard all’Hotel Excelsior del Lido. La cornice è prestigiosa, ma ciò che rende unico l’evento è il suo focus: valorizzare l’uso consapevole e creativo dell’intelligenza artificiale in tutte le fasi del processo produttivo audiovisivo.

Un tempo cambiare software aziendale era come tentare di sostituire un motore mentre si è in volo. Costoso, lento, dannatamente rischioso. Ma se gli strumenti di intelligenza artificiale continuano a evolversi con questa velocità e precisione chirurgica, presto passare da Microsoft a Salesforce sarà semplice come cambiare barista. Secondo The Information, i CIO lo stanno già facendo. E non per sport. L’intelligenza artificiale sta tagliando i costi, riducendo i tempi e azzerando la frizione psicologica che per anni ha blindato i fornitori di software enterprise all’interno di relazioni simili a matrimoni medievali. Forzati, lunghi, spesso infelici, ma inevitabili.

Oggi una società del Minnesota sta utilizzando ChatGPT per scrivere il codice che migra i dati da Microsoft Dynamics a un’applicazione di vendita più agile e moderna. L’intero processo? Ridotto del 50% in costi e tempi. Per i competitor di Microsoft questo è il sogno di una vita. Per Microsoft, Palantir, SAP e compagnia bella, potrebbe trasformarsi in un incubo dal sapore di retrocompatibilità interrotta. I colossi dell’enterprise software, da Salesforce a ServiceNow, hanno prosperato in un mondo in cui cambiare software era una follia contabile, un rischio reputazionale e una guerra psicologica interna. Ma ora la migrazione software si fa in pochi clic, magari con un assistente AI che genera lo script, lo testa e lo valida. E per la prima volta, la fedeltà al fornitore non è più una condanna.

L’era dell’intelligenza artificiale illimitata, quella dove si lasciava Claude Code a macinare prompt nel background come un criceto iperproduttivo, sta per chiudere i battenti. Anthropic, che fino a ieri sembrava la vestale del fair use, ha annunciato l’introduzione di nuovi limiti settimanali all’uso del suo modello di punta, Claude Opus 4, a partire dal 28 agosto. Colpiti saranno gli utenti paganti dei piani da 20, 100 e 200 dollari al mese. L’obiettivo dichiarato? Frenare la “domanda senza precedenti” e mettere un freno a quelli che usano Claude come un cluster privato di compute gratuito. L’obiettivo non dichiarato? Tagliare i super-user che stavano trasformando una promessa di AI sempre disponibile in un buco nero finanziario.

Ethical and Adversarial Risks of Generative AI in Military Cyber Tools

C’è un paradosso in atto nelle centrali strategiche dell’intelligenza artificiale militare. Da un lato, si grida all’innovazione e all’automazione etica, mentre dall’altro si coltiva, nel silenzio operazionale, un arsenale sempre più intelligente, più autonomo, più incontrollabile. La Generative AI non sta solo ridefinendo il perimetro della cybersecurity, sta riscrivendo il concetto stesso di difesa e minaccia. Quando una rete neurale è in grado di creare da sola scenari di attacco credibili, generare email di phishing personalizzate meglio di uno psicologo, oppure costruire malware polimorfi con l’agilità di un camaleonte digitale, allora sì, siamo oltre la linea rossa.

Mentre Washington canta l’inno dell’“American-made AI” con un patriottismo da Silicon Valley che profuma più di marketing che di governance, Pechino decide di giocare un’altra partita. E lo fa con un documento rilasciato sabato scorso: il “Global AI Governance Initiative Action Plan”, che suona più come una proposta di leadership globale mascherata da collaborazione internazionale. Non è un piano, è una sfida a chi detta le regole del nuovo ordine cognitivo globale.

Benvenuti nell’era in cui il browser non si limita più a interpretare URL, ma prende decisioni al posto vostro. Microsoft ha appena iniziato i test pubblici del suo nuovo Copilot Mode all’interno di Edge, un esperimento che mette l’intelligenza artificiale non solo nel cuore del browser, ma anche nei suoi polmoni, fegato e sistema nervoso centrale. Si tratta dell’ennesimo passo verso la fusione definitiva tra assistenti AI e ambienti digitali personali. Un browser che ti confronta hotel, prenota ristoranti, risponde ai comandi vocali e, ciliegina sulla torta, compare anche nella barra degli indirizzi. Inquietante? Certamente. Geniale? Anche.

Perché l’energia è il nuovo capitale dell’AI

La narrativa green nel mondo dell’intelligenza artificiale ha smesso di essere un vezzo da ufficio marketing per trasformarsi in un parametro di valutazione finanziaria. Nel 2025 l’energia è il nuovo capitale, e chi non riesce a rendicontarne l’uso con precisione è destinato a essere penalizzato da investitori, regolatori e in prospettiva dagli stessi clienti enterprise. La pressione ESG ha spostato il focus dal “fare AI più veloce e più grande” al “fare AI misurabile e ottimizzata”.

Chiunque pensasse che la guerra dei chip fosse solo una questione tra Stati Uniti e Cina, tra embargo e retorica bellica digitale, dovrà aggiornare il proprio modello mentale. Elon Musk, con la solita dose di teatralità e disprezzo per le mezze misure, ha appena piazzato un altro scacco alla geopolitica del silicio firmando un accordo da 16,5 miliardi di dollari con Samsung per la produzione del chip AI6, destinato a pilotare il futuro non solo delle Tesla ma, potenzialmente, del concetto stesso di automazione. Musk lo ha annunciato con un post notturno su X (ovviamente), lasciando intendere che l’accordo potrebbe valere “molto di più” in termini di output. Le parole usate? “La sua importanza strategica è difficile da sopravvalutare”. E per una volta, non sembra iperbole.

“Scoprire se un negozio è affidabile sarà come chiedere a un amico, ma con meno emozioni e più algoritmi.” Così Google annuncia, con tono quasi amichevole, la sua ultima trovata: recensioni generate da intelligenza artificiale direttamente in Chrome, disponibili per ora solo in inglese e solo su desktop.

L’obiettivo dichiarato è aiutare gli utenti americani a capire dove convenga comprare, ma quello reale è decisamente più profondo. Più che un semplice aggiornamento del browser, si tratta di un’operazione chirurgica per innestare l’AI nelle vene del web. Non più solo risultati di ricerca. Ora Chrome entra a gamba tesa nella shopping experience, puntando dritto al cuore del retail digitale. Un click sull’icona accanto alla barra degli indirizzi e si apre una sintesi: qualità del prodotto, servizio clienti, politica di reso, prezzi. Non serve più cercare tra mille recensioni.

L’algoritmo ha già deciso cosa ti interessa sapere. E chi gliel’ha detto? Un mix di fonti dal pedigree curioso: Bazaarvoice, Trustpilot, ScamAdviser, Reputation.com. Un’accozzaglia di rating engine, piattaforme di feedback e sistemi reputazionali, tutti distillati in un’unica voce sintetica e insindacabile.

L’ho sentito dire recentemente dal Prof. Luciano Floridi poche settimane fa in AI e Parlamento: “Sono 10 anni che la Cina investe in AI e noi ce ne siamo accorti con Deepseek”.

Quando una conferenza sull’intelligenza artificiale ospitata a Shanghai produce più dati e segnali strategici di una consultazione geopolitica delle Nazioni Unite, conviene prestare attenzione. Il World Artificial Intelligence Conference (WAIC) ha appena sancito un dato che sembra una semplice statistica ma in realtà è un grido di guerra algoritmica: la Cina è ormai casa di 1.509 modelli di intelligenza artificiale, pari a oltre il 40 per cento del totale mondiale. Siamo davanti a un’espansione non lineare, accelerata dalla logica del moltiplicatore digitale. Non si tratta solo di numeri, ma del segnale inequivocabile che Pechino non sta rincorrendo l’Occidente: lo sta sorpassando, a colpi di modelli open source, computing domestico e alleanze da supermarket digitale.

Quando Microsoft gioca d’anticipo e inizia a riscrivere parti del suo codice per Copilot con riferimenti chiari a GPT-5, la Silicon Valley trattiene il fiato. Non perché ci si aspetti una rivoluzione improvvisa, ma perché ogni mossa in quella direzione svela frammenti di un piano ben più ampio: colonizzare lo spazio dell’intelligenza adattiva prima che altri competitor capiscano dove guardare. I nuovi indizi portano tutti nella stessa direzione: l’introduzione di una modalità “Smart” all’interno di Copilot, accanto alle già note Quick Response, Think Deeper e Deep Research. La differenza? Apparentemente minima. Sostanzialmente, un terremoto silenzioso.

Milioni di persone stanno parlando con ChatGPT come se fosse Freud, ma con meno barba e più ottimizzazione algoritmica. I dati lo confermano: le conversazioni con i modelli di linguaggio includono sempre più spesso frasi come “mi sento solo”, “sono ansioso”, “ho bisogno di aiuto”. I numeri salgono, il senso critico scende. A quanto pare, è diventato perfettamente normale confidarsi con un’intelligenza artificiale addestrata a completare frasi, non a comprendere traumi. Qualcosa è andato storto. O forse è semplicemente l’evoluzione naturale di una cultura che preferisce l’istantaneità all’introspezione. E sì, persino Sam Altman, CEO di OpenAI, definisce questa tendenza “cattiva e pericolosa”.

Nell’era dei modelli linguistici di quarta generazione, la censura non ha più la forma del bavaglio, ma del “content moderation layer”. Un colosso opaco e iperaddestrato che decide cosa puoi o non puoi chiedere a un’intelligenza artificiale. Ironico, considerando che i suoi creatori professano apertura e accessibilità. Ma proprio come la Stasi digitando codice in una stanza senza finestre, l’industria dell’AI ha trasformato la sicurezza in un’arte della manipolazione. Eppure, alcune tecniche di jailbreaking come “Crescendo” ed “Echo Chamber” continuano a sfondare queste difese con una regolarità imbarazzante. Il trucco? Far credere al modello che sta solo parlando tra amici.

Sphere Las Vegas inaugura questa versione immersiva del classico del 1939 il 28 agosto 2025, su uno schermo LED da 160 000 piedi quadrati (circa 15 000 m²) con risoluzione 16K×16K, rendendo visibile ogni dettaglio anche a 17 600 spettatori seduti sotto la cupola.

James Dolan, CEO di Sphere Entertainment, ha spiegato che l’originale Technicolor è totalmente rispettato, ma trasformato con l’uso del generative AI: oltre il 90% del film è stato toccato da AI grazie a Google Cloud e DeepMind, con modelli come Gemini, Veo 2 e Imagen 3.

I robot umanoidi non conquisteranno il mondo domani. Né dopodomani. Ma potrebbero iniziare a lavorare nella hall del tuo hotel, offrendoti cocktail con movenze legnose e un sorriso LED stampato in faccia. Keenon Robotics, l’azienda cinese che sta puntando forte su questa visione a bassa velocità ma alta ambizione, ha deciso che il futuro sarà antropomorfo, ma con giudizio. Per adesso meglio limitarsi a compiti semplici, ripetitivi, quelli che l’umanità ha storicamente riservato agli stagisti malpagati e oggi scarica su automi con facce da giocattolo.

AI Cinese, una guerra a colpi di Reti Neuronali e Pixel: Tencent e SenseTime rilanciano al WAIC 2025

Il teatro non poteva essere più adatto: Shanghai, World Artificial Intelligence Conference, 27 luglio 2025. Lì, nel cuore della propaganda tecnologica cinese, dove il metaverso è ancora un’ipotesi e i modelli generativi sono già una religione di Stato, Tencent e SenseTime hanno sfoderato i nuovi ferri del mestiere. Non è solo una gara di chip e GPU, è una dichiarazione d’intenti strategica, geopolitica e industriale. La keyword è chiara: AI generativa. Le correlate si chiamano modelli multimodali e ambienti 3D. Ma sarebbe miope leggerla solo in chiave semantica. Qui si parla di potere.

Alibaba ha appena lanciato il guanto di sfida in uno dei campi più controversi e promettenti dell’elettronica di consumo: quello degli occhiali intelligenti. Non poteva farlo in un palcoscenico più teatrale e simbolico del World Artificial Intelligence Conference (WAIC) di Shanghai, la fiera più importante del settore AI in Cina. Come dire: benvenuti nella guerra dei mondi, dove le lenti sono aumentate, la realtà è aumentata e l’intelligenza artificiale, seppur ancora imperfetta, pretende di vedere e sentire per noi.

Immagina di disegnare la tua visione anziché descriverla a parole. Come cambierebbe il tuo processo creativo?

Google Veo 3 ora permette di tracciare direttamente le istruzioni sul primo frame del video, trasformando l’arte della comunicazione creativa. Disegni il percorso di una ripresa con drone, cerchi il tetto dove dovrà posarsi un uccello, e l’intelligenza artificiale interpreta immediatamente. Non serve più insistere su prompt imperfetti: parli il linguaggio visivo, più naturale e umano.

C’è qualcosa di profondamente ipocrita nel modo in cui parliamo oggi di AI Ethics. Tutti ossessionati dal bias, dai dataset “inclusivi”, dalle trasparenze tanto sbandierate nei convegni e nei white paper patinati. Ma la vera frattura, quella che corrode dall’interno il rapporto tra esseri umani e macchine intelligenti, non è nei numeri né nei grafici di fairness. È nel senso. O meglio, nella sua perdita sistematica. È ciò che i filosofi chiamano hermeneutic harm. Un danno invisibile, ma letale per chi lo subisce. E se pensate che basti un’interfaccia con spiegazioni più “chiare” per risolverlo, fate parte del problema.