La rivoluzione silenziosa di Deepseek: come la cina sta riscrivendo le regole dell’intelligenza artificiale globale

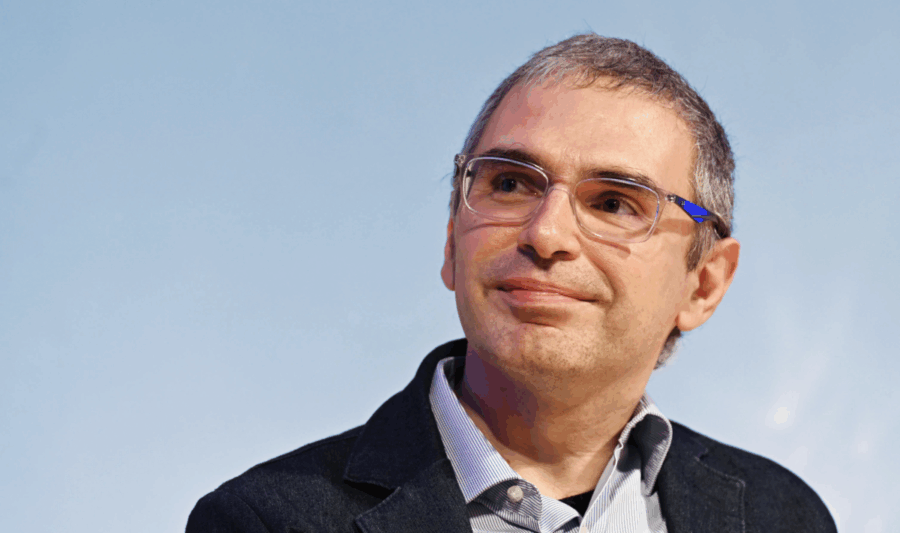

Nel panorama congestionato dell’intelligenza artificiale, dove tutti parlano di parametri, GPU e benchmark come fossero preghiere di una religione laica, una notizia apparentemente marginale si è insinuata come un silenzioso terremoto nel cuore dell’élite accademica. A Vienna, alla conferenza ACL, quella che nel mondo dell’AI è considerata la Champions League dei linguisti computazionali, un paper cinese ha vinto il premio per il miglior lavoro. Titolo: “Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention”. Autore? O meglio, uno dei quindici co-autori: Liang Wenfeng, fondatore della start-up DeepSeek, realtà cinese che sta riscrivendo il manuale di istruzioni della scalabilità nell’intelligenza artificiale.