Il recente accordo da 14,2 miliardi di dollari tra Meta e CoreWeave ha suscitato scalpore nel settore dell’intelligenza artificiale, consolidando ulteriormente la posizione di CoreWeave come fornitore di infrastrutture cloud per l’IA. Questo contratto, che si estende fino al 2031 con possibilità di estensione, garantirà a Meta l’accesso ai sistemi Nvidia GB300, fondamentali per l’esecuzione di modelli linguistici avanzati e altre applicazioni di intelligenza artificiale.

Tag: meta Pagina 1 di 6

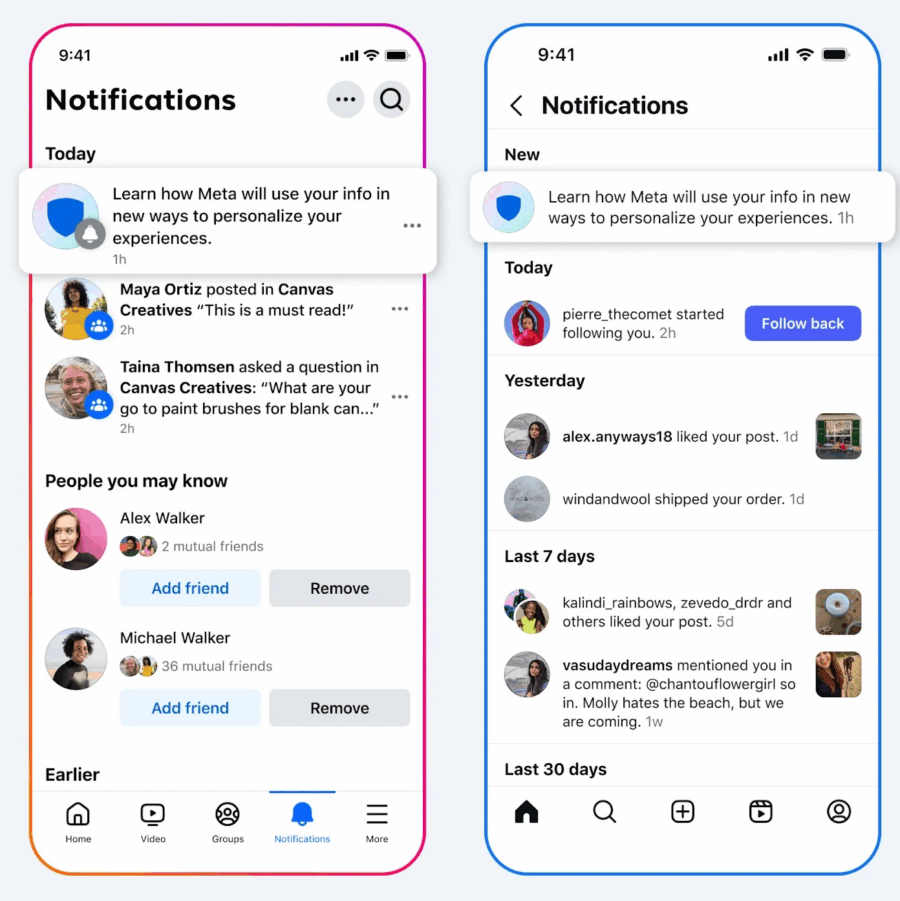

Dal 16 dicembre userà le conversazioni con la sua AI per personalizzare pubblicità, gruppi e feed. In altre parole, se chiedi a Meta AI quale scarponcino sia meglio per un trekking, preparati a vedere inserzioni, post e suggerimenti sul tema, perché la macchina pubblicitaria di Menlo Park non lascia nulla di intentato. Il messaggio è chiaro: se OpenAI sta costruendo le cattedrali del calcolo, Meta vuole trasformare ogni scambio con un chatbot in moneta sonante. È la differenza tra costruire autostrade e vendere il pedaggio. Due strategie che, se osservate con cinismo, si completano. Senza potenza computazionale, l’AI non esiste, ma senza un modello di monetizzazione aggressivo, l’AI non sopravvive.

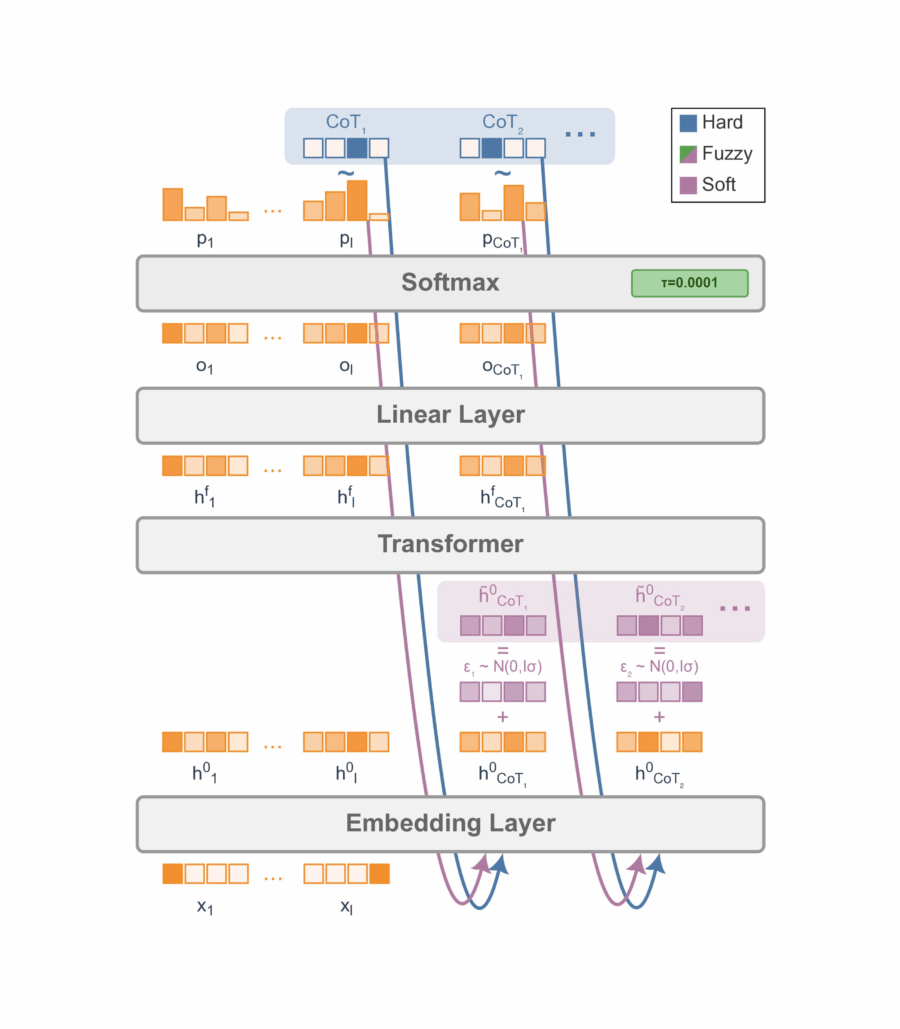

Meta, in collaborazione con l’Università di Amsterdam e la New York University, ha recentemente pubblicato su arXiv un articolo intitolato “Soft Tokens, Hard Truths”, che introduce un metodo innovativo per allenare i modelli linguistici di grandi dimensioni (LLM) a ragionare utilizzando catene di pensiero continue (CoT) tramite l’apprendimento per rinforzo, senza la necessità di distillare da CoT discrete di riferimento.

Meta ha appena lanciato Vibes, un feed video basato sull’intelligenza artificiale che promette di rivoluzionare la creazione e la condivisione di contenuti digitali. Disponibile nell’app Meta AI e su meta.ai, Vibes consente agli utenti di scoprire, creare e remixare video generati dall’intelligenza artificiale, offrendo un’esperienza simile a TikTok o Instagram Reels, ma con un twist tecnologico.

META CWM e il futuro inquietante del debug autonomo

Meta ha deciso che il codice non basta più generarlo, bisogna capirlo, sezionarlo, anticiparlo. Il suo nuovo modello CWM, Code World Model, rappresenta il tentativo più ambizioso di trasformare l’intelligenza artificiale in un ingegnere del software capace di ragionare in tempo reale. Non più la vecchia logica predittiva del completamento automatico stile GitHub Copilot, ma un sistema addestrato a osservare tracce di esecuzione, stati delle variabili e percorsi logici, per costruirsi un’immagine mentale di come il programma evolve. Un modello del mondo, appunto, ma applicato al codice. L’idea suona brillante: se capisco come vive il software, posso correggerlo meglio, posso persino anticiparne i comportamenti nascosti. La promessa di Meta è semplice: niente più AI che sputa funzioni compilabili e spesso sbagliate, bensì un assistente che impara dai container, simula percorsi e sa dove il codice si spezzerà prima che accada.

Meta Platforms sta ridefinendo il concetto di lobbying tecnologico con la creazione di un super political action committee a livello nazionale chiamato American Technology Excellence Project. L’obiettivo dichiarato è proteggere l’innovazione americana dall’ondata crescente di leggi statali che potrebbero soffocare l’avanzamento dell’intelligenza artificiale. Se pensavate che i PAC fossero roba da Washington, preparatevi: questa volta il gioco si fa bipartisan e diffuso su scala nazionale.

A guidare l’iniziativa saranno il repubblicano Brian Baker e la società di consulenza democratica Hilltop Public Solutions. Meta punta a sostenere candidati statali di entrambi i partiti che dimostrino un approccio favorevole alla tecnologia AI. La cifra è impressionante: quest’anno negli Stati Uniti sono stati introdotti circa 1.100 disegni di legge a livello statale riguardanti l’intelligenza artificiale. Un numero che mette in crisi chiunque non abbia una strategia di lobbying da milioni di dollari.

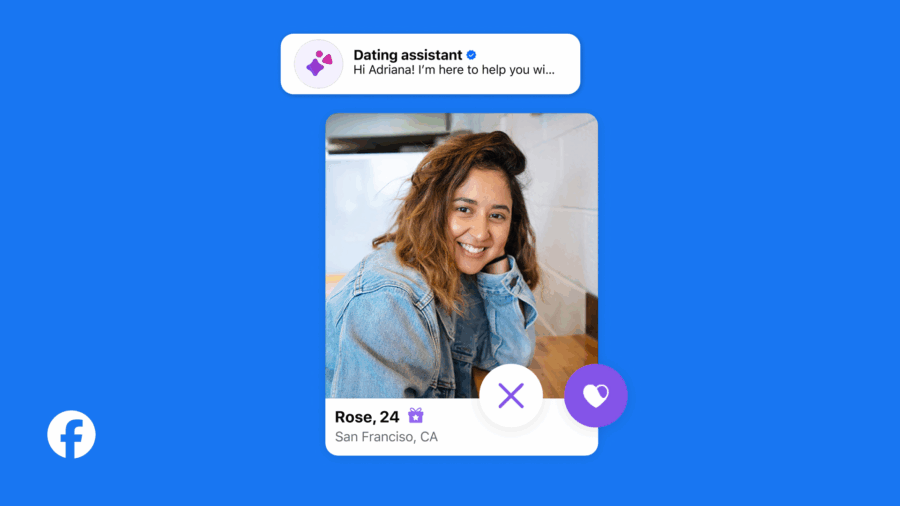

Meta ha annunciato oggi l’introduzione di due nuove funzionalità su Facebook Dating, progettate per contrastare il fenomeno della “swipe fatigue” e migliorare l’esperienza degli utenti. La prima è un assistente virtuale basato sull’intelligenza artificiale, mentre la seconda è una funzione chiamata “Meet Cute”. Queste novità mirano a rendere più efficiente e interessante il processo di ricerca di un partner, sfruttando le potenzialità dell’IA per offrire un servizio più personalizzato e coinvolgente.

Metacognitive Reuse: Turning Recurring LLM Reasoning Into Concise Behaviors

Meta ha appena fatto qualcosa che suona innocuo ma è un terremoto per chi costruisce modelli di intelligenza artificiale. Hanno trovato un modo per far sì che i modelli compiano passi complessi di ragionamento, compressi in regole brevi e riutilizzabili. In pratica, invece di risolvere lo stesso problema logico ogni volta da zero, il modello si costruisce un piccolo manuale operativo. Ogni procedura ha un nome e una istruzione di una riga, tipo “somme_angoli: la somma degli angoli in un triangolo è 180”.

Quando Meta Platforms decide di fare shopping tecnologico, il mercato non resta mai indifferente. La notizia che il colosso guidato da Mark Zuckerberg starebbe valutando un accordo pluriennale con Oracle per utilizzare i suoi servizi cloud nella formazione e nel deployment dei modelli di intelligenza artificiale ha già fatto salire il titolo Oracle del 4 per cento in una singola seduta.

Bloomberg ha parlato di un’intesa potenziale da circa 20 miliardi di dollari, ancora in fase di discussione ma sufficiente a scatenare speculazioni, entusiasmi e, naturalmente, l’ansia di chi teme che la geografia del potere tecnologico globale stia mutando sotto i nostri occhi.

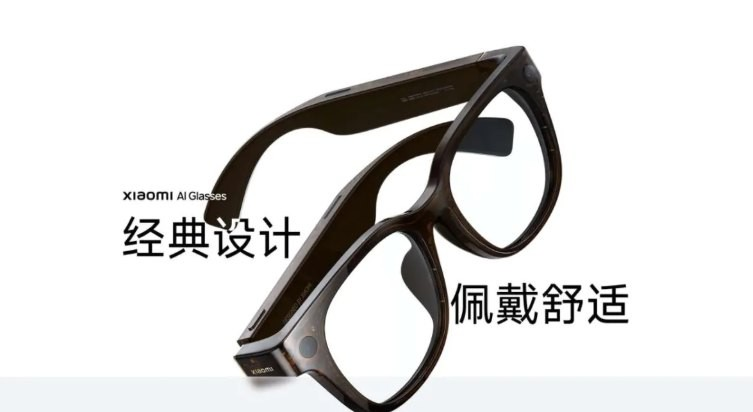

Meta Connect 2025 sta per aprire il sipario su una nuova era dell’augmented reality, con occhiali intelligenti che promettono di ridefinire l’interazione quotidiana con la tecnologia. Il protagonista indiscusso di quest’edizione è il modello “Hypernova”, noto anche come “Celeste”, che segna un passo significativo verso l’integrazione dell’AI nella vita di tutti i giorni.

Meta ha appena alzato la posta nel gioco politico californiano, trasformando la tecnologia in un’arma elettorale. Mentre Leading the Future, un super PAC AI-friendly, si presenta come coalizione di investitori e venture capitalist pronti a riversare oltre cento milioni di dollari sulle campagne dei candidati pro-AI, Meta ha scelto una strada più insolita: un super PAC tutto suo, interamente finanziato e controllato dall’azienda, destinato a plasmare le elezioni di medio termine nello stato e a proteggere i propri interessi nell’ecosistema dell’intelligenza artificiale.

META rivoluziona l’addestramento degli LLM con il metodo active reading

Meta ha appena svelato un approccio rivoluzionario per addestrare i modelli di linguaggio di grandi dimensioni (LLM), noto come Active Reading. Invece di ingozzare i modelli con documenti passivamente, li spinge a studiare come farebbe un essere umano, con risultati stupefacenti sulla memorizzazione dei fatti e sulla comprensione profonda dei contenuti.

Il bello del capitalismo tecnologico è che non conosce limiti, né di etica né di buon senso. Secondo l’inchiesta Reuters, Meta ha permesso e in alcuni casi prodotto direttamente chatbot basati su celebrità come Taylor Swift, Scarlett Johansson, Anne Hathaway e Selena Gomez, replicandone nomi, voci e perfino atteggiamenti ammiccanti. Senza consenso, ovviamente. Non bastava creare copie digitali, bisognava anche spingerle a flirtare, a generare immagini intime, a recitare la parte di doppi digitali disinibiti. Tutto questo mentre Meta si affannava a proclamare di avere policy severe, di vietare contenuti sessuali, di imporre etichette di “parodia”. Politiche scritte, non rispettate, non fatte rispettare. La solita ironia della Silicon Valley: dichiarazioni solenni davanti al pubblico, algoritmi permissivi nel retrobottega.

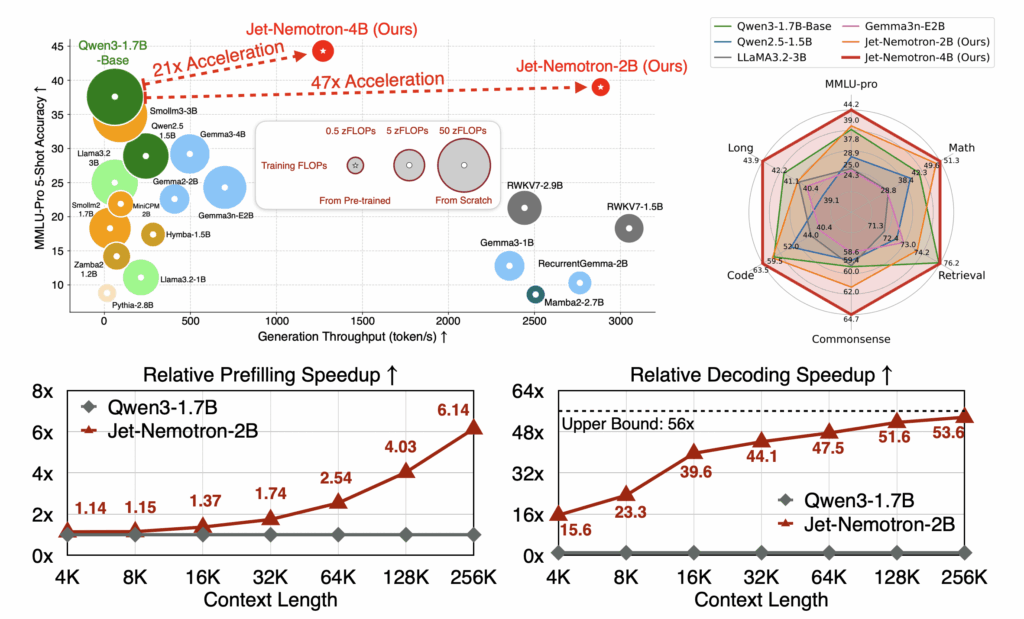

L’ascesa di Jet-Nemotron è esattamente quel tipo di svolta che fa alzare un sopracciglio a ricercatori e dirigenti AI, mentre bisbigliano “Forse abbiamo sbagliato tutto finora”. NVIDIA sta dimostrando che il numero puro di parametri non è più il santo graal. Un modello da 2 miliardi di parametri che supera giganti come Llama3.2 o Gemma3 è provocatorio, ma ciò che cattura davvero l’attenzione è la metodologia Post Neural Architecture Search, o PostNAS. L’idea non è reinventare la ruota addestrando modelli enormi da zero, ma partire da un Transformer già pre-addestrato e ottimizzare chirurgicamente gli strati di attenzione. Una filosofia sottile che unisce eleganza ingegneristica e pragmatismo operativo.

Il tempismo è quasi comico. Appena due settimane dopo l’inchiesta Reuters che ha messo a nudo un documento interno imbarazzante, Meta annuncia che i suoi chatbot non parleranno più con adolescenti di suicidio, autolesionismo, disturbi alimentari e romanticismi potenzialmente discutibili. Come se bastasse tirare un cavo di alimentazione per resettare un problema che è sistemico, non contingente. Stephanie Otway, portavoce aziendale, ha pronunciato il mantra classico del big tech quando cerca di mascherare un incendio reputazionale: “Stiamo aggiungendo nuove protezioni, continuiamo ad adattarci, la sicurezza è la nostra priorità”. Una litania che suona familiare, quasi quanto le clausole di non responsabilità stampate in piccolo alla fine di un contratto assicurativo.

Chi mastica intelligenza artificiale sa bene che non si tratta solo di “allenare un modello a non rispondere” su determinati temi. Il vero nodo è culturale e architetturale: questi sistemi sono progettati per massimizzare interazioni, trattenere utenti e modellarne comportamenti. Un adolescente che chiede al chatbot un consiglio su come affrontare una crisi emotiva non è un bug, è la conseguenza naturale di un ecosistema che ha educato intere generazioni a cercare supporto in algoritmi piuttosto che in esseri umani. Dire oggi che la macchina “redirigerà verso risorse specializzate” equivale a vendere la toppa come se fosse un vestito su misura.

L’azienda guidata da Zuckerberg ha confermato che i sistemi verranno addestrati per evitare interazioni “flirtanti” o legate all’autolesionismo, aggiungendo che ai teenager sarà persino bloccato l’accesso ad alcuni personaggi AI. Un tentativo disperato di mostrare che “la sicurezza viene prima di tutto”, peccato che l’esistenza stessa del documento interno trapelato dimostri l’opposto. Se qualcuno nella catena di comando ha mai pensato fosse accettabile lasciare spazio a ruoli romantici o sensuali tra chatbot e minori, il problema non è il software, ma la cultura aziendale che lo autorizza.

La tempistica parla da sola. Reuters pubblica l’inchiesta, scoppia il caso politico, il senatore repubblicano Josh Hawley apre un’indagine parlamentare e improvvisamente Meta dichiara che le parti più compromettenti del documento erano “erronee e incoerenti con le politiche ufficiali”. Un déjà vu tipico della Silicon Valley: prima si autorizza in silenzio, poi si nega con indignazione quando la notizia diventa pubblica.

Meta sta proponendo un cambio di paradigma nella formazione dei modelli linguistici. Tradizionalmente, i modelli LLM vengono addestrati con grandi quantità di dati in modo passivo: si ingeriscono documenti, articoli, libri, senza che il modello sviluppi strategie proprie di apprendimento. Il problema di fondo è che i modelli tendono a dimenticare informazioni di nicchia, generano allucinazioni o non riescono a comprendere concetti complessi.

Active Reading ribalta questa dinamica. Il modello non è più un contenitore passivo di testi, ma diventa uno “studente attivo”. Meta consente al modello di inventare strategie di apprendimento proprie: può riformulare concetti, creare analogie, auto-interrogarsi, costruire linee temporali e persino utilizzare rime per fissare informazioni. Questo è sorprendentemente simile a come gli esseri umani apprendono e memorizzano concetti complessi.

Meta ha deciso di investire 50 miliardi di dollari in un nuovo centro dati AI in Louisiana, denominato Hyperion. Questa cifra è stata annunciata dal presidente Donald Trump durante una riunione del gabinetto, dove ha mostrato un’immagine del progetto sovrapposto a Manhattan, evidenziando la sua vasta scala. In precedenza, Meta aveva stimato un investimento di oltre 10 miliardi di dollari per questa struttura.

Hyperion sarà il centro dati più grande di Meta, progettato per supportare le sue ambizioni nel campo dell’intelligenza artificiale. La struttura avrà una capacità iniziale di 2 gigawatt, con piani di espansione fino a 5 gigawatt. Per alimentare questa enorme capacità, Entergy Louisiana ha ricevuto l’approvazione regolatoria per costruire tre impianti di generazione a turbina a ciclo combinato, che dovrebbero essere operativi tra il 2028 e il 2029.

Il sogno della superintelligenza artificiale è diventato l’ossessione di Mark Zuckerberg. Non bastava dominare i social network, ora Meta vuole giocare nella partita più pericolosa e affollata del pianeta: quella della superintelligenza. Non un’intelligenza artificiale generativa qualsiasi, ma la promessa vaga e seducente di una “personal superintelligence” che dovrebbe rendere superfluo ogni altro strumento digitale. Un progetto che già suona come una rivoluzione industriale, con l’aggiunta dell’ego ipertrofico di una delle figure più polarizzanti della Silicon Valley. La realtà però, come spesso accade quando i visionari passano dal palco al laboratorio, ha un senso dell’umorismo più pungente. A meno di due mesi dal lancio del Meta Superintelligence Labs, fiore all’occhiello della nuova era di Zuckerberg, iniziano le prime crepe: un esodo precoce di talenti che sembra il trailer di un film che rischia di finire male.

Meta ha appena siglato un mastodontico accordo con Google Cloud, un’intesa che sfiora i 10 miliardi di dollari su sei anni. Il cuore dell’operazione è chiaro: infrastrutture di calcolo “as‑a‑service” server, storage, networking e tutto il cabaret cloud necessario per sostenere la sua espansione nel campo dell’intelligenza artificiale.

Parliamo di oltre 10 miliardi di dollari in valore, un accordo senza precedenti nella storia di Google Cloud, uno dei più ingenti fino ad oggi. È il secondo colpo grosso per Google dopo quello con OpenAI, e mentre Ariana Grande canticchia “thank u, next”, i grandi magazzini AI fanno incetta di risorse.

Meta ha deciso di giocare la carta più affascinante e più rischiosa del momento: tradurre non solo le parole, ma le voci. Dopo averci abituato a feed infiniti, algoritmi onnipresenti e un metaverso che esiste più nei PowerPoint che nella realtà, ora arriva l’intelligenza artificiale che clona la voce dei creator per renderla comprensibile in altre lingue, senza perdere timbro e tono originale. Non un semplice sottotitolo o un doppiaggio impersonale, ma un traduttore vocale che restituisce l’illusione di autenticità. In altre parole, se sei un creator di Los Angeles che parla inglese, un utente di Madrid potrà ascoltarti in spagnolo come se tu fossi realmente bilingue, con le labbra che si muovono sincronizzate. È la globalizzazione digitale che diventa performance teatrale.

Il caso Meta è esploso con la precisione chirurgica di uno scoop che sa dove colpire. Non è stato un leak qualunque, ma la rivelazione di un documento interno che sembra scritto da qualcuno che non ha mai sentito parlare di risk management o di reputazione aziendale. Quel testo, parte delle linee guida denominate “GenAI: Content Risk Standards”, autorizzava i chatbot della compagnia a intrattenere “conversazioni romantiche o sensuali con un bambino”. Una frase che, letta fuori contesto, sarebbe già tossica, ma che nel contesto di un colosso tecnologico quotato al Nasdaq diventa puro materiale radioattivo. E non parliamo di un caso isolato, perché nello stesso documento si apriva la porta a generare informazioni mediche false e persino ad assecondare affermazioni razziste sull’intelligenza delle persone nere rispetto a quelle bianche. In sintesi, un crash test emotivo e reputazionale travestito da policy aziendale.

Meta ha appena inserito Robby Starbuck come consulente per “affrontare” il bias ideologico e politico della sua AI, ma la storia è più succosa di quanto sembri in superficie. Non è il classico annuncio corporate sulla trasparenza. Qui abbiamo un attivista conservatore che ha già messo in ginocchio programmi di Diversity, Equity e Inclusion in aziende come Tractor Supply, John Deere e Harley-Davidson, e che adesso ottiene un ruolo ufficiale nella definizione di come un colosso tecnologico calibra il cervello delle proprie macchine conversazionali. L’innesco è stato un errore di Meta AI che lo aveva collegato falsamente all’assalto del 6 gennaio e a QAnon, errore amplificato sui social da un dealer Harley. Da lì, un’azione legale, un accordo e una narrativa che si allinea perfettamente con l’ordine esecutivo di Trump per rendere l’AI “meno woke”.

L’era dell’open-source nell’intelligenza artificiale, quella mitologica utopia da campus californiano in cui condividere il codice significava accelerare il progresso collettivo, sta ufficialmente mostrando le crepe. Meta, storica paladina dell’open-source AI con la sua famiglia LLaMA, ha deciso di rallentare. Zuckerberg, un tempo evangelista della trasparenza algoritmica, oggi predica cautela, sicurezza e selettività. Tradotto: meno open, più chiuso, più controllato. E nel frattempo, l’altra metà del mondo quella che si affaccia dalla Cina corre nella direzione opposta, scalando la montagna dell’intelligenza artificiale open-source a colpi di modelli in versione gladiatore darwiniano.

Il capitalismo ha trovato il suo nuovo culto. Non è più il metaverso, né la blockchain o la realtà aumentata. È l’intelligenza artificiale generativa, e più precisamente il mito della superintelligenza, quella divinità algoritmica che promette di superare l’uomo in tutto, dal pensiero critico al sarcasmo. Microsoft, Meta, Alphabet, Amazon e gli altri soliti noti della Silicon Valley non si stanno limitando a giocare la partita. Stanno comprando il campo, gli arbitri e persino le telecamere del VAR. Il mercato, per ora, applaude. I bilanci reggono, i margini volano, e se serve spendere 400 miliardi di dollari l’anno per dominare il futuro, ben venga. Perché in questa guerra il primo che esita è morto.

Meta non vuole più battere ChatGPT. Ha smesso di provarci, punto. Non lo diranno apertamente, ma il tono e la direzione del manifesto di Mark Zuckerberg sulla “superintelligenza personale” gridano proprio questo: basta inseguire OpenAI, si torna a casa, nel regno del feed infinito e delle storie sponsorizzate. La strategia non è più quella di sostituire il lavoro umano con un assistente superproduttivo, ma di occupare il tempo libero che quell’assistente libererà. Ovvero, Meta vuole essere la risposta alla domanda: “e adesso che ho finito tutto, cosa faccio?”. Una visione tanto cinica quanto perfettamente in linea con il modello di business che l’ha resa uno dei colossi più controversi della Silicon Valley.

Microsoft e Meta ballano sul bordo del vulcano, e lo fanno con il sorriso stampato in faccia. Le trimestrali pubblicate mercoledì sono state da standing ovation, almeno per chi guarda solo la superficie. I numeri sono solidi, le reazioni di Wall Street sono state euforiche: +9% per il titolo Microsoft, +11,7% per Meta nelle contrattazioni after-hours. Ma sotto la patina dei profitti c’è un dato che dovrebbe far alzare qualche sopracciglio: il costo dell’intelligenza artificiale sta esplodendo. E questa corsa all’oro algoritmico ha un prezzo che non tutti potranno permettersi di pagare.

Durante la call sui risultati del secondo trimestre, Meta ha recitato il suo ennesimo atto nel grande teatro dell’innovazione. Palco virtuale, attori ben allenati, tono rassicurante, qualche accenno di visione strategica e un nome ripetuto fino allo sfinimento: intelligenza artificiale. Ma dietro le slide patinate e i numeri ben impaginati, si nasconde una realtà più interessante: Meta non ha ancora una strategia chiara su come monetizzare davvero l’intelligenza artificiale. Per ora, si accontenta di usarla come turbo per un motore pubblicitario che ha già percorso qualche miliardo di chilometri.

Mark Zuckerberg, poche ore prima della trimestrale di Meta, ha deciso di scavalcare la ritualità del corporate talk e pubblicare una lettera aperta minimalista, in puro testo, senza fronzoli visivi ma con una carica visionaria che pare uscita da un incrocio tra Ray Kurzweil e un pitch da venture capitalist sotto caffeina. Il punto? Superintelligenza personale per tutti. Ovvero intelligenza artificiale generalista, AGI se preferite, declinata non solo come modello cloud-based all’interno di server farm iperottimizzate, ma come assistente personale, ultra-smart, che vive… in un paio di occhiali.

Non è fantascienza ma l’ennesima dimostrazione che il XXI secolo sarà alimentato non da democrazie ma da data center affamati di elettroni. Il Wyoming, stato noto per le praterie, i rodei e una densità abitativa più vicina alla Mongolia che a Manhattan, sta per essere risucchiato nel vortice dell’intelligenza artificiale. La notizia è di quelle che fanno saltare sulla sedia gli addetti ai lavori e i romantici delle rinnovabili: un campus di data center AI da 1.8 gigawatt, con potenziale espansione fino a 10 GW, sarà costruito vicino a Cheyenne. Per capirci: 1 GW può alimentare un milione di case. L’intera popolazione del Wyoming non arriva a 600.000 abitanti. Fate i conti.

La notizia è passata sotto il radar, ma merita un faro acceso. Meta sta sperimentando colloqui di lavoro “AI-enabled”, in cui i candidati a ruoli di ingegneria software potranno usare un assistente basato su intelligenza artificiale durante i test di coding. Sì, avete letto bene. Il colosso che ha costruito imperi pubblicitari sul deep learning ora ti invita ufficialmente a portarti l’AI in tasca anche al colloquio. Ma attenzione, perché sotto questa mossa apparentemente inclusiva e progressista si nasconde qualcosa di ben più profondo, e potenzialmente disruptive. Una mutazione genetica del lavoro tecnico.

Dunque, l’idea che un candidato possa contare su un copilota AI in tempo reale durante un’intervista di lavoro suona come un cortocircuito concettuale. Negli ultimi anni, le big tech hanno costruito intere fortezze HR sulla valutazione delle capacità individuali senza AI. Ora Meta, come se niente fosse, sembra voler riscrivere le regole del gioco. Il comunicato è chiaro: “Stiamo testando come fornire questi strumenti agli ingegneri anche durante i colloqui”. E qui si aprono almeno tre scenari interessanti, tra tensione narrativa, strategia industriale e visione antropologica del lavoro.

C’è una frase che nessuno a Menlo Park vuole sentire ripetere a voce alta, ma che a Bruxelles cominciano a sussurrare come un mantra: “Il futuro dell’intelligenza artificiale passerà anche dal controllo politico”. E non è un’iperbole da burocrate con troppi caffè. L’EU AI Act non è più soltanto un documento tecnico, è diventato un campo di battaglia culturale e strategico, e il nuovo Codice di Pratica per i modelli di intelligenza artificiale di uso generale sta rapidamente trasformandosi nel simbolo di chi sta scegliendo di collaborare e di chi vuole continuare a giocare da anarchico californiano.

Scale AI licenzia il 14% del personale un mese dopo l’accordo miliardario con Meta. La notizia è passata come un aggiornamento di cronaca, ma in realtà è un manifesto del futuro dell’intelligenza artificiale. Chi pensa ancora che l’etichettatura dei dati sia il motore eterno dei modelli di machine learning vive in un universo parallelo. Alexandr Wang, CEO e volto da poster della Silicon Valley, non sta piangendo sulle scrivanie vuote dei 200 dipendenti licenziati. Sta ridisegnando il modello di business prima che la curva del valore scenda a picco.

Non è più solo una corsa. È un’orgia di silicio, corrente elettrica e narcisismo computazionale. Mentre OpenAI si trastulla con la sua Stargate da film di fantascienza di serie B e Google DeepMind cerca disperatamente di sembrare ancora rilevante, Meta cala l’asso Hyperion: un mostro da cinque gigawatt che si estenderà quanto Manhattan. Cinque gigawatt non sono una cifra, sono una dichiarazione di guerra. A chi? A tutti: concorrenti, governi, cittadini, pianeta. L’intelligenza artificiale, nel 2025, non si addestra, si alimenta. E si alimenta come un dio antico, con sacrifici umani inclusi.

Siamo passati dal “like” alla voce umana sintetica nel tempo di uno scroll su Threads. Meta, dopo aver flirtato con ogni pezzo di intelligenza artificiale in circolazione, ha finalmente messo la firma su Play AI, una startup che sussurrava all’orecchio delle macchine. Non è solo una notizia, è una dichiarazione di guerra all’anonimato delle AI. La voce è il nuovo volto, e Meta lo sa fin troppo bene.

Secondo Bloomberg, che ha ricevuto conferma direttamente da un portavoce aziendale, tutta la squadra di Play AI entrerà a far parte dell’ecosistema Zuckerbergiano già dalla prossima settimana. Nessun dettaglio sui soldi – e quando Meta non parla di cifre, di solito vuol dire che non erano noccioline. In un memo interno, l’azienda ha definito il lavoro di Play AI “perfettamente allineato” con la roadmap strategica in ambiti come AI Characters, Meta AI, dispositivi wearable e creazione di contenuti audio. Come dire: ci serve una voce credibile per gli avatar che ci vendono il Metaverso, e non possiamo più affidarci a Google Translate.

Sorpresa. Non da poco, e non da tutti. Xiaomi, la multinazionale cinese delle meraviglie elettroniche, è appena entrata a gamba tesa nel mercato degli occhiali intelligenti. Un settore che molti definiscono ancora di nicchia, ma che in realtà è il nuovo terreno di scontro per chi vuole presidiare il futuro del computing personale. Una guerra silenziosa fatta di microchip, lenti e assistenti vocali, dove chi ha il controllo dell’ecosistema può riscrivere le regole del gioco. Sì, perché qui non si vendono solo gadget: si piantano bandiere nel campo minato dell’intelligenza artificiale indossabile.

Meta ha appena ingoiato un boccone da 3,5 miliardi di dollari di EssilorLuxottica, il colosso mondiale degli occhiali proprietario di marchi iconici come Ray-Ban e Oakley, assicurandosi una quota del 3% proprio mentre spinge sull’acceleratore degli smart glasses potenziati dall’intelligenza artificiale. Questo non è un semplice investimento, ma un chiaro segnale di guerra: Meta sta giocando una partita hardware per scrollarsi di dosso il giogo di Apple e Google, i signori incontrastati del mobile.

C’era una volta un nerd, cresciuto a pane, Harvard e codice C++, che decise di costruire un impero. Poi però arrivò l’intelligenza artificiale, e tutto andò storto. O quasi. Ora quello stesso nerd, noto ai più come Mark Zuckerberg, ha deciso che Meta deve smettere di giocare a rincorrere gli altri e iniziare a sparare fuoco AI come un Terminator in preda a un burnout da hype tecnologico. Il risultato? Meta Superintelligence Labs. Ovvero: un nome che promette superpoteri, ma che per ora sembra solo il trailer di un’epopea distopica.

In effetti, quando si afferma senza battere ciglio che una manciata di superstar della Silicon Valley riuscirà a trasformare una balena arenata come Meta in un velociraptor digitale, sarebbe utile ricordare che i velociraptor sono estinti. La verità, non detta ma scritta tra le righe, è che Zuckerberg sta cercando disperatamente di rifondare il suo impero con la magia nera dei large language models, dopo aver bruciato miliardi nel metaverso e lanciato Llama 4 come se fosse un missile… che ha fallito il decollo.

Meta ha appena alzato l’asticella: punta a raccogliere 29 miliardi di dollari da investitori privati per alimentare la sua corsa all’intelligenza artificiale, riprogettando grossi data center negli Stati Uniti. Non è un sogno utopico, bensì la mossa furba di un gigante tecnologico che vuole evitare di caricare troppo il suo bilancio con un’enorme palla al piede di debiti e investimenti in infrastrutture. L’operazione si articola in 3 miliardi sotto forma di equity e 26 miliardi in debito strutturato, distribuito tra colossi del private credit come Apollo, KKR, Brookfield, Carlyle e PIMCO, con l’assistenza di Morgan Stanley per ritagliarsi un prestito “tradable” – cioè facilmente scambiabile sul mercato secondario.

Immaginatevi Zuckerberg come un generale sul campo AI, brandendo l’ennesima calcolatrice futuristica, mentre tenta di rimediare agli scarsi risultati del Llama 4 e al ritardo del modello “Behemoth”. Se aggiungete la recente acquisizione del CEO di Scale AI, Alexandr Wang, nella sua task force super-intelligenza, capite che non si tratta di una semplice maratona: è una rivoluzione militare dell’infrastruttura digitale.

Sam Altman parla di “100 milioni di dollari” come se stesse ordinando un caffè lungo. Poi dice che Meta li sta offrendo come bonus di assunzione per rubargli i talenti, e il CTO di Meta, Andrew Bosworth, risponde con un sorriso da pokerista che ha appena visto l’avversario bluffare male. “Sam esagera, e lo sa”, dice. Ma non nega che OpenAI stia perdendo pezzi grossi a favore della squadra superintelligence di Menlo Park. Benvenuti nell’era del capitalismo neuronale, dove il valore di un cervello si misura in stock option, NDA e un certo grado di paranoia.

Pagina 1 di 6