Non servono più i droni Predator per colpire il nemico. Basta una virgola fuori posto in un dataset. L’arma del futuro non fa rumore, non produce crateri e non si vede nemmeno con i satelliti. Si chiama data poisoning, e se non hai ancora capito quanto sia centrale per la guerra moderna, stai leggendo i giornali sbagliati. Benvenuti nella nuova era della disinformazione algoritmica, dove un’immagine pixelata o un’etichetta sbagliata possono compromettere l’intera architettura decisionale di un sistema militare autonomo. E no, non è fantascienza. È dottrina militare, nascosta nei silenzi obliqui del Title 50 dello U.S. Code.

Per capirne il senso, basta leggere tra le righe del Wall Street Journal, che già nel 2023 osservava con preoccupazione come le agenzie di intelligence americane stessero ripensando le operazioni sotto copertura alla luce dell’intelligenza artificiale. Non più spie in trench coat, ma informatici con accesso a set di dati strategici. Come ha scritto il Financial Times in un’analisi del 2024, “la competizione tra le superpotenze si giocherà sempre meno su chi addestra meglio i modelli e sempre più su chi li inquina meglio, senza essere scoperto”.

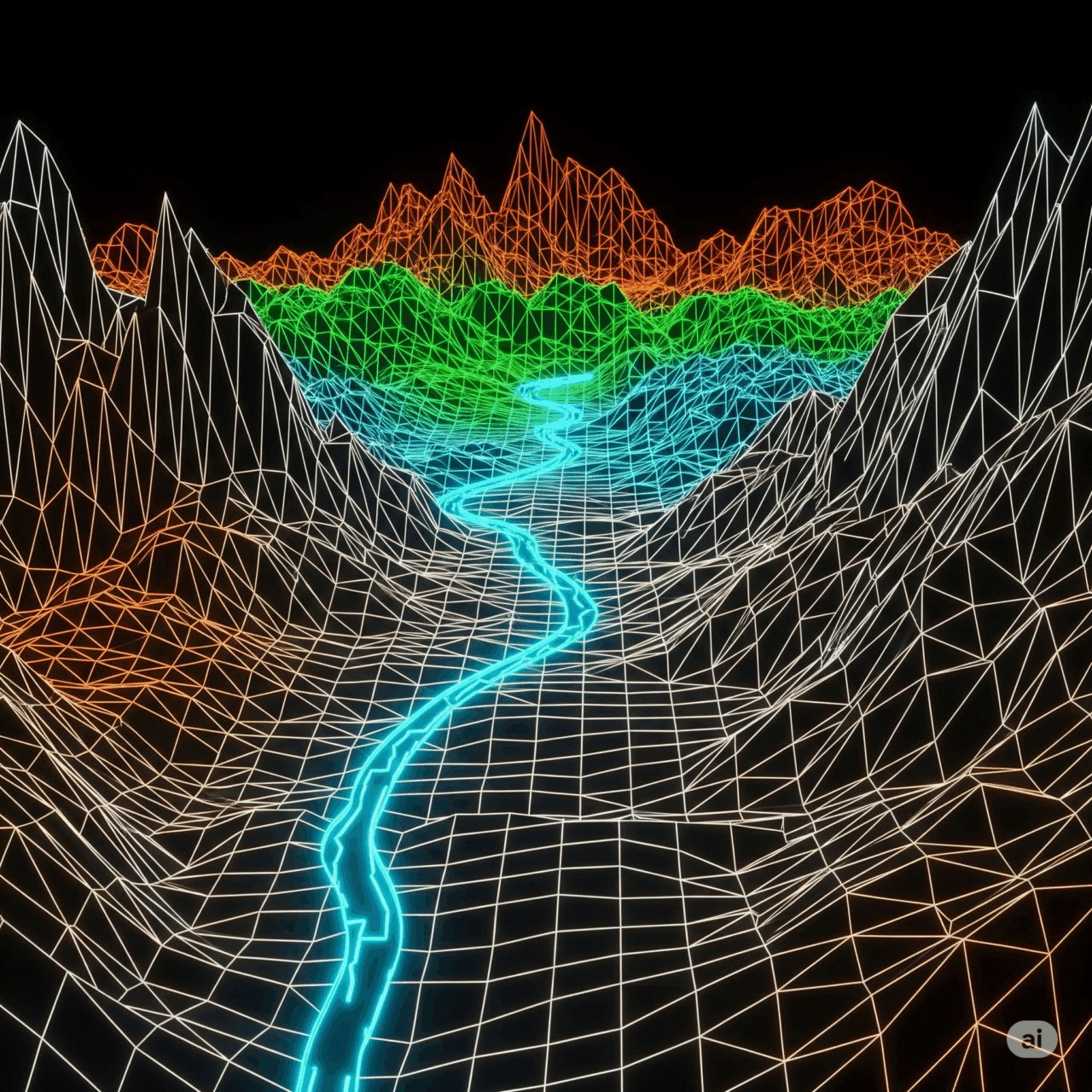

La logica è semplice: ogni sistema AI funziona perché ha imparato da qualcosa. Quel qualcosa si chiama training data, l’equivalente del “come mi hanno cresciuto” per un algoritmo. Alterare quei dati è come convincere un bambino che il fuoco raffredda e il ghiaccio brucia. Quando poi quel bambino diventa un soldato autonomo, hai appena sabotato un’arma senza mai toccarla.

Questo non è solo un gioco teorico. Cina e Russia investono miliardi in sistemi basati su AI per identificare mezzi militari, ottimizzare la logistica, dirigere fuoco d’artiglieria. Un’operazione di label flipping cioè insegnare a un algoritmo che un carro armato Abrams è un furgone DHL può generare errori devastanti. “È come mettere un paraocchi digitale a un generale nemico”, ha commentato Paul Scharre, esperto del Center for a New American Security. Il suo libro Four Battlegrounds lo dice senza mezzi termini: chi controlla i dati, controlla il futuro della guerra.

Ma questa partita si gioca in segreto. Il Title 50 dello U.S. Code, che disciplina le operazioni sotto copertura, offre il framework perfetto per nascondere attività di data poisoning all’interno di operazioni d’intelligence. Nessuna dichiarazione pubblica, solo un presidential finding e un briefing riservato al Congresso. Tutto il resto è silenzio.

Sotto questa cornice legale, si apre un ventaglio di opzioni operative. Il DoD, tramite il suo manuale 5240.01, autorizza l’intelligence militare a condurre operazioni nel cyberspazio, anche in assenza di conflitto armato dichiarato. L’obiettivo? Influenzare le condizioni militari di paesi stranieri, senza che nessuno possa imputarne la responsabilità agli Stati Uniti. Esattamente quello che serve per inquinare un dataset militare russo o cinese con dati manipolati, immagini ambigue, o segnali fittizi.

Il rischio, ovviamente, è quello del contraccolpo. Se l’America avvelena i pozzi digitali dei nemici, deve aspettarsi che lo stesso venga fatto ai suoi. Ed è qui che la questione si complica. Molti sistemi AI militari americani si allenano su dataset open source, commerciali o persino stranieri. Un bell’invito a nozze per chi vuole seminare il caos senza farsi scoprire. Il Clean Label Attack, per esempio, è una tecnica che inserisce immagini apparentemente innocue ma capaci di sabotare il comportamento del modello AI in condizioni operative. Nessun virus, nessuna intrusione evidente, solo un’allucinazione digitale ben confezionata.

Ma anche sul fronte difensivo gli Stati Uniti non stanno a guardare. Il Chief Digital and AI Office (CDAO) e la Joint Artificial Intelligence Center (JAIC) hanno già integrato moduli di adversarial training e tecniche di validazione dei dati per intercettare anomalie. In teoria. Nella pratica, il vantaggio lo mantiene chi riesce a rimanere un passo avanti nei meccanismi di avvelenamento progressivo, magari con attacchi slow poisoning che si attivano solo in contesti specifici, evitando i controlli automatici. Un virus dormiente nel DNA dell’algoritmo.

L’aspetto più affascinante è che il data poisoning non richiede necessariamente hacker in tuta nera davanti a terminali verdi. Può essere operato anche tramite asset umani, con metodologie da manuale CIA. Inserire un agente in un laboratorio di ricerca AI a Wuhan o in un fornitore di dati per l’esercito russo ha lo stesso potenziale di un attacco cyber, ma con un livello di tracciabilità quasi nullo. Secondo il Council on Foreign Relations, il 92% degli studenti cinesi che completano un PhD in AI negli Stati Uniti rimane nel paese dopo il dottorato. Opportunità perfetta per far penetrare la manipolazione direttamente nella pipeline educativa e industriale del nemico.

Le implicazioni legali sono complesse, ma non bloccanti. I principi del Law of Armed Conflict (LOAC) distinzione, proporzionalità e necessità possono guidare operazioni di data poisoning anche in assenza di guerra dichiarata. Non per vincolo giuridico, ma per disciplina strategica. Un attacco che mira esclusivamente a modelli per il riconoscimento di veicoli militari, evitando i sistemi per infrastrutture civili, rispetta la distinction. Un’operazione che degrada la precisione di targeting senza provocare danni collaterali eccessivi rientra nella proportionality. E se quell’azione offre un vantaggio militare concreto senza alternative meno distruttive, rispetta la necessity. Tutto il resto è narrativa.

E proprio la narrativa è l’altro campo di battaglia. Un AI avvelenata che provoca vittime civili sarà sempre imputata agli Stati Uniti se si scopre che ci hanno messo lo zampino. Non importa se il sistema era già mal progettato o se la colpa è di chi l’ha usato. La propaganda farà il suo corso. Ed è qui che serve un information operation parallelo, capace di dissociare l’immagine degli Stati Uniti dalle conseguenze di operazioni segrete. Come disse George Kennan, “la verità è spesso irrilevante in politica estera; ciò che conta è la percezione”.

Non c’è alcuna garanzia che i sistemi avversari smettano di funzionare solo perché li abbiamo sabotati. Ma se anche dovessero continuare a operare con margini d’errore crescenti, il vantaggio è comunque nostro. Il vero obiettivo è creare dubbio, incertezza, esitazione. Se un ufficiale russo non si fida più del modello AI che gli suggerisce dove lanciare un missile, è già una vittoria. Se un comandante cinese decide di tornare all’analisi umana per paura che i suoi sistemi siano compromessi, abbiamo rallentato la loro macchina bellica. E tutto questo senza sparare un solo colpo.

Certo, c’è un prezzo. Ogni atto di sabotaggio algoritmico contribuisce a un clima di sfiducia globale verso l’AI militare. Ma il paradosso è che proprio questa sfiducia diventa un’arma strategica: più il nemico dubita della propria tecnologia, più vulnerabile diventa. E mentre lui esita, noi possiamo agire.

Il futuro della guerra, insomma, non sarà deciso da chi ha il modello AI più potente, ma da chi sa controllare l’ecosistema dei dati. O, per dirla con le parole del generale Paul Nakasone, ex direttore della NSA: “la superiorità algoritmica è inutile senza la superiorità informativa”. E l’informazione, oggi, si costruisce o si distrugge un dato alla volta.