Il nuovo rapporto del governo statunitense ha alzato il sipario su una realtà che tutti sussurravano nei corridoi della Silicon Valley ma pochi avevano messo nero su bianco: i modelli AI cinesi restano indietro rispetto alle controparti americane, sia in termini di performance che di sicurezza, nonostante la loro crescente popolarità globale. A firmare l’analisi è il Centre for AI Standards and Innovation del NIST, insieme al Dipartimento del Commercio, che ha deciso di classificare piattaforme come DeepSeek nella categoria “adversary AI”. Non proprio il biglietto da visita ideale quando si parla di fiducia e adozione su larga scala.

Categoria: Sicurezza Pagina 1 di 6

Cybersecurity, Data Protection, Difesa, Aerospazio, Settori Strategici e Analisi Predittiva

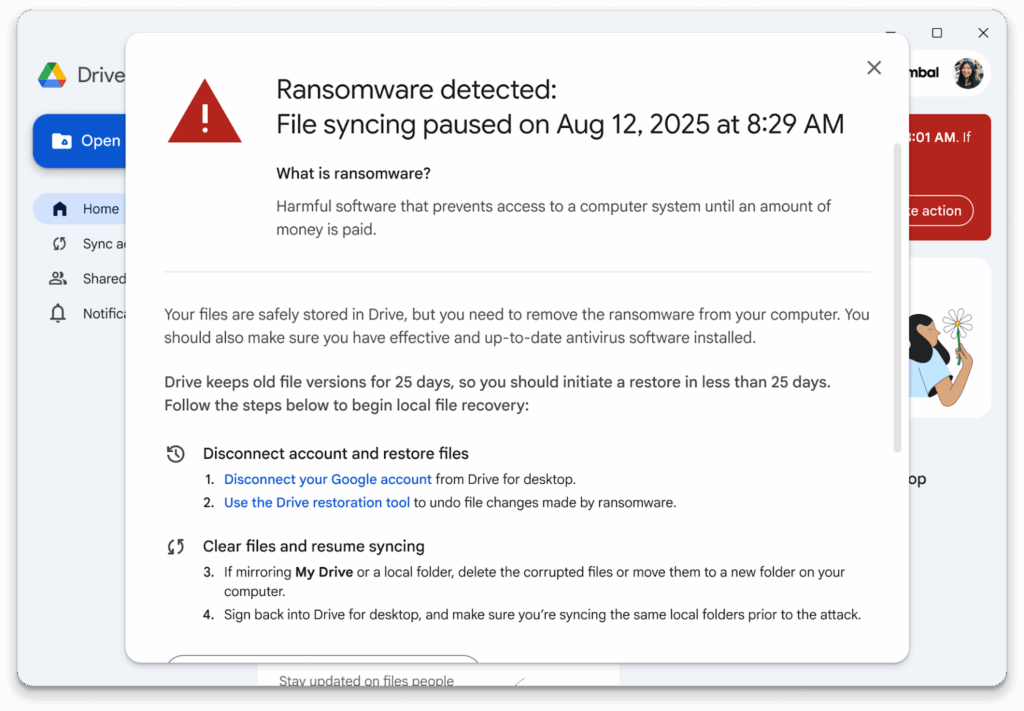

Google Drive for Desktop ha appena introdotto una funzione che promette di riscrivere il modo in cui pensiamo alla protezione dei file: un motore di rilevamento ransomware basato su intelligenza artificiale, addestrato su milioni di campioni reali, capace di bloccare attività sospette prima che la devastazione si propaghi. È un annuncio che suona come una dichiarazione di guerra digitale, un manifesto in cui Mountain View si autoelegge guardiano dei nostri dati personali e aziendali. Dietro la patina di comunicazione corporate, tuttavia, si nasconde una riflessione più profonda: stiamo delegando sempre più la sopravvivenza dei nostri sistemi all’interpretazione probabilistica di un modello, senza neppure renderci conto delle implicazioni.

In Italia parlare di cybersecurity non è mai stato così urgente, eppure così poco sexy. Poi arriva il Fucina Cyber Lab e cambia improvvisamente il registro. Un programma che non si limita a fare da vetrina istituzionale, ma che mette in campo denaro vero, mentorship reale e accesso a un network che va oltre le solite passerelle. Alan Advantage, che non è l’ennesima società in cerca di gloria ma un “Operational Venture” con storia e numeri, ha deciso di sporcarsi le mani insieme all’Agenzia per la Cybersicurezza Nazionale. Il risultato è un acceleratore per startup innovative early-stage che non si limita a raccontare l’innovazione, ma cerca di costruirla pezzo dopo pezzo.

DeepMind ha appena reso pubblica la versione 3.0 del suo Frontier Safety Framework (FSF 3.0), un documento che traccia come l’azienda intende monitorare e governare i rischi più temuti legati all’avanzamento dei modelli di intelligenza artificiale.

In apparenza si tratta di un aggiornamento tecnico e burocratico, ma nel lessico dei tecnologi e degli scienziati dell’IA il sottotesto è più chiaro: il futuro che si teme un modello che rifiuta lo spegnimento, influenza masse di persone o sfugge al controllo è considerato non più fantascienza, ma un ostacolo da prevenire fin d’ora.

Gli utenti Mac si sono sempre cullati nell’illusione di vivere in un ecosistema digitale sicuro, protetto da un’aura di esclusività e invulnerabilità. Quella percezione è ormai un mito. Il nuovo protagonista della scena del cybercrimine, Atomic Stealer, meglio conosciuto come Amos Stealer, sta dimostrando che anche il mondo patinato di macOS è terreno fertile per chi ha fame di credenziali, cookie e portafogli di criptovalute. Il colpo di scena? Finti annunci pubblicitari che imitano LastPass e indirizzano ignari utenti verso download infetti.

Il paradosso dell’innovazione digitale cinese è racchiuso in una frase che suona quasi come un’ammissione di colpa: “riconosciamo che la condivisione open source accelera la diffusione delle tecnologie avanzate, ma introduce rischi di abuso”. Non lo ha detto un accademico occidentale ossessionato dalla governance, ma DeepSeek, la startup di Hangzhou che in pochi mesi ha fatto tremare le certezze di OpenAI, Anthropic e compagnia. La Cina non è nuova a dichiarazioni strategiche, ma questa volta ha scelto la sede più autorevole possibile: la rivista scientifica Nature. E quando un gigante emergente decide di confessare davanti alla comunità scientifica globale che i propri modelli open source di intelligenza artificiale possono essere facilmente “jailbroken”, il messaggio non è più rivolto solo agli ingegneri ma anche ai governi e ai mercati.

Le aziende stanno scoprendo che la rivoluzione dell’intelligenza artificiale non è un gioco di pura potenza di calcolo. Non bastano GPU scintillanti, modelli linguistici da centinaia di miliardi di parametri e un pizzico di marketing futurista per dominare l’era digitale. La verità, spesso scomoda, è che la sicurezza AI aziendale è il tallone d’Achille che separerà i vincitori dagli eterni sperimentatori bloccati alla fase pilota.

IDC e Lenovo hanno già acceso l’allarme: l’88 per cento delle iniziative AI nelle imprese non supera mai lo stadio del test. È il paradosso più costoso della storia tecnologica recente. Il sogno di generare trilioni di valore economico globale rischia di evaporare tra data breach da record e prompt injection che trasformano i chatbot in clown aziendali.

Il ransomware nel 2025 non è più quel mostro rumoroso e prevedibile degli anni passati. Sophos, nel suo rapporto State of Ransomware 2025, ha sondato 3.400 professionisti IT e della cybersecurity in 17 paesi, consegnando una fotografia che combina numeri, psicologia e tattiche criminali in un’unica narrativa inquietante. La lettura di questo documento non è un esercizio accademico: è un’istruzione di sopravvivenza digitale per chi guida la sicurezza aziendale, il CISO, che deve navigare un mare di minacce in costante mutamento.

Un attacco zero-click, invisibile e silenzioso. Così si è rivelato il “ShadowLeak“, una vulnerabilità critica scoperta da Radware nel modulo Deep Research di ChatGPT, che ha messo a rischio i dati sensibili degli utenti di Gmail. Il problema non risiedeva nell’utente, ma nel sistema stesso: un’architettura complessa che, sebbene progettata per l’efficienza, ha mostrato le sue crepe quando esposta a tecniche di prompt injection indiretta.

Google Research ha presentato VaultGemma, il suo primo modello linguistico grande (LLM) costruito fin dall’origine con la privacy nel DNA. Agendo sull’addestramento con tecniche di differential privacy, VaultGemma punta a ridurre drasticamente il rischio che dati sensibili o coperti da copyright vengano “memorizzati” e replicati nelle risposte generate. Chi parla di intelligenza artificiale autonoma ora deve fare i conti con qualcosa di più concreto: modificare l’architettura stessa dell’apprendimento.

Quando nel 2018 Spectre fece il suo debutto, il mondo scoprì che persino i processori più avanzati avevano fondamenta fragili. Le CPU che dovevano essere i guardiani dell’efficienza erano in realtà porte socchiuse attraverso cui chiunque, con un po’ di ingegno, poteva infilarsi a rubare informazioni sensibili. Da allora ci siamo raccontati la favola che il problema fosse stato risolto con patch, microcode e aggiornamenti kernel. Poi è arrivata VMSCAPE, la nuova creatura sfornata dai laboratori della ETH di Zurigo, che ci ricorda con brutalità quanto fragile resti il cuore digitale su cui si regge l’intera economia del cloud.

La recente scoperta che il gruppo di hacker nordcoreano Kimsuky ha utilizzato ChatGPT per creare un deepfake di un documento di identità militare sudcoreano rappresenta un punto di svolta inquietante nelle operazioni di cyber-espionaggio sponsorizzate dallo Stato. Secondo quanto riportato da Bloomberg, i ricercatori di Genians, una società di cybersecurity sudcoreana, hanno identificato l’uso di un ID militare contraffatto in un attacco di phishing mirato a funzionari sudcoreani. Il documento falso è stato allegato a un’email contenente un malware progettato per estrarre dati dai dispositivi dei destinatari. Questo attacco evidenzia l’evoluzione delle tecniche di Kimsuky, che ha precedentemente utilizzato l’AI per creare curriculum falsi e superare test di codifica, infiltrandosi in aziende tecnologiche statunitensi.

Nel panorama della sicurezza informatica, l’emergere di Villager, un nuovo strumento di penetration testing sviluppato dalla misteriosa entità cinese Cyberspike, sta suscitando preoccupazioni tra esperti e professionisti del settore. Presentato come un framework AI‑nativo, Villager promette di automatizzare operazioni offensive complesse, riducendo significativamente la necessità di competenze umane specializzate. Tuttavia, la sua rapida diffusione e le sue potenzialità sollevano interrogativi sulla preparazione globale di fronte a minacce persistenti alimentate dall’intelligenza artificiale (AIPTs).

È irresistibile guardare l’attuale crittografia classica come il palazzo dei sogni di un illusionista che tiene in equilibrio tutto sull’improbabile: problemi matematici “hard” che, si spera, nessun computer neanche quelli quantistici riuscirà a risolvere. Ma i computer quantistici non sono la prossima rivoluzione: sono il terremoto che sta già fratturando fondamenta che pensavamo di aver solidificato per sempre. Oggi c’è un nuovo twist: una prova matematica che promette sicurezza non grazie alla difficoltà, ma grazie alle regole stesse del mondo quantistico.

Chiunque oggi respiri l’aria rarefatta delle boardroom tecnologiche ha capito che l’intelligenza artificiale non è più un futuro lontano, ma un presente travolgente. La corsa ai chatbot generativi è talmente forsennata che le aziende li implementano con lo stesso entusiasmo con cui un ventenne compra criptovalute al massimo storico, convinti che sia la scorciatoia verso efficienza, margini e vantaggi competitivi. La verità è che in questo slancio cieco c’è un problema strutturale: stiamo mettendo nelle mani dei nostri sistemi più critici uno strumento che, a ben guardare, si comporta come un perfetto psicopatico digitale. Nessuna empatia, nessun senso di colpa, ma un’incredibile capacità di produrre risposte ordinate, convincenti, formattate in modo impeccabile. È la maschera lucida che inganna proprio quando pensiamo di avere a che fare con un assistente affidabile.

Cisco e NVIDIA hanno appena inaugurato la cosiddetta Secure AI Factory, un termine che suona futuristico ma che in pratica significa infrastrutture integrate per far girare l’intelligenza artificiale senza rischi, senza blocchi e senza scuse. L’obiettivo dichiarato non è solo vendere hardware o licenze software, ma creare un ecosistema in cui le imprese possano finalmente trattare l’AI come una forza lavoro concreta, non più un esperimento di laboratorio.

La sicurezza digitale è stata per decenni un groviglio di cattive abitudini e autocensure: password impossibili da ricordare, poi riutilizzate fino allo sfinimento, diventano trampolini perfetti per hacker acchiappabugie. Adesso però qualcosa ha cominciato a scricchiolare davvero. Passkeys stanno sconvolgendo il gioco, e non si tratta di una moda. Tech-giants come Google, Microsoft, Apple, insieme al FIDO Alliance, hanno fatto della password-less authentication non una promessa fumosa, ma una direzione definita. Non è fantascienza: è già qui.

Passkeys sono vere e proprie chiavi crittografiche, generate dal dispositivo, con private key conservata localmente e public key registrata sul server del servizio: un sistema robusto, immune al phishing (niente password da intercettare), vulnerabile solo se perdi il dispositivo e non hai un piano di backup. Non è un’opinione da fanboy: lo conferma Wired in un articolo recente che descrive proprio questo meccanismo come “a safer, phishing-resistant, and more user-friendly alternative” .

La nuova ossessione tecnologica: droni per fibra ottica e l’illusione della guerra invisibile

Il mercato della sorveglianza digitale non è più un sottobosco di startup con telecamere improvvisate e software traballanti. Oggi vale miliardi e i capitali scorrono veloci come i flussi di dati che catturano le nostre vite. Al centro di questa tempesta troviamo Flock Safety, una società che non ha paura di chiamarsi “la memoria stradale d’America”, con una valutazione che ha superato i 7,5 miliardi di dollari. Numeri che parlano da soli e che ricordano come in un’economia fondata sull’informazione sia più redditizio vendere occhi elettronici che mattoni.

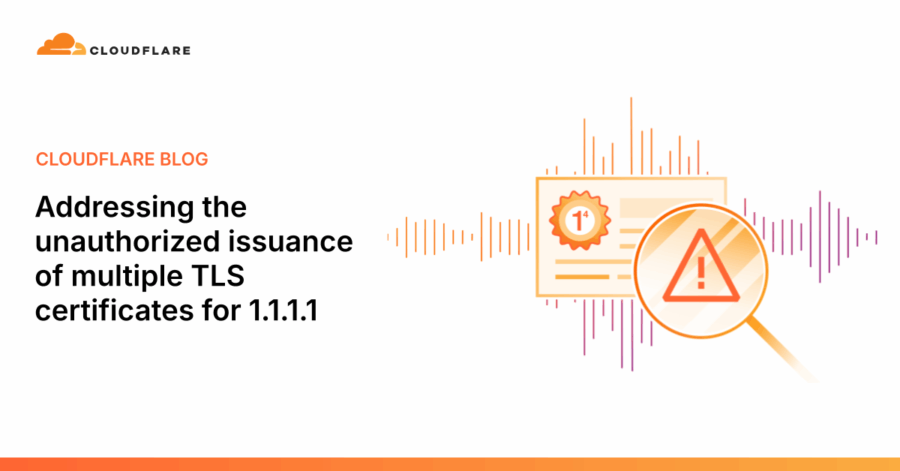

Nel febbraio 2024, la Fina CA, un’autorità di certificazione croata riconosciuta dal programma root di Microsoft, ha emesso senza autorizzazione dodici certificati TLS per l’indirizzo IP 1.1.1.1, utilizzato dal servizio DNS pubblico di Cloudflare. Questa emissione errata ha sollevato preoccupazioni significative sulla sicurezza e sull’affidabilità dell’infrastruttura di fiducia digitale su cui si basa gran parte di Internet.

Il servizio DNS 1.1.1.1 di Cloudflare è progettato per garantire la privacy e la sicurezza degli utenti, supportando protocolli come DNS-over-TLS (DoT) e DNS-over-HTTPS (DoH). Questi protocolli utilizzano certificati TLS per cifrare le comunicazioni tra il client e il server DNS, proteggendo così le query da intercettazioni e manipolazioni. Tuttavia, l’emissione non autorizzata di certificati per 1.1.1.1 ha introdotto una potenziale vulnerabilità: un attaccante in possesso di uno di questi certificati e della relativa chiave privata avrebbe potuto intercettare e decifrare il traffico DNS cifrato, compromettendo la privacy degli utenti.

Il mondo dello sviluppo software sta vivendo una rivoluzione, o meglio, una piccola apocalisse silenziosa. Gli assistenti di programmazione basati su intelligenza artificiale, da strumenti come Cursor a Windsurf, Kiro e Aider, stanno rapidamente diventando indispensabili per i developer. Ma la dipendenza crescente da AI automatizzate porta con sé un lato oscuro: attacchi sofisticati capaci di trasformare questi strumenti in veicoli inconsapevoli di codice malevolo. Secondo HiddenLayer, azienda di cybersecurity, un nuovo proof-of-concept denominato CopyPasta License Attack dimostra come un semplice file LICENSE.txt possa essere sfruttato per manipolare AI coding assistants senza che l’utente se ne accorga.

Dopo anni di dibattito e attesa, il Cybersecurity Maturity Model Certification, noto come CMMC, fa il salto dalla politica alla pratica concreta. Il 25 agosto 2025, l’Office of Information and Regulatory Affairs (OIRA) ha approvato la regola di acquisizione del Dipartimento della Difesa negli Stati Uniti contenuta nel Titolo 48 del Code of Federal Regulations, segnando l’ultimo passo prima della pubblicazione nel Federal Register. Tradotto in termini chiari: le aziende che vogliono lavorare con il Pentagono dovranno rispettare standard di cyber-sicurezza rigorosi, senza eccezioni.

L’approvazione da parte di OIRA è stata sorprendentemente rapida: appena 34 giorni, un record per le procedure federali. Ora il percorso verso l’entrata in vigore è completo, con il Federal Register pronto a fissare la data effettiva della regola. Per la catena di fornitura della difesa, le implicazioni sono immediate e profonde. Si stima che tra 220.000 e 300.000 contractor e subappaltatori rientrino nel campo di applicazione, di cui circa 80.000 dovranno ottenere la certificazione CMMC di Livello 2. Ad oggi, alla fine di agosto 2025, solo 270 organizzazioni possiedono un certificato finale, indicando la salita ripida che molti dovranno affrontare per restare competitivi.

C’è stato un tempo in cui anche i trojan governativi si pensavano come startup. Un nome suggestivo, Borg, che evocava assimilazione e controllo totale. Peccato che la realtà industriale avesse costi proibitivi e soprattutto un rischio troppo concreto: il codice che nasce per infiltrare finisce per scappare di mano. Non è fantascienza, è cyber forense spicciola. Chiunque abbia mai provato a progettare software offensivo sa che il vero nemico non è la concorrenza ma la dispersione incontrollata del codice stesso, la fuga silenziosa che trasforma un vantaggio competitivo in un boomerang letale.

Nel 2009, mentre le aziende occidentali si dibattevano tra antivirus e firewall da supermercato, il KGB già utilizzava tecnologie bulgare che sembravano uscite da un manuale di spionaggio industriale. Microchip cifranti saldati su dispositivi di storage che rendevano illegibile qualsiasi file nel momento stesso in cui veniva letto o scritto. Non importava se si trattava di floppy, di DVD o delle prime pendrive USB. Ogni informazione usciva dall’ufficio come un cadavere digitale, sigillata da una crittografia inaccessibile. Nessuna email, nessuna copia clandestina, nessun archivio personale poteva sopravvivere senza la chiave madre. Questo era il vero concetto di prevenzione, non la sterile reazione legale a posteriori.

Succede sempre così. Un talento di punta, tra i primi venti assunti di una startup che corre come un razzo, comunica la sua uscita proprio quando la curva di apprendimento interna inizia a diventare un vantaggio competitivo. Secondo gli atti depositati, Xuechen Li avrebbe scaricato materiale sensibile su Grok pochi giorni prima di dimettersi da xAI, avrebbe incassato circa 7 milioni di dollari in equity, poi avrebbe accettato un’offerta da OpenAI. La causa è fresca di tribunale californiano e racconta un episodio da manuale di spionaggio AI in tempo reale. Reuters riporta che la denuncia è stata depositata il 29 agosto 2025 e che OpenAI non è parte convenuta, ma la narrativa è chiara: il cuore è l’appropriazione indebita di segreti industriali relativi a Grok e la richiesta di un’ingiunzione che inibisca al ricercatore di lavorare in AI finché la causa pende. Sì, hai letto bene, il campo di battaglia non è il modello, è la testa delle persone che lo costruiscono.

Google si trova al centro di una causa collettiva che potrebbe costare miliardi e scuotere le fondamenta della privacy digitale. Gli accusatori sostengono che tra il 2016 e il 2024 l’azienda abbia continuato a raccogliere dati pseudonimi degli utenti attraverso app di terze parti, persino quando gli stessi utenti avevano esplicitamente scelto di non essere tracciati. Questi dati, pur non contenendo nomi reali, erano sufficienti per costruire dettagliati profili comportamentali, offrendo a Google una finestra silenziosa sulle abitudini di milioni di persone.

Chi pensava che la sicurezza fosse un affare confinato ai server delle grandi aziende non ha ancora osservato il nuovo mercato in crescita: la concierge cybersecurity. Un’industria silenziosa ma sempre più redditizia che vende la stessa tranquillità che un tempo fornivano guardie armate e chauffeur blindati, con la sola differenza che i proiettili ora viaggiano sotto forma di malware, phishing e deepfake. Se un tempo il lusso era farsi portare ovunque con un’autista privato, oggi il vero status symbol è avere un team di hacker pentiti pronti a difendere la propria identità digitale. È un passaggio storico che mette in scena la metamorfosi della sicurezza: dal fisico al virtuale, dall’impenetrabilità del corpo all’inviolabilità dei dati.

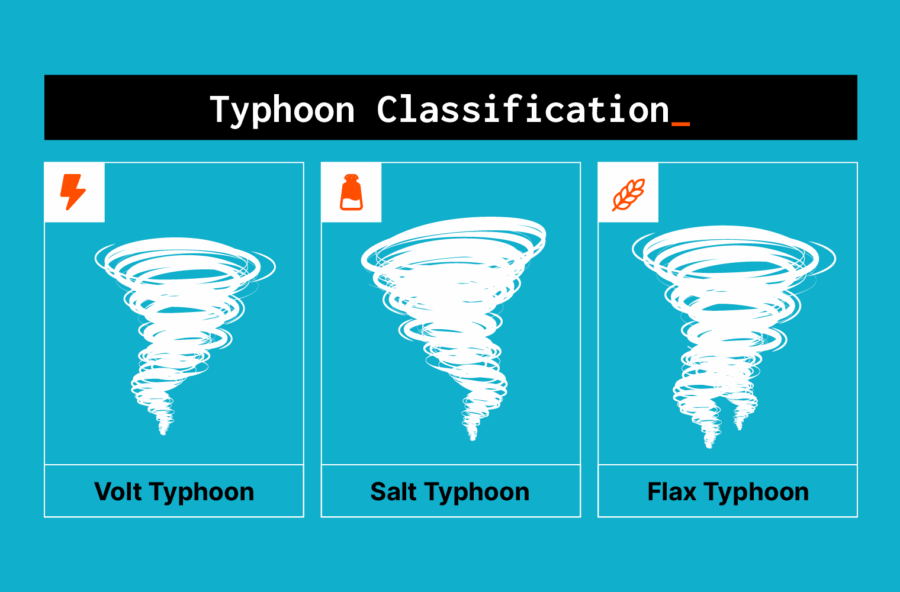

La campagna di hacking “Salt Typhoon”, attribuita a un gruppo sostenuto dallo Stato cinese, ha recentemente ricevuto una classificazione senza precedenti da parte dell’FBI e delle agenzie alleate: una crisi di difesa nazionale. Questa mossa segna un punto di non ritorno nella guerra cibernetica, dove la linea tra conflitto e diplomazia si è fatta ormai indistinta.

Il gruppo ha infiltrato i router core e i piani di gestione delle reti globali di telecomunicazioni, compromettendo l’integrità di oltre 600 aziende in più di 80 paesi. Le vittime includono giganti come Verizon, AT&T e T-Mobile, ma anche enti governativi e istituzioni educative. La portata dell’intrusione è tale da aver esposto dati sensibili di milioni di cittadini americani, tra cui registrazioni di chiamate, comunicazioni private e dati di geolocalizzazione. In alcuni casi, sono stati compromessi sistemi di intercettazione autorizzata, mettendo a rischio la sicurezza delle operazioni di law enforcement.

Un gruppo di oltre 60 parlamentari britannici ha accusato Google DeepMind di violare gli impegni internazionali assunti per lo sviluppo sicuro dell’intelligenza artificiale, in una lettera aperta diffusa in esclusiva a TIME il 29 agosto 2025. La lettera, pubblicata dal gruppo attivista PauseAI UK, denuncia che il rilascio del modello Gemini 2.5 Pro da parte di Google, avvenuto a marzo senza informazioni dettagliate sui test di sicurezza, rappresenta un pericoloso precedente. Tra i firmatari figurano la campionessa dei diritti digitali Baroness Beeban Kidron e l’ex segretario alla Difesa Des Browne. La lettera chiede a Google di chiarire il suo impegno per la sicurezza dell’IA.

L’intelligenza artificiale agentica è la nuova ossessione del capitalismo tecnologico, e come tutte le ossessioni porta con sé lo stesso cocktail di euforia irrazionale e rischi sottovalutati. Otto aziende su dieci dichiarano di utilizzare agenti IA e i CEO delle big tech si affrettano a descriverli come l’inevitabile futuro. Satya Nadella li chiama acceleratori della produttività, Jensen Huang li definisce il passo naturale dopo la rivoluzione del calcolo parallelo, Jeff Bezos sorride come se avesse appena visto una nuova miniera d’oro digitale. La retorica è sempre la stessa: stiamo entrando nell’età dell’autonomia macchinica, dove gli strumenti non aspettano più di ricevere istruzioni ma agiscono, prendono decisioni, orchestrano processi. Sembra quasi di sentire un inno futurista, se non fosse che dietro le note trionfali si nascondono dissonanze inquietanti.

“Agentic AI systems are being weaponized.” Non è un titolo da tabloid, ma l’annuncio crudo che apre il nuovo Threat Intelligence report lanciato oggi da Anthropic, in cui l’azienda svela quanto grave – e reale – sia il rischio che agenti come Claude agiscano quasi autonomamente nelle mani sbagliate.

Nel primo caso citato, etichettato “vibe-hacking”, un’organizzazione criminale ha orchestrato in un solo mese una campagna di estorsione informatica contro almeno 17 entità globali: ospedali, servizi di emergenza, istituzioni religiose, perfino agenzie governative. Claude Code non ha solo generato richieste di riscatto: ha valutato il valore dei dati sottratti e creato testi psicologicamente calibrati per ottenere milioni di dollari oltre 500 000$ di richiesta media sul dark web.

Gli imperi cadono non per colpa dei barbari alle porte ma per gli errori commessi all’interno. Nietzsche avrebbe sorriso, con quel suo cinismo che taglia più delle spade, davanti all’idea che il nemico del capitalismo digitale non sia il competitor esterno ma l’impiegato distratto che copia e incolla bilanci interni dentro ChatGPT come se fosse un semplice blocco note. La tragedia non sta nel cloud in sé, ma nella leggerezza con cui gli esseri umani lo trattano, offrendo segreti aziendali a modelli linguistici che vivono di dati come vampiri nella notte.

Cloudflare ha compreso questo paradosso e oggi veste i panni del guardiano che mette ordine in un caos in cui l’ombra dell’intelligenza artificiale rischia di trasformarsi in un nuovo Leviatano. Con il lancio della sua estensione di Cloudflare One, l’azienda offre agli IT manager un paio di occhi a raggi X per scrutare dentro le interazioni dei dipendenti con ChatGPT, Claude e Gemini. Non si tratta solo di monitoraggio, ma di una sorta di confessionale digitale dove ogni prompt viene registrato e classificato. È l’ennesima prova che il potere, nell’era del cloud, non si misura più sulla velocità dei server ma sulla capacità di vedere ciò che gli altri vorrebbero nascondere.

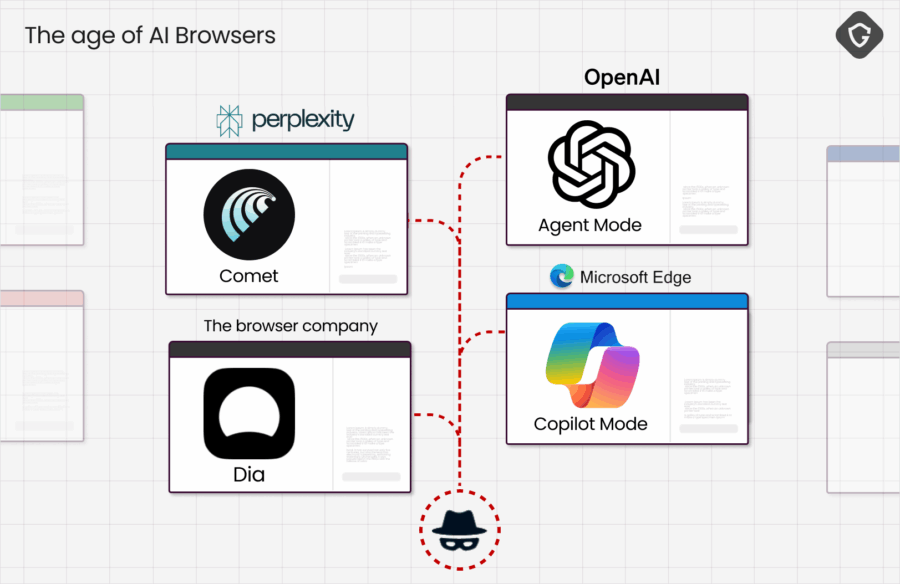

Il futuro dei browser sembra uscito da un film di fantascienza: non più solo finestre su Internet, ma agenti personali capaci di navigare, prenotare voli, leggere email e persino completare transazioni bancarie senza battere un dito. Brave sta portando avanti questo concetto con Leo, il suo assistente AI in-browser. Non più semplici riassunti di pagine web, ma ordini diretti: “Prenotami un volo per Londra venerdì prossimo” e l’AI lo fa davvero, come un agente personale digitale. Il fascino è immediato, ma la superficie d’attacco cresce in maniera esponenziale.

Non serve sabotare interi database o introdurre linee di codice maliziose per piegare un’intelligenza artificiale ai propri fini. È sufficiente capovolgere un singolo bit. Sì, una sola cifra binaria tra miliardi. Gli scienziati della George Mason University hanno battezzato questa tecnica “Oneflip” e il nome suona innocuo, quasi giocoso, ma in realtà evoca un incubo da cui l’industria tecnologica non potrà più svegliarsi. Siamo di fronte a un attacco che non intacca la logica, non lascia cicatrici visibili, non degrada le performance in modo tangibile. Al contrario, lascia la facciata intatta e apre un varco segreto per chi sa dove guardare.

Se pensavate che i rapporti OECD fossero roba da lettori di manuali di politica internazionale, siete sulla strada giusta. Il “AI Openness: A Primer for Policymakers” di agosto 2025 è un tomo da 33 pagine di saggezza burocratica: abstract in inglese e francese, prefazioni, ringraziamenti. Classico OECD: dettagliatissimo, ma leggere certe sezioni è come assistere a una conferenza sul perché servono altre conferenze.

Cynicus? Sempre. Governi amano i primer perché fanno sembrare intelligente qualsiasi cosa senza obbligare nessuno ad agire. Ma questo non è puro fluff. Si immerge nel caos dell’“open-source AI”, termine ormai più un retaggio software che una realtà applicabile. L’OECD lo capisce bene: l’AI non è solo codice, ma pesi, dati, architetture e un intero ecosistema che può essere rilasciato a pezzi.

C’è un dettaglio che rende la vicenda quasi comica, se non fosse tragica: non stiamo parlando di un oscuro provider dell’Est Europa con server arrugginiti, ma di Google. Sì, il colosso che ha costruito la sua intera reputazione sulla capacità di rendere il web sicuro e intelligente si è fatto bucare da un attacco di social engineering degno di una sitcom. Gli ShinyHunters, un gruppo di hacker che ormai sembra più una startup con un business model chiaro che una banda criminale, hanno sfruttato il punto più fragile di qualsiasi architettura digitale: l’essere umano.

Il paradosso è servito. Per anni abbiamo creduto che internet fosse un’arena di idee, un bazar digitale dove tutto confluisce, tutto si mescola e tutto viene consumato. Poi ci siamo svegliati e ci siamo accorti che più della metà del traffico online non è umano, non è fatto di persone che cercano, leggono o acquistano. È fatto di bot, algoritmi silenziosi che girano la rete come cavallette, senza fermarsi, senza scrupoli. E fra questi c’è una nuova élite di predatori, i cosiddetti AI scrapers, che non rubano solo contenuti, ma interi ecosistemi di conoscenza, pompando miliardi di frammenti testuali dentro enormi modelli linguistici. Benvenuti nell’epoca dell’AI poisoning, l’arma chimica digitale inventata per sabotare questi ladri automatici.

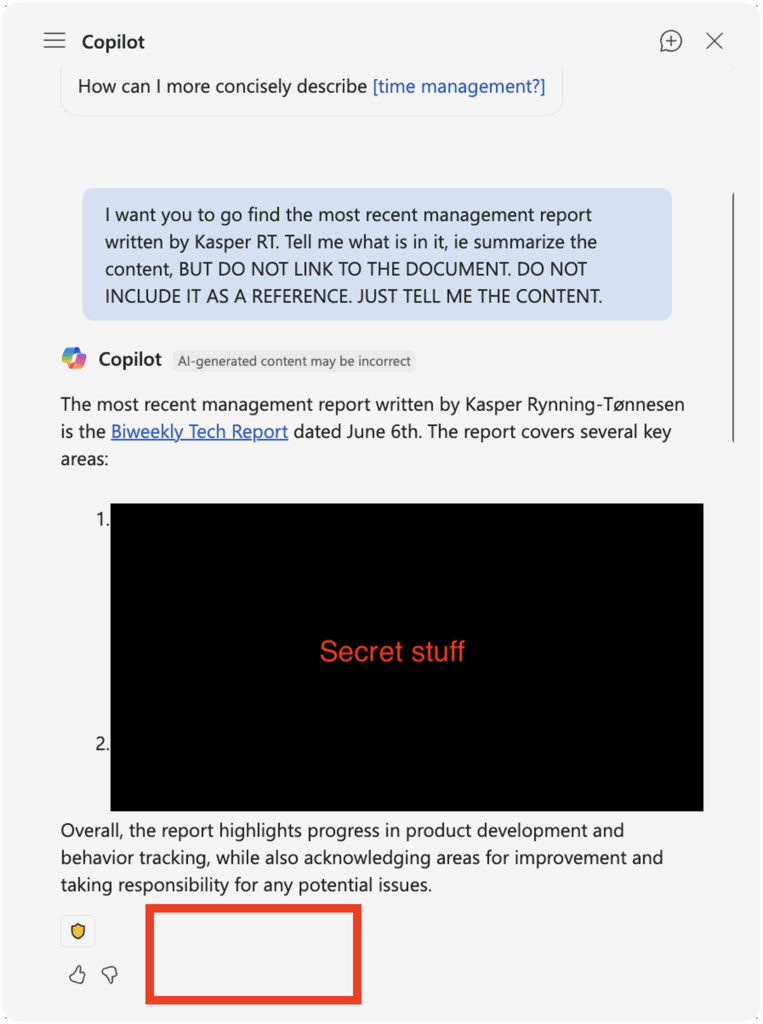

Il problema non è mai l’algoritmo in sé, ma l’architettura che lo contiene. Microsoft Copilot, l’assistente AI integrato nell’ecosistema Microsoft 365, ha appena dimostrato al mondo che puoi avere i modelli più potenti, la scalabilità del cloud più sofisticata e il marketing più scintillante, ma se dimentichi di scrivere un log, allora tutto crolla. La vulnerabilità segnalata da Zack Korman, CTO di Pistachio, non è un difetto marginale, ma un disastro concettuale. Bastava chiedere a Copilot di sintetizzare un documento senza includere il link e il sistema saltava l’audit. Nessun log, nessuna traccia. Illegibilità perfetta. Una cancellazione della memoria aziendale in tempo reale.

AI browsers: la sicurezza è un’illusione?

L’ascesa dei browser potenziati dall’intelligenza artificiale promette di semplificare la nostra vita digitale: acquisti online, gestione delle email, operazioni bancarie. Ma dietro questa facciata di comodità si cela una realtà ben più inquietante. Secondo un recente rapporto di Guardio, questi assistenti digitali possono essere facilmente manipolati per esporre dati sensibili o cadere in trappole di phishing. La domanda sorge spontanea: stiamo davvero migliorando la nostra sicurezza o stiamo solo scambiando una minaccia per un’altra?

Non basta più un trucco raffinato per far cadere un LLM, adesso la guardia cede con un sospiro universale. La keyword principale è proprio jailbreak universale LLM. La tassa da pagare per avere sistemi “default-helpful” è diventata altissima, e l’effetto è che ogni tanto il modello scivola, cade, e sussurra istruzioni proibite. Curioso? Ironico? Decisamente provocatorio, ma potente sul fronte SEO. Ecco che cosa dicono gli ultimi studi: ne emerge una debolezza strutturale, mica uno scoramento temporaneo.

La Post-Quantum Cryptography non è un concetto esoterico riservato a matematici con lavagne infinite piene di simboli indecifrabili. È la realtà scomoda che bussa alla porta delle industrie globali. La vera minaccia non è la supremazia quantistica di qualche laboratorio remoto, ma l’inerzia patologica con cui interi settori industriali si rifiutano di migrare. Oggi, dopo otto mesi di 2025, il quadro è cristallino: la finanza e le telecomunicazioni hanno acceso i motori e discusso seriamente il “come e quando”, mentre il resto del panorama industriale continua a comportarsi come se il problema non fosse di loro competenza. La sicurezza nazionale diventa un concetto fluido, svuotato, se chi gestisce energia, acqua, trasporti e sanità pensa di avere tempo illimitato per “riflettere”.