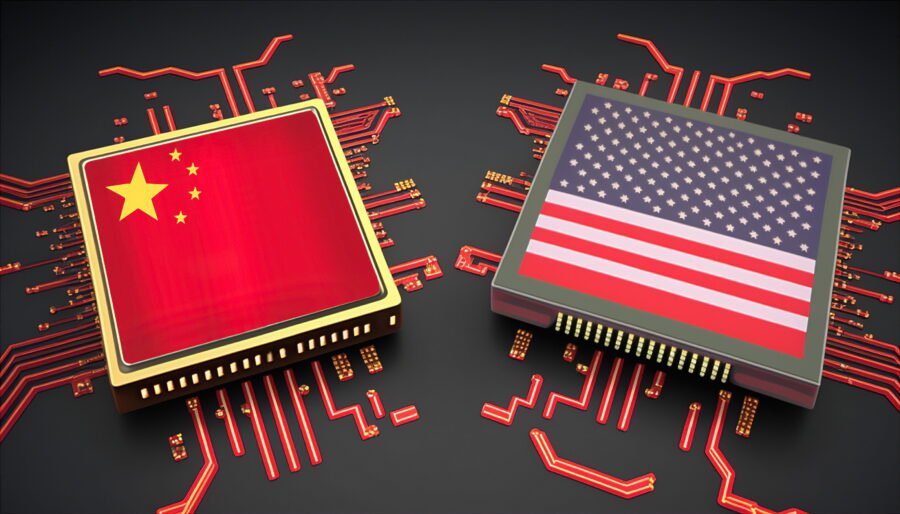

Quando nel mondo tech americano si parlava della cultura lavorativa cinese 9-9-6, lo si faceva con un misto di sconcerto e disprezzo velato. Lavorare dalle 9 alle 21, sei giorni su sette? Una barbarie made in Shenzhen, roba da fabbriche digitali dove il capitale umano è sacrificabile quanto un vecchio server. Ma adesso, nella Silicon Valley dopata dall’intelligenza artificiale, quel modello inizia a sembrare quasi rilassato. Il nuovo mantra? Zero-zero-sette. Non James Bond, ma zero ore, sette giorni: il ciclo completo della nuova mistica del lavoro AI, dove l’unica pausa concessa è il sonno REM tra due sprint di deployment.

La parabola più grottesca viene da Cognition, startup americana specializzata in generazione di codice. Un nome che fa pensare all’intelligenza, alla riflessione, magari all’etica. Nulla di tutto questo. Dopo l’acquisizione del rivale Windsurf, il CEO Scott Wu ha inviato un’email interna che potrebbe essere letta come una dichiarazione di guerra alla vita stessa. Ottanta ore a settimana, sei giorni in ufficio, il settimo a fare call tra colleghi. Nessuna “work-life balance”. Quella, evidentemente, è roba da boomer. “Siamo gli sfavoriti”, scrive Wu, con un tono che pare uscito da una fan fiction distopica in cui Elon Musk guida una setta. I nuovi dipendenti? Dovranno adattarsi o uscire dalla porta sul retro.

Cosa spinge questi moderni monaci digitali a rinunciare a tutto per un cluster di GPU e una valuation ipotetica? Il denaro, certo, ma non solo. La religione dell’hypergrowth ha le sue liturgie, e dormire in ufficio sembra essere diventata una di esse. Una foto su Slack alle 2 del mattino davanti a una dashboard di metrics, una cena consumata su una sedia ergonomica mentre si aggiorna un modello linguistico, sono oggi il corrispettivo delle cicatrici di guerra. Sarah Guo, investitrice in Cognition, lo dice chiaramente: “If this offends you, ngmi” ovvero “se questo ti offende, non ce la farai”. Una frase che suona come un verdetto darwiniano più che un consiglio.

Nel frattempo, startup come Mercor (assunzioni AI) e Anysphere (assistenti di codifica) non si nascondono: anche lì si lavora sette giorni su sette. Nessuna eccezione, nessuna domenica. L’obiettivo è diventare the next big thing e per farlo bisogna spezzarsi, insieme ai propri team. Masha Bucher, fondatrice del fondo Day One Ventures, ci mette il carico da novanta: “Se un founder non è in ufficio almeno un giorno nel weekend, allora sì che mi preoccuperei”. A quanto pare, anche il sabato di ricarica è una debolezza da eliminare.

La trasformazione è tanto inquietante quanto indicativa. Queste non sono startup che rincorrono la produttività. Sono culti tecnologici travestiti da aziende, dove il capitale umano è trattato come un modello di machine learning: più lo alleni, più performa, finché collassa. Il linguaggio è quello del sacrificio eroico, della resistenza estrema, dell’urgenza messianica. In fondo, “lavorare 80 ore a settimana per costruire il futuro” suona meno bene se lo chiami semplicemente sfruttamento.

Ma dietro tutto questo c’è una verità più scomoda. I fondatori e gli investitori stanno orchestrando una narrazione in cui la fatica disumana diventa un badge of honor, un segno distintivo che fa lievitare le valutazioni come una buona metrica di retention. Cognition è vicina a una nuova raccolta fondi che potrebbe raddoppiarne la valutazione a 10 miliardi. Vuoi attrarre i capitali nel 2025? Mostra quanto sei “hardcore”, quanto riesci a spingere il tuo team sull’orlo del burnout. E magari fagli anche sorridere per la foto su Forbes.

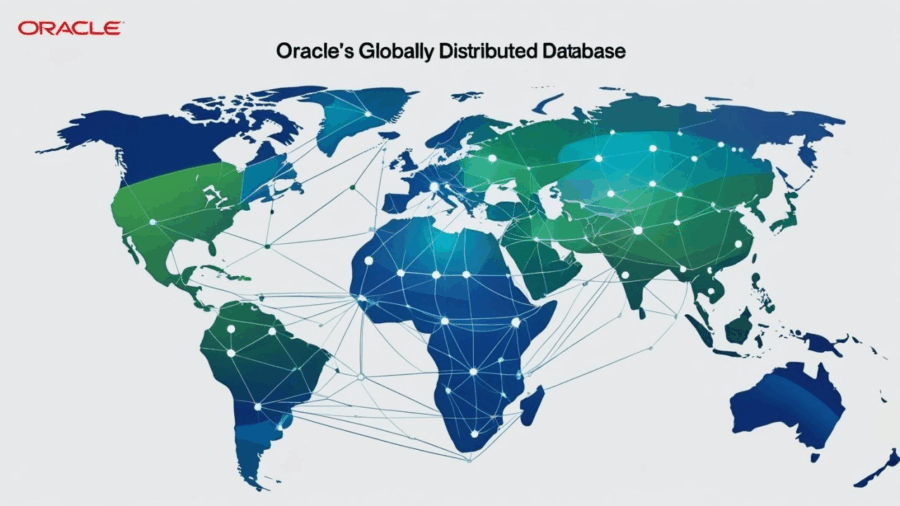

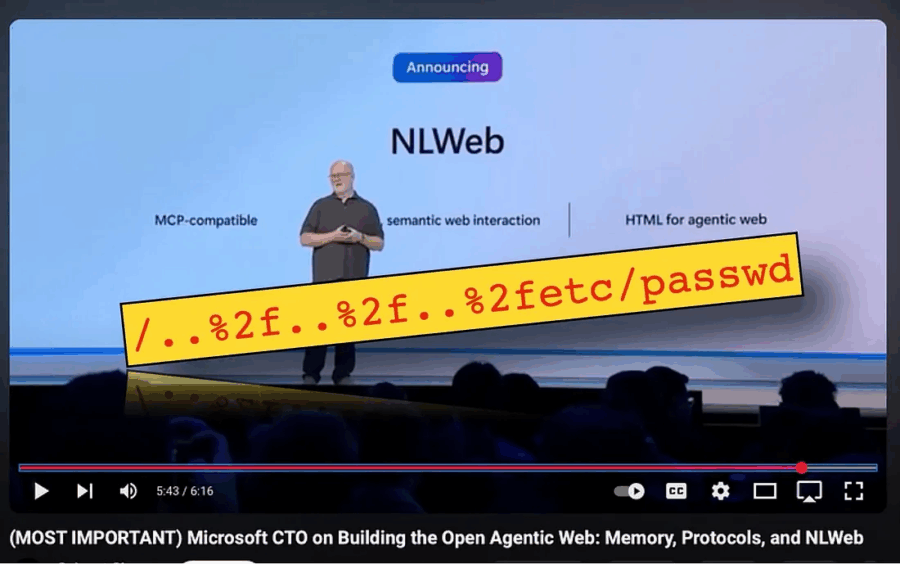

Tutto questo si inserisce in un contesto globale dove l’intelligenza artificiale sta diventando il nuovo petrolio, e la corsa all’oro impone ritmi da rivoluzione industriale 4.0. Solo che, questa volta, non ci sono le tute blu. Ci sono PhD del MIT e ex-Googler, tutti consapevoli, tutti volontari. O forse no? Perché dietro ogni CV brillante, c’è un’illusione silenziosa: quella che il prossimo modello generativo possa davvero cambiare il mondo. Che il codice che stai scrivendo a mezzanotte sia quello che farà la differenza tra anonimato e IPO.

Ma mentre l’élite tecnologica americana gioca a fare gli Shaolin della programmazione, la domanda vera è un’altra. Dove si colloca il limite? Non quello legale o medico, ma quello culturale. Quando una società decide che lavorare sette giorni su sette è il prezzo giusto da pagare per essere competitivi, non è più una questione di work ethic. È un collasso valoriale. Una discesa lenta e scintillante verso una distopia patinata in cui l’uomo è solo un bottleneck biologico da spremere finché l’AGI non sarà pronta a rimpiazzarlo.

Per ora ci restano le ironie. Tipo quella che i fondatori più hardcore predicano il 007, ma poi usano modelli AI addestrati per rendere il lavoro… più efficiente. L’ipocrisia si taglia con un prompt. “Automatizziamo tutto, ma voi continuate a lavorare il doppio”, sembra essere la sintesi perfetta. E sì, forse le teste rasate o le tende da campeggio sotto le scrivanie saranno davvero i nuovi simboli di status nella Silicon Valley AI. O magari lo sono già. Ma se lavorare 16 ore al giorno per mesi diventa l’unico modo per “farcela”, allora chi ce la fa davvero? E a quale prezzo?

Nel frattempo, i venture capitalist osservano compiaciuti, alzano le offerte e stringono le mani sudate di chi ha dormito due ore su un beanbag. L’era post-umana non è iniziata con un’intelligenza artificiale cosciente. È iniziata con una generazione di umani che ha deciso di comportarsi come macchine.