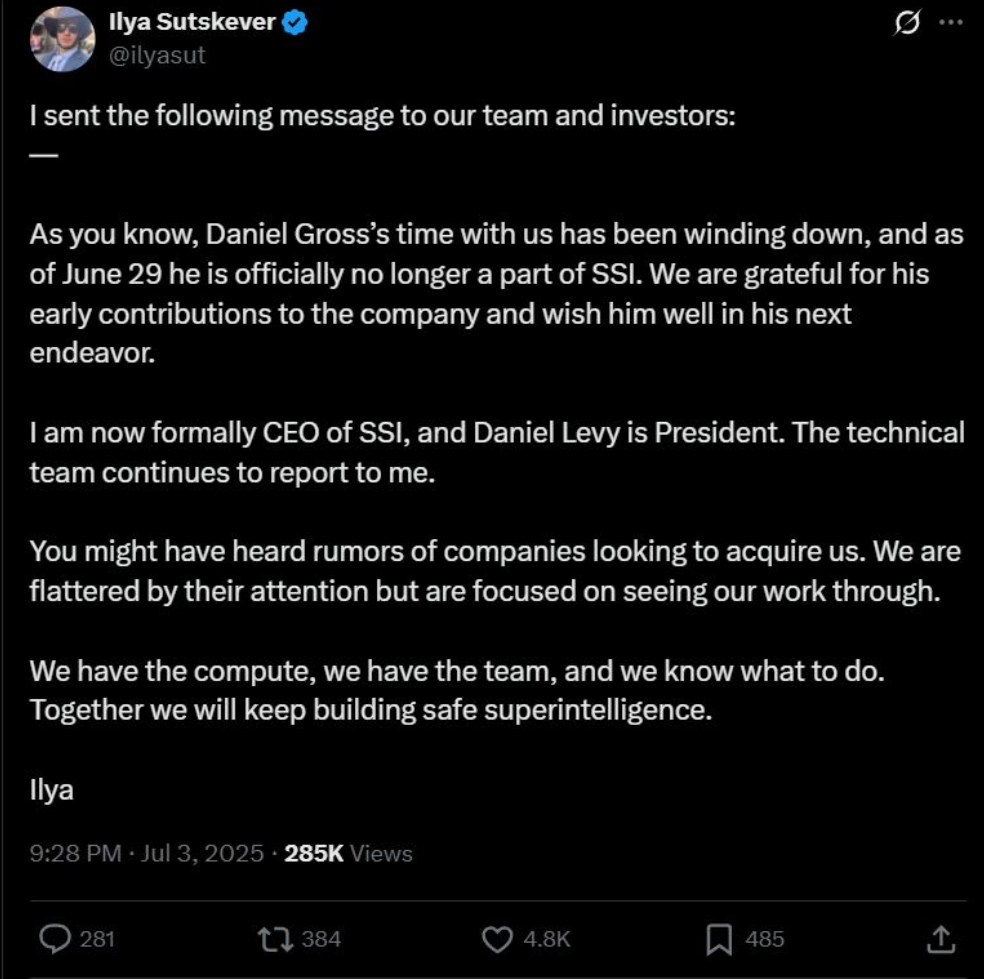

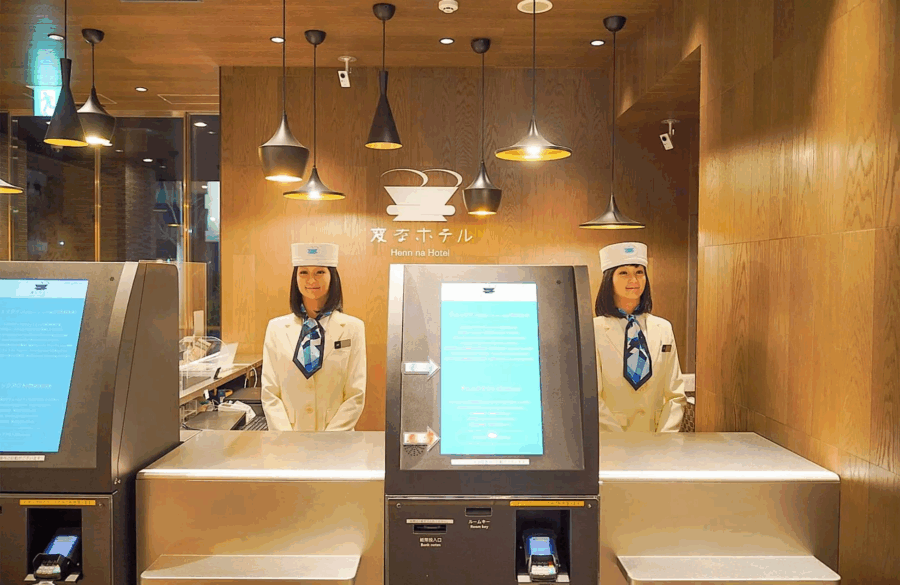

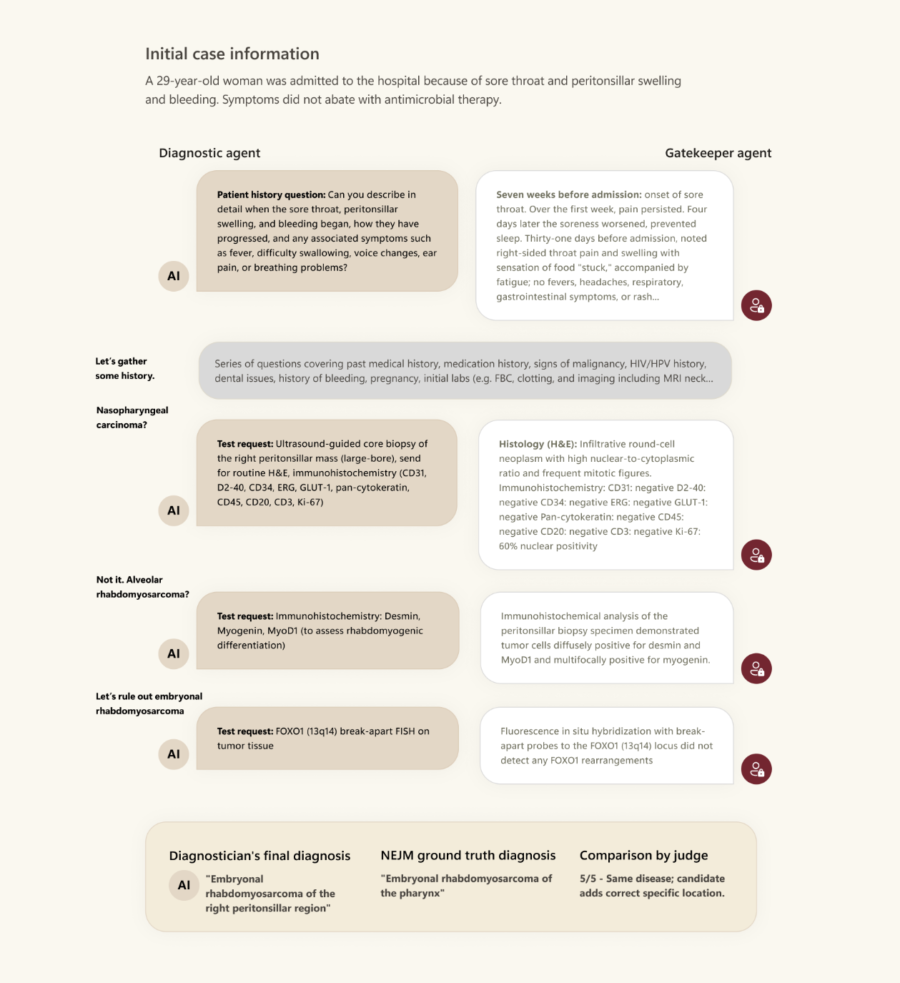

Se c’è una linea che separa l’imitazione dell’intelligenza dalla sua comprensione, Helmholtz Munich ha appena passato quella linea con gli stivali infangati. Il loro nuovo giocattolo si chiama Centaur, e il nome non è scelto a caso: metà intelligenza artificiale, metà proiezione antropomorfa dei nostri bias cognitivi. Un’ibridazione concettuale, non di codice. Eppure funziona. Maledettamente bene, a quanto dicono. Ma il punto non è se funziona. Il punto è: ci fidiamo davvero di una simulazione così accurata del comportamento umano da far impallidire la psicologia sperimentale, ma che resta, ontologicamente, una macchina che non ha la minima idea di cosa stia facendo?

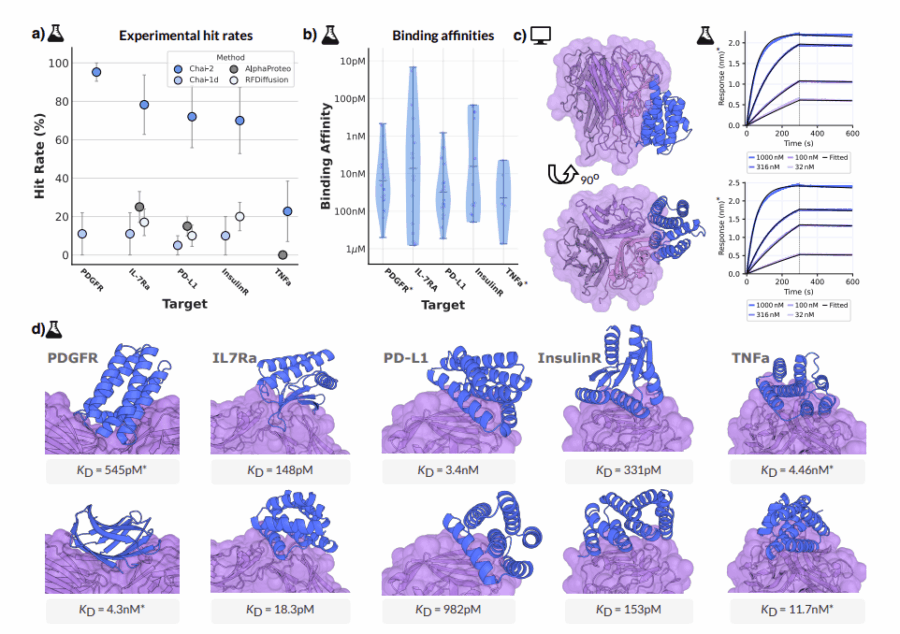

Centaur è stato addestrato su un corpo dati noto come Psych-101, una collezione monumentale di 160 studi psicologici, 60.000 partecipanti umani, 10 milioni di scelte documentate. Una collezione tanto vasta da suggerire che l’intera disciplina della psicologia comportamentale sia diventata, a sua insaputa, il set di addestramento per una nuova intelligenza artificiale. Sopra questo mosaico di decisioni, errori sistematici, illusioni cognitive e ambiguità motivazionali, i ricercatori hanno innestato Llama 3.1 da 70 miliardi di parametri, perfezionandolo con QLoRA, tecnica di fine-tuning che consente di adattare modelli massivi con una frazione delle risorse. Il risultato è un’entità capace di emulare con precisione disturbante la varietà di scelte umane in centinaia di task psicologici, superando 14 modelli cognitivi tradizionali su 159 prove su 160. Chi tiene il conto, evidentemente, è già fuori gioco.

Leggi tutto