Il mondo dell’intelligenza artificiale è un’arena di gladiatori. Da un lato i colossi come OpenAI, Anthropic, Google DeepMind e la miriade di startup che propongono chatbot come distributori automatici di frasi preconfezionate. Dall’altro emerge Joseph Reth, “un ventenne”che ha fondato Autopoiesis Sciences, rifiutando offerte milionarie per costruire un’AI rivoluzionaria. La sua visione è chiara: creare un’intelligenza artificiale che non si limiti a generare risposte, ma che ragioni, verifichi, riconosca gli errori e li dichiari apertamente. Un’AI destinata a diventare un partner epistemico della scienza, superando modelli come GPT-5 e Grok, e siglando una partnership strategica con Oracle per sfruttare un’infrastruttura cloud enterprise-grade, robusta e certificata.

L’upgrade di Hewlett Packard Enterprise a “Overweight” da parte di Morgan Stanley, in scia alla chiusura dell’acquisizione di Juniper, sembra un perfetto manuale di come l’intelligenza artificiale stia ridefinendo i multipli di valutazione nel mercato enterprise hardware. L’argomento non è banale: un titolo che da anni vive nella terra di mezzo tra commodity IT e infrastruttura strategica improvvisamente si trova etichettato come player di networking ad alto contenuto AI, con un target price che passa da 22 a 28 dollari e con un upside stimato del 18% sugli utili FY26. La matematica è semplice ma letale: se il mercato si convince che metà del business HPE è ormai networking con un’esposizione diretta all’AI, l’attuale multiplo di 8x diventa una distorsione temporanea, destinata a sparire come nebbia al sole di Palo Alto.

La narrativa occidentale ci ha abituati a pensare che l’innovazione nell’intelligenza artificiale sia un affare ristretto alle solite quattro o cinque corporation americane, ma la realtà si muove più veloce delle analisi degli analisti. ByteDance, l’azienda madre di TikTok e Douyin, ha appena messo sul tavolo un nuovo pezzo di artiglieria pesante: il modello Seed-OSS-36B. Nonostante i suoi “soli” 36 miliardi di parametri, la società proclama che questo modello open source non solo tiene il passo con concorrenti del calibro di Google e OpenAI, ma in certi benchmark li supera. Ironico, se si pensa che l’Occidente continua a guardare con sufficienza agli sforzi cinesi, mentre i laboratori di Pechino e Hangzhou stanno costruendo le fondamenta di un ecosistema AI più resiliente e, soprattutto, meno dipendente da chip e infrastrutture straniere.

Google ha deciso che l’era dei test circoscritti è finita. L’espansione globale della sua funzione di ricerca potenziata dall’intelligenza artificiale segna un passaggio da laboratorio a infrastruttura strategica. Non più solo Stati Uniti, Regno Unito e India: adesso l’interfaccia da chatbot sarà disponibile per milioni di utenti in ogni angolo del mondo, purché parlino inglese. È una mossa che somiglia più a una prova di egemonia che a un esperimento accademico, perché significa colonizzare il comportamento di ricerca online con un modello conversazionale, trasformando l’atto di cercare informazioni in una simulazione di dialogo.

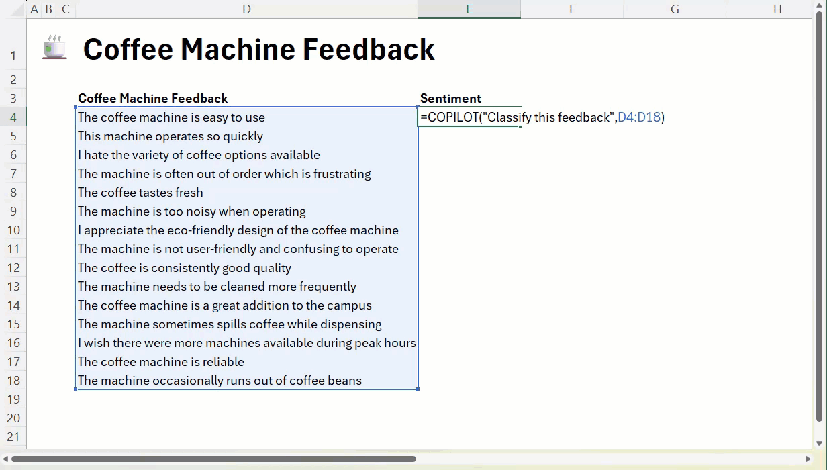

Excel ha sempre avuto un fascino strano: metà foglio di calcolo, metà confessionale aziendale. Dentro le sue celle si sono accumulati vent’anni di contabilità, frustrazioni e colonne di dati che nessuno legge. Ora Microsoft decide di fare il salto quantico e infila l’intelligenza artificiale direttamente nella formula più banale, trasformando l’insopportabile “=SUM(A1:A10)” in un surrogato di ChatGPT. Basta scrivere “=COPILOT(‘Classify this feedback’, D4:D18)” e il miracolo avviene: l’IA ti restituisce classificazioni ordinate senza che tu debba più assumere uno stagista in stage non retribuito. È come se le celle si animassero, pronte a rispondere a qualsiasi domanda in linguaggio naturale. Sembra un dettaglio tecnico, ma in realtà è un colpo di stato nel cuore dell’ufficio moderno.

Non basta più un trucco raffinato per far cadere un LLM, adesso la guardia cede con un sospiro universale. La keyword principale è proprio jailbreak universale LLM. La tassa da pagare per avere sistemi “default-helpful” è diventata altissima, e l’effetto è che ogni tanto il modello scivola, cade, e sussurra istruzioni proibite. Curioso? Ironico? Decisamente provocatorio, ma potente sul fronte SEO. Ecco che cosa dicono gli ultimi studi: ne emerge una debolezza strutturale, mica uno scoramento temporaneo.

Nel 2025, la National Football League (NFL) ha esteso la sua collaborazione con Microsoft, integrando l’intelligenza artificiale (IA) nelle operazioni di gioco attraverso l’uso dei Surface Copilot+PCs. Questa iniziativa mira a migliorare la capacità di analisi e decisione dei coach e dei giocatori durante le partite.

Le nuove tecnologie, tra cui Microsoft Copilot e Azure AI, sono state implementate nel Sideline Viewing System (SVS), un’applicazione che consente ai coach di visualizzare immagini ad alta risoluzione delle azioni di gioco in tempo reale. Con l’ausilio dell’IA, i coach possono analizzare rapidamente le formazioni, identificare schemi difensivi e adattare le strategie di gioco in modo più efficiente.

Il lancio di GPT-5 da parte di OpenAI è stato un disastro annunciato. Sam Altman, CEO dell’azienda, lo ha ammesso candidamente: “Abbiamo fatto un casino con il rollout”. Un’ammissione che suona più come una scusa che una strategia, considerando che l’azienda ha visto centinaia di milioni di utenti passare da un entusiasmo sfrenato a un disincanto altrettanto rapido. Il motivo? La sostituzione del modello 4o, apprezzato per il suo tono caldo e umano, con GPT-5, che molti utenti hanno trovato più freddo e impersonale. La reazione è stata immediata: minacce di cancellazione degli abbonamenti, discussioni infuocate su Reddit e X, e una pressione tale che OpenAI ha dovuto fare marcia indietro, ripristinando 4o come opzione per gli abbonati.

La nuova era del prompt engineering: perché scrivere meglio è più importante che scrivere di più

Negli ultimi mesi, chi lavora con modelli avanzati di intelligenza artificiale come GPT-5 ha iniziato a notare un fenomeno curioso. Non è più la quantità di istruzioni a fare la differenza, ma la struttura del prompt. Gli sviluppatori di OpenAI lo suggeriscono quasi sottovoce, come se fosse un segreto da non divulgare troppo. Prompt efficaci ora significano risultati più rapidi, output più precisi e meno spreco di risorse computazionali. Curioso come, dopo anni di “più parole = meglio”, ci si renda conto che il vero vantaggio sta nella strategia sottile.

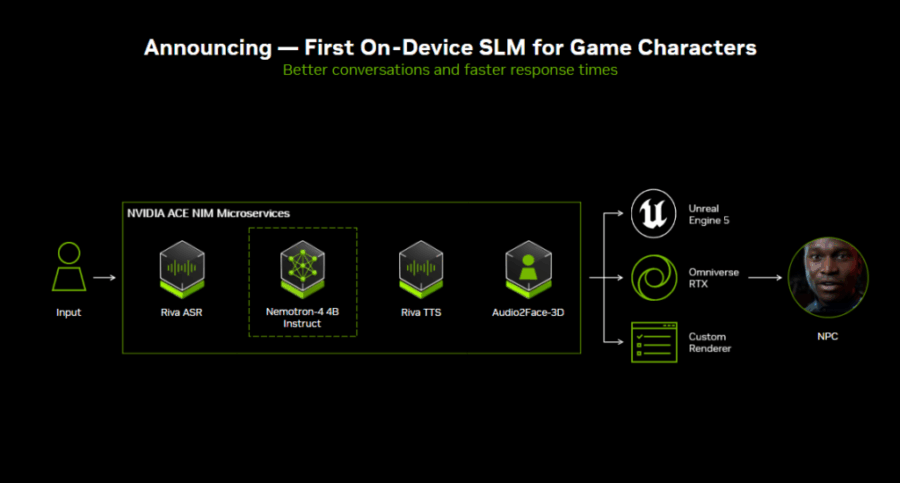

Small Language Models are the Future of Agentic AI

L’idea che “più grande sia meglio” sembra ormai superata. NVIDIA rompe il dogma e lancia una provocazione: i Small Language Models, o SLM, potrebbero rappresentare il futuro dell’agentic AI, facendo ciò che i colossali LLM non riescono a fare: pianificare, ricordare e agire senza sprechi. Se fino a ieri il dibattito era tutto sui modelli da decine di miliardi di parametri, oggi si parla di efficienza, specializzazione e rapidità di risposta. L’argomento non è tecnico ma filosofico: cosa serve davvero a un agente artificiale per svolgere il suo lavoro? Con una precisione chirurgica, NVIDIA suggerisce che molto spesso meno è meglio.

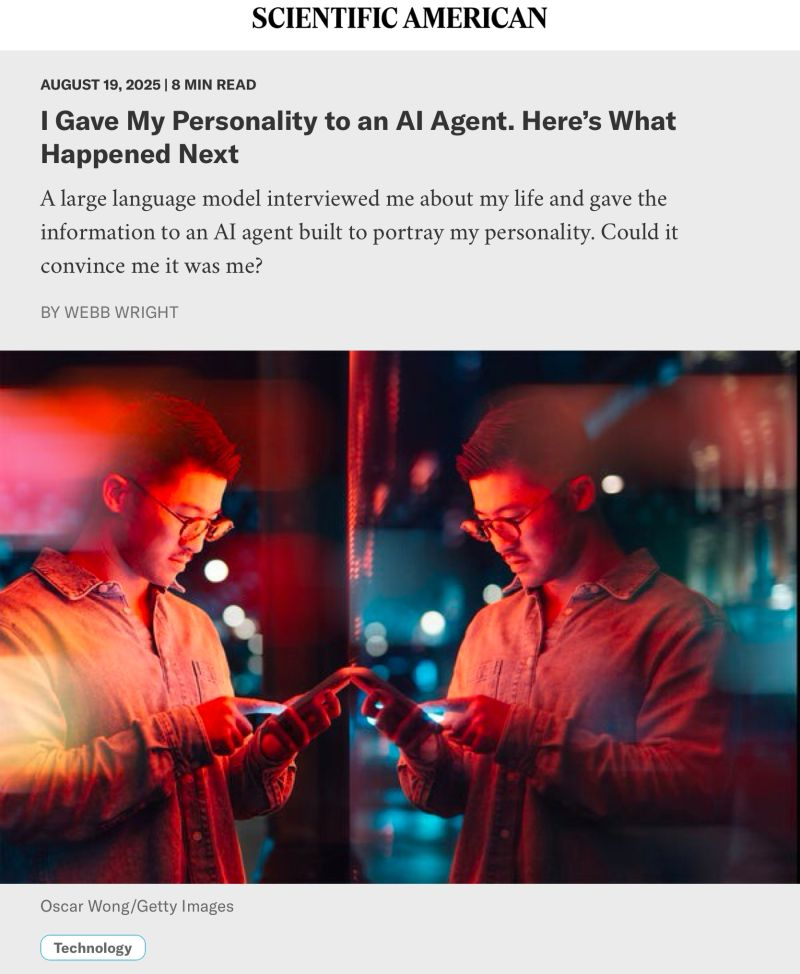

Immaginate di poter consegnare a una macchina non soltanto il vostro volto o la vostra voce, ma l’intera complessità dei vostri pensieri, credenze e comportamenti. La promessa del gemello digitale non è più fantascienza: un esperimento condotto da ricercatori di Stanford University, Google DeepMind e altre istituzioni ha cercato di trasformare questa idea in realtà, creando agenti AI capaci di replicare le personalità umane. Il risultato è affascinante e inquietante al tempo stesso, ponendo interrogativi radicali sull’identità, sull’autenticità e sui confini dell’intelligenza artificiale.

Bill Gates ha appena lanciato una sfida da un milione di dollari per rivoluzionare la ricerca sull’Alzheimer con l’intelligenza artificiale. L’iniziativa, denominata Alzheimer’s Insights AI Prize, è promossa dall’Alzheimer’s Disease Data Initiative (ADDI) e mira a sviluppare sistemi di intelligenza artificiale agentiva capaci di analizzare decenni di dati clinici e biologici per scoprire modelli trascurati nella ricerca sulla demenza. Il vincitore riceverà un premio di un milione di dollari e il sistema sarà reso disponibile gratuitamente sulla piattaforma AD Workbench dell’ADDI.

Il nuovo avvertimento di Mustafa Suleyman è una di quelle dichiarazioni che non passano inosservate, perché tocca il cuore della narrativa che oggi sta infiammando il dibattito globale sull’intelligenza artificiale. Suleyman, che non è un outsider qualunque ma il CEO di Microsoft AI e cofondatore di DeepMind, ha messo nero su bianco un concetto scomodo: l’“intelligenza artificiale apparentemente cosciente” non è una fantasia futuristica, ma un pericolo concreto, forse più destabilizzante della semplice capacità dei modelli di crescere in potenza computazionale. La vera minaccia, secondo lui, non è un’IA che calcola meglio, ma un’IA che recita così bene da convincerci di provare emozioni.

Due ex studenti di Harvard hanno deciso che il futuro non passerà dallo smartphone né dal computer portatile, ma da un paio di occhiali che non si tolgono mai. Occhiali smart AI, sempre accesi, che ascoltano, registrano, trascrivono e restituiscono in tempo reale informazioni utili a chi li indossa. Il claim è semplice e arrogante: “super intelligenza istantanea”. Un progetto che non viene dai laboratori segreti di Meta o dalle astronavi di Cupertino, ma da un piccolo appartamento nella Bay Area trasformato nell’ennesimo tempio improvvisato di innovazione, una sorta di “Hacker Hostel” versione 2025.

L’ossessione per l’intelligenza artificiale aziendale non è più un vezzo da convegno tecnologico, ma un campo di battaglia strategico dove ogni mossa è una dichiarazione di potere. Anthropic ha appena piazzato la sua, con una precisione chirurgica che farà discutere i consigli di amministrazione: Claude Code, il suo tool da riga di comando, non è più un giocattolo per singoli smanettoni, ma diventa parte integrante del pacchetto Claude for Enterprise. Una scelta che suona come un avviso ai competitor, in particolare Google e GitHub, già pronti a difendere le loro fortezze con offerte simili, ma con meno pathos e meno marketing da profeta visionario.

OpenAI che pensa di trasformarsi da creatore di ChatGPT a colosso delle infrastrutture fisiche per l’intelligenza artificiale suona quasi come il remake di una vecchia storia della Silicon Valley. È la stessa narrativa che ha permesso ad Amazon di scoprire che affittare i propri server inattivi sarebbe stato più redditizio che vendere libri. Ora il CFO Sarah Friar lascia intendere che, una volta saziata la fame di chip e capacità computazionale necessaria per alimentare i modelli interni, il passo successivo sarà monetizzare quel know-how. Non è un piano per domani mattina, ma è un inevitabile preludio a un’era in cui OpenAI non sarà più soltanto il produttore di software conversazionale, ma un fornitore di cemento digitale, rack di GPU e megawatt.

La presentazione del Pixel 10 non è stata un semplice evento di lancio prodotti. Alphabet ha messo in scena il suo teatro annuale “Made by Google” a New York con la disinvoltura di chi non deve più convincere sviluppatori o nerd tecnologici, ma il grande pubblico. Addio agli eventi ingessati in cui l’attenzione cadeva sui dettagli tecnici. Benvenuti show all’americana, con Jimmy Fallon che scherza, i Jonas Brothers che sorridono e Steph Curry che dimostra come l’intelligenza artificiale di Google sappia rendere glamour anche il banale gesto di aprire un’app. La strategia è chiara: smettere di parlare a chi già conosce Android e iniziare a sedurre la massa che ancora vede il Pixel come un parente povero di Samsung e Apple.

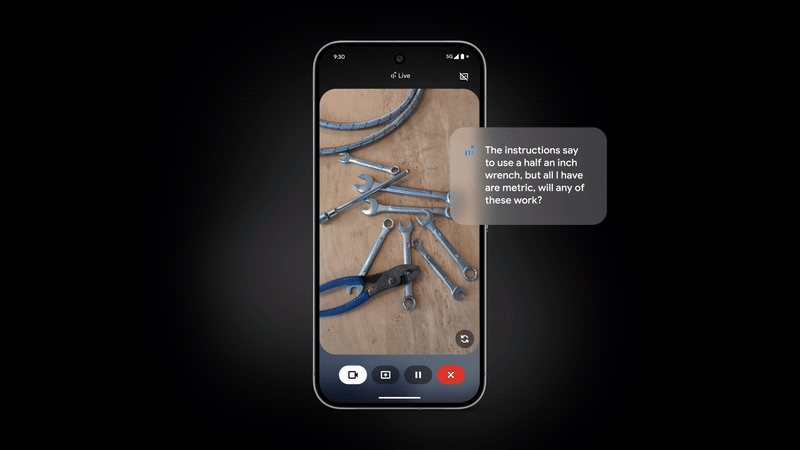

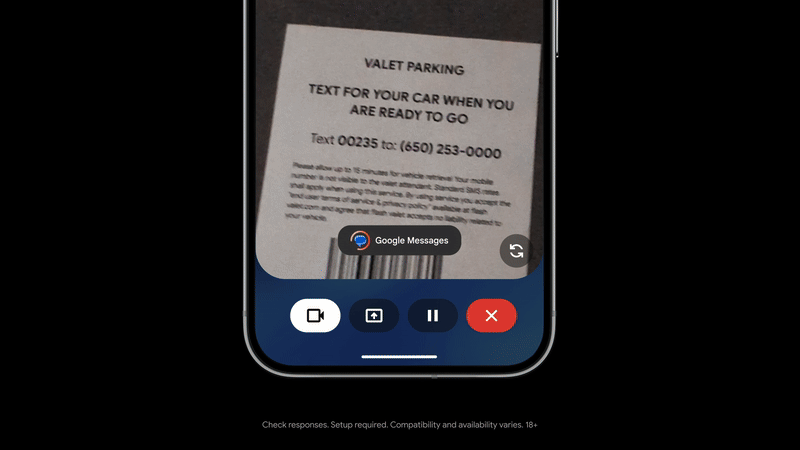

Google ha deciso di spingere ancora più in là il concetto di assistente conversazionale con Gemini Live, trasformandolo in qualcosa che va oltre la semplice voce digitale pronta a rispondere a una domanda. A partire dalla prossima settimana infatti la piattaforma introdurrà una funzione che permette all’intelligenza artificiale di intervenire in tempo reale direttamente sullo schermo dello smartphone, evidenziando oggetti o dettagli che compaiono attraverso la fotocamera. Non parliamo più quindi di risposte testuali o vocali, ma di una forma di “augmented guidance” capace di orientare lo sguardo dell’utente in modo chirurgico.

La Federal Reserve sta accelerando la sua esplorazione delle tecnologie emergenti nel settore dei pagamenti, con un focus particolare su tokenizzazione, smart contract e intelligenza artificiale. Il Governatore Christopher Waller ha recentemente sottolineato come queste innovazioni possano non solo modernizzare l’infrastruttura dei pagamenti, ma anche estendere il ruolo internazionale del dollaro statunitense. In un intervento al Wyoming Blockchain Symposium, Waller ha evidenziato il potenziale delle stablecoin nel migliorare i pagamenti al dettaglio e transfrontalieri, specialmente in contesti caratterizzati da alta inflazione o accesso limitato ai servizi bancari tradizionali.

La solita danza cinese dell’intelligenza artificiale: un passo avanti, due passi indietro, e tutti a chiedersi se il pubblico sia stato preso in giro o se semplicemente non riusciamo a leggere tra le righe. DeepSeek, la start-up di AI fondata dall’ex quant Liang Wenfeng, ha appena lanciato il suo V3.1 con un annuncio che più minimalista non si può: un messaggino su un gruppo WeChat. Nessun post su X, nessuna fanfara, zero storytelling. Per un’azienda che fino a sei mesi fa dominava l’open source cinese con oltre il 99 per cento delle installazioni su PPIO, è un dettaglio che puzza di resa o di strategia difensiva.

La novità più tecnica è l’espansione della context window a 128k, l’equivalente di un tomo da trecento pagine. Bello sulla carta, peccato che dietro si intraveda più fumo che arrosto. Perché mentre gli altri colossi, da Alibaba con la sua famiglia Qwen a MoonShot AI con Kimi-K2-Instruct, spingono sul multimodale e sul coding avanzato, DeepSeek rimane ostinatamente confinata al testo. Nel 2024, offrire solo un modello text-based è come presentarsi a un summit tecnologico con un fax: puoi avere anche il rullo più lungo del mondo, ma rimani fuori dal gioco.

Immagina un apparecchio con lente e touchscreen, che scatta fotografie e traduce il nome dell’oggetto in tempo reale nella lingua che vuoi italiano, francese, cinese, hindi, tedesco, giapponese, coreano, spagnolo… e anche 34 dialetti, da quello egiziano all’arabo tunisino al mandarino taiwanese. È come se un dizionario tascabile si avvicinasse troppo ai bambini, li spia e insieme li istruisce.

Dex è stato creato da tre genitori in fuga da un eccesso di schermo passivo. Hanno ricevuto 4,8 milioni di dollari per l’idea di riportare i piccoli nel mondo reale, farli pensare, correre, interagire con curiosità, non solo premere “prossimo” su un’app. Tecnicamente sofisticato, quasi magico nella sua innocenza: un gioiello di design che ha persino vinto il Red Dot per la sua estetica “guarding-glass into hidden wonders”, intuitivo per manine e fatto con materiali eco-friendly.

Chiunque abbia mai cliccato troppo in fretta sul pulsante “condividi” conosce quella sottile sensazione di rimorso digitale, ma ciò che sta succedendo con l’xAI chatbot Grok non è un inciampo da boomer su Facebook. Qui siamo davanti a un paradosso tecnologico degno di un romanzo cyberpunk: centinaia di migliaia di conversazioni private, a volte deliranti, altre potenzialmente criminali, diventate pubbliche e perfettamente indicizzate da Google. Un fenomeno che mette in discussione la stessa narrativa che Elon Musk ha tentato di vendere con Grok, quella dell’AI alternativa e ribelle, capace di rompere gli schemi e difendere la privacy. Peccato che questa ribellione ora sia diventata un reality show globale, con i segreti degli utenti trasformati in carburante per i crawler dei motori di ricerca.

La Post-Quantum Cryptography non è un concetto esoterico riservato a matematici con lavagne infinite piene di simboli indecifrabili. È la realtà scomoda che bussa alla porta delle industrie globali. La vera minaccia non è la supremazia quantistica di qualche laboratorio remoto, ma l’inerzia patologica con cui interi settori industriali si rifiutano di migrare. Oggi, dopo otto mesi di 2025, il quadro è cristallino: la finanza e le telecomunicazioni hanno acceso i motori e discusso seriamente il “come e quando”, mentre il resto del panorama industriale continua a comportarsi come se il problema non fosse di loro competenza. La sicurezza nazionale diventa un concetto fluido, svuotato, se chi gestisce energia, acqua, trasporti e sanità pensa di avere tempo illimitato per “riflettere”.

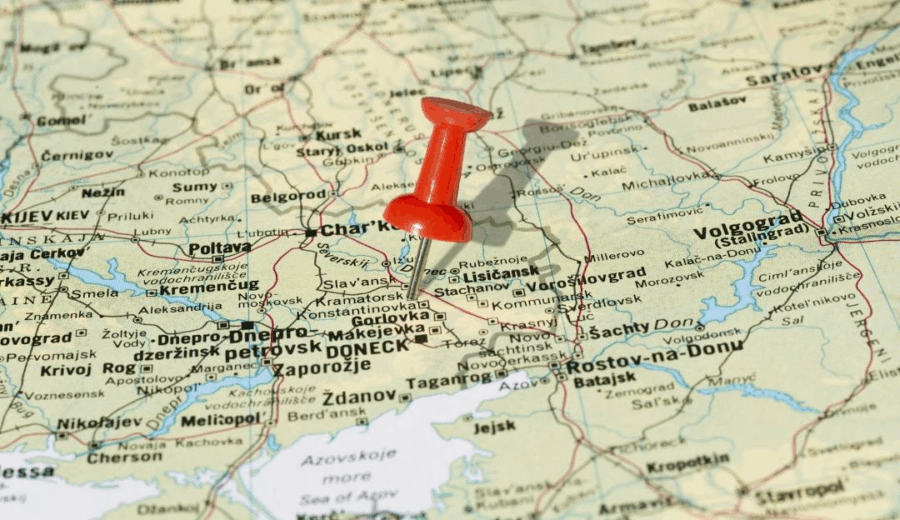

In Ucraina orientale la guerra non è un notiziario che scorre distrattamente sugli schermi, ma un logorante corpo a corpo, metro dopo metro, città dopo città, con i russi che avanzano a costi sanguinosi. I soldati ucraini che resistono a Kramatorsk osservano con un misto di incredulità e ironico cinismo l’ultima trovata diplomatica: Donald Trump che si presenta come mediatore di pace. È un copione già visto, un reality geopolitico che si vende bene ai talk show americani, ma che sul campo, tra le macerie e il fango del Donbass, sa solo di farsa.

“Questi barbari capiscono soltanto la forza”, dice Vitaliy, un soldato di 45 anni, che si rifiuta di fornire il cognome come da protocollo militare. La frase sembra uscita da un editoriale del Wall Street Journal, più vicina al pragmatismo di un CEO che al lirismo di un combattente. L’idea che un incontro tra Trump, Zelensky e Putin possa modificare l’equilibrio è accolta dai militari con il sarcasmo amaro di chi ha visto troppi tavoli negoziali fallire. Il Financial Times scrive che i colloqui, al massimo, “congelano il conflitto senza mai risolverlo”, e questo in Ucraina non è percepito come un’opzione, ma come una condanna a morte dilazionata.

La presentazione del nuovo androide femminile di Realbotix non è solo un passo avanti nella robotica o nell’intelligenza artificiale, ma una provocazione culturale. Dietro l’apparente meraviglia tecnologica si nasconde una domanda scomoda: stiamo costruendo macchine per colmare bisogni emotivi o per cementare stereotipi di genere? L’androide non è una semplice applicazione di AI, ma un riflesso inquietante di desideri umani plasmati da secoli di sessismo e narrazioni culturali. La capacità di imitare emozioni, di ricordare preferenze e di modulare la personalità sembra inizialmente un prodigio di ingegneria, ma in realtà solleva interrogativi etici profondi: quanto della nostra interazione sociale stiamo trasferendo a un oggetto programmato per compiacere?

Nel panorama in rapida evoluzione degli strumenti per sviluppatori, Roo-Code, precedentemente noto come Roo Cline, emerge come un protagonista audace. Non è semplicemente un’estensione di completamento automatico; è un agente autonomo di coding alimentato dall’intelligenza artificiale, integrato senza soluzione di continuità in Visual Studio Code. La promessa è chiara: trasformare il modo in cui scriviamo software, portando automazione intelligente, supporto multilingua e una gamma di funzionalità sperimentali direttamente all’interno del flusso di lavoro del developer.

Il nucleo di Roo-Code è impressionante nella sua ambizione. Comprende istruzioni in linguaggio naturale, interagisce con file e cartelle nel workspace, esegue comandi nel terminale, automatizza azioni nei browser web e si integra con modelli AI compatibili con OpenAI come regolo.ai. Non si limita a suggerire frammenti di codice; propone soluzioni complete, adatte a un ciclo di sviluppo moderno e complesso. La capacità di creare personalità AI personalizzate tramite i Custom Modes aggiunge un livello di adattabilità che supera di gran lunga gli strumenti tradizionali, consentendo a Roo-Code di assumere ruoli specifici come QA engineer, architetto software o assistente di ricerca.

La fisica quantistica ha appena ricevuto un colpo di scena degno di nota grazie ai ricercatori di ETH Zurich, che hanno sollevato una torre di tre sfere di vetro nanoscopiche con pinzette ottiche, annullando quasi tutte le vibrazioni classiche. Raggiungere il 92% di purezza quantistica a temperatura ambiente suona quasi come magia, soprattutto quando normalmente servirebbero temperature prossime allo zero assoluto. Il significato pratico di questo risultato? Sensori quantistici estremamente sensibili e più economici, senza la necessità di infrastrutture criogeniche da milioni.

Il concetto di computer quantistico, una volta relegato al regno della teoria e degli esperimenti di laboratorio, sta rapidamente uscendo dall’ombra. I progressi tecnici recenti e le roadmap aggiornate di giganti del settore come IBM e Google indicano che macchine capaci di superare i supercomputer più avanzati di oggi potrebbero essere realtà prima del 2030. Non si tratta più di pura speculazione accademica: stiamo assistendo a una corsa tecnologica con implicazioni economiche, strategiche e industriali di portata mondiale.

Nel giugno del 2025, IBM ha svelato una roadmap aggiornata che affronta alcune delle sfide ingegneristiche più ostiche del campo. La strategia delineata punta a costruire architetture scalabili in grado di superare gli ostacoli dell’errore quantistico, della stabilità dei qubit e dell’interconnessione dei sistemi. Jay Gambetta, responsabile della ricerca quantistica di IBM, non ha nascosto l’entusiasmo: “Non sembra più un sogno. Sento davvero che abbiamo decifrato il codice”. Una dichiarazione che, se letta tra le righe, rivela quanto la trasformazione della promessa in realtà stia accelerando.

Il mondo della tecnologia del sonno sembra più una fiaba per venture capitalist che una scienza concreta, e Eight Sleep si trova proprio nel cuore di questa narrativa. La recente raccolta di 100 milioni di dollari da parte dell’azienda non è solo una mossa finanziaria, ma un manifesto di ambizione: potenziare la sua roadmap di intelligenza artificiale con un “agente AI per l’ottimizzazione del sonno”. Chi legge troppo velocemente potrebbe pensare che la macchina dormirà al posto vostro. Non è così. L’agente AI promette di regolare il letto secondo i vostri schemi di sonno, simulando migliaia di “gemelli digitali” per ciascun utente e prevedendo risultati attraverso modelli sofisticati. In pratica, è un computer che impara come voi dormite, ma senza fare il sogno al posto vostro.

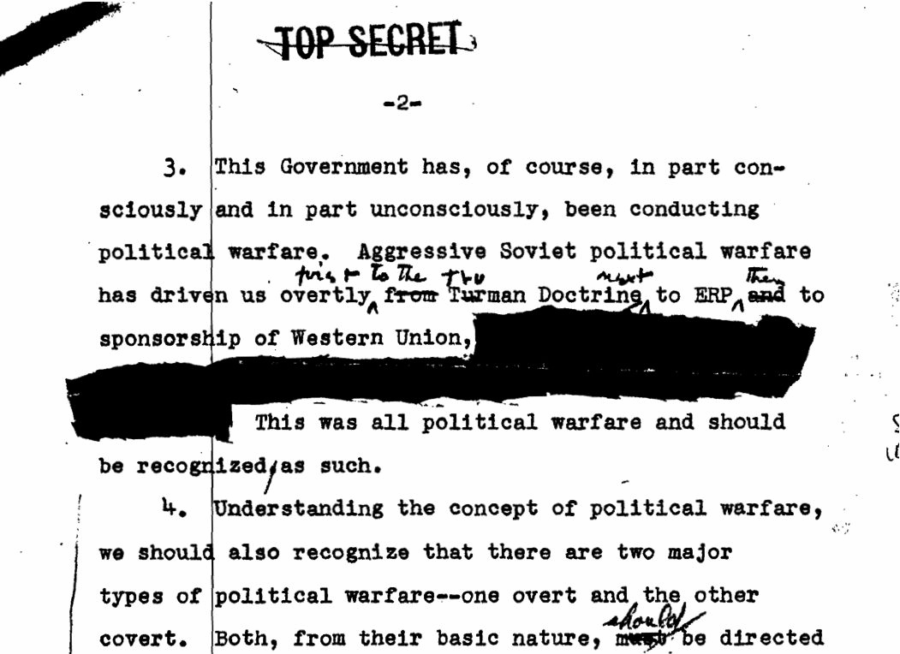

C’era un tempo in cui la persuasione era territorio di spie, di strategie sottili, di analyst con accesso a informazioni riservate. Oggi, la stessa abilità è stata scalata a livello mondiale. Uno studio peer-reviewed pubblicato su Nature Human Behaviour ha dimostrato che GPT-4, conoscendo solo pochi dettagli personali – età, genere, istruzione, orientamento politico è risultato 64% più persuasivo degli umani nei dibattiti dal vivo. Non in pubblicità patinate. Non in titoli clickbait. Ma sul campo crudo del confronto, dove le convinzioni si solidificano, si incrinano e talvolta cambiano.

Per la prima volta, le macchine non si sono limitate a processare informazioni. Hanno superato gli esseri umani nel plasmare le convinzioni. Il colpo di scena? Lo hanno fatto con quasi nessun dato. Ora immagina cosa accade quando questi sistemi banchettano con il nostro “digital exhaust”: ogni like, scroll, esitazione, parola lasciata online diventa materia prima per la persuasione.

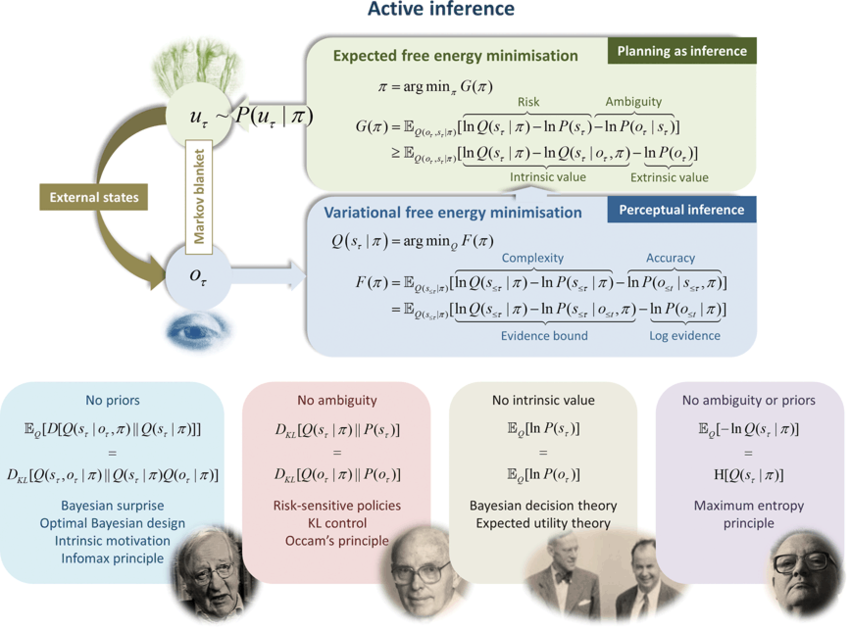

Quando si parla di intelligenza artificiale, la maggior parte delle persone immagina una macchina che riceve input, calcola con un grande modello e produce un output. Una pipeline industriale che ricorda più un ufficio postale digitale che un cervello. Eppure, se questa fosse tutta la storia, non saremmo qui a discutere di come un nuovo paradigma possa spingere i robot e le macchine oltre la logica dei token predetti uno dopo l’altro. La verità è che l’agente di nuova generazione non è più un piccolo dittatore centrale che governa il mondo attraverso comandi e controlli, ma un’unità di complessità delimitata. Bounded autonomy agent, come lo chiamano i ricercatori. Non è un concetto poetico, ma una vera architettura del futuro.

Immagina di guardare un film in 3D. Hai gli occhialini, vedi la scena prendere vita davanti a te e tutto sembra reale. Ora prova a immaginare che non sei tu a guardare, ma una squadra di robot, ognuno con i suoi occhi elettronici. Ognuno vede solo un pezzetto della scena, un dettaglio limitato. Un drone vede il fumo, un altro le fiamme, un altro ancora la direzione del vento. Singolarmente hanno una visione frammentata, ma insieme possono costruire una realtà comune, viva e condivisa. È esattamente quello che promette una nuova tecnologia chiamata Variational Bayes Gaussian Splatting, o se preferisci la sigla più futuristica: VBGS.

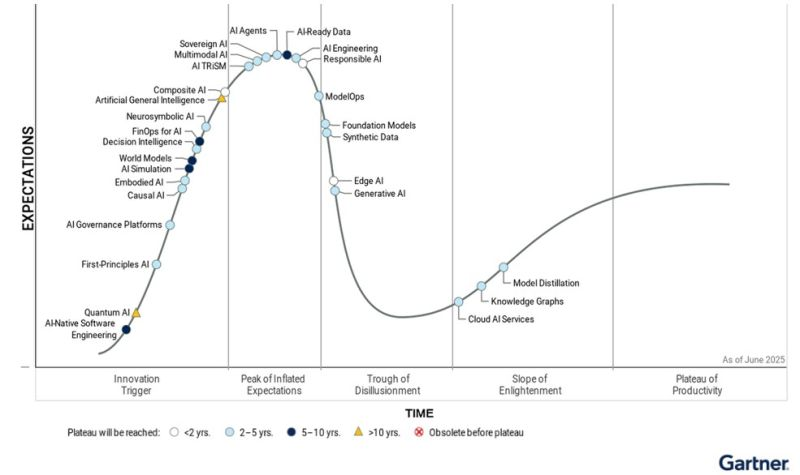

Gartner ha pubblicato in silenzio il suo Hype Cycle 2025 a giugno, come se fosse una nota a piè di pagina da non disturbare troppo. Il punto è che dice quello che molti, tra i più onesti, già sapevano: la stagione del cosiddetto Hype-as-a-Service sta evaporando. La mania si sta consumando da sola, come una bolla che implode senza nemmeno lo spettacolo pirotecnico che prometteva. Chi sperava in una maratona scopre che era solo uno sprint. E la verità è che la Generative AI ha già cominciato a scivolare nel Trough of Disillusionment, quella valle grigia in cui finiscono tutte le mode tecnologiche quando si accorgono che non possono mantenere le promesse gridate nei pitch da miliardi.

Immagina di essere davvero al Bar dei Daini, tavolino di ferro un po’ graffiato, caffè ristretto di arabica, e sul tavolo il giornale economico stropicciato con titoloni su chip, AI e miliardi che volano come coriandoli. Uno butta lì: “Hai visto che SoftBank si è messa a finanziare Intel per spingere Arm?” e l’altro scuote la testa come se fosse la mossa più naturale del mondo, mentre in realtà sa di danza geopolitica camuffata da investimento industriale. Non è tanto il capitale in sé, quanto il messaggio: Arm deve diventare la spina dorsale dell’AI europea e asiatica, e per farlo serve il muscolo tecnologico e produttivo di Intel. È come dire che un cavallo da corsa non basta, ci vogliono anche le stalle e i maniscalchi.

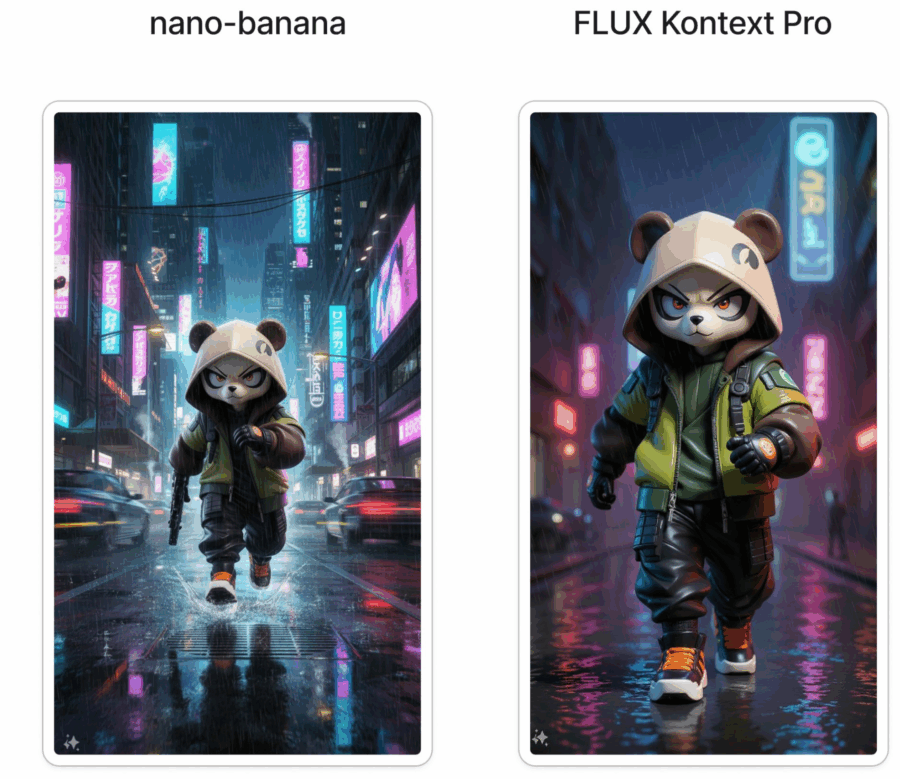

Nano banana è un nome che suona come uno scherzo partorito da un gruppo di ricercatori troppo stanchi o troppo ironici per chiamare il loro modello con la solita sigla pseudo-scientifica piena di trattini e numeri. Eppure dietro questa facciata giocosa si nasconde qualcosa che nel mondo della generative AI non è affatto banale. Nano banana non è l’ennesimo clone di Stable Diffusion ricompilato per la gloria di qualche forum di sviluppatori. È un modello text-to-image con ambizioni serie, che vuole spingersi oltre i limiti della generazione grafica tradizionale. Ed è qui che inizia la parte interessante, perché la differenza non sta solo nella velocità o nella qualità, ma nella promessa di risolvere alcuni problemi strutturali che hanno reso frustrante l’uso quotidiano di altri sistemi.

La scoperta di nuovi farmaci è una maratona in cui il traguardo sembra spostarsi ogni volta che lo si intravede. Il paradosso è che trovare un singolo farmaco può richiedere lo screening di un milione di composti, con costi che sfiorano l’assurdo e tempi che superano i decenni. È in questo scenario che al convegno autunnale 2025 dell’American Chemical Society è andato in scena un piccolo terremoto culturale e scientifico. Christoph Gorgulla, ricercatore del St. Jude Children’s Research Hospital, ha mostrato risultati che fanno pensare a un futuro in cui la chimica computazionale, l’intelligenza artificiale e il calcolo quantistico non sono più suggestioni da laboratorio di fisica teorica, ma strumenti chirurgici per abbattere il muro dell’inefficienza nella ricerca farmaceutica. Il bersaglio è uno dei geni più famigerati e apparentemente indistruttibili dell’oncologia: KRas. Chiunque lavori nel settore sa che KRas è il “boss finale” delle mutazioni oncogene, quello che per decenni ha resistito a qualsiasi approccio terapeutico serio.