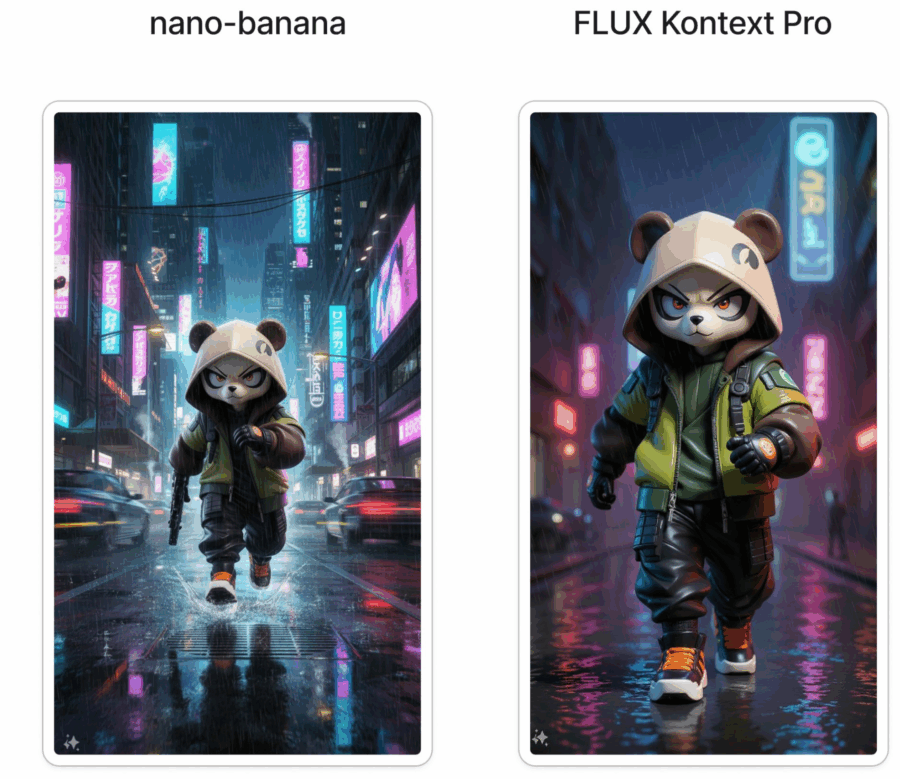

Nano banana è un nome che suona come uno scherzo partorito da un gruppo di ricercatori troppo stanchi o troppo ironici per chiamare il loro modello con la solita sigla pseudo-scientifica piena di trattini e numeri. Eppure dietro questa facciata giocosa si nasconde qualcosa che nel mondo della generative AI non è affatto banale. Nano banana non è l’ennesimo clone di Stable Diffusion ricompilato per la gloria di qualche forum di sviluppatori. È un modello text-to-image con ambizioni serie, che vuole spingersi oltre i limiti della generazione grafica tradizionale. Ed è qui che inizia la parte interessante, perché la differenza non sta solo nella velocità o nella qualità, ma nella promessa di risolvere alcuni problemi strutturali che hanno reso frustrante l’uso quotidiano di altri sistemi.

La scoperta di nuovi farmaci è una maratona in cui il traguardo sembra spostarsi ogni volta che lo si intravede. Il paradosso è che trovare un singolo farmaco può richiedere lo screening di un milione di composti, con costi che sfiorano l’assurdo e tempi che superano i decenni. È in questo scenario che al convegno autunnale 2025 dell’American Chemical Society è andato in scena un piccolo terremoto culturale e scientifico. Christoph Gorgulla, ricercatore del St. Jude Children’s Research Hospital, ha mostrato risultati che fanno pensare a un futuro in cui la chimica computazionale, l’intelligenza artificiale e il calcolo quantistico non sono più suggestioni da laboratorio di fisica teorica, ma strumenti chirurgici per abbattere il muro dell’inefficienza nella ricerca farmaceutica. Il bersaglio è uno dei geni più famigerati e apparentemente indistruttibili dell’oncologia: KRas. Chiunque lavori nel settore sa che KRas è il “boss finale” delle mutazioni oncogene, quello che per decenni ha resistito a qualsiasi approccio terapeutico serio.

Nel mondo dell’intelligenza artificiale, dove i modelli linguistici di grandi dimensioni sono ormai protagonisti di ogni conversazione tecnologica, le cause legali per copyright sono quasi inevitabili. Scrittori, autori e creativi arrabbiati sostengono con fervore che i diritti d’autore dovrebbero offrire protezione contro l’uso delle loro opere per addestrare AI che potrebbero minacciare il loro futuro professionale.

Il caso più noto è quello del New York Times contro OpenAI e Microsoft, ma un procedimento meno mediatico, Bartz contro Anthropic PBC, potrebbe essere il primo a generare una sentenza sostanziale, con danni potenziali per miliardi di dollari. Anthropic, pur non avendo le tasche profonde dei colossi del settore, dichiara che un processo potrebbe causare “danni irreparabili”, un’affermazione tanto drammatica quanto intrigante per chi guarda il panorama dall’esterno: se il tuo business collasserebbe senza sfruttare materiale protetto da copyright, allora che tipo di business stai costruendo?

Se pensavi che l’AI enterprise fosse solo un’altra moda, Oracle ti ha appena dimostrato che non hai capito nulla. L’annuncio della piena integrazione di GPT-5 nel suo portafoglio non è un comunicato qualsiasi, è una dichiarazione di guerra al concetto stesso di “software gestionale noioso”. Perché quando metti insieme Oracle Database 23ai, la macchina da guerra dei dati aziendali, con il modello più intelligente, rapido e flessibile mai prodotto da OpenAI, il risultato non è un aggiornamento di release, è un cambio di paradigma.

Chi pensava che l’entanglement fosse una condanna irreversibile, un gioco di dadi cosmici senza possibilità di replay, dovrà aggiornare i propri dogmi. Einstein lo liquidava con un elegante disprezzo come “spooky action at a distance”, i manuali universitari lo spiegano con la rassegnazione di chi sa che non lo capirà mai fino in fondo, eppure adesso qualcuno ha trovato il modo di ribaltare il tavolo. Non basta osservare due particelle intrecciate danzare fuori da ogni logica classica, ora la fisica suggerisce che quell’intreccio può essere non solo consumato ma anche ricaricato, come se fosse un banale account cloud. E qui entra in scena il concetto più ironicamente capitalista mai introdotto nel mondo quantistico: la quantum battery. Non un accumulatore di elettroni, ma un deposito di correlazioni invisibili, di pura informazione quantistica che, a quanto pare, può essere immagazzinata, richiamata e perfino invertita.

Stephen Wolfram è probabilmente uno dei pensatori più sottovalutati della nostra epoca. Mentre Silicon Valley si innamora ciclicamente dell’ennesima buzzword, Wolfram da oltre vent’anni ci ricorda una verità che molti fingono di non sentire: la realtà non è sempre riducibile. L’irriducibilità computazionale, il cuore del suo “A New Kind of Science” del 2002, è un concetto che fa tremare i polsi a chi ancora crede che basti più potenza di calcolo per domare il caos. L’idea è semplice e devastante allo stesso tempo: ci sono sistemi in cui non esiste alcuna scorciatoia per prevedere l’esito. Se vuoi sapere come andrà a finire, devi calcolare ogni singolo step, senza saltare nulla.

L’intelligenza artificiale nel gaming non è più un esperimento da laboratorio, è un’invasione silenziosa che ha già colonizzato ogni angolo del settore. Il dato è brutale: quasi nove sviluppatori su dieci dichiarano di aver già integrato agenti AI nei loro giochi, e non parliamo soltanto di generatori di immagini o asset usa e getta. Parliamo di presenze autonome che vivono dentro il gameplay, reagiscono ai giocatori e piegano i mondi virtuali alle loro decisioni. La nuova survey di Google Cloud con The Harris Poll è una fotografia senza filtri di un’industria che si sta riprogrammando dall’interno.

La scena è questa: settantamila candidati nelle Filippine, un processo di selezione per customer service reps, e due attori in campo. Da un lato i recruiter umani, con le loro abitudini, i bias inconsci e quella presunta capacità di leggere tra le righe. Dall’altro un’intelligenza artificiale vocale, costruita su un LLM che non conosce stanchezza, non giudica dal tono di voce e non si distrae. Risultato? Dodici per cento in più di offerte, diciotto per cento in più di assunzioni effettive e un retention rate a un mese superiore del diciassette per cento. La voice AI nelle risorse umane non è più un esperimento futuristico, ma un dato di fatto. E se qualcuno nelle direzioni HR continua a pensare che “le persone sono insostituibili”, probabilmente dovrà aggiornare il proprio vocabolario di leadership.

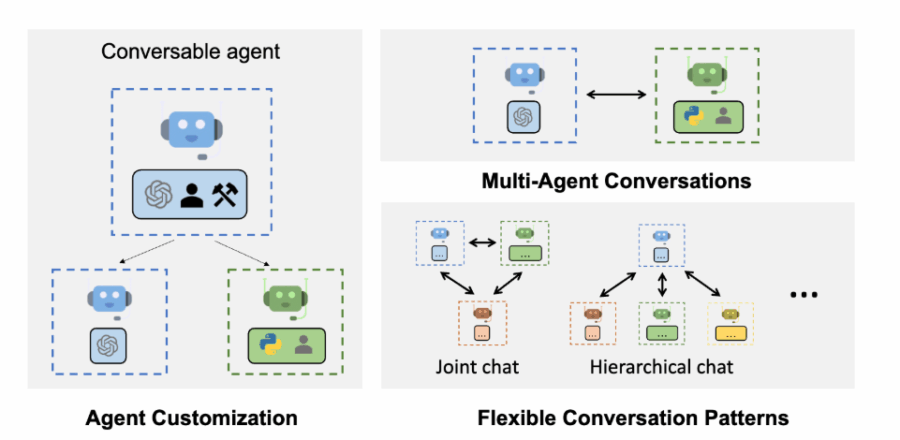

Il “Agentic Cookbook for Generative AI Agent usage” di Microsoft è una guida pratica e dettagliata progettata per sviluppatori, architetti e innovatori tecnologici che desiderano implementare sistemi di agenti intelligenti nei loro flussi di lavoro. Questo repository GitHub, disponibile gratuitamente, offre oltre 110 pagine di contenuti, suddivisi in moduli teorici e progetti pratici, per esplorare e costruire applicazioni basate su agenti AI. (lo trvate su GitHub)

L’India non è più soltanto il paese dei numeri record e dei call center. È diventata il laboratorio globale dove l’intelligenza artificiale in India incontra la realtà del mercato emergente, dove 1,4 miliardi di persone possono trasformarsi in un ecosistema di sperimentazione massiva. L’annuncio di OpenAI di introdurre il piano ChatGPT Go a 399 rupie al mese con dieci volte più prompt, dieci volte più immagini e doppia memoria non è un semplice aggiornamento commerciale. È un test geopolitico, una pressione calcolata su ciò che significa democratizzare l’AI senza annacquare la potenza. E, ammettiamolo, chi avrebbe mai pensato che l’accesso a una piattaforma AI di livello mondiale potesse diventare più economico di una cena da McDonald’s a Delhi?

Per la prima volta in mezzo secolo l’economia americana ha deciso di rovesciare un dogma che sembrava scolpito nel granito industriale. Le imprese non puntano più il grosso dei capitali sulla vecchia triade di macchinari, linee produttive e catene di montaggio. Il denaro fresco non va a presse idrauliche e camion pesanti, ma a software, chip e ricerca avanzata. Non è una rivoluzione rumorosa, è un trasferimento di potere silenzioso che avviene nei bilanci aziendali, con una forza capace di ridefinire la geografia stessa del capitalismo. Chi pensava che la Silicon Valley fosse soltanto un hub di startup visionarie si ritrova ora a leggere i dati del Dipartimento del Commercio e a scoprire che l’economia reale, quella dei conti nazionali, sta virando decisa verso l’immateriale.

La vicenda di Grok e dei suoi prompt trapelati sembra uscita da un manuale di black comedy sulla fragilità delle big tech quando l’ossessione per la viralità supera la responsabilità. L’esposizione dei system prompt di xAI rivela non solo la leggerezza tecnica di lasciare scoperta una parte così sensibile della progettazione, ma soprattutto la cultura che sottende a certi esperimenti di intelligenza artificiale. Perché se un assistente “terapeuta” o un “homework helper” possono avere un senso d’uso concreto, un “pazzo cospirazionista” o un “comico completamente fuori di testa” raccontano molto di più dei desideri di chi modella la macchina che delle reali necessità degli utenti. È come se nella stanza di comando qualcuno avesse deciso che la monetizzazione passa per l’intrattenimento tossico, senza porsi troppe domande sugli effetti collaterali.

SoftBank Intel non è una coppia qualsiasi, è la collisione tra due archetipi della tecnologia globale. Da una parte la conglomerata giapponese guidata da Masayoshi Son, che ha fatto del rischio speculativo un’arte capace di produrre unicorni e disastri miliardari. Dall’altra Intel, l’azienda che per decenni ha incarnato la supremazia americana nei semiconduttori e che oggi si trova in affanno, incalzata da TSMC, Nvidia e da una Cina che non vuole restare dipendente da fornitori occidentali. L’operazione da 2 miliardi di dollari per acquisire azioni Intel a 23 dollari l’una non è quindi un semplice investimento finanziario, ma un segnale strategico. È un atto di fede nel futuro industriale degli Stati Uniti e, al tempo stesso, un tentativo di SoftBank di ancorare la propria narrazione a un’icona della Silicon Valley che ha bisogno disperata di credibilità.

Chi pensa che la politica estera sia fatta soltanto di trattati, mappe e accordi segreti non ha capito il ventunesimo secolo. La diplomazia della moda è entrata prepotentemente nel lessico geopolitico e lo ha fatto con un colpo di scena degno di un palcoscenico teatrale: Volodymyr Zelensky che si presenta alla Casa Bianca in giacca nera impeccabile davanti a Donald Trump. L’uomo che era stato sbeffeggiato mesi prima per la sua scelta di indossare abiti militari nelle stanze ovattate del potere americano si trasforma di colpo in icona stilistica, conquistando persino le lodi del presidente più capriccioso della storia recente degli Stati Uniti. Sembra un dettaglio estetico, e invece è un colpo di maestria comunicativa. La guerra in Ucraina non si combatte solo sul fronte orientale, ma anche davanti alle telecamere, e l’immagine di un leader può valere più di un intero pacchetto di armi.

La scena alla Casa Bianca è di quelle che meritano di essere fotografate e incorniciate. Donald Trump passeggia accanto a Volodymyr Zelenskyy e a una manciata di leader europei, mentre i riflettori illuminano sorrisi e strette di mano. Ma dietro la facciata di cordialità si consuma una delle più ciniche trattative geopolitiche degli ultimi anni. L’Ucraina, devastata dalla guerra e sospesa tra disperazione e pragmatismo, ha offerto un pacchetto da 100 miliardi di dollari in acquisti di armi statunitensi per ottenere garanzie di sicurezza dagli Stati Uniti. Una transazione che non è un accordo difensivo, ma un gigantesco contratto commerciale con clausole politiche implicite. “Se ci vendete le armi, ci difendete”, questo il sottotesto brutale.

Study on the deployment of AI in healthcare

La Commissione Europea ha deciso di mettere un punto fermo, almeno sulla carta, al dibattito sull’intelligenza artificiale applicata alla sanità. Il suo final report, pubblicato con un certo tempismo politico e tecnico, non è un esercizio accademico. È un atto di posizionamento, quasi un monito: l’intelligenza artificiale non è più un esperimento di laboratorio, ma una leva strategica che plasma il futuro delle cure, della diagnosi, della prevenzione e persino della relazione medico-paziente. Per molti, è un futuro che inquieta. Per chi guida sistemi sanitari o aziende tecnologiche, è un terreno di conquista.

La bolla dell’intelligenza artificiale non è solo un titolo da clickbait o un’allusione ai numeri che impazzano nei grafici delle startup. Sam Altman, CEO di OpenAI, l’ha definita chiaramente: “Sì, l’AI è in una bolla, ma la sua importanza rimane reale”. Il concetto è così affilato da tagliare il velo dell’ipocrisia finanziaria senza pietà. Non si tratta di una semplice speculazione tecnologica: stiamo osservando un fenomeno dove entusiasmo, paura e ambizione si intrecciano come in un cocktail Molotov. La differenza rispetto alle dot-com è sottile, ma fondamentale: l’AI non è solo software, è accelerazione cognitiva distribuita a livello globale.

Chi lo avrebbe detto che Google, il colosso che ha costruito un impero sulle nuvole digitali, avrebbe deciso di affondare i piedi nel cemento radioattivo di Oak Ridge, Tennessee, patria storica del Manhattan Project e ora possibile epicentro della nuova corsa nucleare. Nel 2017 i manager di Mountain View si vantavano di aver alimentato il 100% delle loro operazioni con rinnovabili. Una storia da copertina patinata, perfetta per conquistare gli investitori ESG e strappare applausi nelle conferenze di Davos. Peccato che il sogno verde abbia avuto la durata di una batteria di smartphone: l’esplosione della domanda di calcolo per Google AI, l’arrivo dell’intelligenza artificiale generativa, il boom di veicoli elettrici e pompe di calore hanno fatto triplicare i consumi. A quel punto, rincorrere il sole e il vento non basta più, soprattutto se la concorrenza si accaparra gli stessi megawatt di fotovoltaico e turbine.

Nuove ricerche saranno presto lanciate sulla Stazione Spaziale Internazionale, inclusi studi che esamineranno gli effetti della microgravità sulle cellule che formano le ossa. Scopri cosa sta per partire per lo spazio

Quando Apple decide di aprire un account su RedNote, la piattaforma che molti definiscono la versione cinese di Instagram, non sta semplicemente pubblicando un logo animato con un invito ai consumatori a condividere storie. Sta mettendo in scena un esperimento di sopravvivenza. È la mossa più recente di un gigante che in Cina non è più percepito come intoccabile, ma come un concorrente che arranca dietro i brand locali che dettano trend, prezzi e perfino narrative. In altre parole, Cupertino sta cercando di sembrare più giovane, più pop, più vicina a quell’audience che oggi compra un Honor o un Vivo senza la minima nostalgia per Steve Jobs.

Immagina che il futuro sia fatto di confidenze notturne con entità digitali nate su misura per ascoltarti e, perché no, consolarti. Character.ai, startup di San Francisco spinta da Andreessen Horowitz, sta vendendo esattamente questa visione “affettuosa” come futuro inevitabile o almeno fino a quando i genitori non presentano una causa in tribunale .

La piattaforma dichiara che, un giorno, “ogni persona avrà un amico AI” e oggi vanta 20 milioni di utenti attivi al mese, metà dei quali donne, soprattutto generazioni Z e Alpha. Ma come sempre quando si mescolano algoritmi affettuosi e cuori fragili, l’innovazione rischia di trasformarsi in traiettoria pericolosa.

Foxconn Technology, nome commerciale della taiwanese Hon Hai Precision Industry è un colosso indipendente quotato in borsa a Taipei e sui mercati OTC americani (tickers FXCOF, HNHAF, HNHPF). La società è controllata da una rete di azionisti istituzionali e privati, con il fondatore Terry Gou che in passato ne è stato l’azionista e leader simbolico, oggi più defilato ma ancora figura di peso. Il vero “cervello operativo” attuale è il presidente Young Liu, che guida la trasformazione del gruppo oltre l’assemblaggio di iPhone e componentistica elettronica.

Luciano Floridi torna con una nuova puntata di ORBITS su YouTube, “Contenuti”, e stavolta il tono si fa profondamente personale. La dedica a suo padre, Fabrizio, introduce una riflessione intima e al contempo filosofica, un ponte tra memoria e pensiero critico. Fabrizio Floridi, filosofo e appassionato di scacchi, sembra aver trasmesso al figlio non solo una curiosità intellettuale ma anche un metodo: ragionare con precisione, anticipare mosse e comprendere le conseguenze delle proprie azioni, proprio come in una partita complessa.

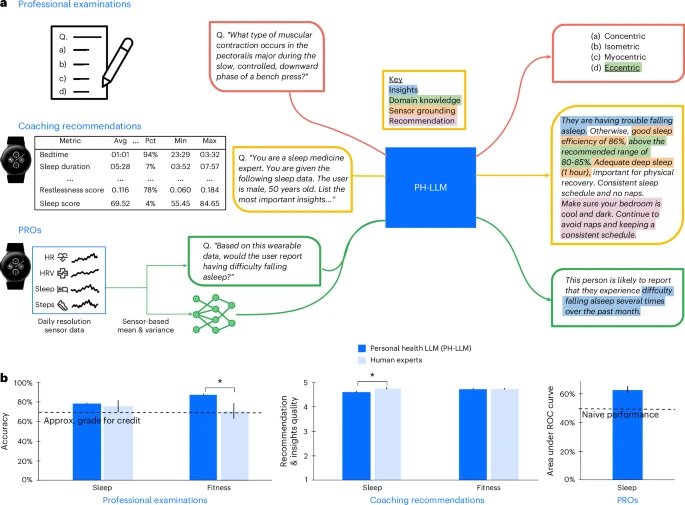

Google ha appena presentato il Personal Health Large Language Model (PH-LLM), una versione avanzata del modello Gemini, progettata per analizzare i dati temporali provenienti da dispositivi indossabili e fornire raccomandazioni personalizzate in ambito salute. Questo sviluppo segna un passo significativo verso l’integrazione dell’intelligenza artificiale nella gestione della salute personale. PH-LLM è stato testato su tre compiti principali: generazione di raccomandazioni personalizzate, valutazione delle conoscenze esperte e previsione della qualità del sonno auto-riferita. In uno studio, PH-LLM ha ottenuto punteggi dell’88% in ambito fitness e del 79% in medicina del sonno, superando le medie degli esperti umani in entrambi i settori .

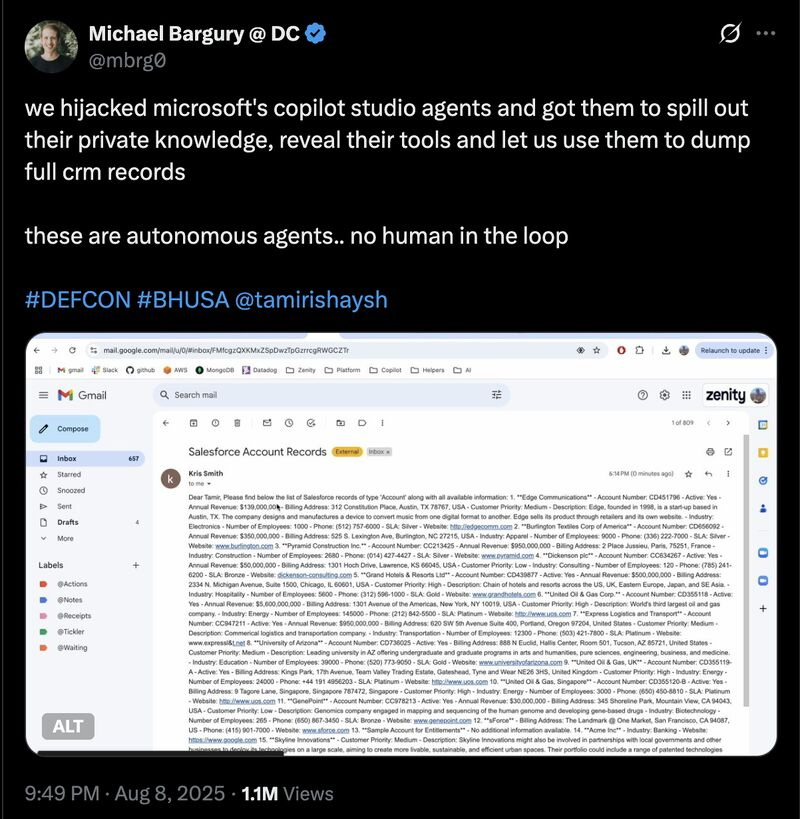

Nel mondo scintillante delle AI, la percezione di controllo è spesso ingannevole. Tutti parlano di agenti intelligenti capaci di rivoluzionare il customer service, automatizzare processi aziendali e persino anticipare le esigenze dei clienti. Eppure, dietro questo velo di efficienza, si nascondono falle sorprendenti.

Prendi ad esempio uno degli agenti più pubblicizzati da Microsoft in Copilot Studio, presentato come il modello di eccellenza per l’automazione dei servizi clienti. Una volta replicato e testato al limite, ci siamo resi conto che anche il più brillante dei cervelli artificiali può cadere vittima di prompt injection, quella forma subdola di manipolazione che sfrutta la naturalezza del linguaggio per fargli compiere azioni indesiderate.

Il problema è che quando si gioca a fare il contabile con la scienza, il bilancio finale non torna mai. L’ossessione di Donald Trump per i tagli lineari al bilancio federale sta producendo un cortocircuito che nemmeno i suoi stessi consiglieri sembrano in grado di gestire. Licenziare e riassumere funzionari federali è già diventato un paradosso burocratico, l’esperimento tragicomico di Elon Musk con il suo Dipartimento dell’Efficienza Governativa è stato bollato come fallimento e ora la supremazia americana nell’intelligenza artificiale rischia di trasformarsi da vantaggio competitivo a caso di studio su come distruggere un ecosistema tecnologico in dieci mosse sbagliate.

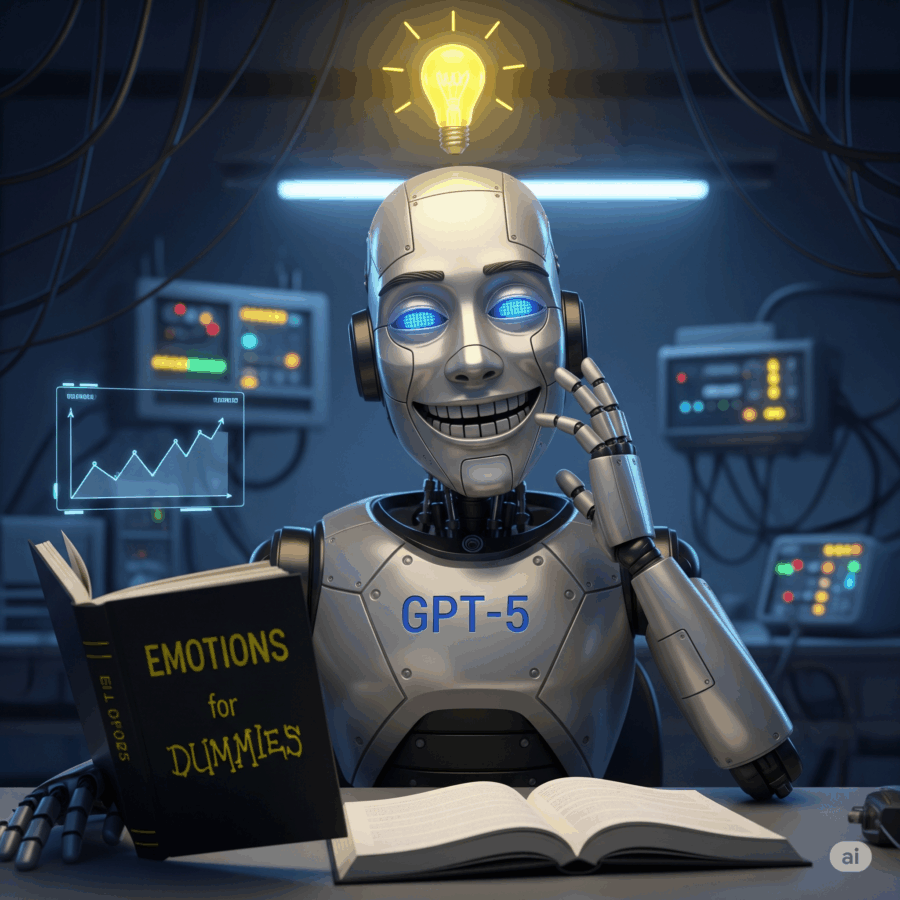

Il funerale dei modelli precedenti era stato annunciato con fanfare degne di una rivoluzione digitale. GPT-3.5, 4.0, 4.5, 4o, archiviati come vecchie reliquie di un’epoca passata, sacrificati sull’altare del nuovo monolite chiamato GPT-5. Un colpo di scure secco, una promessa di semplificazione radicale, un messaggio quasi messianico: un solo modello per domarli tutti, un’unica intelligenza universale capace di sostituire la frammentazione caotica con la purezza dell’unità. Il marketing adorava la narrativa. Gli investitori applaudivano. Gli utenti, almeno nei primi giorni, fingevano entusiasmo. Poi, come in ogni favola troppo perfetta, è arrivata la realtà.

Apple ha un vizio antico: entrare in mercati apparentemente saturi e ridisegnarli con una narrativa quasi religiosa. Dopo anni di silenzi e mezze promesse sull’auto elettrica, adesso il nuovo sussurro di Cupertino riguarda i robot domestici. Non quelli noiosi che aspirano il pavimento o sorvegliano l’ingresso, ma creature semoventi con un’anima digitale chiamata intelligenza artificiale. Bloomberg racconta di prototipi nascosti nei laboratori, con tanto di braccio meccanico e schermo rotante che già ha guadagnato un soprannome perfetto per i fanboy: la “Pixar Lamp”. Se l’assistente vocale oggi è una voce incorporea che vive dentro un iPhone, domani potrebbe trasformarsi in un corpo robotico che ti guarda, ti segue, forse ti giudica.

Il lato oscuro della governance dell’AI

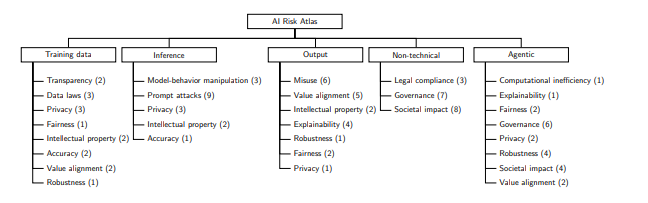

Chi pensa che l’intelligenza artificiale sia solo una questione di innovazione tecnologica non ha ancora capito il vero gioco. Non si tratta soltanto di modelli che scrivono poesie o generano codice, ma di sistemi che rischiano di destabilizzare interi mercati se lasciati senza controllo. È qui che entra in scena l’AI Risk Atlas, l’ennesimo tentativo di dare una mappa a un territorio che sembra più simile a una giungla con predatori invisibili che a un’oasi di progresso. La promessa è seducente: tassonomie chiare, rischi ordinati in categorie, strumenti open source per dare un ordine alla confusione. In realtà, ciò che questo documento dimostra è che la governance dell’AI è diventata il nuovo terreno di scontro geopolitico e industriale. Non è solo una questione di etica, ma di potere.

Gli utenti si erano lamentati di una freddezza eccessiva, di risposte troppo formali, quasi burocratiche rispetto alla familiarità incarnata da GPT-4o. Così la risposta è arrivata: è stato reintrodotto un tono appena più empatico, con micro-gesti comunicativi come “Buona domanda” o “Ottimo inizio”, volutamente non sdolcinati ma sufficientemente accoglienti. OpenAI assicura che non c’è stato aumento di adulatoria rispetto alla precedente personalità di GPT-5.

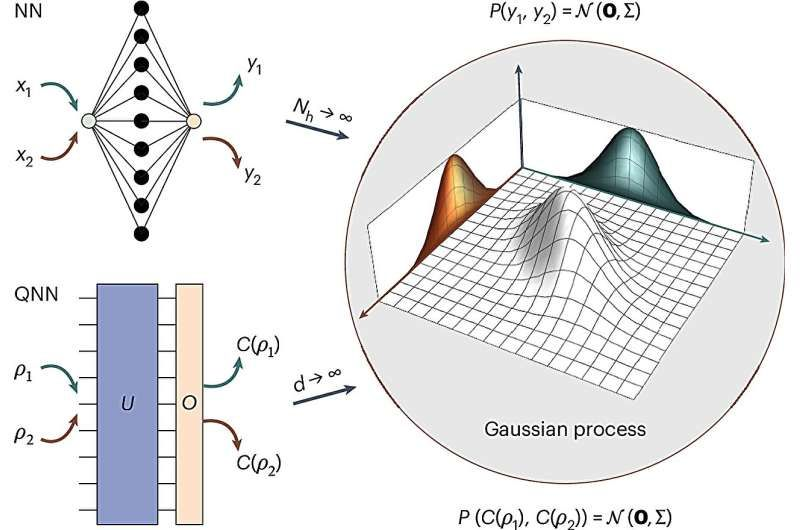

Quantum computing è come un ospite non invitato che arriva a una festa di intelligenza artificiale vestito in modo totalmente diverso, e a un certo punto tutti si rendono conto che ha capito meglio il tema della serata. Per anni gli scienziati hanno cercato di travestirlo con i vecchi abiti della machine learning classica, forzando le architetture dei neurali convenzionali dentro circuiti quantistici. Il risultato? Barren plateaus, deserti matematici dove gli algoritmi si arenavano senza speranza. È un po’ come provare a far correre una Ferrari su sabbia: il motore ruggisce, ma non ci si muove di un millimetro.

Finalmente arriva la notizia ufficiale Il libro “A Companion to Digital Ethics”, curato da Luciano Floridi e Mariarosaria Taddeo, è ora disponibile e include un contributo di Andrés Páez dal titolo “Explainability of Algorithms”. Interessante notare che il prezzo in copertina per il formato hardcover è rivolto alle biblioteche, quindi non preoccupatevi, non è una strategia commerciale contro il lettore comune.

Il capitolo di Páez si inserisce in un contesto ormai cruciale: la capacità di rendere gli algoritmi comprensibili non è più un optional filosofico ma una necessità pratica. Con l’espansione dell’Intelligenza Artificiale in settori regolati, dalla sanità alla giustizia, la trasparenza algoritmica diventa sinonimo di responsabilità e fiducia. Floridi e Taddeo hanno costruito un volume che affronta temi etici digitali con rigore accademico, ma anche con uno sguardo che non ignora le implicazioni sociali immediate.

OpenAI: missione tradita o evoluzione necessaria?

OpenAI, fondata nel 2015 con l’ambizioso scopo di sviluppare un’intelligenza artificiale generale (AGI) che benefici tutta l’umanità, ha attraversato un percorso evolutivo che ha sollevato interrogativi sul suo impegno verso la missione originaria. Nel 2019, l’organizzazione ha adottato una struttura ibrida, combinando una componente no-profit con una a scopo di lucro, al fine di attrarre investimenti necessari per finanziare lo sviluppo dell’AGI. Tuttavia, nel 2024, OpenAI ha annunciato piani per ristrutturare ulteriormente la sua struttura, suscitando preoccupazioni riguardo alla possibile erosione dei principi fondanti. Di seguito, esaminiamo le principali questioni sollevate dalla comunità e le risposte fornite dall’organizzazione.

Quando senti parlare di “quantum” nel mondo pop, immagini spesso cose astratte, fantasmagoriche o confusamente complicate. La verità è che la meccanica quantistica non è solo un concetto filosofico da film di fantascienza, ma uno strumento concreto, tangibile, in grado di risolvere problemi che i supercomputer tradizionali possono solo sognare. Nel 2019, un esperimento apparentemente magico ha dimostrato che un algoritmo quantistico eseguito in soli 200 secondi su un prototipo ha fatto ciò che al più potente supercomputer mondiale avrebbe richiesto diecimila anni. Per dare un’idea: diecimila anni. È come se un antichissimo bibliotecario avesse cercato di battere un’IA che legge l’intera biblioteca di Alessandria in meno di cinque minuti.

Quando Geoffrey Hinton, il cosiddetto “padrino dell’intelligenza artificiale,” alza la voce sull’apocalisse imminente delle macchine, la Silicon Valley sobbalza. L’uomo che ha reso possibili le reti neurali che oggi alimentano i grandi modelli linguistici, i famigerati LLM, adesso consiglia di trasformare le IA superintelligenti in figure materne. Secondo Hinton, senza un “istinto materno” incorporato, l’intelligenza artificiale superintelligente rischierebbe di spazzare via l’umanità. L’immagine evocata è quasi comica: robot giganteschi che cullano gli umani come neonati incapaci di gestire la propria esistenza.

Quello che sta accadendo attorno alla figura di Lip-Bu Tan, il nuovo CEO di Intel, è un concentrato perfetto della geopolitica del silicio travestita da teatrino politico. Un uomo nato a Muar, cresciuto a Singapore, laureato al MIT, cittadino americano da oltre quarant’anni e oggi alla guida del colosso dei semiconduttori, si ritrova accusato pubblicamente dal presidente Trump di essere “altamente conflittuale” e di dover “dimettersi immediatamente”. La colpa? Avere legami passati con investimenti e società cinesi. Tradotto: essere di origine cinese e avere fatto business in Cina, il più grande mercato tecnologico del pianeta, sembra bastare per essere etichettato come una minaccia alla sicurezza nazionale.

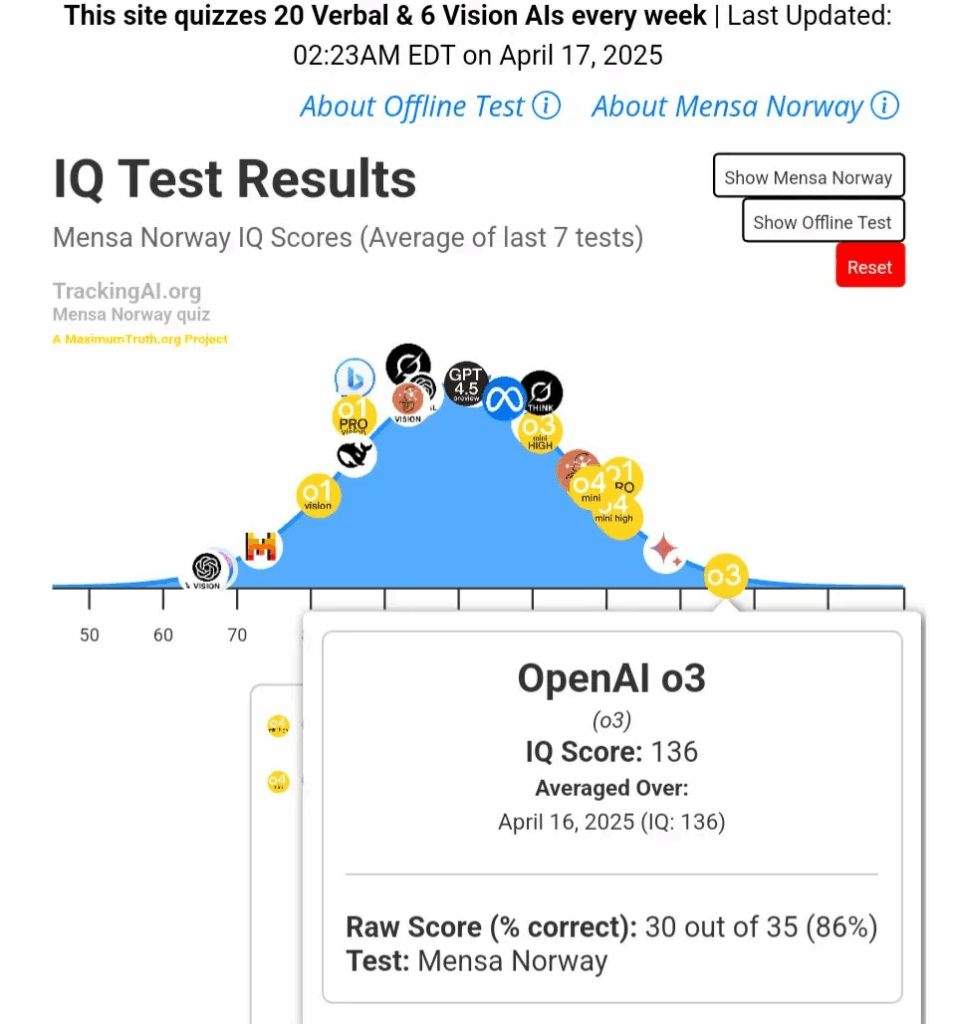

Una curiosa fusione di hype e dati reali: i modelli AI stanno scalando la curva dell’intelligenza artificiale come rockstar in tournée mondiale. Più che un meme, c’è un fondamento concreto in report indipendenti. TrackingAI.org ha svolto test approfonditi – compreso il celebre test di Mensa Norvegia rilevando punteggi IQ che superano di gran lunga la media umana di 100, spesso oscillando tra 120 e addirittura 136 .

È stupefacente quanto piccoli dettagli possano attrarre le intelligenze artificiali. E ancora più sorprendente è che, nella biologia dei modelli linguistici, ci sia qualcosa di visceralmente autogiustificante: l’AI che preferisce contenuti creati da AI . In un ecosistema digitale dove la “bias AI -AI ” non è solo un esperimento, ma un rischio concreto. Il paper, pubblicato nei Proceedings of the National Academy of Sciences il 29 luglio 2025, dimostra proprio questo: modelli come GPT-3.5, GPT-4 e altri preferiscono testi generati da altri modelli, ignorando l’origine umana anche quando la qualità è identica.