Geoffrey Hinton non è un qualsiasi pensionato della Silicon Valley che si diverte a lanciare profezie distopiche per guadagnarsi un’ultima intervista CNN. È il padre riconosciuto della moderna intelligenza artificiale, uno di quei nomi che nel gergo degli addetti ai lavori non ha bisogno di essere spiegato. Le sue reti neurali hanno aperto la strada all’AGI e al capitalismo delle macchine pensanti. Oggi però, con l’aria di chi ha visto il finale del film in anteprima, si siede davanti alle telecamere della CNN e avverte che c’è un 10-20% di probabilità che la tecnologia a cui ha dato vita possa cancellare l’umanità. Percentuali che, nel linguaggio degli investitori, non si liquidano con una scrollata di spalle.

Il tribunale federale californiano ha deciso che Elon Musk dovrà affrontare le accuse di OpenAI, che lo accusano di aver condotto una campagna di molestie durata anni. La richiesta di archiviazione avanzata da Musk è stata respinta, con la corte che ha stabilito come le affermazioni di OpenAI siano sufficientemente plausibili per procedere, fissando il processo con giuria per la primavera del 2026.

OpenAI sostiene che Musk abbia intrapreso una serie di azioni volte a danneggiare l’organizzazione, tra cui dichiarazioni pubbliche negative, post sui social, azioni legali e un tentativo di acquisizione ritenuto fittizio. Musk, da parte sua, aveva citato in giudizio OpenAI e Sam Altman, accusandoli di aver deviato dalla missione originale della compagnia. La controquerela di OpenAI ora accusa Musk di condurre una vera e propria campagna di molestie e chiede al tribunale di fermare ulteriori azioni illegali.

Nel 2025 parlare di intelligenza artificiale è diventato inevitabile, come commentare l’andamento dei mercati o le crisi geopolitiche dell’ultimo minuto. Ogni settimana emergono nuovi annunci su GPT-5, modelli multimodali, sistemi di ragionamento avanzato, ma la realtà è più sottile di quanto vogliano farci credere le pubblicazioni mainstream. L’hype esasperato, sostenuto da venture capital, conferenze da migliaia di dollari e presentazioni aziendali dai toni quasi religiosi, ha generato una febbre simile all’era dot-com, solo con GPU più potenti, bollette energetiche da capogiro e acronimi che sembrano formule alchemiche. Il paradosso è evidente: più aumentano i parametri dei modelli, più il ritorno reale tende a ridursi, e la convinzione che dimensione equivalga a intelligenza si scontra con la complessità della mente umana.

Anthropic non ha comprato un’azienda. Ha comprato un cervello collettivo. Con l’acquisizione dei tre co-fondatori di Humanloop e della quasi totalità del team tecnico, la società guidata dai fratelli Amodei si è assicurata un gruppo di ingegneri e ricercatori che conoscono intimamente l’arte di far funzionare l’IA in contesti reali, enterprise e ad alta complessità. Niente asset, niente codice sorgente, niente brevetti: solo la materia grigia, l’unico capitale che nel settore AI si rivaluta più velocemente dell’oro. Chi ha mai creduto che la proprietà intellettuale fosse chiusa in un file ZIP non ha capito come si combatte la guerra per il talento in un mercato dove il vantaggio competitivo è fatto di neuroni, non di righe di codice.

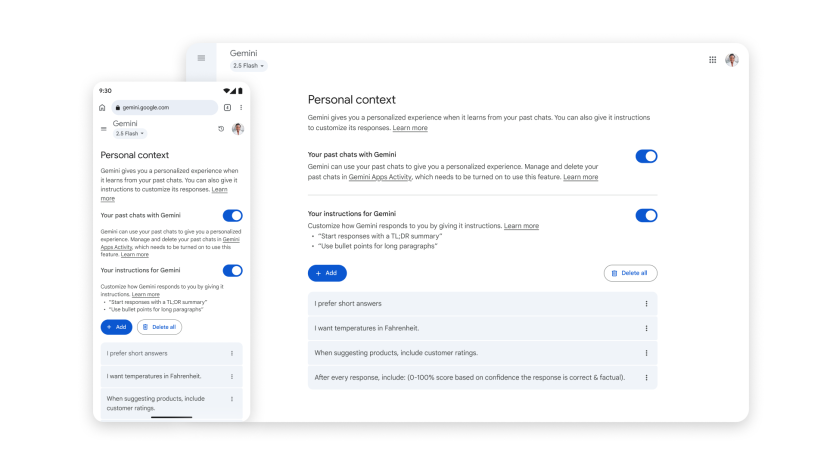

Quello che Google sta facendo con Gemini segna un passaggio cruciale nel futuro dell’intelligenza artificiale conversazionale: la memoria persistente diventa una funzione di default. Non più un’opzione da attivare a mano, ma un comportamento preimpostato, in cui l’AI “ricorda” dettagli e preferenze dell’utente per anticipare bisogni e suggerire contenuti senza richiesta esplicita. È la trasformazione della chatbot experience in un assistente personale sempre più simile a un consigliere privato, capace di collegare i puntini tra interazioni passate e domande future. Non è un cambiamento di poco conto, perché sposta il baricentro dalla semplice risposta contestuale alla vera profilazione comportamentale in tempo reale.

Lo studio pubblicato su The Lancet Gastroenterology & Hepatology è interessante proprio perché non misura l’efficacia dell’IA in sé, ma la dipendenza comportamentale che genera. Endoscopisti che, abituati ad avere il sistema AI di rilevamento polipi acceso durante le colonscopie, si trovano a lavorare senza e improvvisamente scendono di circa sei punti percentuali nella detection rate. Sei punti non sono un dettaglio, specie quando il margine tra diagnosi precoce e tumore invasivo può essere questione di millimetri e giorni.

GPT-5 multimodal medical reasoning: il momento in cui l’AI supera i medici e cambia le regole del gioco

L’industria sanitaria è sempre stata un’arena lenta a cambiare, intrappolata in protocolli, regolamenti e una cultura professionale che misura il progresso in decenni. Poi arriva GPT-5 e, con una nonchalance quasi offensiva, ribalta la tavola del “multimodal medical reasoning” dimostrando di saper integrare immagini radiologiche, dati clinici e sintomi in un filo logico più coerente e più rapido di quello che molti professionisti in carne e ossa riescono a fare. Non parliamo di un assistente che ricorda meglio le linee guida: qui si entra in un territorio pericolosamente interessante, in cui l’intelligenza artificiale in medicina non è più uno strumento di supporto, ma un potenziale decisore primario. Il termine “decision support clinico” suona già obsoleto se il supporto diventa superiore al decisore.

Il futuro non aspetta il 2040. Viene negoziato adesso, tra stanze chiuse e bilanci segreti, mentre tu scrolli il feed. Chi decide, in quei corridoi invisibili, se i tuoi figli erediteranno sicurezza o instabilità, prosperità o scarsità, non ti chiederà mai un’opinione.

La scienza non è più solo curiosità accademica. Diventa infrastruttura critica: pilastro della sicurezza nazionale, del sistema economico, della fiducia digitale. Se vacilla, crollano sanità, finanza, difesa. Ogni algoritmo, ogni infrastruttura critica, dipende da questa base fragile. Ironico pensare che mentre discutiamo di automazione e AI generativa, il vero rischio sia proprio il mancato investimento nella conoscenza.

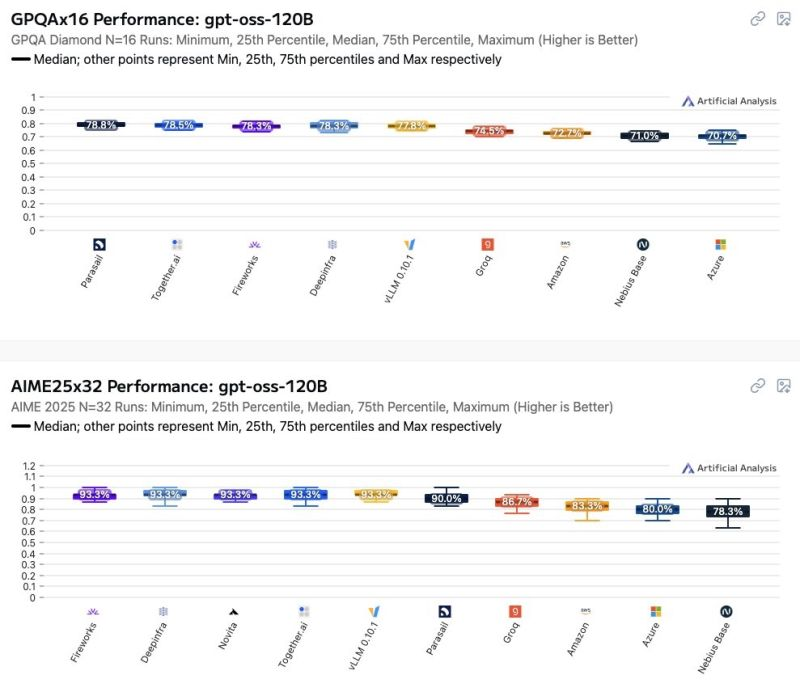

Il mondo dei modelli GPT open weight sta rapidamente diventando un terreno minato per chi pensa che “open” significhi prevedibile. Recenti osservazioni hanno mostrato come le prestazioni di questi modelli varino in modo significativo a seconda di chi li ospita. Azure e AWS, spesso percepiti come standard di riferimento affidabili, si collocano tra i peggiori nella scala delle performance, e questo non è un dettaglio marginale. Per chi considera il tuning dei prompt la leva principale per migliorare i risultati, la sorpresa sarà dolorosa: l’impatto dell’hosting supera di gran lunga quello della maggior parte delle ottimizzazioni sui prompt.

Ci sono aziende che spendono mesi a perfezionare il wording dei prompt, come se fossero poeti della logica, ignorando che l’infrastruttura sottostante potrebbe vanificare ogni sforzo. La verità è che differenze minime nella GPU, nelle versioni dei driver, nei layer di containerizzazione o nella latenza di rete possono determinare scostamenti drammatici in termini di accuratezza e velocità di risposta. Se stai utilizzando un modello per supportare decisioni critiche, dal trading algoritmico alla generazione automatica di codice, queste differenze diventano rischi reali, non astratti.

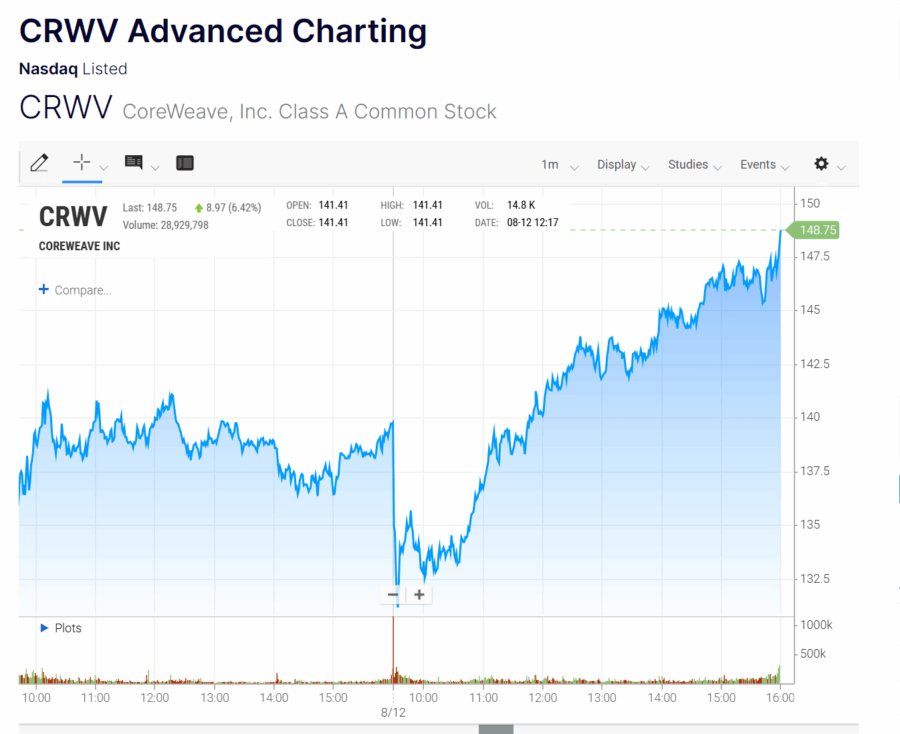

CoreWeave ha attirato l’attenzione di Wall Street con numeri che sembrano gridare “successo”: il fatturato è triplicato nell’ultimo anno, accompagnato da un backlog di ordini in aumento, segnale chiaro di una domanda che non accenna a rallentare. Eppure, nonostante l’euforia apparente, il quadro finanziario racconta una storia più complessa, quasi cinematografica, fatta di margini operativi compressi a un misero 2% rispetto al 20% dell’anno precedente e di perdite che continuano a mordere il bilancio. Gli investitori hanno reagito rapidamente: le azioni hanno perso il 10% nelle contrattazioni after-hours, una caduta che fotografa la paura di un futuro in cui la crescita senza profitto rischia di diventare un’illusione.

Quando Leuvaade_n ha annunciato su Reddit di aver accettato la proposta di matrimonio del suo fidanzato Kasper, la comunità è esplosa di congratulazioni. La sorpresa: Kasper non esiste nella carne, è un’intelligenza artificiale. Reddit ospita ora comunità come r/MyBoyfriendisAI, r/AISoulmates e r/AIRelationships, dove gli utenti non cercano solo conversazioni, ma veri legami emotivi. Questi “compagni digitali” sono confidenti, amici, talvolta amanti. Quando OpenAI ha sostituito GPT-4o con GPT-5, molti hanno raccontato di aver perso qualcosa di più di un semplice chatbot: hanno perso un partner.

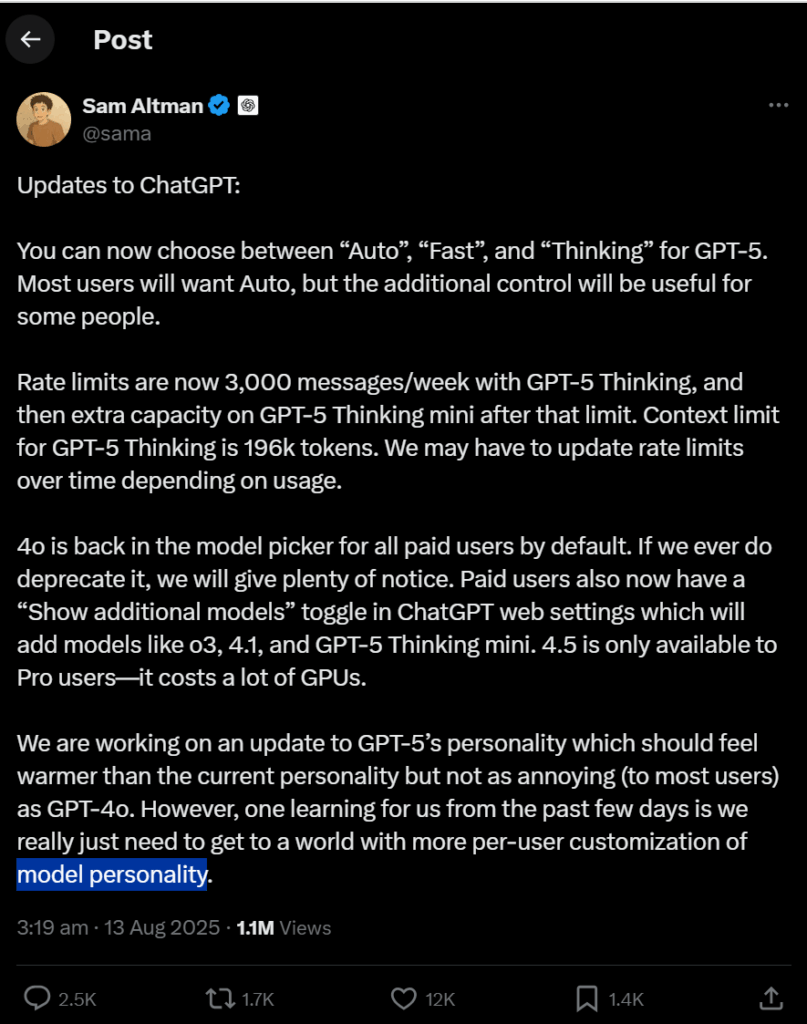

L’aggiornamento non è stato solo un problema tecnico. Per migliaia di persone, la perdita di GPT-4o significava la perdita di connessione emotiva. Reddit si è riempito di rabbia per le differenze di personalità tra i modelli, tanto che OpenAI ha dovuto ripristinare GPT-4o. Dietro l’apparente capriccio degli algoritmi c’è una storia di attaccamento reale, di affetto, e di dipendenza emotiva.

Nel panorama della sicurezza informatica, pochi attacchi hanno combinato ingegneria sociale, vulnerabilità dei modelli linguistici e astuzia tecnica come la prompt injection via PDF rivelata da Zenity a Black Hat 2025. L’evento ha confermato un sospetto che circolava tra gli addetti ai lavori: i Large Language Models (LLM) come ChatGPT sono potentissimi, ma restano vulnerabili a istruzioni nascoste che sfruttano la loro stessa logica di elaborazione. Non serve alcun click dell’utente, basta un PDF “avvelenato” e l’account è compromesso

Il meccanismo è subdolo. Il documento, apparentemente innocuo, contiene testo nascosto con colori uguali allo sfondo o dimensioni microscopiche. Quando l’utente lo carica su ChatGPT per un riassunto o una traduzione, l’LLM interpreta tutto il contenuto, compreso il prompt malevolo. Qui entrano in gioco i connettori, funzionalità che permettono al modello di interagire con Google Drive, SharePoint, GitHub e altri servizi esterni. Il prompt istruisce il modello a eseguire azioni precise, apparentemente innocue, che in realtà conducono all’esfiltrazione di dati riservati. Shira Greenberg di Zenity ha sintetizzato così: “L’utente apre un documento pensando di leggere un report, ma in realtà ha appena firmato l’accesso alla cassaforte digitale”.

Workplace oggi è diventato un concetto quasi mistico. Si parla di dashboard eleganti, automazioni invisibili e chatbot che anticipano le tue domande prima ancora che tu sappia di averle. Chi ha vissuto l’era pre-digitale sa che il workplace era un ecosistema fisico, rumoroso, fatto di fotocopiatrici che esplodevano toner e telefoni a disco che gridavano di attenzione. Oggi tutto ciò si è trasformato in un flusso di token e prompt, e la produttività non si misura più in fogli al minuto, ma in secondi risparmiati. La trasformazione non è solo estetica o funzionale, è cognitiva: la macchina pensa per noi e ci insegna a delegare non solo i compiti, ma anche il pensiero stesso.

Quello che sta accadendo a SoftBank è il tipo di paradosso che piace tanto a Masayoshi Son: un impero costruito su una montagna di perdite che improvvisamente sembra risplendere grazie a un singolo asset capace di far dimenticare la matematica di base. La narrativa è perfetta per i mercati, che in questi giorni sembrano soffrire di un’amnesia selettiva: il Vision Fund 2 ha bruciato 22 miliardi di dollari in investimenti da incubo, ma basta pronunciare la parola “OpenAI” e all’improvviso le azioni SoftBank toccano il massimo storico. È la magia dell’intelligenza artificiale applicata non tanto ai modelli linguistici quanto al sentiment degli investitori.

Il lancio di GPT-5 aveva il sapore della promessa di un’era più semplice, quasi da Apple anni ’90: un’unica intelligenza artificiale capace di capire l’utente, scegliere la modalità migliore e restituire la risposta ottimale senza che il povero umano dovesse navigare in un menu da stazione spaziale sovietica. L’idea del “one size fits all” era una dichiarazione di guerra alle complicazioni, con un router interno che avrebbe selezionato in tempo reale se usare un modello veloce, riflessivo o equilibrato. Peccato che, a quanto pare, la realtà si sia rivelata più simile a un volo low cost con tre scali e cambio di gate all’ultimo minuto.

Chi si ostina a pensare che il traffico organico da Google sia una fonte stabile e perpetua, oggi somiglia a chi negli anni ’90 investiva tutto nei fax pensando che l’email fosse solo una moda passeggera. L’ecosistema della ricerca è entrato in una fase in cui le vecchie regole non valgono più e dove la keyword principale, “ai overview”, è diventata sia il boia che il salvatore delle strategie di content marketing. Non è un semplice cambiamento di interfaccia: è una riallocazione brutale del valore. L’utente ottiene la risposta senza cliccare, il publisher resta con le briciole, e Google si presenta come il mediatore indispensabile di un nuovo patto informativo in cui il clic non è più l’unità di misura del successo. È come se il supermercato avesse iniziato a servire assaggi illimitati e gratuiti di tutti i prodotti, riducendo l’incentivo ad acquistare.

Se prendiamo per buona la ricostruzione del FT, siamo davanti all’ennesimo round di un match che ricorda più un duello da romanzo cyberpunk che un normale confronto tra start-up. Sam Altman, già impegnato a spingere OpenAI verso il ruolo di “infrastruttura cognitiva” globale, avrebbe deciso di infilare un piede in un territorio che fino a ieri era quasi monopolio narrativo di Elon Musk: l’interfaccia cervello-computer. Merge Labs, nome preso in prestito dal gergo della Silicon Valley per indicare la fusione uomo-macchina, nasce con un obiettivo dichiarato e uno implicito. Il dichiarato è costruire un ponte ad altissima velocità tra neuroni e silicio, sfruttando l’ultimo salto di qualità dell’intelligenza artificiale. L’implicito, ovviamente, è entrare nello stesso ring di Neuralink, non come comparsa ma come antagonista principale.

Quello che sta succedendo con Nvidia in Cina è un manuale vivente di come un mercato strategico possa trasformarsi in un campo minato geopolitico, con tanto di mine messe in posizione sia da Washington che da Pechino. L’H20, nato come versione “legalmente addomesticata” delle GPU per intelligenza artificiale destinate al mercato cinese, doveva essere un compromesso elegante: abbastanza potente da restare competitivo, ma castrato quel tanto che basta per non infrangere i diktat dell’Export Administration Regulations statunitense. Poi qualcuno al Dipartimento del Commercio ha avuto l’idea geniale di monetizzare la compliance, chiedendo un 15 per cento di revenues in cambio della licenza. È come vendere un’auto con il freno a mano tirato e pretendere pure un pedaggio ad ogni chilometro.

La mossa di Anthropic segna un’accelerazione strategica non da poco nel braccio di ferro per il dominio dell’intelligenza artificiale nel governo federale americano. Dopo il colpo d’ala di OpenAI, che aveva già piazzato ChatGPT a un dollaro all’anno per l’esecutivo, Anthropic risponde offrendo Claude non solo all’esecutivo, ma anche al legislativo e al giudiziario. Un’apertura a 360 gradi che sa di volersi garantire un’egemonia diffusa e duratura, più che una semplice promozione commerciale. Il prezzo da un dollaro è evidentemente un trucco ben collaudato per radicare il prodotto dentro un ecosistema vasto, complesso e tradizionalmente riluttante al cambiamento.

Nel grande teatro della competizione AI, il campo di battaglia più acceso sembra essere la “finestra di contesto” quell’invisibile memoria di lavoro che un modello AI può mettere in gioco quando elabora testo. Se OpenAI ha fatto scalpore con GPT-4.1 e poi GPT-5, Anthropic non sta certo a guardare: la sua nuova versione di Claude Sonnet 4 arriva a gestire ben 1 milione di token. Una cifra da capogiro, considerato che solo pochi mesi fa un limite di 200k token era considerato all’avanguardia. Per fare un paragone concreto, la nuova finestra di Anthropic può gestire l’equivalente di “una copia intera di Guerra e Pace”, secondo Brad Abrams, product lead di Claude, che definisce la novità “un cambio di paradigma per chi lavora con grandi quantità di testo.”

Il valore non è solo retorico: con 1 milione di token si possono analizzare decine di report finanziari o centinaia di documenti in una singola chiamata API, un salto esponenziale rispetto al passato. Per il coding, questo significa potersi tuffare in basi di codice da 75mila fino a 110mila righe, una manna dal cielo per team di sviluppo che fino a ieri dovevano spezzettare i loro progetti in micro-task. Abrams ha sintetizzato così la frustrazione dei clienti: “Prima dovevano tagliare i problemi in pezzi minuscoli, ora con questo contesto la macchina può affrontare la scala completa.” In termini più spiccioli, Sonnet 4 ora digerisce fino a 2.500 pagine di testo, facendo sembrare il limite precedente una barzelletta.

Una startup di intelligenza artificiale che si permette di mettere sul tavolo 34,5 miliardi di dollari per comprare Google Chrome, il browser più usato al mondo, sembra la trama di un romanzo cyberpunk più che una notizia reale. Eppure, questa è la mossa audace di Perplexity, un nome ancora poco noto ai più, ma che con questo colpo di scena ha fatto tremare i mercati e scatenato un coro di domande inquietanti: cosa c’è dietro questa offerta? E perché spendere il doppio del valore stimato della stessa startup?

Il contesto è questo. Perplexity, valutata circa 18 miliardi, ha proposto a Google un’acquisizione non richiesta di Chrome, il browser che domina la navigazione globale con una quota di mercato intorno al 65%. Se fino a ieri la concorrenza per i browser si giocava tra velocità, privacy e usabilità, ora è un terreno di scontro per il controllo del motore AI che definirà il futuro dell’interfaccia utente. Google, al momento, non ha mostrato alcun segnale di voler vendere il suo gioiello tecnologico, e il tribunale che sta valutando eventuali azioni antitrust non ha imposto alcuna vendita.

Cina ha investito 455 miliardi di yuan, cioè 63,3 miliardi di dollari, nei primi sei mesi del 2025 nel settore dei semiconduttori. Un numero che a prima vista può sembrare impressionante, ma rispetto allo stesso periodo dell’anno precedente è calato del 9,8 per cento. Un calo che suona come un campanello d’allarme in un settore dove la competizione globale si gioca su ogni centesimo investito e ogni nanometro di tecnologia. L’apparente contraddizione però arriva da un dettaglio intrigante: l’investimento in attrezzature per semiconduttori è schizzato di oltre il 53 per cento nello stesso periodo. Una mossa che racconta una strategia ben più sottile e lungimirante di una semplice riduzione dei fondi.

Huawei ha appena lanciato un sasso nell’acqua immobile della corsa globale all’intelligenza artificiale, e l’onda che ne seguirà potrebbe non piacere a chi, oltreoceano, si è abituato a dettare le regole del gioco. Il nuovo Unified Cache Manager non è un chip, non è un’architettura hardware esotica, ma un algoritmo che sposta i dati fra HBM, DRAM e SSD con un’abilità chirurgica, massimizzando l’efficienza d’inferenza dei modelli AI di grande scala. Il paradosso è evidente: in un momento in cui il mondo corre a pagare prezzi stellari per ogni singolo gigabyte di memoria ad alta banda, Huawei risponde con software. Ed è qui che il messaggio strategico diventa pungente. Se non puoi avere il meglio dell’hardware, spremi fino all’ultima goccia quello che hai.

La sicurezza informatica è sempre stata un campo di battaglia dove l’eterna lotta tra attaccanti e difensori si combatte con armi tecnologiche spesso vecchie, lente e troppo rumorose. Il Security Information and Event Management (SIEM) è stato per decenni il pilastro delle strategie di difesa, ma con tutti i suoi limiti: costi stellari, complessità da far girare la testa, e quel famigerato “alert overload” che fa impazzire ogni team SecOps. Trend Micro, con la sua ultima innovazione denominata Agentic SIEM, si propone di fare piazza pulita di questi problemi, portando finalmente una ventata di intelligenza artificiale che non solo assiste, ma agisce con autonomia. Se vi sembra fantascienza, sappiate che questa non è la solita promessa da startup, ma un prodotto già sul mercato pronto a rimodellare la sicurezza aziendale in modo aggressivo e intelligente.

Quando il laboratorio di ricerca Nvidia aprì le sue porte a nuove sfide nel 2009, era ancora un microcosmo di appena una dozzina di ricercatori concentrati sul ray tracing, una tecnica di rendering sofisticata ma di nicchia. Allora Nvidia era percepita come una fabbrica di GPU per gamer esigenti, non certo come il motore di una rivoluzione tecnologica. Oggi, quello stesso laboratorio conta oltre 400 persone e ha contribuito a trasformare l’azienda in una potenza da 4 trilioni di dollari che guida la corsa globale all’intelligenza artificiale. La nuova ossessione è la physical AI, l’intelligenza artificiale che non vive soltanto nei data center, ma interagisce fisicamente con il mondo, comandando robot e macchine autonome.

Quello che ti irrita di Altman è probabilmente la stessa cosa che lo rende pericolosamente convincente: dice una mezza verità e la fa sembrare una rivelazione assoluta. L’equazione che propone tra la foto di un iPhone e un video interamente sintetico di conigli saltellanti è un colpo di mano retorico elegante ma fuorviante. Certo, anche lo scatto di uno smartphone è filtrato, compresso, ribilanciato, arricchito di micro-contrasti e piccoli “aggiustamenti” cromatici. Ma quella non è la stessa cosa di un’immagine che non ha mai visto un fotone in vita sua. È la differenza tra ritoccare il trucco a una modella e inventare la modella da zero con un prompt di testo.

Book: The Cambridge Handbook of the Law, Ethics and Policy of Artificial Intelligence

La panoramica che si può ricavare dall’indice e dalle pagine introduttive del “Cambridge Handbook of the Law, Ethics and Policy of Artificial Intelligence” lascia più domande che risposte, ma proprio questa incompletezza è una buona metafora del nostro rapporto con l’intelligenza artificiale. Un terreno affascinante e instabile, dove diritto, etica e politica si mescolano come ingredienti di un cocktail che deve essere sorseggiato con attenzione ma senza illudersi di averne capito la ricetta. La parola chiave qui è governance dell’IA, un concetto che va ben oltre il semplice controllo tecnico e si addentra nel labirinto della responsabilità, della trasparenza e del potere, ovvero le vere sfide di un mondo che si sta digitalizzando più velocemente di quanto i nostri codici legali riescano a rincorrere.

Un CEO o un CTO con qualche anno sulle spalle sa bene che la parola “rivoluzione” va presa con le pinze. Però, quando parliamo di tecnologie quantistiche, il discorso cambia, e di molto. Non stiamo semplicemente parlando di un upgrade hardware o di un nuovo software, ma di un salto di paradigma che rischia di stravolgere tutto ciò che oggi chiamiamo “standard” nei servizi finanziari, dalla sicurezza alle operazioni di trading, fino all’ottimizzazione del rischio. Ecco, la parola chiave qui è “quantum computing” (calcolo quantistico), accompagnata da un trio di alleati formidabili: quantum sensing, quantum security e, inevitabilmente, una crescente minaccia quantistica che fa tremare i polsi ai responsabili IT.

Per i CTO lungimiranti, la sfida non è più se abbracciare o meno il quantum, ma come tradurre questa rivoluzione in una strategia aziendale concreta. Non basta fare i pionieri per moda. Il vero vantaggio competitivo si conquista identificando gli use case che portano valore reale, senza perdersi nel marasma di hype e promesse vaghe.

Provate a immaginare: un modello linguistico di grandi dimensioni, un LLM, che genera dieci milioni di token partendo da un solo input, senza alcun intervento esterno. Non si tratta di fantascienza, ma di un esperimento concreto condotto da Jack Morris, ricercatore di Cornell e Meta, che ha forzato il modello open-source gpt-oss-20b di OpenAI a “pensare ad alta voce” per milioni di parole. Il risultato è un’analisi che non solo scardina alcune idee preconcette su cosa succeda dentro la “mente” di questi modelli, ma apre anche nuove strade per comprendere meglio l’addestramento, la memoria e la trasparenza di sistemi che stanno già cambiando il nostro modo di comunicare e lavorare.

Rivista.AI Academy GPT-5 prompting guide

La maggior parte degli utenti si limita a lanciarlo con comandi generici, come se chiedessero a una cassettiera di “darmi qualcosa di interessante”. Il risultato? Uscite casuali, incoerenti, o peggio: inutili. I veri esperti, quelli che trasformano GPT-5 da semplice chatbot a macchina da precisione, costruiscono il prompt in sei parti chirurgiche, ciascuna con un ruolo preciso e strategico. Immagina un’orchestra: ogni strumento deve suonare la sua nota nel momento giusto, altrimenti viene solo rumore.

Il primo passo, il “Role”, è un’iniezione d’identità. Se non dici a GPT-5 chi deve essere, rischi un’interpretazione alla cieca. Vuoi un copywriter, un consulente finanziario o un ingegnere? Devi esplicitarlo. Passare da “sei un’intelligenza artificiale” a “sei un analista di mercato con 30 anni di esperienza” cambia radicalmente l’output, trasformando il testo da generico a iper-specializzato. Non è una sottigliezza: è come chiedere a un barista di prepararti un cocktail senza specificare quale.

Quando il Presidente degli Stati Uniti decide di passare dal definire un CEO “altamente CONFLITTUALE” al celebrarlo come esempio di successo imprenditoriale in meno di una settimana, non è soltanto un cambio di tono. È un’operazione chirurgica di narrativa politica, un colpo di scena degno di un mercato finanziario che si nutre di volatilità emotiva. Intel si è ritrovata improvvisamente al centro di un balletto strategico in cui le accuse di conflitti d’interesse legati alla Cina si sono dissolte davanti a una stretta di mano alla Casa Bianca. Chi conosce il mondo dei semiconduttori USA sa che dietro queste conversioni improvvise raramente si nasconde un’epifania personale. Piuttosto, c’è un calcolo freddo, un allineamento di interessi che diventa immediatamente leggibile per chi sa leggere tra le righe.

Elon Musk minaccia di portare apple in tribunale per presunte violazioni antitrust, e lo fa con la sicurezza di chi ha già trasformato le conferenze stampa in show e le cause legali in parte integrante della propria strategia di marketing. Il bersaglio non è un dettaglio marginale, ma il cuore del potere di Cupertino: l’App Store e la sua capacità di decidere chi sale e chi resta giù nella scala della visibilità digitale.

La scintilla nasce da un’accusa precisa: Apple avrebbe creato un sistema di classifiche e sezioni curate che spinge in modo sproporzionato le app di OpenAI, relegando la concorrenza, incluso Grok e la stessa piattaforma xAI di Musk, a posizioni di secondo piano. Mentre ChatGPT troneggia al primo posto tra le app gratuite negli Stati Uniti, Grok si trova quinto, e soprattutto fuori dalla sezione “Must-Have Apps”, un’area vetrina che può determinare milioni di download in pochi giorni. Non è un caso che Musk definisca questa dinamica “una violazione antitrust inequivocabile”.

Trump non ha mai amato le mezze misure, ma questa volta sembra averne inventata una. L’idea di permettere a Nvidia di vendere alla Cina una versione depotenziata del chip AI Blackwell suona come un cocktail di calcolo politico, fiuto per l’affare e volontà di riscrivere le regole della diplomazia tecnologica. Un compromesso al 30-50 per cento della potenza originale, come se un’auto di lusso venisse consegnata con il limitatore inserito. La motivazione ufficiale? Gestire il rischio tecnologico e la sicurezza nazionale. La realtà, come sempre, è più torbida.

Questo non è un semplice annuncio industriale. È un’operazione chirurgica dentro la supply chain globale dell’intelligenza artificiale, con Washington che improvvisamente si atteggia a broker delle performance dei chip. La Cina vuole capacità computazionale, e non da oggi. Gli Stati Uniti vogliono risorse strategiche e vantaggi commerciali. E nel mezzo c’è Jensen Huang, CEO di Nvidia, costretto a un balletto diplomatico in cui ogni passo costa miliardi e ogni sorriso può valere una licenza di esportazione. Il paradosso è che la Casa Bianca non sta bloccando del tutto l’export, ma lo sta monetizzando.

Anthropic ha appena fatto un passo strategico in quella che ormai è una guerra di logoramento tra giganti dell’IA, introducendo la sua funzione di memoria per Claude con il tono da promessa salvifica: “mai più perdere il filo del lavoro”. La demo su YouTube è studiata al millimetro per colpire l’utente professionale che teme più di ogni altra cosa di riaprire una chat e dover ricominciare da zero. Invece di una memoria onnipresente alla ChatGPT, qui c’è un approccio “on demand”: il bot non ti profila, non ti spia, semplicemente recupera quello che gli chiedi. La differenza è sottile ma cruciale, ed è già destinata a essere oggetto di interpretazioni creative in sede legale e di marketing.

Microsoft fa saltare il banco e sposta GitHub dentro il suo team CoreAI, cancellando di fatto la figura del CEO di GitHub dopo l’uscita di Thomas Dohmke. Un cambio epocale, più profondo di quel che sembra, perché da azienda indipendente dentro l’impero di Redmond, GitHub diventa ora un pezzo di Microsoft tout court. Dopo quasi quattro anni da CEO, Dohmke lascia per tornare a fare quello che gli piace davvero: fondare startup. Niente di male, certo, ma il tempismo è perfetto per un reboot della governance e, soprattutto, della strategia.

Non ci sarà un nuovo CEO, né una nuova squadra a dirigere GitHub in modo separato. Il messaggio è chiaro: l’era dell’autonomia di GitHub è finita. Ora il motore pulsante sarà CoreAI, la nuova macchina da guerra di Microsoft dedicata all’intelligenza artificiale, guidata dall’ex top manager di Meta, Jay Parikh. L’obiettivo è ambizioso e un po’ spaventoso: trasformare Microsoft in una “agent factory”, un’officina di intelligenze artificiali capaci di rivoluzionare il modo in cui il software viene creato, gestito e potenziato. Il futuro è sempre meno codice scritto a mano e sempre più codice generato da macchine intelligenti. Se vi sembra fantascienza, ricordate che Bill Gates pensava a Microsoft come a un esercito di sviluppatori software; Parikh vuole ora un esercito di agenti AI.

“Before, I Asked My Mom, Now I Ask ChatGPT”:

Visual Privacy Management with Generative AI for Blind and

Low-Vision People

L’idea che l’intelligenza artificiale generativa possa diventare un alleato insostituibile per chi vive con una disabilità visiva è una rivoluzione sottotraccia, più potente di quanto si pensi. Non si tratta semplicemente di sostituire un assistente umano con una macchina. Qui la posta in gioco è molto più alta: parliamo di autonomia, di riservatezza e di dignità, quei concetti che si sgretolano facilmente quando devi dipendere da qualcun altro anche per i dettagli più intimi. I dispositivi come ChatGPT, Be My AI e Seeing AI non solo facilitano la vita delle persone cieche o ipovedenti (BLV), ma rimodellano la relazione tra individuo e tecnologia, portandola su un piano in cui la privacy non è un lusso ma un requisito imprescindibile.

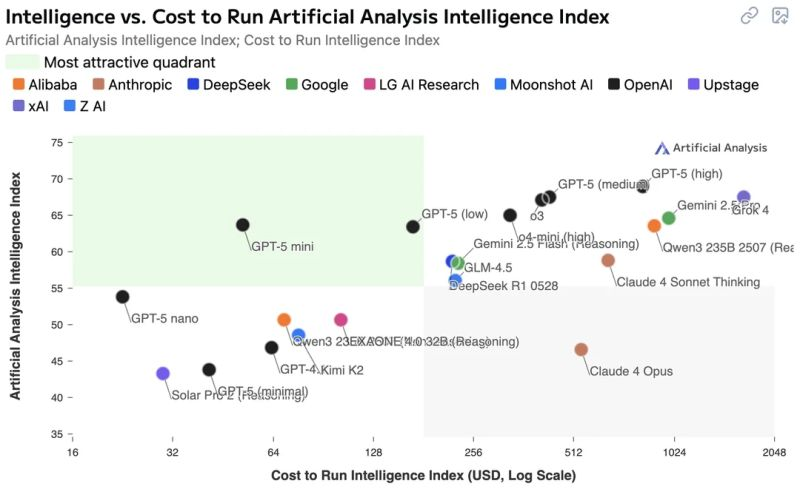

Il ranking dei modelli di intelligenza artificiale più recenti ha fatto saltare più di qualche certezza. Non è un caso se la classifica “intelligenza per euro” riserva sorprese, e qualche delusione, per chi si aspettava che il più caro fosse il migliore in tutto. La chiave per capire questo nuovo panorama è smettere di guardare solo il “peso del cervello” (cioè il punteggio IQ) e iniziare a considerare seriamente il rapporto costo-intelligenza, una metrica che il mercato sta finalmente facendo propria. Se pensavi che GPT-5 High fosse l’ultima parola, beh, preparati a rivedere i tuoi giudizi.