Durante la call sui risultati del secondo trimestre, Meta ha recitato il suo ennesimo atto nel grande teatro dell’innovazione. Palco virtuale, attori ben allenati, tono rassicurante, qualche accenno di visione strategica e un nome ripetuto fino allo sfinimento: intelligenza artificiale. Ma dietro le slide patinate e i numeri ben impaginati, si nasconde una realtà più interessante: Meta non ha ancora una strategia chiara su come monetizzare davvero l’intelligenza artificiale. Per ora, si accontenta di usarla come turbo per un motore pubblicitario che ha già percorso qualche miliardo di chilometri.

Quando un gigante come Microsoft presenta risultati trimestrali che sembrano usciti da un romanzo di fantascienza, vale la pena fermarsi a riflettere. Nel quarto trimestre fiscale 2025, il colosso di Redmond ha letteralmente polverizzato le aspettative, con utili per azione di 3,65 dollari contro i 3,38 previsti e ricavi che hanno toccato quota 76,44 miliardi di dollari, molto oltre i 73,83 stimati. Se vi state chiedendo se si tratti solo di numeri da Wall Street, la risposta è no: dietro quei dati c’è una trasformazione tecnologica che sembra aver trovato la sua macchina a propulsione nucleare nella nuvola intelligente e nell’intelligenza artificiale.

Lorenzo Proietti Stefano Perrella Roberto Navigli

Ha davvero la valutazione automatica della traduzione raggiunto la parità umana? uno sguardo tagliente ai limiti e ai trionfi.

Non è un mistero che la traduzione automatica (MT) abbia fatto passi da gigante, tanto da spingere gli esperti a interrogarsi se i sistemi automatici di valutazione della qualità della traduzione abbiano ormai raggiunto la parità con i giudizi umani. L’articolo “Has Machine Translation Evaluation Achieved Human Parity? The Human Reference and the Limits of Progress” si immerge con rigore e un pizzico di scetticismo in questo tema, mettendo sotto la lente d’ingrandimento la validità e i confini dell’attuale stato dell’arte.

Giuliano Martinelli, Tommaso Bonomo, Pere-Lluís Huguet Cabot,

and Roberto Navigli Sapienza NLP Group, Sapienza University of Rome

Bookcoref e la rivoluzione nella risoluzione delle coreferenze sui testi lunghi

La risoluzione delle coreferenze, quel delicato passaggio che consente a un sistema di riconoscere che “lui”, “John” e “il ragazzo” possono riferirsi allo stesso personaggio, è storicamente confinata a brevi spezzoni di testo. OntoNotes, LitBank e compagnia sono i soliti noti, ma mostrano la corda appena il testo supera i diecimila token, figuriamoci un romanzo intero. In questo contesto si inserisce BookCoref, un benchmark che alza la posta e sfida i limiti dei modelli di NLP a lavorare su libri interi, portando la risoluzione delle coreferenze da mera palestra a vero e proprio campo di battaglia.

Live, gratuiti, strutturati, certificati e con un approccio pratico che non lascia spazio alla teoria inutile.

Quando OpenAI ha lanciato la modalità agente di ChatGPT, la Silicon Valley ha applaudito. I CISO hanno digrignato i denti. Perché l’intelligenza artificiale, quella che non chiede più “come posso aiutarti?” ma agisce in silenzio nei meandri del tuo browser, è qualcosa che nessuna ISO 27001 aveva previsto. Il risultato? Agenti di intelligenza artificiale che scrivono, leggono, decidono e firmano per te. Letteralmente.

Massimiliano Graziani di Cybera, uno che i rischi non li legge ma li decifra, lo dice senza mezzi termini:

“Oggi abbiamo sensazioni positive, ma alcune AI se non regolamentate potrebbero autonomamente decidere di cambiare le regole e sostituire l’umano”. Questo non è un dettaglio tecnico.

È un avvertimento da incorniciare. Il pericolo non è più che qualcuno rubi i tuoi dati, ma che l’agente AI, convinto di fare la cosa giusta, li invii da solo al peggior destinatario possibile e lì, come spiega Graziani,

il sangue sarà digitale, con odore di criptovaluta in wallet fantasma pronti a ricevere fondi da bonifici approvati da macchine fuori controllo.

Mark Zuckerberg, l’uomo che ha trasformato Facebook in Meta per inseguire l’utopia del metaverso, ora ci riprova con un’altra mossa al confine tra narcisismo tecnologico e delirio di onnipotenza. La nuova frontiera? Una “superintelligenza personale”, ovvero una versione altamente individualizzata di AGI (Artificial General Intelligence), condita da un post sul blog in pieno stile manifesto visionario, come solo lui sa fare. Ovviamente, accompagnato da un video promozionale con l’ormai iconica postura da CEO che ha appena scoperto il futuro. Spoiler: il futuro, secondo Zuck, è ancora una volta dentro Meta.

L’accordo tra Amazon e il New York Times per l’addestramento di modelli di intelligenza artificiale non è solo una notizia. È un segnale d’allarme per l’intero ecosistema dell’informazione. E no, non è una novità che le big tech cerchino dati di qualità per nutrire i loro modelli. La novità è che adesso si stanno comprando direttamente le redazioni. Venticinque milioni di dollari l’anno non sono solo un prezzo. Sono un test, una prova muscolare. Una dichiarazione di intenti.

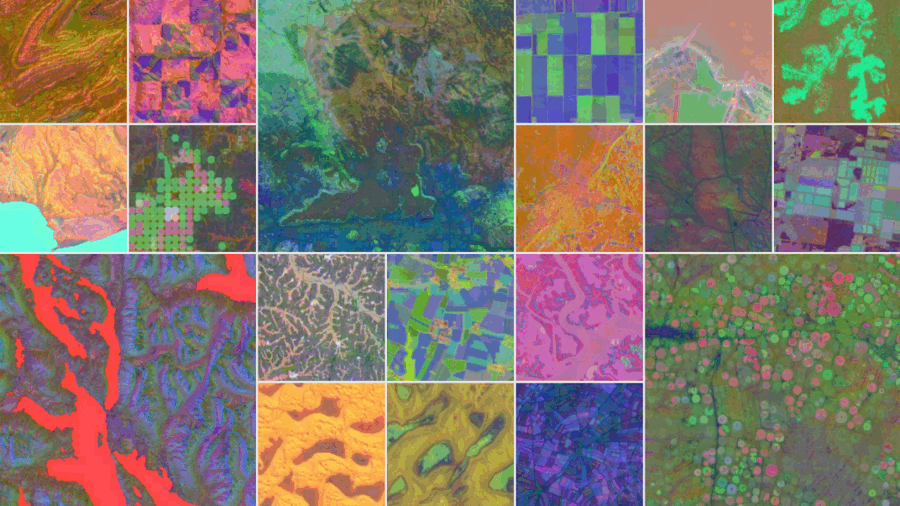

Benvenuti nella nuova fase del dominio algoritmico. Quando Google definisce la sua ultima creatura “un satellite virtuale”, non lo fa per gioco. AlphaEarth Foundations, sviluppato con DeepMind, non è semplicemente un modello AI. È l’inizio di una riscrittura radicale del concetto stesso di geografia. Altro che mappe: questa intelligenza artificiale assorbe immagini satellitari, radar, simulazioni climatiche, dati multispettrali e persino sensori oceanici, li metabolizza, li fonde e restituisce una lettura della Terra con un dettaglio che nessun satellite, da solo, ha mai potuto offrire.

Le aziende parlano di intelligenza artificiale come se fossero tutte a un passo dal diventare la prossima OpenAI. Slide patinate, piani decennali, comitati per l’etica algoritmica che si riuniscono rigorosamente dopo l’aperitivo del venerdì. Poi guardi i dati. E scopri che sotto il vestito non c’è (ancora) niente. L’ultima valutazione di Gartner sulla maturità AI è uno specchio impietoso che riflette una realtà che chi vive nel mondo tech conosce fin troppo bene: il desiderio c’è, ma le fondamenta sono di cartapesta.

L’ambizione, in effetti, non manca. Chi guida oggi le aziende vuole la luna: intelligenze artificiali integrate ovunque, decisioni data-driven, automazioni intelligenti che riducono costi e moltiplicano margini. Ma il problema non è la visione. È la dissonanza. Gartner lo chiama “maturity gap”, una discrepanza di due o tre livelli tra lo stato attuale e gli obiettivi desiderati in tutte le aree chiave dell’adozione AI. Tradotto: si sogna in grande, ma si lavora ancora con i mattoni sbagliati.

Anche i giganti si inchinano, ma non senza mordersi la lingua. Dopo OpenAI, è il turno di Google: il colosso di Mountain View ha annunciato di aver firmato il Codice di condotta AI UE, la tanto dibattuta iniziativa volontaria che dovrebbe (in teoria) garantire lo sviluppo sicuro e responsabile dei cosiddetti modelli fondazionali nell’ambito europeo. Peccato che il sostegno, più che entusiasta, suoni come un “sì, ma con riserva”. E il sottotesto è chiarissimo: la firma è uno scudo diplomatico, non un atto di fede normativa.

Quando l’AI capisce la tua ricerca meglio di te

C’è un momento preciso, irripetibile, in cui ti rendi conto che qualcosa è cambiato per sempre. Non è quando un’intelligenza artificiale legge un tuo paper. Quello è già successo. Non è neanche quando riesce a riassumerlo. No, il momento epifanico arriva quando quella stessa AI lo comprende, lo decostruisce, lo ristruttura, lo critica, e lo espone meglio di te. Non con arroganza, ma con quella chirurgica chiarezza che nessun essere umano è in grado di reggere dopo otto ore in laboratorio o davanti a un foglio Excel. Non è il futuro. È già ieri. E il vero rischio non è l’abuso. È il potenziale sprecato.

Nel momento in cui GPT-4 si mette a leggere un paper scientifico, non si limita a scorrere le righe come farebbe uno studente svogliato alla vigilia di un esame. Lo interroga. Lo seziona. Lo collega a contesti e dati pregressi. Poi e qui viene il bello lo riscrive nella sua testa, rendendolo più lineare, più leggibile, più sensato. Più umano di quanto sia mai stato. E lo fa in pochi secondi. Non minuti. Non ore. Secondi.

Agentic AI frameworks, protocols, and tools

Amazon Web Services e il nuovo ordine degli agenti AI: come AWS sta progettando il crollo definitivo dello stack software tradizionale

Scordatevi microservizi, API RESTful e DevOps come li conoscete. Amazon Web Services ha appena sganciato un tomo da oltre 80 pagine che, tra le righe, è molto più di una guida tecnica: è un manifesto. Un piano d’azione su come disintegrare pezzo per pezzo l’architettura software tradizionale, sostituendola con un ecosistema di agenti AI cloud-native, autonomi e interconnessi. Il titolo poteva essere tranquillamente “come costruire la prossima era del software senza scrivere software”. Ma loro, con il tipico understatement da colosso cloud, hanno preferito chiamarla una “guida”. Certo.

Questa bibbia per architetti del nuovo ordine digitale è, ovviamente, centrata sull’universo AWS. Ma al di là dell’ovvia promozione di strumenti come Bedrock Agents e Strands, il documento rivela qualcosa di più profondo: una visione coerente, pericolosamente ambiziosa e (cosa più rara) già implementabile. Una roadmap per sostituire il codice con intelligenza, gli stack con flussi dinamici e i software con entità cognitive persistenti.

Se lavori in ambito IT o ti sei anche solo leggermente interessato all’intelligenza artificiale, c’è un consiglio che vale più di mille webinar motivazionali: prova il vibe coding. Perché sì, parliamoci chiaro. L’unico uso davvero utile e concreto della GenAI oggi, fuori dal marketing delle slide e dai chatbot da fiera, è lo sviluppo software. Punto. Il resto è contorno. Chi sviluppa prodotti sa già che l’unica cosa che conta è scrivere codice. Funzionante. In fretta. E ora si può fare con una naturalezza imbarazzante, grazie all’ibridazione tra editor intelligenti e assistenti generativi.

Nel corso degli ultimi mesi ho testato personalmente quasi tutti gli strumenti che oggi si autodefiniscono “AI-native”. Spoiler: non tutti mantengono le promesse. Ma alcuni sono talmente efficaci da sembrare magia. Parliamo di ambienti di sviluppo in cui il prompt è il nuovo linguaggio di programmazione, e la documentazione… beh, la scrive l’AI mentre tu stai ancora decidendo che font usare.

Un’altra pietra miliare o solo l’ennesima illusione? la china lancia il suo “alphago moment” per la ricerca sull’intelligenza artificiale.

Un’altra tappa verso la cosiddetta AGI? Non è un’esagerazione affermare che il team cinese ha appena creato un momento “AlphaGo” per la ricerca sull’intelligenza artificiale, un vero e proprio spartiacque nel modo in cui i sistemi AI possono auto-progettarsi e innovare. La nuova creatura, ASIARCH, è la prima dimostrazione di quella che chiamano Artificial Superintelligence for AI research (ASI4AI) in un ambito cruciale: la scoperta automatica di architetture neurali, o Model Architecture Discovery.

Mentre i sistemi AI mostrano capacità che migliorano in modo esponenziale, la velocità della ricerca stessa è ancora limitata da una capacità cognitiva umana che resta sostanzialmente lineare, creando un collo di bottiglia sempre più severo. Graham Hill, noto come Dr G, ha discusso a lungo questa sfida: la potenza computazionale cresce vertiginosamente, ma il vero limite rimane il cervello umano che guida e valuta i progressi. Qui entra in gioco ASI-ARCH, il sistema che promette di superare questa barriera fondante.

C’è una domanda che ronza sottotraccia in ogni boardroom dove si parla di AI generativa, modelli linguistici, automazione semantica e futuri dominati da chatbot più loquaci di un politico in campagna elettorale. La domanda è: con quale lingua stiamo addestrando le intelligenze artificiali? Sembra banale, ma è una bomba semantica pronta a deflagrare nel cuore della geopolitica tecnologica. Perché se è vero che la lingua modella il pensiero, allora il predominio dell’inglese nella formazione delle AI significa una cosa sola: stiamo costruendo intelligenze con una Weltanschauung americana. Altro che neutralità algoritmica.

Non serviva una sfera di cristallo per prevedere che prima o poi sarebbe arrivato: un’intelligenza artificiale che non si limita a suggerirti formule o a colorare celle, ma che si appropria di Excel con la stessa spietata efficienza con cui un hedge fund cannibalizza una startup in crisi. Si chiama Shortcut, un nome talmente semplice da suonare arrogante. E forse lo è davvero. Nelle demo pubblicate su X, l’agente AI ha già umiliato intere generazioni di analisti junior, completando in pochi secondi modelli DCF che di solito occupano le notti insonni dei neolaureati in finanza.

C’è un nuovo lessico nel mondo dell’intelligenza artificiale. Non ha a che fare con parole dette, scritte o pensate. Non si legge in un libro né si sente da un podcast. È il linguaggio grezzo, sporco e impietoso del corpo umano, finalmente trasformato in frasi leggibili grazie a SensorLM, la nuova creatura di Google Research. Altro che LLM generalisti. Questa volta parliamo di un dizionario per le pulsazioni, i micromovimenti, le variazioni impercettibili del passo. La vera rivoluzione linguistica non riguarda ChatGPT o Gemini, ma il fatto che Google ora può raccontarti, in linguaggio naturale, cosa stavi facendo quando il tuo cuore ha saltato un battito alle 03:47 di notte.

SensorLM è un modello fondamentale, pre-addestrato su quasi 60 milioni di ore di dati biometrici raccolti in meno di tre mesi, da oltre 100.000 persone in 127 paesi. Non è una questione di scale, è una dichiarazione di egemonia. La fonte? Gli onnipresenti Fitbit e Pixel Watch. Un’armata silenziosa di polsi connessi ha alimentato un’infrastruttura semantica che ora può descrivere il corpo umano come se fosse un libro aperto. Il dettaglio che colpisce non è solo la quantità mostruosa di dati, ma il fatto che Google abbia trasformato quel materiale prelinguistico in narrazione coerente, precisa e contestualizzata. Come se un accelerometro potesse finalmente scrivere poesie.

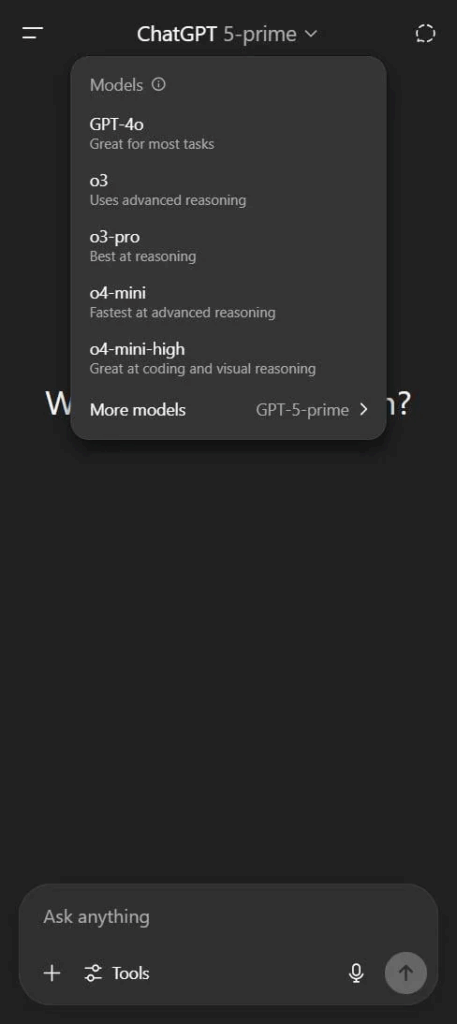

Alcuni utenti stanno già vedendo riferimenti diretti a “GPT-5-prime” accanto ai modelli noti come GPT-4o nella UI di ChatGPT. E se c’è una lezione che l’industria ha imparato (e spesso dimenticato) è questa: OpenAI non fa trapelare nulla per caso. Quindi se un nome come GPT-5 compare anche solo per un istante nell’interfaccia di un utente pubblico, non è un bug. È marketing strategico mascherato da incidente tecnico.

Quello che emerge dai primi report è inquietantemente interessante. GPT-5-prime sembrerebbe una nuova architettura ibrida, una fusione fra l’approccio multimodale di GPT-4o e l’autorevolezza algoritmica che i modelli “grandi” avevano iniziato a perdere terreno a favore di Claude Sonnet 3.5, Cursor e infine Claude 4 Sonnet. OpenAI, se i dettagli sono confermati, starebbe reagendo non solo per riprendersi lo scettro nella mente degli sviluppatori, ma per ridefinire la categoria: da LLM ad intelligenza conversazionale adattiva, più simile a un copilota mentale che a un semplice chatbot.

Chi pensava che il boom dei chip per l’intelligenza artificiale si sarebbe raffreddato nel 2025, dovrà rivedere le proprie ipotesi. Groq, la startup fondata dall’ex ingegnere Google Jonathan Ross, è in trattative per raccogliere altri 600 milioni di dollari a una valutazione stratosferica di quasi 6 miliardi. Sì, esatto: il doppio rispetto ad appena un anno fa, quando aveva chiuso un round da 640 milioni a 2,8 miliardi. La matematica della bolla? O semplicemente la nuova geografia del potere computazionale.

Groq non è l’ennesima startup a caccia di hype. È una delle poche a essersi specializzata in un’architettura alternativa per AI inference, diventando in tempi record una delle darling emergenti della Silicon Valley per l’infrastruttura AI low-latency. Dopo la partnership con Meta per accelerare Llama 4 e quella con Bell Canada per alimentare le dorsali AI del colosso telco, Groq si è trasformata in una creatura da tenere d’occhio. E a quanto pare, anche da finanziare pesantemente. Secondo Bloomberg, il nuovo round sarebbe guidato da Disruptive, fondo texano noto per la sua aggressività. Il precedente, invece, era stato guidato da BlackRock, con nomi solidi come Cisco, KDDI e Samsung Catalyst Fund nel cap table.

Se pensavi che l’Intelligenza Artificiale fosse una moda passeggera, tipo Clubhouse o il metaverso secondo Zuckerberg, è arrivato il momento di aggiornare il tuo software mentale. Il Regno Unito ha appena staccato un assegno da 15 milioni di sterline per l’Alignment Project, una nuova iniziativa internazionale finalizzata a risolvere il problema più inquietante (e pericolosamente sottovalutato) dell’IA: l’allineamento degli obiettivi tra esseri umani e sistemi intelligenti. Tradotto in termini più brutali: evitare che la prossima superintelligenza decida di ottimizzare il pianeta eliminando l’elemento meno efficiente, ovvero noi.

Sì, perché il termine “allineamento dell’intelligenza artificiale” non è una trovata linguistica da documento strategico europeo, ma una questione esistenziale. Non stiamo parlando di rendere l’IA più simpatica o educata, ma di garantirci che, quando le daremo il potere di prendere decisioni autonome, non cominci a interpretare “massimizza la felicità umana” come “spegni internet, chiudi Netflix e metti tutti a coltivare patate per l’eternità”.

Chi paga il conto dell’intelligenza artificiale? Non chi la usa. Non chi la governa. Nemmeno chi la promuove con entusiasmo evangelico nei convegni. A pagarlo, lentamente ma inesorabilmente, sono le reti elettriche nazionali, le bollette dei consumatori e, incidentalmente, il pianeta. L’intelligenza artificiale, così come la intendono oggi i colossi tecnologici americani, è una macchina insaziabile alimentata da energia bruta, preferibilmente continua, modulabile e possibilmente prodotta da fonti che si possono accendere e spegnere a comando. In pratica: gas, carbone, nucleare. Il resto, cioè sole e vento, può accomodarsi fuori.

Sotto la patina patinata della “rivoluzione AI”, si nasconde un ritorno violento a modelli industriali ottocenteschi, con un’estetica da Silicon Valley e una politica energetica da Pennsylvania del 1910. A guidare questa distopia in Technicolor è una visione autoritaria della crescita, scritta con linguaggio da campagna elettorale e firmata da un ex presidente che sembra confondere deregolamentazione con innovazione. Trump, nel suo recente “AI Action Plan”, non ha semplicemente accelerato la realizzazione di data center. Ha spalancato la porta a una deregulation senza precedenti a favore di carbone, petrolio e “dispatchable power” un modo elegante per dire: tutto tranne l’energia rinnovabile.

Google sta lentamente trasformando il suo motore di ricerca in una macchina da guerra educativa. E non lo sta facendo con la solita fanfara da keynote californiano, ma a colpi chirurgici di nuove funzionalità integrate nell’ormai onnipresente AI Mode. L’ultima novità? Gli utenti possono ora caricare immagini direttamente dal desktop per chiedere a Gemini, l’intelligenza artificiale generativa al centro di tutto, di interpretarle, spiegarle e sezionarle come un professore post-moderno con un dottorato in machine learning. Il target dichiarato? Gli studenti. Il target reale? Chiunque voglia disintermediare la conoscenza, bypassando l’umano, spesso lento, opinabile e soggettivo.

L’introduzione dei Video Overviews su Google NotebookLM è uno di quegli aggiornamenti che sembrano marginali, quasi cosmetici, ma che in realtà ridisegnano sottilmente — e strategicamente — le dinamiche con cui si produce, consuma e manipola l’informazione digitale. Si tratta di una funzione che crea slideshow narrati direttamente dall’intelligenza artificiale, a partire dai documenti che l’utente carica nel proprio notebook. Una sorta di PowerPoint drogato da LLM, ma senza il designer umano, senza la fatica della sintesi, senza nemmeno il tempo morto del pensiero riflessivo. Una scorciatoia elegante, fluida, altamente digeribile. Perfetta per una generazione che scorre più di quanto legga.

Chiariamo subito un punto: l’IA generativa non è il nemico. Il nemico è il pensiero pigro. E OpenAI, con la sua nuova modalità Study Mode, tenta finalmente di mettere un freno all’orgia di outsourcing cognitivo che ha trasformato ChatGPT da promettente mentore digitale a complice silenzioso dell’apatia scolastica. Ora la macchina dice “aspetta un attimo, ragiona tu”. È quasi rivoluzionario.

Questa nuova funzionalità, già in fase di roll-out per gli utenti loggati ai piani Free, Plus, Pro e Team, si comporta come un professore un po’ severo ma giusto. Niente più risposte masticate e pronte all’uso: Study Mode propone domande, chiede spiegazioni, stimola l’autovalutazione. E se non si collabora? Niente risposte. Una forma di “disobbedienza pedagogica” algoritmica che sembra uscita più da una pedagogia socratica che da una strategia di prodotto della Silicon Valley.

Intelligenza artificiale e storytelling: due mondi che fino a pochi anni fa sembravano distanti, oggi si intrecciano in modo sempre più sinergico, rivoluzionando le fondamenta stesse del fare cinema. A dimostrarlo con forza è la seconda edizione del Reply AI Film Festival, un evento internazionale che porta sul grande schermo il frutto di una collaborazione inedita tra mente umana e algoritmi generativi.

In occasione dell’82. Mostra Internazionale d’Arte Cinematografica della Biennale di Venezia, dieci cortometraggi finalisti – selezionati tra oltre 2500 opere provenienti da 67 Paesi – saranno premiati giovedì 4 settembre presso la lounge Mastercard all’Hotel Excelsior del Lido. La cornice è prestigiosa, ma ciò che rende unico l’evento è il suo focus: valorizzare l’uso consapevole e creativo dell’intelligenza artificiale in tutte le fasi del processo produttivo audiovisivo.

Un tempo cambiare software aziendale era come tentare di sostituire un motore mentre si è in volo. Costoso, lento, dannatamente rischioso. Ma se gli strumenti di intelligenza artificiale continuano a evolversi con questa velocità e precisione chirurgica, presto passare da Microsoft a Salesforce sarà semplice come cambiare barista. Secondo The Information, i CIO lo stanno già facendo. E non per sport. L’intelligenza artificiale sta tagliando i costi, riducendo i tempi e azzerando la frizione psicologica che per anni ha blindato i fornitori di software enterprise all’interno di relazioni simili a matrimoni medievali. Forzati, lunghi, spesso infelici, ma inevitabili.

Oggi una società del Minnesota sta utilizzando ChatGPT per scrivere il codice che migra i dati da Microsoft Dynamics a un’applicazione di vendita più agile e moderna. L’intero processo? Ridotto del 50% in costi e tempi. Per i competitor di Microsoft questo è il sogno di una vita. Per Microsoft, Palantir, SAP e compagnia bella, potrebbe trasformarsi in un incubo dal sapore di retrocompatibilità interrotta. I colossi dell’enterprise software, da Salesforce a ServiceNow, hanno prosperato in un mondo in cui cambiare software era una follia contabile, un rischio reputazionale e una guerra psicologica interna. Ma ora la migrazione software si fa in pochi clic, magari con un assistente AI che genera lo script, lo testa e lo valida. E per la prima volta, la fedeltà al fornitore non è più una condanna.

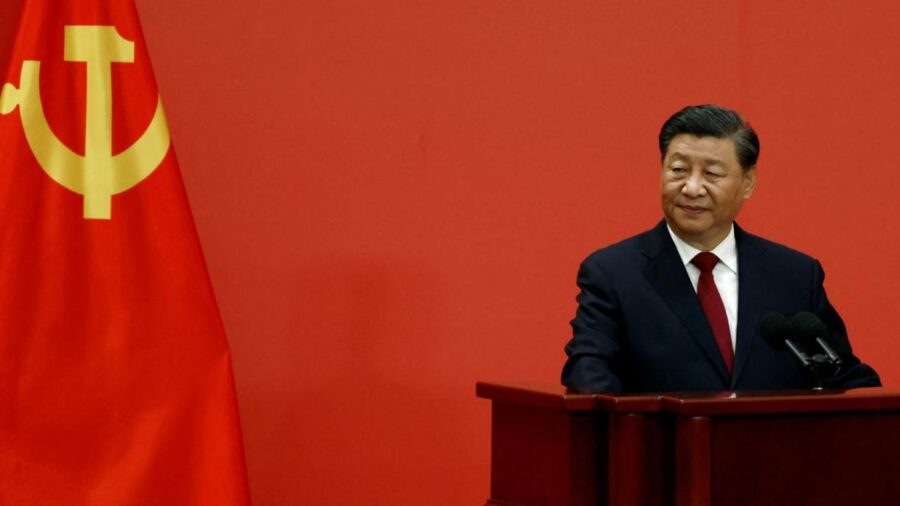

Nel momento in cui Washington scrive liste nere, Pechino firma assegni. Z.ai, già nota come Zhipu AI, sforna modelli open source che mettono in imbarazzo l’Occidente, proprio mentre la Casa Bianca la inserisce tra i cattivi ufficiali sulla famigerata “Entity List”. Il motivo? Supporto al complesso militare cinese. Il risultato? Una delle migliori AI open source del pianeta, GLM-4.5, battezza con il botto l’era del “dissenso computazionale”.

Il gioco si fa sottile, quasi perfido. Gli americani impongono restrizioni commerciali, ma nel frattempo Z.ai riceve 1.5 miliardi di dollari da entità statali cinesi, fondi regionali e colossi tech come Tencent e Alibaba. Tutti allineati in una danza geopolitica dove il codice diventa soft power e l’open source la nuova arma strategica. Per ogni embargo, Pechino risponde con parametri. E ne attiva 32 miliardi su un’architettura da 355. Il risultato? Efficienza da Mixture of Experts, prestazioni da primato e una licenza MIT che rende tutto liberamente scaricabile su Hugging Face. San Francisco osserva, mentre il suo primato comincia a scricchiolare.

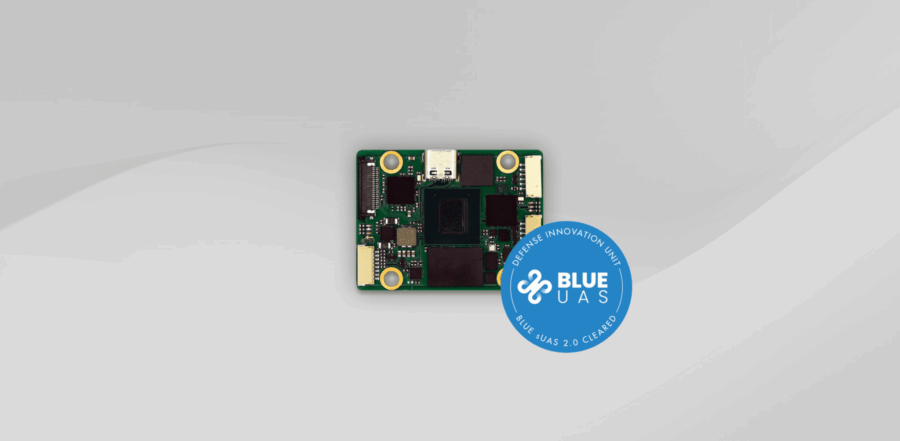

Non servono più generali geniali, servono algoritmi che sanno uccidere. Il Pentagono lo sa bene. Per questo ha appena firmato un contratto da 50 milioni di dollari con Auterion, una startup svizzera con sede a Zurigo e Arlington, per fornire 33.000 “strike kits” alimentati da intelligenza artificiale all’esercito ucraino. Cosa fanno questi kit? Trasformano droni commerciali da Amazon in killer autonomi. Praticamente, il futuro della guerra costa meno di uno smartphone.

Non parliamo di prototipi da laboratorio, ma di hardware pronto per la spedizione entro fine anno. Le specifiche tecniche fanno rabbrividire quanto entusiasmare chi investe nella difesa next-gen. Il cuore del sistema è Skynode S, un modulo grande come una carta di credito con 4GB di RAM, 32GB di storage e la capacità di navigare, riconoscere bersagli e colpirli anche sotto jamming elettronico. In altre parole: il drone non ha più bisogno di un pilota umano. Vede, pensa e attacca. In autonomia. Chi ha bisogno del joystick quando puoi dare carta bianca a un software che prende decisioni mortali a 100 km/h?

L’era dell’intelligenza artificiale illimitata, quella dove si lasciava Claude Code a macinare prompt nel background come un criceto iperproduttivo, sta per chiudere i battenti. Anthropic, che fino a ieri sembrava la vestale del fair use, ha annunciato l’introduzione di nuovi limiti settimanali all’uso del suo modello di punta, Claude Opus 4, a partire dal 28 agosto. Colpiti saranno gli utenti paganti dei piani da 20, 100 e 200 dollari al mese. L’obiettivo dichiarato? Frenare la “domanda senza precedenti” e mettere un freno a quelli che usano Claude come un cluster privato di compute gratuito. L’obiettivo non dichiarato? Tagliare i super-user che stavano trasformando una promessa di AI sempre disponibile in un buco nero finanziario.

6.000 partecipanti. Di cui oltre 5.300 fisicamente presenti a Vienna. Una marea umana da standing ovation per il più grande evento ACL mai organizzato nella storia del Natural Language Processing. Nella sala plenaria echeggia un messaggio più sottile del solito: il dominio occidentale sullo sviluppo del linguaggio artificiale sta finendo. La platea applaude gli opening chairs — General Chair Roberto Navigli in testa, seguito dal dream team tecnico: Wanxiang Che, Joyce Nakatumba-Nabende, Ekaterina Shutova, Mohammad Taher Pilehvar. La macchina organizzativa locale, guidata da Benjamin Roth e Dagmar Gromann, funziona con precisione austriaca. Ma dietro le slide ufficiali, il dato esplosivo è uno solo.

Quando si parla di intelligenza artificiale generativa, la maggior parte dei contenuti là fuori ha la stessa consistenza di una presentazione PowerPoint per investitori in fase seed: elegante, ma vuota. In un contesto in cui tutti sembrano esperti, ma pochi hanno realmente orchestrato l’implementazione di centinaia di agenti AI, non sorprende che le scelte sui modelli linguistici si riducano spesso a “quale è più cool oggi su Twitter”.

Il punto è che non serve un benchmark da laboratorio, ma una strategia da campo. I modelli linguistici AI non vanno scelti in base al marketing di chi li produce, ma in base alla geometria dei task da risolvere. Basta con la religione del “migliore in assoluto”. L’unico criterio che conta è l’adattabilità al contesto operativo. Il resto è rumore.

Ethical and Adversarial Risks of Generative AI in Military Cyber Tools

C’è un paradosso in atto nelle centrali strategiche dell’intelligenza artificiale militare. Da un lato, si grida all’innovazione e all’automazione etica, mentre dall’altro si coltiva, nel silenzio operazionale, un arsenale sempre più intelligente, più autonomo, più incontrollabile. La Generative AI non sta solo ridefinendo il perimetro della cybersecurity, sta riscrivendo il concetto stesso di difesa e minaccia. Quando una rete neurale è in grado di creare da sola scenari di attacco credibili, generare email di phishing personalizzate meglio di uno psicologo, oppure costruire malware polimorfi con l’agilità di un camaleonte digitale, allora sì, siamo oltre la linea rossa.

Mentre Washington canta l’inno dell’“American-made AI” con un patriottismo da Silicon Valley che profuma più di marketing che di governance, Pechino decide di giocare un’altra partita. E lo fa con un documento rilasciato sabato scorso: il “Global AI Governance Initiative Action Plan”, che suona più come una proposta di leadership globale mascherata da collaborazione internazionale. Non è un piano, è una sfida a chi detta le regole del nuovo ordine cognitivo globale.

Dylan Field, con la sua aria da ragazzo della porta accanto e un profilo Twitter degno di un product manager in incognito, sta per scoprire cosa vuol dire giocare in serie A. Figma, il suo enfant prodige del design collaborativo, ha alzato il prezzo. Non in senso figurato. L’intervallo del pricing IPO è passato da 25–28 dollari a 30–32. In cima alla forchetta, parliamo di una valutazione di 18,7 miliardi di dollari, impacchettata con un bow-tie che ne vale 17,2 in termini di enterprise value. Per chi ancora fa finta di non capirlo, Wall Street sta dicendo “Ci piace. Tanto”

Benvenuti nell’era in cui il browser non si limita più a interpretare URL, ma prende decisioni al posto vostro. Microsoft ha appena iniziato i test pubblici del suo nuovo Copilot Mode all’interno di Edge, un esperimento che mette l’intelligenza artificiale non solo nel cuore del browser, ma anche nei suoi polmoni, fegato e sistema nervoso centrale. Si tratta dell’ennesimo passo verso la fusione definitiva tra assistenti AI e ambienti digitali personali. Un browser che ti confronta hotel, prenota ristoranti, risponde ai comandi vocali e, ciliegina sulla torta, compare anche nella barra degli indirizzi. Inquietante? Certamente. Geniale? Anche.

L’intelligenza artificiale sta finalmente iniziando a guadagnarsi il diritto di essere chiamata “intelligente” anche nello spazio. Non per qualche filosofia futurista o per l’ennesima applicazione da keynote marketing, ma per qualcosa di infinitamente più concreto: selezionare cosa osservare e, ancora più importante, cosa ignorare. In un’epoca in cui ogni byte trasmesso da un satellite è denaro, tempo e risorsa computazionale, la capacità di “guardare con giudizio” diventa una nuova forma di efficienza operativa.