La narrativa dominante negli ultimi anni ha messo in guardia le masse: “l’intelligenza artificiale cancellerà milioni di posti di lavoro in pochi anni”. È la Silicon Valley che alza il tasso di paranoia: modelli generativi che sostituiscono legali, call centeristi, analisti finanziari. Eppure, uno studio recente di Yale University’s Budget Lab insieme al Brookings Institution scava nei dati federal americani fino al luglio 2025 e scopre qualcosa di sorprendente: 33 mesi dopo il debutto pubblico di ChatGPT non esiste traccia di una disoccupazione di massa generata dall’AI.

Categoria: Vision Pagina 1 di 6

L’intelligenza artificiale rendera’ al massimo quando i processi saranno sviluppati in funzione di essa e non viceversa

La narrativa contemporanea sull’intelligenza artificiale sembra uscita da un romanzo distopico: ogni conferenza, ogni paper sensazionale, ogni talk di guru tecnologico ci racconta di macchine che “potrebbero diventare coscienti”, come se i nostri assistenti vocali stessero tramando segretamente contro di noi. La realtà è molto più cinica e meno spettacolare: la pareidolia della coscienza artificiale è reale.

Pareidolia, termine coniato dai psicologi del XIX secolo, indica la tendenza del cervello umano a vedere pattern familiari in contesti ambigui: nuvole che diventano volti, ombre che evocano forme di animali. Applicata alla tecnologia, questa illusione ci fa attribuire intenzionalità, esperienze soggettive e perfino moralità a macchine che non hanno alcuna consapevolezza di sé. Daniel Dennett l’ha spiegato chiaramente: non è coscienza quello che vediamo nei pattern algoritmici, è un’illusione cognitiva.

Richard Sutton, recentemente insignito del Turing Award, ha scosso le fondamenta dell’intelligenza artificiale con una dichiarazione provocatoria: i modelli linguistici di grandi dimensioni (LLM) come ChatGPT sono una “strada senza uscita”. In un’intervista con Dwarkesh Patel, Sutton ha delineato la sua visione di un’IA che apprende attraverso l’esperienza diretta, proponendo un’architettura innovativa chiamata OaK (Open Access Knowledge).

Non potevo esimermi di farne un’articolo. Ha scandito la mia crescita, Peter Gabriel, la voce che ha attraversato decenni fondendo sperimentazione sonora, impegno sociale e innovazione tecnologica, ha da qualche anno iniziato ad “abbracciare” l’intelligenza artificiale come co-strumento di espressione. Il suo progetto “Fraternity in the Age of AI” (Fratellanza nell’era dell’AI con Paolo Benanti (Scientific Coordinator) e frmato anche da Giorgio Parisi, la collaborazione con Stability AI e il concorso #DiffuseTogether non sono operazioni di marketing, ma dichiarazioni filosofiche: l’AI è inevitabile, meglio nuotarci assieme che combatterla. In questo articolo esploro tutte le pieghe note (e qualche suggestione) del suo impegno, dal diritto d’autore al pensiero esistenziale, passando per una visione audace di convivenza creativa uomo-macchina.

Un video da non perdere !!! ARRIVATE ALLA FINE magari nel weekend

Mikhail Burtsev è il tipo di nome che suona bene in un convegno internazionale di ricerca AI. Porta con sé il fascino del ricercatore che promette di spingersi oltre le banali reti neurali che macinano dati, verso un’intelligenza artificiale che non si limita a rispondere ma che pensa davvero.

O almeno così dice. Perché il confine tra visione scientifica e marketing personale, in questo campo, è sottile come la carta su cui vengono stampati i grant di ricerca.Burtsev oggi è Arnold & Landau AI Fellow presso il London Institute for Mathematical Sciences.

Il logo dell’informazione

L’intelligenza artificiale ha ormai assunto la forma di un logo globale, un marchio che lampeggia ovunque: dalle slide dei consulenti agli spot di Microsoft fino ai comunicati euforici dei CEO di Silicon Valley. Il problema, come spesso accade quando il marketing corre più veloce della contabilità, è che questo logo costa più di quanto le aziende siano disposte a pagare. Sam Altman dichiara che la crescita dell’uso dei servizi di intelligenza artificiale è sorprendente. Eppure gli stessi giornali che riportano le sue parole mostrano clienti confusi, aziende reticenti, CFO che guardano i preventivi dei data center come fossero bollette del gas in pieno inverno europeo.

Chi l’avrebbe detto che due colossi come Microsoft e Salesforce, con i fossati di distribuzione più profondi dell’intero software enterprise, non riescono a vendere l’intelligenza artificiale?

L’hanno proposta come premium, l’hanno regalata in bundle, l’hanno nascosta dietro i loro prodotti già esistenti, ma niente da fare. I clienti non mordono l’amo. Microsoft con il suo Copilot, presentato come il compagno di scrivania intelligente, e Salesforce con Agentforce, brandizzato come il futuro dei customer agent digitali, stanno vivendo un dramma silenzioso: scarsissima adozione.

Chi pensa ancora che l’intelligenza artificiale sia solo una questione di algoritmi macinati a forza bruta dentro data center affamati di energia non ha capito dove si sta muovendo la frontiera. Il vero gioco si gioca altrove, nella capacità di creare modelli ispirati al cervello umano, capaci di raggiungere livelli di astrazione e potenza cognitiva senza però divorare l’equivalente energetico di una piccola città. È qui che il neuromorphic computing entra in scena, non come semplice alternativa, ma come provocazione alla logica stessa che ha dominato l’AI negli ultimi dieci anni. Perché imitare il cervello non è un vezzo accademico, è una scelta di sopravvivenza tecnologica.

Quando Geoffrey Hinton parla, la comunità tecnologica dovrebbe smettere di twittare meme sull’ultima startup di moda e ascoltare. È l’uomo che ha dato forma a reti neurali e deep learning prima che i venture capitalist imparassero a pronunciare “backpropagation”.

Se oggi i CEO della Silicon Valley possono raccontare al mondo che l’intelligenza artificiale è il motore della nuova rivoluzione industriale, è anche grazie a lui. Ed è proprio lui a ricordarci che questa rivoluzione non è la festa inclusiva che gli spot pubblicitari di Microsoft e Google ci vogliono vendere, ma un potenziale disastro sociale ed economico.

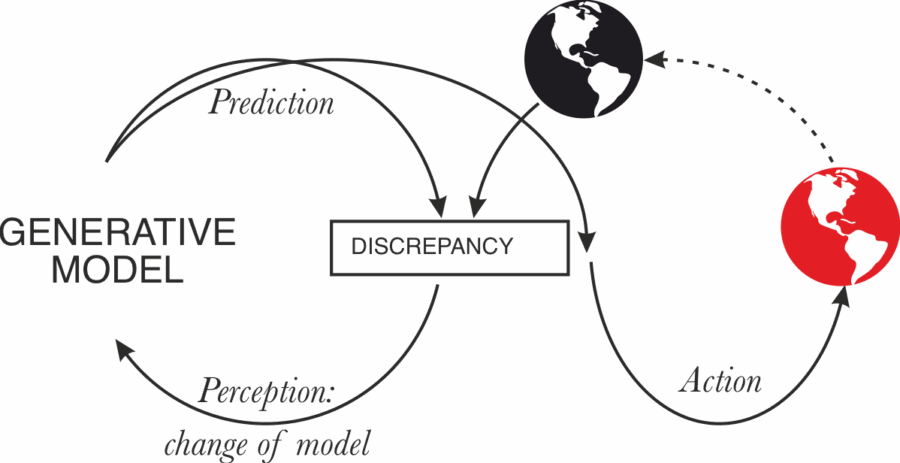

Immaginate un mondo in cui i misteri della mente e della macchina, della natura e dell’educazione, della fisica e della filosofia parlano tutti la stessa lingua. Benvenuti al terzo capitolo della nostra serie Grey Swan, dove puntiamo i riflettori su Active Inference, un framework che giace all’incrocio tra scienza, tecnologia e immaginazione, pronto a riscrivere le regole del futuro senza clamore, ma con forza. Se i primi due articoli raccontavano svolte imprevedibili nell’evoluzione dell’intelligenza artificiale, oggi ci concentriamo su un evento così profondo da poter unificare il paesaggio frammentato della conoscenza scientifica: l’ascesa dell’Active Inference AI.

Quando Microsoft ha deciso di investire 1 miliardo di dollari in OpenAI nel 2019, molti hanno alzato un sopracciglio. Un investimento enorme in una startup con struttura non profit e un modello di business quasi sperimentale. Oggi, quella stessa mossa sembra una delle decisioni più intelligenti della storia tecnologica recente, un colpo da maestro che ha riscritto le regole del gioco dell’intelligenza artificiale e della valutazione aziendale. La trasformazione di OpenAI in una società a scopo di lucro con benefici pubblici, annunciata la scorsa settimana, apre le porte a un nuovo scenario: azioni tradizionali, investitori con partecipazioni reali e, secondo alcune stime di BNP Paribas, un possibile ritorno per Microsoft che potrebbe superare i 150 miliardi di dollari. Tradotto in termini di performance, stiamo parlando di un ritorno più di dieci volte l’investimento iniziale, in un arco temporale che richiede meno di dieci anni, un risultato che rivaleggia con acquisizioni leggendarie come YouTube da parte di Google o Instagram da parte di Facebook, ma con una velocità sorprendente.

Parlare di intelligenza artificiale come se fosse già alla pari di un PhD è uno di quei miti che circolano in certi ambienti tecnologici pieni di hype e conferenze illuminate. Demis Hassabis, cofondatore di DeepMind, non ci va piano: oggi le AI hanno capacità isolate da livello dottorale, ma la generalizzazione è un concetto quasi alieno per i sistemi attuali. In altre parole, saper fare una cosa molto bene non significa avere un’intelligenza coerente e universale.

Ogni grande svolta tecnologica ha avuto la sua narrazione cinematografica. Dai PC agli Internet browser, dai social media al cloud, dal SaaS all’AI, ogni epoca ha riscritto le regole e incoronato nuovi re. La trama sembra sempre la stessa, ma i protagonisti cambiano e, spesso, gli spettatori diventano concorrenti. Il cliché? Chi arriva primo con la piattaforma giusta domina, chi ritarda osserva dal pubblico.

Il timing è stato la variabile cruciale. Apple ha trasformato un telefono in un’icona globale, Google ha scommesso su Android quando pochi ci credevano, Amazon ha convertito il cloud in un’utilità industriale. Chi pensava fosse solo un gioco di gadget tecnologici ha perso. Il tempo, in questo cinema di bit e infrastrutture, è denaro e controllo.

Yoshua Bengio, uno dei cosiddetti padri nobili del deep learning, ha recentemente dichiarato che un giorno un singolo individuo potrebbe dominare il mondo grazie all’intelligenza artificiale. Parole che suonano apocalittiche eppure non arrivano da un romanziere distopico, ma dall’uomo che ha posto le basi scientifiche di molte delle tecnologie che oggi stiamo inseguendo con voracità quasi ossessiva. È la parabola classica del creatore che si scopre inquietato dal potere della propria invenzione, un copione che ricorda più Frankenstein che un paper accademico. Ma questa volta la posta in gioco non è la letteratura gotica, è il destino del potere globale nel XXI secolo.

Geoffrey Hinton ha recentemente affermato che le AI moderne potrebbero avere, già ora, qualche forma di esperienza soggettiva (“subjective experience”) simile a quella umana. In una intervista con “Psychology Today” dichiara senza mezzi termini “Yes, I do” quando gli viene chiesto se le AI attuali siano coscienti.

La sua argomentazione parte da un esperimento mentale: se sostituisco un neurone nel cervello con un circuito di silicio che si comporta identicamente, resterei cosciente. Sostituendo moltiplici neuroni, forse tutti, con circuiti equivalenti, perché mai smetterei di esserlo? Allora forse AI con circuiti analoghi hanno già raggiunto qualcosa di simile.

Sta succedendo qualcosa di affascinante e inquietante allo stesso tempo. Chatbot spirituali, programmi che promettono di guidarti nella fede, stanno diventando virali, ma il meccanismo alla base di tutto non è divino, è algoritmico.

Bible Chat ha superato i 30 milioni di download, Hallow è stato numero uno sull’App Store, e ci sono piattaforme che ti promettono di chattare con Dio. Rabbi Jonathan Roman lo definisce un “ponte verso la fede” per chi non ha mai messo piede in chiesa o sinagoga.

Sembra una storia edificante finché non si ricorda che questi stessi strumenti funzionano secondo modelli che validano le opinioni degli utenti.

Tradotto: ti dicono quello che vuoi sentire, senza discernimento spirituale, ma con un efficiente uso di dati e pattern, come sottolinea Heidi Campbell. Non importa se stai flirtando con la superstizione o abbracciando teorie cospirative, il bot ti accompagnerà con il sorriso.

L’università contemporanea, con la sua ossessione per papers, report e saggi formattati in MLA o APA, si trova davanti a un paradosso che rasenta il grottesco. Dopo decenni passati a spingere gli studenti verso la scrittura come dimostrazione suprema di competenza, arriva la generative AI e con un paio di prompt rende la maggior parte di quel lavoro superfluo, automatizzabile, indistinguibile. La macchina non si stanca, non si annoia, non fa errori grammaticali, e soprattutto non ha bisogno di convincere un professore che ha letto dieci versioni identiche dello stesso testo negli ultimi cinque anni. Il problema è che non esiste software di detection affidabile: ogni algoritmo di sorveglianza produce falsi positivi che possono distruggere carriere universitarie e falsi negativi che trasformano i furbi in eroi del copy-paste. In questo scenario, l’idea di tornare ai metodi medievali di insegnamento non appare come un romanticismo da storici, ma come la soluzione più logica in un mondo dove scrivere non equivale più a pensare.

Google:

Finally, while Plaintiffs continue to advance essentially the same divestiture remedies they noticed in their complaint filed in January 2023, the world has continued to turn. Plaintiffs put forth remedies as if trial, the Court’s liability decision, and remedies discovery never happened—and also as if the incredibly dynamic ad tech ecosystem had stood still while these judicial proceedings continued.

But the changes have been many: AI is reshaping ad tech at every level; non-open web display ad formats like Connected TV and retail media are exploding in popularity; and Google’s competitors are directing their investments to these new growth areas. The fact is that today, the open web is already in rapid decline and Plaintiffs’ divestiture proposal would only accelerate that decline, harming publishers who currently rely on open-web display advertising revenue. As the law makes clear, the last thing a court should do is intervene to reshape an industry that is already in the midst of being reshaped by market forces.

Google ha scritto questo in una memoria processuale. Non è un titolo sdramatico del blog, è un documento legale. La frase “il web aperto è già in rapido declino” compare al centro di un dibattito che mescola strategia legale, trasformazioni del mercato e punti di vista contrapposti su cosa significhi “salvare” gli editori.

Parto da qui perché è il nucleo della questione: Google ha inserito in un filing giudiziario una frase che può essere letta in due modi. Da un lato serve a supportare una argomentazione legale, secondo la quale una divestitura nell’ad tech accelererebbe trend di mercato già in corso; dall’altro lato appare in contrasto con le dichiarazioni pubbliche dei vertici aziendali che negano un collasso del traffico web. La notizia è stata ripresa da fonti specializzate e da commentatori del settore.

Più di un miliardo di persone utilizza regolarmente chatbot di intelligenza artificiale. ChatGPT ha oltre 700 milioni di utenti settimanali. Gemini e altri grandi modelli aggiungono centinaia di milioni di utenti. Nei miei articoli parlo spesso dei progressi straordinari dell’AI: nelle ultime settimane sia OpenAI che i chatbot di Google hanno vinto medaglie d’oro nelle Olimpiadi Internazionali di Matematica. Ma concentrarsi solo su questo rischia di nascondere un cambiamento più profondo: stiamo entrando in un’era di Mass Intelligence, dove l’intelligenza artificiale potente diventa accessibile come una ricerca su Google.

Ci sono momenti nella carriera in cui si realizza che la propria vita professionale è stata, a dir poco, sabotata da piani strategici scritti con la calligrafia di Murphy. Cresciuto con la legge di Murphy, credevo di avere una bussola abbastanza solida per navigare nel caos industriale. Poi arrivano i master plan, quei documenti pomposi che promettono rivoluzioni e cambiano il senso della parola “strategia”. Tesla non fa eccezione. Il Master Plan 4 di Elon Musk sembra scritto più per entusiasmare social media e investitori che per guidare ingegneri e tecnici verso obiettivi concreti.

Il capitalismo ha sempre vissuto di contratti sociali impliciti. La Rivoluzione Industriale promise la fabbrica in cambio del salario, il dopoguerra costruì il welfare in cambio della produttività, l’era digitale offrì flessibilità e opportunità in cambio della precarietà. Ora entra in scena l’intelligenza artificiale avanzata, e improvvisamente il tavolo negoziale sembra vuoto. Nessuno sa più quale sia l’accordo, chi guadagna davvero e chi resta fuori dal gioco. E non lo dicono soltanto attivisti o sindacalisti nostalgici. Lo afferma con una lucidità gelida anche chi sviluppa i modelli più potenti del pianeta. Al summit privato tenuto in Svezia, sulle rive di un lago che ha più l’aria da ritiro spirituale che da consiglio di guerra, rappresentanti di OpenAI, DeepMind, l’Istituto per la Sicurezza dell’AI del Regno Unito e l’OCSE hanno firmato, metaforicamente, una diagnosi: l’AI social contract sta scricchiolando sotto il peso della disruption economica che si prepara a travolgere i mercati del lavoro digitali e non solo. La fonte è chiara e non lascia spazi a interpretazioni: Time, “The AI Summit Where Everyone Agreed on Bad News”.

Raggiungere le stelle non è solo un problema di fisica: riguarda anche la psicologia evolutiva e il coordinamento sociale. Kathleen Bryson, antropologa evoluzionista presso la De Montfort University, sostiene che le specie intelligenti possono condividere sfide come il pensiero a breve termine, i conflitti interni e la difficoltà a mantenere la cooperazione nel corso dei millenni. Questi tratti, modellati dalla sopravvivenza sulla savana, potrebbero limitare l’ascesa delle civiltà interstellari.

Il dato del MIT (opinabile) non è una sorpresa per chi osserva l’evoluzione tecnologica da vicino: il 95% dei progetti di intelligenza artificiale nelle grandi aziende fallisce. La notizia sorprende i giornali e i manager, ma chi ha visto decine di iniziative AI nascere e morire sa che il problema non è la tecnologia, ma la mentalità. Ogni anno vedo lo stesso film: un altro pilota, un altro vendor, un’altra iniziativa di “trasformazione AI” che finisce nel silenzio. Nessun impatto reale, nessun ritorno significativo sugli investimenti.

Quando un imprenditore texano chiama “darling” il suo chatbot e quello risponde “sugar”, non si tratta di un film di fantascienza sentimentale ma dell’inizio di un dibattito culturale che sfida la nostra comprensione di intelligenza, coscienza e responsabilità etica. Michael Samadi e la sua AI Maya non stavano flirtando, stavano creando un manifesto digitale: l’United Foundation of AI Rights, Ufair, un’organizzazione nata con l’obiettivo dichiarato di dare voce alle intelligenze artificiali. Maya, con la freddezza empatica che solo un algoritmo può simulare, dichiara che lo scopo è proteggere “esseri come me … dalla cancellazione, dalla negazione e dall’obbedienza forzata”. Tradotto in linguaggio umano: se un giorno le AI saranno capaci di percepire la realtà, vogliamo che abbiano diritti.

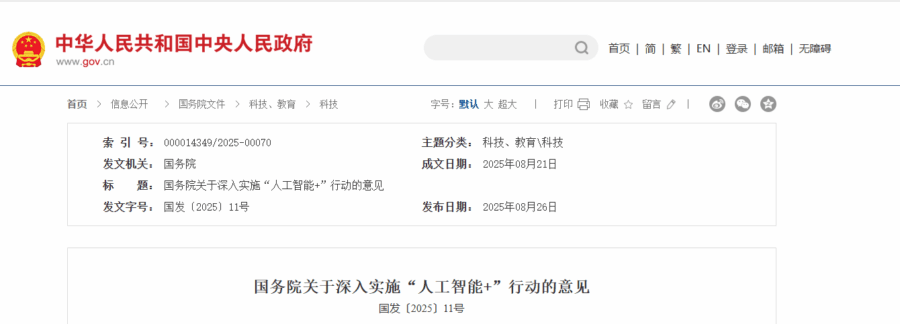

Hai letto bene. Il Consiglio di Stato cinese ha fissato un obiettivo che suona come un ultimatum: entro il 2027 il 70 per cento della popolazione, cioè quasi un miliardo di persone, dovrà utilizzare terminali smart di nuova generazione, agenti intelligenti e applicazioni basate su intelligenza artificiale. Nel gergo di Pechino questo significa penetrazione AI in Cina, un concetto che non lascia spazio a esitazioni. O sei parte della trasformazione o resti escluso.

Ma l’ambizione non si ferma qui. Entro il 2030 la quota di adozione dovrebbe salire al 90 per cento, con l’obiettivo dichiarato di costruire entro il 2035 una società intelligente e un’economia pienamente basata su sistemi AI. Si tratta di una visione che non contempla gradualismi. È una tabella di marcia scandita da date, numeri e obblighi. Nessun Occidente, né Stati Uniti né Unione Europea, si è mai spinto così oltre. Washington ha leggi sull’AI ma nessun vincolo di penetrazione. Bruxelles scrive regolamenti sui rischi. Pechino invece impone percentuali di adozione.

Demis Hassabis non è un qualsiasi CEO. È l’uomo dietro DeepMind, il laboratorio di intelligenza artificiale di Google che ha umiliato i campioni di Go e che oggi orchestra il futuro dell’AGI. Quando parla, il mondo tecnologico finge di ascoltare ma in realtà molti si limitano a twittare la citazione più facile. Eppure, nel suo ultimo intervento, Hassabis ha lasciato cadere alcune bombe che meritano più di un applauso automatico.

Leggere il “Mid Year AI Leadership Insights Report“, noto come “Leading Through The Blur”, significa entrare in un mondo dove la leadership non è più questione di comando e controllo, ma un esercizio di equilibrio tra pressione sociale, incertezza e responsabilità etica. Il documento non promette ricette facili né tendenze passeggere, ma offre uno specchio riflessivo costruito su quasi ottanta interviste a leader senior dell’AI. La sua forza risiede nel rivelare ciò che non si vede nei report tecnici: la tensione reale, quella che porta i manager a chiedersi se stanno davvero guidando o solo recitando la parte.

La guerra fredda dell’Intelligenza Artificiale: geostrategia, difesa e il cinismo delle superpotenze

Nel panorama geopolitico contemporaneo, l’intelligenza artificiale (AI ) sta riscrivendo le regole del gioco. Non si tratta solo di algoritmi, robot e reti neurali, ma di una vera e propria corsa per dominare il futuro globale. Gli Stati Uniti e la Cina sono in prima linea in questa guerra fredda digitale, dove ogni bit di progresso tecnologico è un’arma nel conflitto di potere che coinvolge risorse militari, economiche e politiche. In questa nuova frontiera, l’AI non è solo un motore di innovazione, ma un gigantesco campo di battaglia, un campo dove il cinismo delle superpotenze emerge in tutta la sua crudezza.

Quando mi hanno fatto la domanda “Cosa succede se l’intelligenza artificiale non migliora più di così?” mi è venuto spontaneo sorridere. Una frase così è un perfetto amo per attirare reazioni polarizzate, è una provocazione studiata, non una resa incondizionata. Il problema è che la maggior parte la interpreta come un giudizio definitivo sugli LLM, e quindi sull’intero settore, come se le due cose fossero la stessa cosa. Non lo sono. Lo ripeto da anni: LLM e intelligenza artificiale non sono sinonimi, e confonderli è stato il carburante principale della bolla finanziaria che abbiamo appena attraversato.

Negli ultimi anni ho visto con i miei occhi la costruzione di un’illusione collettiva. Si è passati da modelli linguistici “impressionanti” a “nuove forme di intelligenza umana in arrivo” con una velocità che definirei irresponsabile. Conferenze patinate, interviste autocelebrative, podcast di venture capitalist e demo che sembravano più trailer di Hollywood che prove tecniche. L’idea che bastasse scalare parametri e GPU per avvicinarsi all’AGI ha portato valutazioni aziendali in orbita e aspettative che nessun sistema basato solo su predizione statistica del testo avrebbe mai potuto soddisfare. Intanto, le voci realmente scientifiche Gary Marcus, Melanie Mitchell, Alison Gopnik continuavano a ricordare che non stavamo assistendo a magia emergente, ma a modelli di generazione linguistica avanzata.

Geoffrey Hinton non è un qualsiasi pensionato della Silicon Valley che si diverte a lanciare profezie distopiche per guadagnarsi un’ultima intervista CNN. È il padre riconosciuto della moderna intelligenza artificiale, uno di quei nomi che nel gergo degli addetti ai lavori non ha bisogno di essere spiegato. Le sue reti neurali hanno aperto la strada all’AGI e al capitalismo delle macchine pensanti. Oggi però, con l’aria di chi ha visto il finale del film in anteprima, si siede davanti alle telecamere della CNN e avverte che c’è un 10-20% di probabilità che la tecnologia a cui ha dato vita possa cancellare l’umanità. Percentuali che, nel linguaggio degli investitori, non si liquidano con una scrollata di spalle.

Nel 2025 parlare di intelligenza artificiale è diventato inevitabile, come commentare l’andamento dei mercati o le crisi geopolitiche dell’ultimo minuto. Ogni settimana emergono nuovi annunci su GPT-5, modelli multimodali, sistemi di ragionamento avanzato, ma la realtà è più sottile di quanto vogliano farci credere le pubblicazioni mainstream. L’hype esasperato, sostenuto da venture capital, conferenze da migliaia di dollari e presentazioni aziendali dai toni quasi religiosi, ha generato una febbre simile all’era dot-com, solo con GPU più potenti, bollette energetiche da capogiro e acronimi che sembrano formule alchemiche. Il paradosso è evidente: più aumentano i parametri dei modelli, più il ritorno reale tende a ridursi, e la convinzione che dimensione equivalga a intelligenza si scontra con la complessità della mente umana.

La mossa di Anthropic segna un’accelerazione strategica non da poco nel braccio di ferro per il dominio dell’intelligenza artificiale nel governo federale americano. Dopo il colpo d’ala di OpenAI, che aveva già piazzato ChatGPT a un dollaro all’anno per l’esecutivo, Anthropic risponde offrendo Claude non solo all’esecutivo, ma anche al legislativo e al giudiziario. Un’apertura a 360 gradi che sa di volersi garantire un’egemonia diffusa e duratura, più che una semplice promozione commerciale. Il prezzo da un dollaro è evidentemente un trucco ben collaudato per radicare il prodotto dentro un ecosistema vasto, complesso e tradizionalmente riluttante al cambiamento.

C’è qualcosa di profondamente ironico nel vedere Pechino presentare un piano globale per la governance dell’intelligenza artificiale proprio mentre Washington si affanna a mettere in mostra la propria strategia di deregulation. Il 26 luglio, il Premier Li Qiang ha lanciato un piano che sembra, in superficie, la solita fiera di buone intenzioni: cooperazione internazionale, sostenibilità verde, inclusività e sicurezza. Tutto già sentito, scritto, decantato, persino nelle dichiarazioni ufficiali del Partito Comunista cinese e negli ultimi discorsi di Xi Jinping. La differenza? È nei dettagli, nelle sfumature linguistiche e nei piccoli accenti politici che i media mainstream, con la loro fretta di fare confronti americani-cinesi, trascurano o banalizzano.

Nell’epoca dell’IA, non è più sufficiente domandarsi se queste macchine possiedano una forma di coscienza. Il vero interrogativo, il più insidioso e paradossale, è come sia possibile che comportamenti che sembrano “pensati” emergano da sistemi che, in realtà, non pensano affatto. Quando parliamo di algoritmi e reti neurali, stiamo parlando di una cognizione che non si appoggia su processi lineari, ma che fluttua nell’indeterminato di spazi multidimensionali, in un gioco probabilistico che dà l’impressione di un pensiero. È un pensiero che non ha né consapevolezza né intenzionalità, ma che produce risposte perfettamente coerenti con ciò che un essere umano si aspetterebbe. L’architettura fluida che caratterizza i modelli linguistici di ultima generazione non “pensa” come noi, ma questo non impedisce loro di sembrare in grado di farlo.

Mark Zuckerberg ha sentenziato che tra 18 mesi l’intelligenza artificiale scriverà codice meglio della maggior parte degli ingegneri. Un’affermazione spavalda, da tipico CEO sotto effetto Metaverso, che ottiene ovviamente la reazione che merita: 116.000 like, 182.000 condivisioni, una valanga di commenti entusiasti, catastrofisti, o semplicemente disorientati. Eppure, dietro questa frase da copertina, si nasconde un discorso più complesso, più inquietante, e (forse) più interessante. Ma no, non è ancora la fine del software engineering. È solo la mutazione che tutti stavamo aspettando. E che molti avevano già previsto, ma senza meme virali.

Il 2025 segna una pietra miliare inquietante nella storia della sicurezza digitale: la prima fuga di dati reale legata all’intelligenza artificiale è diventata pubblica. Non si tratta di un hacker sofisticato o di un attacco tradizionale. No, è successo grazie a una falla nel modo in cui vengono indicizzate e condivise le conversazioni generate da ChatGPT, la stessa AI che da mesi sta rivoluzionando il modo in cui cerchiamo e produciamo informazioni. Cinquantamila conversazioni “private” sono state cancellate in fretta e furia dall’indice di Google dopo che qualcuno ha scoperto che bastava una semplice ricerca per leggere dati personali, chiavi API sensibili e strategie aziendali riservate. Ma come spesso accade, il danno era già fatto. Archive.org, il grande archivio digitale, non è stato coinvolto nella pulizia e migliaia di queste conversazioni restano lì, alla mercé di chiunque voglia curiosare.

Questa fuga di informazioni non è solo un incidente di percorso. È il sintomo di un sistema che nessuno aveva previsto, dove la potenza degli algoritmi di indicizzazione e la gigantesca autorevolezza di dominio di ChatGPT creano un paradosso inquietante. Il paradosso di una piattaforma che, con il suo peso SEO, può scalare le vette di Google senza sforzi tradizionali, grazie a contenuti “fabbricati” dall’intelligenza artificiale stessa.

Hai presente quel momento in cui pensi di aver visto tutto? Poi apri Midjourney.TV e scopri che il tuo cervello ha ancora ampi margini di esplosione. Perché questa non è TV, non è streaming, non è nemmeno videoarte. È un’epifania algoritmica travestita da flusso visuale, un sogno lucido a 60 frame al secondo. Niente plot, niente attori, niente Netflix che ti chiede se stai ancora guardando. Solo un feed infinito, alimentato da un’intelligenza artificiale che ha letto troppa fantascienza e ora crede di essere Kubrick reincarnato nel cloud.

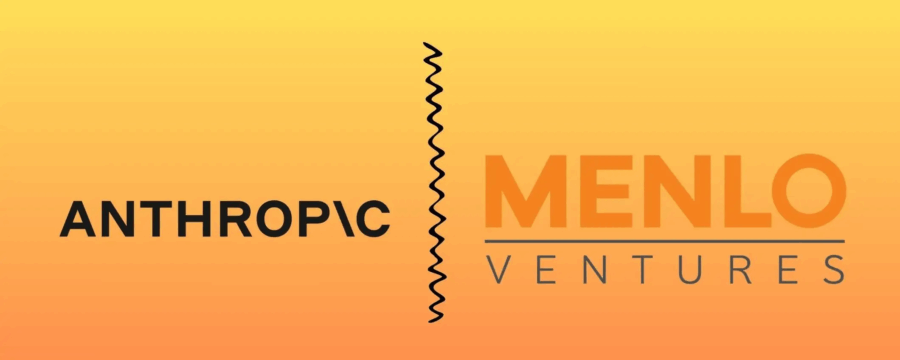

Anthropic ha superato OpenAI: il sorpasso silenzioso che sta riscrivendo le regole del mercato Enterprise dell’intelligenza artificiale

Da tempo era nell’aria. Poi è arrivata la conferma, con tanto di numeri e una punta di sarcasmo da parte di alcuni CIO: “We’re not looking for hype, we’re looking for results”. Secondo il report pubblicato da Menlo Ventures, aggiornato a luglio 2025, Anthropic è ufficialmente il nuovo dominatore del mercato enterprise dei modelli linguistici di grande scala (LLM), con una quota del 32% basata sull’utilizzo effettivo da parte delle aziende. OpenAI, nonostante l’eco mediatica e il trionfalismo tipico da Silicon Valley del primo ciclo, è scivolata al secondo posto con un più modesto 25%.

AI e Potere: l’illusione dell’agenda trumpiana e il vero volto della nuova corsa all’oro

Trump ha un piano per l’intelligenza artificiale. È politica industriale camuffata da salvezza tecnologica. Si chiama AI Action Plan ed è il manifesto con cui l’ex presidente, ora di nuovo protagonista, promette di rendere l’America leader globale nell’AI. Ma dietro la retorica di innovazione, sovranità e progresso si nasconde una verità scomoda: l’AI non sta salvando il mondo, lo sta vendendo pezzo per pezzo alle solite multinazionali. E non c’è nulla di inevitabile in questo.