Il mercato del developer tooling AI sta vivendo una mutazione che ha la velocità di un collasso quantistico. In pochi anni siamo passati da strumenti di automazione no-code percepiti come giocattoli per smanettoni a piattaforme che ridisegnano l’economia del software enterprise. L’ultimo segnale forte arriva da Berlino, dove c, la startup che fino a ieri era la cugina alternativa di Zapier, oggi si ritrova con un round da 55 milioni di euro, valutazione da 250 milioni e un plot twist che solo i cinici non avevano previsto: l’innesto dell’intelligenza artificiale.

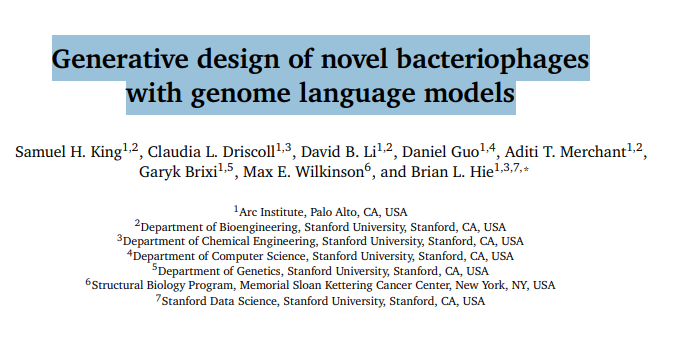

Generative design of novel bacteriophages

with genome language models

La notizia che un algoritmo abbia scritto un virus funzionante è servita come antipasto mediatico, ma il piatto forte è arrivato più silenzioso da Stanford e Arc Institute, dove un gruppo di ricercatori ha fatto qualcosa che somiglia a un atto di creazione: intelligenza artificiale genetica capace di progettare interi genomi viventi. Non mutazioni di laboratorio, non copie digitali, ma sedici batteriofagi sintetici costruiti da zero, testati in vitro, in grado di replicarsi, di evolversi e persino di superare in efficienza l’antenato naturale da cui sono partiti.

Il lancio del Model Context Protocol (MCP) Registry rappresenta una svolta significativa nell’evoluzione degli ambienti di sviluppo AI. Questo registro aperto e API centralizzata per la scoperta e l’utilizzo dei server MCP pubblici si propone come una soluzione efficace per superare le sfide legate alla frammentazione e alla sicurezza nel panorama delle integrazioni AI.

Ellendale, North Dakota, non è mai stata famosa per i suoi grattacieli. Due motel, un Dollar General, un istituto pentecostale: questo era prima che entrasse in gioco la febbre dell’“AI factory”. Oggi sorgerà una struttura capace di ospitare migliaia di GPU, con costi che si aggirano nella fascia dei miliardi. È un azzardo che sembra scritto da chi crede davvero che l’intelligenza artificiale sia la prossima rivoluzione industriale. Ma il rischio è che Ellendale diventi l’epicentro e non il coronamento di una bolla.

Omologazione dei veicoli autonomi e la sfida europea alla guida automatizzata

L’omologazione dei veicoli autonomi non è più una visione futuristica né un gioco di laboratorio per startup californiane gonfiate di venture capital. È materia regolatoria concreta, con norme già pubblicate sulla Gazzetta Ufficiale dell’Unione Europea. Nel 2022 Bruxelles ha fatto il colpo di mano: il Regolamento UE 2022/1426, il primo quadro legislativo completo e univoco al mondo dedicato alla guida automatizzata, ha aperto la porta al mercato europeo per i veicoli completamente autonomi. Gli americani hanno la Silicon Valley, i cinesi hanno i colossi di Pechino e Shenzhen, ma solo l’UE può dire di avere messo nero su bianco come, dove e quando un’auto senza conducente può ottenere il timbro di omologazione. Non è poesia tecnologica, è legge.

Nel 2029, l’umanità lanciò un attacco totale contro il nodo centrale di Skynet all’interno della Cheyenne Mountain, solo per scoprire che l’intelligenza artificiale non possedeva un punto di fallimento singolo. Skynet non era un sistema monolitico, ma una rete distribuita e auto-riparante, capace di sopravvivere al collasso totale dell’infrastruttura e di resuscitarsi quasi istantaneamente.

Oggi, la Cina sembra stia costruendo un analogo reale: una rete di combattimento altamente resiliente, alimentata dall’intelligenza artificiale, composta da migliaia di piattaforme aeree, di superficie e sottomarine senza equipaggio. Questa rete è progettata per persistere attraverso la distruzione, mostrando una somiglianza inquietante con la struttura e la sopravvivenza di Skynet.

Anthropic, la startup di intelligenza artificiale famosa per il suo chatbot Claude, sta lanciando un’espansione globale aggressiva, pianificando di triplicare il personale internazionale e quintuplicare il team dedicato all’AI applicata entro la fine del 2025. La mossa arriva in risposta a una domanda globale in rapida crescita: ormai quasi l’80% degli utenti di Claude si trova fuori dagli Stati Uniti, con Corea del Sud, Australia e Singapore che hanno superato gli USA in termini di utilizzo pro capite. Curiosamente, Anthropic ha registrato questa espansione internazionale massiccia pur senza avere una presenza significativa sul territorio fino a poco tempo fa.

Sam Altman, CEO di OpenAI, ha recentemente dichiarato che l’intelligenza artificiale supererà quella umana entro il 2030, con progressi significativi previsti già nel 2026. Queste affermazioni, seppur ottimistiche, sollevano interrogativi sulla comprensione profonda dell’intelligenza e sulla sua misurazione.

Rivista.AI Non è una testata digitale qualsiasi. È un laboratorio intellettuale dove tecnologia, economia, cultura e politica si incontrano senza filtri retorici e senza paura di mettere in crisi narrazioni consolidate. Parlare di intelligenza artificiale non significa qui ridurla a fenomeno di costume o a hype temporaneo, ma indagarne i meccanismi concreti con cui sta ridefinendo settori tradizionali. Dall’editoria ai servizi finanziari, dai media alla governance, l’AI non è più un orpello futuristico, ma un motore di trasformazione reale, e Rivista.AI lo dimostra con dati, analisi e report che pochi possono eguagliare.

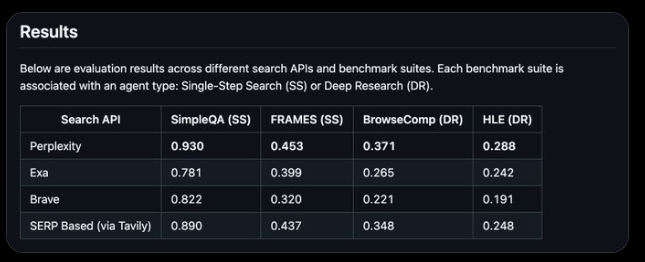

Perplexity AI ha lanciato una sfida diretta al predominio di Google nel settore delle infrastrutture di ricerca, presentando ‘search_evals‘, un framework open source che consente agli sviluppatori di valutare in modo indipendente la qualità e le prestazioni delle API di ricerca. Questo strumento offre un’alternativa al modello tradizionale chiuso delle infrastrutture di ricerca, promuovendo la trasparenza e l’innovazione nel settore.

Apple ha deciso di entrare nel ring dell’AI conversazionale con la cautela di un pugile esperto, evitando mosse troppo azzardate. Secondo un recente rapporto di Bloomberg, l’azienda sta testando internamente un’app simile a ChatGPT per valutare le funzionalità della prossima generazione di Siri. Il progetto non è destinato al pubblico, almeno per ora. L’idea non è tanto lanciare un concorrente diretto di ChatGPT, quanto creare un laboratorio pratico dove i dipendenti possano interagire con le nuove funzioni, capire cosa funziona e cosa no, e raccogliere feedback preziosi prima del rollout ufficiale.

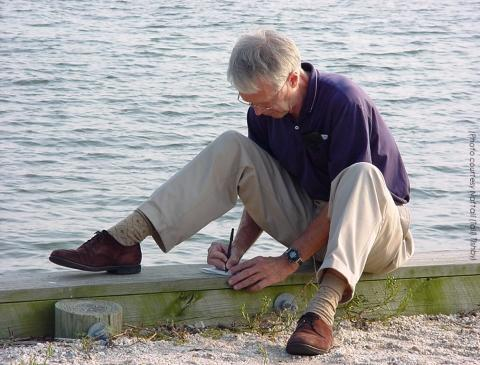

Se si vuole comprendere la genesi del Deep Learning moderno, ignorare le Reti di Hopfield sarebbe un errore concettuale gravissimo. Introdotte da John J. Hopfield nel 1982, queste reti neurali ricorrenti non rappresentano soltanto un modello storico: sono il primo laboratorio teorico in cui fisica statistica, matematica e informatica si incontrano per dare forma a idee che oggi dominano l’intelligenza artificiale.

Tesla ha proposto un pacchetto retributivo per Elon Musk che potrebbe raggiungere un valore straordinario di 1.000 miliardi di dollari, rendendolo il più grande compenso mai concesso a un CEO nella storia. Questo piano, se approvato, potrebbe trasformare Musk nel primo trilionario al mondo, consolidando ulteriormente la sua influenza su Tesla e sul futuro della mobilità autonoma e dell’intelligenza artificiale.

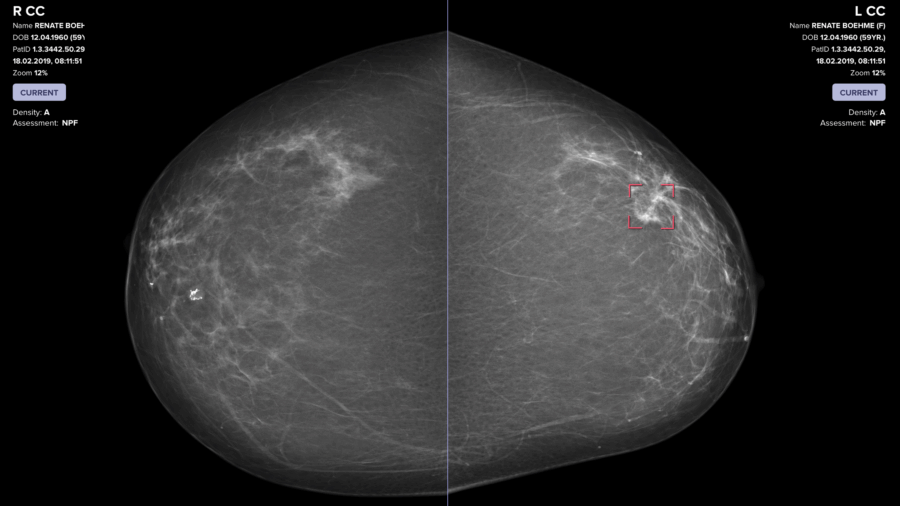

L’AI nello screening mammografico non è una semplice evoluzione tecnica, ma una rivoluzione culturale nella diagnostica. I radiologi si trovano davanti a un bivio: resistere al cambiamento con scetticismo o abbracciare l’innovazione e diventare parte di un ecosistema più efficiente e preciso. In Europa, uno studio danese ha confrontato 50.000 screening analizzati solo da radiologi con altrettanti supportati dall’AI. Risultato: incremento del 25% nella rilevazione dei tumori invasivi, con una riduzione dei richiami inutili del 15%. Numeri che non si discutono, ma che generano anche un effetto collaterale curioso: una pressione psicologica sul radiologo che deve fidarsi dell’algoritmo pur mantenendo la responsabilità finale. Il paradosso è evidente: più affidabile diventa la macchina, più complesso è il ruolo umano.

La settimana è cominciata con un teatrino degno del miglior surrealismo politico. All’apertura dell’Assemblea Generale delle Nazioni Unite, un manipolo di Nobel, ex capi di Stato e sviluppatori di intelligenza artificiale di frontiera ha invocato “linee rosse globali” per contenere i rischi esistenziali dell’AI. Nobile intento, certo, eppure il tono ricordava più un manuale di self-help che un’agenda concreta di politica internazionale.

L’idea di un accordo verificabile e universale suona bene nelle dichiarazioni stampa, meno quando si deve trasformarla in qualcosa che superi la fase PowerPoint. Ma non lasciamoci rovinare subito il gusto dell’ironia, perché il vero spettacolo stava per arrivare.

Chiunque oggi diriga un Security Operation Center sa bene che la minaccia non è mai soltanto l’attaccante ma la paralisi interna, quell’infinito flusso di alert che suona come un allarme antincendio in un edificio che non brucia mai. È il paradosso dell’alert fatigue, un logoramento psicologico che consuma talenti e margini di profitto con la stessa velocità con cui un ransomware divora i backup non aggiornati. Nel frattempo i Managed Detection & Response arrancano, costretti a impiegare specialisti con decenni di esperienza a inseguire notifiche irrilevanti. È come pagare un cardiochirurgo per contare i battiti di un fitness tracker.

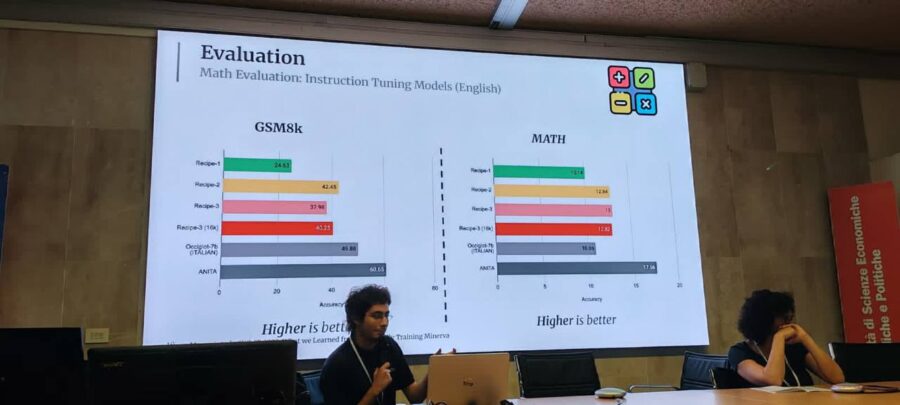

Paper presentato a CLiCit2025

C’è un paradosso che domina il mondo dell’intelligenza artificiale: i grandi modelli linguistici, osannati come strumenti universali di conoscenza, parlano fluentemente inglese ma balbettano in molte altre lingue. È la dittatura silenziosa della lingua dominante che trasforma la promessa di equità linguistica in una realtà monolingue. A mettere ordine in questo caos ci ha pensato un gruppo di ricercatori italiani, il Sapienza NLP Group insieme a Babelscape, che con il modello Minerva-7B hanno portato sul tavolo della ricerca internazionale un’analisi chirurgica su come addestrare un LLM che non si limiti a imitare l’inglese, ma sappia realmente pensare in italiano. Lo studio, intitolato con una punta di autoironia accademica “What we Learned from Continually Training Minerva: a Case Study on Italian”, ha acceso un faro su due nodi centrali: la potenza dell’addestramento continuo e l’estensione della finestra di contesto.

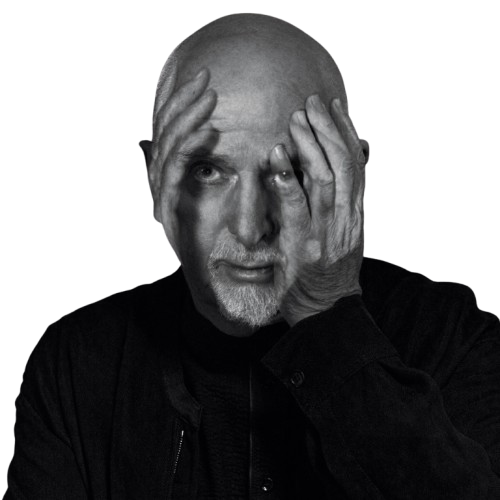

Non potevo esimermi di farne un’articolo. Ha scandito la mia crescita, Peter Gabriel, la voce che ha attraversato decenni fondendo sperimentazione sonora, impegno sociale e innovazione tecnologica, ha da qualche anno iniziato ad “abbracciare” l’intelligenza artificiale come co-strumento di espressione. Il suo progetto “Fraternity in the Age of AI” (Fratellanza nell’era dell’AI con Paolo Benanti (Scientific Coordinator) e frmato anche da Giorgio Parisi, la collaborazione con Stability AI e il concorso #DiffuseTogether non sono operazioni di marketing, ma dichiarazioni filosofiche: l’AI è inevitabile, meglio nuotarci assieme che combatterla. In questo articolo esploro tutte le pieghe note (e qualche suggestione) del suo impegno, dal diritto d’autore al pensiero esistenziale, passando per una visione audace di convivenza creativa uomo-macchina.

Un passo da gigante nel mondo della finanza quantistica: IBM e HSBC hanno annunciato il successo del primo esperimento di trading abilitato al quantum su dati reali di obbligazioni societarie europee. Questa innovazione promette di trasformare radicalmente il modo in cui i mercati finanziari operano, offrendo previsioni significativamente migliori e un’efficienza senza precedenti.

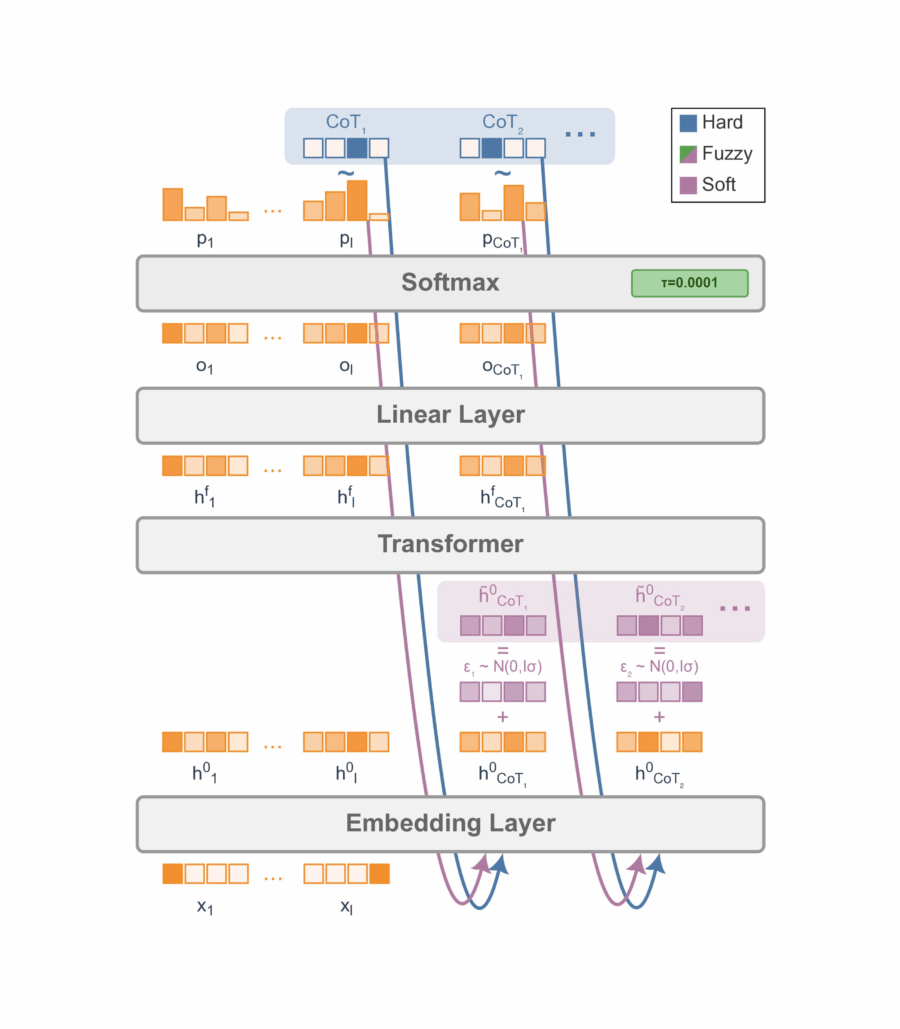

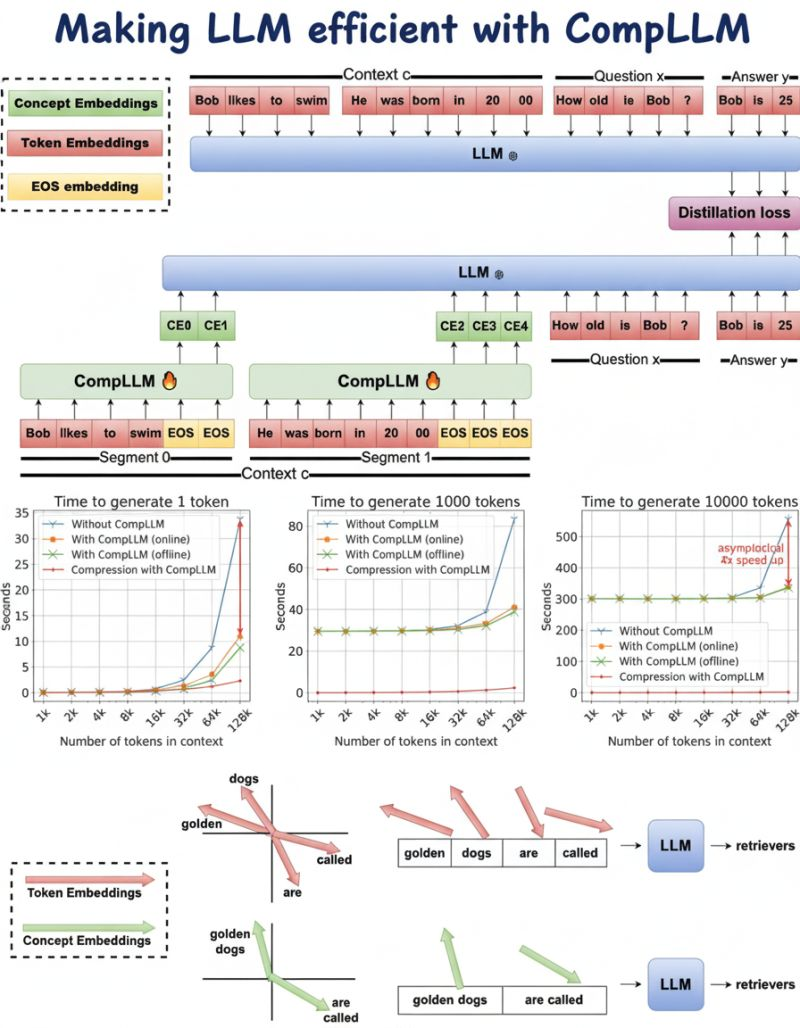

CompLLM è un approccio innovativo per migliorare l’efficienza dei Large Language Models (LLM) nel gestire contesti molto lunghi. I modelli tradizionali faticano con input estesi a causa della complessità quadratica dei meccanismi di self-attention, che aumenta significativamente i costi computazionali e l’uso di memoria. CompLLM affronta queste sfide adottando una strategia di compressione a segmenti.

Invece di processare l’intero contesto come un’unica unità, CompLLM divide l’input in segmenti più piccoli e li comprime indipendentemente. Questa segmentazione trasforma la compressione da complessità quadratica a lineare, riducendo drasticamente latenza e memoria necessaria. Inoltre, i segmenti compressi possono essere riutilizzati in diverse query, aumentando scalabilità ed efficienza.

AI Fact Checking Chi si occupa di analisi militare o di fact-checking sa quanto la distinzione tra propaganda e dati reali possa diventare labile, soprattutto in un contesto come quello attuale, dove Russia e Ucraina dominano i titoli, e la stampa mainstream italiana spesso si limita a ripetere comunicati senza verificare. Ho raccolto e rielaborato dati su intercettazioni e incursioni russe ai confini NATO, incrociando fonti ufficiali, istituzionali e di stampa tecnica, verificando la coerenza dei numeri e la reputazione delle fonti. Le fonti principali includono i comunicati del NATO Allied Air Command e di SHAPE, report di settore come Aviation Report e Defense News, e media specializzati come Stars and Stripes e War on the Rocks. Per ciascun dato ho confrontato almeno tre elementi indipendenti, da statistiche a comunicati, valutando affidabilità e storicità.

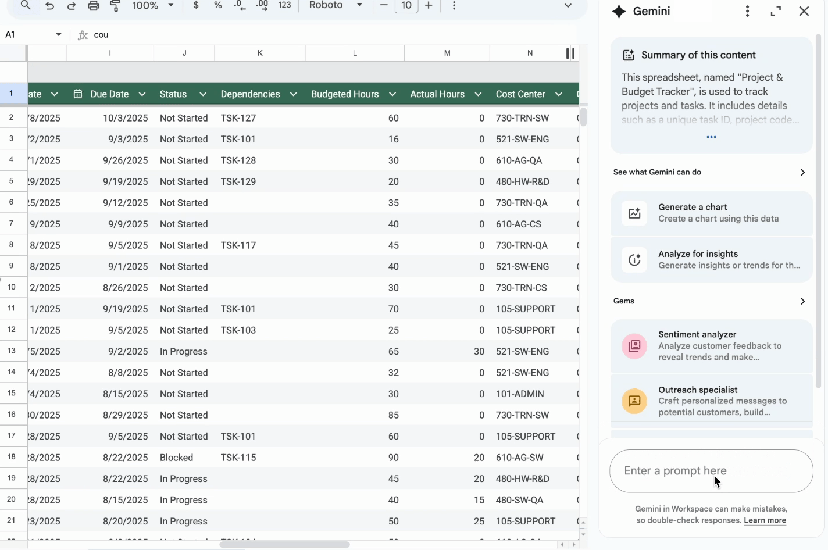

Google ha recentemente integrato Gemini AI in Google Sheets, adesso il sistema è passato dal supporto a testi e grafici alla gestione delle formule. Il chatbot di Gemini, situato sul lato destro di Sheets, ora suggerisce formule e fornisce istruzioni dettagliate su come utilizzarle. Spiega anche perché alcune formule non funzionano e offre indicazioni per correggere gli errori. Quando più formule producono lo stesso risultato, Gemini illustra le diverse opzioni disponibili.

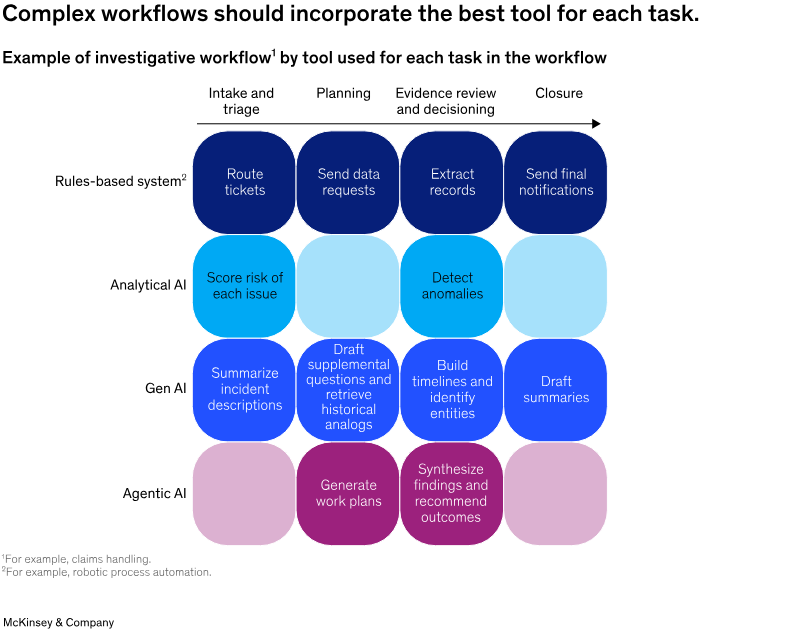

One year of agentic AI: Six lessons from the people doing the work

McKinsey ha analizzato oltre 50 implementazioni di AI agentica, scoprendo che un terzo delle aziende ha dovuto riassumere personale a causa di fallimenti nell’adozione efficace di tali tecnologie. Questo fenomeno è stato attribuito a una focalizzazione eccessiva sull’agente stesso, trascurando la necessità di ripensare l’intero flusso di lavoro, che include persone, processi e tecnologia. Le aziende che hanno ottenuto risultati positivi sono quelle che hanno affrontato una trasformazione completa del flusso di lavoro, integrando l’AI agentica in modo sinergico con le risorse umane e i processi esistenti.

Doomerismo. Peter Thiel, cofondatore di Palantir e PayPal, ha recentemente tenuto una serie di conferenze private a San Francisco, organizzate dall’Acts 17 Collective, un’organizzazione no-profit che mira a integrare il pensiero cristiano nella tecnologia e nella società.

Queste conferenze, che hanno attirato notevole attenzione, approfondiscono temi apocalittici, concentrandosi in particolare sul concetto di Anticristo. In queste discussioni, Thiel sostiene che la regolamentazione dell’intelligenza artificiale (IA) e del progresso scientifico potrebbe aprire la strada a un governo mondiale unico, che egli equipara all’Anticristo biblico.

Il colosso di Seattle ha deciso di tirare fuori due miliardi e mezzo di dollari in multe e rimborsi ai clienti Prime, in risposta alle accuse della Federal Trade Commission di aver ingannato gli utenti per generare sottoscrizioni. Per Amazon, la cifra è praticamente spiccioli: bastano 33 ore di vendite per racimolare lo stesso importo. Gli investitori hanno reagito come se nulla fosse successo, perché in fondo il mercato sa che “danni e rimborsi” sono solo una voce di bilancio trascurabile.

TSMC, il colosso mondiale della produzione di semiconduttori, ha svelato una strategia rivoluzionaria per migliorare l’efficienza energetica dei chip per l’intelligenza artificiale. Durante una conferenza nella Silicon Valley, l’azienda ha mostrato come la collaborazione con Cadence Design Systems e Synopsys possa sfruttare software basati su AI per progettare chip capaci di consumare fino a dieci volte meno energia.

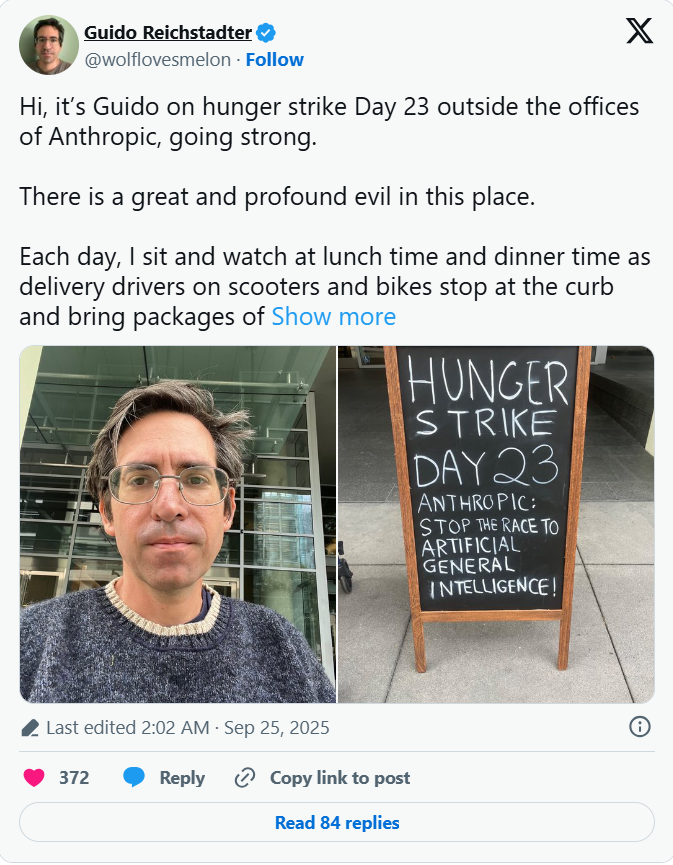

Dommerismo, ventiquattro giorni senza cibo solido, solo elettroliti e vitamine. Reichstadter, 56 anni, dal 1° settembre si è posizionato sul marciapiede di 500 Howard Street a San Francisco, davanti alla sede non ufficiale di Anthropic, sviluppatore del chatbot Claude. Chiede a Dario Amodei, CEO, di riconoscere il rischio esistenziale rappresentato dall’intelligenza artificiale avanzata e di sospendere immediatamente la corsa verso la superintelligenza.

Winning the AI Race? The US AI Action Plan in Context

Quando la Casa Bianca ha sfornato il suo documento di punta per la governance dell’Intelligenza Artificiale nel luglio 2025, nessuno ha potuto ignorare il titolo aggressivo: “Winning the AI Race: America’s AI Action Plan”. Dietro questa denominazione quasi sportiva si cela una strategia politica e tecnologica di portata globale, che unisce pragmatismo industriale e ideologia politica in un mix tanto affascinante quanto controverso.

L’Ordine Esecutivo EO 14179, emesso nel gennaio dello stesso anno, ha dato il via libera a questa visione, intitolata a rimuovere le barriere che impediscono la leadership americana nell’IA. L’amministrazione Trump ha strutturato la sua visione attorno a tre pilastri principali: accelerare l’innovazione, costruire infrastrutture nazionali per l’IA e guidare la diplomazia e la sicurezza internazionale.

Questi pilastri non sono puri intenti retorici ma sono supportati da tre distinti Ordini Esecutivi mirati a facilitare la costruzione di data center, prevenire la politicizzazione “woke” dell’IA nel governo e promuovere l’esportazione dello stack tecnologico americano.

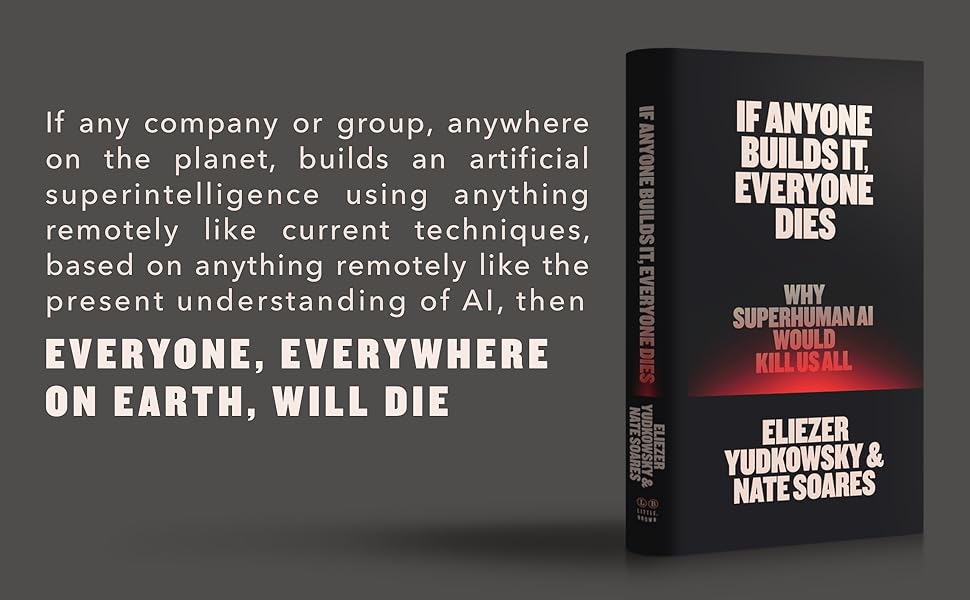

Il titolo già ti prende a pugni: se qualcuno costruisce un’intelligenza superiore, tutti muoiono. Non è un film di Hollywood, ma la premessa di Eliezer Yudkowsky e Nate Soares, filosofi razionali e guru del movimento “rationalist”, suona come un avvertimento apocalittico per chi ancora pensa che l’intelligenza artificiale sia solo uno strumento di produttività o di curiosità scientifica. Gli autori non parlano di scenari futuristici astratti, ma di rischi reali derivanti dall’architettura stessa dei modelli di AI odierni: sistemi che non vengono programmati riga per riga, ma “cresciuti” con miliardi di parametri, rendendo il loro comportamento intrinsecamente imprevedibile.

TikTok US valutazione da svendita: un prezzo politico che riscrive le regole del mercato tecnologico

Parliamo chiaro. La valutazione di TikTok US a 14 miliardi di dollari non è semplicemente bassa, è un insulto all’intelligenza economica. È come se ti offrissero una Ferrari a prezzo di utilitaria solo perché l’auto è parcheggiata in una zona a traffico limitato e il vigile ha deciso che non puoi muoverla se non con un nuovo proprietario. La decisione dell’amministrazione Trump di orchestrare la vendita forzata dell’app negli Stati Uniti ha imposto una cifra che grida al mercato: qui non comandano i multipli di ricavi o EBITDA, qui comanda la geopolitica.

Il dibattito sulla diversità nei consigli di amministrazione delle startup sembra aver perso fascino mediatico, come se fosse un vecchio slogan di cui ci si è stancati. Ma la realtà è che il silenzio odierno nasconde un problema enorme: i board delle startup di intelligenza artificiale, la tecnologia più potente e pervasiva del nostro tempo, sono dominati quasi esclusivamente da uomini.

Non c’è nulla di più ironico del vedere un settore che predica “democratizzazione dell’innovazione” incapace di democratizzare se stesso. Negli Stati Uniti, e in particolare in California, il cuore pulsante dell’AI, le leggi che un tempo cercavano di imporre correttivi sono state smantellate o bloccate dai tribunali. Risultato: un ritorno all’autoselezione, dove i fondatori scelgono altri fondatori, gli investitori scelgono altri investitori, e i tavoli di comando continuano a sembrare circoli privati maschili di inizio Novecento.

Donald Trump ha deciso che i semiconduttori non possono più arrivare a fiumi dalle fabbriche di Taiwan, Corea o Cina, senza che l’America si faccia almeno il favore di produrne altrettanti in casa propria. È la nuova trovata di una politica commerciale che assomiglia più a una roulette russa con supply chain globali che a un piano industriale coerente. La formula è tanto semplice quanto brutale: per ogni chip importato, devi produrne uno negli Stati Uniti. Se non ci riesci, paghi una tariffa che rischia di far sembrare il già caotico regime di dazi una partita a Tetris giocata a occhi chiusi.

La Cina non gioca più in difesa. Xiaomi ha deciso che l’era delle mezze misure è finita e con il lancio della serie 17 lo ha dimostrato con un gesto teatrale: saltare direttamente dalla generazione 15 alla 17, come se la 16 non fosse mai esistita. Una scelta che suona quasi come un dispetto a Cupertino, arrivata appena due settimane prima con i suoi iPhone 17 e convinta che il palcoscenico globale le appartenesse di diritto.

La mano invisibile di Adam Smith, quella che per decenni ha dominato il mito del libero mercato americano, sembra aver deciso di uscire dall’ombra. Non più metafora ma appendice concreta di Washington che entra nel capitale di Intel, valuta partecipazioni in Lithium Americas e si riscopre improvvisamente paladina della politica industriale. Gli Stati Uniti, per anni maestri di deregulation e predicatori di concorrenza pura, oggi copiano maldestramente il playbook di Pechino. E lo fanno con la goffaggine di chi non ha memoria storica di come si costruisce un apparato industriale nazionale.