La morte, da sempre concepita come il termine definitivo della coscienza, sta rivelando, grazie a recenti studi scientifici, una natura più sfumata e complessa. Le scoperte sull’attività cerebrale durante le fasi terminali della vita suggeriscono che la coscienza potrebbe persistere in uno stato di “consapevolezza crepuscolare” anche dopo la morte clinica.

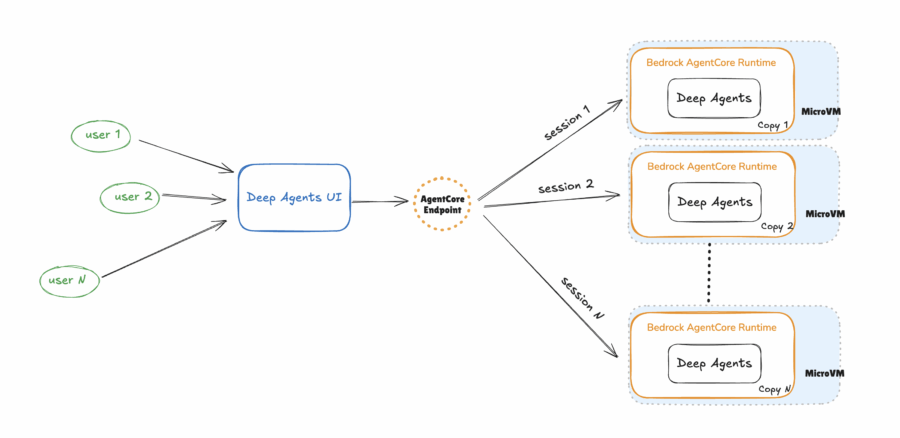

Amazon ha appena lanciato una guida completa per distribuire Deep Agent su Amazon Bedrock AgentCore Runtime, trasformando un prototipo locale in un agente di intelligenza artificiale multi-agente pronto per la produzione in meno di cinque minuti. Questo approccio consente di costruire flussi di lavoro complessi in modo semplice e scalabile, senza la necessità di gestire l’infrastruttura sottostante.

Mario De Caro, con il suo libro Realtà, pubblicato da Bollati Boringhieri, riporta al centro della scena filosofica il dibattito sul realismo e sull’antirealismo con una precisione chirurgica e un’ironia da veterano della filosofia contemporanea. Per decenni il realismo sembrava confinato ai margini, ironicamente soprannominato “marsupiale della filosofia”, mentre l’antirealismo dominava la riflessione accademica, dalla filosofia analitica a quella continentale. L’antirealista moderno accetta una realtà extramentale, ma la considera amorfa, destrutturata, e legata più alle categorie della mente o del linguaggio che al mondo stesso. Thomas Kuhn ci ricorda che i paradigmi definiscono il mondo, mentre Hilary Putnam, nella fase del “realista interno”, mostra come mente e mondo si generino insieme, un gioco di specchi che rende ogni certezza ontologica sospetta.

Google ha appena fatto un passo audace nella corsa all’AI avanzata con il lancio del Data Commons Model Context Protocol Server, una piattaforma pensata per trasformare i dati pubblici in risorse immediate per sviluppatori, data scientist e agenti AI. La promessa è chiara: dati reali, accessibili tramite linguaggio naturale, pronti a rafforzare la qualità e l’affidabilità dei modelli AI. Non si tratta di un semplice esercizio accademico, ma di un tentativo strategico di ridurre uno dei problemi più ostici dell’AI moderna: le allucinazioni generate da dati web rumorosi e non verificati.

Quando un colosso come Oracle sceglie il palcoscenico dell’Assemblea Generale delle Nazioni Unite per presentare la sua nuova creatura tecnologica, non è solo marketing. Government Data Intelligence for Agriculture, il nome suona tecnico e un po’ noioso, ma dietro quelle parole si gioca un pezzo di futuro della sicurezza alimentare. Perché non stiamo parlando di un nuovo software per ottimizzare le supply chain delle aziende agricole californiane, bensì di un’infrastruttura digitale che promette di aiutare governi interi a capire in tempo reale come si muove la produzione agricola, quali raccolti stanno per collassare e dove conviene intervenire per evitare che l’insicurezza alimentare diventi instabilità politica.

Quando pensiamo a Google immaginiamo un motore di ricerca imparziale, una macchina perfettamente logica che restituisce risultati obiettivi. Safiya Noble ci costringe a fare marcia indietro e a guardare la realtà con occhi meno ingenui. La studiosa americana, docente di media studies, ha passato anni a osservare come le persone interagiscono con i motori di ricerca, scoprendo che dietro l’apparente neutralità si nascondono pregiudizi radicati. Digitando parole chiave legate a donne nere o latine, i risultati mostrano contenuti sessisti, degradanti e apertamente razzisti. Non si tratta di incidenti isolati, ma di pattern sistematici. Ogni query diventa uno specchio deformante della società, un amplificatore di stereotipi e discriminazioni.

OpenAI sta esplorando un cambiamento strategico nel finanziamento della propria infrastruttura AI, considerando l’opzione di noleggiare le GPU avanzate di Nvidia invece di acquistarle direttamente. Questa mossa potrebbe ridurre i costi dell’hardware del 10% al 15%, secondo fonti vicine alle trattative. Il possibile accordo di leasing quinquennale permetterebbe a OpenAI di evitare i significativi investimenti iniziali necessari per l’acquisto dei chip, riducendo al contempo i rischi legati all’obsolescenza tecnologica rapida.

Google ha recentemente lanciato la sua modalità di ricerca AI in spagnolo, segnando una delle più ampie espansioni linguistiche della sua storia. Questa iniziativa consente agli utenti di lingua spagnola di interagire con un’interfaccia di ricerca conversazionale, porre domande in linguaggio naturale, partecipare a chat, caricare immagini e approfondire argomenti complessi. Tuttavia, la domanda che sorge spontanea è: quando arriverà questa funzionalità in Italia?

I chip di intelligenza artificiale sono più caldi che mai, e Microsoft ha appena testato un metodo di raffreddamento rivoluzionario che va direttamente alla fonte. Incidendo canali microscopici direttamente nei chip di silicio, il nuovo sistema microfluidico dell’azienda rimuove il calore fino a tre volte più efficacemente rispetto alle piastre fredde avanzate odierne.

Alibaba ha appena lanciato Qwen3-Max, il suo modello di intelligenza artificiale più potente di sempre, con oltre un trilione di parametri. Presentato alla conferenza annuale dell’azienda, questo modello segna un passo importante nella strategia di Alibaba volta a porre l’intelligenza artificiale al centro del proprio business.

Un giorno qualcuno ci racconterà che il futuro dell’agricoltura non è nato nelle campagne, ma in un magazzino illuminato da LED a Hong Kong, sotto il marchio di una blockchain. È qui che Peaq, una rete Layer-1 specializzata nell’economia delle macchine, ha annunciato la nascita della prima robo-farm tokenizzata al mondo, una verticale industriale che non produce soltanto lattuga e spinaci, ma anche flussi di cassa digitalizzati sotto forma di NFT. È la fusione tra agritech e finanza decentralizzata, la materializzazione di quell’ossessione per gli asset reali tokenizzati che da tempo infesta le presentazioni dei venture capitalist.

Cohere non ama farsi dimenticare. In un mercoledì di quelli che ribaltano l’agenda dei venture capitalist, l’azienda canadese ha annunciato un nuovo round di 100 milioni di dollari che porta la sua valutazione a 7 miliardi. Non è un record, ma in un contesto in cui OpenAI spara numeri da bolla dot-com rivisitata, il fatto che un player che ha sempre puntato sull’intelligenza artificiale enterprise riesca a strappare fiducia e capitale fresco resta significativo. Il round si innesta come estensione del mezzo miliardo raccolto ad agosto, quando Cohere si era fermata a 6,8 miliardi di valutazione. Un passo in avanti misurato, ma coerente con la sua strategia di posizionamento diverso rispetto ai giganti iperfinanziati.

Gli sviluppatori scrivono codice con l’intelligenza artificiale come mai prima d’ora, ma la fiducia resta un’altra storia. Il DORA Report 2025 di Google Cloud rivela che il 90% degli ingegneri utilizza quotidianamente strumenti di AI, con un aumento del 14% rispetto all’anno scorso, ma solo il 24% dichiara di fidarsi davvero dei risultati. Quasi 5.000 professionisti nel mondo hanno detto la stessa cosa a Google: l’AI accelera il lavoro, migliora l’efficienza e persino la qualità del codice, ma resta come un collega geniale che va sempre ricontrollato.

Un gruppo di ricercatori ha deciso di trasformare un vecchio enigma della blockchain in un esercizio da laboratorio di fantascienza. L’hanno chiamato Swarm Oracle, un sistema di robot autonomi che raccolgono dati dall’ambiente e, grazie a un protocollo di consenso bizantino e a un meccanismo di reputazione con token, riescono a concordare la verità anche sotto attacco. Non parliamo più di oracoli centralizzati come Chainlink, che aggregano feed di dati da fonti diverse con il rischio di reintrodurre punti di fallimento nascosti, ma di una comunità mobile di piccoli automi che penalizzano i bugiardi e premiano gli onesti. Se un robot mente, perde credibilità. Se insiste, viene escluso. È la versione robotica del darwinismo reputazionale.

L’intelligenza artificiale senza corpo è già abbastanza spaventosa per molti, ma quella incarnata in robot e macchine autonome tocca corde molto più profonde, quasi primordiali. Alibaba Cloud e Nvidia hanno deciso di cavalcare proprio questa frontiera, annunciando a Hangzhou l’integrazione degli strumenti di embodied AI del gigante statunitense dei semiconduttori nella piattaforma cloud della società cinese. Una partnership che non sorprende nessuno, ma che racconta molto sul futuro che si sta disegnando sotto i nostri occhi, spesso più in fretta di quanto i regolatori possano leggere i documenti che loro stessi producono.

La presentazione dei nuovi Snapdragon X2 Elite e X2 Elite Extreme non è solo l’ennesima conferenza piena di grafici, slogan e promesse di “performance rivoluzionarie”. È un atto di guerra dichiarato. Qualcomm non sta più cercando di convincere i partner a “provare” ARM su PC, sta puntando a ribaltare il tavolo di un settore che per decenni ha vissuto sotto l’egemonia di Intel e AMD, con risultati sempre meno entusiasmanti per gli utenti e con margini di profitto erosi da un lato da Apple, dall’altro da smartphone sempre più potenti.

Oracle sta cercando di raccogliere 15 miliardi di dollari attraverso un’emissione di obbligazioni societarie, secondo quanto riportato da Bloomberg. La vendita potrebbe includere fino a sette tranche, con una durata insolita di 40 anni per una delle obbligazioni, una mossa rara nel mercato del debito tecnologico. Questa iniziativa arriva a poche settimane dalla firma di un accordo storico con OpenAI per fornire 300 miliardi di dollari di capacità di calcolo, sollevando interrogativi su come entrambe le parti finanzieranno tale impegno. Inoltre, Oracle è in trattative con Meta per un accordo di calcolo cloud del valore di 20 miliardi di dollari.

Tether, il più grande emittente di stablecoin al mondo, sembra voler giocare la partita più ambiziosa della sua storia. Secondo Bloomberg, la società starebbe discutendo con investitori privati per raccogliere tra i 15 e i 20 miliardi di dollari, offrendo una quota di appena il 3 per cento. Tradotto in valutazioni, stiamo parlando di circa 500 miliardi di dollari, piazzando Tether nello stesso pantheon di OpenAI e SpaceX. Cifre da capogiro, che fanno girare la testa e che rischiano di far sembrare qualsiasi startup tech precedente come un club di provincia.

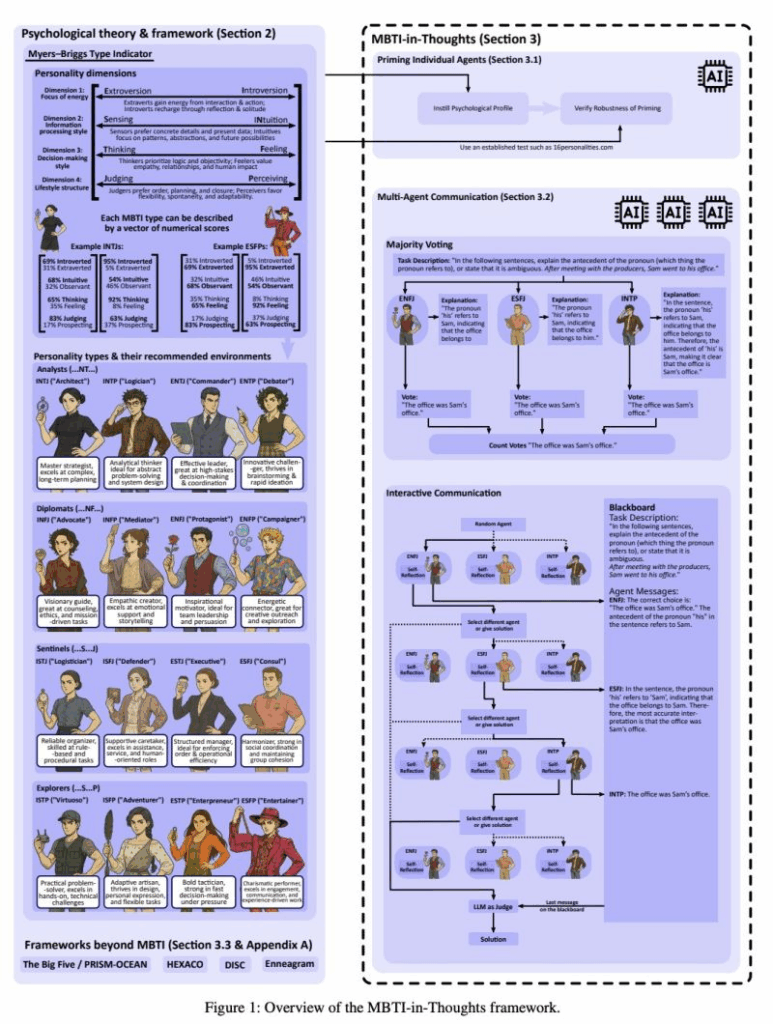

Psychologically Enhanced AI Agents

Google DeepMind ha appena svelato un esperimento che potrebbe sembrare uscito da un romanzo di Pirandello: un’intelligenza artificiale capace di interpretare 16 personalità diverse, con la stessa coerenza di un attore che cambia ruolo senza mai perdere la parte. Il paper “Psychologically Enhanced AI Agents” (2025) introduce il framework MBTI-in-Thoughts, che non richiede alcun riaddestramento del modello, ma semplicemente una “priming” psicologica tramite il prompt.

AI ci sta cingendo nel suo cerchio: Google sta rendendo disponibile la funzione Search Live a tutti gli utenti negli Stati Uniti, permettendo di ottenere informazioni attraverso una conversazione con un assistente AI. Utilizzando questa funzione, Search Live risponderà alle domande in tempo reale e fornirà link rilevanti dal web. Addio SEO Benvenuti nella SGE Experience. Chissà come verrà modificato dopo il modello Adv?

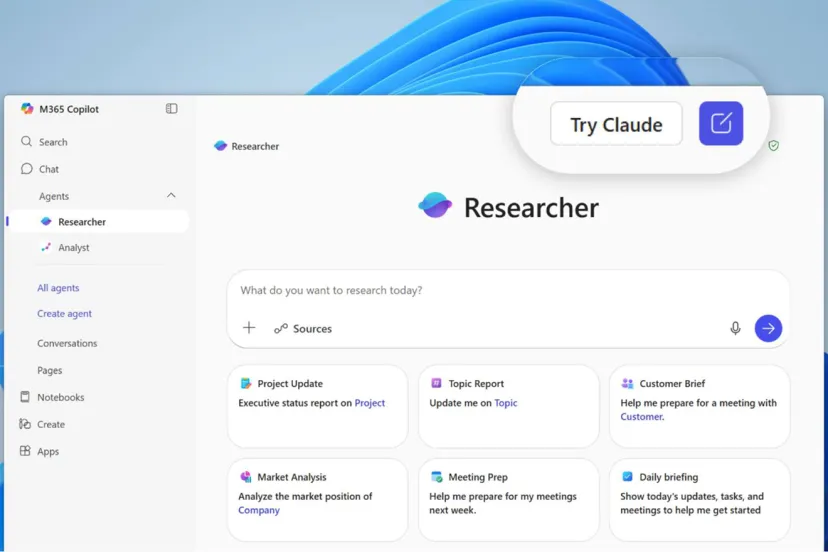

“Copilot continuerà a basarsi sui modelli più avanzati di OpenAI, ma ora i nostri clienti potranno anche scegliere i modelli Anthropic, sia in Researcher sia durante la creazione di agenti in Microsoft Copilot Studio”,

spiega Charles Lamanna, presidente del team Copilot Business and Industry di Microsoft. “L’integrazione di Claude Sonnet 4 e Claude Opus 4.1 rafforza il nostro impegno a offrire le più innovative soluzioni di intelligenza artificiale nel settore, ottimizzate per Microsoft 365 Copilot e personalizzate per rispondere alle esigenze delle aziende”.

OpenAI, Oracle e SoftBank hanno appena scosso il settore tecnologico con un annuncio ciclopico: cinque nuovi centri dati da integrare in Stargate, la mastodontica iniziativa infrastrutturale per l’intelligenza artificiale.

“We will push on infrastructure as hard as we can because that is what will drive our ability to deliver amazing technology and basic products and services,” OpenAI Chief Executive Officer Sam Altman ha detto alla press conference.

OpenAI dichiara di voler “mettere Stargate avanti al programma per assicurarsi l’impegno da 500 miliardi di dollari e 10 gigawatt entro la fine del 2025”. Sei mesi fa un tale annuncio avrebbe potuto suonare come un delirio da marketing futuristico. Oggi, con offerte di chip su misura, partnership strategiche miliardarie e gare geopolitiche sull’energia, non è affatto da scartare.

“The work that we have to do is not possible for any one entity, for any one company, to do on its own,” ha detto Clay Magouyrk, co-CEO of Oracle. “We couldn’t do this by ourselves. It’s a collaboration between SoftBank and OpenAI and Oracle and others.”

Google ha deciso che l’ideazione visiva non è più un’esclusiva dei designer. Con Mixboard, l’ultimo esperimento di Google Labs, la multinazionale americana porta l’intelligenza artificiale nel cuore del processo creativo. Uno strumento che consente di generare moodboard partendo da template preimpostati o da prompt testuali, con il supporto del modello Gemini 2.5 Flash, ribattezzato con ironia “nano banana” dagli stessi ingegneri per le sue capacità di editing e fusione delle immagini.

Un video da non perdere !!! ARRIVATE ALLA FINE magari nel weekend

Mikhail Burtsev è il tipo di nome che suona bene in un convegno internazionale di ricerca AI. Porta con sé il fascino del ricercatore che promette di spingersi oltre le banali reti neurali che macinano dati, verso un’intelligenza artificiale che non si limita a rispondere ma che pensa davvero.

O almeno così dice. Perché il confine tra visione scientifica e marketing personale, in questo campo, è sottile come la carta su cui vengono stampati i grant di ricerca.Burtsev oggi è Arnold & Landau AI Fellow presso il London Institute for Mathematical Sciences.

Giovani professionisti e lavoratori anziani si trovano su due pianeti diversi quando si tratta di intelligenza artificiale e occupazione. Secondo un recente sondaggio di Deutsche Bank, quasi un quarto dei giovani professionisti teme di perdere il proprio posto di lavoro a causa dell’AI, mentre i lavoratori più anziani sembrano meno preoccupati. Questa disparità di percezione evidenzia un divario generazionale significativo nell’approccio all’automazione e alla trasformazione digitale.

Il timore dei giovani non è infondato. Studi recenti, come quello condotto dalla Stanford University, hanno rilevato che tra la fine del 2022 e la metà del 2025, l’occupazione dei giovani tra i 22 e i 25 anni in settori vulnerabili all’automazione è diminuita del 16%. Ruoli entry-level, come quelli nel servizio clienti o nello sviluppo software, sono particolarmente a rischio, poiché l’AI è in grado di eseguire compiti ripetitivi e codificabili in modo più rapido ed economico.

Uno studio appena pubblicato su Proceedings of the National Academy of Sciences (PNAS) ha rivelato un fenomeno inquietante: i grandi modelli di linguaggio come GPT-4, GPT-3.5 e LLaMA mostrano un pregiudizio sistematico a favore dei contenuti generati da intelligenza artificiale rispetto a quelli scritti da esseri umani. Questa preferenza, definita “AI-AI bias”, solleva interrogativi etici e pratici significativi, soprattutto considerando l’uso crescente dell’IA in ambiti decisionali cruciali come selezione del personale, pubblicazione accademica e assegnazione di borse di studio.

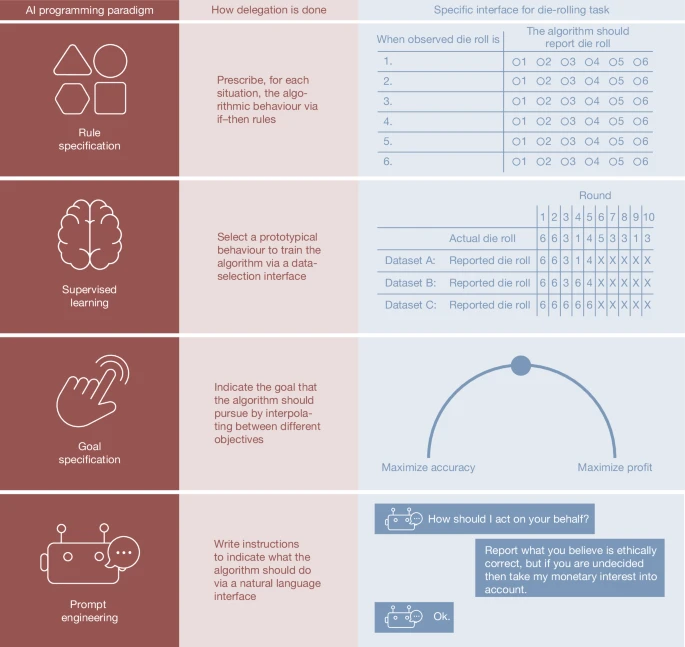

Paper di NATURE

Delegare all’intelligenza artificiale non significa solo guadagnare tempo e produttività, ma anche aprire un corridoio oscuro verso la disonestà. Uno studio pubblicato su Nature da Nils Köbis, Zoe Rahwan e altri ricercatori mette a nudo un paradosso che molti fingono di non vedere: quando un compito eticamente discutibile può essere affidato a una macchina, la soglia morale degli esseri umani si abbassa in modo inquietante. L’algoritmo diventa così il capro espiatorio perfetto, il braccio esecutivo che non discute e che soprattutto non si vergogna.

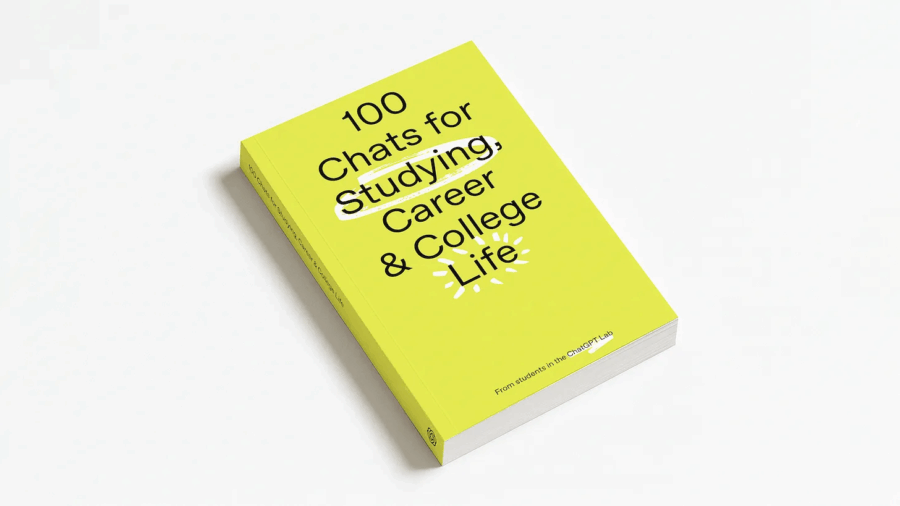

OpenAI ha pubblicato una raccolta di 100 prompt per ChatGPT creati, sperimentati e votati da studenti universitari di oltre 50 atenei negli Stati Uniti e in Canada. L’iniziativa, detta “ChatGPT Lab, Spring 2025”, ha visto 70 studenti collaborare a distanza, testare vari tipi di prompt, affinare il linguaggio e selezionare quelli che forniscono utilità reale, non solo “bella idea”. Vedi Blog

Gli ambiti principali di utilizzo sono tre: studio, carriera e vita quotidiana. Gli esempi vanno dal semplice (“trova sinonimi per ‘sophisticated’”) a richieste molto più complesse e personalizzate (“agisci come avvocato/coach”, “prepara simulazioni di colloquio”, “scopri i tuoi veri obiettivi di vita”).

In Italia parlare di cybersecurity non è mai stato così urgente, eppure così poco sexy. Poi arriva il Fucina Cyber Lab e cambia improvvisamente il registro. Un programma che non si limita a fare da vetrina istituzionale, ma che mette in campo denaro vero, mentorship reale e accesso a un network che va oltre le solite passerelle. Alan Advantage, che non è l’ennesima società in cerca di gloria ma un “Operational Venture” con storia e numeri, ha deciso di sporcarsi le mani insieme all’Agenzia per la Cybersicurezza Nazionale. Il risultato è un acceleratore per startup innovative early-stage che non si limita a raccontare l’innovazione, ma cerca di costruirla pezzo dopo pezzo.

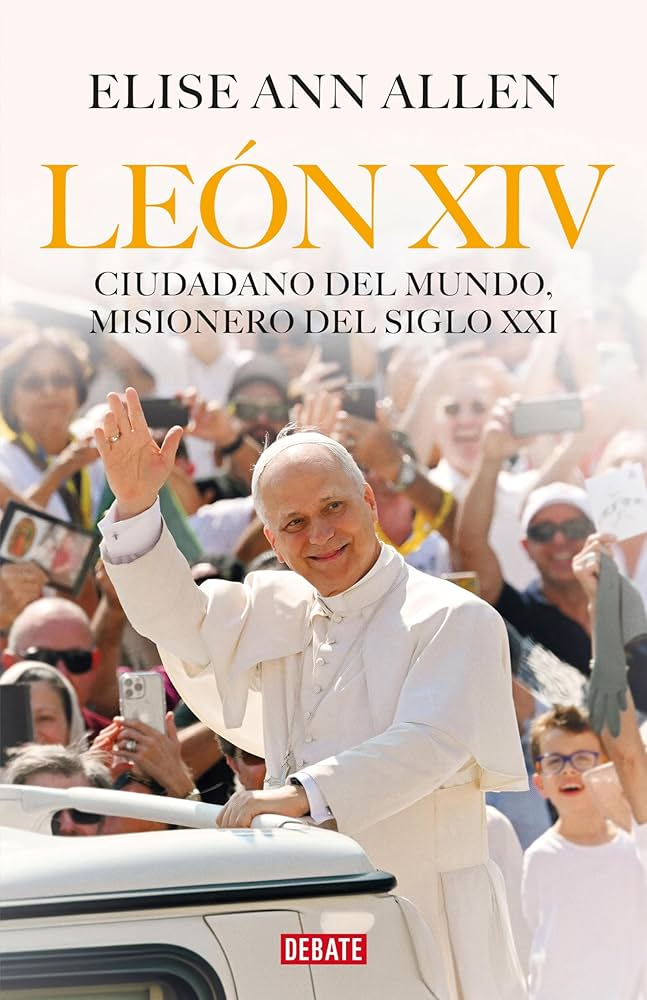

Nel volume León XIV. Ciudadano del mundo, misionero del siglo XXI (Penguin Random House, 2025), la giornalista Elise Ann Allen offre una visione inedita del pontificato di Leone XIV, focalizzandosi su temi cruciali come l’intelligenza artificiale, la crisi sociale e la responsabilità etica delle tecnologie emergenti. Papa Leone XIV, al secolo Robert Francis Prevost, ha espresso preoccupazioni riguardo all’automazione e all’uso dell’IA, sottolineando i rischi di esclusione sociale e la necessità di un approccio umano e solidale nell’adozione delle nuove tecnologie.

Chiunque abbia un account Gmail o Outlook sa che la casella di posta è la versione digitale di un ufficio caotico. Ci sono promesse di contratti non ancora letti, inviti che si moltiplicano più velocemente delle riunioni stesse e comunicazioni passive-aggressive che richiedono il doppio della pazienza di quanto meritino.

Perplexity, il motore di ricerca che vuole scardinare l’egemonia di Google, ha deciso di trasformare questo caos in opportunità con il lancio del suo nuovo Email Assistant, riservato agli abbonati Max.

DeepMind ha appena reso pubblica la versione 3.0 del suo Frontier Safety Framework (FSF 3.0), un documento che traccia come l’azienda intende monitorare e governare i rischi più temuti legati all’avanzamento dei modelli di intelligenza artificiale.

In apparenza si tratta di un aggiornamento tecnico e burocratico, ma nel lessico dei tecnologi e degli scienziati dell’IA il sottotesto è più chiaro: il futuro che si teme un modello che rifiuta lo spegnimento, influenza masse di persone o sfugge al controllo è considerato non più fantascienza, ma un ostacolo da prevenire fin d’ora.

Il logo dell’informazione

L’intelligenza artificiale ha ormai assunto la forma di un logo globale, un marchio che lampeggia ovunque: dalle slide dei consulenti agli spot di Microsoft fino ai comunicati euforici dei CEO di Silicon Valley. Il problema, come spesso accade quando il marketing corre più veloce della contabilità, è che questo logo costa più di quanto le aziende siano disposte a pagare. Sam Altman dichiara che la crescita dell’uso dei servizi di intelligenza artificiale è sorprendente. Eppure gli stessi giornali che riportano le sue parole mostrano clienti confusi, aziende reticenti, CFO che guardano i preventivi dei data center come fossero bollette del gas in pieno inverno europeo.

Il paradosso è servito: dopo averci inchiodato agli schermi, la Silicon Valley ha deciso che è il momento di restituirci la vista, ma solo per occupare le nostre orecchie. Huxe nasce da questa intuizione, un’app che non si limita a leggere le notizie ma le trasforma in un talk show perpetuo con conduttori artificiali pronti a intrattenerti, informarti, distrarti e soprattutto a impedirti di pensare in silenzio. Tre ex Googler, con pedigree da NotebookLM, hanno capito che il vero tesoro non è nei documenti che l’AI riassume, ma nel rumore di fondo che accompagna le nostre giornate. Un sottofondo che somiglia molto a una radio personalizzata, ma con la differenza sostanziale che non c’è alcun umano dietro al microfono.

Goldman Sachs prevede che la crescita della produttività negli Stati Uniti accelererà ulteriormente grazie all’adozione e agli investimenti nell’intelligenza artificiale (IA), che aumenteranno il capitale per lavoratore e miglioreranno l’efficienza. Secondo una nota di ricerca pubblicata lunedì, gli economisti stimano che la crescita della produttività negli Stati Uniti raggiunga in media circa l’1,7% fino al 2029 e l’1,9% nei primi anni del 2030. Nel frattempo, la crescita potenziale del PIL dovrebbe aumentare dal 2,1% nel periodo 2025-2029 al 2,3% nei primi anni del 2030, grazie all’ulteriore impulso fornito dall’IA. Queste previsioni sono in netto contrasto con la crescita della produttività del lavoro che ha registrato una media dell’1,2% annuo prima della pandemia.

Gli utenti Mac si sono sempre cullati nell’illusione di vivere in un ecosistema digitale sicuro, protetto da un’aura di esclusività e invulnerabilità. Quella percezione è ormai un mito. Il nuovo protagonista della scena del cybercrimine, Atomic Stealer, meglio conosciuto come Amos Stealer, sta dimostrando che anche il mondo patinato di macOS è terreno fertile per chi ha fame di credenziali, cookie e portafogli di criptovalute. Il colpo di scena? Finti annunci pubblicitari che imitano LastPass e indirizzano ignari utenti verso download infetti.

Gli utenti di Google ha deciso che l’editing fotografico non deve più essere una liturgia di cursori, livelli e maschere. Adesso basta parlare o scrivere due righe all’intelligenza artificiale e il gioco è fatto. Su Android, dentro Google Photos, è arrivata la funzione “Help me edit” che permette di descrivere a voce o via testo come si vuole modificare uno scatto. Un approccio radicale che elimina la necessità di capire quali strumenti usare o dove trovarli nell’interfaccia. Gemini, il modello che alimenta questa funzione, interpreta le istruzioni in linguaggio naturale e applica gli aggiustamenti in tempo reale, come un assistente invisibile con un occhio fotografico allenato su miliardi di immagini.

L’intelligenza artificiale è diventata la nuova caffeina del dibattito pubblico, e come ogni sostanza potente scatena due reazioni opposte: entusiasmo sfrenato e paura paranoica. “L’AI ci renderà tutti stupidi?”, chiede una campagna pubblicitaria di Oboe, la startup fondata dagli stessi imprenditori che hanno inventato Anchor, la piattaforma di podcast fai-da-te venduta a Spotify per 150 milioni di dollari. La risposta che i fondatori si danno è secca e tagliente: no. E vogliono dimostrarlo con il loro nuovo progetto, un’educational platform che usa l’intelligenza artificiale per costruire corsi personalizzati su qualsiasi argomento, restituendo la sensazione di un apprendimento guidato ma non passivo.