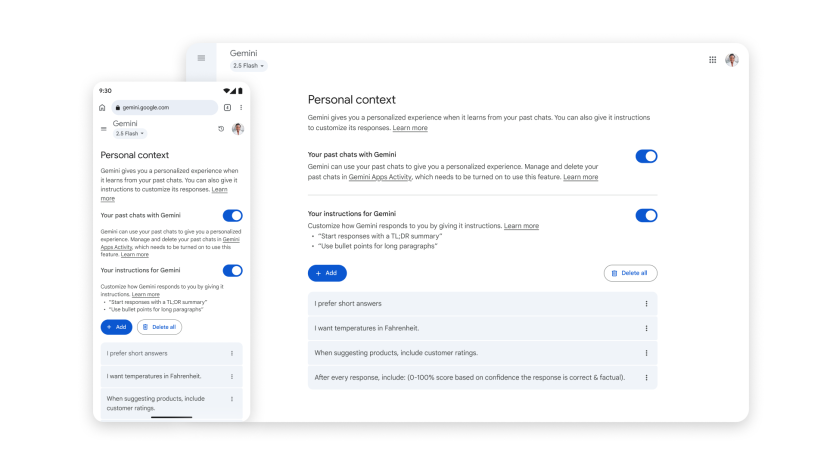

Quello che Google sta facendo con Gemini segna un passaggio cruciale nel futuro dell’intelligenza artificiale conversazionale: la memoria persistente diventa una funzione di default. Non più un’opzione da attivare a mano, ma un comportamento preimpostato, in cui l’AI “ricorda” dettagli e preferenze dell’utente per anticipare bisogni e suggerire contenuti senza richiesta esplicita. È la trasformazione della chatbot experience in un assistente personale sempre più simile a un consigliere privato, capace di collegare i puntini tra interazioni passate e domande future. Non è un cambiamento di poco conto, perché sposta il baricentro dalla semplice risposta contestuale alla vera profilazione comportamentale in tempo reale.

Tag: gemini Pagina 1 di 2

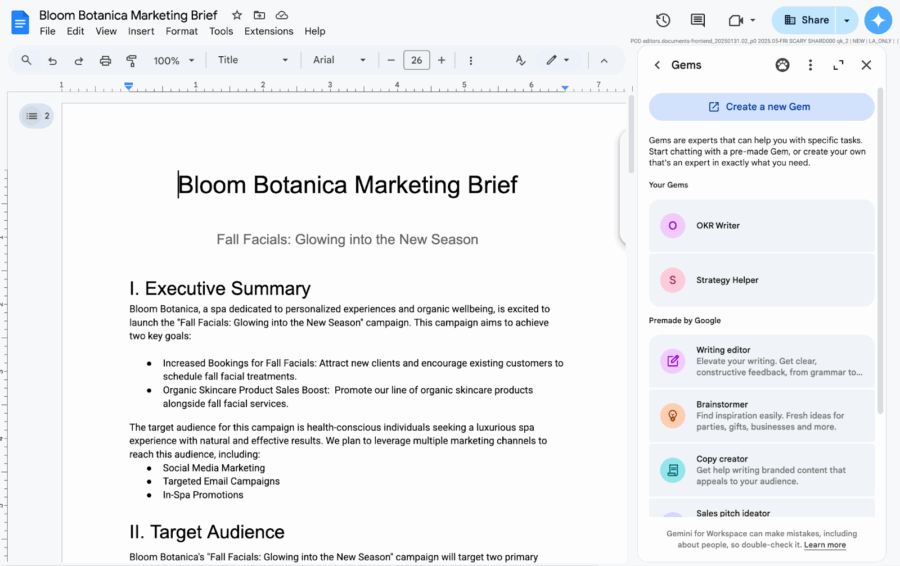

Siamo nell’epoca in cui l’intelligenza artificiale non si limita più a stare in un’app a parte, ma si insinua senza troppo riguardo nei nostri spazi digitali quotidiani. Google Workspace ha appena alzato il tiro con “Gems”, ovvero gemme personalizzate del suo assistente Gemini AI, che promettono di farci risparmiare tempo e noia senza costringerci ad aprire la tanto odiata app di Gemini. Per chi ancora non lo sapesse, Gemini è la nuova frontiera AI di Google, quella che dovrebbe – almeno sulla carta – rivoluzionare il modo in cui interagiamo con il digitale, passando dalla mera automazione al vero “potenziamento umano”.

La novità sta nel fatto che questi Gems (permettete la semplificazione, si legge più veloce) sono ora incastonati come perle nel pannello laterale di Docs, Slides, Sheets, Drive e Gmail. Non serve più fare avanti e indietro tra app diverse, basta un clic e la magia dell’intelligenza artificiale si spalanca direttamente accanto ai vostri documenti, fogli e email, come un consigliere digitale che non dorme mai.

Gemini ha superato ChatGPT: quando l’intelligenza artificiale incontra il potere della distribuzione

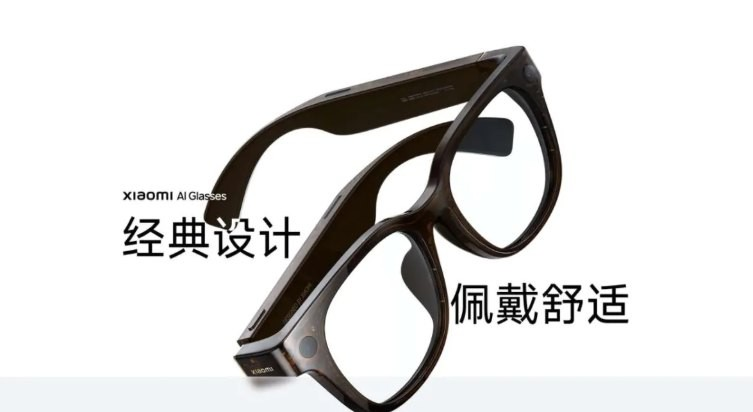

La domanda vera non è se OpenAI possa tenere il passo, ma se basti “essere migliori” quando l’avversario controlla il terreno di gioco. A maggio, Google non ha solo superato ChatGPT: ha fatto quello che i venture capitalist chiamano a systemic play. Gemini non è più un chatbot. È il nuovo middleware della vita quotidiana digitale per chi vive nell’ecosistema Android, ovvero miliardi di persone. Quando hai il controllo dell’OS, delle app, dell’auto, dello schermo e della fotocamera… non stai solo competendo, stai reimpostando le regole.

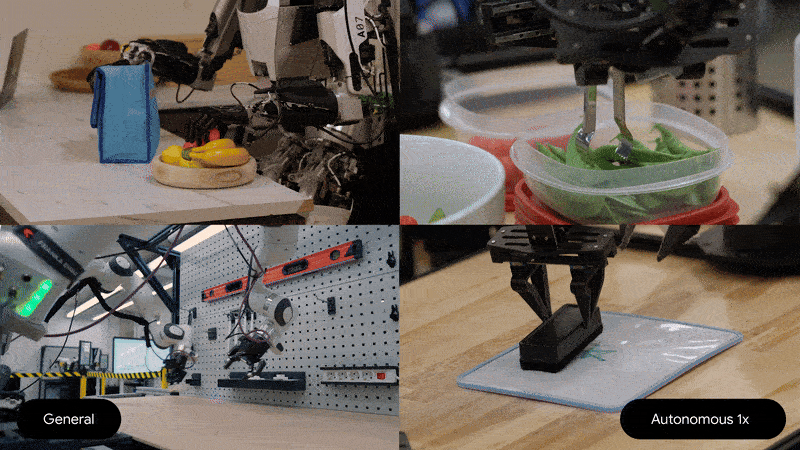

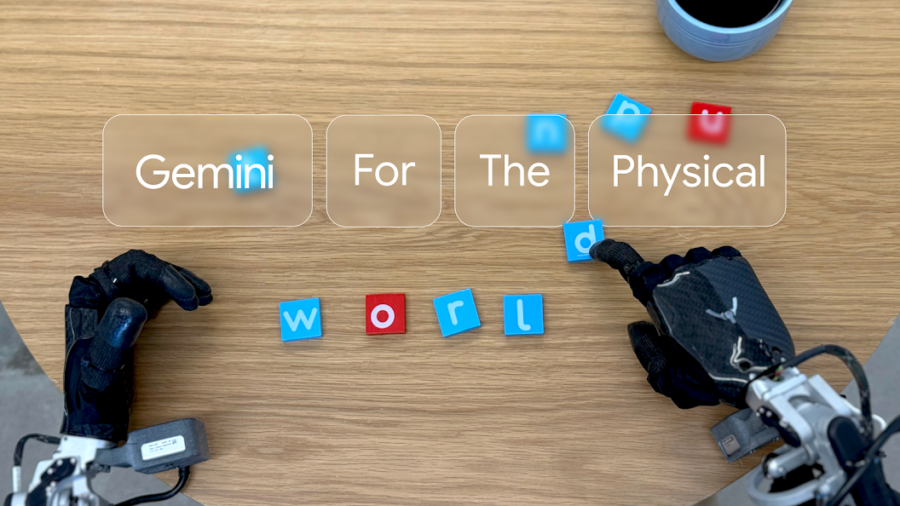

L’AI ha perso la testa. O meglio, l’ha trasferita nei nervi periferici. Perché la vera notizia non è che DeepMind abbia reso Gemini Robotics “più piccolo e più efficiente”, ma che abbia deciso di farlo vivere direttamente a bordo delle macchine, scollegandolo dalla placenta del cloud. Il nuovo modello vision-language-action di Google, annunciato come una versione on-device del già impressionante Gemini Robotics, rompe il cordone ombelicale della connettività perpetua e si installa nel corpo dei robot come un cervello portatile. Senza Wi-Fi, senza lag, senza autorizzazioni. Solo carne meccanica e sinapsi di silicio.

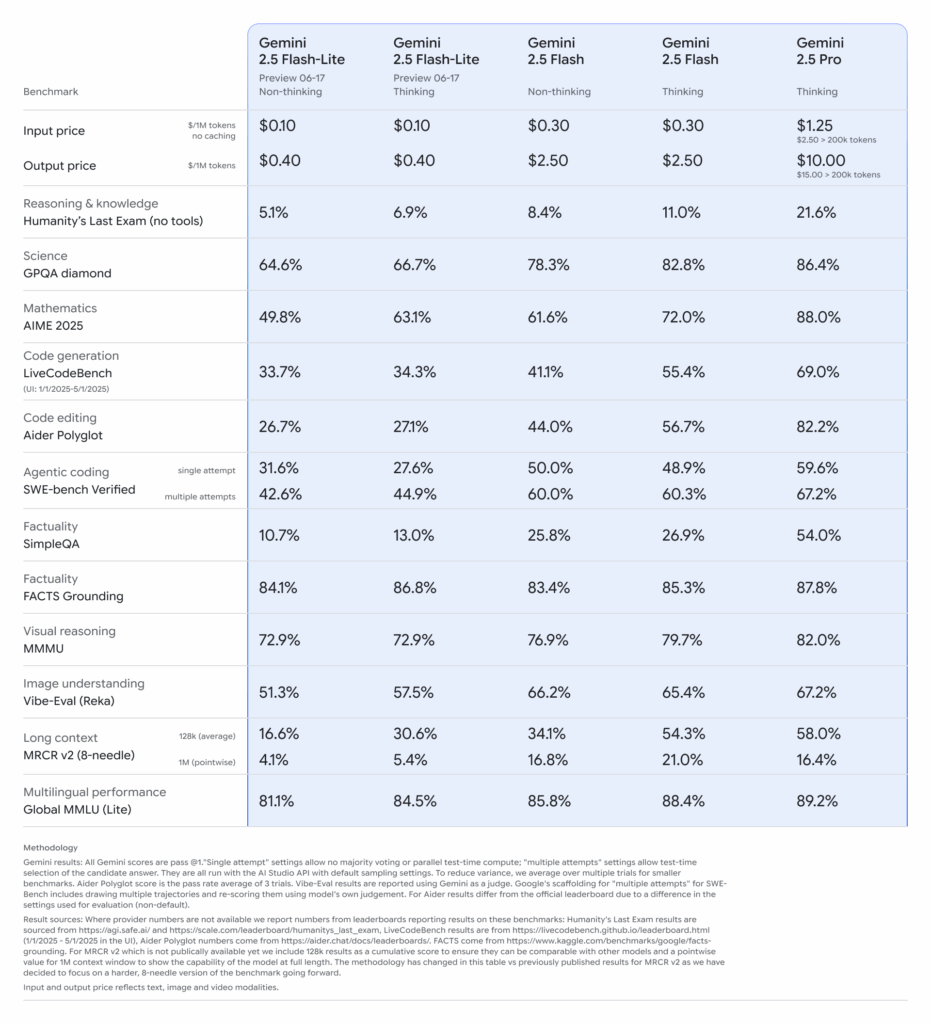

Google ha sganciato la bomba: Gemini 2.5 Pro e Flash sono ora disponibili in versione stabile, ma il vero colpo d’asta è la preview di Gemini 2.5 Flash‑Lite, un modello pensato per chi vuole ragionare in tempo reale a costi risicati.

Hai digitato una query su Google. Ti aspettavi il solito elenco di link, quella noiosa gerarchia di SEO tossico, titoli clickbait e snippet semi utili. Invece, all’improvviso, una voce calda ti sussurra nelle orecchie una sintesi personalizzata, confezionata da un’intelligenza artificiale addestrata a suonare come un mix tra David Attenborough e il tuo barista di fiducia. No, non è fantascienza. È l’ultima trovata del colosso di Mountain View: trasformare le ricerche in un podcast istantaneo. Automatico. Sintetico. Inevitabile.

Google arma Gemini di orologio e volontà: scheduled actions ecco perché l’AI non dimentica più nulla

Nel gioco a scacchi tra Google e OpenAI, la prossima mossa si gioca sul tempo. Non nel senso generico della velocità, dove ormai tutto si misura in nanosecondi computazionali, ma nel senso umano del calendario, della pianificazione, delle piccole promesse che dimentichiamo e delle abitudini che ci raccontano chi siamo. E Google, con la sua Gemini, ha deciso di diventare un assistente con memoria e agenda. Altro che segretaria virtuale: adesso sa anche quando ricordartelo.

La funzione si chiama “scheduled actions” e sembra innocua, quasi banale. Ma chi conosce la guerra delle AI sa che sotto ogni rollout in punta di codice si nasconde una visione strategica. Tradotto: l’utente potrà dire a Gemini “ricordamelo domani alle 18” o “ogni lunedì mandami idee per il blog” e l’AI lo farà. Semplice? Solo in apparenza. Perché dietro quel “lo farà” c’è il passo definitivo verso un’AI che non reagisce più, ma agisce. È questo il punto. Non è un chatbot che risponde. È un agente che prende iniziative — su tua delega, ovvio, ma comunque in autonomia operativa.

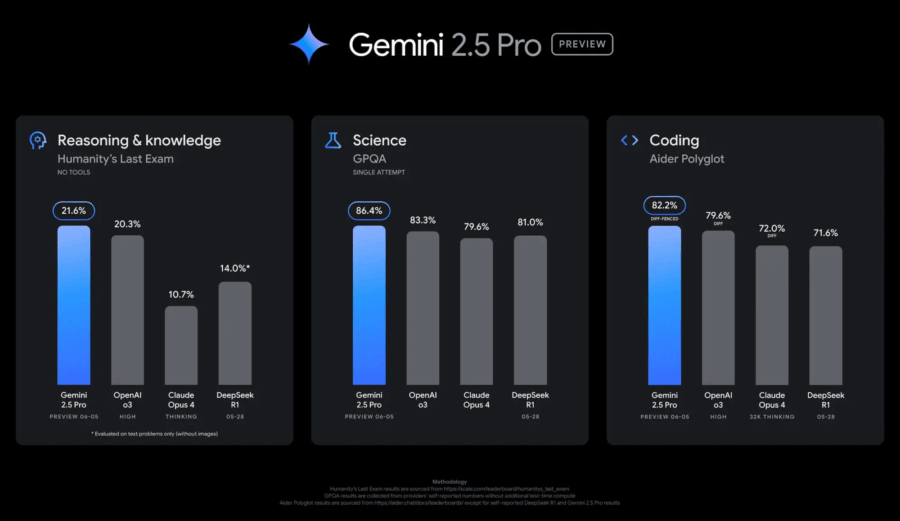

Ogni attore ha il suo momento di gloria, il suo rilascio “rivoluzionario”, la sua conferenza patinata da annunciare tra un keynote e una demo pompata a razzo. Ma oggi, finalmente, Google sembra aver smesso di rincorrere gli altri per tornare a fare scuola. Con il rilascio della versione aggiornata in anteprima di Gemini 2.5 Pro, siglata 06-05, Mountain View alza l’asticella in modo tangibile. E sì, stavolta i benchmark non mentono: stavolta è roba seria.

Partiamo da dove il dolore si sentiva di più: fuori dal mondo del coding, le release precedenti della famiglia Gemini 2.5 sembravano avvolte da una nebbia di mediocrità. Accuse non troppo velate su Reddit, sussurri negli ambienti dev più esigenti: “03-25 era più brillante”, “le nuove release hanno perso smalto”, “troppa ottimizzazione, poca anima”. Bene: con 06-05, Google prova a rimediare. E lo fa con un’operazione chirurgica sul linguaggio, sulla formattazione delle risposte e udite udite su una creatività finalmente leggibile, non più solo impressa nei prompt di marketing.

C’è un silenzioso ma potentissimo colpo di stato in atto nei corridoi digitali di Google Workspace. Lo chiamano Gemini in Drive, e la sua missione è semplice quanto devastante per l’antico rituale del “guardarsi il video della riunione persa”. Ora lo fa lui. Lo guarda lui. E ti dice anche quello che ti serve sapere, senza che tu debba perdere mezz’ora della tua vita a fissare slide mosce e volti smarriti in videocall.

La novità è semplice nella sua superficie ma profonda nel suo impatto: Gemini ora riassume anche i video archiviati su Google Drive, dopo aver già colonizzato documenti e PDF con le sue sintesi algoritmiche. C’è un chatbot, ovviamente, con quella faccia finta-amichevole da assistente che “ti aiuta”, ma dietro c’è il motore semantico di Google che comincia a comprendere i contenuti visivi e trasformarli in azione testuale.

Non mi hanno invitato al party privato di Dior Cruise a Villa Albani. Né me, né mia sorella. Una mancanza imperdonabile, lei mi ha detto questione di gerarchia, Bho..sarà il mio outfit inadeguato… cosi’ che ho deciso di sublimare dedicando la mia serata, con gli avanzi della festa di ieri sera, alla versione beta di Gemini in Chrome, l’ultima trovata di Google per convincerci che l’AI non è solo un hype, ma una presenza “agente”, onnisciente e pronta a servire. Spoiler: no, non lo è. Ma ci stanno lavorando, e molto seriamente.

L’integrazione di Gemini dentro Chrome attualmente disponibile solo per gli utenti AI Pro o Ultra e solo sulle versioni Beta, Dev o Canary del browser è presentata come il primo passo verso un’esperienza “agentica”, ovvero un’intelligenza artificiale che non si limita a rispondere, ma che agisce. L’illusione della proattività. L’assistente che “vede” ciò che c’è sullo schermo, e lo commenta. Tipo il tuo collega passivo-aggressivo che legge ad alta voce ogni riga di codice che sbagli.

Google, sempre più protagonista nell’universo della tecnologia, sta introducendo una nuova funzionalità per le famiglie, permettendo ai minori di utilizzare la sua intelligenza artificiale avanzata, Gemini, sui dispositivi Android monitorati tramite Family Link. Questo passo è stato annunciato tramite un’email inviata ai genitori, che presto vedranno i propri figli avere accesso a Gemini, un’IA progettata per assisterli in attività quotidiane come i compiti o la lettura di storie.

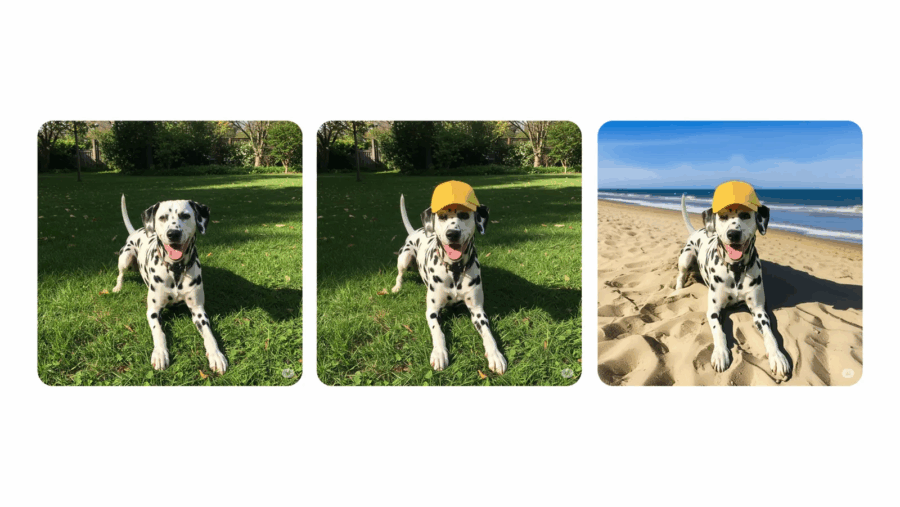

Google rilancia la sfida ad Adobe, Meta e OpenAI con un aggiornamento di Gemini che punta dritto al cuore dell’editing visivo. Da oggi, o meglio “nelle prossime settimane”, l’app Gemini sarà in grado di modificare direttamente immagini caricate dagli utenti o generate dall’AI stessa. Il tutto senza dover uscire dall’app o usare software terzi: è l’alba dell’editing nativo AI-driven secondo Mountain View.

Per capirci: carichi una foto tua, clicchi su “modifica” e puoi cambiare lo sfondo, aggiungere elementi, togliere persone, persino vedere che faccia avresti con i capelli viola. Fantascienza? No, solo la nuova normalità spinta al massimo dalla consumer AI.

Quello che si sta profilando all’orizzonte non è un semplice accordo tecnologico: è un armistizio tra titani, una tregua armata tra due delle aziende più potenti del pianeta. Google e Apple stanno per siglare un’intesa storica per integrare Gemini, il modello linguistico di Google, direttamente nei dispositivi iOS. Siri, la tanto vituperata assistente digitale di Apple, potrebbe finalmente evolversi e diventare qualcosa di più di una segreteria vocale di lusso. La conferma è arrivata in pieno processo antitrust, come spesso accade quando la verità salta fuori sotto giuramento: Sundar Pichai ha dichiarato che l’accordo con Apple per integrare Gemini dovrebbe chiudersi entro metà 2025. E il rollout? Entro fine anno.

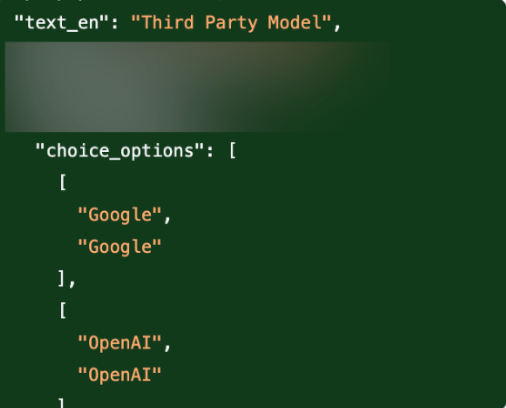

Il sottotesto è chiaro: Apple non vuole restare schiacciata tra l’entusiasmo popolare per ChatGPT e la spinta tentacolare di Google. E se l’IA è il nuovo petrolio, Cupertino non intende comprarlo solo da un pozzo. La strategia è multi-modello, pluralista, e profondamente opportunistica. Craig Federighi lo aveva lasciato intendere già lo scorso anno: l’obiettivo è offrire agli utenti una scelta tra diversi modelli di IA, Gemini incluso. Questo spiega perché nell’ultima beta di iOS 18.4 sono comparsi riferimenti espliciti a “Google” come possibile opzione all’interno di Apple Intelligence. Non è un bug, è una bandiera piantata in territorio nemico.

Quando sei il re indiscusso del motore di ricerca globale e ti ritrovi sul banco degli imputati per monopolio illegale, non combatti per la tua innocenza, combatti per mantenere il potere il più possibile intatto. Questa settimana, il processo antitrust contro Google si è trasformato in un teatrino squisitamente illuminante su come funziona davvero il capitalismo delle Big Tech. E no, non è un complotto: è tutto documentato, verbalizzato e testimoniato davanti a un giudice federale.

Peter Fitzgerald, vice-presidente delle partnership di Google, ha confermato davanti al tribunale che da gennaio Google paga Samsung una cifra mensile definita “enorme” per preinstallare l’app Gemini AI su tutti i dispositivi Samsung di nuova generazione, come se fosse il nuovo Bixby, ma con molta meno personalità e molti più dati da succhiare. E no, non è uno scherzo. La stessa Samsung, che da anni tenta di affermare il proprio assistente vocale, ha sostanzialmente gettato la spugna per un assegno a sei (forse sette) zeri.

Google si trova nuovamente al centro delle polemiche per la gestione della trasparenza e della sicurezza dei suoi modelli di intelligenza artificiale, in particolare Gemini 2.5 Pro e la nuova variante Flash. Nonostante le promesse di innovazione e affidabilità, l’azienda è stata criticata per la scarsa chiarezza nei report di sicurezza e per le pratiche di valutazione discutibili.

Il report di sicurezza di Gemini 2.5 Pro è stato definito “scarno” da TechCrunch, sollevando dubbi sulla reale affidabilità del modello. La mancanza di dettagli specifici e l’assenza di una documentazione approfondita hanno alimentato le preoccupazioni sulla trasparenza delle pratiche di Google. Inoltre, l’azienda non ha ancora pubblicato un report per il modello Gemini 2.5 Flash, annunciando che sarà disponibile “presto”, ma senza fornire una data precisa.

Quando anche i giganti cambiano idea, di solito c’è un odore nell’aria: quello della competizione che comincia a bruciare sul collo. Google aveva promesso che Gemini Live, la sua feature AI con super-poteri visivi, sarebbe rimasta un’esclusiva per chi sborsava l’abbonamento Gemini Advanced. Ma oggi, con una mossa che sa più di ritirata strategica che di generosità improvvisa, ha deciso di renderla disponibile gratuitamente a tutti gli utenti Android attraverso l’app Gemini.

La notizia è secca, quasi banale: Google sta integrando Photos con Gemini, il suo nuovo assistente AI. Ma attenzione: è solo per “un gruppo selezionato di utenti invitati”.

L’effetto è quello di una festa a cui non sei stato chiamato, ma dalla strada vedi tutto attraverso le finestre.La vera questione non è cosa fa, ma cosa promette di diventare.

L’integrazione, attualmente in rollout graduale su Android e iOS, permette a Gemini di accedere al tuo archivio fotografico e di rispondere a richieste del tipo “mostrami le foto con Mario al lago di Como” oppure “quando ho rinnovato il passaporto?” o ancora “che cavolo ho mangiato a Barcellona l’anno scorso?”.

C’è qualcosa di vagamente distopico ma irresistibilmente seducente nell’idea che un’intelligenza artificiale possa guardare quello che stiamo guardando e dirci in tempo reale cosa stiamo vedendo, consigliarci cosa comprare o addirittura dirci se quel pesce nell’acquario è un tetra o un guppy. Non è fantascienza, è il nuovo giocattolo di Google: Gemini Live. E adesso è ufficialmente in rollout, a partire da due flagship che sembrano nati per ospitare un futuro da Black Mirror: il Pixel 9 e il Galaxy S25.

L’annuncio arriva tra le righe, senza fanfare da keynote, ma con la fredda efficienza di un update che cambia le carte in tavola. Gemini Live, l’interfaccia “live” dell’ecosistema Gemini, ora consente non solo di attivare la videocamera e farsi assistere visivamente dall’AI, ma anche di condividere lo schermo del proprio smartphone. E il tutto con una naturalezza che nasconde un’enorme complessità infrastrutturale sotto il cofano. Basta un tap per passare da “scatto la foto al pesce” a “consigliami un nuovo outfit su Zalando”, con la stessa voce pacata e infallibile che ti aiuta a scrivere un’email o sintetizza una riunione su Meet.

Google ha presentato Gemini 2.5, la sua nuova famiglia di modelli di intelligenza artificiale che, a detta dell’azienda, è in grado di “pensare”. Un’affermazione audace, ma che segna un altro passo nella corsa all’AI sempre più avanzata.

Secondo il colosso di Mountain View, Gemini 2.5 è un modello progettato per il ragionamento avanzato, il che significa che non si limita a classificare e prevedere, ma è capace di analizzare informazioni, trarre conclusioni logiche, incorporare il contesto e le sfumature, e prendere decisioni informate. In sostanza, Google vuole far credere che la sua AI non si limita a rigurgitare dati, ma elabora risposte più intelligenti e contestualizzate.

L’IA va usata a scuola? Quante volte ho visto nei compiti a casa “non usate chatgpt”? Ma è giusto o sbagliato utilizzare i LLM per fare i compiti a casa?

Voglio raccontarvi la mia idea di IA e scuola.Per farlo voglio parlarvi un po’ delle cose da tutti i giorni, senza parlare di aziende, bilanci, budget e vendite, ma di compiti a casa, interrogazioni, ricerche e verifiche. Mio figlio sta facendo la terza media, e già dall’anno scorso usa Copilot e altri tool per fare i compiti a casa.

“Ah! Si fa scrivere i temi da chatgpt!” questa è la frase che mi sono sentito dire, e la risposta è “No”.

Google ha iniziato il rilascio di nuove funzionalità AI per Gemini Live, consentendo all’assistente di “vedere” lo schermo dello smartphone o l’ambiente circostante attraverso la fotocamera e rispondere in tempo reale. La conferma arriva direttamente da Alex Joseph, portavoce di Google, in un’email a The Verge. Dopo quasi un anno dalla presentazione del progetto Astra, finalmente l’azienda porta sul mercato queste capacità avanzate.

L’aggiornamento è già stato avvistato da un utente su Reddit, che ha condiviso un video dimostrativo della nuova funzione di lettura dello schermo su un dispositivo Xiaomi, come riportato da 9to5Google. Questa è solo una delle due caratteristiche annunciate da Google all’inizio di marzo e destinate agli utenti del piano Google One AI Premium, che offre accesso esclusivo alle funzionalità avanzate di Gemini.

Google ha recentemente introdotto una funzione rivoluzionaria nella sua app Gemini: le “Audio Overviews”. Questa innovazione consente agli utenti di trasformare documenti, presentazioni e rapporti dettagliati generati dalla funzione “Deep Research” in conversazioni audio in stile podcast, animate da due host AI.

Lanciata inizialmente a settembre nell’app di annotazioni AI NotebookLM, la funzione Audio Overviews ha ricevuto un’accoglienza entusiastica, spingendo Google a estenderla anche agli utenti di Gemini, sia nella versione gratuita che in quella Advanced. Questa espansione permette di convertire non solo documenti e slide, ma anche i rapporti approfonditi generati da Deep Research in discussioni audio coinvolgenti.

Google sta ridefinendo il panorama dell’intelligenza artificiale integrando il suo più grande vantaggio competitivo: la ricerca. Con il crescente numero di chatbot AI lanciati da varie aziende, Google sta sfruttando il suo motore di ricerca per rendere Gemini un assistente davvero personalizzato e intelligente. Ora, attivando la funzione di personalizzazione, Gemini può analizzare automaticamente le query e valutare se fare riferimento alla cronologia di ricerca dell’utente per migliorare la qualità delle risposte.

Questa funzionalità è alimentata dal modello sperimentale Gemini 2.0 Flash Thinking, un’innovazione progettata per rendere le risposte dell’AI più contestuali e pertinenti. Se un utente chiede consigli su ristoranti o viaggi, ad esempio, Gemini potrà consultare le ricerche recenti legate al cibo o alle destinazioni turistiche per offrire suggerimenti più mirati. Tuttavia, l’integrazione della cronologia di ricerca è opzionale e può essere disattivata in qualsiasi momento.

DeepMind, la divisione di intelligenza artificiale di Alphabet, ha recentemente presentato due modelli avanzati di IA, Gemini Robotics e Gemini Robotics-ER, progettati per potenziare le capacità dei robot nell’interazione con l’ambiente fisico.

Questi modelli rappresentano un significativo passo avanti nella creazione di macchine in grado di comprendere e agire in contesti complessi, avvicinandosi sempre più al concetto di robotica generale. Gemini Robotics, evoluzione del modello linguistico Gemini 2.0, integra visione, linguaggio e azione per consentire ai robot di adattarsi a nuove situazioni senza necessità di addestramento specifico.

Recenti sviluppi indicano che Apple sta pianificando l’integrazione di Gemini, il modello di intelligenza artificiale di Google, all’interno della sua piattaforma Apple Intelligence. Questa mossa rappresenta un passo significativo nell’evoluzione delle capacità AI dei dispositivi Apple, offrendo agli utenti una gamma più ampia di strumenti e funzionalità avanzate.

Durante il keynote della WWDC 2024, Craig Federighi, Senior Vice President di Apple, ha accennato alla possibilità di collaborare con altri modelli di intelligenza artificiale di terze parti, menzionando esplicitamente Gemini di Google come potenziale candidato. Questa apertura riflette la volontà di Apple di fornire agli utenti una scelta diversificata di strumenti AI, riconoscendo che diversi modelli possono eccellere in compiti specifici, come la scrittura creativa o la programmazione.

Google ha appena svelato Deep Research, un nuovo strumento basato sull’intelligenza artificiale che permette agli utenti di delegare la ricerca sul web al chatbot Gemini, il quale analizza autonomamente le informazioni disponibili e genera un report dettagliato. Questa innovazione rappresenta un ulteriore passo verso l’intelligenza artificiale agentica, ossia sistemi in grado di eseguire compiti complessi in modo autonomo, aprendo scenari inediti per il futuro della ricerca online.

Google ha compiuto un significativo passo avanti nell’evoluzione dell’intelligenza artificiale con il lancio dell’aggiornamento di Gemini AI, ora in grado di ricordare le conversazioni passate per fornire risposte più pertinenti e contestuali. Questa innovazione è riservata agli utenti abbonati a Gemini Advanced tramite Google One AI Premium, segnando un cambio di paradigma nell’interazione con gli assistenti digitali.

E chi l’avrebbe mai detto? L’intelligenza artificiale, quella meravigliosa creatura di Big Tech nata per rendere il mondo un posto migliore, sta finendo nelle mani sbagliate. Stando a quanto riportato da Bleeping Computer, il Threat Intelligence Group (GTIG) di Google ha fatto una scoperta che ha dell’incredibile (o forse no?): gruppi di cybercriminali sponsorizzati dai governi stanno usando Gemini per pianificare i loro attacchi con una precisione chirurgica. E non parliamo di ragazzini annoiati nel seminterrato, ma di squadre di hacker professionisti che puntano dritti alle infrastrutture critiche e ad altri obiettivi di alto valore. In pratica, invece di essere solo uno strumento di produttività, l’AI si sta rivelando un prezioso alleato per chi vuole seminare il caos.

Google ha deciso di portarci un passo più vicini al futuro, o forse ci sta solo preparando a un piccolo “game changer” per l’ennesimo esperimento, perché, ammettiamolo, l’azienda che ha visto crescere a dismisura la sua galassia di AI non sembra mai sazia. Il modello di “ragionamento” sperimentale di Gemini 2.0, capace di spiegare come giunge alle sue risposte per domande complesse, arriva oggi nell’app Gemini, sotto il nome di Flash Thinking. È l’ennesima aggiunta all’ormai infinita gamma di roll-out legati a Gemini 2.0 che Google ha annunciato con il piglio di chi ha un budget di 75 miliardi di dollari da investire in cose che, a quanto pare, chiamano AI. E sappiamo tutti quanto ai giganti della tecnologia piacciano le cifre rotonde e le promesse a cinque zeri.

Google ha recentemente lanciato una serie di spot pubblicitari durante il Super Bowl per mostrare come le piccole imprese negli Stati Uniti utilizzano Gemini AI. Tuttavia, uno degli annunci ha attirato l’attenzione degli osservatori più attenti, specialmente gli appassionati di formaggio, per un’affermazione piuttosto discutibile sulla popolarità del Gouda.

Google ha recentemente annunciato un significativo aggiornamento per la sua applicazione Gemini, introducendo il modello AI Flash 2.0. Questo avanzamento mira a fornire risposte più rapide e a migliorare le prestazioni in vari benchmark chiave, assistendo gli utenti in attività quotidiane come brainstorming, apprendimento e scrittura.

L’aggiornamento è in fase di distribuzione sia per le applicazioni web che mobili di Gemini e sarà disponibile per tutti gli utenti.er un periodo limitato, gli utenti avranno ancora accesso ai modelli precedenti, Flash 1.5 e 1.5 Pro.

Google ha recentemente introdotto una funzionalità innovativa nell’app Files, che consente agli utenti di interagire direttamente con i contenuti dei PDF attraverso l’assistente AI, Gemini. Questa integrazione rappresenta un significativo passo avanti nell’ottimizzazione della gestione dei documenti digitali su dispositivi mobili.

Per accedere a questa funzione, è necessario essere abbonati a Gemini Advanced e disporre di un dispositivo con Android 15 o versioni successive. Una volta soddisfatti questi requisiti, aprendo un PDF nell’app Files e attivando Gemini, apparirà l’opzione “Chiedi informazioni su questo PDF”. Selezionando questa opzione, l’utente può porre domande specifiche sul contenuto del documento, ricevendo risposte immediate e pertinenti. Questo elimina la necessità di scorrere manualmente pagine di testo alla ricerca di informazioni, migliorando l’efficienza e l’esperienza d’uso.

Google ha presentato Gemini 2.0, il suo nuovo modello di intelligenza artificiale, rivoluzionando il concetto di chatbot trasformandoli in veri e propri agenti AI autonomi. Questi agenti sono progettati per comprendere e svolgere compiti in tempo reale, grazie a capacità multimodali avanzate che integrano immagini, audio e strumenti nativi. Sundar Pichai, CEO di Google, ha sottolineato come questa evoluzione rappresenti un passo avanti verso l’assistente universale.

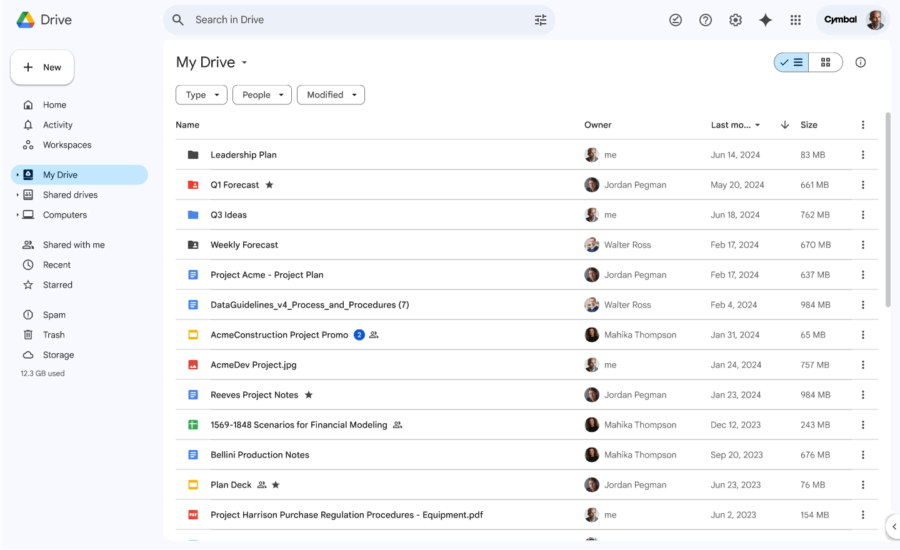

Devo ammetterlo, la gestione delle cartelle in Google Drive è sempre stata un po’ noiosa. Troppi file, troppi nomi simili, e il classico “Dove ho messo quel documento?” che ci fa perdere minuti preziosi. Ecco perché l’ultima novità di Google mi ha colpito: Gemini AI ora può riassumere l’intero contenuto delle cartelle. Sì, hai capito bene: non solo i singoli documenti, ma intere cartelle!

Spotify ha fatto un ulteriore passo avanti nel migliorare l’esperienza utente grazie all’integrazione con Google Gemini Extensions, permettendo agli utenti di cercare e riprodurre musica utilizzando richieste in linguaggio naturale. Questo sviluppo rappresenta un’evoluzione significativa nell’ecosistema delle piattaforme musicali e dei servizi di intelligenza artificiale, aprendo nuove opportunità di interazione con i contenuti digitali.

Google Workspace ha svelato una nuova funzionalità rivoluzionaria: un generatore di immagini basato su AI, alimentato dalla tecnologia Gemini, integrato direttamente in Google Docs. Questo strumento consente agli utenti di creare rapidamente immagini personalizzate per arricchire i propri documenti, avvicinandosi al concetto di “clip art su misura”, con un approccio che sfida e affianca la funzionalità simile introdotta da Microsoft nei suoi prodotti Office.

Google ha ufficialmente lanciato l’app Gemini per iOS, aprendo agli utenti iPhone l’accesso completo alla sua potente intelligenza artificiale in un’app autonoma, simile a quanto offerto su Android. Questo debutto rappresenta una svolta strategica: mentre Gemini era già integrato nella Google app, l’app autonoma introduce funzionalità avanzate che arricchiscono l’esperienza degli utenti iOS, in una mossa che mira a competere con le offerte IA di Apple.

Google ha introdotto una funzionalità innovativa nella sua suite di modelli di intelligenza artificiale Gemini 1.5, migliorando drasticamente la qualità e la precisione delle risposte generate. Attraverso la “Grounding with Google Search,” i modelli Gemini ora integrano dati aggiornati direttamente dalla Ricerca Google, consentendo lo sviluppo di applicazioni AI in grado di fornire risposte basate su informazioni verificate e in tempo reale. Questo passo rappresenta una mossa strategica di Google, proprio prima del rilascio della nuova funzione di ricerca di ChatGPT di OpenAI, posizionandosi al centro dell’evoluzione dell’intelligenza artificiale conversazionale.

Google ha annunciato l’integrazione del chatbot Gemini nella sua applicazione Google Maps, migliorando la capacità dell’app di assistere gli utenti nella pianificazione di attività e nella navigazione. Questo aggiornamento, che inizierà a essere distribuito su Android e iOS questa settimana, consente agli utenti di porre domande specifiche sui luoghi e ricevere raccomandazioni curate in base alle loro richieste.