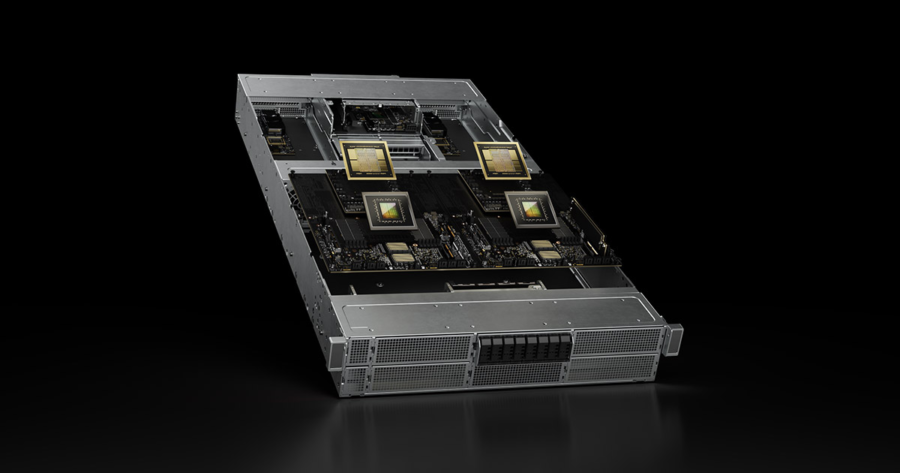

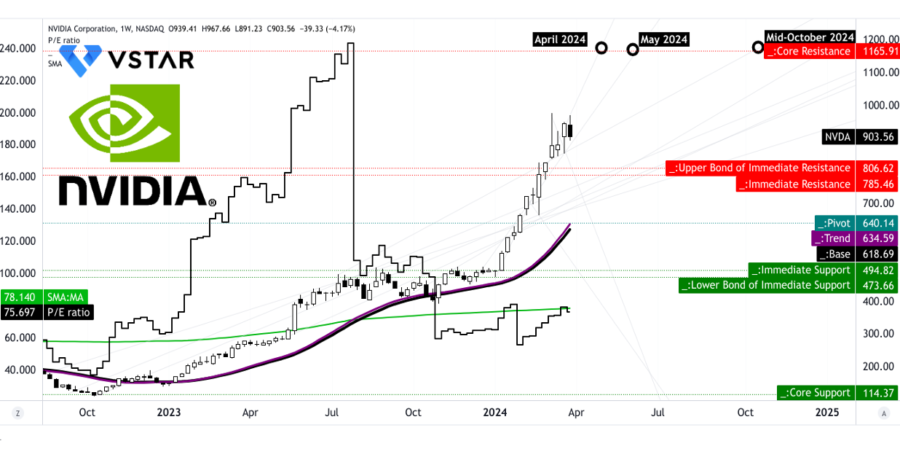

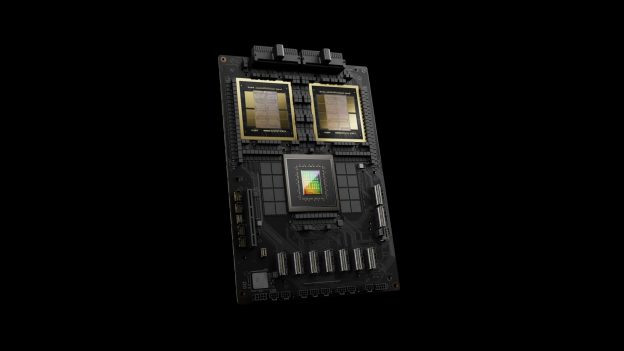

Le autorità di Singapore hanno recentemente incriminato tre uomini per frode, in relazione alla presunta vendita illegale di chip avanzati Nvidia, violando i controlli all’esportazione degli Stati Uniti. I sospettati, due cittadini singaporiani e un cittadino cinese, avrebbero esportato server contenenti questi chip verso la Malesia, sollevando preoccupazioni sul possibile aggiramento delle restrizioni tecnologiche imposte dagli Stati Uniti.

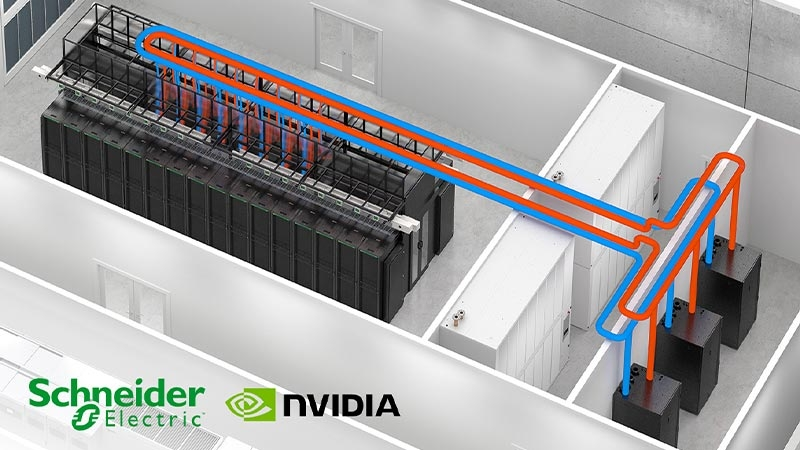

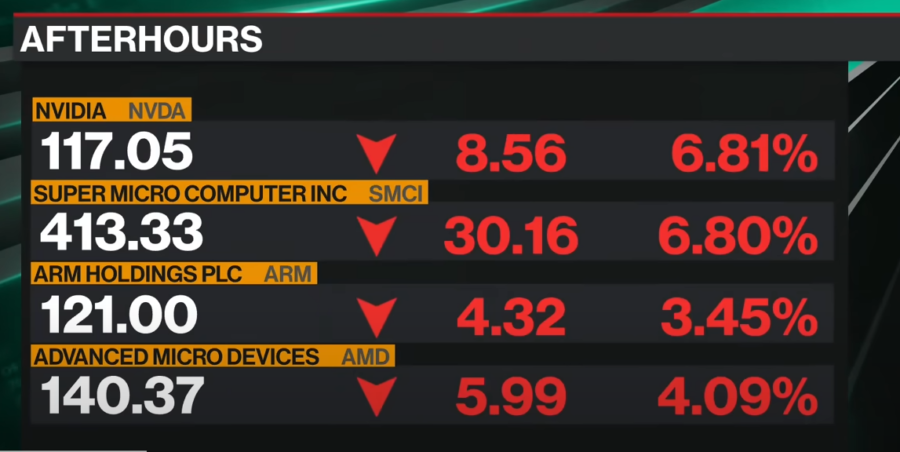

Il ministro degli Affari Interni e della Giustizia di Singapore, K Shanmugam, ha confermato che i server coinvolti potrebbero contenere chip Nvidia soggetti a controlli all’esportazione statunitensi. Questi server, forniti da Dell e Super Micro Computer, sono stati inizialmente consegnati a società con sede a Singapore prima di essere inviati in Malesia. Le autorità stanno attualmente indagando se la Malesia fosse la destinazione finale o se i server fossero destinati ad altri paesi.