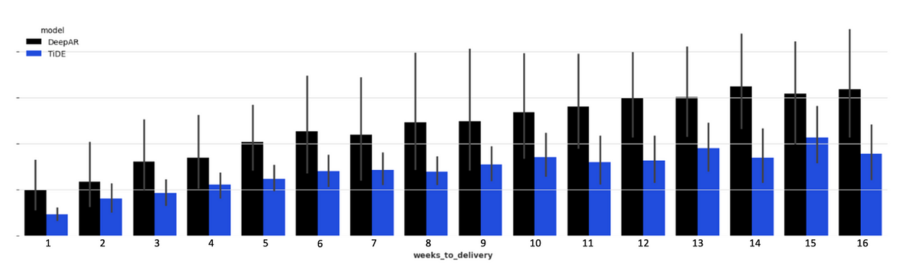

Negli ultimi anni, i modelli di previsione a lungo termine hanno guadagnato sempre più attenzione nel campo dell’intelligenza artificiale (AI) e dell’apprendimento automatico (machine learning). Questi modelli sono cruciali per una vasta gamma di applicazioni, dalle previsioni meteorologiche alle analisi economiche, passando per la gestione delle risorse energetiche e la pianificazione urbana. In questo contesto, TiDE (Time-series Dense Encoder) si è distinto come uno dei più promettenti. Sviluppato dal team di Google Research, TiDE rappresenta un passo in avanti significativo nella capacità di fare previsioni affidabili su orizzonti temporali più lunghi rispetto ai modelli tradizionali.

Autore: Dina Pagina 33 di 36

Direttore senior IT noto per migliorare le prestazioni, contrastare sfide complesse e guidare il successo e la crescita aziendale attraverso leadership tecnologica, implementazione digitale, soluzioni innovative ed eccellenza operativa.

Con oltre 20 anni di esperienza nella Ricerca & Sviluppo e nella gestione di progetti di crescita, vanto una solida storia di successo nella progettazione ed esecuzione di strategie di trasformazione basate su dati e piani di cambiamento culturale.

Nell’affascinante panorama dell’intelligenza artificiale, una nuova categoria di modelli sta emergendo come protagonista: i Modelli di Azione Avanzati (LAMs). Questi sistemi AI rappresentano un cambiamento paradigmatico, in grado di superare i limiti del tradizionale processamento del linguaggio e aprire nuovi orizzonti nell’interazione tra il mondo virtuale e quello fisico.

Quando ha segnato un decennio al vertice del potere (13 marzo 2013), era chiaro che sotto questo pontificato anticonformista, nulla sarebbe più stato lo stesso. La sua apertura, la sua passione per le riforme, il suo senso elettrico della possibilità, avevano catturato l’immaginazione del mondo e spinto l’istituzione che guida in acque inesplorate.

Era altrettanto chiaro, tuttavia, che questo affascinante papa avrebbe potuto scatenare energie che alla fine non sarà in grado di controllare.

Nonostante la sua enorme popolarità all’estero, il papa deve affrontare un nucleo determinato di opposizione interna sia da destra che da sinistra, lasciando la sua stessa istituzione lacerata, polarizzata e sempre più fragile. Un decennio di cambiamenti precedentemente impensabili ha distrutto vecchie certezze, creando un contesto in cui quasi tutto sembra possibile, compresi i risultati che l’uomo al vertice non intendeva né desiderava.

Questa potrebbe facilmente essere la descrizione di Papa Francesco in questo momento, mentre celebra il decimo anniversario della sua elezione al Soglio di Pietro.

Oggi sembra chiaro che Papa Francesco abbia enormi consensi al di fuori della Chiesa cattolica, ma un’opposizione sempre più sfrontata dall’interno. I nemici di Francesco provengono sia da una destra tradizionalista insoddisfatta della sua agenda progressista, sia da una sinistra impaziente e sempre più affamata di vera rivoluzione piuttosto che di semplici riforme.

Potentati finanziari, multinazionali, mafie, terroristi islamici, trafficanti di armi, prelati arraffoni, monsignori minacciati nel loro potere curiale, despoti avidi di ricchezze…

Francesco ha promosso una versione ecclesiastica della glasnost, sollevando vecchi tabù e incoraggiando un dibattito intenso su questioni precedentemente chiuse, dalla sensibilizzazione verso gay e lesbiche al ruolo delle donne nella chiesa, al clero sposato e questioni oltre. Anche lui ha lanciato un programma di decentramento, che ora va sotto la parola d’ordine “sinodalità”.

Francesco ha riabilitato figure emarginate sotto i papi precedenti (come i cardinali Walter Kasper Oscar Rodriguez Maradiaga) e ha invertito la rotta della Chiesa su questioni come la comunione ai cattolici divorziati risposati civilmente e la messa in latino.

La domanda ora è se riuscirà a tenere il genio nella bottiglia.

Francesco deve affrontare una forte ala destra all’interno del suo stesso sistema, compresa un’ampia fascia di dirigenti intermedi da cui dipende per governare, che temono che le cose stiano andando troppo oltre. Sebbene sia improbabile che tentino un vero colpo di stato, sono certamente inclini alla resistenza, attiva o passiva, a gran parte dell’agenda del papa.

Nel frattempo, deve anche affrontare una coorte crescente di liberali non disposti ad aspettare il permesso per attuare riforme ancora più radicali, forse in modo più evidente proprio adesso in parti dell’Europa occidentale come Germania e Belgio. Il recente voto dei vescovi tedeschi per autorizzare la benedizione delle unioni omosessuali, in aperto disprezzo delle direttive vaticane,

Certo, la Chiesa cattolica ha una forte capacità di resistenza, il cattolicesimo esiste da più di 2.000. Non importa quanto le contraddizioni sotto Francesco possano essere accentuate, è profondamente improbabile che la chiesa da lui guidata si dissolva semplicemente.

Tuttavia, la domanda rimane: la riforma moderata delineata da Francesco potrà durare, o le energie centrifughe di un’epoca profondamente polarizzata si dimostreranno così intense da rendere inevitabile una rottura?

Francesco è destinato a bere fino in fondo questo calice amaro, nel linguaggio dei Salmi? Oppure, data la resilienza relativamente maggiore del cattolicesimo e l’opportunità di imparare dall’esperienza, Francesco potrà riuscire lasciando dietro di sé un’istituzione rivitalizzata pronta ad affrontare le sue sfide con nuova energia e senso di scopo?

Quando Papa Francesco parlerà al G7 sull’intelligenza artificiale (AI), il mondo intero sarà in ascolto. Il leader spirituale della Chiesa cattolica romana ha già dimostrato di essere un pensatore progressista e rivoluzionario, e molti si aspettano che porti la stessa energia e passione alla discussione sull’AI.

In passato, ha espresso preoccupazione per l’impatto dell’AI sulla società, affermando che “la tecnologia non può essere neutrale” e che “dobbiamo garantire che l’intelligenza artificiale sia al servizio dell’umanità e non il contrario”.

Quando Papa Francesco parlerà al G7 sull’AI, ci si aspetta che affronti questioni come l’etica dell’AI, la privacy e la sicurezza, l’impatto sull’occupazione e la necessità di una regolamentazione globale. Si prevede anche che esorti i leader mondiali a lavorare insieme per garantire che l’AI sia utilizzata in modo responsabile e per il bene comune.

Ma Papa Francesco non si fermerà qui. Come leader spirituale, è anche profondamente interessato all’impatto dell’AI sulla dignità umana e sul nostro senso di identità. In un mondo in cui le macchine diventano sempre più intelligenti, cosa significa essere umani? Come possiamo garantire che l’AI non eroda la nostra umanità e i nostri valori fondamentali?

Queste sono domande difficili, ma Papa Francesco non ha paura di affrontarle. In passato, ha esortato i leader tecnologici a considerare l’impatto etico delle loro innovazioni e ha chiesto una “rivoluzione etica” nella tecnologia. Quando parlerà al G7 sull’AI, ci si aspetta che faccia lo stesso.

In un mondo sempre più dominato dalla tecnologia, Papa Francesco è una voce profetica che ci ricorda che la tecnologia non è un fine in sé, ma uno strumento per il bene comune. Ci si aspetta che sfidi i leader mondiali a pensare in modo critico sull’impatto dell’AI sulla società e a lavorare insieme per garantire che questa tecnologia sia utilizzata in modo responsabile e per il bene di tutti.

Pope Francis, now marking a decade in power, has led a transformative and unconventional papacy, pushing the Catholic Church into new territory with reforms and openness. While his popularity outside the Church remains strong, he faces growing opposition from within, both from traditionalists unhappy with his progressive agenda and liberals eager for more radical changes. His reforms, such as decentralization and addressing previously taboo issues like LGBTQ rights and women’s roles, have sparked internal polarization.

As Pope Francis prepares to speak at the G7 on artificial intelligence (AI), he’s expected to address ethical concerns, privacy, and AI’s impact on society, urging responsible global regulation. He will also focus on preserving human dignity in a tech-driven world, challenging world leaders to ensure AI serves humanity, not the other way around.

The central question remains whether his moderate reforms will endure or if internal divisions will lead to lasting fractures within the Church.

Con l’incertezza economica e geopolitica in corso, i dirigenti finanziari degli Stati Uniti hanno concentrato le loro energie sul rafforzamento degli sforzi di riduzione dei costi, rendendola la loro priorità numero uno, secondo un recente sondaggio di US Bank (USB).

Questo è un ambiente difficile per i direttori finanziari.

Making big decisions in the face of big unknowns

“Si trovano ad affrontare inflazione e tassi di interesse più elevati, incertezza politica negli Stati Uniti e all’estero, un’economia a breve termine difficile da prevedere e un’incredibile pressione per effettuare i giusti investimenti tecnologici di cui le loro aziende avranno bisogno per competere”

Stephen Philipson, responsabile dei mercati globali e della finanza specializzata presso US Bank.

Ridurre i costi all’interno della funzione finanziaria e dell’intera azienda sono le due priorità principali, secondo il quarto rapporto annuale CFO Insights della banca statunitense, che ha intervistato 2.030 dirigenti finanziari senior durante il periodo gennaio-febbraio.

Concentrarsi sulla gestione del rischio sta diventando sempre più importante per i CFO, diventando ora la terza priorità più comune. L’aumento dell’espansione delle entrate, nel frattempo, occupa una posizione modesta come la quinta questione più urgente.

Uno dei maggiori rischi che gli intervistati continuano a citare è il ritmo dei cambiamenti tecnologici.

Quasi la metà dei CFO intervistati ha affermato di dare priorità agli investimenti nella tecnologia rispetto ai tagli ai posti di lavoro come soluzione principale per tagliare le spese. L’intelligenza artificiale è la seconda priorità per gli investimenti nella funzione finanziaria (51%) dopo l’analisi dei dati (52%). In generale, i licenziamenti sono considerati quasi l’ultima risorsa quando si tratta di tagliare le spese.

Un sondaggio Coupa all’inizio di questo mese ha rivelato che, mentre il 45% dei CFO afferma di voler investire nell’intelligenza artificiale per stimolare la crescita quest’anno, l’89% di loro nutre dubbi sulla capacità della propria azienda di implementare con successo una strategia di intelligenza artificiale.

Due CFO su cinque hanno riferito che la loro sfida più grande è tenere il passo con i progressi dell’intelligenza artificiale “poiché il tasso di innovazione supera la scala umana e l’efficienza dei processi tradizionali”, afferma l’indagine Strategic CFO di Coupa.

In una lettera agli azionisti, il CEO di Amazon Andy Jassy ha sottolineato l’attenzione del colosso dell’e-commerce sulle misure di riduzione dei costi, parlando al contempo del potenziale dell’intelligenza artificiale, affermando che la società ha “trovato diverse aree in cui crediamo di poter ridurre ulteriormente i costi mentre inoltre, consegnamo più velocemente ai clienti.”

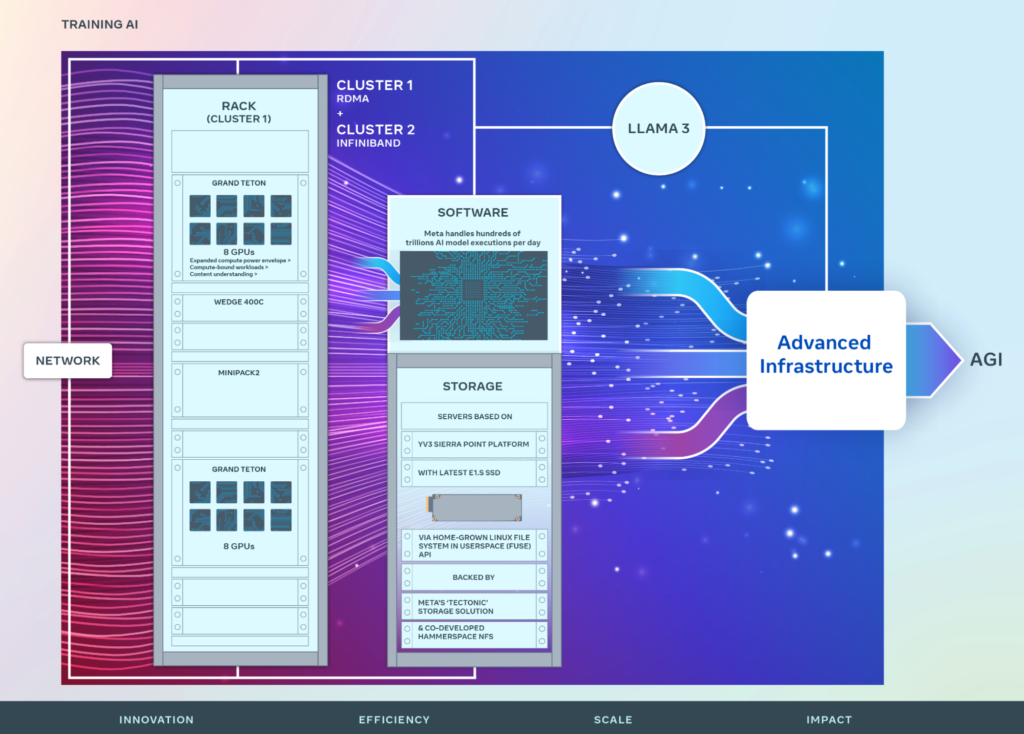

Nello spazio tecnologico, Meta Platforms ha segnalato la scorsa settimana che sarebbe stata in un ciclo di investimenti per qualche tempo mentre la corsa all’intelligenza artificiale continua. Anche se si prevede che una tale mossa aumenterà i costi nel breve periodo, Wall Street ritiene che la spesa per l’intelligenza artificiale potrebbe ripagare nel lungo termine, con Andrew Boone di JMP Securities che afferma che Meta probabilmente sarà “ben posizionata” per trarre vantaggio dall’intelligenza artificiale. aumentare il coinvolgimento e l’efficienza pubblicitaria.

Iscriviti alla nostra newsletter settimanale per non perdere le ultime notizie sull’Intelligenza Artificiale.

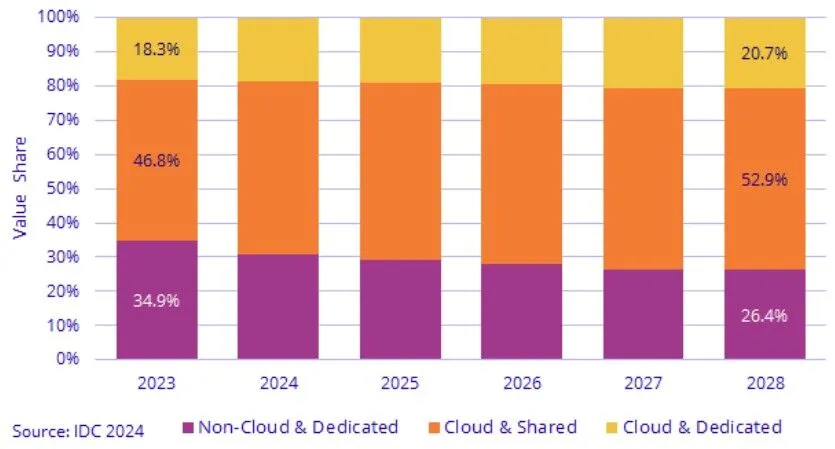

Per IDC nel 2028 il 70% della spesa in server e storage proverrà dai Cloud Provider: uno scenario molto rischioso per utenti e produttori hardware, sottolinea The Next Platform

Proprio mentre la pandemia di coronavirus si è scatenata nel primo trimestre del 2020, secondo i dati dell’IDC che abbiamo monitorato con attenzione fin dalla loro prima pubblicazione nel 2021 nel suo Worldwide Quarterly Enterprise Infrastructure Tracker, i service provider intendendo gli iperscalers, i costruttori di cloud e altri service provider che costruiscono infrastrutture per data center e vendono capacità su di essa come gruppo hanno superato il 50 percento delle entrate combinate di server e storage WW.

Avevano rappresentato più della metà delle spedizioni di unità diversi anni prima, secondo stime.

Se i prognostici dell’IDC sono corretti, quattro anni da ora, quando il 2028 sta per concludersi, i service provider come gruppo costituiranno più di due terzi delle entrate di server e storage per quell’anno.

La previsione più recente per il 2028, infatti, mostra che i service provider, che hanno acquistato 94,5 miliardi di dollari di attrezzature di server e storage nel 2023 (in aumento del 5,6 percento e dando agli SP una quota del 56,4 percento) vedranno le loro spese salire a 188,5 miliardi di dollari entro il 2028, conferendo a questo prestigioso gruppo una quota del 69,7 percento dei soldi spesi su questa attrezzatura.

Le imprese, i governi e le istituzioni accademiche hanno rappresentato 73,1 miliardi di dollari di acquisizioni di server e storage l’anno scorso, in aumento del 11,6 percento anno su anno e dando loro una quota del 43,6 percento delle spese. Ma entro il 2028, con un tasso di crescita annuo composto che è 6,4 volte più piccolo al 2,3 percento, questa quota EG&A Expenses for General and Administrative. scenderà al 30,3 percento delle spese e raggiungerà solo 82 miliardi di dollari entro il 2028.

Questo è più simile a dozzine di acquirenti di server in quella fetta maggioritaria, ma è molto più vicino a cinque acquirenti di server di quanto vorremmo.

E ci chiediamo come faranno a crescere e a rimanere finanziariamente sani i restanti OEM (Original Equipment Manufacturer, parti prodotte da una societa’ usate in un’altra) di server che servono la classe di EG&A in alcuni casi, diventare finanziariamente sani in primo luogo.

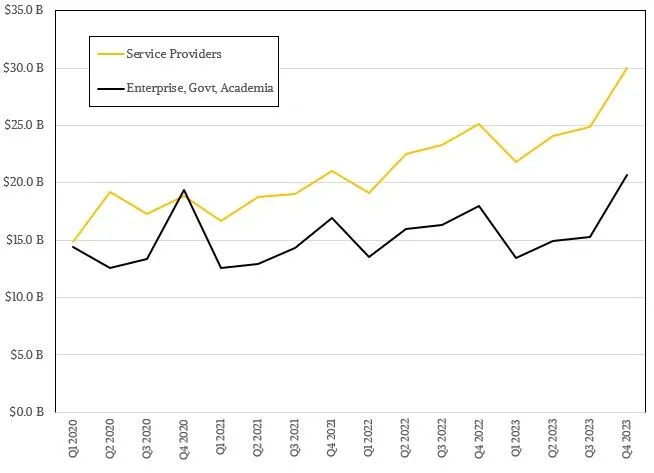

Ecco come appaiono le vendite di server e storage ai SP (Service Providers) rispetto alle EG&A negli ultimi quattro anni, che è l’unica data che abbiamo disponibile dall’IDC per queste due distinzioni:

Il divario tra le due classi di acquirenti di server e storage non sembra così grande, vero? Ma si è ampliato, in media, negli ultimi due decenni e mezzo, e ci sembra che i server AI che eseguono grandi modelli di linguaggio stiano per ribaltare l’equilibrio a partire dal 2024.

IDC non ha spiegato la differenza massiccia nei tassi di crescita nel suo rapporto pubblico, ma pensiamo che questo sia il differenziatore. E potrebbe anche accadere che gli LLM siano le killer app per i cloud, costringendo le imprese, i governi e le istituzioni accademiche a farlo sul cloud anziché lottare per il budget e gli acceleratori per i propri data center.

La crescita per SP e sEG&A è altalenante. Nessuno dei due è particolarmente lineare su base trimestrale. Ma ci sarà un divario più ampio che si aprirà se l’IDC avrà ragione.

Questi dati sono presentati dall’IDC come un modo per spiegare le vendite di macchinari per l’infrastruttura cloud, distinta dalle macchine bare metal che eseguono database relazionali e suite di applicazioni back office come ERP, SCM, CRM e altre.

(Queste sono abbreviazioni per pianificazione delle risorse aziendali, gestione della catena di approvvigionamento e gestione delle relazioni con i clienti, e sono le principali attività che svolgono la maggior parte delle imprese, che includono cose noiose come conti da pagare e ricevere e stipendi. Noi pensiamo che la gestione dello stipendio sia molto eccitante, personalmente. . . .)

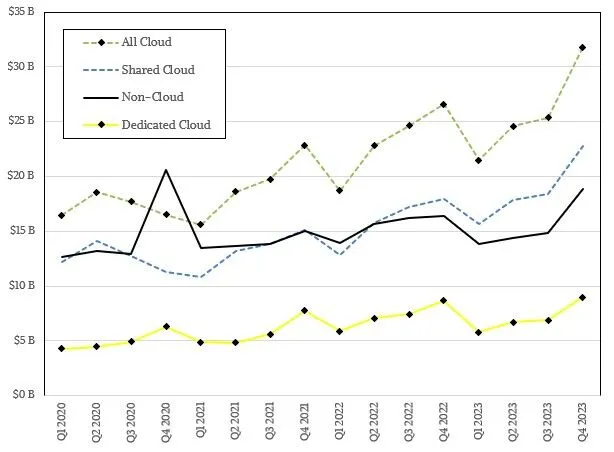

Ecco come è apparsa quella spesa per gli ultimi anni per il cloud condiviso, il cloud dedicato e gli utilizzi non cloud:

L’infrastruttura cloud condivisa è esattamente ciò che sembra: macchine vendute in modo che possano essere virtualizzate e vendute con più aziende contemporaneamente che affittano tempo su di esse. Il cloud dedicato significa che le macchine vengono vendute per essere utilizzate come macchine host nel senso più tradizionale dell’outsourcing – una scatola, un cliente – così come l’infrastruttura periferica venduta sotto un modello di prezzo cloud per le aziende da eseguire nel proprio data center o in una struttura di co-location da loro scelta. Non-cloud sono quelle noiose attività di back office che mantengono effettivamente in movimento l’economia globale.

In passato, IDC suddivideva il mercato del cloud dedicato in cloud dedicato e cloud dedicato in loco, e siamo abbastanza sicuri che lo faccia ancora, ma non lo sta più facendo nei dati che rilascia al pubblico.

Ecco una tabella mostro che riporta tutto ciò che sappiamo dell’IDC che copre il 2022 e il 2023, include anche la previsione per il 2024 e quella lontana fino al 2028:

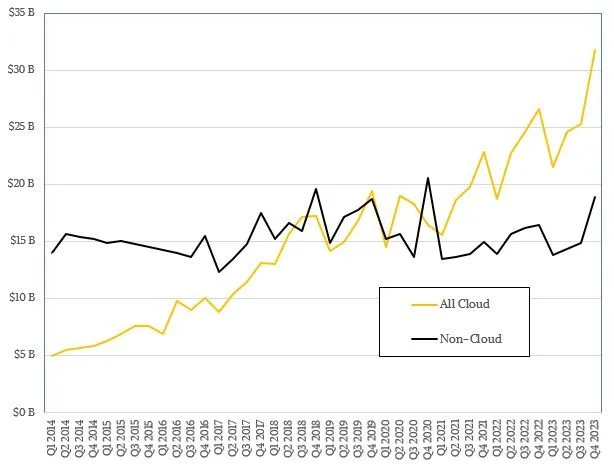

Per coloro che preferiscono un’analisi visiva, ecco un grafico del buying di server e storage cloud rispetto a non cloud dal 2014, che fa parte di un set di dati più vecchio e più ampio che abbiamo monitorato, prima che venissero suddivisi i diversi tipi di spesa cloud e prima che iniziassero a dare il breakout SP e EG&A. Date un’occhiata:

Ecco la suddivisione delle diverse tipologie di spesa cloud rispetto a non cloud:

E per completare il set, ecco un grafico a barre sovrapposte che mostra la suddivisione della spesa tra i tre tipi di casi d’uso dei clienti – non cloud, cloud condiviso e cloud dedicato – tra il 2023 e il 2028:

Quasi due decenni fa, quando è iniziata la seconda ondata di utility computing – ricordate l’ascesa dei service provider di applicazioni e del grid computing a seguito della commercializzazione delle tecnologie Internet alla fine degli anni ’90? – era importante monitorare l’ascesa del modello di consumo del cloud computing. Ma alla fine, il cloud è solo un modello di consumo. Ciò di cui abbiamo parlato all’inizio di questa storia è un cambiamento nei consumatori stessi, e questo è forse più profondo a lungo termine.

In quel più lungo del lungo termine, le imprese potrebbero perdere le competenze necessarie per gestire la propria infrastruttura mentre diventano più dipendenti dai service provider.

In quel più lungo del lungo termine, potrebbero non esserci produttori di chip, di sistemi e di storage indipendenti, e l’IT potrebbe diventare molto più costoso a causa di questo.

Potrebbero non esserci affatto acquirenti di server e neanche produttori di server. Solo cloud iperscalabili (questo è un ibrido intenzionale) che vendono accesso alle applicazioni con AI costose integrate che nessuno può replicare facilmente in un data center proprio, tutto basato sull’hardware di loro progettazione e realizzazione.

Cosa succede se la Lobby degli Hyperscalere dei costruttori di cloud non è solo quello di costruire le proprie cose, ma di impedire alle aziende e ai partner OEM di costruire un’alternativa?

Questo è ciò che accade quando il settore EG&A revenues diventa troppo piccolo, e non pensare nemmeno per un secondo che questi giganti sempre affamati non lo sappiano.

Innovazione, Digital Twin, Analisi Dati, Risultati Finanziari e Riconoscimento del Mercato.

Nell’ultimo anno, il settore tecnologico negli Stati Uniti ha mostrato progressi impressionanti, fungendo da motore fondamentale dell’espansione economica e portando il mercato azionario a nuovi massimi storici.

In particolare, settori come quello dei semiconduttori, dell’hardware dei computer, delle infrastrutture software e dei software applicativi sono emersi come risultati di spicco.

Questa notevole crescita è dovuta molto allo sviluppo e alla proliferazione delle tecnologie di Intelligenza Artificiale (AI) e Machine Learning (ML), applicazioni software all’avanguardia, che sono sempre più integrate in molti aspetti della nostra vita.

Queste tecnologie hanno rivoluzionato l’analisi dei dati e i processi decisionali, rafforzando l’efficienza e l’efficacia di vari settori. Inoltre, la crescente integrazione dell’Internet delle cose (IoT) e gli sforzi verso una connettività di rete completa e la digitalizzazione hanno spinto in modo significativo questi settori verso una redditività sostenuta.

Palantír è un oggetto immaginario presente nella trilogia de “Il Signore degli Anelli” di J.R.R. Tolkien. Si tratta di una pietra vedente, una sfera di cristallo utilizzata per comunicare a distanza e per vedere eventi lontani. I Palantír furono creati dagli Elfi nell’antichità e in seguito furono dati agli uomini di Númenor. Dopo la caduta di Númenor, i Palantír furono portati nella Terra di Mezzo e divisi tra i regni dei Dúnedain.

Palantir Technologies inc. ha sede a Denver in Colorado ed è stata fondata da Peter Thiel, Nathan Gettings, Joe Lonsdale, Stephen Cohen e Alex Karp nel 2003. Inizialmente le agenzie federali statunitensi erano i principali clienti dell’azienda per poi gradualmente servire agenzie governative di altri paesi nonché aziende private che operano in ambito finanziario e dell’assistenza sanitaria.

Palantir Technologies Inc. ha annunciato a dicembre 2023 ad esempio di aver rinnovato la sua partnership con UniCredit S.p.A finalizzata alla fornitura del sistema operativo Palantir Foundry per accelerare la trasformazione digitale della banca, aiutandola ad incrementare i ricavi e a mitigare i rischi.

Nel 2019, Shyam Sankar, Chief Technology Officer di Palantir, ha scritto di come i big data, spacciati da molti come “il nuovo petrolio”, fossero più simili a petrolio di serpente, dato l’enorme e persistente divario tra ciò che i fornitori promettevano e ciò che effettivamente fornivano.

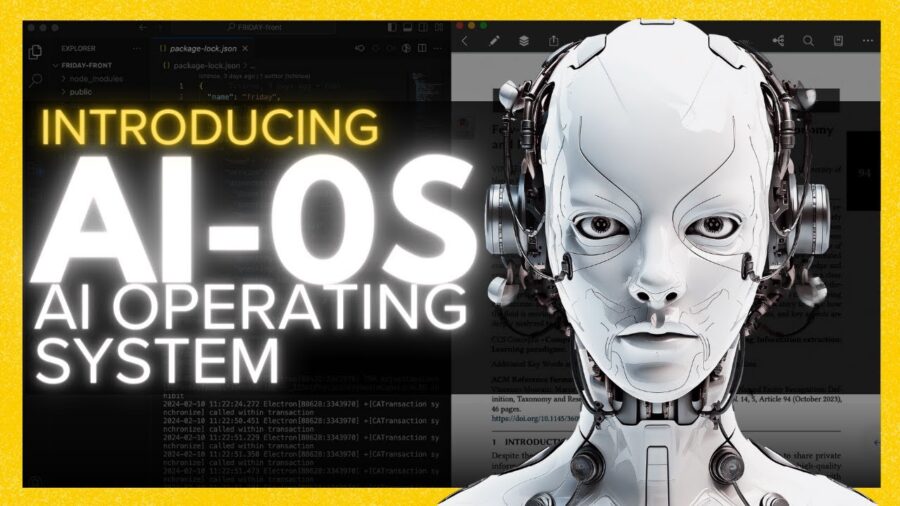

Palantir è molto forte nello spazio AI/ML proprio per il nostro sano realismo e la nostra fiducia nel valore dei sistemi rispetto a tecnologie specifiche. Abbiamo dedicato tempo ed energie alla creazione di sistemi operativi che consentano l’implementazione efficace di AI/ML nel contesto di ambienti di dati complessi con obiettivi e missioni diversi (ad esempio, AI-OS). Palantir non si concentra sulla costruzione o sulla vendita di modelli AI/ML. Non ci concentriamo sulla creazione o sulla vendita di librerie AI/ML. Palantir si concentra piuttosto sulla creazione di un sistema operativo AI che consenta a un’organizzazione di utilizzare effettivamente modelli AI/ML come parte di un ecosistema di creazione di valore e miglioramento continuo. È importante sottolineare che questo approccio a livello di sistema aiuta anche a dare vita a considerazioni contestuali, inclusa l’etica che circonda l’uso della tecnologia. In questo modo, il nostro approccio aiuta a incoraggiare un’implementazione più responsabile dell’AI/ML, o di quella che viene spesso definita “AI responsabile”.

Gran parte del nostro realismo come Rivista.AI sulle tecnologie AI/ML deriva da uno scetticismo generalizzato sul fatto che ogni singola tecnologia possa fornire la soluzione miracolosa a un determinato problema, anche quando tale tecnologia ha un reale potenziale trasformativo. Lo stesso si può dire di molte delle tecnologie specifiche che compongono un ecosistema di dati: estrazione di entità, analisi predittiva, streaming di dati in tempo reale, ecc ecc.

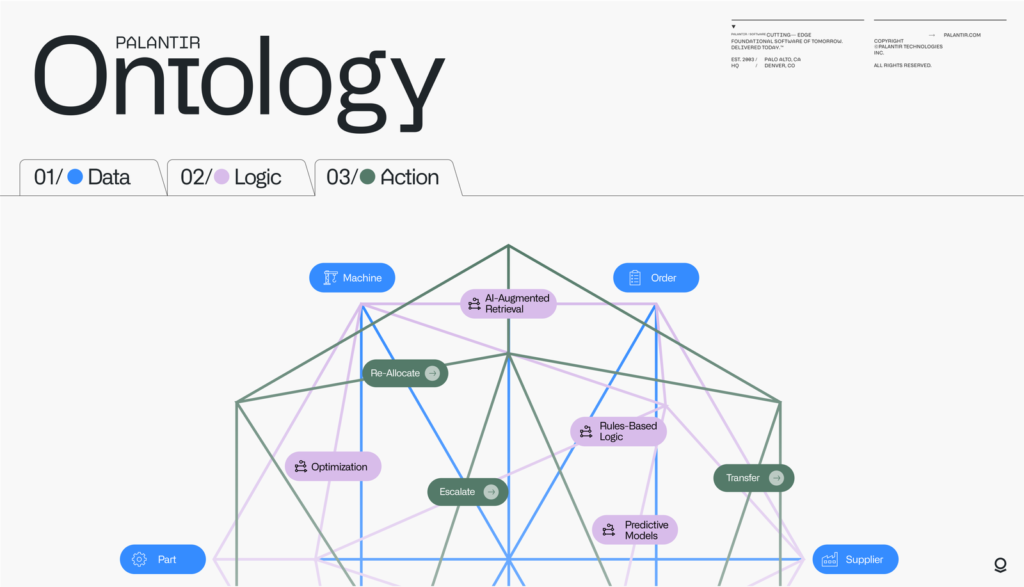

Palantir è conosciuta principalmente per le sue due principali piattaforme software, chiamate Palantir Gotham e Palantir Foundry:

Palantir Gotham: Gotham è utilizzato principalmente dalle agenzie governative statunitensi, in particolare dalla comunità dell’intelligence e dal Dipartimento della Difesa. Aiuta con l’identificazione di modelli in set di dati altamente complessi e facilita anche la facilità di collaborazione tra analisti e operatori.

Palantir Foundry : è un sistema operativo centrale per i dati organizzativi. Il suo ruolo principale è quello di aggregare origini dati isolate in un’interfaccia comune per l’accessibilità, la gestibilità e l’analisi avanzata.

La forza lavoro di Palantir è composta principalmente da data scientist e ingegneri, e al fatto che le sue operazioni non forniranno un “momento Nvidia, come hanno suggerito alcuni analisti. Si tratta di un’azienda altamente specializzata e di nicchia in un settore avanzato ma di grande valore dell’analisi dei dati per clienti d’élite e di alto profilo.

Palantir è all’avanguardia nell’innovazione dei Digital Twins. (I Digital Twins, o gemelli digitali, sono rappresentazioni virtuali in tempo reale di oggetti, processi e sistemi1. Queste repliche virtuali di prodotti fisici forniscono una fotografia dello stato del prodotto, in tempo reale. I gemelli digitali consentono, grazie a modelli predittivi elaborati da algoritmi di Intelligenza Artificiale (AI), di prevedere le prestazioni future dell’asset fisico e di sperimentare miglioramenti senza doverli testare sul prodotto stesso)

Digital Twins Interattivo: Palantir integra l’intera gamma di dati e modelli in tutta l’azienda in una rappresentazione unificata, governata e dinamica dell’organizzazione. Questo permette di scalare gli investimenti esistenti e di potenziare il processo decisionale per gli utenti non tecnici.

Digital Twins basati su AI/ML: Palantir porta in vita il paesaggio digitale con la modellazione nativa delle azioni e dei processi nell’impresa. Questo permette di avere dettagli granulari e in tempo reale su entità ed eventi del mondo reale (ad esempio, clienti, fabbriche, ordini di lavoro, spedizioni).

Simulazioni basate su Digital Twins: Palantir permette di visualizzare e quantificare la causa e l’effetto attraverso il gemello digitale dell’organizzazione, e di simulare le condizioni future per prendere decisioni ottimali e trovare cambiamenti di impatto.

Analisi Avanzate e Flussi di Lavoro: Palantir offre applicazioni come Quiver e Vertex (da non confondere con Vertex di Google) per flussi di lavoro analitici complessi e permette alle applicazioni consapevoli degli oggetti di innescare azioni sui sistemi sottostanti, con un framework completamente governato e verificabile che garantisce la coerenza attraverso tutti i flussi di lavoro.

Simulazioni e Scenari attraverso il tuo Digital Twin: Vertex ti permette di monitorare, simulare e ottimizzare le decisioni operative basate su condizioni attuali, previste o proposte. Le simulazioni possono essere supportate da semplici regole basate sulla logica, modelli fisici, modelli di deep learning o approcci ibridi.

Queste innovazioni di Palantir nel campo dei gemelli digitali stanno rivoluzionando il modo in cui le aziende utilizzano l’AI e il ML per migliorare le loro operazioni e prendere decisioni informate.

Palantir Technologies unisce la prospettiva di un successo duraturo con l’importante lavoro di difesa degli Stati Uniti.

Palantir ha illustrato come l’intelligenza artificiale può essere applicata per la difesa nazionale e altri scopi militari. L’impiego dell’intelligenza artificiale nel settore militare è un argomento di grande dibattito. In questo contesto, i Large Language Models (LLM) e gli algoritmi devono essere implementati nel modo più etico possibile.

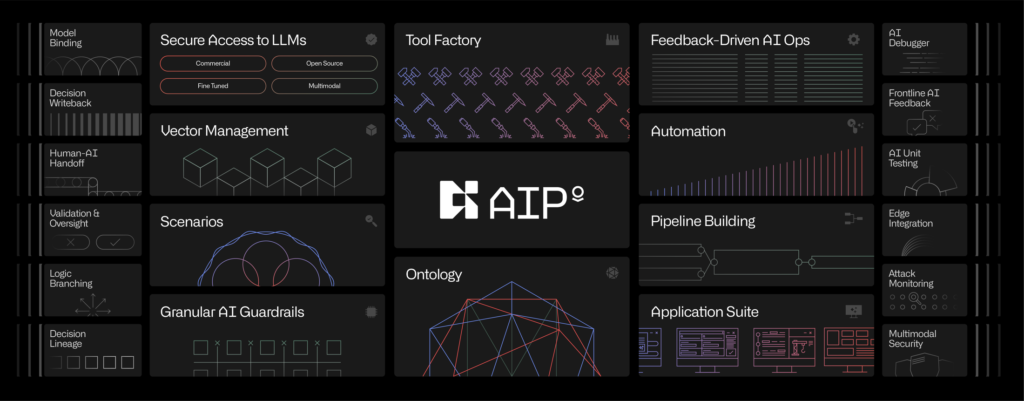

Palantir sostiene che la sua piattaforma AI (AIP) svolge un ruolo fondamentale in questo contesto. AIP offre funzionalità all’avanguardia di intelligenza artificiale e si impegna a garantire che l’uso di LLM e intelligenza artificiale nel contesto militare sia guidato da principi etici.

AIP può implementare LLM e IA su qualsiasi rete, dalle reti classificate ai dispositivi sul confine tattico. AIP collega dati di intelligence altamente sensibili e classificati per creare una rappresentazione in tempo reale dell’ambiente.

Le funzionalità di sicurezza della soluzione consentono di definire cosa possono e non possono vedere gli LLM e l’intelligenza artificiale e cosa possono e non possono fare con le funzioni sicure di intelligenza artificiale e trasferimento. Questo controllo e governance sono cruciali per mitigare i rischi legali, normativi ed etici significativi posti dagli LLM e dall’intelligenza artificiale in contesti sensibili e classificati.

AIP implementa anche guardrail per controllare, governare e aumentare la fiducia. Man mano che gli operatori e l’intelligenza artificiale agiscono sulla piattaforma, AIP genera un registro digitale sicuro delle operazioni. Queste capacità sono essenziali per un’implementazione responsabile, efficace e conforme dell’IA in ambito militare.

In una demo che mostra l’AIP, un operatore militare responsabile del monitoraggio dell’attività nell’Europa orientale riceve un avviso che l’equipaggiamento militare è accumulato in un campo a 30 km dalle forze amiche.

AIP sfrutta modelli linguistici di grandi dimensioni per consentire agli operatori di porre rapidamente domande come:

Quali unità nemiche ci sono nella regione? Assegna nuove immagini per questa posizione con una risoluzione di un metro o superiore Genera tre linee d’azione per prendere di mira questo equipaggiamento nemico Analizza il campo di battaglia, considerando un veicolo Stryker e un’unità delle dimensioni di un plotone Quanti missili Javelin ha il Team Omega?

Assegnare disturbatori a ciascuno degli obiettivi di comunicazione ad alta priorità convalidati Riepilogare il piano operativo Mentre l’operatore pone domande, LLM utilizza informazioni in tempo reale integrate da fonti pubbliche e classificate. I dati vengono automaticamente contrassegnati e protetti da contrassegni di classificazione e AIP impone a quali parti dell’organizzazione ha accesso LLM rispettando le autorizzazioni, il ruolo e la necessità di conoscenza di un individuo.

Ogni risposta di AIP conserva collegamenti ai record di dati sottostanti per consentire trasparenza all’utente che può indagare se necessario.

L’AIP libera la potenza di grandi modelli linguistici e di un’intelligenza artificiale all’avanguardia per le organizzazioni militari e di difesa, mirando a farlo con le barriere appropriate e gli alti livelli di etica e trasparenza richiesti per applicazioni così sensibili.

Questo mese Palantir e Oracle hanno annunciato una partnership strategica per ospitare e distribuire le piattaforme Palantir su Oracle Cloud Infrastructure.

L’approccio modulare di Oracle dovrebbe ridurre i costi del software e aumentare la disponibilità in regioni con leggi sulla privacy dei dati variabili.

Questa partnership potrebbe ridurre il processo di vendita di Palantir e consentire implementazioni più rapide e senza intoppi.

Questa partnership è allo stesso tempo sorprendente e no. Le offerte della piattaforma Palantir competono con le offerte OBIEE e OBIA di Oracle (business Intelligence) per la business intelligence e l’ottimizzazione aziendale. Sebbene questa partnership non fosse stata prevista, non dovrebbe essere vista come un campo di estrema sinistra come si potrebbe presumere. Gran parte del settore tecnologico ha lavorato verso l’integrazione incrociata anziché verso silos indipendenti per il bene dell’integrità dei dati, della sicurezza informatica e dell’esperienza del cliente.

Ciò può essere visto su varie piattaforme come Microsoft Azure e VMware in cui Microsoft compete su server virtuali, cyber e comunicazioni. Microsoft ha creato un percorso diretto per l’hosting di applicazioni cloud sulla piattaforma cloud di VMware per i clienti. Microsoft ha anche una partnership con Oracle con la quale la concorrenza è addirittura agguerrita sia per i data center hyperscaler che per le applicazioni ERP con la loro offerta Microsoft Dynamics.

Oracle sta costruendo oltre 20 data center in coordinamento con Microsoft Azure. Intel sta lavorando per fare lo stesso con la propria attività di manifatturiera, disaccoppiando il processo di progettazione e produzione entro la fine dell’anno per produrre set di chip avanzati della concorrenza.

La partnership tra Oracle e Palantir consentirà un’implementazione più fluida delle piattaforme Palantir in cui Foundry sarà ospitato su Oracle Cloud Infrastructure e Gotham e le piattaforme AI distribuibili sulla rete cloud distribuita di Oracle. Questa partnership porterà grandi benefici ad entrambe le aziende nonostante il fattore concorrenza. Credo che il management di Oracle possa vedere le applicazioni di Palantir come una potenziale minaccia per il core business del software di Oracle poiché le applicazioni AI e decisionali di Palantir potrebbero essere preferite rispetto alle applicazioni BI di Oracle.

Credo inoltre che il management di Oracle sia sufficientemente lungimirante da vedere la scritta sul muro e preferirebbe prendere una fetta della torta invece di perdere tutta. Prevedo inoltre che questa partnership aprirà le porte a Oracle per attirare vendite verso i governi sovrani mentre cercano di implementare applicazioni abilitate all’intelligenza artificiale. Considerate le profonde radici di Palantir in tutti gli enti governativi, credo che questa partnership strategica porterà benefici ad entrambe le aziende nei rispettivi rispettivi ambiti.

Di seguito un Esempio di Palantir Digital Twins :

Iscriviti alla nostra newsletter settimanale per non perdere le ultime notizie sull’Intelligenza Artificiale.

Google fa la storia chiudendo sopra i 2 trilioni di dollari.

Venerdì le azioni di Alphabet si sono mosse nettamente in rialzo – +10% – dopo che un rapporto sugli utili ricevuto dagli investitori segnalava (insieme a quello di Microsoft) che il lungo trade in Big Tech era decisamente ancora acceso.

Abbiamo visto non solo ha visto la forza del rapporto in una ripresa della pubblicità digitale, ma anche molteplici catalizzatori per un altro passo avanti nel prossimo futuro, tra cui la continua forte crescita degli annunci digitali, il probabile azzeramento della stima degli utili per azione, la possibilità per Alphabet il riacquisto fino al 4% delle sue azioni in circolazione e un nuovo dividendo che potrebbe portare una nuova classe di acquirenti.

Non solo i risultati sono stati ottimi, ma Google sta “lentamente voltando una nuova pagina ed emergendo di nuovo in testa nell’accesa corsa all’intelligenza artificiale”.

Guardando al futuro, la disponibilità generale della Search Generative Experience dell’azienda potrebbe diventare un fattore critico di espansione multipla:

“Crediamo che l’eventuale integrazione di SGE nella Ricerca Google sarà fondamentale per rafforzare la rilevanza del motore man mano che i tradizionali formati di risposta alle query migrano gradualmente verso formati di intelligenza artificiale generativa”.

I ricavi sono saliti a 80,54 miliardi di dollari, superando facilmente il consenso di 78,7 miliardi di dollari. I ricavi pubblicitari sono aumentati del 13% a 61,7 miliardi di dollari.

Nel frattempo, le entrate pubblicitarie di YouTube – in precedenza motivo di preoccupazione – sono aumentate del 21% arrivando a 8,09 miliardi di dollari. I ricavi da abbonamenti, piattaforme e dispositivi sono aumentati del 18%.

E lo slancio nel cloud è continuato, con una crescita dei ricavi del 28% e un utile operativo più che quadruplicato anno su anno.

L’utile operativo è aumentato del 46% su base annua, raggiungendo i 25,47 miliardi di dollari. L’utile per azione è stato di 1,89 dollari contro gli 1,50 dollari previsti da Wall Street. Anche il margine operativo è aumentato, al 32% rispetto al 25% di un anno fa.

“I nostri risultati nel primo trimestre riflettono le ottime prestazioni di Ricerca, YouTube e Cloud”, “Siamo a buon punto con la nostra era Gemini e c’è un grande slancio in tutta l’azienda.”

CEO S. Pichar

Nel frattempo, “l’accelerazione della crescita e del rialzo della ricerca nel secondo trimestre è stato il secondo fattore positivo del sentiment di ricerca che stavamo cercando e riteniamo che Google I/O a maggio possa mettere in mostra le capacità di intelligenza artificiale di Google per gli sviluppatori mobili”.

Il contenuto del presente articolo deve intendersi solo a scopo informativo e non costituisce una consulenza professionale. Le informazioni fornite sono ritenute accurate, ma possono contenere errori o imprecisioni e non possono essere prese in considerazione per eventuali investimenti personali. L’articolo riporta esclusivamente le opinioni della redazione che non ha alcun rapporto economico con le aziende citate.

Come evitare “un nuovo colonialismo digitale”

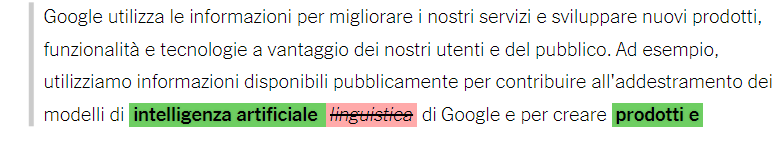

Non è possibile parlare di “AI per tutti” (la retorica di Google), di “AI responsabile” (la retorica di Facebook) o di “distribuire su larga scala” i suoi benefici (la retorica di OpenAI) senza riconoscere e affrontare onestamente gli ostacoli che si frappongono.

Ora una nuova generazione di studiosi sta sostenendo una “AI decoloniale” per restituire il potere dal Nord del mondo al Sud del mondo, dalla Silicon Valley alle persone. Per non rendere le Nazioni dipendenti e indebitate con le corporations e dipendenti tecnologiche dal silicio. La spesa ICT nel settore business in Italia ha raggiunto a fine 2023 quasi 39 miliardi di euro (secondo i dati Assintel) e di questo valore, una fetta intorno al 30% va “oversea“.

La nostra speranza è che questa articolo possa fornire uno spunto su come potrebbe essere l’Intelligenza Artificiale decoloniale e un invito alla riflessione, perché c’è molto altro da esplorare.

Sappiamo che l’Intelligenza Artificiale sta rivoluzionando il mondo industriale. Tuttavia, in Italia, molti si chiedono come sia possibile finanziare questa nuova rivoluzione industriale se si è sommersi dai debiti.

Ristrutturazione del debito: prima di tutto, è importante affrontare la questione del debito, perché l’equazione è la seguente:

Debito = < Investimenti in AI

Una delle ragioni principali per prepararci un’altra ondata di crisi del debito italiano è che tutti i fattori che potrebbero consentire al bel Paese di ridurre il proprio debito si stanno ora muovendo nella direzione sbagliata.

Per il 2024 l’Italia prevede un debito pubblico in rapporto al Pil sostanzialmente stabile rispetto al 2023, rimanendo il secondo più elevato (140,1 per cento) dopo la Grecia (152,2 per cento), l’economia italiana è circa dieci volte più grande di quella della Grecia e ha un mercato dei titoli di Stato da 3mila miliardi di dollari. Se la crisi del debito greco del 2010 ha scosso i mercati finanziari mondiali, quanto potrebbe farlo una eventuale crisi del debito italiano oggi?

Quando si tratta di valutare le prospettive economiche italiane, faremo bene a ricordare il famoso :

Se qualcosa non può andare avanti per sempre, si fermerà.

Herb Stein:

Se mai questo aforisma è vero, lo è per quanto riguarda la continua capacità dei Governi in Italia di emettere una quantità sempre maggiore di debito per coprire il proprio deficit di bilancio. Ciò è particolarmente vero quando ci sono poche prospettive che l’Italia possa mai ridurre l’entità della sua montagna di debito pubblico.

Una delle ragioni principali per prepararci ad un’altra ondata di crisi del debito italiano è che tutti i fattori che potrebbero consentire al nostro Paese di ridurre il proprio debito si stanno ora muovendo nella direzione sbagliata. Ciò deve essere particolarmente preoccupante se si considera che il rapporto debito pubblico/Pil di oggi è pari al 145%, ovvero circa 20 punti percentuali in più rispetto al periodo della crisi del debito italiano del 2012.

Per pura questione aritmetica, i tre fattori che potrebbero migliorare il peso del debito pubblico di un Paese sono un sano avanzo di bilancio primario (la differenza tra la spesa pubblica e le entrate tributarie ed extra-tributarie al netto degli interessi da pagare sul debito), tassi di interesse più bassi e un ritmo più rapido di crescita economica. Sfortunatamente, nel caso attuale dell’Italia, tutti e tre questi fattori vanno nella direzione opposta.

Nel frattempo, lungi dallo sperimentare una rapida crescita economica, l’economia italiana sembra essere sul filo di un’altra recessione economica anche grazie alle conseguenze della stretta monetaria della BCE per riprendere il controllo dell’inflazione. Una simile recessione difficilmente ispirerebbe fiducia nella capacità dell’Italia di riuscire a ridurre il proprio debito. Senza contare che dall’adesione all’Euro nel 1999, il livello del reddito pro capite italiano è rimasto pressoché invariato.

Fino a poco tempo fa, il nostro Paese aveva avuto poche difficoltà a finanziarsi a condizioni relativamente favorevoli nonostante la montagna di debito pubblico. Ciò è dovuto in gran parte al fatto che, con il suo programma quantitativo aggressivo, la BCE ha coperto quasi la totalità del fabbisogno netto di indebitamento italiano. Tuttavia, dal luglio 2023, la BCE ha completamente interrotto i suoi programmi di acquisto di obbligazioni. E ciò rende l’Italia molto più dipendente dai mercati finanziari per soddisfare le proprie esigenze di prestito.

Sfruttare le sovvenzioni e gli incentivi fiscali: l’Italia, come molti altri Paesi, offre una serie di sovvenzioni e incentivi fiscali per le aziende che investono in tecnologia e innovazione.

Secondo l’Osservatorio sulle politiche in materia di AI dell’OCSE, numerosi Paesi e territori, inclusa l’Unione Europea, hanno introdotto iniziative per le politiche sull’Intelligenza Artificiale .

Anche l’Italia ha fatto la sua parte, pubblicando tre piani programmatici multisettoriali nel 2020 e nel 2021.

Il primo è stato reso ufficiale dal Ministero dello Sviluppo Economico durante il Governo Conte II, mentre il secondo è stato diffuso congiuntamente dal Ministero per l’Innovazione Tecnologica e la Transizione Digitale, dal Ministero dello Sviluppo Economico e dal Ministero dell’Università e della Ricerca durante il Governo Draghi e per ultimo il piano annunciato dall’attuale Premier Meloni assieme al un coinvolgimento di Cassa Depositi e Prestiti.

Il fatto che siano stati necessari 3 piani in così poco tempo potrebbe essere attribuito all’instabilità politica dell’Italia e alla volontà del nuovo Governo di adattare le politiche sull’AI al nuovo contesto politico. In ogni caso, nel frattempo abbiamo nominato, ovviamente, 3 commissioni diverse, quindi abbiamo “parzialmente” ricominciato tutto da capo ogni volta.

Ora, ancora una volta il successo della nuova strategia nazionale dipende dall’attuazione di queste nuove iniziative, poiché sono strettamente interconnesse.

Sulla carta c’è un fondo da un miliardo sull’Intelligenza Artificiale. È forse questo l’investimento più atteso del piano industriale 2024-28 di Cdp Venture Capital sgr.

Ma quale è la situazione lato imprese?

In Italia, circa la metà delle grandi aziende (49%)

Osservatorio Artificial Intelligence

ha iniziato a riflettere sulle potenzialità e sugli impatti della Generative AI e il 17% ha già all’attivo

progettualità sul tema. Le piccole e medie imprese, invece, rimangono per lo più escluse dal percorso:

soltanto il 7% sta riflettendo su potenziali applicazioni e, ancor meno (2%) ha concretamente attivato

effettive sperimentazioni o iniziative.

Come faccio ad aumentare questi numeri senza ingenti investimenti pubblici, si controllati per non prendere scivoloni come per il super bonus, ma non iper burocratizzati?

Abbiamo a disposizione 1 miliardo contro i 7 della Germania e della Francia e guardando al Regno Unito, anche se fuori dall’UE, notiamo che è il terzo mercato di Intelligenza Artificiale al mondo dopo Stati Uniti e Cina, con una valutazione attuale di 21 miliardi di dollari, che si stima raggiungerà i mille miliardi di dollari entro il 2035.

Al di fuori dei confini UE notiamo altresì che la tecnologica locale di Israele si è affermata in prima linea nello sviluppo dell’Intelligenza Artificiale, raggiungendo 11 miliardi di dollari di investimenti privati tra il 2013 e il 2022 (Mirae Asset), il quarto più alto al mondo.

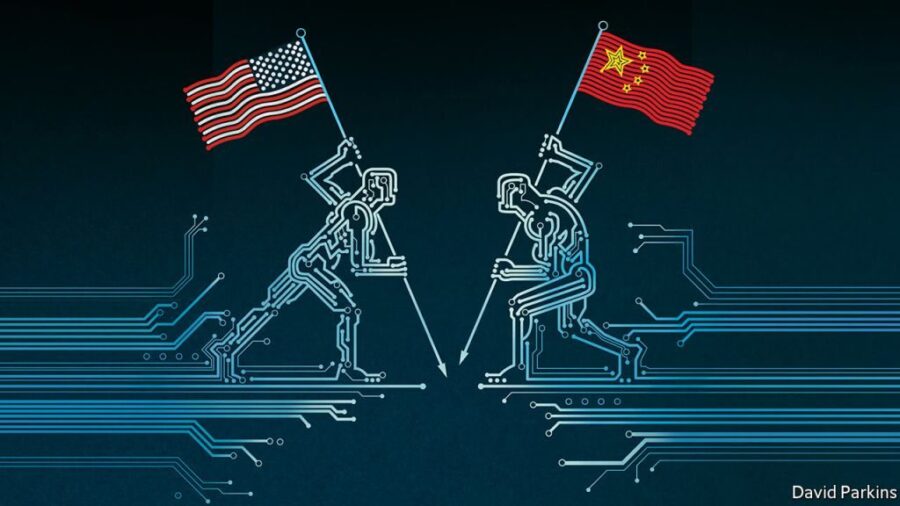

Ovviamente gli Stati Uniti sono il paese più prolifico nella ricerca sull’Intelligenza Artificiale, con Macro Polo che rileva che quasi il 60% dei ricercatori di “alto livello” sull’Intelligenza Artificiale lavora per Università e aziende americane, e Mirae Assets che suggerisce che fino ad oggi sono stati raccolti 249 miliardi di dollari in finanziamenti privati.

Non ci sorprende infine che il secondo contributore più significativo alla ricerca sull’Intelligenza Artificiale al mondo sia la Cina, che ha l’11% dei ricercatori di alto livello impegnati sull’Intelligenza Artificiale (Macro Polo), 232 investimenti legati alle tematiche dell’AI nel 2023 e che ha raccolto 95 miliardi di dollari in investimenti privati tra il 2022 e il 2023 (sempre secondo i dati Mirae).

Sembrerebbe una battaglia con i fucili di legno a guardarla così, sia per il nostro Paese ma anche per l’UE nel suo complesso:

Guardando all’adozione da parte delle organizzazioni, circa 6 grandi imprese su 10 (61%) dichiarano di avere

Osservatorio Artificial Intelligence

all’attivo – almeno a livello di sperimentazione – progetti di Intelligenza Artificiale. L’adozione scende al 18%

tra le piccole e medie imprese (+3 punti percentuali rispetto al 2022). L’adozione nelle imprese è dunque

sostanzialmente stabile rispetto al 2022, ma ciò non deve essere letto in contrasto con la crescita del mercato.

Infatti, le aziende che avevano già avviato almeno una sperimentazione proseguono e accelerano.

Contrariamente alle aspettative, l’avvento della Generative AI non sembra aver influenzato il percorso di

avvicinamento all’AI di quelle aziende che non hanno ancora adottato la tecnologia: mentre per le aziende

più mature è il 33%

Anche se la strada per finanziare la rivoluzione dell’AI può sembrare ardua, ci sono molte strategie che possono essere adottate per navigare tra i debiti e finanziare l’innovazione. Con la giusta pianificazione e strategia, la rivoluzione dell’Intelligenza Artificiale può diventare una realtà anche per coloro che attualmente si trovano in una situazione di debito.

Per chi volesse guardarsi i numeri dell’AI in Italia c’è un’interessante Contributo dell’Osservatorio Artificial Intelligence all’Indagine Conoscitiva sull’Intelligenza Artificiale: opportunità e rischi per il sistema produttivo italiano, che riportiamo sotto.

A voi le conclusioni.

Lanciata nel 2020, la Rome Call ha riunito originariamente la Pontificia Accademia, i leader di Microsoft e IBM il governo italiano e l’Organizzazione delle Nazioni Unite per l’alimentazione e l’agricoltura per promuovere scelte etiche nello sviluppo della tecnologia , norme legali per regolamentarla e sforzi educativi per aiutare le persone a comprendere l’intelligenza artificiale e il suo ruolo in una vasta gamma di applicazioni.

Oggi anche Cisco nella persona dell Presidente Chuck Robbins dopo aver brevemente incontrato Papa Francesco ha aderito alla iniziativa.

Siamo molto lieti che Cisco abbia aderito alla Rome Call, perché è un’azienda che svolge un ruolo cruciale come partner tecnologico per l’adozione e l’implementazione dell’intelligenza artificiale (AI), offrendo competenze in infrastrutture, sicurezza e protezione dei beni Dati e sistemi di intelligenza artificiale. D’ora in poi valuteremo come questa possa crescere ulteriormente per coniugare l’impegno aziendale già presente con i principi etici della Rome Call

presidente della Fondazione RenAIssance, mons. Vincenzo Paglia.

I firmatari stanno inoltre spingendo per lo sviluppo dell “algoretica”, un quadro etico per garantire che gli algoritmi utilizzati per costruire sistemi artificialmente intelligenti promuovano ciò che è vero, giusto ed etico.

L’algoretica è un termine coniato dal teologo Paolo Benanti. L’algoretica fonde l’algoritmo con l’etica e si pone come una nuova branca dell’etica che si dedica a esaminare gli aspetti morali degli algoritmi e dei sistemi basati sull’intelligenza artificiale1.

Il Rome Call for AI Ethics è un documento di grande importanza, firmato per la prima volta il 28 febbraio 2020. Questo documento è stato sviluppato per sostenere un approccio etico all’Intelligenza Artificiale (AI) e promuovere un senso di responsabilità tra organizzazioni, governi, istituzioni e il settore privato.

Pontificia Accademia per la Vita

La Pontificia Accademia per la Vita ha giocato un ruolo fondamentale nella creazione del Rome Call for AI Ethics. Questa accademia, con sede nello Stato della Città del Vaticano, è stata istituita da Papa Giovanni Paolo II con il motu proprio Vitae mysterium, l’11 febbraio 1994. Ha come fine la difesa e la promozione del valore della vita umana e della dignità della persona.

Fondazione RenAIssance

La Fondazione RenAIssance, istituita da Papa Francesco nel 2021, ha promosso il Rome Call for AI Ethics. Questa fondazione, con sede nella Città del Vaticano, presso la Pontificia Accademia per la Vita, è un’entità strumentale di tale Accademia. La Fondazione RenAIssance è un’organizzazione senza scopo di lucro con l’obiettivo di sostenere la riflessione antropologica ed etica delle nuove tecnologie sulla vita umana, promossa dalla Pontificia Accademia per la Vita.

Principi del Rome Call for AI Ethics

Il Rome Call for AI Ethics comprende 3 aree di impatto e 6 principi:

Aree di Impatto

- Etica: Tutti gli esseri umani nascono liberi e uguali in dignità e diritti.

- Educazione: Trasformare il mondo attraverso l’innovazione dell’IA significa impegnarsi a costruire un futuro per e con le generazioni più giovani.

- Diritti: Lo sviluppo dell’IA al servizio dell’umanità e del pianeta deve essere riflesso in regolamenti e principi che proteggono le persone, in particolare i deboli e i meno privilegiati, e gli ambienti naturali.

Principi

- Trasparenza: I sistemi di IA devono essere comprensibili per tutti.

- Inclusione: Questi sistemi non devono discriminare nessuno, poiché ogni essere umano ha pari dignità.

- Responsabilità: Deve sempre esserci qualcuno che si assume la responsabilità di ciò che una macchina fa.

- Imparzialità: I sistemi di IA non devono seguire o creare pregiudizi.

- Affidabilità: L’IA deve essere affidabile.

- Sicurezza e Privacy: Questi sistemi devono essere sicuri e rispettare la privacy degli utenti.

Rome Call for AI Ethics è un passo importante verso un futuro in cui l’innovazione digitale e il progresso tecnologico servono il genio e la creatività umana, e non il loro graduale rimpiazzo. Questo documento rappresenta un appello a riconoscere e poi a assumere la responsabilità che deriva dalla moltiplicazione delle opzioni rese possibili dalle nuove tecnologie digitali.

L’intelligenza artificiale generativa (GenAI) è un campo affascinante caratterizzato da una vasta e variegata offerta di soluzioni fornite da una molteplicità di attori. Le imprese che si avventurano nell’implementazione della GenAI devono navigare attraverso un complesso ecosistema di fornitori, che comprende produttori di modelli di base, sviluppatori di piattaforme AI, specialisti nella gestione dei dati, fornitori di strumenti per la personalizzazione dei modelli e molti altri.

Ciò che sorprende è che, nonostante il dominio delle grandi aziende di cloud computing nel panorama IT degli ultimi dieci anni, il loro ruolo centrale nel settore della GenAI non è stato così marcato come inizialmente previsto. Almeno finora. Ma ci sono segnali che la situazione potrebbe cambiare. Google ha recentemente tenuto un impressionante evento Cloud Next in cui l’azienda ha presentato un’ampia gamma di funzionalità basate su GenAI.

Siamo ancora in una fase embrionale per quanto riguarda le implementazioni di GenAI, e molte organizzazioni stanno appena cominciando a delineare la propria strategia e il metodo di attuazione. È diventato evidente, tuttavia, che molte aziende stanno riconoscendo l’importanza di avere software e servizi GenAI integrati con le loro fonti di dati primarie.

Considerando l’abbondanza di dati ospitati nel cloud AWS, molte di queste organizzazioni vedranno con favore le nuove funzionalità migliorate offerte da AWS, poiché possono agevolare la creazione e l’ottimizzazione dei modelli GenAI, specialmente con tecnologie come RAG.

Per le aziende che dipendono pesantemente dai servizi di archiviazione dati di AWS per l’addestramento e l’affinamento dei propri modelli GenAI, l’introduzione di queste nuove funzionalità Bedrock potrebbe essere un incentivo significativo per rilanciare i loro progetti applicativi GenAI.

È probabile che assistiamo anche alla crescita delle implementazioni di piattaforme multi-GenAI. Come le imprese hanno imparato che l’adozione di più fornitori di cloud era vantaggiosa dal punto di vista economico, logistico e tecnico, è possibile che si adotti un approccio analogo per sfruttare le diverse piattaforme GenAI per soddisfare le esigenze di diverse tipologie di applicazioni. Sebbene la competizione sia ancora in corso, è evidente che tutti i principali fornitori di cloud computing stanno cercando di affermarsi come player rilevanti anche in questo settore.

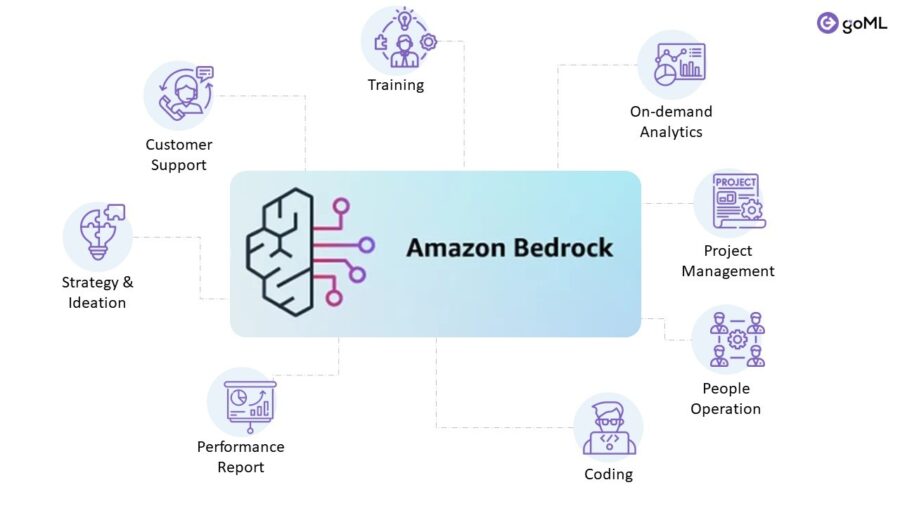

La divisione AWS di Amazon sta svelando una serie di nuove funzionalità e miglioramenti per il suo servizio completamente gestito Bedrock GenAI.

Amazon Bedrock è un servizio completamente gestito che offre una scelta di modelli di fondazione (FM) ad alte prestazioni delle principali aziende di IA, come AI21 Labs, Anthropic, Cohere, Meta, Mistral AI, Stability AI e Amazon, tramite un’unica API, insieme ad un’ampia gamma di funzionalità necessarie per creare applicazioni di IA generativa, utilizzando l’IA in modo sicuro, riservato e responsabile

Nello specifico, Amazon sta aggiungendo la possibilità di importare modelli di fondazione personalizzati nel servizio e quindi consentire alle aziende di sfruttare le capacità di Bedrock attraverso tali modelli personalizzati.

Le aziende che hanno addestrato un modello open source come Llama o Mistral con i propri dati potenzialmente con lo strumento di sviluppo del modello SageMaker di Amazon possono ora integrare quel modello personalizzato insieme ai modelli standardizzati esistenti all’interno di Bedrock.

Come risultato possono utilizzare un’unica API per creare applicazioni che attingono ai loro modelli personalizzati e alle opzioni dei modelli Bedrock esistenti, tra cui le ultime novità di AI21 Labs, Anthropic, Cohere, Meta e Stability AI, nonché i modelli Titan di Amazon.

Amazon ha anche introdotto la versione 2 del suo modello Titan Text Embeddings, che è stato specificamente ottimizzato per le applicazioni RAG.

Uno degli altri vantaggi dell’importazione di modelli personalizzati in Bedrock è la capacità di sfruttare le funzioni RAG integrate del servizio. Ciò consente alle aziende di sfruttare questa nuova tecnologia sempre più popolare per continuare a perfezionare i propri modelli personalizzati con nuovi dati.

La società ha inoltre annunciato la disponibilità generale del suo modello Titan Image Generator.

Poiché è serverless, Bedrock ha funzionalità integrate per scalare senza problemi le prestazioni dei modelli anche tra le istanze AWS, consentendo alle aziende di gestire più facilmente le proprie richieste in tempo reale in base alla situazione.

Le organizzazioni che desiderano creare agenti basati sull’intelligenza artificiale in grado di eseguire attività in più fasi, Bedrock offre anche strumenti che consentono agli sviluppatori di crearli e alle aziende di attingere ai loro modelli personalizzati mentre lo fanno.

Gli agenti sono attualmente uno degli argomenti di discussione più caldi in GenAI, quindi questo tipo di funzionalità è destinato a interessare quelle organizzazioni che vogliono rimanere all’avanguardia. Oltre a queste funzionalità esistenti per Bedrock, Amazon ne ha annunciate altre due, entrambe estensibili ai modelli Bedrock esistenti e anche ai modelli importati personalizzati.

Il Guardrails per Amazon Bedrock aggiunge un ulteriore set di funzionalità di filtro per impedire la creazione e il rilascio di contenuti inappropriati e dannosi, nonché di informazioni personali e/o sensibili.

Praticamente tutti i modelli incorporano già un certo grado di filtraggio dei contenuti, ma i nuovi Guardrail forniscono un ulteriore livello di prevenzione personalizzabile per aiutare le aziende a proteggersi ulteriormente da questo tipo di problemi e garantire che i contenuti generati siano conformi alle linee guida del cliente.

Inoltre, lo strumento di valutazione dei modelli di Amazon all’interno di Bedrock è ora generalmente disponibile. Questo strumento aiuta le organizzazioni a trovare il miglior modello di base per la particolare attività che stanno cercando di realizzare o per l’applicazione che stanno cercando di scrivere.

Il valutatore confronta caratteristiche standard come l’accuratezza e la robustezza delle risposte di diversi modelli. Consente inoltre la personalizzazione di diversi criteri chiave.

Le aziende possono, ad esempio, caricare i propri dati o una serie di suggerimenti personalizzati sul valutatore e quindi generare un report che confronti il comportamento dei diversi modelli in base alle loro esigenze personalizzate.

Amazon offre anche un meccanismo per consentire agli esseri umani di valutare diversi output del modello per misurazioni soggettive come la voce del marchio, lo stile, ecc. Questa valutazione del modello è una capacità importante perché mentre molte aziende potrebbero inizialmente essere attratte da una piattaforma a modello aperto come Bedrock grazie alla gamma delle diverse scelte che offre, quelle stesse scelte possono rapidamente diventare confuse e travolgenti.

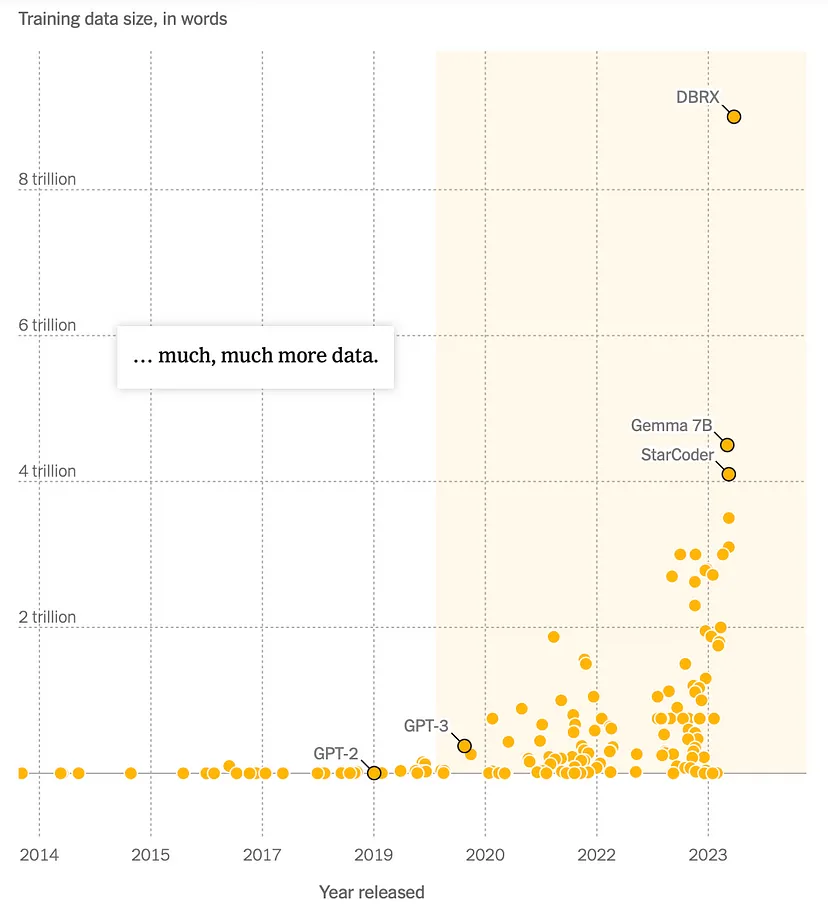

Secondo una ricerca condotta da Microsoft, circa l’88% delle lingue parlate nel mondo, che coinvolgono 1,2 miliardi di persone, non ha accesso ai Large Language Models (LLM). Perchè sono costruiti principalmente utilizzando dati in lingua inglese e per utenti di madrelingua inglese: “di conseguenza, la distinzione tra chi ha e chi non ha è diventata piuttosto netta“. La soluzione a questo problema risiede nell’implementazione di LLM multilingue, che possano essere allenati in diverse lingue e utilizzati per compiti in diverse lingue.

Il gruppo di ricerca Sapienza NLP (Natural Language Processing), guidato da Roberto Navigli, professore ordinario presso il Dipartimento di Ingegneria Informatica, Automatica e Gestionale “Antonio Ruberti” della Sapienza Università di Roma, annuncia oggi il rilascio dei modelli Minerva, una nuova famiglia di modelli linguistici su larga scala (Large Language Model, LLM) addestrati “da zero” per la lingua italiana.

Minerva è la prima famiglia di LLM italiano-inglese veramente aperti (dati e modello) preformati da zero, un modello da 350 milioni di parametri addestrato su 70 miliardi di token (35 miliardi in italiano, 35 miliardi in inglese), sviluppata da Sapienza NLP in collaborazione con Future Artificial Intelligence Research (FAIR) e CINECA . In particolare, circa la metà dei dati pre-formazione include testo in italiano.

Questo lavoro è stato finanziato dal progetto PNRR MUR PE0000013-FAIR . Riconosciamo il premio CINECA “IscB_medit” nell’ambito dell’iniziativa ISCRA, per la disponibilità di risorse e supporto informatico ad alte prestazioni.

“La caratteristica distintiva dei modelli Minerva è il fatto di essere stati costruiti e addestrati da zero usando testi ad accesso aperto, al contrario dei modelli italiani esistenti ad oggi, che sono basati sull’adattamento di modelli come LLaMA e Mistral, i cui dati di addestramento sono tuttora sconosciuti”

“Nello specifico, ogni modello Minerva è stato addestrato su un vasto insieme di fonti italiane e inglesi online e documentate, per un totale di oltre 500 miliardi di parole, l’equivalente di oltre 5 milioni di romanzi”.

“Non solo la trasparenza nell’addestramento dei modelli rafforza la fiducia degli utenti, della comunità scientifica, degli enti pubblici e dell’industria, ma stimola anche continui miglioramenti ed è un primo passo verso processi di verifica rigorosi per garantire la conformità a leggi e regolamenti”.

Roberto Navigli.

Il team di PNL della Sapienza

- Riccardo Orlando: preelaborazione dei dati, training del modello

- Pere-Lluis Huguet Cabot: preelaborazione dei dati, vocabolario, valutazione

- Luca Moroni: data curation, analisi dei dati, compiti downstream, valutazione

- Simone Conia: data curation, valutazione, supervisione del progetto

- Edoardo Barba: preelaborazione dati, attività downstream, supervisione del progetto

- Roberto Navigli: coordinatore del progetto

Durante la recente teleconferenza sugli utili, Elon Musk, CEO di Tesla, ha espresso le sue opinioni su vari argomenti. Ha riconosciuto che l’adozione globale di veicoli elettrici sta affrontando delle sfide, ma ha mantenuto la sua convinzione che, nel lungo periodo, i veicoli elettrici prenderanno il sopravvento nell’industria automobilistica.

| Q1 2024 Actual | Analyst Estimates for Q1 2024 | Q1 2023 | Year-Over-Year Change | |

|---|---|---|---|---|

| Revenue | $21.3 billion | $22.25 billion | $23.33 billion | (9%) |

| Adjusted Diluted Earnings / (Loss) Per Share | 45 cents | 52 cents | 85 cents | (47%) |

| Adjusted Net Income / (Loss) | $1.54 billion | $1.88 billion | $2.93 billion | (48%) |

Musk ha inoltre annunciato che nuovi modelli di auto saranno lanciati nella prima metà del 2025, o forse già alla fine del 2024. Questi nuovi modelli incorporeranno elementi della tecnologia autonoma di Tesla e saranno prodotti utilizzando le linee di produzione esistenti. Tuttavia, Musk non ha voluto rivelare se questi nuovi modelli saranno versioni aggiornate dei modelli attuali.

Parlando della Full Self-Driving (FSD), Musk ha elogiato le caratteristiche dell’ultima versione.

Secondo lui, una rete neurale con telecamere è la soluzione ideale per la FSD. Ha anche sottolineato che la potenza di calcolo dell’intelligenza artificiale di Tesla sta progredendo rapidamente. Musk ha rivelato che Tesla è attualmente in trattative con almeno un grande produttore di automobili per concedere in licenza la tecnologia FSD.

Rispondendo a una domanda sul robot umanoide Optimus, Musk ha dichiarato che prevede che Tesla sarà in grado di iniziare a vendere questi robot entro la fine del prossimo anno. Ha anche espresso la sua convinzione che Optimus potrebbe diventare la più grande attività di Tesla.

Tesla aveva affermato che Optimus è alimentato dallo stesso software della funzionalità di guida autonoma delle sue auto, per le quali Tesla ha sviluppato i propri chip, sia all’interno del veicolo che nel supercomputer (Dojo) utilizzato per l’allenamento. i modelli. Certamente, queste capacità di deep learning (sia hardware che software), che sono così cruciali per rendere utili i robot umanoidi, sono al di fuori del dominio di tutte le altre aziende di robotica. È qui che nasce l’attrattiva e la differenziazione dell’ingresso di Tesla in questo mercato.

Musk ha apprezzato gli sforzi di altre case automobilistiche nel creare un percorso per le approvazioni normative sulla guida autonoma.

Ha citato dati che dimostrano che la guida autonoma è più sicura della guida umana. Ha immaginato un futuro in cui esiste una flotta di robotaxi, una sorta di ibrido tra Uber e Airbnb, con i clienti e la società con sede ad Austin che gestiscono entrambe le parti della flotta. Musk ha affermato:

“In futuro, le auto a benzina che non saranno autonome saranno come andare a cavallo e usare un telefono cellulare, e questo diventerà molto ovvio”.

E.Musk

Il punto è che tutti questi esempi appartengono al dominio del software, non dell’hardware, e che è alimentato da chip di silicio. Come alcuni hanno sostenuto, avere semplicemente un robot che assomigli a un essere umano o una automobile che si guida da soloenon è sufficiente, deve anche essere in grado di fare le cose che un essere umano può fare. Ebbene, data l’ascesa dell’intelligenza artificiale, questo sta diventando un ambito possibile.

Il contenuto del presente articolo deve intendersi solo a scopo informativo e non costituisce una consulenza professionale. Le informazioni fornite sono ritenute accurate, ma possono contenere errori o imprecisioni e non possono essere prese in considerazione per eventuali investimenti personali. L’articolo riporta esclusivamente le opinioni della redazione che non ha alcun rapporto economico con le aziende citate.

l CEO di Meta, Mark Zuckerberg, ha lasciato intendere che la sua azienda sta facendo progressi sulle sue prime “interfacce neurali di consumo”, dispositivi indossabili non invasivi in grado di interpretare i segnali cerebrali per controllare i computer. Brain Computer Interface (BCI)

“Una delle cose di cui sono piuttosto entusiasta: penso che presto inizieremo a ottenere alcune interfacce neurali di consumo.

Mark Zuckerberg, a differenza del chip cerebrale Neuralink di Elon Musk, ha spiegato che i dispositivi in questione non sarebbero qualcosa che “si collega al tuo cervello”, ma un dispositivo indossabile al polso in grado di “leggere i segnali neurali che il tuo cervello invia attraverso i tuoi nervi alla tua mano per muoverla in modi sottili”.

Meta ha iniziato a discutere dello sviluppo dell’“interazione basata sul polso” nel marzo 2021 come parte della ricerca di Facebook Reality Labs.

Il braccialetto di Meta funziona utilizzando l’elettromiografia (EMG) per interpretare i segnali cerebrali relativi ai gesti della mano desiderati e tradurli in comandi per controllare i dispositivi.

“Siamo fondamentalmente in grado di leggere quei segnali e usarli per controllare occhiali o altri dispositivi informatici”, .

Mark Zuckerberg

I commenti più recenti sono arrivati durante un’intervista il 18 aprile tra il co-fondatore di Facebook e l’imprenditore tecnologico e il YouTuber Roberto Nickson.

“Siamo ancora all’inizio del viaggio perché non abbiamo ancora lanciato la prima versione del prodotto, ma giocarci internamente è… è davvero interessante vedere”.

All’inizio di quest’anno, l’AD di Meta ha detto che questo braccialetto neurale potrebbe diventare un prodotto di consumo in pochi anni, utilizzando l’intelligenza artificiale per superare i limiti del tracciamento dei gesti basato su telecamera.

Mark Zuckerberg ha anche immaginato che le interfacce neurali funzionino con gli occhiali intelligenti con realtà aumentata Ray-Ban di Meta. Commentando gli occhiali intelligenti dell’azienda, ha detto che la “funzione Hero ” era l’integrazione dell’IA in essi.

“Siamo davvero vicini ad avere un’IA multimodale […] quindi non le fai solo una domanda con testo o voce; puoi chiederle delle cose che stanno succedendo intorno a te, e può vedere cosa sta succedendo e rispondere alle domande […] è piuttosto selvaggio”, ha aggiunto.

Nel frattempo, i legislatori negli Stati Uniti stanno già lavorando su una legislazione volta a proteggere la privacy nel nascente campo della neurotecnologia.

La Protect Privacy of Biological Data Act, che espande la definizione di “dati sensibili” per includere dati biologici e neurali, è stata approvata in Colorado questa settimana, secondo quanto riportato.

In altre notizie, Meta ha appena rilasciato una nuova versione di Meta AI, l’assistente che opera attraverso le applicazioni e gli occhiali dell’azienda. “Il nostro obiettivo è costruire l’IA leader nel mondo”, ha detto Zuckerberg.

Meta AI viene aggiornata con il nuovo modello di IA “Llama 3 all’avanguardia, che stiamo rendendo open source”, ha aggiunto.

Il mercato ha attraversato una settimana turbolenta, culminata con una sessione di venerdì segnata dal brusco calo delle azioni di Netflix , che ha influito negativamente sul settore tecnologico, e dalle tensioni geopolitiche tra Iran e Israele, che hanno tenuto gli investitori con il fiato sospeso.

Richard Hunter di Interactive Investor ha notato che i titoli tecnologici sono stati particolarmente colpiti alla fine di una settimana altamente volatile, con parte dei recenti guadagni cancellati dopo un periodo di crescita eccezionale per le azioni legate all’intelligenza artificiale.

La situazione attuale dei mercati è piuttosto confusa, con una grande incertezza riguardo agli eventi in corso in Medio Oriente, una significativa vendita nel settore tecnologico americano, che non si verificava da circa 18 mesi, e un aumento dei rendimenti mentre i tagli dei tassi di interesse vengono sempre più messi da parte,” ha aggiunto Jim Reid di Deutsche Bank.

Dopo un venerdì tumultuoso caratterizzato da vendite aggressive, lunedì i titoli legati all’intelligenza artificiale sembravano trovare una certa stabilità in vista dei prossimi annunci di utili.

Richard Hunter di Interactive Investor ha notato che i titoli tecnologici, in particolare quelli con una forte esposizione all’intelligenza artificiale, hanno subito un deciso calo dopo un periodo di forte crescita. Tuttavia, lunedì le azioni di Nvidia sono aumentate di quasi il 2%, nonostante il declassamento da parte di UBS da Overweight a Neutral, ribaltando la tendenza negativa degli utili. Venerdì, il titolo aveva subito una perdita superiore al 10%.

Nvidia, che pubblicherà i suoi risultati del primo trimestre il 22 maggio, ha previsto un aumento significativo dell’EPS e dei ricavi rispetto all’anno precedente.

Altre società del settore, come Super Micro Computer e Astera Labs , hanno mostrato una performance altalenante. Super Micro Computer è sceso di oltre il 2% lunedì, aggiungendosi al crollo del 23% di venerdì, mentre Astera Labs è salito del 2% dopo un calo del 9% venerdì.

Arm, una società britannica di progettazione di chip, ha registrato un aumento del 4,2%, recuperando parte delle perdite del giorno precedente. Anche altre società del settore, come Qualcomm (QCOM), Broadcom e Texas Instruments hanno registrato aumenti nella giornata di lunedì.

Il contenuto del presente articolo deve intendersi solo a scopo informativo e non costituisce una consulenza professionale. Le informazioni fornite sono ritenute accurate, ma possono contenere errori o imprecisioni e non possono essere prese in considerazione per eventuali investimenti personali. L’articolo riporta esclusivamente le opinioni della redazione che non ha alcun rapporto economico con le aziende citate.

Questa settimana, noi di Redazione Rivista.AI siamo andati a un paio di convegni e la parola Hype e’ stata sparsa come lo zucchero a velo sul pandoro o spread thin like butter on toast come dicono gli anglofoni.

Ci e’ sembrato doveroso scrivere una articolo nella sezione Vision, di venerdi sera, sperando che abbiate abbastanza tempo durante il Weekend per leggerlo. Altrimenti fermatevi all’elevetor pitch :

I grandi modelli linguistici (LLM) e l’intelligenza artificiale generativa (GenAI) stanno attualmente rivoluzionando numerosi settori e stanno trasformando radicalmente la nostra vita quotidiana.

Finora, l’approccio principale per monetizzare la GenAI è stato orientato verso i flussi di entrate Business-to-Business (B2B), ma si sta iniziando a osservare un crescente interesse verso l’implementazione di modelli basati su abbonamento e l’introduzione del “GPT Store”, che mostra promesse anche per gli utenti individuali.

Allo stesso tempo, la progettazione di hardware e software, unita agli strumenti per ottimizzare i flussi di lavoro dell’intelligenza artificiale e le opportunità nell’applicazione pratica dell’intelligenza artificiale, emergono come aree chiave da monitorare attentamente nello spazio della GenAI.

Quando si parla di intelligenza artificiale, si sente spesso parlare di Nvidia, Broadcom , AMD e altre società di chip, software e servizi. Tuttavia, Intel viene spesso trascurata . Dovremmo mettere le cose in prospettiva perché siamo ancora agli inizi del gioco dell’intelligenza artificiale e c’è molto spazio per l’espansione di molti leader di mercato.

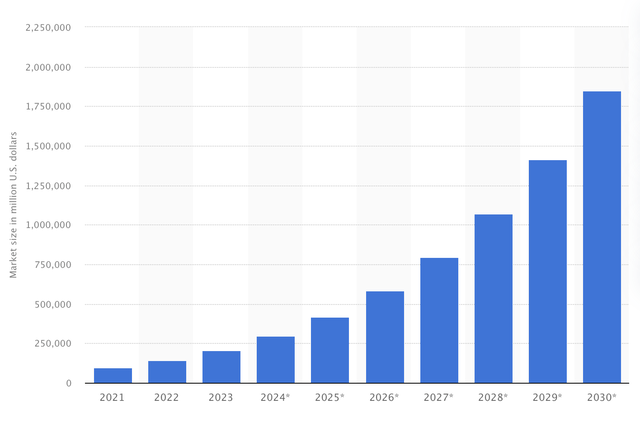

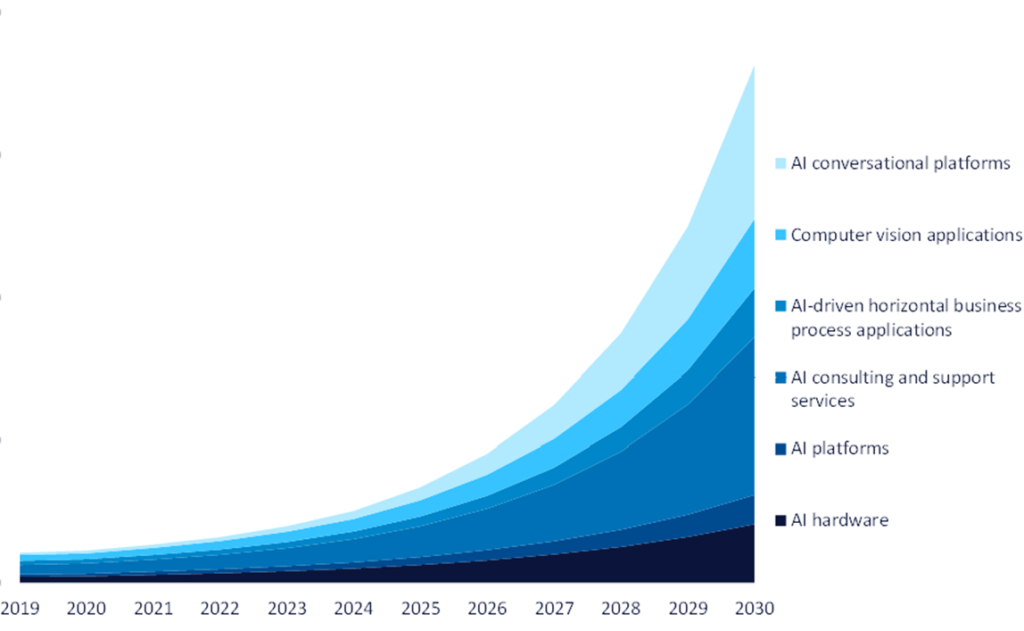

Quest’anno, si prevede che i ricavi legati all’intelligenza artificiale saranno di circa 300 miliardi di dollari. Tuttavia, si prevede che il mercato dell’intelligenza artificiale si espanderà notevolmente, con ricavi stimati a 1,85 trilioni di dollari entro il 2030, di seguito propiezioni da Statista:

Venerdì, i titoli nel settore dei semiconduttori hanno subito un’improvvisa ondata di vendite, alimentata dalle preoccupazioni riguardo ai prossimi risultati trimestrali del gigante dell’intelligenza artificiale Super Micro Computer e dalle crescenti inquietudini riguardo alle spese relative all’IA.

Il crollo del 23% di Super Micro Computer è stato innescato dalle sue dichiarazioni riguardanti la pubblicazione dei risultati fiscali del terzo trimestre, prevista per il 30 aprile. Negli ultimi trimestri, l’azienda ha spesso anticipato i suoi risultati, con un’azione simile avvenuta anche a gennaio, quando ha rialzato le sue previsioni 11 giorni prima del resoconto degli utili.

Venerdì sono passate di mano più di 14 milioni di azioni, rispetto al volume medio giornaliero di poco più di 10 milioni, portando alla speculazione che la società potrebbe vedere un rallentamento delle vendite.

Nvidia , precedentemente identificata da Oppenheimer come una delle migliori opzioni del settore all’inizio della stagione degli utili, ha registrato una diminuzione superiore al 10%, chiudendo a 761,77 dollari. Dall’evento GTC tenutosi il mese precedente, le azioni dell’azienda sono diminuite di oltre il 20%.

AMD spesso associata a Nvidia, ha visto un calo superiore al 5%, terminando a 146,64 dollari.

Intel , concorrente sia di Nvidia che di AMD nei mercati delle GPU e delle CPU, ha chiuso venerdì in ribasso del 2,4%.

Astera Labs, che ha recentemente debuttato in borsa, ha subito una flessione del 9%. Anche se inizialmente aveva registrato un aumento del 164% rispetto al prezzo IPO di 34 dollari, il calo di venerdì ha ridotto il guadagno a circa il 60%.

Arm , che ha fatto il suo ingresso in borsa a settembre 2023, ha subito un calo superiore al 16% venerdì. Nel mese precedente, le azioni hanno registrato una perdita del 33%.

Altri attori del settore, tra cui Taiwan Semiconductor , Qualcomm (QCOM), Micron Technology , Texas Instruments e ON Semiconductor , hanno anch’essi registrato un significativo calo venerdì, con diminuzioni del 2% o più.

Taiwan Semiconductor ha visto un calo superiore al 12% durante la settimana, in seguito alla pubblicazione dei risultati del primo trimestre, sebbene Needham, una società di investimento, abbia commentato venerdì che il calo è stato “esagerato”.

Divulgazione dell’analista: non ho/noi non abbiamo alcuna posizione su azioni, opzioni o derivati simili in nessuna delle società menzionate e non ho intenzione di avviare tali posizioni entro le prossime 72 ore. Ho scritto questo articolo io stesso ed esprime le mie opinioni. Non ricevo alcun compenso per questo . Non ho rapporti d’affari con alcuna società le cui azioni sono menzionate in questo articolo.

La performance passata non è garanzia di risultati futuri. Non viene fornita alcuna raccomandazione o consiglio riguardo al fatto che un particolare titolo, portafoglio, transazione o strategia di investimento sia adatto a una persona specifica. L’autore non ti consiglia personalmente riguardo alla natura, al potenziale, al valore o all’idoneità di qualsiasi particolare titolo o altra questione. Solo tu sei l’unico responsabile di determinare se qualsiasi investimento, titolo o strategia, o qualsiasi prodotto o servizio, sia appropriato o adatto a te in base ai tuoi obiettivi di investimento e alla tua situazione personale e finanziaria.

Si è parlato di sostenibilità, di trasformazione digitale e di Intelligenza Artificiale nel corso dell’evento Digital Sustainability Day organizzato ieri dalla Fondazione per la Sostenibilità Digitale all’Università La Sapienza.

L’evento, rivolto alle aziende del tessuto economico italiano, a enti, istituzioni, Pubbliche Amministrazioni e Università che hanno intrapreso o stanno per intraprendere processi di trasformazione digitale e che vogliono, o hanno bisogno, di mettere la sostenibilità al centro delle loro attività, è stato l’occasione per fare il punto sui primi 3 anni di attività della Fondazione per la Sostenibilità Digitale che ha rapidamente assunto un ruolo centrale nel panorama del settore, promuovendo una visione sociale della sostenibilità, sottolineando l’importanza di una comprensione diffusa e di scelte economiche consapevoli.

Questo approccio, che negli ultimi anni potremmo chiamare “Sostenibilità Digitale Esponenziale”, per effetto anche dell’Intelligenza Artificiale, riconosce che il futuro sostenibile richiede un contesto abilitante fornito dalla tecnologia digitale.

Le iniziative della Fondazione si concentrano sulla creazione di opportunità di comunicazione, confronto e apprendimento per sostenere le istituzioni nell’adozione di pratiche sostenibili, avendo ben presente che la sostenibilità non può essere imposta dall’alto, ma deve essere accettata e compresa a livello sociale.

Nel contesto del Convegno, è stata affrontata la questione della sostenibilità e della sua relazione con la trasformazione digitale con l’apporto e la partecipazione di una platea ampia e trasversale che riunisce esperti, ricercatori, professionisti ed esponenti del mondo della politica, chiamati ad esaminare le sfide e le opportunità legate alla sostenibilità digitale.

La trasformazione digitale non riguarda il come facciamo le cose, la trasformazione digitale non è una questione tecnologica, o meglio, non è soltanto una questione tecnologica, perché la trasformazione digitale è un fenomeno sociale, è l’impatto sulla società della digitalizzazione e è un impatto che guarda al modo in cui la trasformazione digitale agisce sui comportamenti, agisce sui contesti, agisce sulle cose e ne ridefinisce il senso, non è una scelta, noi non possiamo scegliere che i nostri clienti utilizzino un determinato strumento, non possiamo scegliere che i cittadini usino o non usino delle tecnologie a meno che non siamo in Cina, non possiamo scegliere, ci troviamo in una condizione di contesto e quella condizione di contesto ha un impatto (9:07) fortissimo su di noi, quindi di fatto la trasformazione digitale è un fenomeno sociale unisce il senso delle cose..

Stefano Epifani, Presidente della fondazione per la sostenibilitÀ digitale