C’è qualcosa di vagamente distopico ma irresistibilmente seducente nell’idea che un’intelligenza artificiale possa guardare quello che stiamo guardando e dirci in tempo reale cosa stiamo vedendo, consigliarci cosa comprare o addirittura dirci se quel pesce nell’acquario è un tetra o un guppy. Non è fantascienza, è il nuovo giocattolo di Google: Gemini Live. E adesso è ufficialmente in rollout, a partire da due flagship che sembrano nati per ospitare un futuro da Black Mirror: il Pixel 9 e il Galaxy S25.

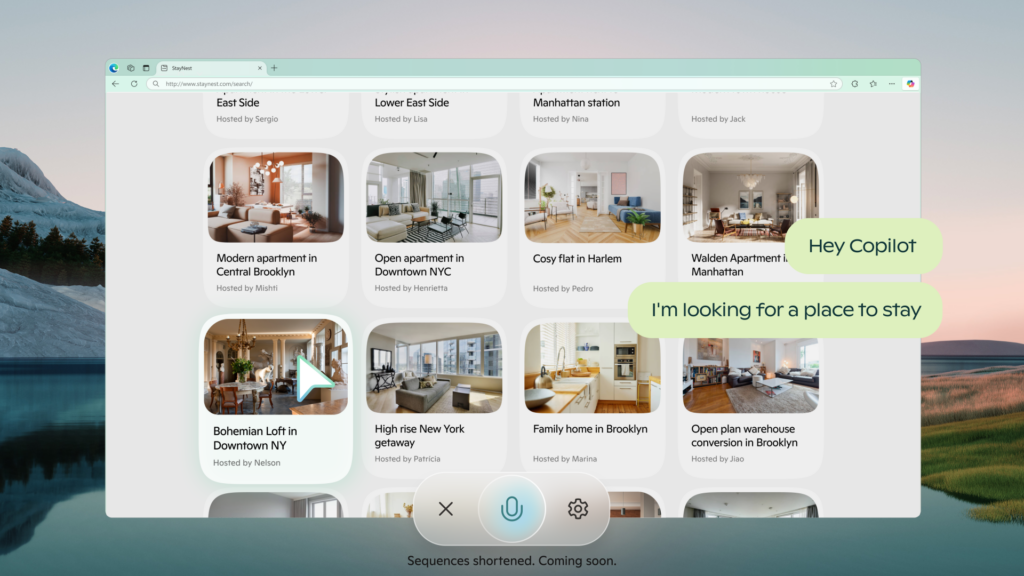

L’annuncio arriva tra le righe, senza fanfare da keynote, ma con la fredda efficienza di un update che cambia le carte in tavola. Gemini Live, l’interfaccia “live” dell’ecosistema Gemini, ora consente non solo di attivare la videocamera e farsi assistere visivamente dall’AI, ma anche di condividere lo schermo del proprio smartphone. E il tutto con una naturalezza che nasconde un’enorme complessità infrastrutturale sotto il cofano. Basta un tap per passare da “scatto la foto al pesce” a “consigliami un nuovo outfit su Zalando”, con la stessa voce pacata e infallibile che ti aiuta a scrivere un’email o sintetizza una riunione su Meet.