La Silicon Valley non licenzia più. Offre pacche sulle spalle e assegni di buonuscita in cambio del badge. L’era dei buyout è arrivata a Mountain View come un gentile tsunami, e a giudicare dall’euforia semantica delle memo interne, è solo l’inizio. Per i dipendenti di Google, in particolare quelli di Core Engineering, Search e altri dipartimenti “strategici”, la nuova parola magica è: “voluntary exit”. Come dire: sei ancora libero di restare, ma non sei più parte del futuro.

Categoria: News Pagina 1 di 80

Rivista.AI e’ il portale sull’intelligenza artificiale (AI) attualita’, ultime notizie (news) e aggiornamenti sempre gratuiti e in italiano

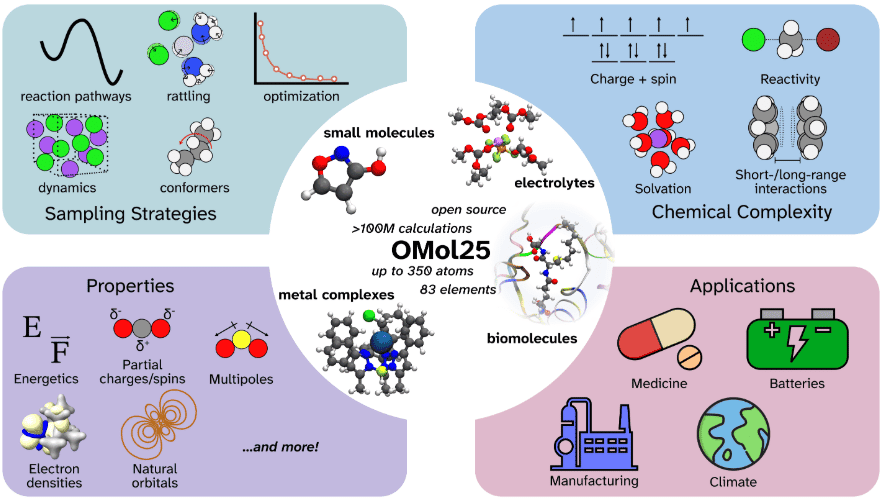

Sarebbe piaciuto a Schrödinger, anche se probabilmente avrebbe chiesto a ChatGPT di spiegargli cosa sia un dataset da 100 milioni di DFT. In un’alleanza che ha più del Manhattan Project che di una startup in garage, Meta, Los Alamos National Laboratory e il Lawrence Berkeley Lab hanno appena acceso una miccia quantistica sotto la chimica computazionale. Il risultato si chiama Open Molecules 2025, ed è, senza giri di parole, la più grande biblioteca pubblica mai rilasciata di simulazioni molecolari ad alta fedeltà. Parliamo di oltre cento milioni di calcoli al livello della teoria funzionale della densità, o DFT per chi ha confidenza con l’inferno della meccanica quantistica applicata alla materia.

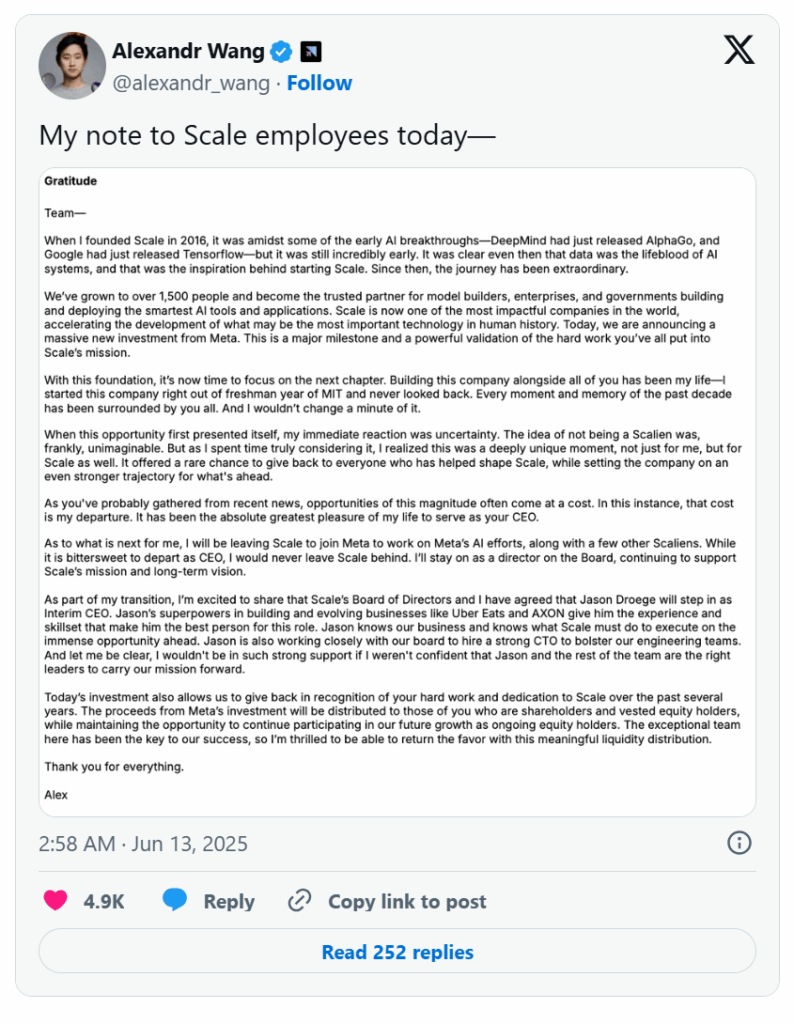

Nel silenzio ovattato degli uffici open space di Google, DeepMind e OpenAI, un sussurro inquietante comincia a propagarsi tra i ricercatori: “È davvero Zuck?” Una domanda che non è metafisica, ma professionale. E con ogni probabilità, economica. È infatti Mark Zuckerberg — in carne, ossa e messaggi WhatsApp personalizzati — ad aver cominciato a corteggiare personalmente il gotha della ricerca AI, proponendo offerte che definire stravaganti sarebbe un understatement imbarazzante. Si parla di pacchetti compensativi a otto cifre. Alcuni addetti ai lavori hanno sussurrato che ha “pagato 14 Instagrams” per strapparsi Alexandr Wang, il giovane prodigio e CEO di Scale AI.

Hai digitato una query su Google. Ti aspettavi il solito elenco di link, quella noiosa gerarchia di SEO tossico, titoli clickbait e snippet semi utili. Invece, all’improvviso, una voce calda ti sussurra nelle orecchie una sintesi personalizzata, confezionata da un’intelligenza artificiale addestrata a suonare come un mix tra David Attenborough e il tuo barista di fiducia. No, non è fantascienza. È l’ultima trovata del colosso di Mountain View: trasformare le ricerche in un podcast istantaneo. Automatico. Sintetico. Inevitabile.

Non è l’uranio arricchito a costruire una bomba. È la paura. La paura che il nemico, messo all’angolo, abbandoni ogni freno ideologico e giochi la sua ultima carta: la dissuasione atomica. Israele lo sa, ma ha scelto comunque di alzare la posta. Con chirurgica brutalità ha colpito il cuore pulsante del programma nucleare iraniano, assassinando scienziati, bombardando impianti e facendo saltare in aria non solo edifici, ma equilibri strategici.

L’Iran si ritrova oggi in un vicolo cieco. E come ogni bestia ferita, potrebbe scegliere di fare ciò che ha sempre negato pubblicamente: costruire l’arma che non osa nominare. Perché tra Teheran e la bomba, ormai, non ci sono più barriere tecnologiche. Solo un velo sottile di reticenza politica, l’ultima linea di difesa prima del punto di non ritorno.

La scena politica americana si anima di fronte a un pericolo che ha il sapore di un thriller geopolitico: la nuova legge Advanced AI Security Readiness Act, presentata da un gruppo bipartisan guidato da John Moolenaar, rappresenta l’ennesimo tentativo di Washington di blindare il proprio primato nell’intelligenza artificiale, puntando il dito contro il “nemico” cinese come se fossimo già in un episodio di House of Cards tecnologico.

Fondata nel 2020 da veterani del settore con oltre vent’anni di esperienza sulle spalle – e probabilmente qualche cicatrice lasciata da intrusioni, notti insonni e patch critiche alle 3 del mattino RedCarbon non si è accontentata di seguire il flusso dell’AI applicata alla sicurezza. Lo ha anticipato, lo ha cavalcato, e poi lo ha trasformato in un’onda d’urto capace di riscrivere le regole del gioco: il primo Virtual Cyber Analyst, un’entità algoritmica pensante che non dorme mai, non sbaglia, non ha bisogno di ferie, e soprattutto non si lamenta del caffè della macchinetta.

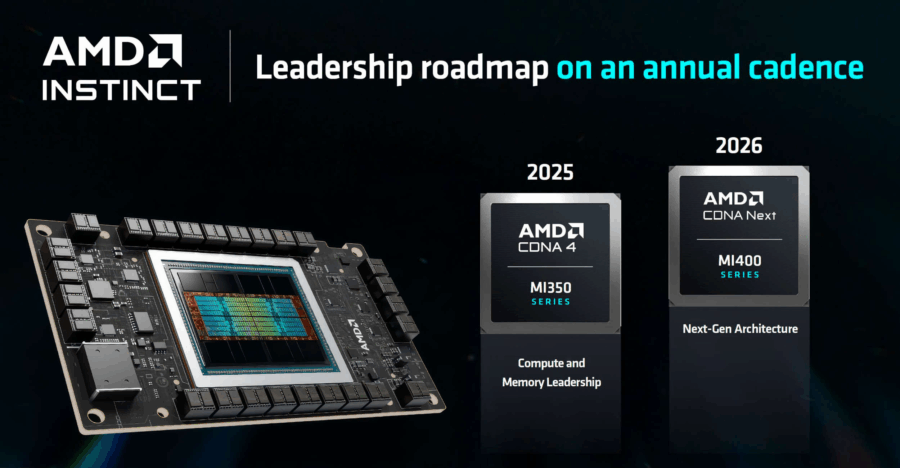

AMD ha acceso i riflettori su sé stessa, ma lo spettacolo vero non era sul palco. Il lancio della nuova serie MI350, celebrata con il solito repertorio di slide scintillanti e testimonial di peso, ha in realtà lasciato il pubblico – e soprattutto gli investitori – con lo sguardo rivolto al futuro. E quel futuro ha un nome: MI400. Un numero, una promessa, forse una scommessa colossale per entrare finalmente nel ring di Nvidia.

C’è un errore concettuale che si continua a ripetere nel mondo dell’Intelligenza Artificiale, una specie di dogma non scritto: per avere prestazioni elevate, devi sacrificare il controllo. In altre parole: se vuoi GPU, devi affidarti mani e CPU alle big cloud d’oltreoceano, rinunciando a ogni pretesa di privacy-by-design. Ma cosa succede se ti dicessimo che è possibile avere entrambi? Se la scelta non fosse più tra potenza e proprietà, ma tra dipendenza e autonomia?

E’ stato un piacere e un onore ascoltare Stefano Epifani. President DIGITAL TRANSFORMATION INSTITUTE al Nam 2025. Un lampo, un tuono ha squarciato l’apertura del convegno organizzato da NAMEX al Gasometro.

Quando qualcuno oggi parla di “etica dell’intelligenza artificiale”, raramente si riferisce all’etica. È più facile che stia facendo marketing, PR o damage control. Perché l’etica quella vera, non quella da policy framework aziendale è una cosa sporca, scomoda, lenta e spesso irricevibile nei board meeting. L’etica, per sua natura, spacca i consensi, apre i conflitti e sabota la narrativa del progresso inarrestabile. È ciò che rende una decisione tecnologica politica, cioè carica di valori, visioni del mondo e rapporti di forza. Ed è proprio questo che molti oggi preferirebbero ignorare.

Il romanticismo dei “beni rifugio digitali” è svanito in un’esplosione sopra il cielo di Teheran. Le criptovalute, da anni narrate come l’arca post-moderna per sopravvivere al diluvio dei mercati tradizionali, si sono comportate esattamente come ogni altro asset ad alto beta: hanno tremato, hanno ceduto. Bitcoin, l’apripista di questa rivoluzione finanziaria 2.0, è scivolato del 3% fino a toccare brevemente i 103.000 dollari prima di recuperare, come un pugile che ha sentito il colpo e cerca disperatamente il clinch.

Se fosse davvero così facile costruire chip per l’intelligenza artificiale, allora perché Jensen Huang sembra uscito da un rave tech senza fine, invecchiato di dieci anni in dodici mesi ma ancora in cima alla catena alimentare dell’AI?

Parlando con l’aria stanca ma trionfante a Parigi — la città che ti fa sentire elegante anche quando parli di semiconduttori — il CEO di Nvidia ha mostrato con l’aria di chi la sa lunga che non è minimamente minacciato dal fatto che i suoi clienti più importanti, da Amazon Web Services a Microsoft fino a OpenAI, stiano tentando di fabbricare chip proprietari. Il tono? Mezzo ironico, mezzo “siete tutti i benvenuti a provarci, ma fallirete”.

Una scacchiera grigia, pochi pixel maldestri. Un processore da 1.19 MHz, Atari 2600, anno 1977. E poi c’è ChatGPT, monumento del machine learning, con miliardi di parametri, ore di training, infrastruttura da superpotenza. Risultato? Umiliazione. Confusione tra pezzi. Errori da principiante. Scacco matto dall’intelligenza di un tostapane glorificato.

Non è ironia cosmica. È una lezione spietata sul perché l’intelligenza artificiale non è onnisciente, e sul fatto che il contesto – come sempre – conta più dell’intelligenza in sé.

Nel regno rarefatto della Silicon Valley, dove ogni nuova sigla è una religione e ogni layer una guerra di potere, c’è un termine che gira con l’eleganza di una coltellata: “wrapper”. Un insulto travestito da etichetta tecnica, un modo per sminuire ciò che non si riesce a controllare. Ma sotto la superficie, proprio come accadde con i browser nei primi anni del web, quelli che oggi chiamiamo wrapper sono, in realtà, i veri motori dell’innovazione. E se la storia ha un minimo senso, saranno loro a riscrivere – letteralmente – il futuro dell’intelligenza artificiale.

Manus AI è diventato come quel tipo alla festa che non solo arriva in anticipo, ma si presenta anche con lo champagne migliore e un DJ al seguito. Era già considerato un “agent” AI piuttosto solido, una di quelle piattaforme che prometteva bene tra prompt, video e automazione. Ma adesso, con l’integrazione di Veo3, il salto non è solo evolutivo, è cinematografico. Letteralmente.

Facciamola breve, perché il tempo è l’unica cosa che l’AI non può restituirci: Manus ora permette non solo di generare video, ma esperienze visive che sfiorano l’ossessione maniacale per il dettaglio. Stiamo parlando di qualità visiva superiore, sincronizzazione audio-labiale finalmente credibile, e scene che non sembrano uscite da un generatore di meme con l’ambizione di Kubrick. Il passaggio al supporto per Google Slides e PowerPoint è solo un preambolo, un assaggio della direzione in cui sta andando il vero game changer.

Apple ha un problema con l’intelligenza artificiale. E si chiama Siri.

Nonostante le fanfare, le demo impeccabili e le promesse reiterate nei keynote più luccicanti della Silicon Valley, l’assistente vocale di Apple – lanciato nel 2011 come l’alba del futuro vocale – oggi sembra più un’inserviente spaesata nella grande villa dell’AI generativa. Eppure, qualcosa si muove a Cupertino. Dopo rinvii, scaricabarile interni e riscritture strutturali del codice, Apple ha fissato un obiettivo ambizioso ma (stavolta) realistico: lanciare la nuova Siri nella primavera del 2026, con iOS 26.4.

Lisa Su, CEO di AMD, ha dichiarato che la domanda di inferenza AI crescerà dell’80% all’anno. Ma dietro questa previsione ottimistica si cela una realtà più complessa.

Nel 2024, AMD ha generato oltre 5 miliardi di dollari di entrate dalle sue GPU Instinct, con previsioni di crescita significativa nel segmento AI. Su ha dichiarato che la società prevede che le entrate annuali derivanti dai chip AI raggiungano “decine di miliardi di dollari nei prossimi anni”.

Se c’è una cosa che Elon Musk sa fare meglio di lanciare razzi nello spazio o provocare crolli azionari con un meme, è trasformare una causa legale in una guerra ideologica. Ed è esattamente ciò che sta accadendo con il suo scontro sempre più surreale con OpenAI. Mentre la maggior parte delle Big Tech si limita a giocare a Risiko con i dati degli utenti, Musk punta direttamente al cuore di ciò che ritiene un tradimento: l’aver messo il profitto davanti all’umanità, peccato capitale per chi si è autoproclamato paladino del bene universale.

Sentito quel pop? No, non è lo champagne di qualche startup unicorn appena quotata. È il suono della nuova bolla, ma stavolta nessuno vuole chiamarla così. Perché quando Chime—una fintech che somiglia a una banca ma preferisce non esserlo—esordisce al Nasdaq con un +37% rispetto al prezzo IPO, chi osa fare il guastafeste?

Quello che accade sotto gli occhi di Wall Street è il ritorno del grande spettacolo delle IPO tech, con una sceneggiatura vecchia quanto i dot-com: hype, rally iniziale, FOMO contagiosa e occhi a dollaro nei pitch deck. Gli investitori istituzionali (quelli veri, con i polsini inamidati) e i retail più speculativi (quelli di Reddit) si stanno dando il cinque virtuale, ringraziando i banker di Morgan Stanley come se fossero DJ in un festival di capitali.

C’è qualcosa di affascinante, quasi surreale, nell’idea che un’azienda di sei anni, con un CEO che si dichiara umile portatore della coscienza artificiale globale, stia trattando per una raccolta fondi da quaranta miliardi di dollari mentre i suoi dipendenti vendono azioni come se fossero opzioni su GameStop nel 2021.

Ma in questo teatro di specchi chiamato Silicon Valley, l’eccezione è la norma. OpenAI, società nata come non profit con un’etica missionaria per “assicurare che l’intelligenza artificiale generale benefici tutta l’umanità”, oggi si muove come un hedge fund che ha appena letto “The Prince” di Machiavelli.

Se l’hai vista, non te la dimentichi più. Un alieno che beve birra. Un vecchio con un chihuahua e un cappello da cowboy. Un tizio che nuota in una piscina piena di uova. E no, non è il trailer di un film trash anni ’90 o un esperimento dadaista di Spike Jonze: è una pubblicità mandata in onda durante le NBA Finals. Il budget? Due spiccioli: 2.000 dollari. Il regista? Un tizio solo con un laptop e Google Veo 3. Benvenuti nell’era del slopvertising, la pubblicità generativa AI che mescola delirio e strategia come uno shaker senza coperchio.

C’era una volta Arc, l’adorabile eccesso nerd con l’ambizione di reinventare il browser. Sidebar, cartelle animate, icone fluttuanti come se la navigazione web fosse un esperimento di Bauhaus digitale. Poi qualcuno ha fatto due conti, guardato i numeri di adozione e ha detto: “troppo strano”. Così, The Browser Company è passata da “ridisegnare il web” a Dia, un’app che, almeno all’apparenza, sembra Chrome in giacca e cravatta. Ma sotto il cofano, è una macchina infernale di intelligenza artificiale che ti osserva, ti capisce e, potenzialmente, ti anticipa.

Inizia tutto come una carezza semantica, come sempre a Bruxelles: parole come “resilienza”, “razionalizzazione” e “equità” che sembrano uscite dal manuale del perfetto burocrate del XXI secolo. Peccato che sotto questa patina da ufficio stampa, il cosiddetto Digital Networks Act (DNA) riveli la sua vera natura: un attacco chirurgico, e tutt’altro che accidentale, al cuore stesso della rete europea. Non una riforma, ma una riconfigurazione strutturale del mercato digitale che punta a concentrare, centralizzare e — diciamolo chiaramente — sterilizzare la pluralità che oggi definisce l’Internet nel Vecchio Continente.

È ufficiale: l’intelligenza artificiale in Cina non è più solo una corsa tecnologica. È una guerra fredda a bassa latenza, giocata al ritmo di GPU e tariffe al millesimo di yuan. ByteDance, SenseTime, DeepSeek, Baidu, Alibaba: tutti a contendersi il trono dell’LLM più performante, più economico, più patriottico. E se vi aspettavate una lotta leale, preparatevi a qualcosa di più crudo: dumping cognitivo, propaganda di silicio e un’estetica da showroom di potenza computazionale.

Il protagonista della settimana è SenseTime, il colosso dell’AI quotato a Hong Kong e da sempre nel mirino geopolitico occidentale. Ha appena rilasciato un upgrade del suo Sensechat, un chatbot conversazionale ora dotato di capacità vocali e visive. Tradotto in termini brutali: parla cantonese, ti guarda, ti ascolta, e pensa anche – o almeno finge benissimo. La vera chicca? L’integrazione del modello multimodale SenseNova V6, che promette “visual reasoning”, ovvero la capacità di elaborare simultaneamente testo, video, audio, e – perché no – anche l’espressione rassegnata di un manager davanti al KPI che non sale.

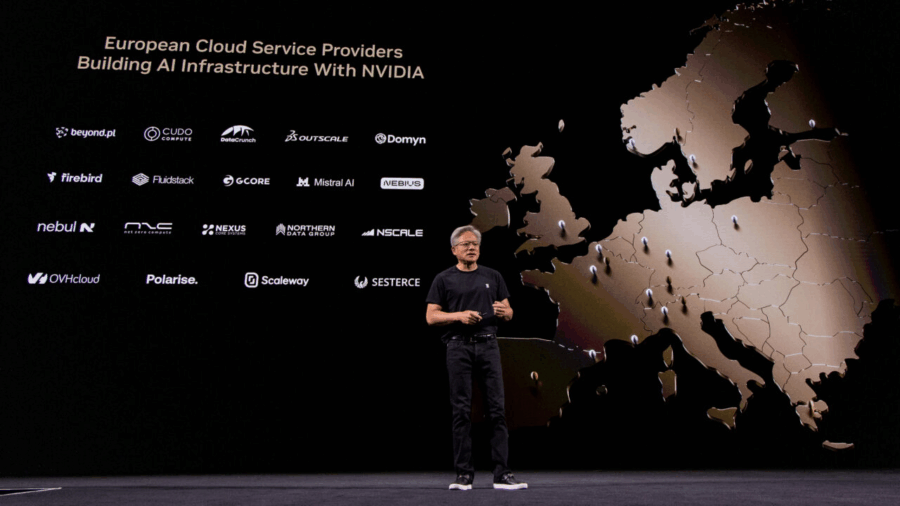

Jensen Huang non si è presentato a VivaTech con un keynote, si è presentato con un’operazione di conquista. Mentre Washington chiude le porte alla Cina e Nvidia assorbe colpi da miliardi di dollari a causa delle restrizioni all’export, l’Europa diventa improvvisamente sexy. Più che un piano industriale, quello del fondatore di Nvidia sembra un corteggiamento strategico: 20 fabbriche di intelligenza artificiale, decuplicazione della capacità computazionale, e un occhio lungo puntato su Parigi, Berlino e oltre.

Ma non facciamoci incantare dalla cortesia californiana del CEO con il bomber in pelle. Dietro il sorriso fotogenico e i robot da palcoscenico, si muove una manovra ad altissima densità geopolitica e commerciale: l’AI cloud industriale di Nvidia è, senza troppi giri di parole, il tentativo di trasformare l’Europa da cliente periferico a satellite strategico nella nuova architettura del potere computazionale globale.

Il momento preciso in cui una macchina ha dato l’illusione di “pensare” non è quando vince a scacchi, né quando genera un poema decente. È quando risolve un problema che, per definizione, non si può memorizzare. Come un maledetto word ladder da SPACE a EARTH, passo dopo passo, senza internet, senza imbrogli, senza contaminazioni.

La O3 Pro di OpenAI – sì, quella “cosa” misteriosa che aleggia sopra GPT-4 come una forma più lucida e meno nevrotica – l’ha fatto. Ha risolto un enigma logico che aveva ridotto ai minimi termini ogni altro modello, incluso il celebre e sovraesposto GPT-4. Una serie di trasformazioni di parole, ognuna semanticamente e ortograficamente vincolata, per arrivare dalla fredda vastità dello spazio alla fragile complessità della terra. E l’ha fatto in avanti. Non al contrario, come l’unico esempio noto su internet. Già questo dovrebbe far suonare qualche campanello.

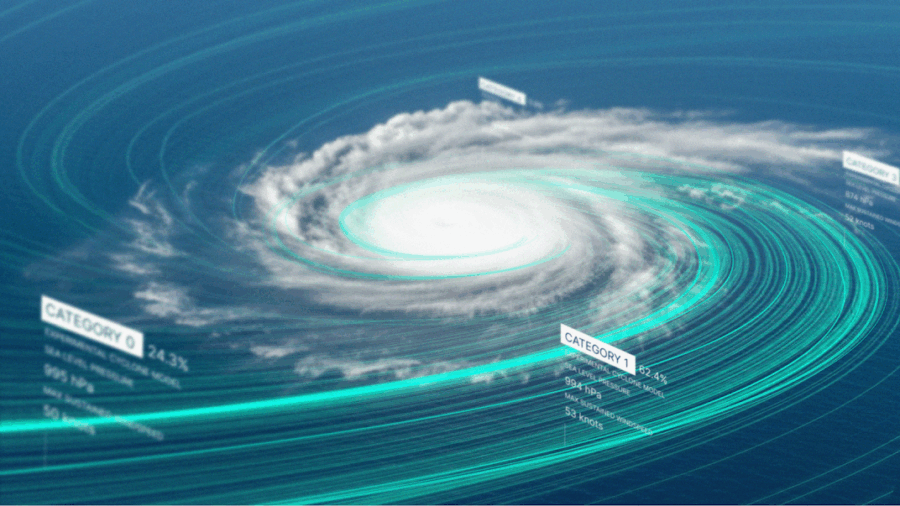

Se la Silicon Valley è la nuova Babilonia, oggi il suo oracolo si chiama DeepMind. E no, non sta leggendo i fondi di caffè: sta leggendo i venti, gli uragani e le correnti tropicali. Google ha appena annunciato il lancio di Weather Lab, una piattaforma che mostra al mondo come il suo modello sperimentale di previsione meteorologica, basato su intelligenza artificiale, possa battere — anzi, aggirare elegantemente — i modelli fisici tradizionali. Il bersaglio? I cicloni tropicali, che da fenomeni atmosferici stanno diventando test per stressare la soglia tra pubblico e privato, tra algoritmo e scienza, tra previsioni e controllo.

Ci sono momenti nella storia dell’informatica in cui le metafore saltano. Il desktop non è più un “desktop”, e nemmeno una scrivania virtuale. Con l’arrivo di Copilot Vision, Microsoft ha spalancato la finestra: adesso il tuo sistema operativo ha degli occhi. E li presta volentieri al suo assistente AI, che guarda, interpreta e reagisce in tempo reale a ciò che stai facendo. Sì, proprio come il collega ficcanaso in ufficio. Ma con meno giudizi morali e molta più RAM.

La parola chiave qui è visione. Copilot Vision non si accontenta di “capire” le tue parole. Vuole anche vedere il contesto in cui le stai digitando. Una vera e propria evoluzione cognitiva dell’assistente digitale, che ora può analizzare direttamente quello che appare sul tuo schermo — da una foto di famiglia a un layout di InDesign — per suggerire, spiegare, correggere, anticipare. Il tutto senza necessità di sottoscrivere Copilot Pro, perché sì, è gratuito. Almeno per ora, almeno negli Stati Uniti. La gentilezza dei colossi dura poco, come gli ombrelloni gratis a luglio.

Nel tempo in cui i manager diventano avatar vocali, e i board meeting si trasformano in prompt, accade l’impensabile: l’uomo che guida una delle fintech più aggressive d’Europa, Sebastian Siemiatkowski, CEO di Klarna, ha deciso di… smettere di parlare. O meglio, di delegare la sua voce a una IA che lo imita, lo cita, lo filtra e lo reinventa, come un assistente personale che ha fatto troppa strada con ChatGPT in tasca. E allora la domanda diventa inevitabile: se Luciano Floridi ha fatto il suo bot filosofico, perché un CEO non dovrebbe clonarsi vocalmente per parlare con i clienti? La risposta sta, come sempre, nel potere. Ma anche nella farsa.

In apparenza, Klarna sta innovando. Ma sotto, molto sotto, sta automatizzando una maschera. Ai clienti che chiamano la hotline negli Stati Uniti o in Svezia, risponde “AI Sebastian”, un clone vocale addestrato con la voce reale e le “esperienze” (già, esperienze) dell’originale. Una sintesi di toni, frasi fatte, narrazioni aziendali e storytelling personale. Nessuna emozione, solo brand voice. Un chatbot travestito da visionario scandinavo. Uno strano caso di CEO outsourcing, al contrario.

A Roma, tra la placida eleganza barocca di palazzi e la tensione strisciante del futuro digitale, il keynote di Stefano Quintarelli al Namex 2025 ha fatto più rumore di quanto ci si aspettasse. Sotto la superficie rassicurante della retorica mainstream sul digitale come panacea universale, Quintarelli ha smontato pezzo dopo pezzo la narrazione dominante. E ciò che ne emerge è un paradosso: stiamo guadagnando valore, ma ne beneficiamo sempre meno. In fondo, è la stessa logica con cui si può morire di sete su una zattera in mezzo all’oceano.

Partiamo dai numeri, quelli veri. Quintarelli, con l’ostinazione di un filosofo prestato all’ingegneria e il rigore di un contabile, ha citato dati ufficiali del Bureau of Economic Analysis statunitense: se si includono i servizi nel calcolo della bilancia commerciale, e si aggiusta il tutto per l’inflazione – magari usando il 2007, l’anno dell’iPhone, come spartiacque simbolico – il famigerato deficit commerciale USA smette di sembrare una voragine apocalittica. Anzi, è sorprendentemente stabile. Le esportazioni crescono, le importazioni pure. Ma non c’è alcun abisso in allargamento. E allora perché tutti urlano alla fine del mondo?

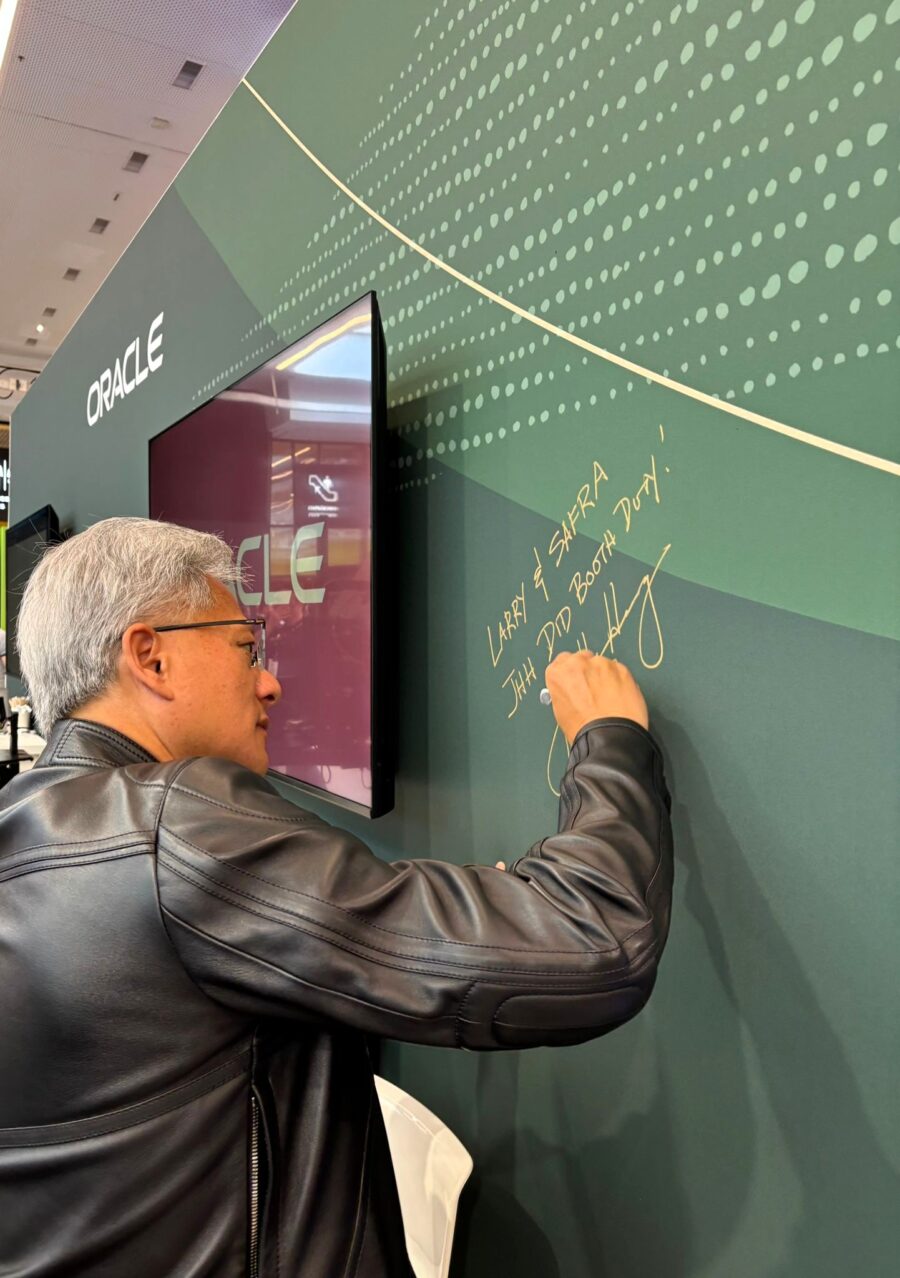

Da una parte una delle aziende più sottovalutate ma più longeve del cloud enterprise. Dall’altra il semidio delle GPU che ha reinventato la traiettoria del calcolo. Ecco a voi Oracle e NVIDIA: una strana coppia in missione per colonizzare l’intelligenza artificiale con un approccio che odora di strategia da Guerra Fredda più che di semplice evoluzione tecnologica.

L’annuncio? Di quelli che a prima vista sembrano uno dei tanti comunicati stampa scritti in stile-benessere-aziendale. Ma sotto la superficie c’è molto di più. Oracle ha deciso di spingere tutto il suo stack cloud nelle braccia muscolose della piattaforma AI di NVIDIA. E non si tratta solo di un abbraccio tecnico: parliamo di un’integrazione nativa, radicale, e soprattutto distribuita, che mette insieme 131.072 GPU Blackwell e il DGX Cloud Lepton. No, non è fantascienza: è OCI (Oracle Cloud Infrastructure) in versione steroidea.

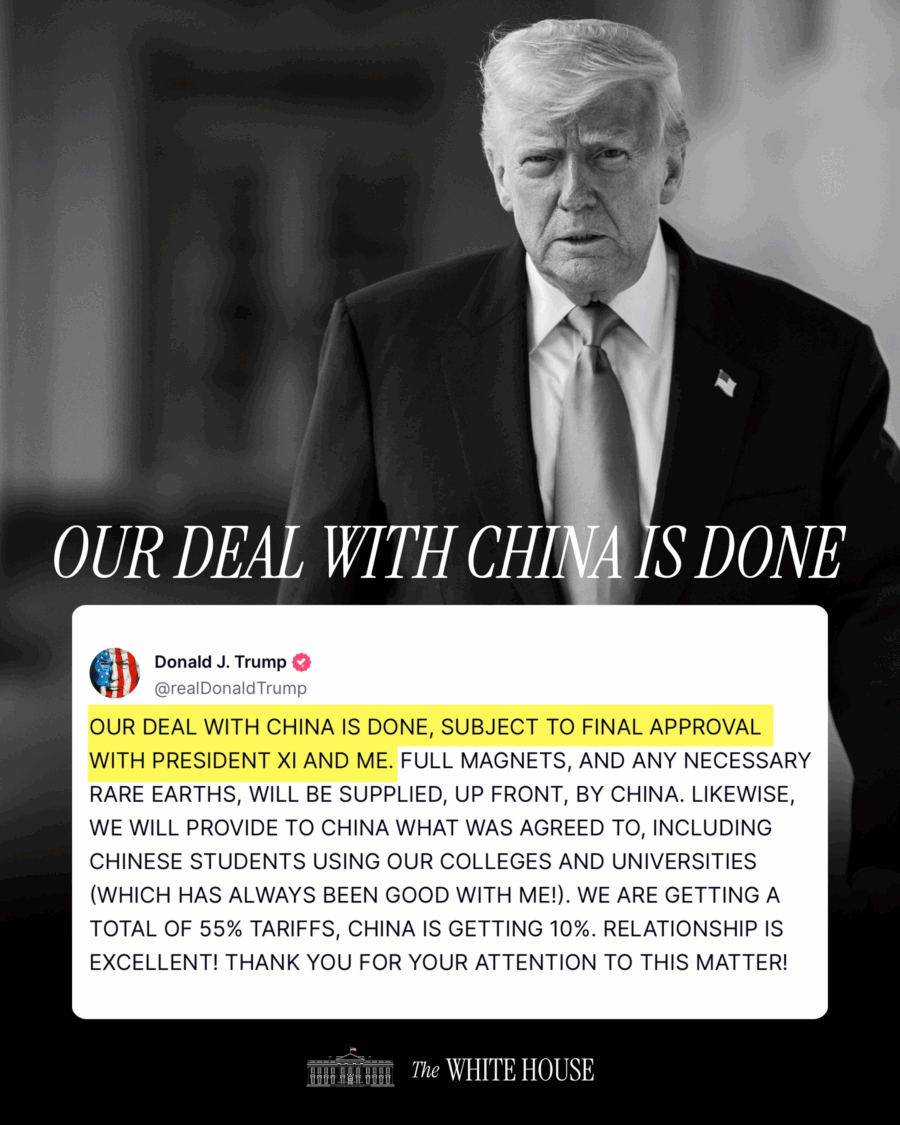

«OUR DEAL WITH CHINA IS DONE» twitta Trump con la sobrietà di un adolescente che ha finalmente ricevuto un like da Elon Musk. È mercoledì mattina, e il Presidente più imprevedibile della storia americana getta la notizia come un osso a una stampa affamata: l’accordo commerciale preliminare con la Cina è stato raggiunto. Una dichiarazione che, in altri tempi, avrebbe acceso i riflettori di Wall Street come Times Square a Capodanno. Ma stavolta no. Il mercato scrolla le spalle, forse sbadiglia. Perché?

I negoziatori di Stati Uniti e Cina hanno raggiunto un’intesa preliminare su un “quadro” generale, che ora verrà sottoposto ai rispettivi leader per la revisione, nel tentativo di riattivare l’accordo di tregua commerciale siglato a Ginevra il mese scorso.

Alla domanda su eventuali concessioni americane sul controllo delle esportazioni dopo i colloqui di Londra, la Casa Bianca ha evitato dettagli, ribadendo solo il rispetto dell’accordo di Ginevra. Secondo la portavoce Leavitt, la Cina si è detta disponibile ad aprire i suoi mercati agli USA in modo separato e ha acconsentito al rilascio di minerali strategici impiegati nei magneti, secondo i termini già pattuiti a Ginevra.

In un giorno che sembra uno spartiacque per il mercato dei database, Databricks ha annunciato oggi il lancio di Lakebase, una soluzione inedita pensata per aziende e sviluppatori desiderosi di costruire applicazioni e agenti AI su una piattaforma multi‑cloud unificata.

Immaginate un database operativo—di quelli che fanno girare le transazioni in tempo reale—progettato per l’era dell’IA, integrato con analytics e storage a bassissimo costo. È questa l’ambizione dichiarata da Lakebase: portare i dati operativi nel lakehouse, con compute che scala automaticamente e garantisce latenza sotto i 10 ms e capacità di gestire oltre 10 000 query al secondo.

Nessuno aveva chiesto il permesso. Nvidia è entrata in Europa come una valanga silenziosa, con l’annuncio che segna una nuova frontiera: la costruzione del primo cloud industriale AI europeo. Non un data center qualsiasi, ma una piattaforma con 10.000 GPU H100, pensata non per alimentare i meme su Midjourney, ma per far girare le macchine che muovono l’industria pesante, le smart factory e, soprattutto, le economie nazionali.

Dietro l’annuncio c’è molto di più che un’infrastruttura. C’è un messaggio politico. C’è l’idea, finora solo sussurrata nei corridoi della Commissione Europea, che il cloud “made in USA” non sia più sostenibile. E mentre Bruxelles balbetta leggi e regolamenti, Nvidia fa. E lo fa a casa nostra.

Non si tratta più di pacchi che arrivano a destinazione. È il tempo che viene domato. È il desiderio del cliente che viene previsto prima ancora che sia espresso. È Amazon che, con tre mosse di scacchi algoritmici, si prepara a mettere le mani sul vero potere dell’e-commerce globale: la predizione esatta. Non dei bisogni, ma delle condizioni affinché i bisogni si manifestino. Come un oracolo vestito da fattorino.

La chiamano “real-world value”, ma la posta in gioco è molto più sofisticata: chi controlla la mappa, controlla il territorio. E adesso, la mappa la disegna Amazon, pixel dopo pixel, con Wellspring, la sua nuova tecnologia di generative AI per la logistica, capace di trasformare un condominio labirintico o un quartiere appena nato in un sistema comprensibile, leggibile, prevedibile. Un algoritmo che osserva satellite, impronte degli edifici, foto di strada e persino le istruzioni del cliente, combinandoli in una rete neurale che “vede” meglio del corriere, “pensa” prima del cliente e “decide” come un architetto del delivery.

Oracle scommette tutto sulla nuvola e prende a calci la vecchia guardia

Il vecchio dinosauro di Redwood Shores ha finalmente tirato fuori i denti. Dopo anni passati a inseguire i giganti del cloud come un avvocato stanco che rincorre le big tech in tribunale, Oracle sembra aver trovato il suo punto di pressione: l’IA. E i numeri, almeno per ora, sembrano dare ragione a Safra Catz, che con un candore quasi spietato ha sparato: “Le nostre percentuali di crescita saranno drammaticamente più alte.”

Tradotto dal cattivo gergo delle earnings call: Oracle prevede una crescita del 70% nel business cloud nell’anno fiscale in corso. Una cifra che fa sobbalzare anche gli algoritmi delle sale trading, visto che il titolo è salito di oltre il 6% nel dopoborsa. Chiariamolo subito: non è solo storytelling da CFO con l’occhio lucido e il power suit impeccabile. Dietro c’è una scommessa brutale da $25 miliardi di capex, spinti soprattutto da acquisti di GPU Nvidia e altri arnesi indispensabili per servire il grande banchetto dell’intelligenza artificiale generativa.