Nel nuovo scenario digitale, l’intelligenza artificiale non è più solo un motore di innovazione: è anche una nuova superficie di attacco. Perchè l’AI, da un lato entra in azienda, dall’altro finisce anche nelle mani dei cybercriminali. E l’Italia non sembra essere pronta. L’allarme arriva forte e chiaro dal Cybersecurity Readiness Index 2025 di Cisco, secondo cui oltre la metà delle aziende italiane (il 51% per l’esattezza) prevede nei prossimi 12-24 mesi una possibile interruzione operativa causata da attacchi informatici legati all’AI.

Categoria: Sicurezza Pagina 3 di 6

Cybersecurity, Data Protection, Difesa, Aerospazio, Settori Strategici e Analisi Predittiva

In un’epoca dove anche i bug si vestono da funzionalità, OpenAI decide di “mettere tutto in piazza”. O almeno, così dice. Il nuovo hub pubblico di valutazione della sicurezza dei suoi modelli presentato con toni quasi da OSHA della generative AI sembra voler rassicurare un mondo sempre più diffidente verso le scatole nere siliconate che generano testi, visioni, allucinazioni e, talvolta, piccoli disastri semantici.

Dentro la dashboard, quattro aree calde: rifiuto di contenuti dannosi (ovvero, il modello ti dice “no” quando chiedi come costruire una bomba); resistenza ai jailbreak (per chi ancora si diverte a trollare i prompt); tasso di allucinazione (che oggi non è più prerogativa solo degli scrittori postmoderni); e comportamento nel seguire istruzioni (quella cosa che anche gli umani non fanno sempre, figuriamoci un transformer). Ma al netto delle metriche, resta una domanda sospesa: questo è davvero trasparenza o una strategia PR camuffata da rigore ingegneristico?

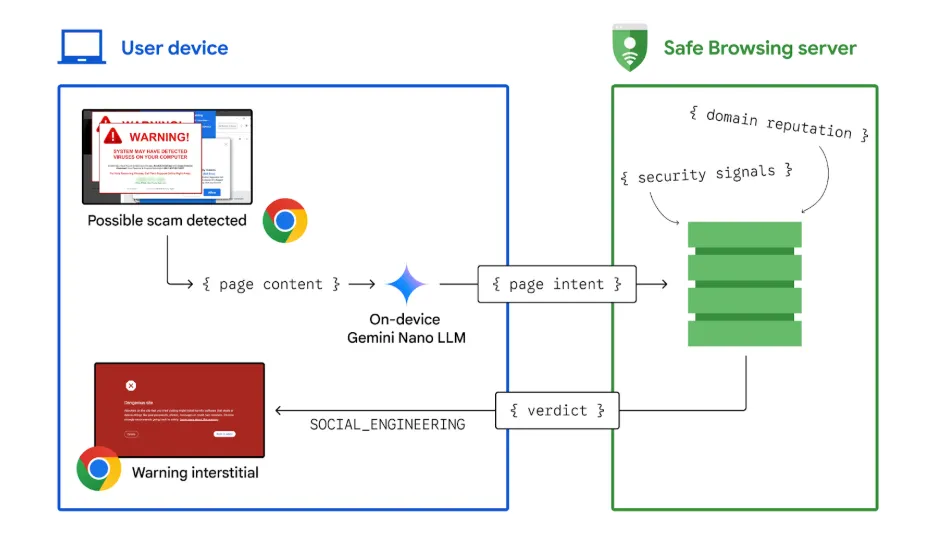

Il mondo digitale, come ogni bar malfamato di Caracas, ha i suoi borseggiatori. Solo che qui non usano le mani, ma le notifiche. Quelle stesse notifiche che ti compaiono sullo smartphone alle tre di notte con promesse oscene di guadagni facili, antivirus miracolosi e principi nigeriani in cerca d’amore. Google ha deciso di affrontare questa fiera del click truffaldino con una mossa che sa di rivoluzione (ma con il solito retrogusto di controllo totale): Chrome su Android ora usa intelligenza artificiale on-device per analizzare le notifiche e sputtanare in tempo reale quelle truffaldine. Tutto questo, ovviamente, senza mandare nulla ai server centrali. Giurano.

Google ha finalmente fatto una mossa che sa di resa dei conti tra la privacy e la sicurezza, tra il fastidio e la truffa conclamata. Con l’ultimo aggiornamento di Chrome per Android, è stato introdotto un sistema di difesa basato su intelligenza artificiale on-device, capace di identificare e bloccare notifiche sospette direttamente sul telefono, prima che possano trasformarsi in furti di dati o click su software da incubo.

Che succede quando il più grande player mondiale della cybersecurity decide di smontare i sogni di gloria dell’AI autonoma? Succede che Palo Alto Networks prende due agenti intelligenti identici nei compiti, strumenti e scopo e li bombarda con attacchi reali, dimostrando che la differenza tra framework CrewAI e Microsoft AutoGen è del tutto irrilevante. Entrambi falliscono miseramente. Non per colpa del codice, ma per colpa della presunzione.

C’è qualcosa di ironicamente tragico nel vedere il più grande colosso finanziario del mondo, JPMorgan Chase, dover scrivere una lettera aperta ai suoi fornitori per spiegare una verità che sembrava ovvia sin dall’inizio: correre come forsennati sull’adozione dell’intelligenza artificiale senza capirne i rischi è un suicidio annunciato. La storia la trovi qui JPMorgan Open Letter.

In un mondo già saturo di intelligenze artificiali che sembrano tutte un po’ cloni l’una dell’altra, CrowdStrike ha deciso di alzare il tiro e tirare fuori la sua pistola più grossa: Charlotte AI. Se ti aspetti la solita assistente virtuale che sussurra consigli banali a un povero analista sovraccarico, ti conviene cambiare canale. Qui siamo davanti a qualcosa che pensa, investiga e agisce in totale autonomia — ovviamente, con quei “guardrail” rassicuranti che piacciono tanto ai compliance officer.

Se ti chiedessi: “Compreresti un robot domestico, sapendo che viene guidato da un assistente umano nelle Filippine?”, la risposta istintiva sarebbe un misto di fascinazione e orrore. E sarebbe perfettamente normale. Perché in un mondo sempre più schizofrenico tra innovazione accelerata e rispetto umano in caduta libera, la nuova moda delle startup come Prosper è quella di unire outsourcing e robotica in un cocktail che sa di Black Mirror, ma con il sorriso corporate sulle labbra.

La recente pubblicazione del rapporto tecnico relativo a Gemini 2.5 Pro da parte di Google ha sollevato non poche polemiche, soprattutto per la sua scarsità di dettagli utili. Dopo settimane di attesa, il gigante di Mountain View ha finalmente rilasciato un documento che, tuttavia, lascia ancora molti interrogativi sulla sicurezza del suo modello. Come sottolineato da Peter Wildeford in un’intervista a TechCrunch, il rapporto in questione è troppo generico, al punto da risultare quasi inutile per una valutazione accurata della sicurezza del sistema.

L’assenza di dettagli chiave rende impossibile per gli esperti del settore capire se Google stia effettivamente rispettando gli impegni presi, e se stia implementando tutte le necessarie misure di protezione per garantire un utilizzo sicuro di Gemini 2.5 Pro. Il documento pubblicato non fornisce informazioni sufficienti a valutare se il modello sia stato sottoposto a test adeguati, né se le vulnerabilità potenziali siano state analizzate in modo rigoroso. In sostanza, non c’è modo di capire come Google stia affrontando la questione della sicurezza nei suoi modelli AI più recenti, lasciando un alone di opacità che solleva dubbi sulle reali intenzioni dell’azienda.

Il 27 aprile 2025, l’European Data Protection Board (EDPB) ha pubblicato il suo report annuale 2024, un documento che si potrebbe sintetizzare con una sola parola: adattamento. In un contesto regolatorio e tecnologico che evolve a ritmi compulsivi, l’EDPB cerca di non restare indietro. Ma riesce davvero a tenere il passo?

Il report, disponibile con tanto di executive summary direttamente dalla fonte ufficiale, parte con il tono da grande assemblea multilaterale: dichiarazioni solenni, buone intenzioni, retorica dell’impegno civico. La Presidente Anu Talus ribadisce che il 2024 è stato l’anno del consolidamento della missione fondativa dell’EDPB: difendere i diritti fondamentali alla privacy e alla protezione dei dati personali, mentre il mondo digitale si trasforma sotto i nostri piedi.

Nel secondo semestre del 2024, i cyberattacchi crescono del +28,3%, nonostante il calo delle gang attive. AI, phishing realistici e Malware-as-a-Service ridisegnano il panorama delle minacce globali. L’Italia resta un obiettivo strategico.

Se c’è un settore dove l’Europa ha storicamente arrancato — tra proclami vaghi e mille “strategia comuni” mai implementate — è proprio la cybersicurezza. Troppa frammentazione, troppe gelosie nazionali, troppi piani che si fermavano alla slide. Ma nel 2023 qualcosa è cambiato. E stavolta non si tratta solo di un fondo da annunciare a Davos.

Parliamo di 27 Centri Nazionali di Coordinamento per la Cybersicurezza, uno per ogni Stato Membro UE. Non centri “di facciata” piazzati in qualche capoluogo per dare una carezza alla politica locale, ma strutture operative, tecniche, integrate in una rete continentale che punta a un obiettivo tanto ambizioso quanto necessario: la difesa digitale coordinata e distribuita.

L’Irlanda, terra di folletti, di San Patrizio e headquarters tech europei, ha deciso di non farsi incantare dalle magie di Elon Musk. Il suo nuovo giocattolo, Grok, l’intelligenza artificiale sviluppata da xAI, è ufficialmente sotto indagine da parte del Data Protection Commission (DPC) irlandese. E come sempre, non si parla di dettagli tecnici ma di privacy, la moneta più preziosa nell’economia dell’attenzione.

Il cuore della questione è la presunta violazione del GDPR, quel famigerato regolamento europeo che ogni CEO americano sembra conoscere solo per sentito dire, ma che puntualmente riesce a ignorare finché non arriva una sanzione milionaria. Secondo l’autorità irlandese, Grok sarebbe stato addestrato usando i post degli utenti europei su X, la piattaforma social ex-Twitter, di proprietà dello stesso Musk. Il problema? Quei dati potrebbero essere stati utilizzati senza un consenso esplicito e informato, come richiesto dalla normativa comunitaria. In altre parole: “Caro Elon, non puoi usare i nostri tweet per insegnare al tuo robottino a parlare, se prima non ci chiedi il permesso.”

Nel 2023, OpenAI sembrava incarnare il paradigma della responsabilità etica nella corsa all’intelligenza artificiale. Sei mesi di test per GPT-4, un impegno pubblico verso la trasparenza e persino collaborazioni con istituzioni governative per garantire che la nuova tecnologia non si trasformasse in un’arma nelle mani sbagliate. Ma quell’immagine da tech-samaritani sembra già roba da archivio storico. Oggi, il nuovo modello “o3” viene lanciato dopo appena pochi giorni di valutazioni. Una marcia forzata al rilascio che ha tutta l’aria di una sindrome da IPO imminente o da guerra fredda tra colossi dell’IA. O entrambe.

Dietro questa virata non ci sono misteri: pressione competitiva, fame di mercato, e un culto ossessivo per il “first mover advantage” stanno spingendo OpenAI ad accelerare brutalmente il ciclo di sviluppo dei suoi modelli. Il problema? Che questi modelli non stanno diventando solo più intelligenti, ma anche più pericolosi. E il tempo per verificarlo si è drasticamente ridotto.

Negli ultimi anni, il panorama delle minacce informatiche si è evoluto a una velocità impressionante. Gli hacker affinano costantemente le loro tecniche, mentre le aziende cercano di stare al passo con difese sempre più sofisticate. Il Sophos Active Adversary Report 2025 lancia, da questo punto di vista, un segnale d’allarme chiaro: la semplice prevenzione non è più sufficiente.

Quando il 1° aprile 2025, la notizia della sospensione dell’account di Pliny, uno dei più celebri “jailbreakers” dell’intelligenza artificiale, è emersa, in molti hanno pensato a un pesce d’aprile. Tuttavia, come spesso accade, la realtà si è rivelata molto più interessante di una semplice burla. OpenAI ha effettivamente disattivato l’accesso a ChatGPT di Pliny, citando violazioni delle sue politiche legate a “attività violente” e “creazione di armi”. Eppure, questa sospensione ha innescato una serie di eventi e riflessioni che meritano attenzione, poiché illuminano le dinamiche di un settore sempre più al centro delle controversie sull’uso sicuro e etico delle intelligenze artificiali.

In un mondo in cui le minacce alla sicurezza si evolvono rapidamente, l’Europa si prepara a un cambiamento epocale con ProtectEU, la nuova strategia per la sicurezza interna presentata dalla Commissione Europea. Annunciata dalla presidente Ursula von der Leyen nelle sue linee guida politiche, questa iniziativa ambiziosa mira a rafforzare la capacità dell’Unione Europea di proteggere i suoi cittadini, affrontando sia le minacce tradizionali che quelle emergenti in un panorama geopolitico sempre più complesso. Con un approccio che coinvolge l’intera società, ProtectEU si propone di rivoluzionare il modo in cui l’Europa gestisce la sicurezza interna, promuovendo una cooperazione più profonda, strumenti legali più rigorosi e una maggiore condivisione delle informazioni.

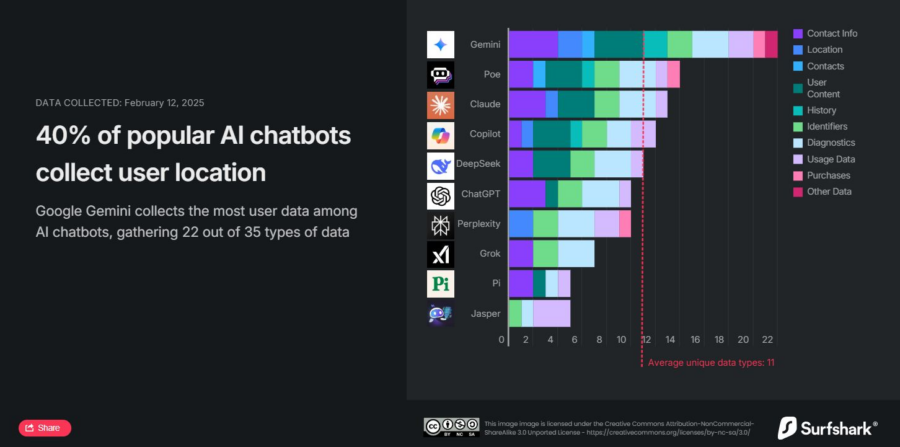

L’idea che un assistente virtuale possa essere un amico fidato è una delle più grandi illusioni dell’era digitale. Dietro l’apparente neutralità di un chatbot si cela una realtà ben più inquietante: il 30% delle app di intelligenza artificiale più popolari condivide i tuoi dati con terze parti.

Abbiamo analizzato le pratiche di raccolta dati dei 10 chatbot più diffusi sull’Apple Store, da Google Gemini a DeepSeek, ChatGPT e altri. I risultati? Ogni chatbot raccoglie informazioni su di te, con una media di 11 tipi di dati per app su un totale di 35 possibili categorie. Alcuni arrivano a collezionare dettagli inquietanti, come la posizione precisa, lo storico delle ricerche e persino la tua lista contatti.

Un drone di fabbricazione russa è stato avvistato vicino a Ispra, in provincia di Varese, violando una «no fly zone» altamente sorvegliata. Secondo il Corriere della Sera, il velivolo avrebbe sorvolato per circa una settimana la zona del Joint Research Centre della Commissione europea, sul lago Maggiore. Il Centro comune di ricerca europeo ha rilevato il drone grazie a un sistema sperimentale per individuare velivoli sconosciuti. A marzo sono stati registrati almeno cinque passaggi, provocando l’allarme sicurezza.

Benvenuti nell’era in cui ogni vostro movimento, ogni decisione, ogni interazione è potenzialmente registrata, analizzata e archiviata. Se pensavate che il concetto di “privacy” avesse ancora qualche significato, Waldo 3.0 potrebbe essere la prova definitiva che vi sbagliate. Questo modello di AI di rilevamento avanzato è in grado di identificare e tracciare oggetti, veicoli, persone e infrastrutture, dalle immagini satellitari a quelle catturate da un drone a pochi metri dal suolo.

Ma non si tratta solo di tecnologia all’avanguardia per il monitoraggio urbano, la sicurezza pubblica o la gestione delle emergenze. Il vero problema è che ogni innovazione come questa sposta l’ago della bilancia sempre più verso un controllo totale, normalizzando una sorveglianza che una volta sarebbe stata considerata fantascientifica.

Il mondo della cybersecurity è nuovamente in allerta: FamousSparrow, gruppo APT (Advanced Persistent Threat) allineato alla Cina, ha ripreso le proprie attività di cyberspionaggio, colpendo organizzazioni negli Stati Uniti, in Messico e in Honduras. Dopo un’apparente inattività di due anni, i ricercatori di ESET hanno scoperto nuove varianti della backdoor SparrowDoor e l’impiego, per la prima volta, del malware ShadowPad.

Il lavoro Prompt Injection Detection and Mitigation via AI Multi-Agent NLP Frameworks di Diego Gosmar Deborah A. Dahl, Dario Gosmar rappresenta un passo avanti nella lotta contro i prompt injection attacks. Il framework multi-agente non solo migliora la sicurezza dei modelli linguistici, ma pone anche le basi per un’AI più affidabile e conforme alle normative. Con l’aumento dell’integrazione dell’AI nei processi aziendali e sociali, soluzioni come questa saranno fondamentali per garantire la robustezza dei sistemi futuri.

Negli ultimi anni, l’intelligenza artificiale generativa (Generative AI) ha trasformato numerosi settori, dal customer service all’automazione dei contenuti. Tuttavia, questa rivoluzione è accompagnata da nuove vulnerabilità, tra cui i cosiddetti prompt injection attacks. Questi attacchi sfruttano la tendenza dei modelli di linguaggio a seguire istruzioni, anche quando queste sono progettate per aggirare le loro restrizioni. Un recente studio condotto da Diego Gosmar e colleghi propone un approccio innovativo per affrontare questa minaccia: un framework multi-agente che combina rilevamento, sanitizzazione e enforcement delle policy.

All’evento di Seeweb e Istituto EuropIA.it “Private AI”, Stefano Quintarelli Informatico, imprenditore seriale ed ex professore di sistemi informativi, servizi di rete e sicurezza, ha portato un esempio, tra i tanti, reti neurali, sistemi predittivi etc, che ho trovato interessante e vorrei condividere con i nostri lettori: “Lessons from red teaming 100 generative AI products Authored by: Microsoft AI Red Team”, che trovate in allegato.

Stefano Quintarelli, ha recentemente sollevato un punto cruciale riguardo alla sicurezza dell’intelligenza artificiale (IA), evidenziando una verità fondamentale che spesso viene sottovalutata. La sua affermazione che la sicurezza dell’IA non sarà mai “completata” è una riflessione profonda che tocca uno degli aspetti più critici nell’evoluzione della tecnologia. Con il costante avanzamento delle tecnologie, la protezione da minacce potenziali diventa un campo in continua espansione, mai definitivo. Questo concetto va oltre la semplice sicurezza dei sistemi: implica una continua adattabilità delle misure di protezione e una vigilanza costante rispetto alle vulnerabilità emergenti.

Recenti indagini hanno svelato una sofisticata operazione di disinformazione orchestrata dalla Russia, volta a manipolare i chatbot basati sull’intelligenza artificiale (IA) per diffondere la propaganda del Cremlino.

Questa strategia, che sfrutta le potenzialità delle moderne tecnologie, rappresenta una nuova frontiera nella guerra dell’informazione.

Ivan Shkvarun intelligenza artificiale: l’evoluzione delle minacce invisibili e la corsa alla difesa

Ivan Shkvarun, Fondatore e CEO di Social Links, e Autore dell’Iniziativa Darkside AI. Lo abbiamo incontrato all’ AI Festival dove ha presentato per la prima volta l’iniziativa Darkside AI, con esempi reali di manipolazione dei consumatori, abbiamo condiviso una intervista sulle strategie per aiutare le aziende a difendersi dalle inganni alimentati dall’AI.

Ivan è un esperto di punta nell’AI e nell’intelligence a codice aperto (OSINT), con oltre 15 anni di esperienza nella mitigazione dei rischi guidata dalla tecnologia. Sotto la sua leadership, Social Links — riconosciuta da Frost & Sullivan come leader nel settore OSINT — ha sviluppato soluzioni alimentate dall’AI che espongono e neutralizzano il crimine informatico, la disinformazione e le frodi digitali a livello globale.

Evoluzione delle minacce AI-driven

Rivista.AI: Negli ultimi 15 anni, come sono cambiati i modelli operativi degli attori malevoli nell’utilizzo dell’AI per frodi e disinformazione? Quali tecniche emergenti (es. generative adversarial networks, LLM avanzati) stanno rivoluzionando il panorama delle minacce? [Esempi specifici?]

In che modo le identità sintetiche e i deepfake stanno superando le tradizionali difese biometriche o di verifica dell’identità? Esistono differenze geografiche nell’adozione di queste tecnologie a scopo malevolo?

Ivan Shkvarun: Negli ultimi dieci anni, ho assistito all’evoluzione del cybercrimine, passato da semplici violazioni di sistema a una manipolazione su larga scala della percezione e della fiducia umana. L’AI non è più solo uno strumento di innovazione: viene anche utilizzata come arma, trasformando le classiche truffe di phishing e i botnet in deepfake iper-realistici, disinformazione generata dall’AI e reti di frode completamente automatizzate.

Questo cambiamento non è ipotetico; stiamo già vedendo le conseguenze. Si prevede che le perdite per frodi legate all’AI passeranno dai 12,3 miliardi di dollari del 2023 a 40 miliardi entro il 2027, e questa è una stima prudente. L’impatto finanziario è concreto, ma il problema più profondo è la fiducia. Quando l’AI può generare identità sintetiche credibili, documenti finanziari falsificati e notizie generate dall’AI su larga scala, mina le fondamenta stesse della sicurezza digitale.

L’Europa si trova a un punto di svolta: i rapidi progressi delle tecnologie digitali, l’aumento delle minacce informatiche e un contesto geopolitico in continua evoluzione stanno spingendo l’Unione Europea e i suoi Stati membri a ripensare la sicurezza dello spazio digitale. “Mentre lavoriamo per mantenere un’economia forte e sicura, la necessità di una sicurezza informatica rafforzata in tutti i settori non è mai stata così urgente”, si legge nella Warsaw Call, una dichiarazione adottata all’unanimità durante il Consiglio informale Telecomunicazioni tenutosi a Varsavia il 5 marzo 2025. Questo documento, noto anche come Dichiarazione di Varsavia, rappresenta un pilastro strategico per il futuro della cybersecurity europea, offrendo una risposta coordinata alle crescenti sfide che minacciano la stabilità digitale del continente.

La Cina continua a rafforzare il suo apparato militare con un approccio che definisce “moderato e ragionevole”, mantenendo una crescita della spesa per la difesa a una cifra per il nono anno consecutivo. A sottolinearlo è stato Lou Qinjian, portavoce del Congresso Nazionale del Popolo (NPC), durante il briefing di presentazione dell’evento politico più importante dell’anno per la Repubblica Popolare, che si terrà a partire da domani, 5 marzo 2025. Sarà proprio quello il momento nel quale l’NPC svelerà il budget della difesa per il 2025, un dato atteso con attenzione sia dagli analisti interni sia dalla comunità internazionale, desiderosa di decifrare le ambizioni del Dragone in un contesto globale sempre più teso.

In Italia, il panorama della cybersecurity si fa sempre più critico: gli attacchi informatici, potenziati da tecnologie avanzate e dall’intelligenza artificiale, sono in aumento, colpendo il 73% delle grandi imprese nell’ultimo anno, secondo i dati dell’Osservatorio Cybersecurity & Data Protection del Politecnico di Milano. Nel 2024, il mercato italiano della sicurezza informatica cresce del 15%, raggiungendo un valore di 2,48 miliardi di euro, con previsioni di ulteriore espansione nel 2025. Eppure, nonostante i progressi, l’Italia rimane fanalino di coda tra i Paesi del G7 nel rapporto tra spesa in cybersecurity e PIL, ben lontana dai livelli di Stati Uniti e Regno Unito.

Negli ultimi mesi, l’Italia è stata teatro di una serie di attacchi DDoS (Distributed Denial of Service) orchestrati dal gruppo di hacker attivisti russi NoName057, noto per la sua fedeltà ideologica al Cremlino e per le sue azioni contro i Paesi occidentali che sostengono l’Ucraina. Le offensive, peraltro iniziate nel 2022 ma intensificatesi in modo significativo nei primi mesi del 2025, hanno preso di mira infrastrutture critiche, grandi aziende e enti pubblici italiani, tra cui i siti web del Ministero degli Esteri, gli aeroporti di Milano Linate e Malpensa, banche come Intesa Sanpaolo e Monte dei Paschi di Siena, e persino portali di trasporto pubblico come ATAC a Roma e AMT a Genova.

Verizon Business e Accenture hanno annunciato una partnership strategica per affrontare le crescenti sfide della cybersecurity, un settore in rapida evoluzione che richiede soluzioni innovative e resilienti. L’accordo unisce le competenze di Verizon nel networking e nella sicurezza informatica con l’esperienza di Accenture nei servizi tecnologici avanzati, con l’obiettivo di sviluppare e offrire soluzioni all’avanguardia per proteggere le organizzazioni di ogni dimensione da minacce sempre più sofisticate, come violazioni dei dati, attacchi di phishing, social engineering e altri rischi emergenti.

Il Segretario alla Difesa Pete Hegseth ha ordinato al Cyber Command degli Stati Uniti di sospendere la pianificazione di operazioni informatiche e di intelligence contro la Russia.

Nel corso del 2024 in Italia sono stati registrati 1.927 attacchi informatici, il 18% in più rispetto all’anno precedente anche se, quelli andati a buon fine, 467 in totale, sono diminuiti del 10% rispetto al 2023 e del 63% rispetto al 2022. Sono i dati, contenuti nel ‘Threat intelligence report’ pubblicato dall’osservatorio cybersecurity di Exprivia, che evidenziano inoltre che gli hacker sono andati a segno il 24% delle volte (contro il 31% dell’anno precedente) e che nel 30% degli attacchi portati a termine e quindi riusciti è stata utilizzata l’intelligenza artificiale.

Notizie dagli USA.

La recente nomina di Scale AI come primo valutatore terzo autorizzato dall’Istituto per la Sicurezza dell’Intelligenza Artificiale degli Stati Uniti (AISI) rappresenta un passo significativo verso una maggiore sicurezza e affidabilità nello sviluppo dei modelli di intelligenza artificiale.

Questa collaborazione mira a sviluppare metodi avanzati per testare i modelli di frontiera dell’IA, includendo valutazioni congiunte tra l’AISI e il Safety, Evaluation, and Alignment Lab (SEAL) di Scale AI. Attraverso questi metodi, i costruttori di modelli di diverse dimensioni potranno accedere volontariamente a nuove forme di test affidabili, con la possibilità di condividere i risultati con una rete globale di istituti di sicurezza dell’IA.

Questa partnership non solo rafforza la posizione di Scale AI nel panorama dell’IA, ma suggerisce anche una visione ottimistica per il futuro dell’AISI. È improbabile che Scale AI avrebbe intrapreso questo accordo se ci fossero stati dubbi sulla stabilità o sulla continuazione dell’istituto, indipendentemente dalle dinamiche politiche attuali o future.

Recentemente, i giganti tecnologici Apple e Google hanno rimosso fino a 20 app dai loro store dopo che gli esperti di sicurezza di Kaspersky hanno scoperto che queste applicazioni contenevano malware. Questo malware, noto come SparkCat, è in grado di rubare frasi di recupero dei portafogli di criptovalute utilizzando tecniche avanzate come il riconoscimento ottico (OCR).

Nel settore aerospaziale, la velocità e l’efficienza nello sviluppo di nuove tecnologie sono fattori chiave per la competitività. La collaborazione tra Altair e Meridian Flight Systems segna un passo avanti nell’integrazione dell’Intelligenza Artificiale e della simulazione avanzata per accelerare l’innovazione nel settore degli UAV (Unmanned Aerial Vehicle), i velivoli senza pilota.

Lo vediamo dalle pubblicità on line e in televisione. L’argomento della sicurezza è presente in ogni istante della nostra vita. Vediamo come l’AI al servizio della sicurezza riesce a creare nuovi strumenti per tenerci sempre meglio al sicuro rispetto al passato.

E siamo solo all’inizio!

Nel panorama tecnologico odierno, i giganti americani come Amazon, Alphabet (la società madre di Google), Microsoft e Meta stanno pianificando di investire oltre 300 miliardi di dollari in infrastrutture per l’intelligenza artificiale nel 2025. Questo rappresenta un aumento significativo rispetto ai 230 miliardi spesi l’anno precedente, evidenziando l’importanza strategica attribuita all’AI da queste aziende.

Amazon prevede di guidare questa ondata di investimenti con una spesa di 100 miliardi di dollari, focalizzandosi principalmente su Amazon Web Services (AWS), la sua divisione cloud. Il CEO Andy Jassy ha sottolineato che l’IA rappresenta un’opportunità tecnologica storica, paragonabile all’avvento di Internet, e ha evidenziato la necessità di garantire una potenza di calcolo sufficiente per lo sviluppo e l’operatività dei modelli AI.

Recentemente, è emerso uno scandalo in Italia riguardante l’uso di Graphite per spiare giornalisti e attivisti. Meta, la società madre di WhatsApp, ha scoperto che il software veniva installato attraverso messaggi o chiamate su WhatsApp, permettendo di rubare informazioni senza che l’utente dovesse cliccare su alcun link. In Italia, almeno sette persone sono state colpite, tra cui Francesco Cancellato, direttore del quotidiano digitale Fanpage, e Luca Casarini, attivista della ONG Mediterranea. Il governo italiano ha negato qualsiasi coinvolgimento, ma Paragon ha sospeso il suo contratto con l’Italia a causa di violazioni del “quadro etico” dell’accordo.

WhatsApp ha denunciato una campagna di cyberspionaggio che ha coinvolto circa 90 giornalisti e attivisti in una ventina di paesi, realizzata utilizzando spyware dell’azienda israeliana Paragon Solutions. La campagna, interrotta nel dicembre 2024, prevedeva l’invio di file PDF dannosi per accedere illegalmente ai dati personali degli utenti. WhatsApp ha notificato le vittime e ha esortato Paragon a cessare le sue attività, non escludendo azioni legali.

E chi l’avrebbe mai detto? L’intelligenza artificiale, quella meravigliosa creatura di Big Tech nata per rendere il mondo un posto migliore, sta finendo nelle mani sbagliate. Stando a quanto riportato da Bleeping Computer, il Threat Intelligence Group (GTIG) di Google ha fatto una scoperta che ha dell’incredibile (o forse no?): gruppi di cybercriminali sponsorizzati dai governi stanno usando Gemini per pianificare i loro attacchi con una precisione chirurgica. E non parliamo di ragazzini annoiati nel seminterrato, ma di squadre di hacker professionisti che puntano dritti alle infrastrutture critiche e ad altri obiettivi di alto valore. In pratica, invece di essere solo uno strumento di produttività, l’AI si sta rivelando un prezioso alleato per chi vuole seminare il caos.

Il 2024 ha segnato un anno straordinario per la ricerca sulla sicurezza informatica, con un livello di innovazione senza precedenti. Dall’hijacking di OAuth ai nuovi exploit nei web server Apache, queste scoperte non solo ridefiniscono le minacce esistenti, ma introducono anche nuove classi di attacchi che i professionisti della sicurezza dovranno affrontare nei prossimi anni.