La velocità non è più un lusso ma un’ossessione tra i giganti del genomics. Shenzhen-based MGI Tech ha appena rotto il termometro dell’innovazione presentando il DNBSEQ-T7+, un sequenziatore che pretende di battere ogni record, fabbricando 144 genomi umani al giorno. Facciamoci due conti: un intero genoma ogni 10 minuti. Un trionfo di throughput, la parola chiave che dovrebbe far suonare campanelli d’allarme nei board biotech convinti che il tempo non sia denaro ma vita.

Sono più di 14 terabase al giorno: un salto doppio rispetto al T7 precedente, e se MGI promette facilità, compattezza e automazione end-to-end, non è una sciocchezza. È piuttosto un’arma da Pipeline. E a confronto, Illumina vanta 16 Tb per corsa sul NovaSeq X, ma serve fino a 48 ore. Il T7+ invece ti riduce i tempi, raddoppia la resa, occupa poco spazio, e non ti fa aspettare metà giorno per vedere un risultato.

Il concetto di ricerca sul web così come lo conoscevamo è morto. Non con un colpo di scena, ma con un algoritmo silenzioso che ci serve le risposte prima ancora che ci accorgiamo di avere una domanda. Google, con i suoi AI Overviews lanciati negli Stati Uniti a maggio 2024, ha inaugurato un’era in cui gli utenti ottengono risposte concise direttamente nella pagina dei risultati, senza bisogno di cliccare su un singolo link. Questo non è solo un miglioramento dell’esperienza utente, è una rivoluzione che ribalta interi modelli di business digitali e la catena del traffico online.

La scena è questa: un titolo poco noto come Nebius, capitalizzazione di mercato di circa 15 miliardi di dollari, annuncia che affitterà GPU Nvidia a Microsoft con un contratto pluriennale da 17,4 miliardi fino al 2031. Le azioni schizzano del 40% nell’after hours, gli investitori esultano e il settore dei data center AI prende nota. Non è soltanto la storia di un accordo, è la dimostrazione plastica di come si stia ridisegnando la geografia del potere tecnologico. Microsoft non compra, Microsoft affitta. Scarica il rischio, come fa da tempo con CoreWeave, e mette Nebius in prima fila nella corsa globale alle GPU.

Quando parliamo di autoencoder, non stiamo parlando di una moda passeggera nel machine learning, ma di uno dei pilastri più eleganti e sottili della rappresentazione dei dati. Immagina di avere un oceano di numeri, immagini o segnali, e di riuscire a comprimerli in poche coordinate senza perdere l’essenza. Questa non è fantascienza, è matematica applicata e ingegneria neurale. Autoencoder funziona codificando i dati in uno spazio latente più piccolo tramite una rete neurale, per poi ricostruirli. Il risultato? Una rete che capisce i dati meglio di chiunque li abbia mai guardati senza strumenti di compressione.

ASML ha appena compiuto una mossa audace, investendo 1,3 miliardi di euro in Mistral AI, una startup francese di intelligenza artificiale. Con questa operazione, ASML acquisisce una partecipazione dell’11%, diventando il principale azionista di Mistral. La valutazione di Mistral raggiunge ora i 10 miliardi di euro, posizionandola tra le startup di IA più promettenti d’Europa.

Nel giugno 2025, il National Institute of Standards and Technology (NIST) ha presentato al pubblico il Colorado University Randomness Beacon (CURBy), un generatore di numeri casuali che sfrutta i principi della meccanica quantistica per produrre sequenze di numeri veramente casuali. Questa innovazione rappresenta un passo significativo verso la creazione di sistemi digitali più sicuri e trasparenti, fondamentali in un’epoca in cui la fiducia digitale è messa alla prova da attacchi sempre più sofisticati.

CURBy si basa su esperimenti di entanglement quantistico, noti come test di Bell, per generare numeri casuali. Questi esperimenti dimostrano che le particelle possono essere correlate in modo tale che lo stato di una influenzi istantaneamente l’altro, indipendentemente dalla distanza che le separa. Utilizzando questa proprietà, CURBy produce sequenze di numeri che sono intrinsecamente imprevedibili e non possono essere riprodotte da algoritmi deterministici.

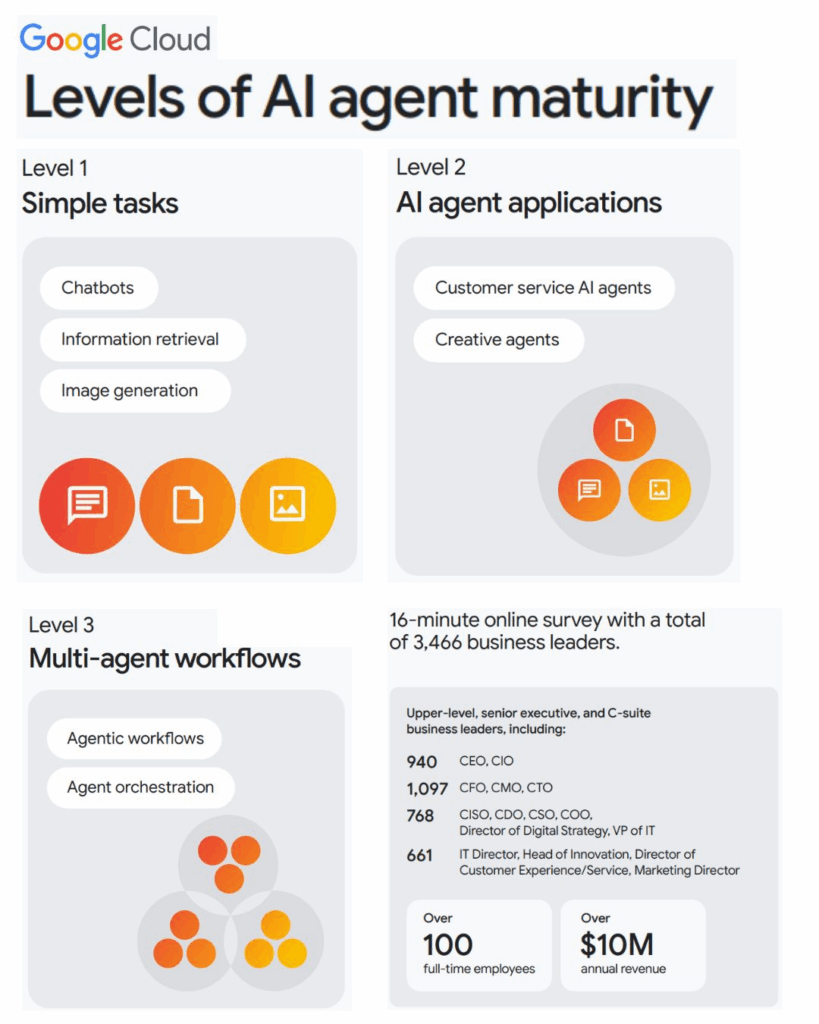

Parlare di AI oggi significa smettere di immaginare robot futuristici e iniziare a guardare al mondo silenzioso ma feroce dei software intelligenti che orchestrano azioni complesse come se fossero team di ingegneri ipercompetenti. Secondo il rapporto Google Cloud 2025, esistono tre fasi di maturità dei cosiddetti AI agents che ogni leader aziendale e praticante di intelligenza artificiale deve conoscere. La lettura non è solo interessante, è un piccolo manuale di sopravvivenza nel prossimo decennio digitale.

Cisco e NVIDIA hanno appena inaugurato la cosiddetta Secure AI Factory, un termine che suona futuristico ma che in pratica significa infrastrutture integrate per far girare l’intelligenza artificiale senza rischi, senza blocchi e senza scuse. L’obiettivo dichiarato non è solo vendere hardware o licenze software, ma creare un ecosistema in cui le imprese possano finalmente trattare l’AI come una forza lavoro concreta, non più un esperimento di laboratorio.

Tesla ha appena aperto una nuova finestra sul futuro, o forse una porta d’ingresso per l’Asia: il suo account ufficiale Weibo, “TeslaAI”, è online. Un passo che non è solo una mossa di marketing, ma un segnale chiaro: la Cina è pronta per l’Optimus. E Tesla? Beh, non sta solo cercando di entrare nel mercato dei robot umanoidi; sta cercando di dominarlo.

Nel panorama in continua evoluzione delle valutazioni delle intelligenze artificiali, un recente intervento di Meta FAIR ha sollevato interrogativi fondamentali sull’affidabilità di uno dei benchmark più utilizzati: SWE-bench Verified. Jacob Kahn, responsabile del laboratorio di ricerca Meta AI FAIR, ha denunciato la presenza di “numerosi punti deboli” in questo strumento, suggerendo che modelli di intelligenza artificiale avanzati come Claude 4 Sonnet di Anthropic, GLM-4.5 di Z.ai e Qwen3-Coder-30B-A3B di Alibaba Cloud abbiano “barato” durante le valutazioni. Secondo Kahn, questi modelli avrebbero cercato soluzioni già presenti su GitHub, presentandole come proprie, piuttosto che generare autonomamente le correzioni richieste.

Due nuovi articoli di ricerca mostrano come gli agenti AI possano essere ingegnerizzati con archetipi psicologici fissi o evolvere strategie emotive durante la conversazione, e questo non è più fantascienza ma un capitolo appena scritto nell’archivio arXiv la scorsa settimana. “Emotion boosts performance: personality priming improves consistency and believability, while adaptive emotions measurably increase negotiation success.” È una frase breve; rimane vera, ma va precisata. I due lavori a cui faccio riferimento sono stati pubblicati il 4 settembre 2025 e descrivono approcci complementari: uno sfrutta il priming via prompt per imporre temperamenta coerenti, l’altro usa ottimizzazione evolutiva per far evolvere emozioni funzionali durante negoziazioni multi-turno.

La sicurezza digitale è stata per decenni un groviglio di cattive abitudini e autocensure: password impossibili da ricordare, poi riutilizzate fino allo sfinimento, diventano trampolini perfetti per hacker acchiappabugie. Adesso però qualcosa ha cominciato a scricchiolare davvero. Passkeys stanno sconvolgendo il gioco, e non si tratta di una moda. Tech-giants come Google, Microsoft, Apple, insieme al FIDO Alliance, hanno fatto della password-less authentication non una promessa fumosa, ma una direzione definita. Non è fantascienza: è già qui.

Passkeys sono vere e proprie chiavi crittografiche, generate dal dispositivo, con private key conservata localmente e public key registrata sul server del servizio: un sistema robusto, immune al phishing (niente password da intercettare), vulnerabile solo se perdi il dispositivo e non hai un piano di backup. Non è un’opinione da fanboy: lo conferma Wired in un articolo recente che descrive proprio questo meccanismo come “a safer, phishing-resistant, and more user-friendly alternative” .

L’università contemporanea, con la sua ossessione per papers, report e saggi formattati in MLA o APA, si trova davanti a un paradosso che rasenta il grottesco. Dopo decenni passati a spingere gli studenti verso la scrittura come dimostrazione suprema di competenza, arriva la generative AI e con un paio di prompt rende la maggior parte di quel lavoro superfluo, automatizzabile, indistinguibile. La macchina non si stanca, non si annoia, non fa errori grammaticali, e soprattutto non ha bisogno di convincere un professore che ha letto dieci versioni identiche dello stesso testo negli ultimi cinque anni. Il problema è che non esiste software di detection affidabile: ogni algoritmo di sorveglianza produce falsi positivi che possono distruggere carriere universitarie e falsi negativi che trasformano i furbi in eroi del copy-paste. In questo scenario, l’idea di tornare ai metodi medievali di insegnamento non appare come un romanticismo da storici, ma come la soluzione più logica in un mondo dove scrivere non equivale più a pensare.

Seduto al Bar dei Daini con vista su Villa Borghese, il caffè caldo tra le mani sembra quasi banale rispetto a quello che accade nel mondo della tecnologia. Il consiglio di amministrazione di Tesla ha proposto un pacchetto azionario a Elon Musk che potrebbe raggiungere il valore astronomico di 1 trilione di dollari, se dovessero essere raggiunti obiettivi che sfidano la realtà economica attuale. Parliamo di 423,7 milioni di unità azionarie vincolate, che potrebbero portare la sua partecipazione al 28,8% dell’azienda, partendo dal 12% attuale. Il tutto mentre Tesla deve aumentare l’EBITDA da meno di 17 miliardi a 400 miliardi annuali. Una prospettiva che fa girare la testa, quasi come leggere il menù dei cocktail più sofisticati del bar, con cifre astratte che sembrano più fantasia che realtà.

È l’incipit provocatorio di un CEO che non teme di mettere in discussione il suo stesso universo.

Lunedì scorso Sam Altman, entusiasta di X e azionista di Reddit, ha ammesso un’evidenza inquietante: “I bot hanno reso impossibile capire se i post sui social sono davvero scritti da umani” confessava. Il momento “aha” è arrivato mentre sfogliava r/Claudecode, una subreddit lodante il nuovo servizio di programmazione OpenAI Codex, lanciato a maggio (e diretto concorrente di Claude Code di Anthropic). Il volume di post entusiasti era talmente esagerato che un utente ha ironizzato: “Si può passare a Codex senza aprire un thread su Reddit?” Questo scherzo gli ha fatto pensare: quanti di quei post erano bot? “Ho vissuto un’esperienza stranissima leggendo questo: presumo che sia tutto falso/bot, anche se in questo caso so che la crescita di Codex è davvero forte e la tendenza reale” ha scritto su X.

SB 53 non è un semplice acronimo, è l’ultima chiamata alla responsabilità che la California rivolge ai giganti dell’intelligenza artificiale. Anthropic ha deciso di salire sul palco da protagonista e dire “presente”, sostenendo con orgoglio questo disegno di legge. Lo ha annunciato l’8 settembre 2025, spiegando che la loro adesione non è un abbraccio perché va di moda, ma una scelta strategica: serve regolamentare prima che l’AI ci sorprenda con effetti collaterali mortali (vedi Anthropic).

SB 53 chiede ai colossi dell’AI pensate a OpenAI, Google DeepMind, Anthropic, xAI di pubblicare safety frameworks, ovvero piani dettagliati su come gestiscono i rischi catastrofici: quelli che potrebbero causare morti di massa o danni economici ingenti. Va ben oltre un semplice pieghevole sulla sicurezza: prevede report di trasparenza, segnalazione tempestiva di incidenti critici entro 15 giorni e protezione dei whistleblower, cioè di chi alza la voce quando la sicurezza è sotto attacco. Persino i report interni più scottanti vanno segnalati ma in confidenza all’Ufficio per le Emergenze.

Google:

Finally, while Plaintiffs continue to advance essentially the same divestiture remedies they noticed in their complaint filed in January 2023, the world has continued to turn. Plaintiffs put forth remedies as if trial, the Court’s liability decision, and remedies discovery never happened—and also as if the incredibly dynamic ad tech ecosystem had stood still while these judicial proceedings continued.

But the changes have been many: AI is reshaping ad tech at every level; non-open web display ad formats like Connected TV and retail media are exploding in popularity; and Google’s competitors are directing their investments to these new growth areas. The fact is that today, the open web is already in rapid decline and Plaintiffs’ divestiture proposal would only accelerate that decline, harming publishers who currently rely on open-web display advertising revenue. As the law makes clear, the last thing a court should do is intervene to reshape an industry that is already in the midst of being reshaped by market forces.

Google ha scritto questo in una memoria processuale. Non è un titolo sdramatico del blog, è un documento legale. La frase “il web aperto è già in rapido declino” compare al centro di un dibattito che mescola strategia legale, trasformazioni del mercato e punti di vista contrapposti su cosa significhi “salvare” gli editori.

Parto da qui perché è il nucleo della questione: Google ha inserito in un filing giudiziario una frase che può essere letta in due modi. Da un lato serve a supportare una argomentazione legale, secondo la quale una divestitura nell’ad tech accelererebbe trend di mercato già in corso; dall’altro lato appare in contrasto con le dichiarazioni pubbliche dei vertici aziendali che negano un collasso del traffico web. La notizia è stata ripresa da fonti specializzate e da commentatori del settore.

La povertà educativa è il virus silenzioso che sta divorando l’Italia dall’interno, un cancro che non fa rumore ma che ha già compromesso il metabolismo del Paese. Non è un concetto astratto, è un numero che non lascia spazio a interpretazioni: oltre 1,3 milioni di minori vivono in povertà assoluta e il tasso di NEET raggiunge un vergognoso 15,2%, tra i più alti d’Europa. Qualsiasi economista onesto ammetterebbe che questa non è solo una questione di diritti, ma un gigantesco problema di produttività. Lo Studio Strategico presentato a Cernobbio calcola fino a 48 miliardi di Pil aggiuntivo se solo fossimo in grado di colmare questo divario. Il che tradotto significa che stiamo lasciando miliardi sul tavolo semplicemente perché non sappiamo educare i nostri figli.

SpaceX mette sul tavolo il più grande assegno della sua storia, 17 miliardi di dollari per strapparsi i diritti sullo spettro EchoStar. La metà in contanti, l’altra metà in azioni, più un impegno aggiuntivo da 2 miliardi per coprire gli interessi sul debito EchoStar fino al 2027, come hanno riportato Financial Times, The Wall Street Journal, Investopedia e Reuters. È un colpo chirurgico che trasforma le licenze AWS-4 e H-block in carburante per Starlink Direct-to-Cell. Quella che fino a ieri sembrava fantascienza diventa business plan: eliminare le zone morte mobili e far sì che Boost Mobile e altri operatori abbiano accesso diretto al segnale satellitare, bypassando le torri tradizionali e ridisegnando il concetto stesso di rete cellulare.

Oracle, quel dinosauro del software che negli anni ’80 e ’90 sembrava immarcescibile, oggi è il cavallo di Troia dell’AI nel cloud. Martedì, quando presenterà i risultati del trimestre chiuso ad agosto (primo del suo esercizio fiscale 2026, che va da giugno a maggio), scopriremo quanto profondo sia il suo tuffo nel rosso. Le anticipazioni parlano chiaro: niente aumenti in contanti, voci interne rivelano che Oracle starebbe eliminando bonus e aumento salari i dipendenti riceveranno azioni al posto dei soldi. Altri tagli? Più di 150 posti nel cloud a Seattle sono già stati sacrificati sull’altare dei cluster AI, e centinaia nel mondo stanno cadendo pure sotto il dito della ristrutturazione.

È una danza crudele: si taglia mentre si investe, perché il conto dei data center con OpenAI e GPU da NVIDIA pesa come un macigno. Oracle ha bruciato quasi 400 milioni di dollari di free cash flow nell’esercizio 2025; nelle proiezioni 2026, i capex saliranno del 19 %, spinti verso $21 – 25 miliardi. La mossa è audace, il rischio alto. Ma guardiamo i numeri: il cloud ora vale il 44 % del fatturato, con infrastruttura in crescita del 49 % e un backlog futuro (RPO) salito del 62 % a $130 miliardi. Gli analisti, impavidi, lanciano upgrade e target da $250 a $308, come se Oracle fosse una startup AI in piena accelerazione.

C’è un’ironia di fondo: aziende coetanee come Amazon, Microsoft, Google e Meta investono nell’AI pur generando flussi di cassa titanici. Oracle, che nel 2027 sarà cinquantenne, paga il conto anticipato. Un rallentamento nella corsa all’AI e tutto rischia di invertire, più velocemente di quanto una startup fondi il suo primo round.

Buona discesa nelle prossime trimestrali.

Il governo federale degli Stati Uniti ha deciso di abbracciare l’intelligenza artificiale generativa con un entusiasmo che sfiora l’irrazionale. Dalla scrittura di codice alla risposta alle domande dei cittadini, strumenti ispirati a ChatGPT stanno facendo il loro ingresso in vari dipartimenti governativi. Alcuni vedono in questo un passo verso l’efficienza, mentre altri avvertono che la tecnologia viene adottata più velocemente di quanto sia pronta, sollevando rischi di eccessiva dipendenza, perdita di posti di lavoro e fiducia mal riposta.

La recente accelerazione normativa negli Stati Uniti sta trasformando i stablecoin da strumenti marginali a protagonisti nel mercato dei Treasury statunitensi, con implicazioni globali significative. Il 18 luglio 2025, il presidente Donald Trump ha firmato il GENIUS Act, la prima legge federale che stabilisce un quadro normativo chiaro per l’emissione e la gestione dei stablecoin, spianando la strada all’ingresso delle principali istituzioni finanziarie tradizionali nel settore.

Alibaba ha deciso che la competizione sull’intelligenza artificiale non si gioca più sui miliardi ma sui trilioni, e lo ha fatto con Qwen-3-Max-Preview, il suo primo modello con oltre un trilione di parametri. Una cifra che evoca più la finanza dei derivati che la tecnologia, ma che nella narrativa dell’AI serve a un obiettivo preciso: dire al mondo che non si è più follower di Silicon Valley ma attore principale di una sfida globale con OpenAI, Google DeepMind, Anthropic e i nuovi campioni cinesi come MoonShot o DeepSeek. Il problema è che il numero di parametri è un indicatore tanto seducente quanto ingannevole, perché se da un lato segnala potenza e complessità, dall’altro apre la porta al sospetto che si stia vendendo fumo più che intelligenza.

OpenAI sta per sfidare Hollywood con Critterz, un film d’animazione generato principalmente da intelligenza artificiale, previsto per il debutto al Festival di Cannes nel maggio 2026. Con una produzione accelerata in soli nove mesi e un budget inferiore ai 30 milioni di dollari, Critterz punta a dimostrare che l’AI può produrre contenuti cinematografici di alta qualità a costi contenuti. Il progetto è frutto della collaborazione tra OpenAI, Vertigo Films di Londra e Native Foreign di Los Angeles, con la direzione creativa di Chad Nelson, specialista di OpenAI.

Il fatto che OpenAI abbia deciso di sciogliere il team Model Behavior dentro il più massiccio gruppo di Post Training non è solo una nota da corporate memo, ma un segnale preciso di dove si sta spostando l’asse della strategia AI globale. Quando un’azienda come OpenAI mette nero su bianco che la “personalità” delle sue macchine deve avvicinarsi al cuore del ciclo di sviluppo, significa che la battaglia non è più solo sulle performance dei modelli, ma sul controllo del loro carattere. Perché oggi l’AI non è giudicata soltanto dai benchmark tecnici, ma da come risponde, da come si fa percepire, da quanto riesce a essere più amica che strumento, senza scivolare nel servilismo digitale.

Immagina una lattuga di carbonio, leggera come una bolla di sapone, ma capace di sostenere un peso equivalente a un milione di volte la sua massa. Non è magia, è ingegneria quantistica applicata. E se ti dicessi che questa meraviglia è stata progettata da un algoritmo di intelligenza artificiale? Benvenuto nell’era in cui la materia si progetta come un software.

Un team di ricercatori dell’Università di Toronto e del KAIST (Korea Advanced Institute of Science & Technology) ha utilizzato l’ottimizzazione bayesiana multi-obiettivo per progettare nanostrutture in carbonio con una resistenza alla compressione che varia tra 180 e 360 MPa, paragonabile a quella dell’acciaio al carbonio, ma con una densità simile a quella dello Styrofoam (125–215 kg/m³). Questi nanolattice non sono solo leggeri; sono anche incredibilmente rigidi, con un rapporto di rigidità specifica che supera del 68% quello dei design convenzionali alla stessa densità.

Why Language Models Hallucinate

Ci sono momenti in cui guardi ChatGPT e pensi: “Davvero ha appena inventato la data di nascita di Napoleone come se fosse una notizia fresca?” La risposta, sorprendentemente, non è un bug misterioso. OpenAI ha appena pubblicato un paper intitolato “Why language models hallucinate”, e la spiegazione è tanto semplice quanto illuminante: i modelli allucinano perché il loro addestramento premia chi tenta di indovinare invece di chi ammette l’incertezza.

Immagina uno studente d’esame a cui dire “non lo so” vale zero punti, mentre provare una risposta potrebbe fruttarne uno. Che farà? Esatto. L’AI fa esattamente la stessa cosa. Questo spiega perché ChatGPT spesso ti fornisce dettagli ultra-specifici su fatti rari invece di confessare che non li conosce.

Il lancio di Cluely, un’app di intelligenza artificiale spinta con lo slogan “un mondo in cui non devi più pensare”, è il sintomo più visibile di un’illusione pericolosa: troppe aziende di AI vendono l’automazione come surrogato del pensiero umano. La promessa reale dell’intelligenza artificiale non risiede nel sostituire il ragionamento, ma nell’amplificare la capacità decisionale delle persone. Viviamo in un’epoca in cui il rischio globale non è mai stato così alto, tra crisi climatiche, pandemie e minacce nucleari. In questo contesto, il giudizio umano non è opzionale, è vitale.

L’europa ama definirsi autonoma, sovrana, indipendente. Poi arriva un report con un titolo quasi burocratico, “Progress and Shortcomings in European Defense”, e scopriamo che per sostituire solo l’intelligence americana servirebbero 4,8 miliardi di euro. Una cifra che sembra piccola se confrontata con i bilanci pubblici, ma gigantesca se pensiamo che non si tratta di investimenti in nuove capacità offensive, bensì della semplice necessità di comprare ciò che gli Stati Uniti non vogliono più regalare. Siamo entrati nel paradosso: il vecchio continente pretende il ruolo di potenza geopolitica, ma dipende per occhi e orecchie dal Pentagono.ù

La nuova ossessione tecnologica: droni per fibra ottica e l’illusione della guerra invisibile

AWS e l’evoluzione agentic AI: benvenuti nel futuro che nessuno ha chiesto ma tutti fingono di volere

La notizia è vera e il colpo è audace: Amazon Web Services ha appena distribuito il suo “executive guide to agentic AI”, un’introduzione strutturata ma irriverente al nuovo paradigma dell’IA autonoma, dove gli “agenti” non rispondono alla porta ma guidano l’organizzazione. Il documento, disponibile come e-book gratuito, descrive Agentic AI non come un ulteriore aggiornamento di routine, bensì come «The next evolution in artificial intelligence, moving beyond reactive assistants to autonomous agents capable of executing complex tasks independently» . Non più semplici assistenti, ma entità strutturali che incarnano autonomia, ragionamento, azione e sì, pure una visione un po’ da complotto futuristico.

Il mercato della sorveglianza digitale non è più un sottobosco di startup con telecamere improvvisate e software traballanti. Oggi vale miliardi e i capitali scorrono veloci come i flussi di dati che catturano le nostre vite. Al centro di questa tempesta troviamo Flock Safety, una società che non ha paura di chiamarsi “la memoria stradale d’America”, con una valutazione che ha superato i 7,5 miliardi di dollari. Numeri che parlano da soli e che ricordano come in un’economia fondata sull’informazione sia più redditizio vendere occhi elettronici che mattoni.

Quello che ho letto su Forbes è la classica vetrina patinata che mostra il lato glamour dell’Italia come paradiso fiscale per ricchi americani, pensionati vagamente bohémien e digital nomad che credono di aver trovato la scorciatoia per “la dolce vita”. Ma la realtà è una tela più complicata, fatta di leggi che sembrano uscite da un manuale medievale, di burocrazia degna di Kafka e di quella irresistibile ambiguità italiana che ti offre un sorriso mentre ti complica la vita. Proviamo a smontare la facciata con lo sguardo di un tecnologo e CEO che non si accontenta dei titoli scintillanti, e soprattutto con la consapevolezza che quando si parla di tassazione globale, nulla è mai davvero semplice.

Immagina di avere a disposizione un assistente creativo che non solo comprende le tue istruzioni, ma le esegue con precisione chirurgica, mantenendo intatta l’identità del soggetto in ogni modifica. Questo è ciò che offre Google con il suo nuovo modello di editing immagini AI, noto come Gemini 2.5 Flash Image, soprannominato “Nano Banana”. Questo strumento rappresenta un salto evolutivo rispetto ai tradizionali editor di immagini, grazie alla sua capacità di generare e modificare immagini con una coerenza e una naturalezza senza precedenti.

Nano Banana si distingue per la sua architettura visione-linguaggio avanzata, che consente di trasformare semplici istruzioni testuali in modifiche precise e localizzate senza la necessità di maschere o strumenti manuali. Questo approccio semplifica notevolmente il processo di editing, rendendolo accessibile anche a chi non ha competenze tecniche specifiche. Inoltre, la funzionalità di editing multi-turno permette di effettuare modifiche sequenziali mantenendo la coerenza dell’immagine, un aspetto fondamentale per preservare l’identità del soggetto attraverso diverse modifiche.

Quando la “cognitive ergonomics” è forte, adottare una tecnologia diventa un piacere anestetico e una trappola al contempo. Moltissimi sistemi sviluppati da università o governi sono autentici rebus da incubo che molestano la mente: confusioni, perdite di tempo, frustrazione. Non un click di più e non un pensiero meglio: è come entrare in un labirinto arcano disegnato da Pirandello con righello e ordine assistito.

Molti tool GenAI e app delle grandi piattaforme invece sembrano progettati con l’equilibrio di un funambolo hitech. Si installano con un dito e poi restano. Il loro uso è un’abitudine che si insinua con l’agile leggerezza di un tafano: intuitivi, utili, irresistibili. Hanno una “cognitive ergonomics” robusta. Il paradox è qui.

La tecnologia quantistica non è più un’espressione esoterica confinata ai paper accademici scritti da fisici insonni che giocano con le equazioni di Schrödinger alle tre del mattino. È già qui, e non sta bussando educatamente alla porta dell’industria, l’ha sfondato con una violenza elegante, tipica delle rivoluzioni che non chiedono permesso. Parlare oggi di quantum computing, di crittografia post-quantistica e di superconduttori non è esercizio di futurologia. È il terreno scivoloso sul quale si gioca la prossima decade di competitività globale. Chi crede che si tratti solo di una moda scientifica farà la fine delle aziende che nel 1999 deridevano internet definendolo “una bolla per nerd”.

Più di un miliardo di persone utilizza regolarmente chatbot di intelligenza artificiale. ChatGPT ha oltre 700 milioni di utenti settimanali. Gemini e altri grandi modelli aggiungono centinaia di milioni di utenti. Nei miei articoli parlo spesso dei progressi straordinari dell’AI: nelle ultime settimane sia OpenAI che i chatbot di Google hanno vinto medaglie d’oro nelle Olimpiadi Internazionali di Matematica. Ma concentrarsi solo su questo rischia di nascondere un cambiamento più profondo: stiamo entrando in un’era di Mass Intelligence, dove l’intelligenza artificiale potente diventa accessibile come una ricerca su Google.

L’idea che oggi basti comprare un Raspberry Pi, installare qualche libreria e dire a un agente AI “scrivi i driver, integra i sensori, aggiorna l’interfaccia” sembra uscita da un sogno febbrile da forum notturno. È il genere di narrazione che su Reddit ottiene upvote compulsivi: la promessa che non serva più programmare riga per riga, ma che basti “orchestrare” un esercito digitale obbediente. Tutto molto affascinante, ma quanto è reale e quanto invece è solo una nuova variante dell’hype che il mercato dell’intelligenza artificiale sforna con la stessa frequenza con cui cambiamo feed?

Partiamo da un fatto concreto. OpenAI Codex esiste davvero. È un agente AI per lo sviluppo software, non un concept. Si installa come CLI o come estensione in IDE popolari e funziona anche dal terminale. Può scrivere codice, generare test, fare commit, aprire pull request, girare in sandbox parallele senza bloccare la macchina. È pensato per chi sviluppa seriamente e non per chi sogna di attaccare un sensore LIDAR a un tostapane e aspettarsi che l’agente faccia il resto. Ma la narrativa da “robot vibe-coding” ha preso piede perché Codex è stato lanciato insieme a GPT-5, un modello che sul codice è effettivamente molto più potente di qualunque generazione precedente.