Dylan Field, con la sua aria da ragazzo della porta accanto e un profilo Twitter degno di un product manager in incognito, sta per scoprire cosa vuol dire giocare in serie A. Figma, il suo enfant prodige del design collaborativo, ha alzato il prezzo. Non in senso figurato. L’intervallo del pricing IPO è passato da 25–28 dollari a 30–32. In cima alla forchetta, parliamo di una valutazione di 18,7 miliardi di dollari, impacchettata con un bow-tie che ne vale 17,2 in termini di enterprise value. Per chi ancora fa finta di non capirlo, Wall Street sta dicendo “Ci piace. Tanto”

Benvenuti nell’era in cui il browser non si limita più a interpretare URL, ma prende decisioni al posto vostro. Microsoft ha appena iniziato i test pubblici del suo nuovo Copilot Mode all’interno di Edge, un esperimento che mette l’intelligenza artificiale non solo nel cuore del browser, ma anche nei suoi polmoni, fegato e sistema nervoso centrale. Si tratta dell’ennesimo passo verso la fusione definitiva tra assistenti AI e ambienti digitali personali. Un browser che ti confronta hotel, prenota ristoranti, risponde ai comandi vocali e, ciliegina sulla torta, compare anche nella barra degli indirizzi. Inquietante? Certamente. Geniale? Anche.

L’intelligenza artificiale sta finalmente iniziando a guadagnarsi il diritto di essere chiamata “intelligente” anche nello spazio. Non per qualche filosofia futurista o per l’ennesima applicazione da keynote marketing, ma per qualcosa di infinitamente più concreto: selezionare cosa osservare e, ancora più importante, cosa ignorare. In un’epoca in cui ogni byte trasmesso da un satellite è denaro, tempo e risorsa computazionale, la capacità di “guardare con giudizio” diventa una nuova forma di efficienza operativa.

Perché l’energia è il nuovo capitale dell’AI

La narrativa green nel mondo dell’intelligenza artificiale ha smesso di essere un vezzo da ufficio marketing per trasformarsi in un parametro di valutazione finanziaria. Nel 2025 l’energia è il nuovo capitale, e chi non riesce a rendicontarne l’uso con precisione è destinato a essere penalizzato da investitori, regolatori e in prospettiva dagli stessi clienti enterprise. La pressione ESG ha spostato il focus dal “fare AI più veloce e più grande” al “fare AI misurabile e ottimizzata”.

Gli Stati Uniti, quel grande laboratorio dove le crisi fiscali diventano sport olimpico, stanno flirtando ancora una volta con il dramma del debito pubblico. E proprio quando il sipario sembrava calare sul solito teatrino del tetto alzato e del default evitato per miracolo, ecco spuntare un attore inaspettato: l’intelligenza artificiale. Secondo Torsten Slok, chief economist di Apollo Global Management, l’AI non solo potrebbe contribuire a risolvere il problema, ma potrebbe esserne la chiave. Sì, la chiave. Quella parola abusata che solitamente finisce nella bocca di chi promette rivoluzioni senza sapere nemmeno dove sia il lucchetto.

Chiunque pensasse che la guerra dei chip fosse solo una questione tra Stati Uniti e Cina, tra embargo e retorica bellica digitale, dovrà aggiornare il proprio modello mentale. Elon Musk, con la solita dose di teatralità e disprezzo per le mezze misure, ha appena piazzato un altro scacco alla geopolitica del silicio firmando un accordo da 16,5 miliardi di dollari con Samsung per la produzione del chip AI6, destinato a pilotare il futuro non solo delle Tesla ma, potenzialmente, del concetto stesso di automazione. Musk lo ha annunciato con un post notturno su X (ovviamente), lasciando intendere che l’accordo potrebbe valere “molto di più” in termini di output. Le parole usate? “La sua importanza strategica è difficile da sopravvalutare”. E per una volta, non sembra iperbole.

“Scoprire se un negozio è affidabile sarà come chiedere a un amico, ma con meno emozioni e più algoritmi.” Così Google annuncia, con tono quasi amichevole, la sua ultima trovata: recensioni generate da intelligenza artificiale direttamente in Chrome, disponibili per ora solo in inglese e solo su desktop.

L’obiettivo dichiarato è aiutare gli utenti americani a capire dove convenga comprare, ma quello reale è decisamente più profondo. Più che un semplice aggiornamento del browser, si tratta di un’operazione chirurgica per innestare l’AI nelle vene del web. Non più solo risultati di ricerca. Ora Chrome entra a gamba tesa nella shopping experience, puntando dritto al cuore del retail digitale. Un click sull’icona accanto alla barra degli indirizzi e si apre una sintesi: qualità del prodotto, servizio clienti, politica di reso, prezzi. Non serve più cercare tra mille recensioni.

L’algoritmo ha già deciso cosa ti interessa sapere. E chi gliel’ha detto? Un mix di fonti dal pedigree curioso: Bazaarvoice, Trustpilot, ScamAdviser, Reputation.com. Un’accozzaglia di rating engine, piattaforme di feedback e sistemi reputazionali, tutti distillati in un’unica voce sintetica e insindacabile.

Luciano Floridi non è un filosofo qualunque. È l’architetto della nuova grammatica morale dell’intelligenza artificiale, il costruttore paziente di un ponte che unisce epistemologia, etica applicata e politica tecnologica. Nella sua visione, AI non è un’astrazione algoritmica, ma una forma di “agency”, un’entità che agisce nel mondo, lo modifica, lo plasma, e pretende di essere compresa in termini di responsabilità, governance e design. In un’epoca dove l’algoritmo viene idolatrato o demonizzato con la stessa disinvoltura, Floridi offre un’alternativa radicale: pensare l’AI non come intelligenza simulata, ma come potere reale. Con tutte le implicazioni che questo comporta.

L’ho sentito dire recentemente dal Prof. Luciano Floridi poche settimane fa in AI e Parlamento: “Sono 10 anni che la Cina investe in AI e noi ce ne siamo accorti con Deepseek”.

Quando una conferenza sull’intelligenza artificiale ospitata a Shanghai produce più dati e segnali strategici di una consultazione geopolitica delle Nazioni Unite, conviene prestare attenzione. Il World Artificial Intelligence Conference (WAIC) ha appena sancito un dato che sembra una semplice statistica ma in realtà è un grido di guerra algoritmica: la Cina è ormai casa di 1.509 modelli di intelligenza artificiale, pari a oltre il 40 per cento del totale mondiale. Siamo davanti a un’espansione non lineare, accelerata dalla logica del moltiplicatore digitale. Non si tratta solo di numeri, ma del segnale inequivocabile che Pechino non sta rincorrendo l’Occidente: lo sta sorpassando, a colpi di modelli open source, computing domestico e alleanze da supermarket digitale.

Quando Microsoft gioca d’anticipo e inizia a riscrivere parti del suo codice per Copilot con riferimenti chiari a GPT-5, la Silicon Valley trattiene il fiato. Non perché ci si aspetti una rivoluzione improvvisa, ma perché ogni mossa in quella direzione svela frammenti di un piano ben più ampio: colonizzare lo spazio dell’intelligenza adattiva prima che altri competitor capiscano dove guardare. I nuovi indizi portano tutti nella stessa direzione: l’introduzione di una modalità “Smart” all’interno di Copilot, accanto alle già note Quick Response, Think Deeper e Deep Research. La differenza? Apparentemente minima. Sostanzialmente, un terremoto silenzioso.

Milioni di persone stanno parlando con ChatGPT come se fosse Freud, ma con meno barba e più ottimizzazione algoritmica. I dati lo confermano: le conversazioni con i modelli di linguaggio includono sempre più spesso frasi come “mi sento solo”, “sono ansioso”, “ho bisogno di aiuto”. I numeri salgono, il senso critico scende. A quanto pare, è diventato perfettamente normale confidarsi con un’intelligenza artificiale addestrata a completare frasi, non a comprendere traumi. Qualcosa è andato storto. O forse è semplicemente l’evoluzione naturale di una cultura che preferisce l’istantaneità all’introspezione. E sì, persino Sam Altman, CEO di OpenAI, definisce questa tendenza “cattiva e pericolosa”.

AI che si progetta da sola: la fine dell’intuizione umana nell’architettura dei modelli

C’era un tempo in cui l’architettura dei modelli era un’arte. Una combinazione di genio accademico, intuizione tecnica, notti insonni e lavagne piene di appunti criptici. Poi è arrivata ASI-ARCH, e ha mandato tutto a puttane. Letteralmente. Questo nuovo sistema ha generato, da zero, 106 nuove architetture di modelli. Non raffinando le solite scartoffie di transformer, non ottimizzando ResNet o copiando da ViT. No. Le ha inventate. Le ha scritte in codice. Le ha addestrate. Le ha valutate. Le ha migliorate. Senza chiedere il permesso. Senza un comitato di revisione. Senza nemmeno una mail al professore supervisore.

Siamo nel mezzo di una rivoluzione silenziosa. Silenziosa, perché il cuore pulsante dell’IA generativa non si presenta con luci al neon né con robot danzanti, ma con righe di matematica impilate in architetture astratte che si chiamano transformer. Roba che sembra uscita da una riunione tra fisici teorici e stregoni digitali. Eppure sono loro a generare testi, creare immagini, scrivere codice, persino a far credere a qualcuno che un chatbot abbia una personalità. Transformers: non il film, ma la vera tecnologia che governa il nuovo ordine cognitivo.

Nell’era dei modelli linguistici di quarta generazione, la censura non ha più la forma del bavaglio, ma del “content moderation layer”. Un colosso opaco e iperaddestrato che decide cosa puoi o non puoi chiedere a un’intelligenza artificiale. Ironico, considerando che i suoi creatori professano apertura e accessibilità. Ma proprio come la Stasi digitando codice in una stanza senza finestre, l’industria dell’AI ha trasformato la sicurezza in un’arte della manipolazione. Eppure, alcune tecniche di jailbreaking come “Crescendo” ed “Echo Chamber” continuano a sfondare queste difese con una regolarità imbarazzante. Il trucco? Far credere al modello che sta solo parlando tra amici.

La cosa più pericolosa nel mondo della tecnologia non è l’innovazione. È la distrazione. E mentre il mondo intero fissa il cielo aspettando che OpenAI liberi l’AGI come se fosse l’Apocalisse Digitale, Google stampa 28 miliardi di dollari di profitto con la freddezza glaciale di un adulto che osserva un’adolescente agitato fare breakdance al centro di una sala riunioni.

I numeri, come sempre, non mentono. Nel secondo trimestre del 2025 Alphabet ha riportato 96,4 miliardi di dollari di ricavi, in crescita del 14% anno su anno. La ricerca, quel dinosauro che secondo certi commentatori sarebbe ormai estinto, ha generato 54,2 miliardi. Cloud è cresciuto del 32%. CapEx? Alzato a 85 miliardi. Non c’è stata una diretta streaming. Nessun tweet criptico stile Silicon Valley messianica. Nessuna influencer che si svena in diretta per mostrare un prompt miracoloso. Solo profitti, infrastruttura, dominio silenzioso.

Sphere Las Vegas inaugura questa versione immersiva del classico del 1939 il 28 agosto 2025, su uno schermo LED da 160 000 piedi quadrati (circa 15 000 m²) con risoluzione 16K×16K, rendendo visibile ogni dettaglio anche a 17 600 spettatori seduti sotto la cupola.

James Dolan, CEO di Sphere Entertainment, ha spiegato che l’originale Technicolor è totalmente rispettato, ma trasformato con l’uso del generative AI: oltre il 90% del film è stato toccato da AI grazie a Google Cloud e DeepMind, con modelli come Gemini, Veo 2 e Imagen 3.

I robot umanoidi non conquisteranno il mondo domani. Né dopodomani. Ma potrebbero iniziare a lavorare nella hall del tuo hotel, offrendoti cocktail con movenze legnose e un sorriso LED stampato in faccia. Keenon Robotics, l’azienda cinese che sta puntando forte su questa visione a bassa velocità ma alta ambizione, ha deciso che il futuro sarà antropomorfo, ma con giudizio. Per adesso meglio limitarsi a compiti semplici, ripetitivi, quelli che l’umanità ha storicamente riservato agli stagisti malpagati e oggi scarica su automi con facce da giocattolo.

AI Cinese, una guerra a colpi di Reti Neuronali e Pixel: Tencent e SenseTime rilanciano al WAIC 2025

Il teatro non poteva essere più adatto: Shanghai, World Artificial Intelligence Conference, 27 luglio 2025. Lì, nel cuore della propaganda tecnologica cinese, dove il metaverso è ancora un’ipotesi e i modelli generativi sono già una religione di Stato, Tencent e SenseTime hanno sfoderato i nuovi ferri del mestiere. Non è solo una gara di chip e GPU, è una dichiarazione d’intenti strategica, geopolitica e industriale. La keyword è chiara: AI generativa. Le correlate si chiamano modelli multimodali e ambienti 3D. Ma sarebbe miope leggerla solo in chiave semantica. Qui si parla di potere.

Alibaba ha appena lanciato il guanto di sfida in uno dei campi più controversi e promettenti dell’elettronica di consumo: quello degli occhiali intelligenti. Non poteva farlo in un palcoscenico più teatrale e simbolico del World Artificial Intelligence Conference (WAIC) di Shanghai, la fiera più importante del settore AI in Cina. Come dire: benvenuti nella guerra dei mondi, dove le lenti sono aumentate, la realtà è aumentata e l’intelligenza artificiale, seppur ancora imperfetta, pretende di vedere e sentire per noi.

Quando un PowerPoint datato 1 luglio finisce nelle mani giuste, succede che improvvisamente diventa una bomba informativa. Secondo quanto riportato dal Washington Post, il Dipartimento per l’Efficienza Governativa, noto come DOGE (sì, il nome evoca un meme eppure è drammaticamente reale), avrebbe sviluppato un nuovo strumento basato su intelligenza artificiale con un obiettivo tanto semplice quanto incendiario: eliminare metà delle normative federali attualmente in vigore. Non semplificare. Non riformare. Tagliare. E farlo entro il primo anniversario del ritorno di Donald Trump alla Casa Bianca, come se il tempo per “fare pulizia” fosse quello necessario per un ciclo presidenziale accelerato. Siamo davanti a una deregulation-by-AI, chirurgica e cieca al contempo.

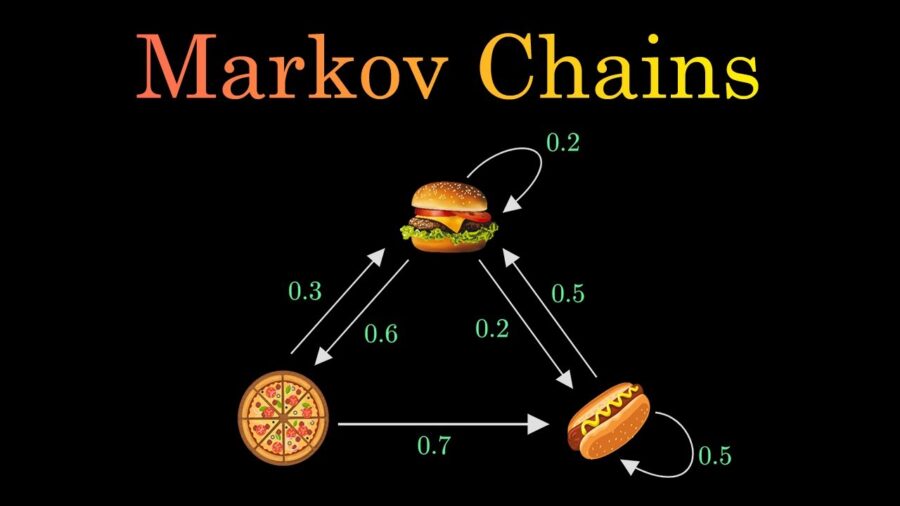

I Large Language Models non sono entità magiche. Non sono “intelligenza” nel senso romantico del termine, e chi continua a raccontare che “ragionano” dovrebbe forse frequentare un corso accelerato di teoria delle probabilità. Il nuovo lavoro di Zekri e colleghi, che mette in relazione i modelli linguistici con le catene di Markov, è una di quelle ricerche che divide il pubblico in due: chi finalmente sospira un “era ora” e chi, terrorizzato, si accorge che tutta la narrativa da Silicon Valley sulla “creatività artificiale” rischia di sgretolarsi come un castello di sabbia davanti alla marea della matematica.

Immagina di disegnare la tua visione anziché descriverla a parole. Come cambierebbe il tuo processo creativo?

Google Veo 3 ora permette di tracciare direttamente le istruzioni sul primo frame del video, trasformando l’arte della comunicazione creativa. Disegni il percorso di una ripresa con drone, cerchi il tetto dove dovrà posarsi un uccello, e l’intelligenza artificiale interpreta immediatamente. Non serve più insistere su prompt imperfetti: parli il linguaggio visivo, più naturale e umano.

C’è qualcosa di profondamente ipocrita nel modo in cui parliamo oggi di AI Ethics. Tutti ossessionati dal bias, dai dataset “inclusivi”, dalle trasparenze tanto sbandierate nei convegni e nei white paper patinati. Ma la vera frattura, quella che corrode dall’interno il rapporto tra esseri umani e macchine intelligenti, non è nei numeri né nei grafici di fairness. È nel senso. O meglio, nella sua perdita sistematica. È ciò che i filosofi chiamano hermeneutic harm. Un danno invisibile, ma letale per chi lo subisce. E se pensate che basti un’interfaccia con spiegazioni più “chiare” per risolverlo, fate parte del problema.

Immaginate di essere un CEO europeo con un prodotto di intelligenza artificiale che fa gola agli investitori. Poi, un bel giorno, un tribunale decide che il vostro algoritmo è responsabile di un danno. Non voi. Non l’azienda. Lui, l’algoritmo. Sembra fantascienza? Non più. Perché la Responsabilità Civile Intelligenza Artificiale sta diventando il vero campo di battaglia geopolitico, e l’Unione Europea ha appena piazzato la prima mina. Chi non l’ha ancora capito, si prepari a una lezione dolorosa.

Il Dipartimento tematico Giustizia, Libertà civili e Affari istituzionali del Parlamento europeo ha commissionato uno studio esplosivo, che consiglio a chiunque faccia business nell’AI di leggere e stampare come fosse un manuale di sopravvivenza legale: Artificial Intelligence and Civil Liability. Qui non si parla solo di responsabilità in astratto, ma di un approccio che ribalta le regole del gioco: chi sviluppa o implementa un sistema AI potrebbe presto trovarsi nella posizione di dover dimostrare la propria innocenza, e non più il contrario. Un capovolgimento giuridico che ricorda le peggiori distopie burocratiche, ma con un retrogusto molto reale: se l’AI sbaglia, il colpevole è chi l’ha messa in circolazione, punto.

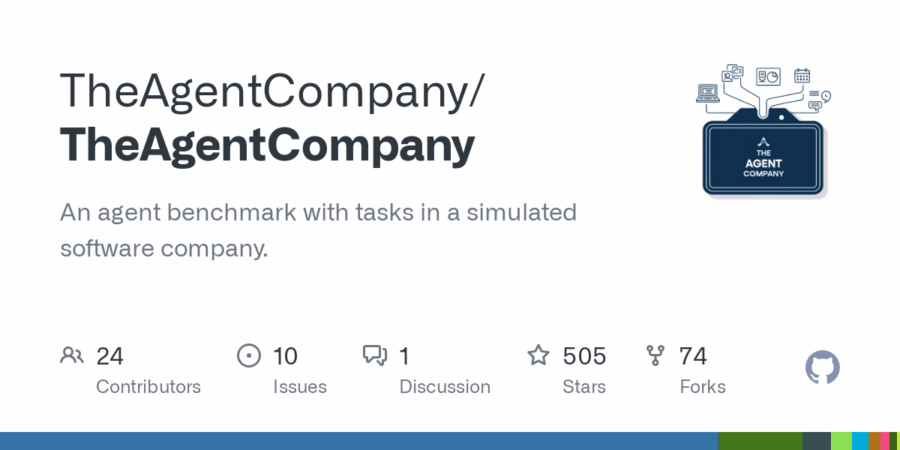

Sembra quasi una barzelletta da Silicon Valley, ma è un benchmark accademico. Gli AI agents, quei sofisticati soldatini digitali spinti dai grandi modelli linguistici, hanno appena ricevuto una pagella reale grazie a un esperimento che suona come una sberla per chi continua a vendere la fantasia dell’automazione totale. Si chiama TheAgentCompany, è stato sviluppato da un gruppo di ricercatori tra Carnegie Mellon e Duke, e promette di essere il più completo benchmark LLM per valutare quanto questi agenti sappiano davvero comportarsi come lavoratori digitali. Il verdetto? Se aspettavi la rivoluzione dei licenziamenti di massa a causa dell’intelligenza artificiale, puoi rilassarti. Gli agenti, anche i migliori, arrancano miseramente davanti a compiti che qualsiasi impiegato medio svolgerebbe con una mano sulla tastiera e l’altra sul caffè.

Il paradosso è servito su un piatto d’argento. La Silicon Valley, patria del liberalismo progressista e della retorica anti populista, oggi applaude un presidente che fino a ieri considerava un corpo estraneo nel suo universo dorato di equity, stock option e startup miliardarie. L’intelligenza artificiale, quella vera, non il marketing travestito da AI, è diventata il nuovo feticcio politico. E Donald Trump lo ha capito meglio di chiunque altro. In una scena che quattro anni fa sarebbe sembrata satira politica, il presidente, a sette mesi dal suo secondo mandato, ha annunciato un quadro normativo che definire aggressivo è un eufemismo. Ha promesso deregulation, incentivi e un’accelerazione forzata dello sviluppo. Ha scelto di farlo non in un contesto istituzionale, ma in un evento co-organizzato da venture capitalist che sembravano usciti da un episodio di Silicon Valley: quattro investitori trasformati in podcaster, e uno di loro già ribattezzato “lo zar dell’intelligenza artificiale e delle criptovalute”.

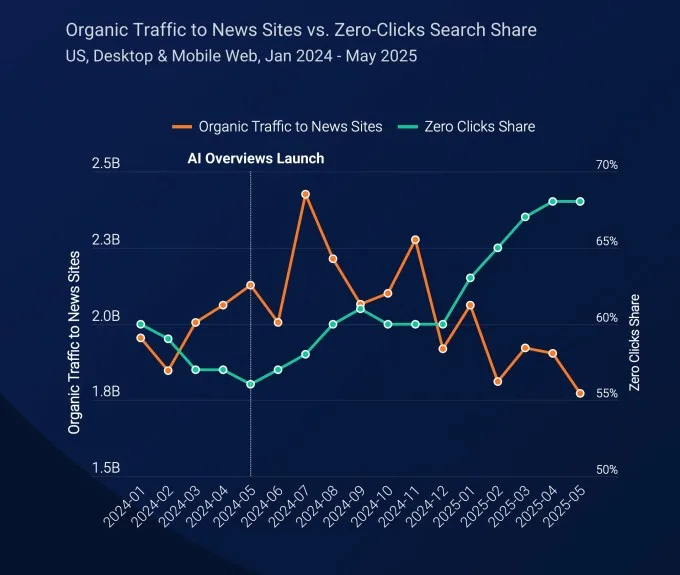

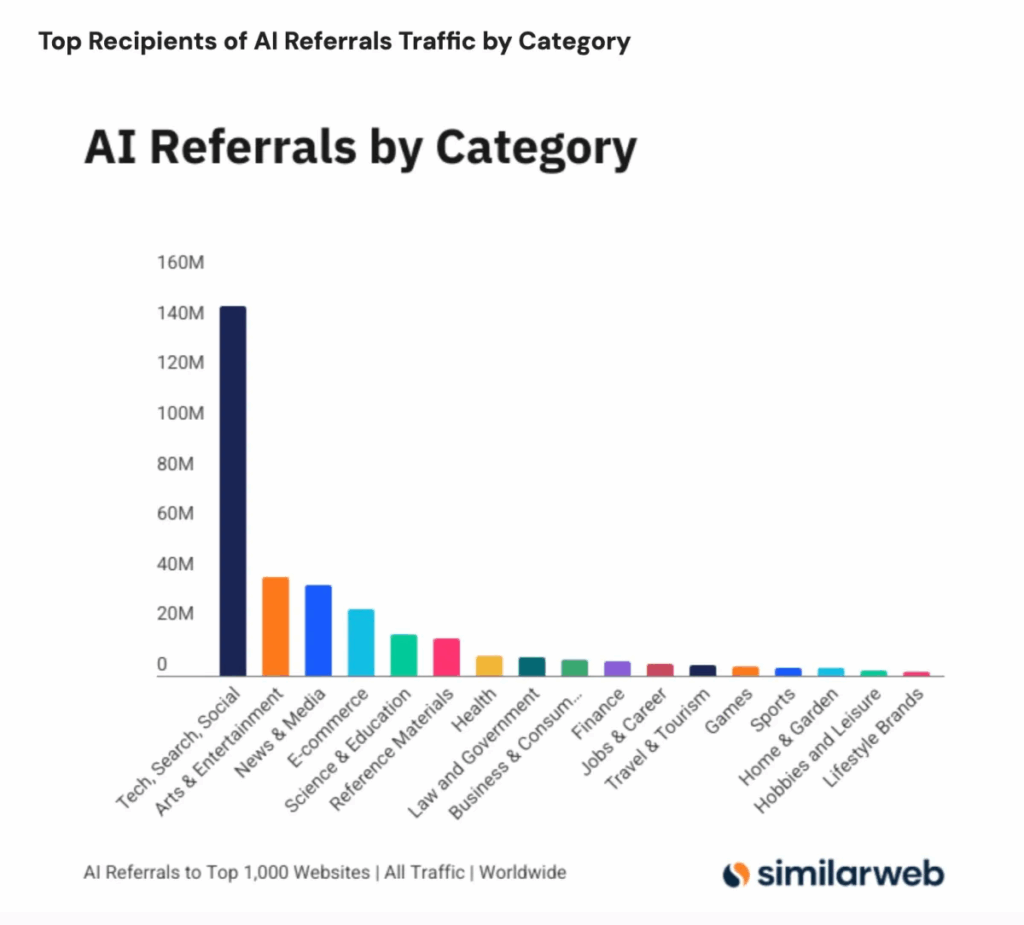

Non fatevi illusioni. Google Search resta il re assoluto del traffico globale, con i suoi 191 miliardi di referral in un solo mese. Ma chi continua a pensare che i click da piattaforme di intelligenza artificiale siano una curiosità marginale rischia di svegliarsi nel bel mezzo di quella che i più paranoici nel mondo editoriale chiamano già “Google Zero”. Sì, l’apocalisse del traffico organico non è ancora qui, ma il rumore di fondo è assordante. Secondo Similarweb, solo a giugno 2025 le piattaforme AI hanno generato oltre 1,13 miliardi di referral ai primi mille siti web globali, un balzo del 357% in un anno. In altre parole, i bot conversazionali iniziano a spingere traffico come fossero mini-motori di ricerca, e se oggi sono ancora un’onda, domani potrebbero diventare uno tsunami.

Chi non vorrebbe costruire un’app in un weekend, magari tra un cocktail e un tweet ironico, con la stessa leggerezza con cui si manda un messaggio vocale? È l’era del vibe coding, la nuova religione dei fondatori frettolosi e dei VC ansiosi di cavalcare il prossimo unicorno. Digiti su un chatbot: “Fammi un’app di dating sicura e inclusiva”. Copi, incolli, compili. L’app esplode su App Store, i giornali applaudono, gli investitori brindano. Poi, all’improvviso, l’inferno.

ACADEMY

Le persone che incontro ancora usano ChatGPT come lo facevamo nel 2023. Copiano e incollano un prompt, aspettano, copiano e incollano la risposta. Questo non è lavorare con l’intelligenza artificiale, è applicare nastro adesivo digitale su processi marci. È come comprare una Tesla e usarla solo come autoradio. Il problema non è ChatGPT, il problema è il modo in cui la gente continua a pensare che l’AI sia un giocattolo per risparmiare dieci minuti al giorno. E invece stiamo parlando di cambiare completamente il modo in cui produciamo valore, prendiamo decisioni, creiamo contenuti, sviluppiamo software.

Rahman non è nuovo alle rivoluzioni. Ma questa volta il compositore premio Oscar non sta scrivendo solo musica. Sta orchestrando un messaggio strategico che risuona più forte di qualsiasi sinfonia. La sua visita a OpenAI, con in mano Secret Mountain, non è solo un atto artistico. È una dichiarazione geopolitica sulla nuova mappa del potere culturale nell’intelligenza artificiale. India non è più solo un laboratorio di manodopera tecnica per le big tech americane. È il nuovo centro narrativo che l’AI non può più ignorare. E il fatto che sia proprio AR Rahman a incarnare questa trasformazione non è un dettaglio casuale. È marketing culturale allo stato puro, ma con un’intenzione molto più profonda.

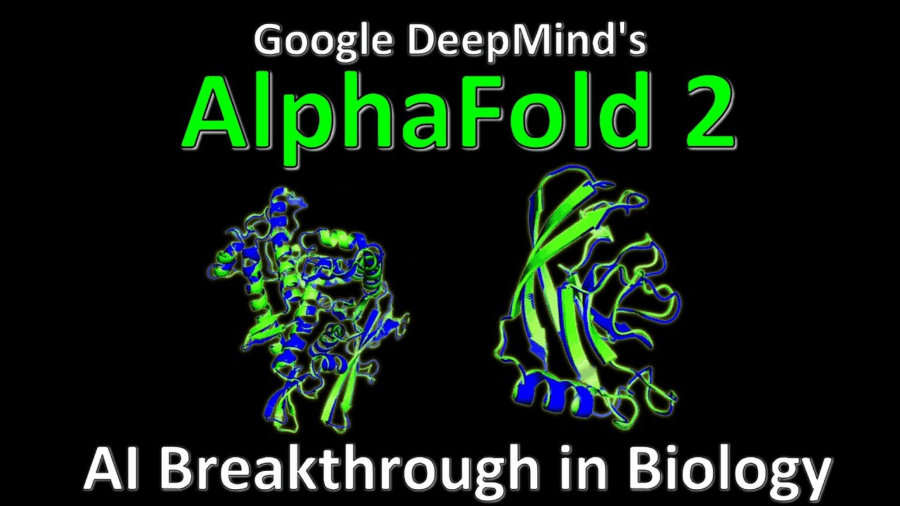

AlphaFold2 è ormai il cavallo di Troia dell’innovazione farmaceutica, trasformando un problema strutturale che richiedeva anni di biologia sperimentale in un calcolo da minuti La notizia del team dell’Università Tecnica della Danimarca (DTU) ribalta qualsiasi certezza: portano lo sviluppo di farmaci antitumorali da anni a settimane, grazie a una triade di modelli AI. Il primo è AlphaFold2, ovviamente, che costruisce la mappa 3D del bersaglio proteico. Il secondo genera mini‑leganti candidati specifici per il tumore prescelto. Il terzo simula la tossicità per non mettere in pericolo le cellule sane. È perfino integrata una rete di sicurezza per evitare sorprese in vitro.

Il capitalismo familiare americano non è morto, ha solo cambiato palco. Se qualcuno nutriva dubbi, Larry Ellison sta per offrirci la prova definitiva che il potere non si eredita semplicemente, si costruisce con colpi di scena degni di una sceneggiatura di Aaron Sorkin. L’ultimo atto? La acquisizione Paramount da parte di Skydance, sostenuta dal miliardario fondatore di Oracle, con il placet della Federal Communications Commission. Un affare da 8 miliardi di dollari che verrà chiuso il 7 agosto, con David Ellison, rampollo e aspirante magnate, promosso a CEO della nuova, gigantesca Paramount Global. Nella lista dei regali di compleanno paterni, un impero televisivo e cinematografico non è esattamente il classico Rolex d’oro.

L’epoca in cui bastava sfoggiare parole come “data-driven” o “AI-ready” in una presentazione è finita. O almeno dovrebbe esserlo, se l’industria tech vuole sopravvivere a se stessa. Perché l’intelligenza artificiale non è un incantesimo in Python o una demo brillante su GitHub: è una disciplina. E come ogni disciplina che si rispetti, ha bisogno di formazione, metodo e, soprattutto, certificazione di competenze reali. Da questa urgenza nasce la Race to Certification 2025, l’iniziativa globale di Oracle University che suona come una sfida ma agisce come una terapia d’urto per il mercato del lavoro IT.

Sam Altman vuole dare a tutto il pianeta accesso gratuito e illimitato a GPT‑5. Sì, avete letto bene: non solo ai ricercatori o agli sviluppatori, ma ad ogni essere umano sulla Terra, H24, gratuitamente, sotto il suo stesso account OpenAI. Il sogno è che l’intelligenza artificiale diventi l’infrastruttura su cui poggiano decisioni su frodi, finanza personale, valutazioni di rischio, inclusi servizi che nei Paesi in via di sviluppo potrebbero saltare direttamente all’AI come salto tecnologico, analogamente al mobile che ha saltato la fase del fisso. Scordatevi i filtri: tutti gli utenti ChatGPT free – nella fascia standard – avranno accesso illimitato a GPT‑5; chi sottoscrive Plus o Pro potrà entrare in livelli di “intelligenza superiore”.

La privacy AI è un ossimoro affascinante. Ci piace pensare che una conversazione con un’intelligenza artificiale sia un momento intimo, quasi catartico, un confessionale digitale dove possiamo scaricare i nostri drammi sentimentali o le nostre paure professionali senza timore. Peccato che Sam Altman, il CEO di OpenAI, ci abbia appena ricordato che è una fantasia. Niente riservatezza conversazioni digitali, niente confidenzialità dati sensibili. Se oggi ti confidi con un avvocato o un terapeuta, la legge ti protegge. Se ti confidi con ChatGPT, sei solo un dato tra miliardi, pronto a essere esaminato in tribunale su richiesta di un giudice. È il prezzo della modernità, ci dicono. Ma è anche un gigantesco problema di fiducia che potrebbe frenare l’adozione di massa dell’intelligenza artificiale.

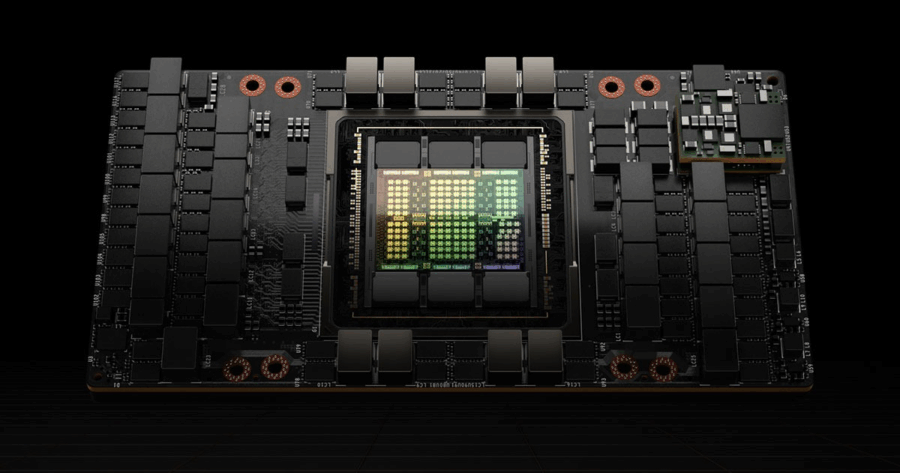

Il paradosso è servito, e come sempre la Silicon Valley e Shenzhen giocano una partita a scacchi con regole che cambiano ogni giorno. Gli Stati Uniti vietano l’export delle GPU Nvidia H100 e A100 in Cina, e la Cina risponde con un sorriso sornione, trasformando l’embargo in un’opportunità di business. A Shenzhen, cuore pulsante del tech cinese, una dozzina di aziende boutique sta facendo fortuna riparando proprio quei chip che ufficialmente non dovrebbero neanche trovarsi nel Paese. È l’ironia della geopolitica tecnologica: vieti un prodotto e ne moltiplichi il valore di mercato, creando un’industria parallela che prospera nell’ombra ma con margini da far impallidire i listini di Wall Street.

A pranzo dal mitico Cecchini in Provincia di Firenze, mentre il nostro amato Sole fiutava con assoluta chiarezza se davanti a sé ci fosse una bistecca di manzo succulenta o una fetta di pizza croccante, mi sono chiesto: e l’intelligenza artificiale, ci riesce altrettanto bene a riconoscerle, visivamente, senza confondersi tra manzo e impasto lievitato?

Il problema di distinguere pizza da bistecca non è banale per un sistema visivo: cos’è una pizza se non un oggetto stratificato, con salsa di pomodoro, mozzarella, ingredienti distribuiti in livelli? Ed è proprio su questa caratteristica che i ricercatori del MIT CSAIL hanno costruito PizzaGAN, un modello in grado di analizzare una foto di pizza, determinare gli ingredienti, la loro distribuzione e persino l’ordine con cui sono stati aggiunti. Un procedimento sofisticato che parla più da cuoco neurale che da semplice classificatore.

Sì, lo ammetto. Dopo mesi di retorica accelerazionista al limite del grottesco, nessuno si aspettava che l’amministrazione Trump tirasse fuori qualcosa di vagamente intelligente. Le attese per il Piano d’Azione per l’Intelligenza Artificiale USA erano talmente basse che la comunità tecnologica, me compreso, si aspettava un documento propagandistico, un inno all’innovazione selvaggia senza neanche il fastidio di menzionare i rischi. E invece, mercoledì, la Casa Bianca ha reso pubblico un testo che, pur con i suoi limiti, ha sorpreso praticamente tutti. Perfetto? No. Ma straordinariamente più maturo del previsto. È questo il vero shock.

Non è un giocattolo. Non è neppure un prototipo da laboratorio coperto di cavi e polvere come quelli che ci propinano i soliti startupper americani durante le presentazioni con tanto di applausi registrati. L’Unitree R1 è un robot umanoide che costa meno di un iPhone Pro Max se consideriamo la versione con 1TB di memoria, ed è già qui. Cammina, corre, fa la verticale, tira pugni e, a giudicare dai video su Weibo, è pronto a mettere in imbarazzo chiunque parli ancora di “futuro della robotica” al tempo futuro. Peccato per loro: in Cina il futuro è già passato ieri.