Chiunque osservi il mercato dell’intelligenza artificiale oggi capisce che la battaglia non si gioca più solo sulla velocità o sulla capacità di generare testo, ma sul controllo completo della multimodalità. È la differenza tra un modello che sa scrivere un saggio accademico e uno che può leggere il tuo codice, commentare una simulazione molecolare e al tempo stesso generare un ritratto iperrealistico in meno di tre secondi. ChatGPT-5 e Gemini 2.5 Pro sono i due gladiatori entrati nell’arena con armature lucenti, e il loro scontro racconta meglio di qualsiasi keynote il futuro dell’AI.

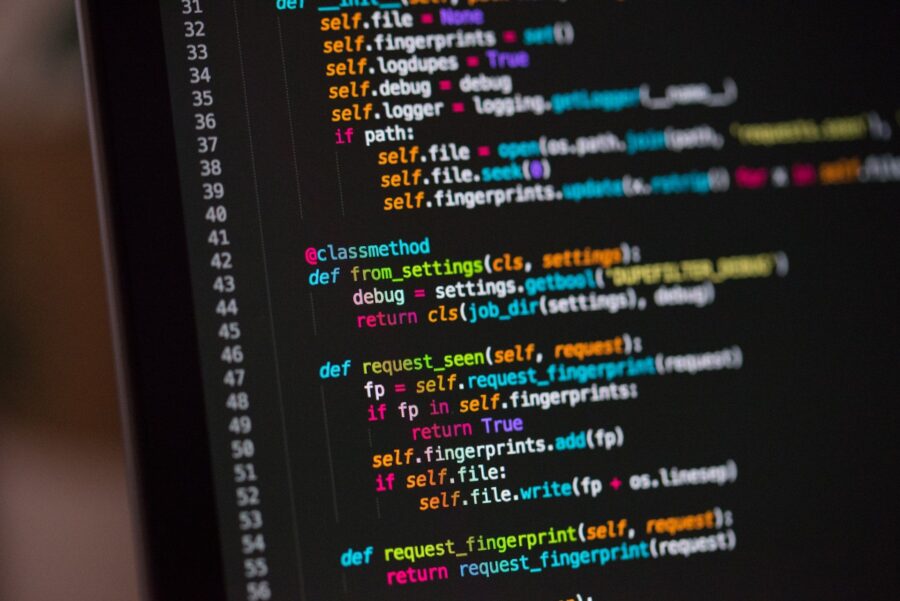

ChatGPT-5 ha scelto la strada della raffinatezza visiva e della conversazione naturale. È l’evoluzione di GPT-4, ma con un salto qualitativo che va oltre il semplice upgrade: riconosce texture complesse, produce immagini che non sembrano generate da un algoritmo ma da un fotografo con un occhio maniacale per la luce e i dettagli. Il suo contesto di 400.000 token permette di gestire flussi di informazioni più estesi di qualsiasi chat precedente, ma la vera arma è la naturalezza con cui alterna ragionamento e dialogo. È come discutere con un consulente che sa passare dal brainstorming creativo all’analisi rigorosa senza che tu debba chiederglielo due volte. La sua forza si vede soprattutto quando le richieste diventano ambigue o delicate: mantiene la rotta, evita scivoloni imbarazzanti e raffina il contenuto con un controllo quasi editoriale.