L’innovativo approccio di TikTok rappresenta una svolta nel mondo dei social network, in quanto è il primo a fondare il suo prodotto sull’intelligenza artificiale stessa.

Un recente articolo pubblicato su towardsdatascience.com evidenzia questo cambiamento di paradigma, sottolineando che non sono più le visualizzazioni o i click a determinare la popolarità dei contenuti, bensì un algoritmo di intelligenza artificiale che suggerisce specifici contenuti al fine di trattenere gli utenti il più a lungo possibile.

È importante comprendere che ciò non implica una demonizzazione delle dinamiche della piattaforma, ma piuttosto una presa di coscienza riguardo alle regole del gioco a cui ci si adatta implicitamente utilizzando tali strumenti. Utilizzare TikTok comporta quindi una responsabilità condivisa, sia da parte degli utenti che dei responsabili e progettisti degli algoritmi di raccomandazione.

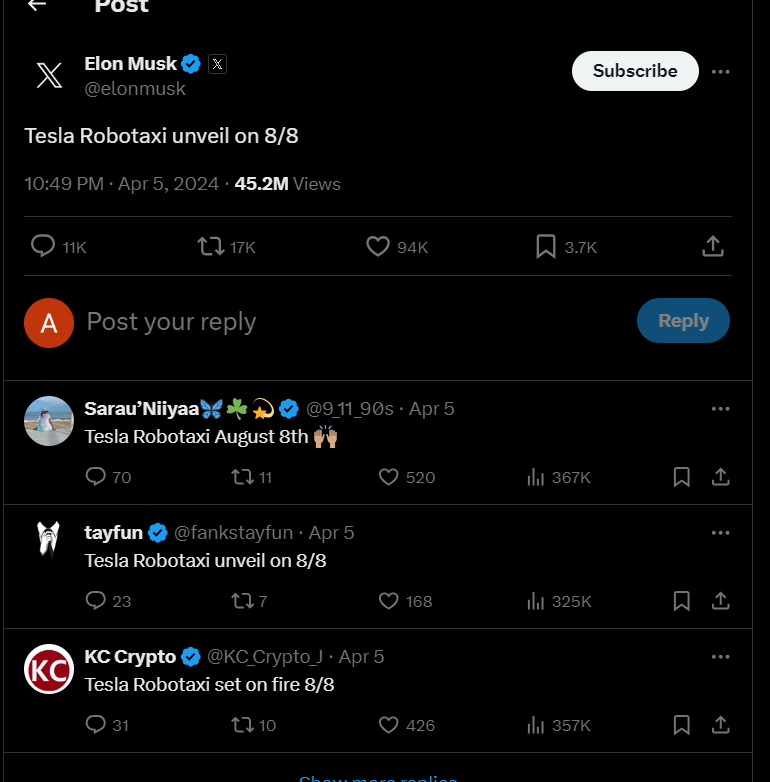

L’ex segretario al Tesoro Steve USA Mnuchin afferma che sta mettendo insieme un gruppo di investitori per acquisire TiKTok.

La Camera dei Rappresentanti ha approvato un disegno di legge che potrebbe vietare la piattaforma di social media di ByteDance in tutto il paese.

Mnuchin ha dichiarato alla CNBC: “Penso che la legislazione dovrebbe essere approvata e penso che l’APP dovrebbe essere venduta. È un ottimo affare e metterò insieme un gruppo per acquistare TikTok”.

“Questo dovrebbe essere di proprietà delle imprese statunitensi. Non è possibile che i cinesi permettano mai a una società americana di possedere qualcosa di simile in Cina”.

Mnuchin non ha rivelato chi farà parte del gruppo che acquisirà TikTok.

Il Ministero degli Affari Esteri cinese ha risposto al Congresso, affermando: “Sebbene gli Stati Uniti non abbiano mai trovato alcuna prova che TikTok costituisca una minaccia per la sicurezza nazionale degli Stati Uniti, non hanno mai smesso di inseguire TikTok.

Tale pratica di ricorrere a mosse egemoniche quando non è possibile avere successo in una concorrenza leale interrompe il normale funzionamento delle imprese, mina la fiducia degli investitori internazionali nell’ambiente degli investimenti e sabota il normale ordine economico e commerciale nel mondo. Ciò inevitabilmente si ritorcerà contro gli stessi Stati Uniti”.

Gli Stati Uniti hanno espresso preoccupazioni su TikTok per vari motivi:

Sicurezza dei dati: Gli Stati Uniti temono che TikTok, essendo di proprietà della società cinese ByteDance, possa condividere i dati sensibili degli utenti, come le informazioni sulla posizione, con il governo cinese. Questo è dovuto alle leggi cinesi che consentono al governo di richiedere segretamente dati alle aziende e ai cittadini cinesi.

Un’importante irregolarità si manifesta nell’ormai quasi certa pratica di trasferire i dati sensibili degli utenti iscritti a TikTok su server ubicati in Cina. Questa situazione è stata confermata da una class action avviata nello Stato della California da una studentessa di Palo Alto di nome Misty Hong. Hong sostiene con sicurezza di aver utilizzato l’applicazione TikTok esclusivamente per visualizzare contenuti video, senza mai creare o caricare alcun contenuto dopo essersi iscritta. Tuttavia, la giovane ha scoperto l’esistenza di un account a suo nome, non richiesto e utilizzato per caricare contenuti sulla piattaforma, utilizzando come password il suo numero di cellulare e i suoi dati biometrici, probabilmente acquisiti attraverso l’analisi dei video mai condivisi. Hong sostiene che queste anomalie nei suoi dati siano state possibili grazie al trasferimento dei suoi dati verso server situati in Cina.

Propaganda e disinformazione: Gli Stati Uniti sono preoccupati che TikTok possa essere utilizzato come strumento di propaganda dal Partito Comunista Cinese. Inoltre, temono che la Cina possa utilizzare le segnalazioni dei contenuti di TikTok per diffondere disinformazione.

Influenza politica: Alcuni ritengono che TikTok possa interferire con le campagne politiche ed amministrative statunitensi.

TikTok ha negato queste accuse e ha cercato di prendere le distanze da ByteDance. Ha anche affermato di non aver mai condiviso, o ricevuto una richiesta di condivisione, dei dati degli utenti statunitensi con il governo cinese.

Qui un video della FOX che mostra il punto di vista USA : https://www.foxnews.com/video/6309696840112

Meta e Google sembrano essere i maggiori beneficiari se i disegni di legge che mirano a colpire le operazioni di TikTok negli Stati Uniti diventassero legge, secondo Wedbush Securities.

L’analista Scott Devitt e altri presso la società di investimenti hanno recentemente incontrato l’ex membro del Congresso degli Stati Uniti Ryan Costello per discutere le implicazioni del Protecting Americans from Foreign Adversary Controlled Applications Act (H.R. 7521).

Costello, che è stato al Congresso dal 2015 al 2019, ha stimato che esista una probabilità del 55% che una forma della legislazione venga alla fine approvata. Tuttavia, dubita che la società cinese ByteDance si disimpegni da TikTok – come richiede la legislazione – il che alla fine comporterebbe l’uscita di TikTok dal paese.

H.R. 7521 è passato alla Camera dei Rappresentanti degli Stati Uniti il 13 marzo, ricevendo un ampio sostegno bipartisan con un voto di 352-65-1 a favore del disegno di legge.

Il Presidente Biden ha già indicato che firmerà l’H.R. 7521 in legge se arriverà sulla sua scrivania.

Il disegno di legge mira alla “minaccia rappresentata dalle applicazioni controllate da avversari stranieri, come TikTok e qualsiasi applicazione o servizio successivo e qualsiasi altra applicazione o servizio sviluppato o fornito da ByteDance”.

“Questa legislazione bipartizan è necessaria per proteggere la nostra sicurezza nazionale e la privacy dei consumatori americani,” ha detto la deputata Shontel Brown (D-Ohio). “Ci sono chiare e legittime preoccupazioni riguardo alle applicazioni soggette al controllo dei nostri avversari stranieri. È imperativo che il Congresso agisca per proteggere il pubblico, giovane e vecchio.”

Una settimana dopo che l’H.R. 7521 è passato alla Camera, l’organo legislativo ha approvato un secondo disegno di legge, il Protecting Americans’ Data from Foreign Adversaries Act of 2024 (H.R. 7520), all’unanimità.

L’H.R. 7520, che è correlato all’H.R. 7521, proibirebbe ai broker di dati di vendere le informazioni personali sensibili degli americani agli avversari stranieri.

Ci si aspetta che il Senato degli Stati Uniti esamini entrambi i disegni di legge insieme, con un voto che avverrà nei prossimi due mesi, ha detto Costello.

Tuttavia, questi disegni di legge probabilmente subiranno delle modifiche prima di arrivare al Senato, ha detto Costello. Ad esempio, potrebbe essere necessaria una maggiore chiarezza riguardo alla definizione di “avversario straniero” o il termine “broker di dati” potrebbe necessitare di ulteriore classificazione, ha detto l’ex membro del Congresso.

Inoltre, la versione della Camera prevede che TikTok si disimpegni da ByteDance entro 180 giorni. Questo periodo è probabilmente irragionevole per un’affare di questa portata e complessità e verrà probabilmente modificato dal Senato, ha detto Costello.

“Se il disegno di legge slitta ai mesi estivi o all’inizio dell’autunno, è improbabile che passi secondo il parere di Ryan, dato il prossimo elezione e la difficoltà di mantenere il necessario slancio politico per un periodo così prolungato,” ha notato Wedbush.

Se i due disegni di legge diventassero legge, ByteDance e il governo cinese hanno indicato resistenza a disimpegnarsi da TikTok, utilizzato da circa 170 milioni di americani.

Se TikTok fosse costretto a lasciare gli Stati Uniti, Meta e Google sono le due aziende meglio posizionate per beneficiare della ridistribuzione della pubblicità, ha detto Wedbush.

“Delle persone che utilizzano TikTok, l’83%, l’81% e il 73%, utilizzano anche Facebook, Instagram e WhatsApp, rispettivamente,” ha detto l’analista di Seeking Alpha Yuval Rotem. “Dal punto di vista opposto, il 51%, il 52% e il 50% delle persone che utilizzano Facebook, Instagram e WhatsApp, sono anche su TikTok.”

“Secondo me, ciò significa che in caso di divieto di TikTok, il tempo trascorso dagli utenti comuni sulle piattaforme di Meta aumenterà in modo significativo,” ha aggiunto.

Tuttavia, i commercianti cinesi on-line che vendono prodotti su TikTok Shop negli Stati Uniti, come alternativa ad Amazon, sono preoccupati per le mosse, dicono, che l’azienda ha fatto per una adesione più rigorosa alle regole per i venditori stranieri che aprono negozi sull’app, ha riferito Reuters.

Nelle ultime settimane, TikTok – di proprietà della società cinese ByteDance rischia di dover vendere le “operations ” (Processi, Persone e Tecnologia) statunitensi dell’app o affrontare un divieto nel paese – ha adottato una posizione più dura per far rispettare le sue regole interne, ha aggiunto il rapporto citando cinque venditori cinesi sul sito e un’associazione di settore che rappresenta 3.000 negozi cinesi che vendono prodotti online.

TikTok richiede che le entità statunitensi registrate dai commercianti siano di proprietà statunitense al 51% e presiedute da un titolare di passaporto statunitense, secondo i venditori e Winnie Wang, presidente esecutivo dell’Associazione di E-Commerce Transfrontaliero di Shenzhen.

Diversi venditori cinesi avevano utilizzato entità statunitensi per essere considerati come commercianti statunitensi sull’app, ma ora le regole comportano che richiederanno la ri-registrazione come venditori stranieri, che dicono ricevono meno visibilita’ e aiuto, mettendoli in svantaggio rispetto ai venditori di TikTok statunitensi, ha notato il rapporto.

TikTok ha politiche e requisiti chiari per tutti i venditori sul suo negozio, compresi i venditori internazionali, e queste politiche non sono cambiate da quando TikTok Shop è stato lanciato negli Stati Uniti nel settembre 2023, ha detto un portavoce di TikTok, secondo il rapporto.

I commercianti cinesi hanno notato che si sentono presi di mira dalle regolamentazioni di TikTok e alcuni stanno considerando di limitare le risorse che mettono nel promuovere le vendite sull’app o trovare partner statunitensi, secondo il rapporto.

Nel frattempo, alcuni commercianti hanno detto che, in confronto, Amazon non fa distinzioni tra venditori statunitensi e altri venditori sulla sua piattaforma.

Il commerciante di Shenzhen Jackie Bai e altri due venditori cinesi hanno detto di aver sentito dai rappresentanti di TikTok Shop che le regole più severe erano in risposta al clima politico che TikTok sta affrontando negli Stati Uniti in un anno elettorale, ha aggiunto il rapporto.

I funzionari statunitensi temono che i dati degli utenti possano essere condivisi con la Cina, tuttavia, TikTok ha notato che non ha mai condiviso, o ricevuto una richiesta di condividere i dati degli utenti statunitensi con il governo cinese.

Separatamente, la Federal Trade Commission, o FTC, sta indagando su TikTok per presunte pratiche sospette di privacy e sicurezza dei dati, e potrebbe decidere nelle prossime settimane di fare una causa o un accordo, Politico ha riferito martedì, citando persone a conoscenza della questione.

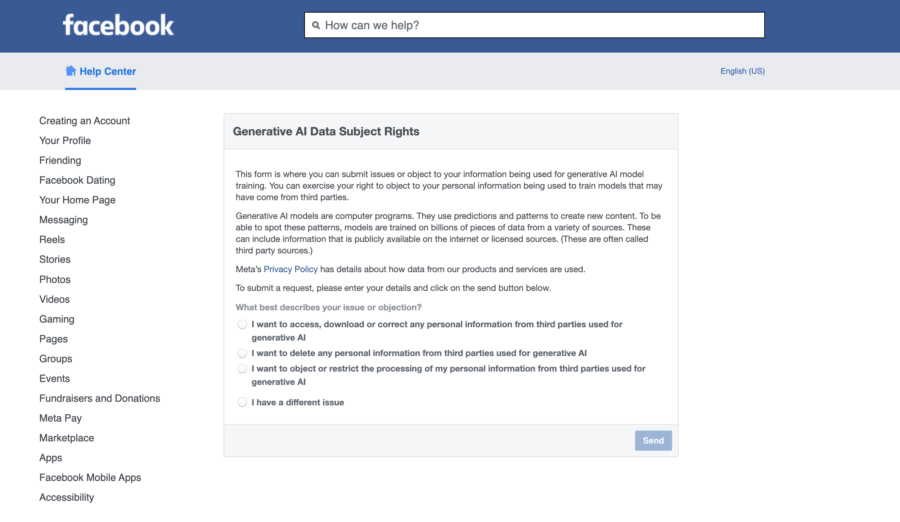

La FTC sta valutando le accuse secondo cui TikTok e la società madre ByteDance, hanno ingannato i suoi utenti negando che le persone in Cina avessero accesso ai loro dati, e hanno anche violato una legge sulla privacy dei bambini, ha aggiunto il rapporto.

La FTC, in collaborazione con il Dipartimento di Giustizia, potrebbe registrare la causa o risolvere con l’azienda, tuttavia, un accordo non è ancora stato raggiunto, ha aggiunto il rapporto.

Il caso FTC non è correlato al disegno di legge che cerca la dismissione dell’app.

Non è stata presa alcuna decisione finale su se portare un caso o quali rivendicazioni includere. Non era chiaro nemmeno se un’eventuale azione contro TikTok avrebbe incluso anche ByteDance, ha aggiunto il rapporto.

TikTok è stato sotto il radar della FTC per le sue attività di privacy e sicurezza dei dati da almeno due anni, secondo il rapporto.

Nel 2019, Musical.ly, ora noto come TikTok, ha accettato di pagare $5.7M per risolvere le accuse della FTC che l’azienda ha raccolto illegalmente informazioni personali dai bambini in violazione della Children’s Online Privacy Protection Act.

Newsletter AI – non perderti le ultime novità sul mondo dell’Intelligenza Artificiale, i consigli sui tool da provare, i prompt e i corsi di formazione. Iscriviti alla newsletter settimanale e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!

[newsletter_form type=”minimal”]